Spark reduceByKey函式

在Spark中,reduceByKey函式是一種常用的轉換操作,它執行資料聚合。它接收鍵值對(K,V)作為輸入,基於鍵聚合值並生成(K,V)對的資料集作為輸出。

reduceByKey函式的範例

在此範例中,我們基於鍵聚合值。要在Scala模式下開啟Spark,請按照以下命令操作。

$ spark-shell

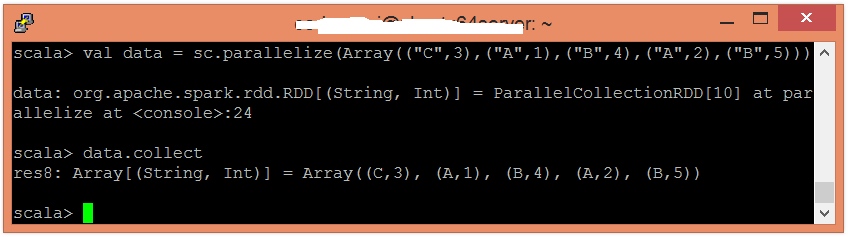

使用並行化集合建立RDD。

scala> val data = sc.parallelize(Array(("C",3),("A",1),("B",4),("A",2),("B",5)))

現在,可以使用以下命令讀取生成的結果。

scala> data.collect

應用reduceByKey()函式來聚合值。

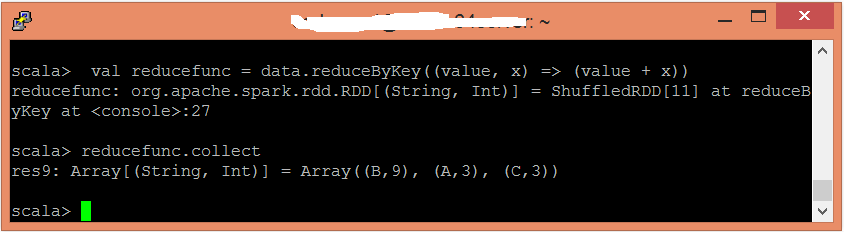

scala> val reducefunc = data.reduceByKey((value, x) => (value + x))

現在,可以使用以下命令讀取生成的結果。

scala> reducefunc.collect