Spark groupByKey函式

在Spark中,groupByKey函式是一種經常使用的轉換操作,它執行資料的混亂。它接收鍵值對(K,V)作為輸入,基於鍵對值進行分組,並生成(K,Iterable)對的資料集作為輸出。

groupByKey函式的範例

在此範例中,根據鍵對值進行分組。要在Scala模式下開啟Spark,請按照以下命令操作。

$ spark-shell

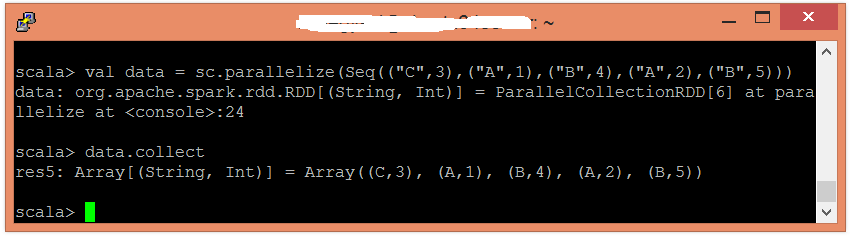

使用並行化集合建立RDD。

scala> val data = sc.parallelize(Seq(("C",3),("A",1),("B",4),("A",2),("B",5)))

現在,可以使用以下命令讀取生成的結果。

scala> data.collect

應用groupByKey()函式對值進行分組。

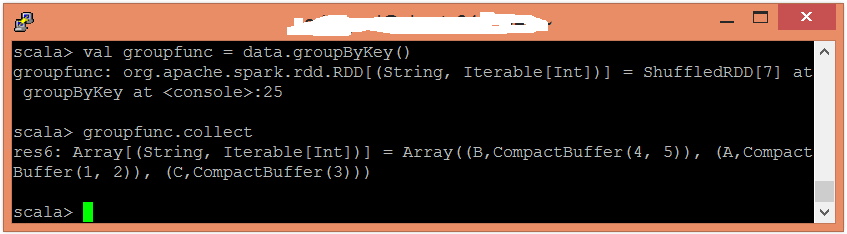

scala> val groupfunc = data.groupByKey()

現在,可以使用以下命令讀取生成的結果。

scala> groupfunc.collect