Hadoop HDFS

Hadoop檔案系統使用分散式檔案系統設計開發。它是執行在普通硬體。不像其他的分散式系統,HDFS是高度容錯以及使用低成本的硬體設計。

HDFS擁有超大型的資料量,並提供更輕鬆地存取。為了儲存這些龐大的資料,這些檔案都儲存在多台機器。這些檔案都儲存以冗餘的方式來拯救系統免受可能的資料損失,在發生故障時。 HDFS也使得可用於併行處理的應用程式。

HDFS的特點

- 它適用於在分散式儲存和處理。

- Hadoop提供的命令介面與HDFS進行互動。

- 名稱節點和資料節點的幫助使用者內建的伺服器能夠輕鬆地檢查叢集的狀態。

- 流式存取檔案系統資料。

- HDFS提供了檔案的許可權和驗證。

HDFS架構

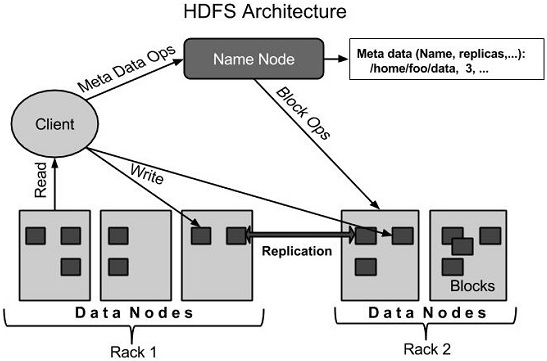

下面給出是Hadoop的檔案系統的體系結構。

HDFS遵循主從架構,它具有以下元素。

名稱節點 - Namenode

名稱節點是包含GNU/Linux作業系統和軟體名稱節點的普通硬體。它是一個可以在商品硬體上執行的軟體。具有名稱節點系統作為主伺服器,它執行以下任務:

- 管理檔案系統名稱空間。

- 規範用戶端對檔案的存取。

- 它也執行檔案系統操作,如重新命名,關閉和開啟的檔案和目錄。

資料節點 - Datanode

Datanode具有GNU/Linux作業系統和軟體Datanode的普通硬體。對於叢集中的每個節點(普通硬體/系統),有一個資料節點。這些節點管理資料儲存在它們的系統。

- 資料節點上的檔案系統執行的讀寫操作,根據客戶的請求。

- 還根據名稱節點的指令執行操作,如塊的建立,刪除和複製。

塊

一般使用者資料儲存在HDFS檔案。在一個檔案系統中的檔案將被劃分為一個或多個段和/或儲存在個人資料的節點。這些檔案段被稱為塊。換句話說,資料的HDFS可以讀取或寫入的最小量被稱為一個塊。預設的塊大小為64MB,但它可以增加按需要在HDFS組態來改變。

HDFS的目標

-

故障檢測和恢復:由於HDFS包括大量的普通硬體,部件故障頻繁。因此HDFS應該具有快速和自動故障檢測和恢復機制。

-

巨大的資料集:HDFS有數百個叢集節點來管理其龐大的資料集的應用程式。

-

資料硬體:請求的任務,當計算發生不久的資料可以高效地完成。涉及巨大的資料集特別是它減少了網路通訊量,並增加了吞吐量。