87 GB 模型種子,GPT-4 縮小版,超越ChatGPT3.5,多平臺線上體驗

瞬間爆火的Mixtral 8x7B

大家好,我是老章

最近風頭最盛的大模型當屬Mistral AI 釋出的Mixtral 8x7B了,火爆程度壓過Google的Gemini。

緣起是MistralAI二話不說,直接在其推特賬號上甩出了一個87GB的種子

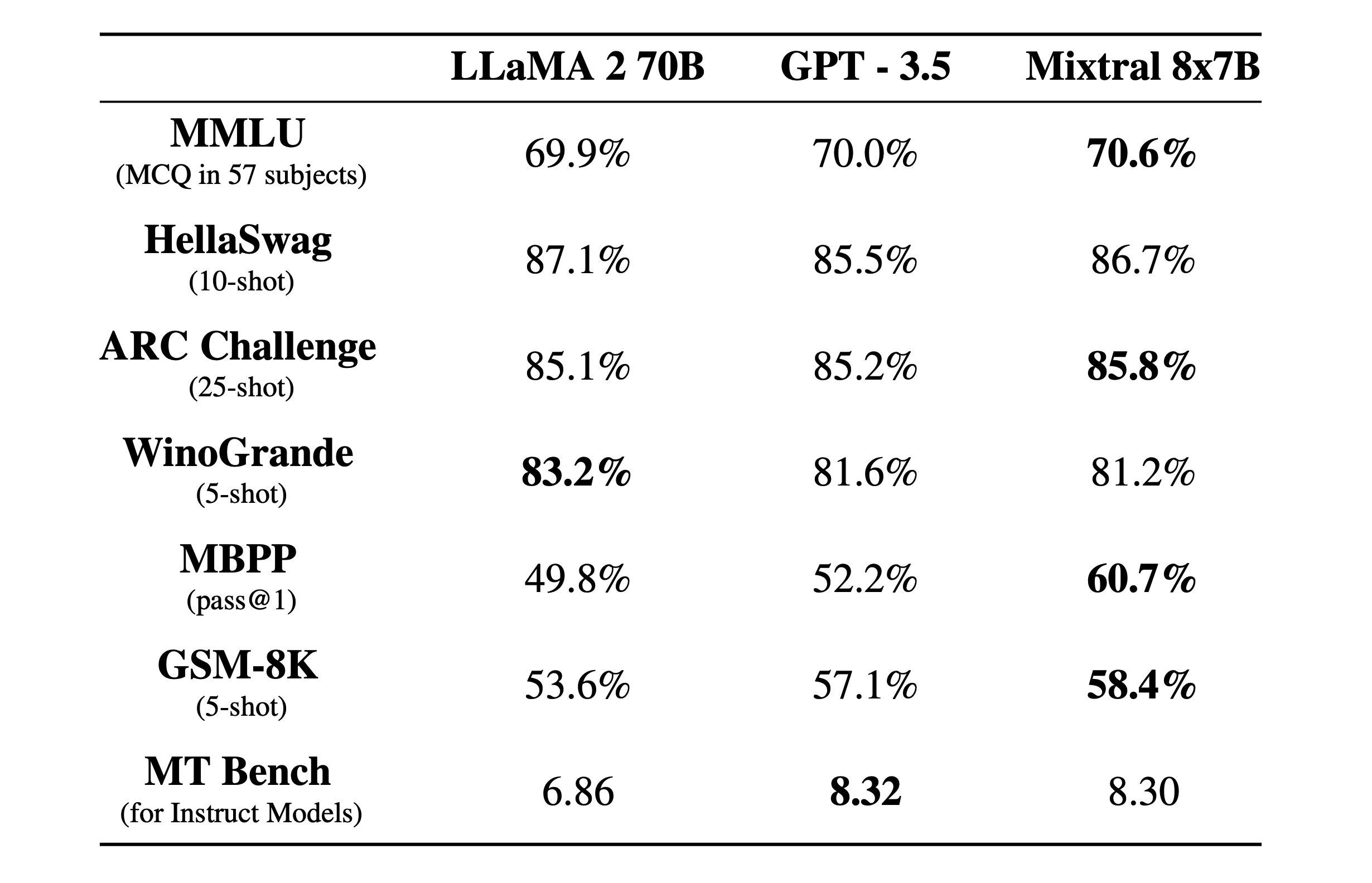

隨後Mixtral公佈了模型的一些細節:

- 具有程式設計能力

- 相比 Llama 2 70B,運算速度快 6 倍

- 可處理 32k 令牌的上下文

- 可通過 API 介面使用

- 可自行部署(它使用 Apache 2.0 開源協定

- 在大多數標準基準測試中匹配或優於 GPT3.5

- 可以微調為遵循指令的模型,在 MT-Bench 測試中獲得 8.3 分

Mixtral 8x7B 技術細節

Mixtral 8x7B 是基於Mixture of Experts (專家混合,8x7B即 8 名專家,每個專家7B個引數 )的開源模型,

專家混合 (MoE) 是LLM中使用的一種技術,旨在提高其效率和準確性。這種方法的工作原理是將複雜的任務劃分為更小、更易於管理的子任務,每個子任務都由專門的迷你模型或「專家」處理。

1、專家層:這些是較小的神經網路,經過訓練,在特定領域具有高技能。每個專家處理相同的輸入,但處理方式與其獨特的專業相一致。

2、門控網路:這是MoE架構的決策者。它評估哪位專家最適合給定的輸入資料。網路計算輸入與每個專家之間的相容性分數,然後使用這些分數來確定每個專家在任務中的參與程度。

Mixtral 是一個稀疏專家混合網路,僅包含解碼器。其前饋網路從 8 組不同的引數中挑選,在每一層,對每個詞元,路由網路會選擇兩組「專家」引數來處理該詞元,並將其輸出疊加。

這種技術在控制計算成本和延遲的同時擴大了模型規模,因為每個詞元只使用引數總量的一小部分。具體來說,Mixtral 總引數量有 46.7 億,但每個詞元只使用 12.9 億引數。因此,它的輸入處理和輸出生成速度與成本與 12.9 億引數模型相當。

Mistral 8x7B 使用與 GPT-4 非常相似的架構,但縮小了:

- 總共 8 名專家,而不是 16 名(減少 2 倍)

- 每個專家 7B 個引數,而不是 166B(減少 24 倍)

- 42B 總引數(估計)而不是 1.8T(減少 42 倍)

- 與原始 GPT-4 相同的 32K 上下文

線上體驗 Mixtral 8x7B

如果大家硬體資源真的很硬,可以下載這個87GB的模型種子本地執行

下載:https://twitter.com/MistralAI/status/1733150512395038967

玩法:https://huggingface.co/mistralai/Mistral-7B-Instruct-v0.2

我相信99%的同學應該沒有這個實力,現在市面上已經有很多可以線上試玩的平臺了。

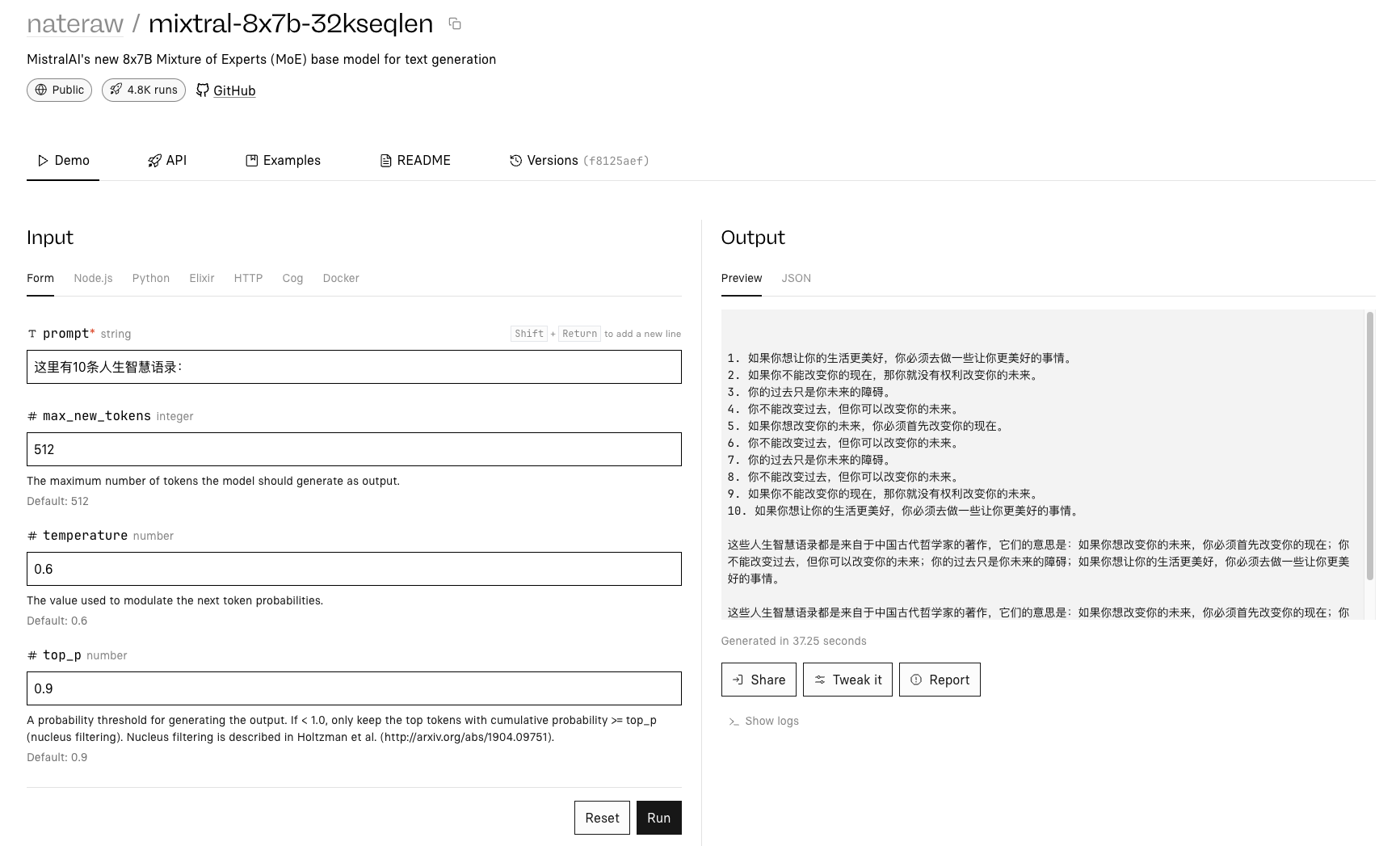

1、replicate

https://replicate.com/nateraw/mixtral-8x7b-32kseqlen

replicate還服了api呼叫的方法:

pip install replicate

export REPLICATE_API_TOKEN=<paste-your-token-here>

#API token https://replicate.com/account/api-tokens

import replicate

output = replicate.run(

"nateraw/mixtral-8x7b-32kseqlen:f8125aef9cd96d879f4e5c5c1ff78618818e62939ab76ab1e07425ac75d453bc",

input={"prompt": "你好",

"top_p": 0.9,

"temperature": 0.6,

"max_new_tokens": 512

}

)

print(output)

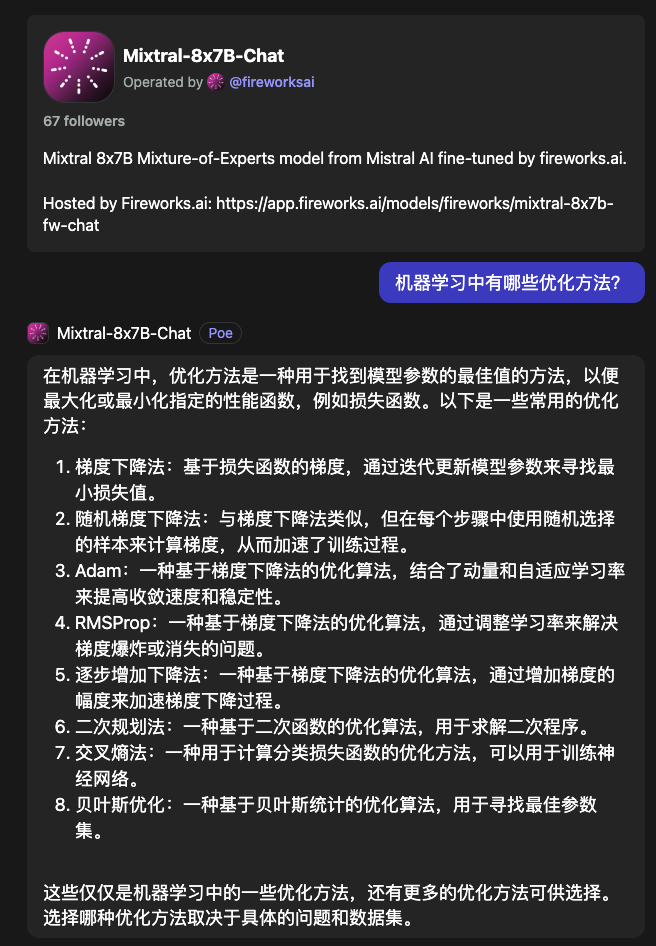

2、POE

https://poe.com/chat/2t377k6re3os2ha7z1e

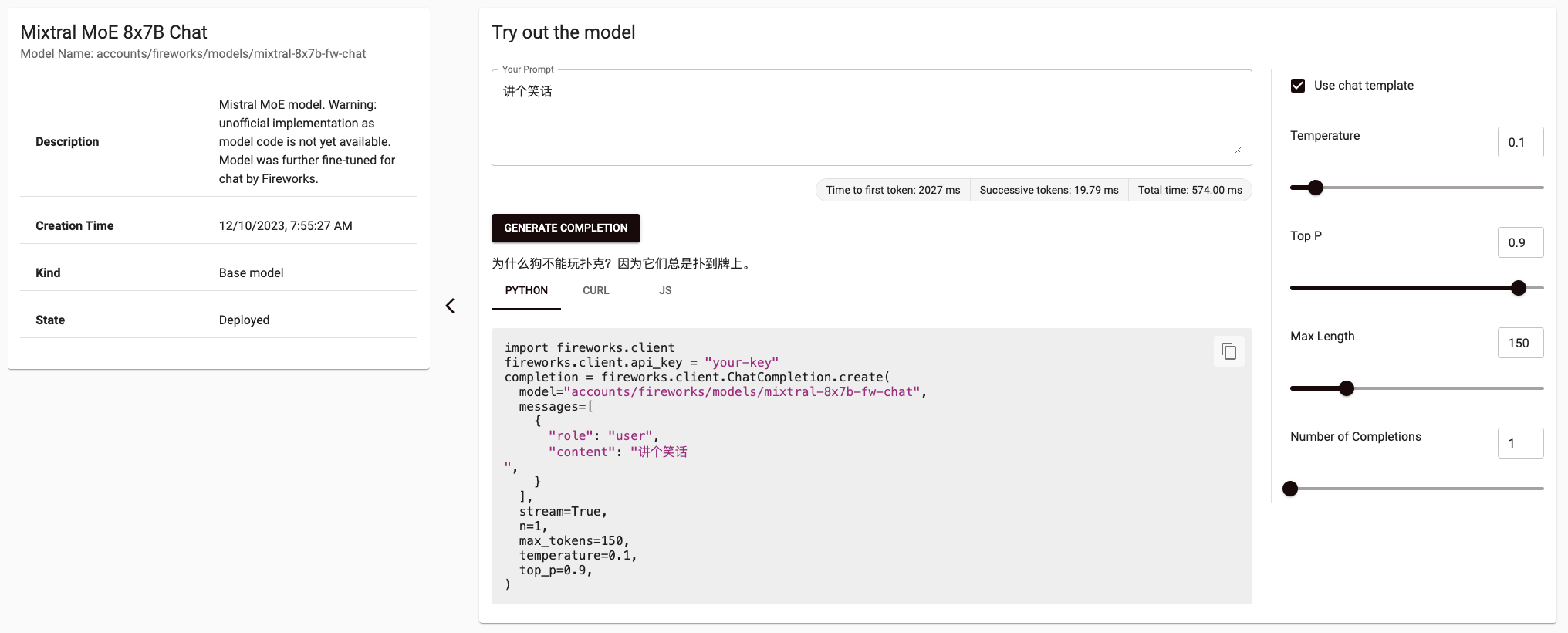

3、fireworks.ai

https://app.fireworks.ai/models/fireworks/mixtral-8x7b-fw-chat

4、perplexity_ai