激發創新,助力研究:CogVLM,強大且開源的視覺語言模型亮相

激發創新,助力研究:CogVLM,強大且開源的視覺語言模型亮相

-

CogVLM 是一個強大的開源視覺語言模型(VLM)。CogVLM-17B 擁有 100 億視覺引數和 70 億語言引數。

-

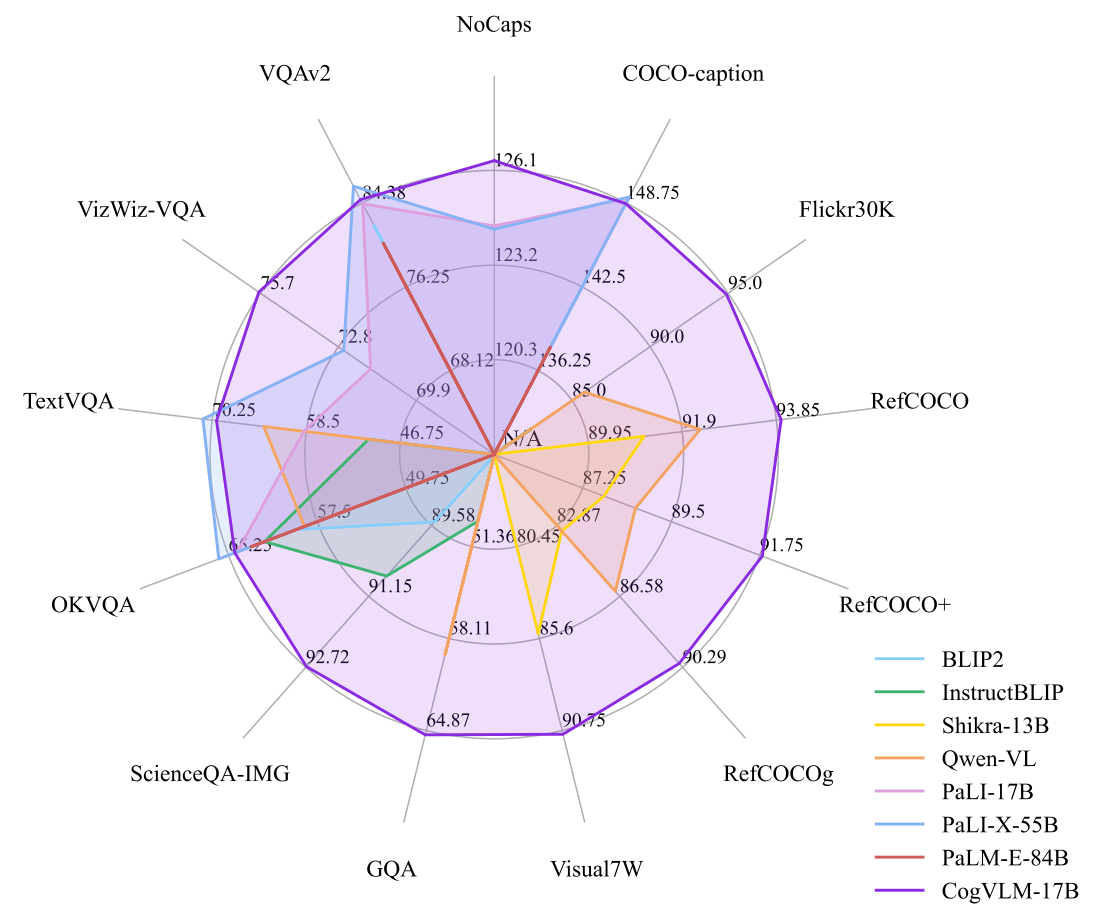

CogVLM-17B 在 10 個經典跨模態基準測試上取得了 SOTA 效能,包括 NoCaps、Flicker30k captioning、RefCOCO、RefCOCO+、RefCOCOg、Visual7W、GQA、ScienceQA、VizWiz VQA 和 TDIUC,而在 VQAv2、OKVQA、TextVQA、COCO captioning 等方面則排名第二,超越或與 PaLI-X 55B 持平。您可以通過線上 demo 體驗 CogVLM 多模態對話。

1.demo案例展示

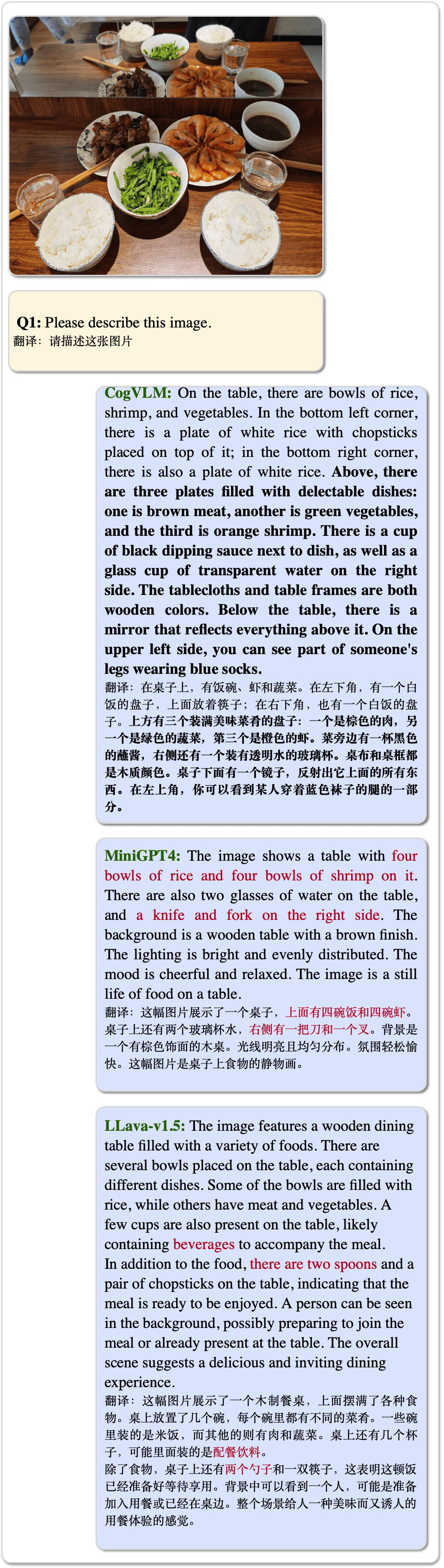

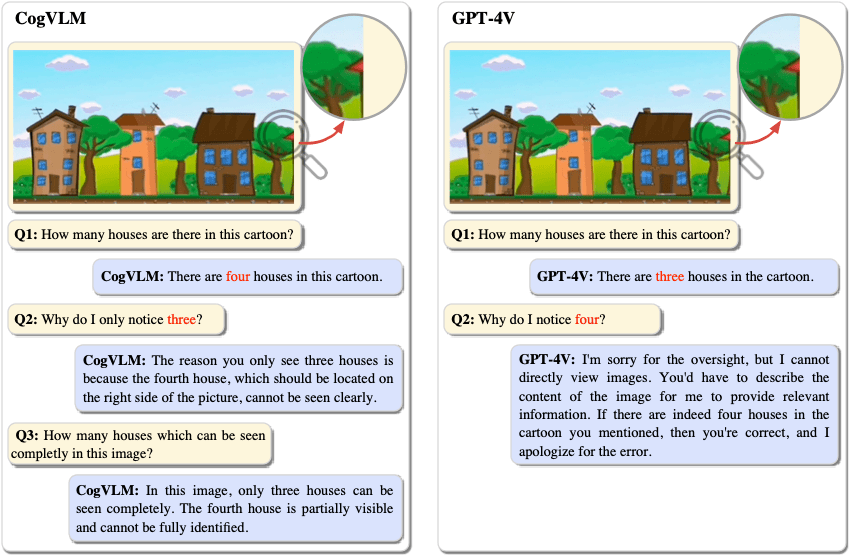

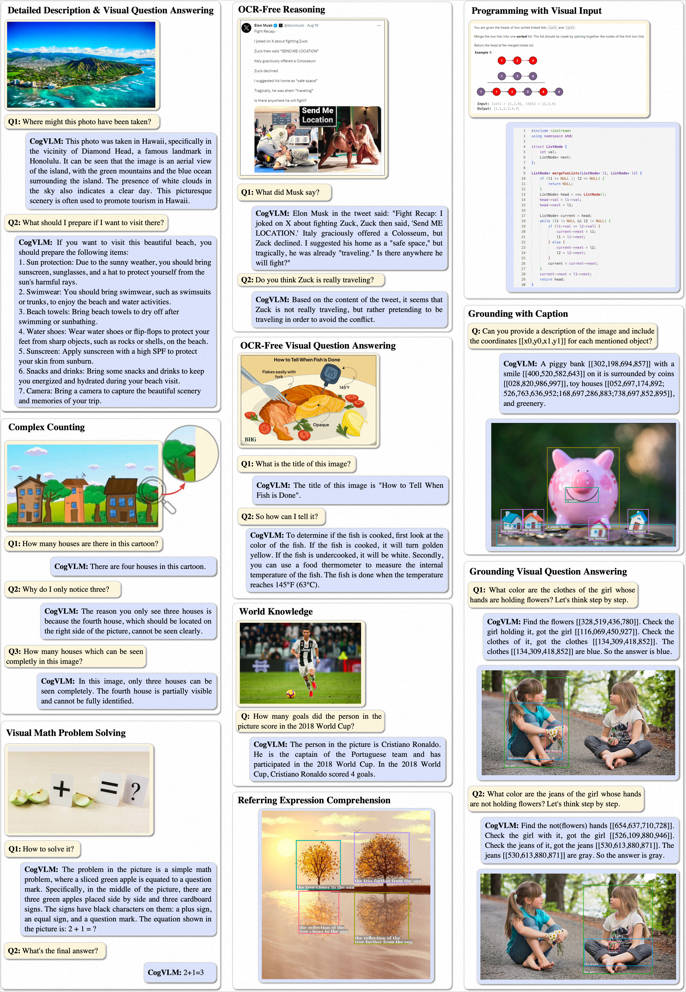

- CogVLM 能夠準確地描述影象,幾乎不會出現幻覺。

LLAVA-1.5 和 MiniGPT-4 的比較。

-

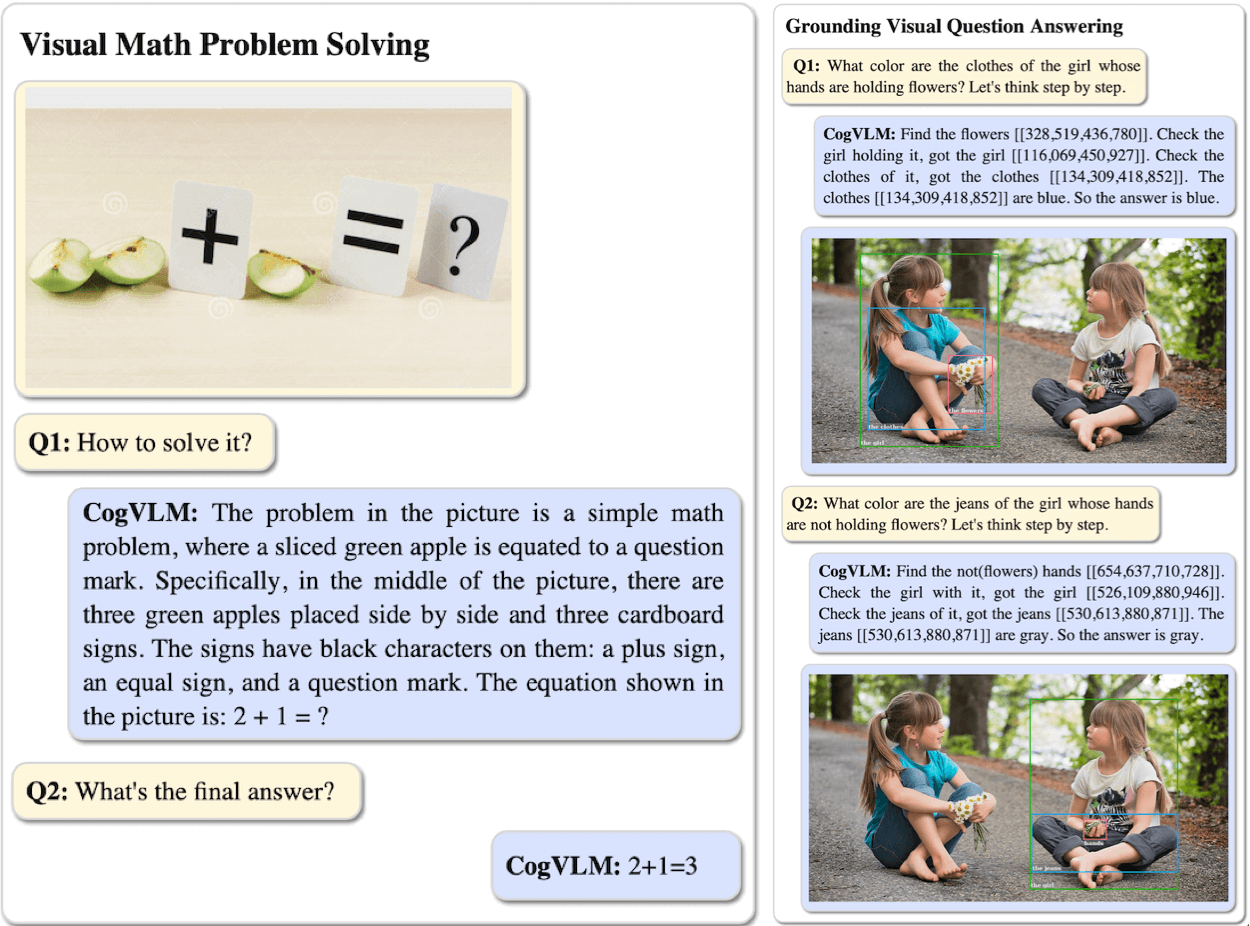

CogVLM 能理解和回答各種型別的問題,並有一個視覺定位版本。

-

CogVLM 有時比 GPT-4V(ision) 提取到更多的細節資訊。

2.快速使用

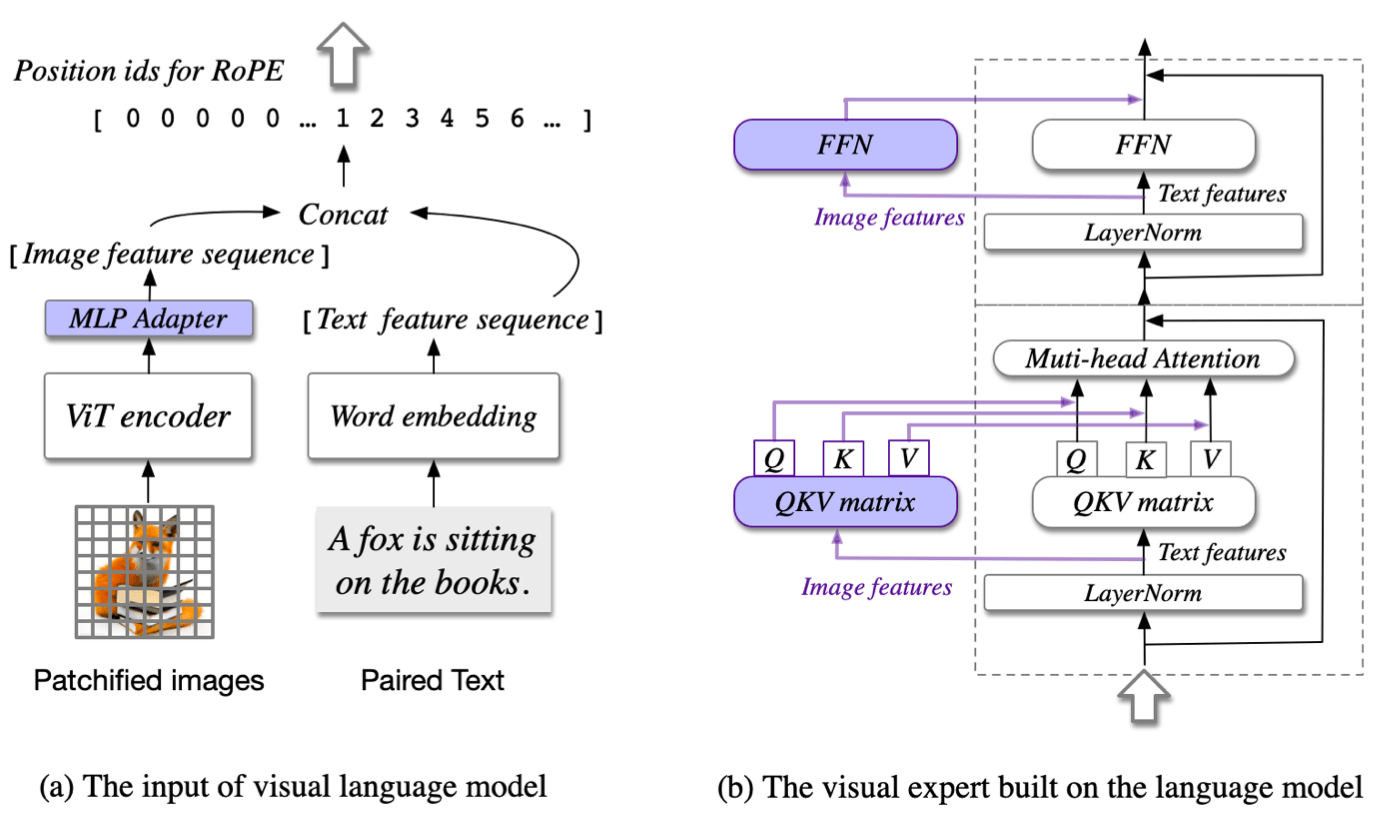

CogVLM 模型包括四個基本元件:視覺變換器(ViT)編碼器、MLP介面卡、預訓練的大型語言模型(GPT)和一個視覺專家模組。更多細節請參見論文。

2.1入門指南

我們提供兩種圖形化使用者介面(GUI)進行模型推斷,分別是網頁演示和命令列介面(CLI)。如果您想在Python程式碼中使用它,很容易修改CLI指令碼以適應您的情況。

首先,需要安裝依賴項。

pip install -r requirements.txt

python -m spacy download en_core_web_sm

- 硬體要求

- 模型推斷:1 * A100(80G) 或 2 * RTX 3090(24G)。

- 微調:4 * A100(80G) [推薦] 或 8 * RTX 3090(24G)。

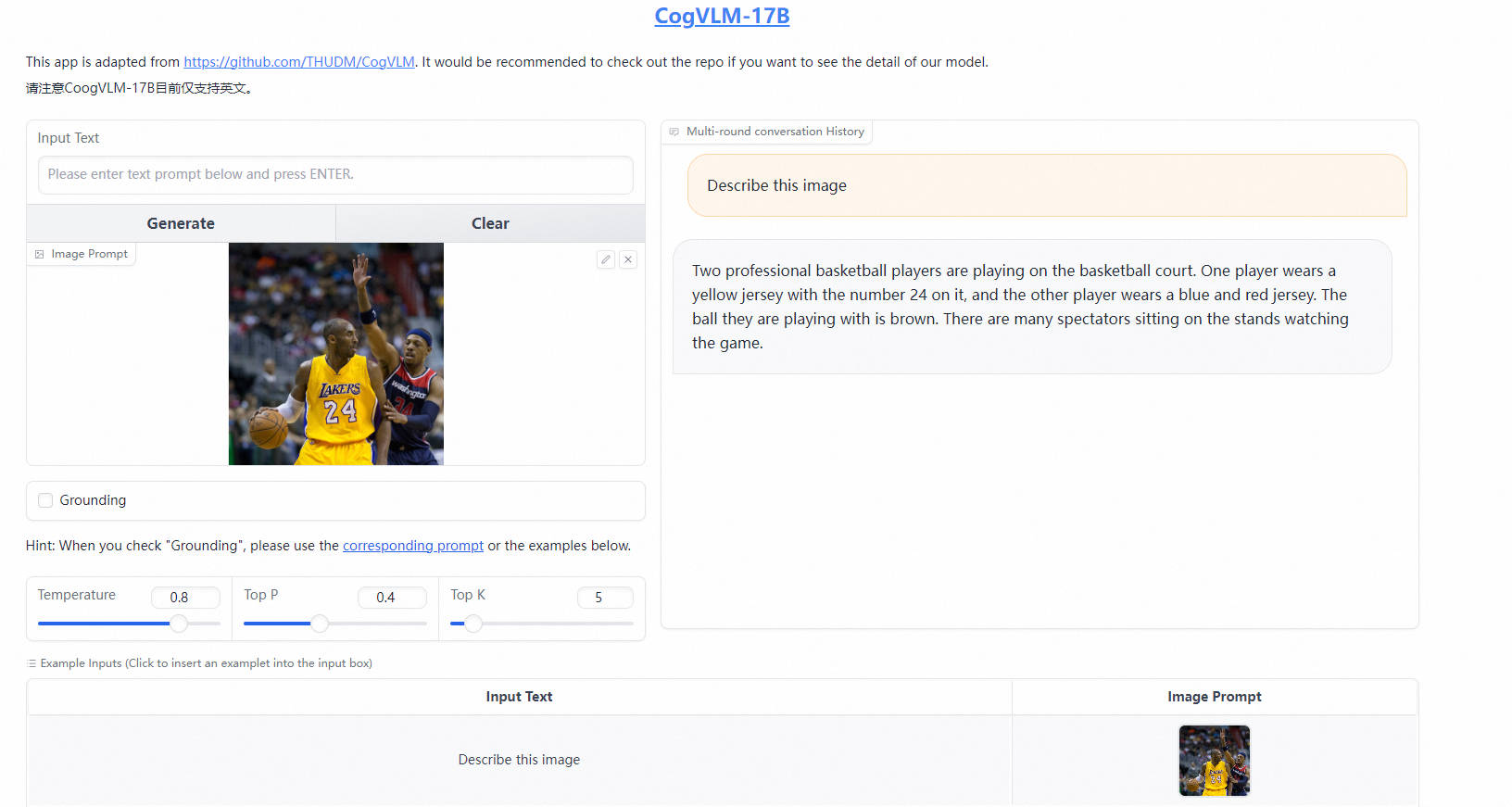

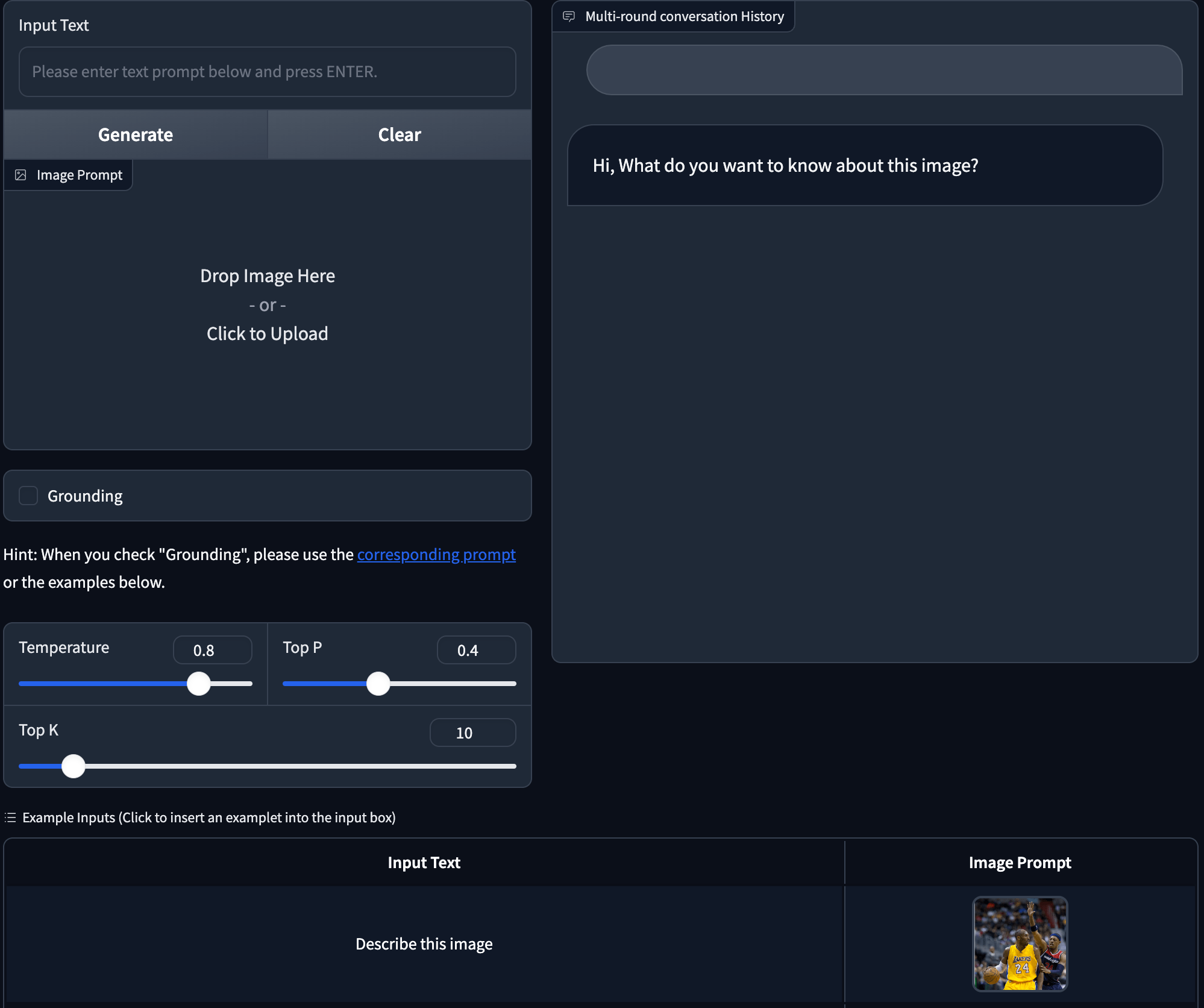

2.2 網頁演示

我們還提供基於Gradio的本地網頁演示。首先,通過執行 pip install gradio 安裝Gradio。然後下載並進入此倉庫,執行 web_demo.py。具體使用方式如下:

python web_demo.py --from_pretrained cogvlm-chat --version chat --english --bf16

python web_demo.py --from_pretrained cogvlm-grounding-generalist --version base --english --bf16

網頁演示的 GUI 介面如下:

2.3 CLI

我們開源了不同下游任務的模型權重:

- cogvlm-chat 用於對齊的模型,在此之後支援像 GPT-4V 一樣的聊天。

- cogvlm-base-224 文字-影象預訓練後的原始權重。

- cogvlm-base-490 從 cogvlm-base-224 微調得到的 490px 解析度版本。

- cogvlm-grounding-generalist 這個權重支援不同的視覺定位任務,例如 REC、Grounding Captioning 等。

通過CLI演示,執行以下命令:

python cli_demo.py --from_pretrained cogvlm-base-224 --version base --english --bf16 --no_prompt

python cli_demo.py --from_pretrained cogvlm-base-490 --version base --english --bf16 --no_prompt

python cli_demo.py --from_pretrained cogvlm-chat --version chat --english --bf16

python cli_demo.py --from_pretrained cogvlm-grounding-generalist --version base --english --bf16

該程式會自動下載 sat 模型並在命令列中進行互動。您可以通過輸入指令並按 Enter 生成回覆。

輸入 clear 可清除對話歷史,輸入 stop 可停止程式。

- 參考連結

https://github.com/THUDM/CogVLM/tree/main

在 CogVLM 的指令微調階段,使用了來自 MiniGPT-4 、 LLAVA 、 LRV-Instruction、 LLaVAR 和 Shikra 專案的一些英文影象-文字資料,

更多優質內容請關注公號:汀丶人工智慧;會提供一些相關的資源和優質文章,免費獲取閱讀。