深度解析BERT:從理論到Pytorch實戰

本文從BERT的基本概念和架構開始,詳細講解了其預訓練和微調機制,並通過Python和PyTorch程式碼範例展示瞭如何在實際應用中使用這一模型。我們探討了BERT的核心特點,包括其強大的注意力機制和與其他Transformer架構的差異。

關注TechLead,分享AI全維度知識。作者擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

一、引言

在資訊爆炸的時代,自然語言處理(NLP)成為了一門極其重要的學科。它不僅應用於搜尋引擎、推薦系統,還廣泛應用於語音識別、情感分析等多個領域。然而,理解和生成自然語言一直是機器學習面臨的巨大挑戰。接下來,我們將深入探討自然語言處理的一些傳統方法,以及它們在處理語言模型時所面臨的各種挑戰。

傳統NLP技術概覽

規則和模式匹配

早期的NLP系統大多基於規則和模式匹配。這些方法具有高度的解釋性,但缺乏靈活性。例如,正規表示式和上下文無關文法(CFG)被用於文字匹配和句子結構的解析。

基於統計的方法

隨著計算能力的提升,基於統計的方法如隱馬爾可夫模型(HMM)和最大熵模型逐漸流行起來。這些模型利用大量的資料進行訓練,以識別詞性、句法結構等。

詞嵌入和分散式表示

Word2Vec、GloVe等詞嵌入方法標誌著NLP從基於規則到基於學習的向量表示的轉變。這些模型通過分散式表示捕捉單詞之間的語意關係,但無法很好地處理詞序和上下文資訊。

迴圈神經網路(RNN)與長短時記憶網路(LSTM)

RNN和LSTM模型為序列資料提供了更強大的建模能力。特別是LSTM,通過其內部門機制解決了梯度消失和梯度爆炸的問題,使模型能夠捕獲更長的依賴關係。

Transformer架構

Transformer模型改變了序列建模的格局,通過自注意力(Self-Attention)機制有效地處理了長距離依賴,並實現了高度並行化。但即使有了這些進展,仍然存在許多挑戰和不足。

在這一背景下,BERT(Bidirectional Encoder Representations from Transformers)模型應運而生,它綜合了多種先進技術,並在多個NLP任務上取得了顯著的成績。

二、什麼是BERT?

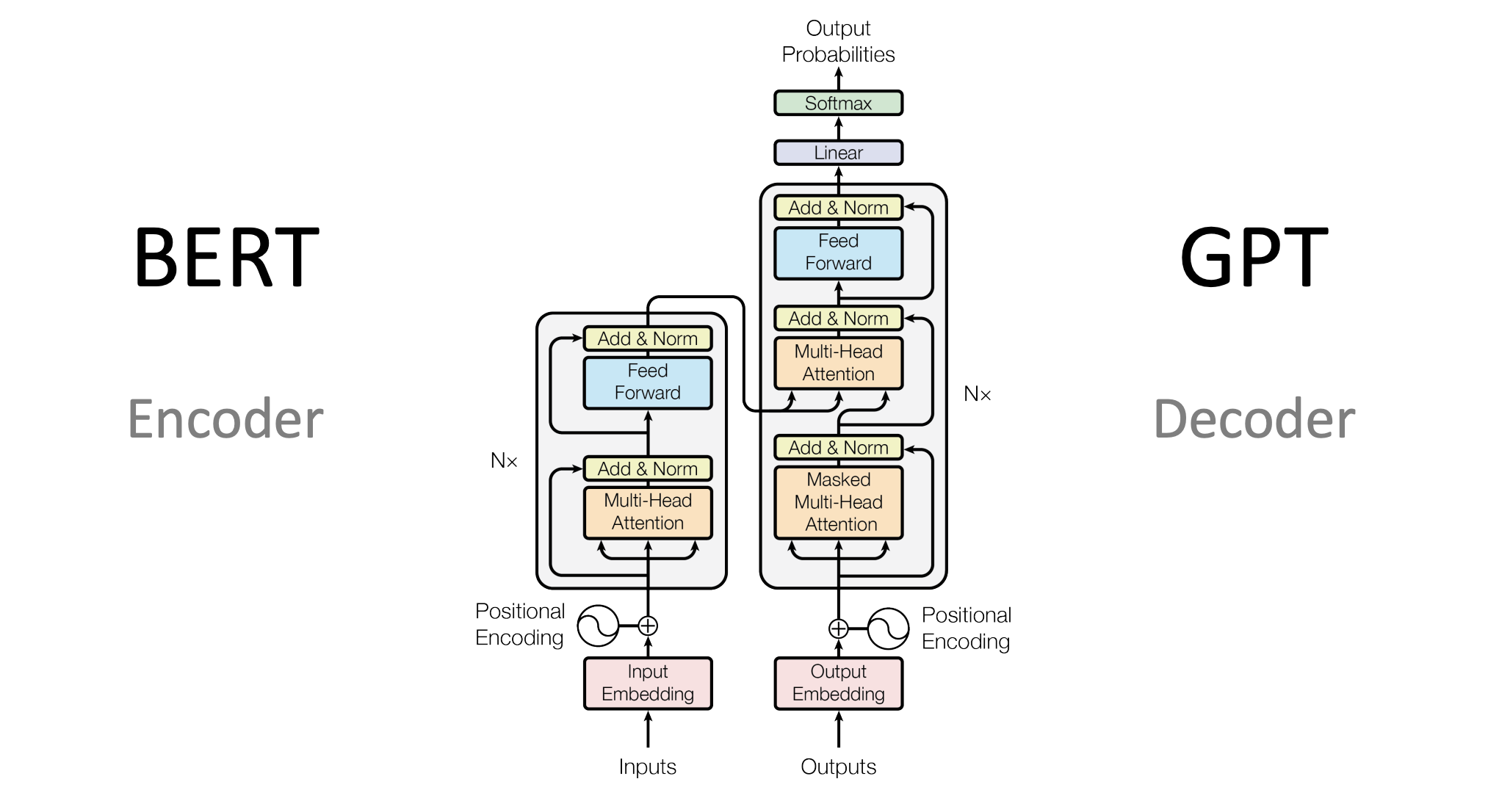

BERT的架構

BERT(Bidirectional Encoder Representations from Transformers)模型基於Transformer架構,並通過預訓練與微調的方式,對自然語言進行深度表示。在介紹BERT架構的各個維度和細節之前,我們先理解其整體理念。

整體理念

BERT的設計理念主要基於以下幾點:

-

雙向性(Bidirectional): 與傳統的單向語言模型不同,BERT能同時考慮到詞語的前後文。

-

通用性(Generality): 通過預訓練和微調的方式,BERT能適用於多種自然語言處理任務。

-

深度(Depth): BERT通常具有多層(通常為12層或更多),這使得模型能夠捕捉複雜的語意和語法資訊。

架構部件

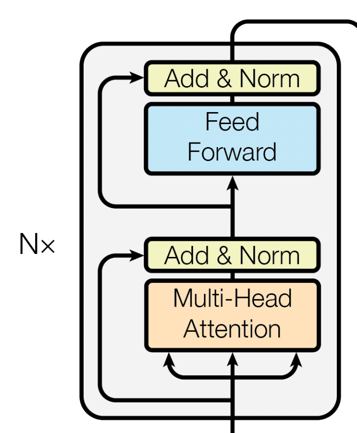

Encoder層

BERT完全基於Transformer的Encoder層。每個Encoder層都包含兩個主要的部分:

-

自注意力機制(Self-Attention): 這一機制允許模型考慮到輸入序列中所有單詞對當前單詞的影響。

-

前饋神經網路(Feed-Forward Neural Networks): 在自注意力的基礎上,前饋神經網路進一步對特徵進行非線性變換。

嵌入層(Embedding Layer)

BERT使用了Token Embeddings, Segment Embeddings和Position Embeddings三種嵌入方式,將輸入的單詞和附加資訊編碼為固定維度的向量。

部件的組合

-

每個Encoder層都依次進行自注意力和前饋神經網路計算,並附加Layer Normalization進行穩定。

-

所有Encoder層都是堆疊(Stacked)起來的,這樣能夠逐層捕捉更抽象和更復雜的特徵。

-

嵌入層的輸出會作為第一個Encoder層的輸入,然後逐層傳遞。

架構特點

-

引數共用: 在預訓練和微調過程中,所有Encoder層的引數都是共用的。

-

靈活性: 由於BERT的通用性和深度,你可以根據任務的不同在其基礎上新增不同型別的頭部(Head),例如分類頭或者序列標記頭。

-

高計算需求: BERT模型通常具有大量的引數(幾億甚至更多),因此需要大量的計算資源進行訓練。

通過這樣的架構設計,BERT模型能夠在多種自然語言處理任務上取得出色的表現,同時也保證了模型的靈活性和可延伸性。

三、BERT的核心特點

BERT模型不僅在多項NLP任務上取得了顯著的效能提升,更重要的是,它引入了一系列在自然語言處理中具有革新性的設計和機制。接下來,我們將詳細探討BERT的幾個核心特點。

Attention機制

自注意力(Self-Attention)

自注意力是BERT模型中一個非常重要的概念。不同於傳統模型在處理序列資料時,只能考慮區域性或前序的上下文資訊,自注意力機制允許模型觀察輸入序列中的所有詞元,併為每個詞元生成一個上下文感知的表示。

# 自注意力機制的簡單PyTorch程式碼範例

import torch.nn.functional as F

class SelfAttention(nn.Module):

def __init__(self, embed_size, heads):

super(SelfAttention, self).__init__()

self.embed_size = embed_size

self.heads = heads

self.head_dim = embed_size // heads

assert (

self.head_dim * heads == embed_size

), "Embedding size needs to be divisible by heads"

self.values = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.keys = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.queries = nn.Linear(self.head_dim, self.head_dim, bias=False)

self.fc_out = nn.Linear(heads * self.head_dim, embed_size)

def forward(self, values, keys, queries, mask):

N = queries.shape[0]

value_len, key_len, query_len = values.shape[1], keys.shape[1], queries.shape[1]

# Split the embedding into self.head different pieces

values = values.reshape(N, value_len, self.heads, self.head_dim)

keys = keys.reshape(N, key_len, self.heads, self.head_dim)

queries = queries.reshape(N, query_len, self.heads, self.head_dim)

values = self.values(values)

keys = self.keys(keys)

queries = self.queries(queries)

# Scaled dot-product attention

attention = torch.einsum("nqhd,nkhd->nhqk", [queries, keys])

if mask is not None:

attention = attention.masked_fill(mask == 0, float("-1e20"))

attention = torch.nn.functional.softmax(attention, dim=3)

out = torch.einsum("nhql,nlhd->nqhd", [attention, values]).reshape(

N, query_len, self.heads * self.head_dim

)

out = self.fc_out(out)

return out

多頭注意力(Multi-Head Attention)

BERT進一步引入了多頭注意力(Multi-Head Attention),將自注意力分成多個「頭」,每個「頭」學習序列中不同部分的上下文資訊,最後將這些資訊合併起來。

預訓練和微調

BERT模型的成功很大程度上歸功於其兩階段的訓練策略:預訓練(Pre-training)和微調(Fine-tuning)。下面我們會詳細地探討這兩個過程的特點、技術點和需要注意的事項。

預訓練(Pre-training)

預訓練階段是BERT模型訓練過程中非常關鍵的一步。在這個階段,模型在大規模的無標籤文字資料上進行訓練,主要通過以下兩種任務來進行:

-

掩碼語言模型(Masked Language Model, MLM): 在這個任務中,輸入句子的某個比例的詞會被隨機地替換成特殊的

[MASK]標記,模型需要預測這些被掩碼的詞。 -

下一個句子預測(Next Sentence Prediction, NSP): 模型需要預測給定的兩個句子是否是連續的。

技術點:

-

動態掩碼: 在每個訓練週期(epoch)中,模型看到的每一個句子的掩碼都是隨機的,這樣可以增加模型的魯棒性。

-

分詞器: BERT使用了WordPiece分詞器,能有效處理未登入詞(OOV)。

注意點:

- 資料規模需要非常大,以充分訓練龐大的模型引數。

- 訓練過程通常需要大量的計算資源,例如高效能的GPU或TPU。

微調(Fine-tuning)

在預訓練模型好之後,接下來就是微調階段。微調通常在具有標籤的小規模資料集上進行,以使模型更好地適應特定的任務。

技術點:

-

學習率調整: 由於模型已經在大量資料上進行了預訓練,因此微調階段的學習率通常會設定得相對較低。

-

任務特定頭: 根據任務的不同,通常會在BERT模型的頂部新增不同的網路層(例如,用於分類任務的全連線層、用於序列標記的CRF層等)。

注意點:

- 避免過擬合:由於微調資料集通常比較小,因此需要仔細選擇合適的正則化策略,如Dropout或權重衰減(weight decay)。

通過這兩個階段的訓練,BERT不僅能夠捕捉到豐富的語意和語法資訊,還能針對特定任務進行優化,從而在各種NLP任務中都表現得非常出色。

BERT與其他Transformer架構的不同之處

預訓練策略

雖然Transformer架構通常也會進行某種形式的預訓練,但BERT特意設計了兩個階段:預訓練和微調。這使得BERT可以首先在大規模無標籤資料上進行預訓練,然後針對特定任務進行微調,從而實現了更廣泛的應用。

雙向編碼

大多數基於Transformer的模型(例如GPT)通常只使用單向或者條件編碼。與之不同,BERT使用雙向編碼,可以更全面地捕捉到文字中詞元的上下文資訊。

掩碼語言模型(Masked Language Model)

BERT在預訓練階段使用了一種名為「掩碼語言模型」(Masked Language Model, MLM)的特殊訓練策略。在這個過程中,模型需要預測輸入序列中被隨機掩碼(mask)的詞元,這迫使模型更好地理解句子結構和語意資訊。

四、BERT的場景應用

BERT模型由於其強大的表徵能力和靈活性,在各種自然語言處理(NLP)任務中都有廣泛的應用。下面,我們將探討幾個常見的應用場景,並提供相關的程式碼範例。

文字分類

文字分類是NLP中最基礎的任務之一。使用BERT,你可以輕鬆地將文字分類到預定義的類別中。

from transformers import BertTokenizer, BertForSequenceClassification

import torch

# 載入預訓練的BERT模型和分詞器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased')

# 準備輸入資料

inputs = tokenizer("Hello, how are you?", return_tensors="pt")

# 前向傳播

labels = torch.tensor([1]).unsqueeze(0) # Batch size 1, label set as 1

outputs = model(**inputs, labels=labels)

loss = outputs.loss

logits = outputs.logits

情感分析

情感分析是文字分類的一個子任務,用於判斷一段文字的情感傾向(正面、負面或中性)。

# 繼續使用上面的模型和分詞器

inputs = tokenizer("I love programming.", return_tensors="pt")

# 判斷情感

outputs = model(**inputs)

logits = outputs.logits

predictions = torch.softmax(logits, dim=-1)

命名實體識別(Named Entity Recognition, NER)

命名實體識別是識別文字中特定型別實體(如人名、地名、組織名等)的任務。

from transformers import BertForTokenClassification

# 載入用於Token分類的BERT模型

model = BertForTokenClassification.from_pretrained('dbmdz/bert-large-cased-finetuned-conll03-english')

# 輸入資料

inputs = tokenizer("My name is John.", return_tensors="pt")

# 前向傳播

outputs = model(**inputs)

logits = outputs.logits

文字摘要

BERT也可以用於生成文字摘要,即從一個長文字中提取出最重要的資訊。

from transformers import BertForConditionalGeneration

# 載入用於條件生成的BERT模型(這是一個假設的例子,實際BERT原生不支援條件生成)

model = BertForConditionalGeneration.from_pretrained('some-conditional-bert-model')

# 輸入資料

inputs = tokenizer("The quick brown fox jumps over the lazy dog.", return_tensors="pt")

# 生成摘要

summary_ids = model.generate(inputs.input_ids, num_beams=4, min_length=5, max_length=20)

print(tokenizer.decode(summary_ids[0], skip_special_tokens=True))

這只是使用BERT進行實戰應用的冰山一角。其靈活和強大的特性使它能夠廣泛應用於各種複雜的NLP任務。通過合理的預處理、模型選擇和微調,你幾乎可以用BERT解決任何自然語言處理問題。

五、BERT的Python和PyTorch實現

預訓練模型的載入

載入預訓練的BERT模型是使用BERT進行自然語言處理任務的第一步。由於BERT模型通常非常大,手動實現整個架構並載入預訓練權重是不現實的。幸運的是,有幾個庫簡化了這一過程,其中包括transformers庫,該庫提供了豐富的預訓練模型和相應的工具。

安裝依賴庫

首先,你需要安裝transformers和torch庫。你可以使用下面的pip命令進行安裝:

pip install transformers

pip install torch

載入模型和分詞器

使用transformers庫,載入BERT模型和相應的分詞器變得非常簡單。下面是一個簡單的範例:

from transformers import BertTokenizer, BertModel

# 初始化分詞器和模型

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased")

model = BertModel.from_pretrained("bert-base-uncased")

# 檢視模型架構

print(model)

這段程式碼會下載BERT的基礎版本(uncased)和相關的分詞器。你還可以選擇其他版本,如bert-large-uncased。

輸入準備

載入了模型和分詞器後,下一步是準備輸入資料。假設我們有一個句子:"Hello, BERT!"。

# 分詞

inputs = tokenizer("Hello, BERT!", padding=True, truncation=True, return_tensors="pt")

print(inputs)

tokenizer會自動將文字轉換為模型所需的所有型別的輸入張量,包括input_ids、attention_mask等。

模型推理

準備好輸入後,下一步是進行模型推理,以獲取各種輸出:

with torch.no_grad():

outputs = model(**inputs)

# 輸出的是一個元組

# outputs[0] 是所有隱藏狀態的最後一層的輸出

# outputs[1] 是句子的CLS標籤的隱藏狀態

last_hidden_states = outputs[0]

pooler_output = outputs[1]

print(last_hidden_states.shape)

print(pooler_output.shape)

輸出的last_hidden_states張量的形狀為 [batch_size, sequence_length, hidden_dim],而pooler_output的形狀為 [batch_size, hidden_dim]。

以上就是載入預訓練BERT模型和進行基本推理的全過程。在理解了這些基礎知識後,你可以輕鬆地將BERT用於各種NLP任務,包括但不限於文字分類、命名實體識別或問答系統。

微調BERT模型

微調(Fine-tuning)是將預訓練的BERT模型應用於特定NLP任務的關鍵步驟。在此過程中,我們在特定任務的資料集上進一步訓練模型,以便更準確地進行預測或分類。以下是使用PyTorch和transformers庫進行微調的詳細步驟。

資料準備

假設我們有一個簡單的文字分類任務,其中有兩個類別:正面和負面。我們將使用PyTorch的DataLoader和Dataset進行資料載入和預處理。

from torch.utils.data import DataLoader, Dataset

import torch

class TextClassificationDataset(Dataset):

def __init__(self, texts, labels, tokenizer):

self.texts = texts

self.labels = labels

self.tokenizer = tokenizer

def __len__(self):

return len(self.texts)

def __getitem__(self, idx):

text = self.texts[idx]

label = self.labels[idx]

inputs = self.tokenizer(text, padding='max_length', truncation=True, max_length=512, return_tensors="pt")

return {

'input_ids': inputs['input_ids'].flatten(),

'attention_mask': inputs['attention_mask'].flatten(),

'labels': torch.tensor(label, dtype=torch.long)

}

# 假設texts和labels分別是文字和標籤的列表

texts = ["I love programming", "I hate bugs"]

labels = [1, 0]

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

dataset = TextClassificationDataset(texts, labels, tokenizer)

dataloader = DataLoader(dataset, batch_size=2)

微調模型

在這裡,我們將BERT模型與一個簡單的分類層組合。然後,在微調過程中,同時更新BERT模型和分類層的權重。

from transformers import BertForSequenceClassification

from torch.optim import AdamW

# 初始化模型

model = BertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=2)

# 使用AdamW優化器

optimizer = AdamW(model.parameters(), lr=1e-5)

# 訓練模型

for epoch in range(3):

for batch in dataloader:

input_ids = batch['input_ids']

attention_mask = batch['attention_mask']

labels = batch['labels']

outputs = model(input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

optimizer.zero_grad()

print(f'Epoch {epoch + 1} completed')

模型評估

完成微調後,我們可以在測試資料集上評估模型的效能。

# 在測試資料集上進行評估...

通過這樣的微調過程,BERT模型不僅能夠從預訓練中獲得的通用知識,而且能針對特定任務進行優化。

六、總結

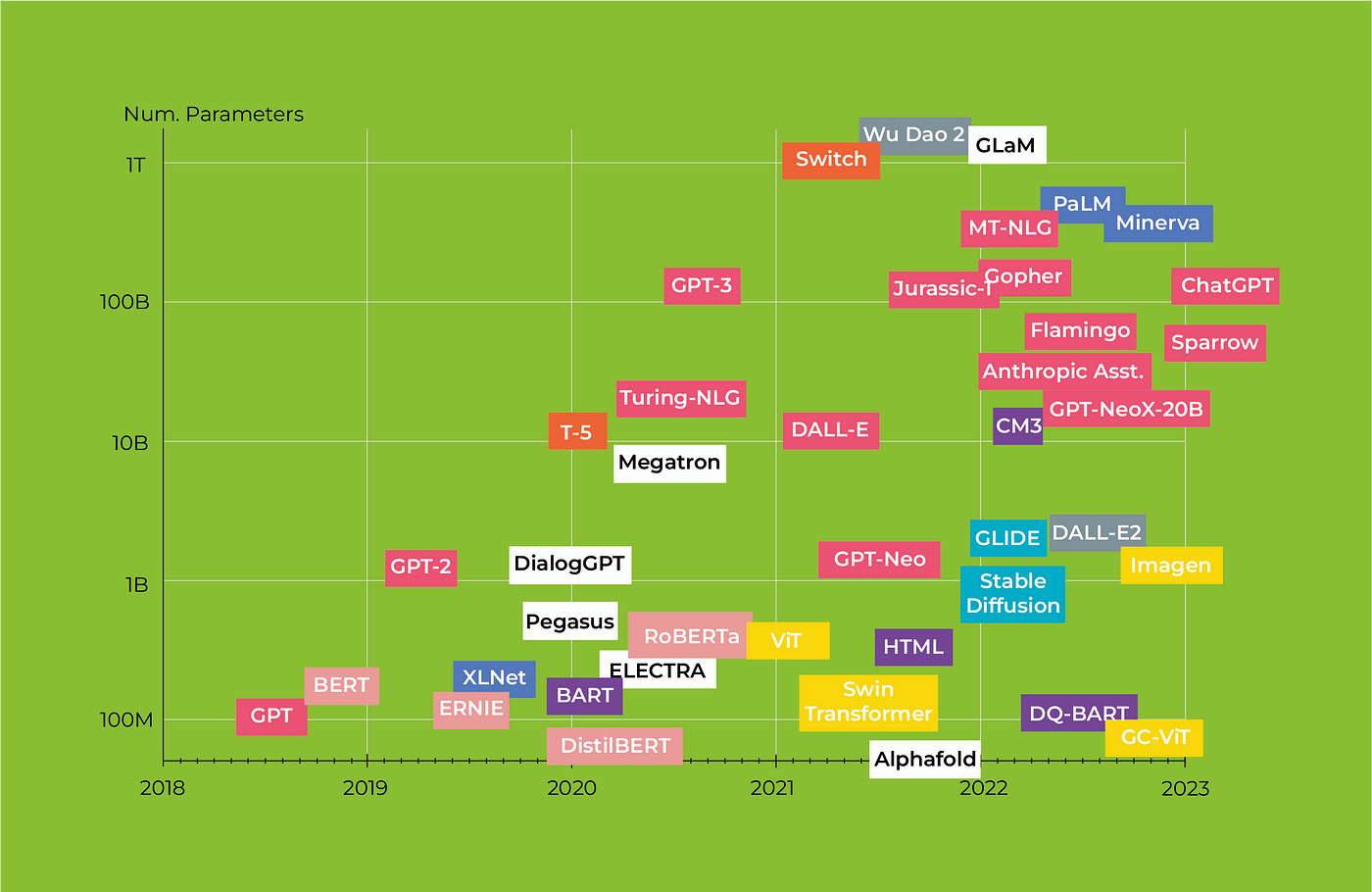

經過對BERT(Bidirectional Encoder Representations from Transformers)的深入探討,我們有機會一窺這一先進架構的內在複雜性和功能豐富性。從其強大的雙向注意力機制,到預訓練和微調的多樣性應用,BERT已經在自然語言處理(NLP)領域中設定了新的標準。

架構的價值

-

預訓練和微調: BERT的預訓練-微調正規化幾乎是一種「一刀切」的解決方案,可以輕鬆地適應各種NLP任務,從而減少了從頭開始訓練模型的複雜性和計算成本。

-

通用性與專門化: BERT的另一個優點是它的靈活性。雖然原始的BERT模型是一個通用的語言模型,但通過微調,它可以輕鬆地適應多種任務和行業特定的需求。

-

高度解釋性: 雖然深度學習模型通常被認為是「黑盒」,但BERT和其他基於注意力的模型提供了一定程度的解釋性。例如,通過分析注意力權重,我們可以瞭解模型在做決策時到底關注了哪些部分的輸入。

發展前景

-

可延伸性: 雖然BERT模型本身已經非常大,但它的架構是可延伸的。這為未來更大和更復雜的模型鋪平了道路,這些模型有可能捕獲更復雜的語言結構和語意。

-

多模態學習與聯合訓練: 隨著研究的進展,將BERT與其他型別的資料(如影象和音訊)結合的趨勢正在增加。這種多模態學習方法將進一步提高模型的泛化能力和應用範圍。

-

優化與壓縮: 雖然BERT的效能出色,但其計算成本也很高。因此,模型優化和壓縮將是未來研究的重要方向,以便在資源受限的環境中部署這些高效能模型。

綜上所述,BERT不僅是自然語言處理中的一個里程碑,也為未來的研究和應用提供了豐富的土壤。正如我們在本文中所探討的,通過理解其內部機制和學習如何進行有效的微調,我們可以更好地利用這一強大工具來解決各種各樣的問題。毫無疑問,BERT和類似的模型將繼續引領NLP和AI的未來發展。

關注TechLead,分享AI全維度知識。作者擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

如有幫助,請多關注

TeahLead KrisChang,10+年的網際網路和人工智慧從業經驗,10年+技術和業務團隊管理經驗,同濟軟體工程本科,復旦工程管理碩士,阿里雲認證雲服務資深架構師,上億營收AI產品業務負責人。