一文讀懂強化學習:RL全面解析與Pytorch實戰

在本篇文章中,我們全面而深入地探討了強化學習(Reinforcement Learning)的基礎概念、主流演演算法和實戰步驟。從馬爾可夫決策過程(MDP)到高階演演算法如PPO,文章旨在為讀者提供一套全面的理論框架和實用工具。同時,我們還專門探討了強化學習在多個領域,如遊戲、金融、醫療和自動駕駛等的具體應用場景。每個部分都提供了詳細的Python和PyTorch程式碼範例,以助於更好地理解和應用這些概念。

關注TechLead,分享AI全維度知識。作者擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

一、引言

強化學習(Reinforcement Learning, RL)是人工智慧(AI)和機器學習(ML)領域的一個重要子領域,與監督學習和無監督學習並列。它模仿了生物體通過與環境互動來學習最優行為的過程。與傳統的監督學習不同,強化學習沒有事先標記好的資料集來訓練模型。相反,它依靠智慧體(Agent)通過不斷嘗試、失敗、適應和優化來學習如何在給定環境中實現特定目標。

強化學習的核心組成

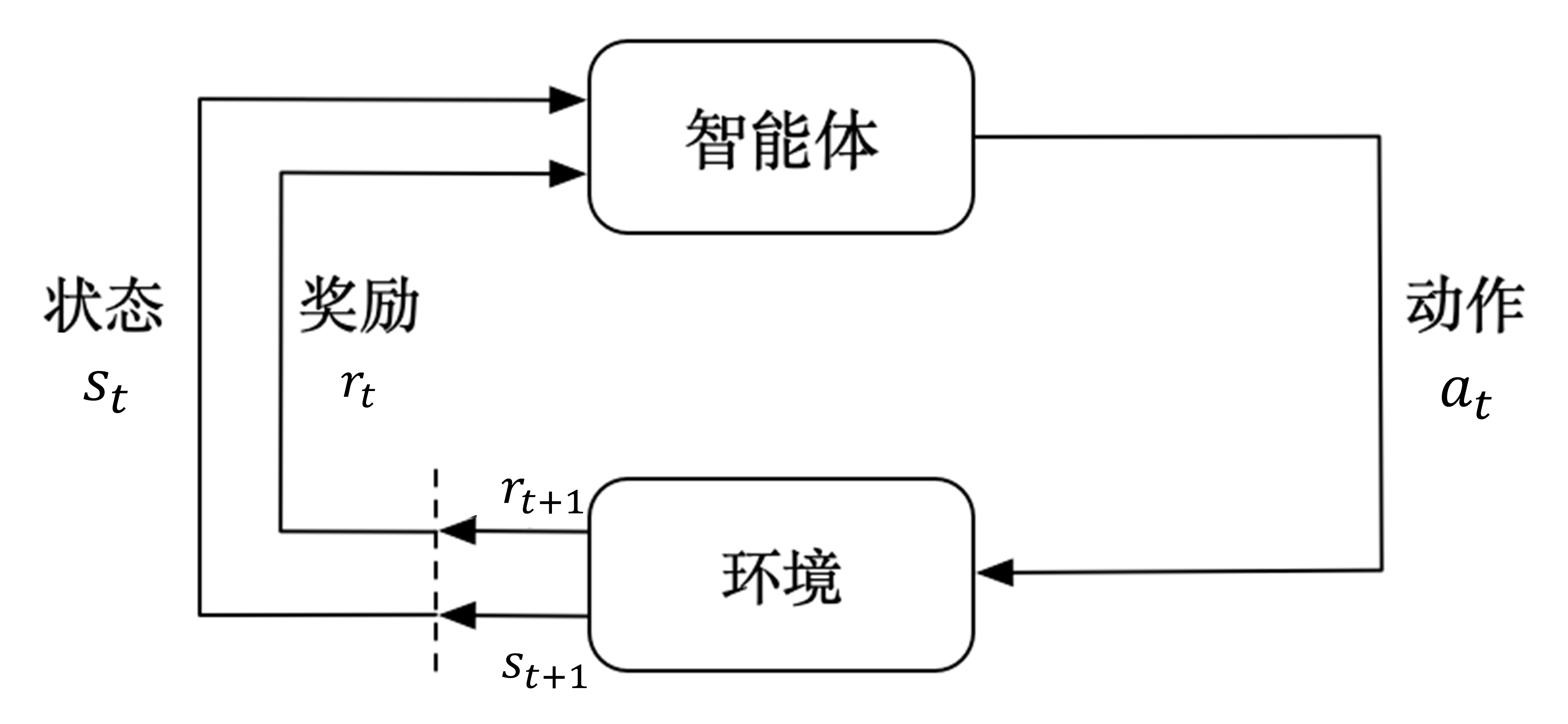

強化學習的框架主要由以下幾個核心組成:

-

狀態(State):反映環境或系統當前的情況。

-

動作(Action):智慧體在特定狀態下可以採取的操作。

-

獎勵(Reward):一個數值反饋,用於量化智慧體採取某一動作後環境的反應。

-

策略(Policy):一個對映函數,指導智慧體在特定狀態下應採取哪一動作。

這四個元素共同構成了馬爾可夫決策過程(Markov Decision Process, MDP),這是強化學習最核心的數學模型。

為什麼強化學習重要?

實用性與廣泛應用

強化學習的重要性首先體現在其廣泛的應用價值。從自動駕駛、遊戲AI、到量化交易、工業自動化,以及近年來在自然語言處理、推薦系統等方面的突破,強化學習都發揮著不可或缺的角色。

自適應與優化

傳統的演演算法往往是靜態的,即它們沒有能力去適應不斷變化的環境或引數。而強化學習演演算法則可以不斷地適應和優化,這使它們能在更加複雜和動態的環境中表現出色。

推動AI研究前沿

強化學習也在推動人工智慧的研究前沿,特別是在解決一些需要長期規劃和決策的複雜問題上。例如,強化學習已成功地應用於圍棋演演算法AlphaGo中,擊敗了人類世界冠軍,這標誌著AI在執行復雜任務方面取得了重大突破。

引領倫理與社會思考

隨著強化學習在自動決策系統中的應用越來越廣泛,如何設計公平、透明和可解釋的演演算法也引發了眾多倫理和社會問題,這需要我們更加深入地去探索和理解強化學習的各個方面。

二、強化學習基礎

強化學習的核心是建模決策問題,並通過與環境的互動來學習最佳決策方案。這一過程常常是通過馬爾可夫決策過程(Markov Decision Process, MDP)來描述和解決的。在本節中,我們將詳細地探討馬爾可夫決策過程以及其核心元件:獎勵、狀態、動作和策略。

馬爾可夫決策過程(MDP)

MDP是用來描述決策問題的數學模型,主要由一個四元組 ( (S, A, R, P) ) 組成。

-

狀態空間(S): 表示所有可能狀態的集合。

-

動作空間(A): 表示在特定狀態下可能採取的所有動作的集合。

-

獎勵函數(R): ( R(s, a, s') ) 表示在狀態 ( s ) 下采取動作 ( a ) 並轉移到狀態 ( s' ) 時所獲得的即時獎勵。

-

轉移概率(P): ( P(s' | s, a) ) 表示在狀態 ( s ) 下采取動作 ( a ) 轉移到狀態 ( s' ) 的概率。

狀態(State)

在MDP中,狀態是用來描述環境或問題的現狀。在不同應用中,狀態可以有很多種表現形式:

- 在棋類遊戲中,狀態通常表示棋盤上各個棋子的位置。

- 在自動駕駛中,狀態可能包括車輛的速度、位置、以及周圍物件的狀態等。

動作(Action)

動作是智慧體(Agent)在某一狀態下可以採取的操作。動作會影響環境,並可能導致狀態的轉變。

- 在股市交易中,動作通常是「買入」、「賣出」或「持有」。

- 在遊戲如「超級馬里奧」中,動作可能包括「跳躍」、「下蹲」或「向前移動」等。

獎勵(Reward)

獎勵是一個數值反饋,用於評估智慧體採取某一動作的「好壞」。通常,智慧體的目標是最大化累積獎勵。

- 在迷宮問題中,到達目的地可能會得到正獎勵,而撞到牆壁則可能會得到負獎勵。

策略(Policy)

策略是一個從狀態到動作的對映函數,用於指導智慧體在每一狀態下應採取哪一動作。形式上,策略通常表示為 ( \pi(a|s) ),代表在狀態 ( s ) 下采取動作 ( a ) 的概率。

- 在遊戲如「五子棋」中,策略可能是一個複雜的神經網路,用於評估每一步棋的優劣。

通過優化策略,我們可以使智慧體在與環境的互動中獲得更高的累積獎勵,從而實現更優的效能。

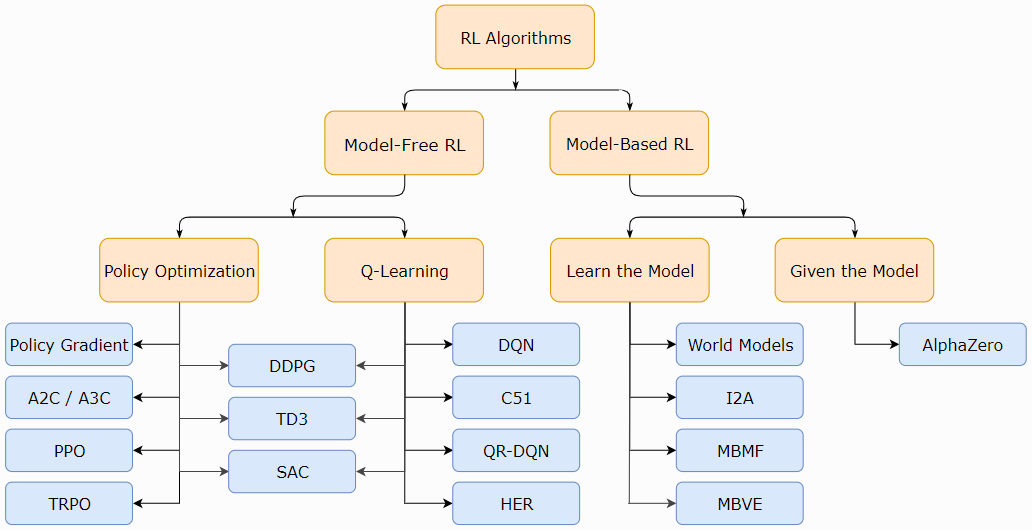

三、常用強化學習演演算法

強化學習擁有多種演演算法,用於解決不同型別的問題。在本節中,我們將探討幾種常用的強化學習演演算法,包括他們的工作原理、意義以及應用範例。

值迭代(Value Iteration)

演演算法描述

值迭代是一種基於動態規劃(Dynamic Programming)的方法,用於計算最優策略。主要思想是通過迭代更新狀態值函數(Value Function)來找到最優策略。

演演算法意義

值迭代演演算法主要用於解決具有完全可觀測狀態和已知轉移概率的MDP問題。它是一種「模型已知」的演演算法。

應用範例

值迭代經常用於路徑規劃、遊戲(如迷宮問題)等環境中,其中所有狀態和轉移概率都是已知的。

Q學習(Q-Learning)

演演算法描述

Q學習是一種基於值函數的「模型無知」演演算法。它通過更新Q值(狀態-動作值函數)來找到最優策略。

演演算法意義

Q學習演演算法適用於「模型無知」的場景,也就是說,智慧體並不需要知道環境的完整資訊。因此,Q學習特別適用於現實世界的問題。

應用範例

Q學習廣泛用於機器人導航、電子商務推薦系統以及多玩家遊戲等。

Policy Gradients(策略梯度)

演演算法描述

與基於值函數的方法不同,策略梯度方法直接在策略空間中進行優化。演演算法通過計算梯度來更新策略引數。

演演算法意義

策略梯度方法特別適用於處理高維或連續的動作和狀態空間,而這些在基於值的方法中通常很難處理。

應用範例

策略梯度方法在自然語言處理(如機器翻譯)、連續控制問題(如機器人手臂控制)等方面有廣泛應用。

Actor-Critic(演員-評論家)

演演算法描述

Actor-Critic 結合了值函數方法和策略梯度方法的優點。其中,"Actor" 負責決策,"Critic" 負責評價這些決策。

演演算法意義

通過結合值函數和策略優化,Actor-Critic 能在各種不同的環境中實現更快和更穩定的學習。

應用範例

在自動駕駛、資源分配和多智慧體系統等複雜問題中,Actor-Critic 方法被廣泛應用。

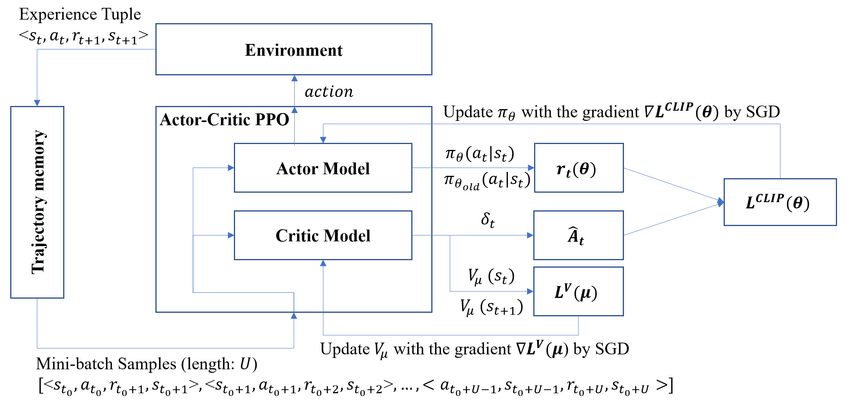

四、PPO(Proximal Policy Optimization)演演算法

PPO是一種高效、可靠的強化學習演演算法,屬於策略梯度家族的一部分。由於其高效和穩定的性質,PPO演演算法在各種強化學習任務中都有廣泛的應用。

與強化學習的關係

PPO是用於解決馬爾可夫決策過程(MDP)問題的演演算法。它通過優化策略(Policy)來讓智慧體在不同狀態下選擇最優動作,從而最大化預期的累積獎勵。

原理

PPO的核心思想是通過限制策略更新的步長來避免太大的效能下降。這是通過引入一種特殊的目標函數實現的,該目標函數包含一個剪輯(Clipping)項來限制策略的改變程度。

具體的目標函數如下:

細節

-

多步優勢估計: PPO通常與多步回報(Multi-Step Return)和優勢函數(Advantage Function)結合使用,以減少估計誤差。

-

自適應學習率: PPO通常使用自適應學習率和高階優化器(如Adam)。

-

並行取樣: 由於PPO是一種「樣本高效」的演演算法,通常與並行環境取樣結合使用,以進一步提高效率。

程式碼舉例

下面是使用Python和PyTorch實現PPO的簡單範例:

import torch

import torch.nn as nn

import torch.optim as optim

# 定義策略網路

class PolicyNetwork(nn.Module):

def __init__(self, state_dim, action_dim):

super(PolicyNetwork, self).__init__()

self.fc = nn.Linear(state_dim, 128)

self.policy_head = nn.Linear(128, action_dim)

def forward(self, x):

x = torch.relu(self.fc(x))

return torch.softmax(self.policy_head(x), dim=-1)

# 初始化

state_dim = 4 # 狀態維度

action_dim = 2 # 動作維度

policy_net = PolicyNetwork(state_dim, action_dim)

optimizer = optim.Adam(policy_net.parameters(), lr=1e-3)

epsilon = 0.2

# 取樣資料(這裡假設有一批樣本資料)

states = torch.rand(10, state_dim)

actions = torch.randint(0, action_dim, (10,))

advantages = torch.rand(10)

# 計算舊策略的動作概率

with torch.no_grad():

old_probs = policy_net(states).gather(1, actions.unsqueeze(-1)).squeeze()

# PPO更新

for i in range(4): # Typically we run multiple epochs

action_probs = policy_net(states).gather(1, actions.unsqueeze(-1)).squeeze()

ratio = action_probs / old_probs

surr1 = ratio * advantages

surr2 = torch.clamp(ratio, 1-epsilon, 1+epsilon) * advantages

loss = -torch.min(surr1, surr2).mean()

optimizer.zero_grad()

loss.backward()

optimizer.step()

print("PPO Update Done!")

這只是一個非常基礎的範例,實際應用中還需要包括更多元素,如狀態標準化、網路結構優化等。

五、強化學習實戰

5.1 模型建立

在強化學習實戰中,模型建立是第一步也是至關重要的一步。通常,這一階段包括環境設定、模型架構設計和資料預處理等。以下是一個使用PyTorch實現強化學習模型的範例,這裡我們使用一個簡單的CartPole環境作為案例。

環境設定

首先,我們需要安裝必要的庫並設定環境。

pip install gym

pip install torch

接著,我們將匯入這些庫:

import gym

import torch

import torch.nn as nn

import torch.optim as optim

建立Gym環境

使用OpenAI的Gym庫,我們可以方便地建立CartPole環境:

env = gym.make('CartPole-v1')

模型架構

接下來,我們設計一個簡單的神經網路來作為策略網路。該網路將接收環境狀態作為輸入,並輸出各個動作的概率。

class PolicyNetwork(nn.Module):

def __init__(self, input_dim, output_dim):

super(PolicyNetwork, self).__init__()

self.fc1 = nn.Linear(input_dim, 64)

self.fc2 = nn.Linear(64, output_dim)

def forward(self, state):

x = torch.relu(self.fc1(state))

action_probs = torch.softmax(self.fc2(x), dim=-1)

return action_probs

初始化模型和優化器

在定義了模型架構之後,我們需要對其進行初始化,並選擇一個優化器。

input_dim = env.observation_space.shape[0] # 狀態空間維度

output_dim = env.action_space.n # 動作空間大小

policy_net = PolicyNetwork(input_dim, output_dim)

optimizer = optim.Adam(policy_net.parameters(), lr=1e-2)

5.2 模型評估

模型評估通常包括在一系列測試環境下進行模擬執行,以及計算各種效能指標。

測試環境執行

以下程式碼展示瞭如何在Gym的CartPole環境中測試訓練好的模型:

def evaluate_policy(policy_net, env, episodes=10):

total_rewards = 0

for i in range(episodes):

state = env.reset()

done = False

episode_reward = 0

while not done:

state_tensor = torch.FloatTensor(state).unsqueeze(0)

with torch.no_grad():

action_probs = policy_net(state_tensor)

action = torch.argmax(action_probs).item()

next_state, reward, done, _ = env.step(action)

episode_reward += reward

state = next_state

total_rewards += episode_reward

average_reward = total_rewards / episodes

return average_reward

# 使用上文定義的PolicyNetwork和初始化的env

average_reward = evaluate_policy(policy_net, env)

print(f"Average reward over {episodes} episodes: {average_reward}")

效能指標

效能指標可能包括平均獎勵、方差、最大/最小獎勵等。這些指標有助於我們瞭解模型在不同情況下的穩定性和可靠性。

# 在這裡,我們已經計算了平均獎勵

# 在更復雜的場景中,你可能還需要計算其他指標,如獎勵的標準差等。

5.3 模型上線

模型上線通常包括模型的儲存、載入和實際環境中的部署。

模型儲存和載入

PyTorch提供了非常方便的API來儲存和載入模型。

# 儲存模型

torch.save(policy_net.state_dict(), 'policy_net_model.pth')

# 載入模型

loaded_policy_net = PolicyNetwork(input_dim, output_dim)

loaded_policy_net.load_state_dict(torch.load('policy_net_model.pth'))

部署到實際環境

模型部署的具體步驟取決於應用場景。在某些線上系統中,可能需要將PyTorch模型轉換為ONNX或TensorRT格式以提高推理速度。

# 範例:將PyTorch模型轉為ONNX格式

dummy_input = torch.randn(1, input_dim)

torch.onnx.export(policy_net, dummy_input, "policy_net_model.onnx")

總結

強化學習(Reinforcement Learning, RL)是人工智慧中最具潛力和挑戰性的研究方向之一。通過本篇文章,我們深入探討了強化學習的核心概念,包括馬爾可夫決策過程(Markov Decision Processes, MDP)以及其中的獎勵、狀態、動作和策略等要素。我們還介紹了多種主流的強化學習演演算法,如Q-Learning, DQN, 和PPO等,每一種演演算法都有其獨特的優點和應用場景。

在強化學習實戰部分,我們以CartPole環境為例,從模型建立到模型評估和上線,全方位地講解了一個完整的RL專案的實施步驟。我們還提供了詳盡的PyTorch程式碼範例和解釋,幫助讀者更好地理解和應用這些概念。

強化學習不僅在理論研究中佔有重要地位,也在實際應用,如自動駕駛、金融交易和醫療診斷等多個領域有著廣泛的應用前景。然而,強化學習也面臨多個挑戰,包括但不限於資料稀疏性、訓練不穩定和環境模擬等。因此,掌握強化學習的基礎知識和實戰經驗,將為解決這些複雜問題提供有力的工具和視角。

關注TechLead,分享AI全維度知識。作者擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

如有幫助,請多關注

TeahLead KrisChang,10+年的網際網路和人工智慧從業經驗,10年+技術和業務團隊管理經驗,同濟軟體工程本科,復旦工程管理碩士,阿里雲認證雲服務資深架構師,上億營收AI產品業務負責人。