如何在 RHEL8 /CentOS8 上建立多節點 Elastic stack 叢集

Elastic stack 俗稱 ELK stack,是一組包括 Elasticsearch、Logstash 和 Kibana 在內的開源產品。Elastic Stack 由 Elastic 公司開發和維護。使用 Elastic stack,可以將系統紀錄檔傳送到 Logstash,它是一個資料收集引擎,接受來自可能任何來源的紀錄檔或資料,並對紀錄檔進行歸一化,然後將紀錄檔轉發到 Elasticsearch,用於分析、索引、搜尋和儲存,最後使用 Kibana 表示為視覺化資料,使用 Kibana,我們還可以基於使用者的查詢建立互動式圖表。

在本文中,我們將演示如何在 RHEL 8 / CentOS 8 伺服器上設定多節點 elastic stack 叢集。以下是我的 Elastic Stack 叢集的詳細資訊:

Elasticsearch:

- 三台伺服器,最小化安裝 RHEL 8 / CentOS 8

- IP & 主機名 – 192.168.56.40(

elasticsearch1.linuxtechi.local)、192.168.56.50 (elasticsearch2.linuxtechi.local)、192.168.56.60(elasticsearch3.linuxtechi.local`)

Logstash:**

- 兩台伺服器,最小化安裝 RHEL 8 / CentOS 8

- IP & 主機 – 192.168.56.20(

logstash1.linuxtechi.local)、192.168.56.30(logstash2.linuxtechi.local)

Kibana:

- 一台伺服器,最小化安裝 RHEL 8 / CentOS 8

- IP & 主機名 – 192.168.56.10(

kibana.linuxtechi.local)

Filebeat:

- 一台伺服器,最小化安裝 CentOS 7

- IP & 主機名 – 192.168.56.70(

web-server)

讓我們從設定 Elasticsearch 叢集開始,

設定3個節點 Elasticsearch 叢集

正如我已經說過的,設定 Elasticsearch 叢集的節點,登入到每個節點,設定主機名並設定 yum/dnf 庫。

使用命令 hostnamectl 設定各個節點上的主機名:

[root@linuxtechi ~]# hostnamectl set-hostname "elasticsearch1.linuxtechi. local"[root@linuxtechi ~]# exec bash[root@linuxtechi ~]#[root@linuxtechi ~]# hostnamectl set-hostname "elasticsearch2.linuxtechi. local"[root@linuxtechi ~]# exec bash[root@linuxtechi ~]#[root@linuxtechi ~]# hostnamectl set-hostname "elasticsearch3.linuxtechi. local"[root@linuxtechi ~]# exec bash[root@linuxtechi ~]#對於 CentOS 8 系統,我們不需要設定任何作業系統包庫,對於 RHEL 8 伺服器,如果你有有效訂閱,那麼用紅帽訂閱以獲得包儲存庫就可以了。如果你想為作業系統包設定本地 yum/dnf 儲存庫,請參考以下網址:

在所有節點上設定 Elasticsearch 包儲存庫,在 /etc/yum.repo.d/ 資料夾下建立一個包含以下內容的 elastic.repo 檔案:

~]# vi /etc/yum.repos.d/elastic.repo[elasticsearch-7.x]name=Elasticsearch repository for 7.x packagesbaseurl=https://artifacts.elastic.co/packages/7.x/yumgpgcheck=1gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearchenabled=1autorefresh=1type=rpm-md儲存檔案並退出。

在所有三個節點上使用 rpm 命令匯入 Elastic 公共簽名金鑰。

~]# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch在所有三個節點的 /etc/hosts 檔案中新增以下行:

192.168.56.40 elasticsearch1.linuxtechi.local192.168.56.50 elasticsearch2.linuxtechi.local192.168.56.60 elasticsearch3.linuxtechi.local使用 yum/dnf 命令在所有三個節點上安裝 Java:

[root@linuxtechi ~]# dnf install java-openjdk -y[root@linuxtechi ~]# dnf install java-openjdk -y[root@linuxtechi ~]# dnf install java-openjdk -y使用 yum/dnf 命令在所有三個節點上安裝 Elasticsearch:

[root@linuxtechi ~]# dnf install elasticsearch -y[root@linuxtechi ~]# dnf install elasticsearch -y[root@linuxtechi ~]# dnf install elasticsearch -y注意: 如果作業系統防火牆已啟用並在每個 Elasticsearch 節點中執行,則使用 firewall-cmd 命令允許以下埠開放:

~]# firewall-cmd --permanent --add-port=9300/tcp~]# firewall-cmd --permanent --add-port=9200/tcp~]# firewall-cmd --reload設定 Elasticsearch, 在所有節點上編輯檔案 /etc/elasticsearch/elasticsearch.yml 並加入以下內容:

~]# vim /etc/elasticsearch/elasticsearch.ymlcluster.name: opn-clusternode.name: elasticsearch1.linuxtechi.localnetwork.host: 192.168.56.40http.port: 9200discovery.seed_hosts: ["elasticsearch1.linuxtechi.local", "elasticsearch2.linuxtechi.local", "elasticsearch3.linuxtechi.local"]cluster.initial_master_nodes: ["elasticsearch1.linuxtechi.local", "elasticsearch2.linuxtechi.local", "elasticsearch3.linuxtechi.local"]注意: 在每個節點上,在 node.name 中填寫正確的主機名,在 network.host 中填寫正確的 IP 地址,其他引數保持不變。

現在使用 systemctl 命令在所有三個節點上啟動並啟用 Elasticsearch 服務:

~]# systemctl daemon-reload~]# systemctl enable elasticsearch.service~]# systemctl start elasticsearch.service使用下面 ss 命令驗證 elasticsearch 節點是否開始監聽 9200 埠:

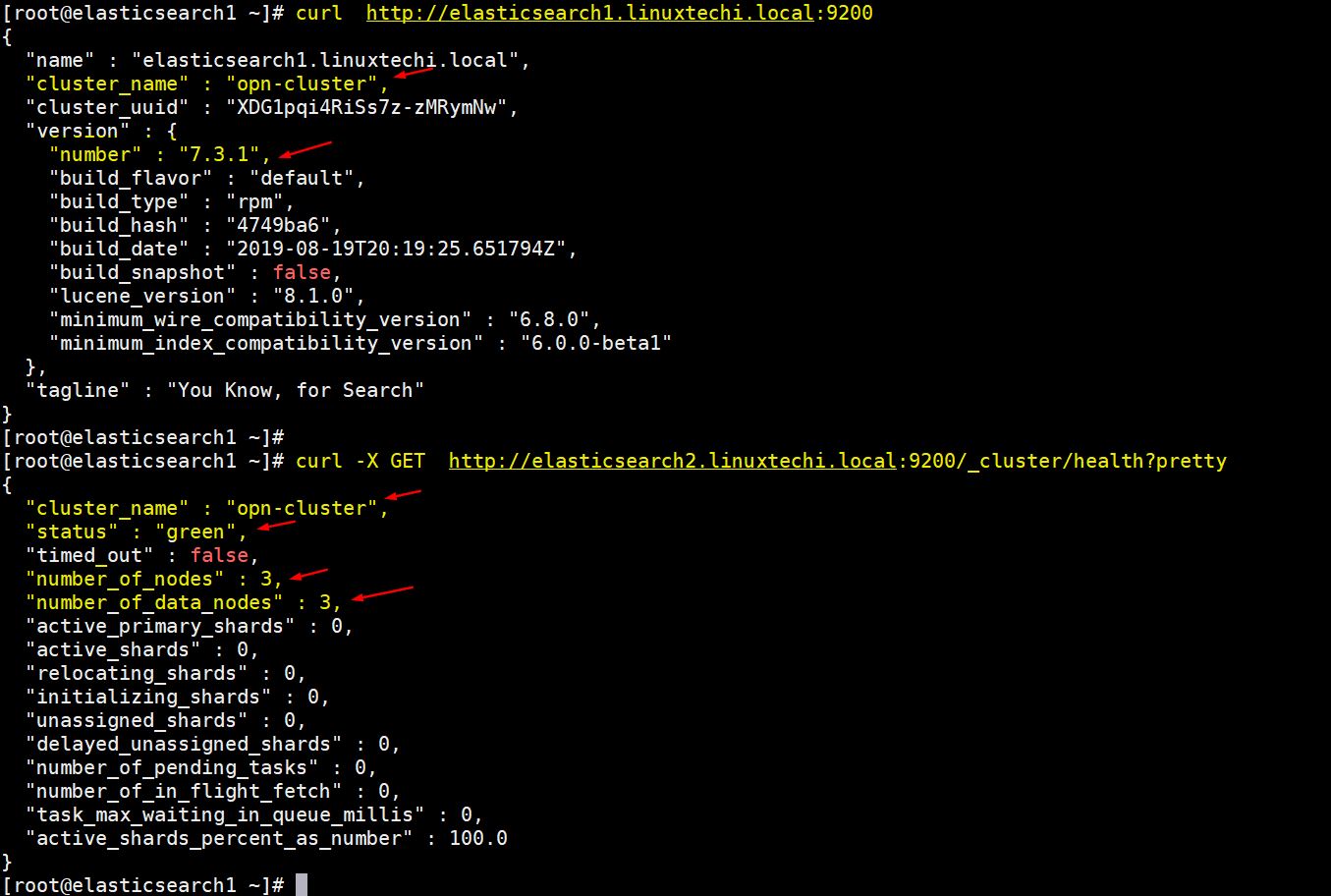

[root@linuxtechi ~]# ss -tunlp | grep 9200tcp LISTEN 0 128 [::ffff:192.168.56.40]:9200 *:* users:(("java",pid=2734,fd=256))[root@linuxtechi ~]#使用以下 curl 命令驗證 Elasticsearch 群集狀態:

[root@linuxtechi ~]# curl http://elasticsearch1.linuxtechi.local:9200[root@linuxtechi ~]# curl -X GET http://elasticsearch2.linuxtechi.local:9200/_cluster/health?pretty命令的輸出如下所示:

以上輸出表明我們已經成功建立了 3 節點的 Elasticsearch 叢集,叢集的狀態也是綠色的。

注意: 如果你想修改 JVM 堆大小,那麼你可以編輯了檔案 /etc/elasticsearch/jvm.options,並根據你的環境更改以下引數:

-Xms1g-Xmx1g

現在讓我們轉到 Logstash 節點。

安裝和設定 Logstash

在兩個 Logstash 節點上執行以下步驟。

登入到兩個節點使用 hostnamectl 命令設定主機名:

[root@linuxtechi ~]# hostnamectl set-hostname "logstash1.linuxtechi.local"[root@linuxtechi ~]# exec bash[root@linuxtechi ~]#[root@linuxtechi ~]# hostnamectl set-hostname "logstash2.linuxtechi.local"[root@linuxtechi ~]# exec bash[root@linuxtechi ~]#在兩個 logstash 節點的 /etc/hosts 檔案中新增以下條目:

~]# vi /etc/hosts192.168.56.40 elasticsearch1.linuxtechi.local192.168.56.50 elasticsearch2.linuxtechi.local192.168.56.60 elasticsearch3.linuxtechi.local儲存檔案並退出。

在兩個節點上設定 Logstash 儲存庫,在資料夾 /ete/yum.repo.d/ 下建立一個包含以下內容的檔案 logstash.repo:

~]# vi /etc/yum.repos.d/logstash.repo[elasticsearch-7.x]name=Elasticsearch repository for 7.x packagesbaseurl=https://artifacts.elastic.co/packages/7.x/yumgpgcheck=1gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearchenabled=1autorefresh=1type=rpm-md儲存並退出檔案,執行 rpm 命令匯入簽名金鑰:

~]# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch使用 yum/dnf 命令在兩個節點上安裝 Java OpenJDK:

~]# dnf install java-openjdk -y從兩個節點執行 yum/dnf 命令來安裝 logstash:

[root@linuxtechi ~]# dnf install logstash -y[root@linuxtechi ~]# dnf install logstash -y現在設定 logstash,在兩個 logstash 節點上執行以下步驟,建立一個 logstash 組態檔,首先我們在 /etc/logstash/conf.d/ 下複製 logstash 範例檔案:

# cd /etc/logstash/# cp logstash-sample.conf conf.d/logstash.conf編輯組態檔並更新以下內容:

# vi conf.d/logstash.confinput { beats { port => 5044 }}output { elasticsearch { hosts => ["http://elasticsearch1.linuxtechi.local:9200", "http://elasticsearch2.linuxtechi.local:9200", "http://elasticsearch3.linuxtechi.local:9200"] index => "%{[@metadata][beat]}-%{[@metadata][version]}-%{+YYYY.MM.dd}" #user => "elastic" #password => "changeme" }}在 output 部分之下,在 hosts 引數中指定所有三個 Elasticsearch 節點的 FQDN,其他引數保持不變。

使用 firewall-cmd 命令在作業系統防火牆中允許 logstash 埠 “5044”:

~ # firewall-cmd --permanent --add-port=5044/tcp~ # firewall-cmd –reload現在,在每個節點上執行以下 systemctl 命令,啟動並啟用 Logstash 服務:

~]# systemctl start logstash~]# systemctl eanble logstash使用 ss 命令驗證 logstash 服務是否開始監聽 5044 埠:

[root@linuxtechi ~]# ss -tunlp | grep 5044tcp LISTEN 0 128 *:5044 *:* users:(("java",pid=2416,fd=96))[root@linuxtechi ~]#以上輸出表明 logstash 已成功安裝和設定。讓我們轉到 Kibana 安裝。

安裝和設定 Kibana

登入 Kibana 節點,使用 hostnamectl 命令設定主機名:

[root@linuxtechi ~]# hostnamectl set-hostname "kibana.linuxtechi.local"[root@linuxtechi ~]# exec bash[root@linuxtechi ~]#編輯 /etc/hosts 檔案並新增以下行:

192.168.56.40 elasticsearch1.linuxtechi.local192.168.56.50 elasticsearch2.linuxtechi.local192.168.56.60 elasticsearch3.linuxtechi.local使用以下命令設定 Kibana 儲存庫:

[root@linuxtechi ~]# vi /etc/yum.repos.d/kibana.repo[elasticsearch-7.x]name=Elasticsearch repository for 7.x packagesbaseurl=https://artifacts.elastic.co/packages/7.x/yumgpgcheck=1gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearchenabled=1autorefresh=1type=rpm-md[root@linuxtechi ~]# rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch執行 yum/dnf 命令安裝 kibana:

[root@linuxtechi ~]# yum install kibana -y通過編輯 /etc/kibana/kibana.yml 檔案,設定 Kibana:

[root@linuxtechi ~]# vim /etc/kibana/kibana.yml…………server.host: "kibana.linuxtechi.local"server.name: "kibana.linuxtechi.local"elasticsearch.hosts: ["http://elasticsearch1.linuxtechi.local:9200", "http://elasticsearch2.linuxtechi.local:9200", "http://elasticsearch3.linuxtechi.local:9200"]…………啟用並啟動 kibana 服務:

[root@linuxtechi ~]# systemctl start kibana[root@linuxtechi ~]# systemctl enable kibana在系統防火牆上允許 Kibana 埠 “5601”:

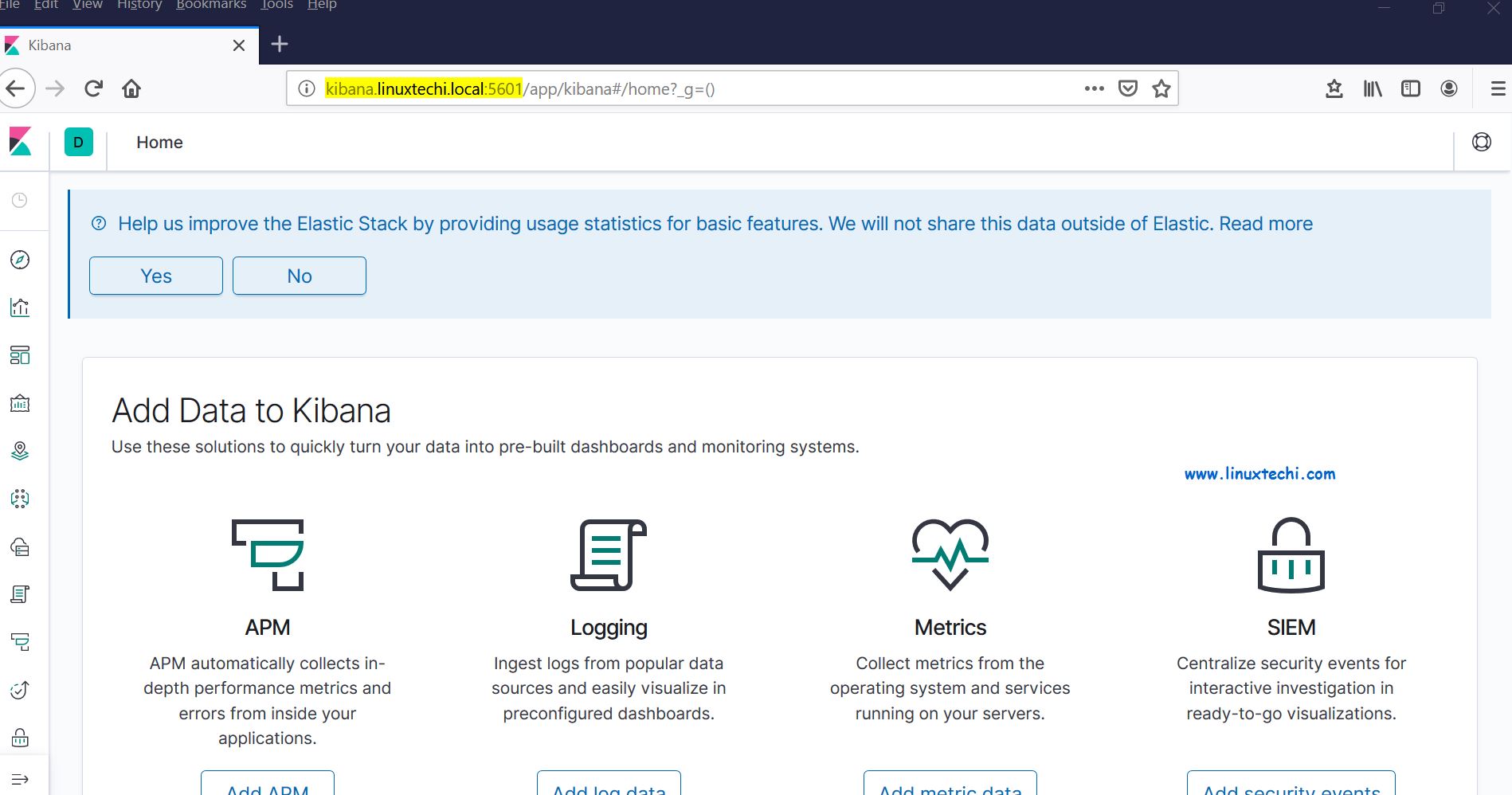

[root@linuxtechi ~]# firewall-cmd --permanent --add-port=5601/tcpsuccess[root@linuxtechi ~]# firewall-cmd --reloadsuccess[root@linuxtechi ~]#使用以下 URL 存取 Kibana 介面:http://kibana.linuxtechi.local:5601

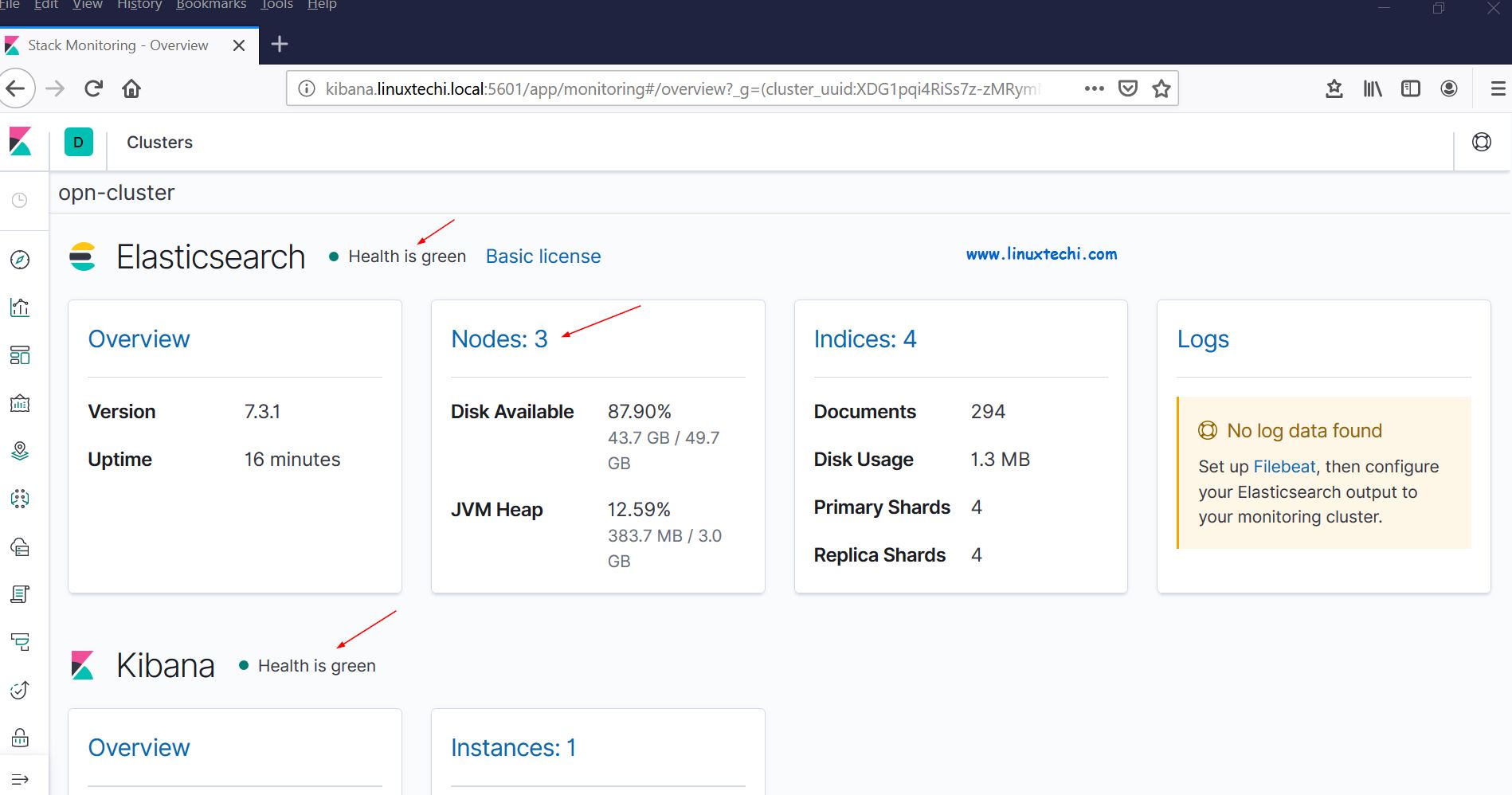

從面板上,我們可以檢查 Elastic Stack 叢集的狀態。

這證明我們已經在 RHEL 8 /CentOS 8 上成功地安裝並設定了多節點 Elastic Stack 叢集。

現在讓我們通過 filebeat 從其他 Linux 伺服器傳送一些紀錄檔到 logstash 節點中,在我的例子中,我有一個 CentOS 7伺服器,我將通過 filebeat 將該伺服器的所有重要紀錄檔推播到 logstash。

登入到 CentOS 7 伺服器使用 yum/rpm 命令安裝 filebeat 包:

[root@linuxtechi ~]# rpm -ivh https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-7.3.1-x86_64.rpmRetrieving https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-7.3.1-x86_64.rpmPreparing... ################################# [100%]Updating / installing... 1:filebeat-7.3.1-1 ################################# [100%][root@linuxtechi ~]#編輯 /etc/hosts 檔案並新增以下內容:

192.168.56.20 logstash1.linuxtechi.local192.168.56.30 logstash2.linuxtechi.local現在設定 filebeat,以便它可以使用負載平衡技術向 logstash 節點傳送紀錄檔,編輯檔案 /etc/filebeat/filebeat.yml,並新增以下引數:

在 filebeat.inputs: 部分將 enabled: false 更改為 enabled: true,並在 paths 引數下指定我們可以傳送到 logstash 的紀錄檔檔案的位置;注釋掉 output.elasticsearch 和 host 引數;刪除 output.logstash: 和 hosts: 的註釋,並在 hosts 引數新增兩個 logstash 節點,以及設定 loadbalance: true。

[root@linuxtechi ~]# vi /etc/filebeat/filebeat.ymlfilebeat.inputs:- type: log enabled: true paths: - /var/log/messages - /var/log/dmesg - /var/log/maillog - /var/log/boot.log#output.elasticsearch: # hosts: ["localhost:9200"]output.logstash: hosts: ["logstash1.linuxtechi.local:5044", "logstash2.linuxtechi.local:5044"] loadbalance: true使用下面的 2 個 systemctl 命令 啟動並啟用 filebeat 服務:

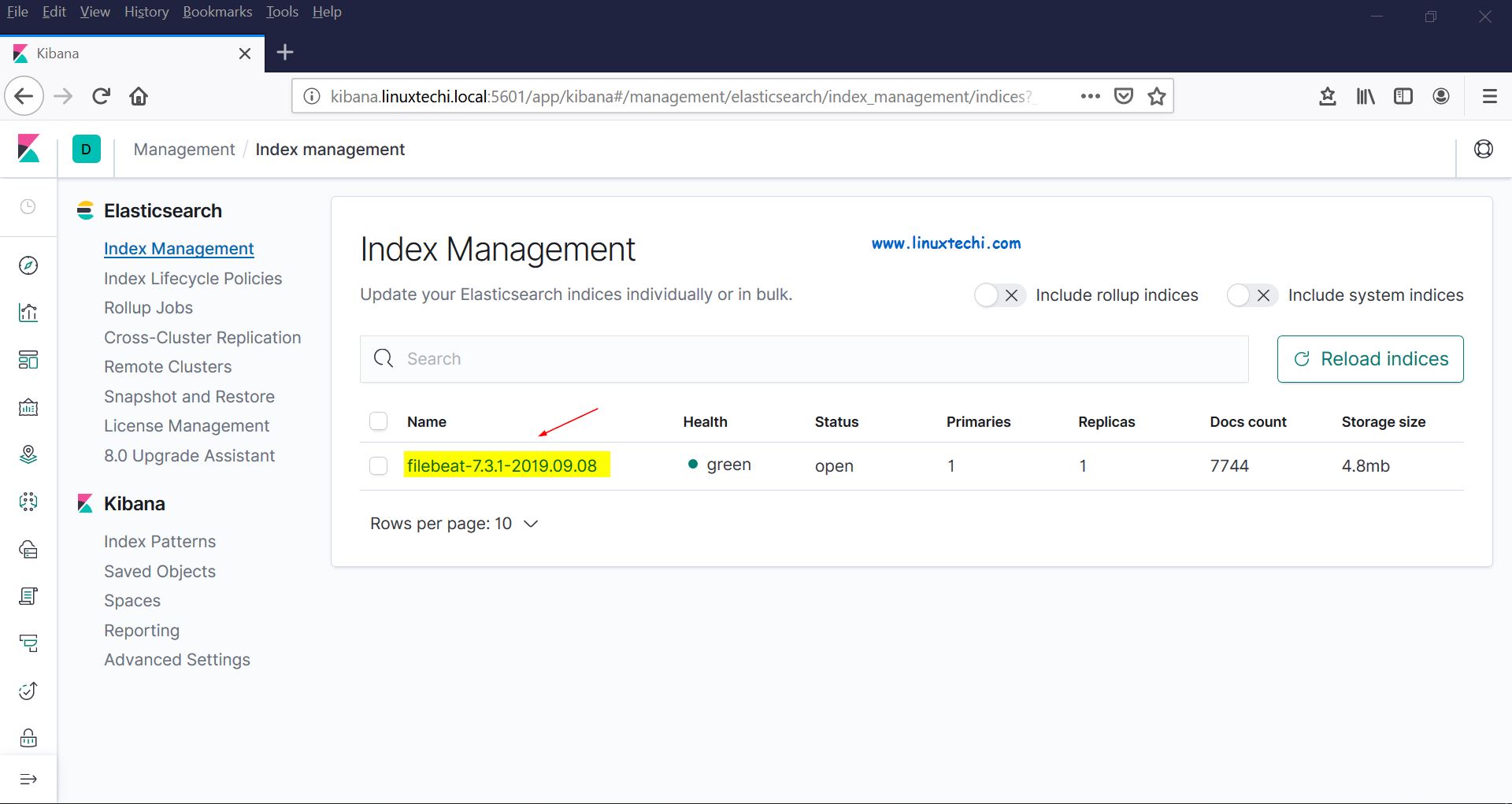

[root@linuxtechi ~]# systemctl start filebeat[root@linuxtechi ~]# systemctl enable filebeat現在轉到 Kibana 使用者介面,驗證新索引是否可見。

從左側欄中選擇管理選項,然後單擊 Elasticsearch 下的索引管理:

正如我們上面看到的,索引現在是可見的,讓我們現在建立索引模型。

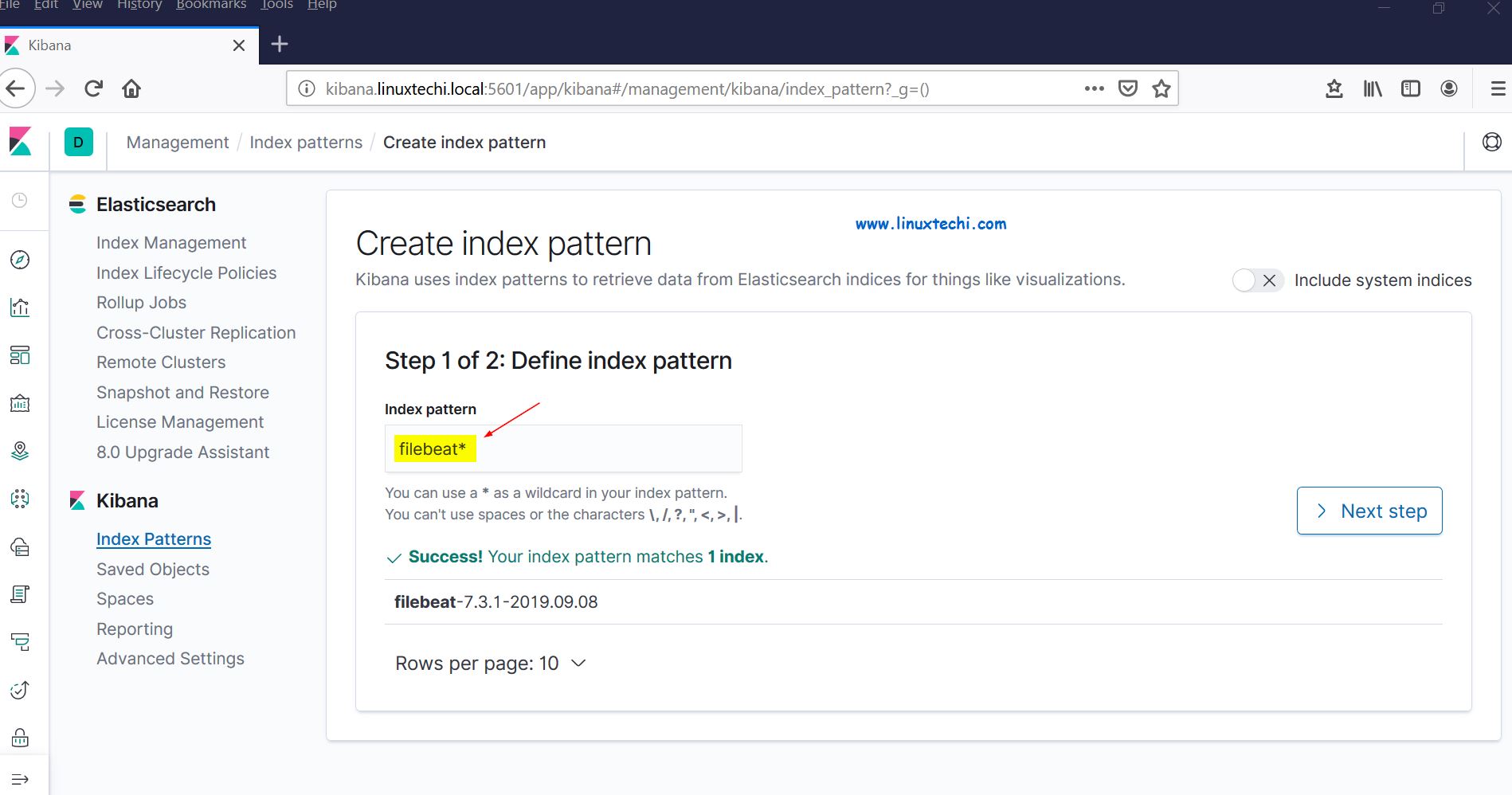

點選 Kibana 部分的 “Index Patterns”,它將提示我們建立一個新模型,點選 “Create Index Pattern” ,並將模式名稱指定為 “filebeat”:

點選下一步。

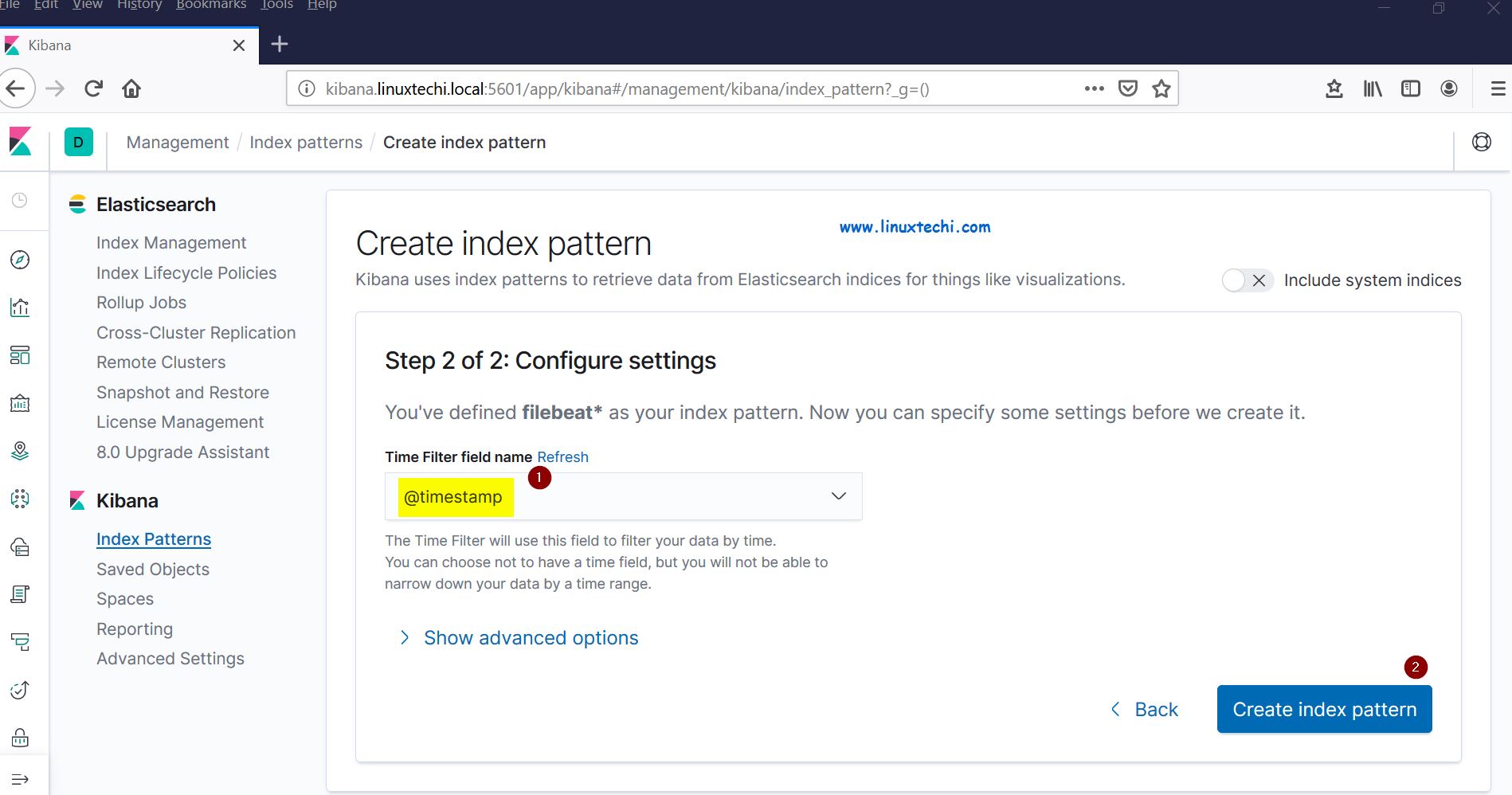

選擇 “Timestamp” 作為索引模型的時間過濾器,然後單擊 “Create index pattern”:

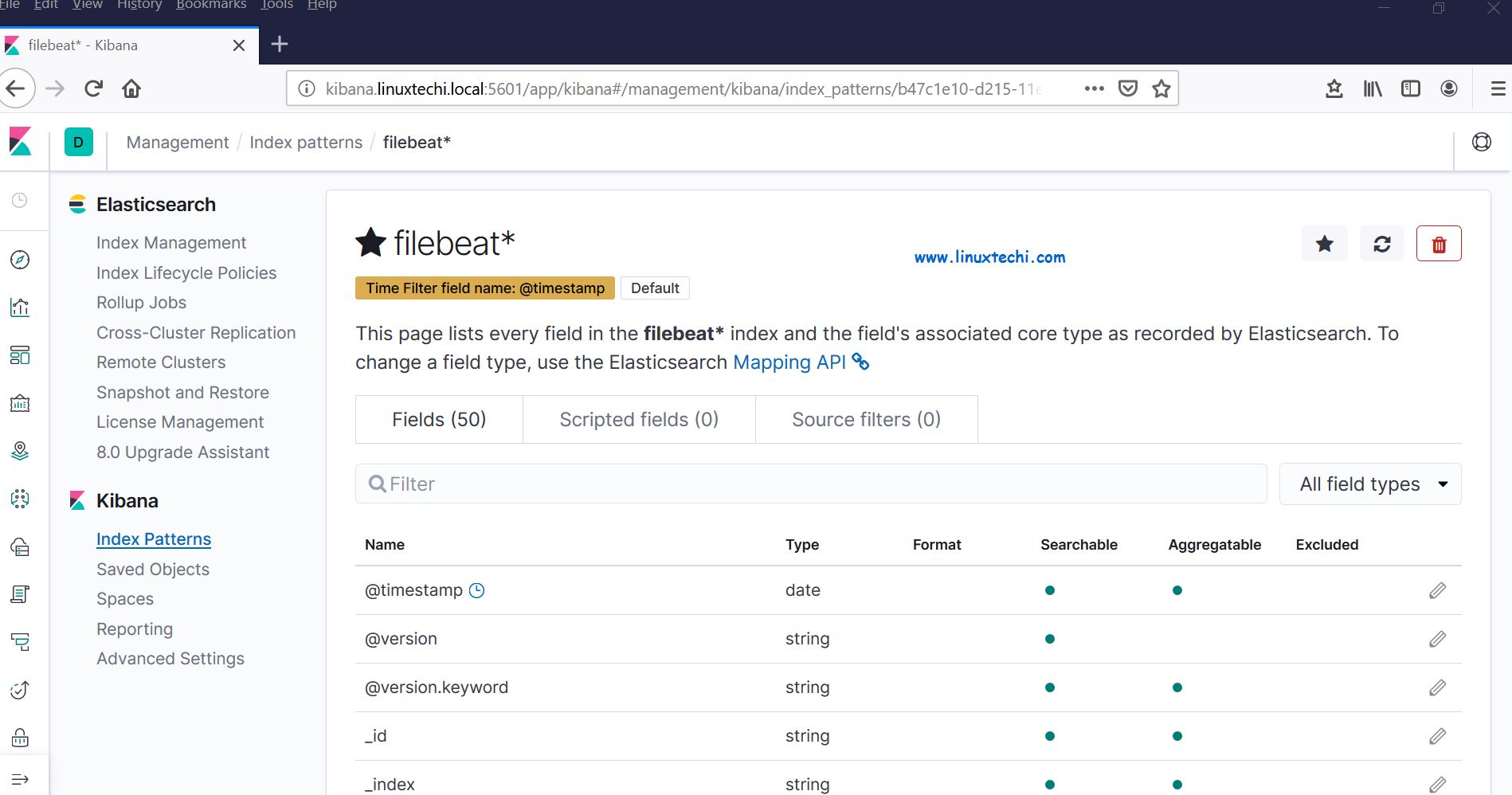

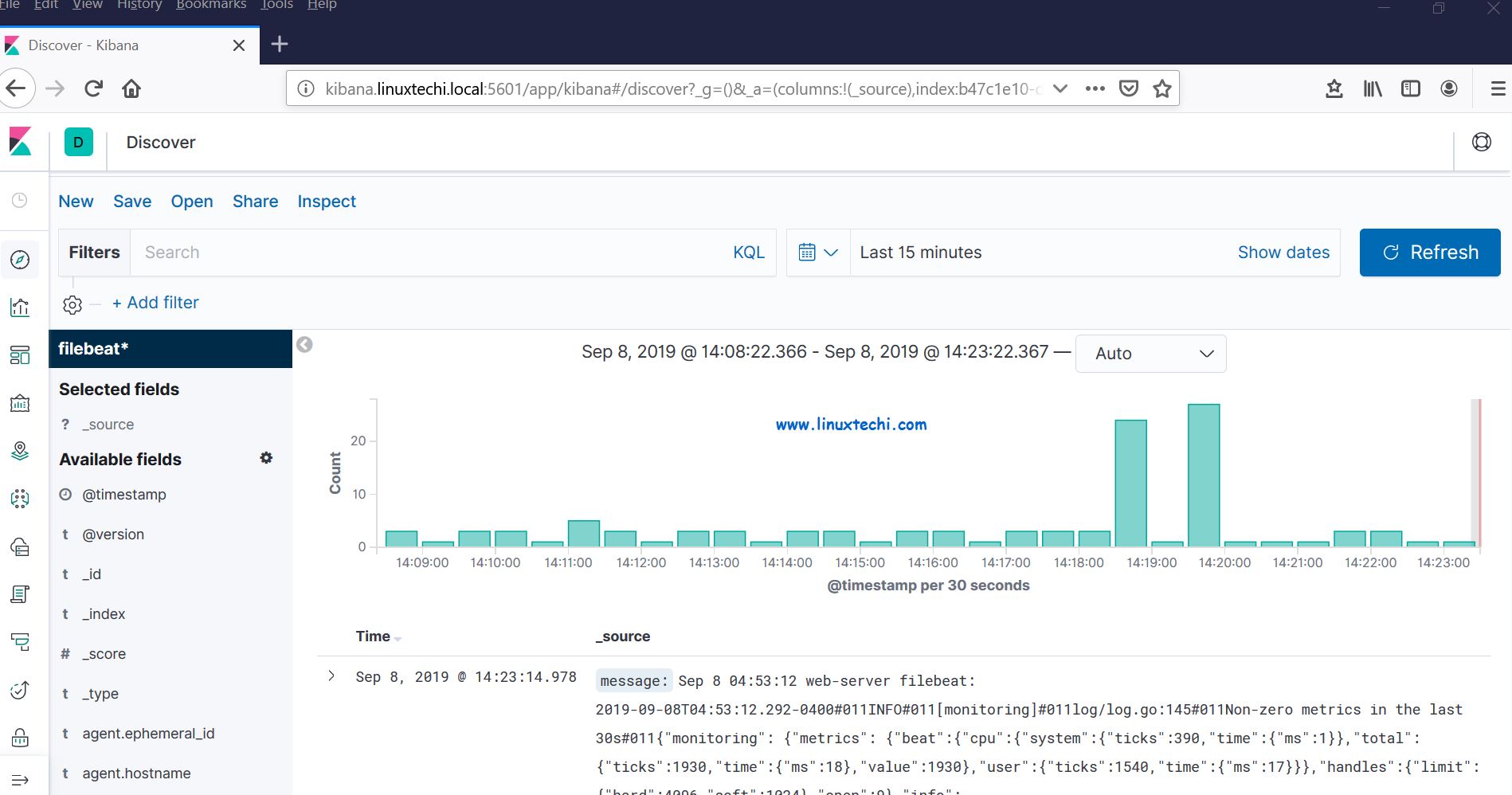

現在單擊檢視實時 filebeat 索引模型:

這表明 Filebeat 代理已設定成功,我們能夠在 Kibana 儀表盤上看到實時紀錄檔。

以上就是本文的全部內容,對這些幫助你在 RHEL 8 / CentOS 8 系統上設定 Elastic Stack 叢集的步驟,請不要猶豫分享你的反饋和意見。