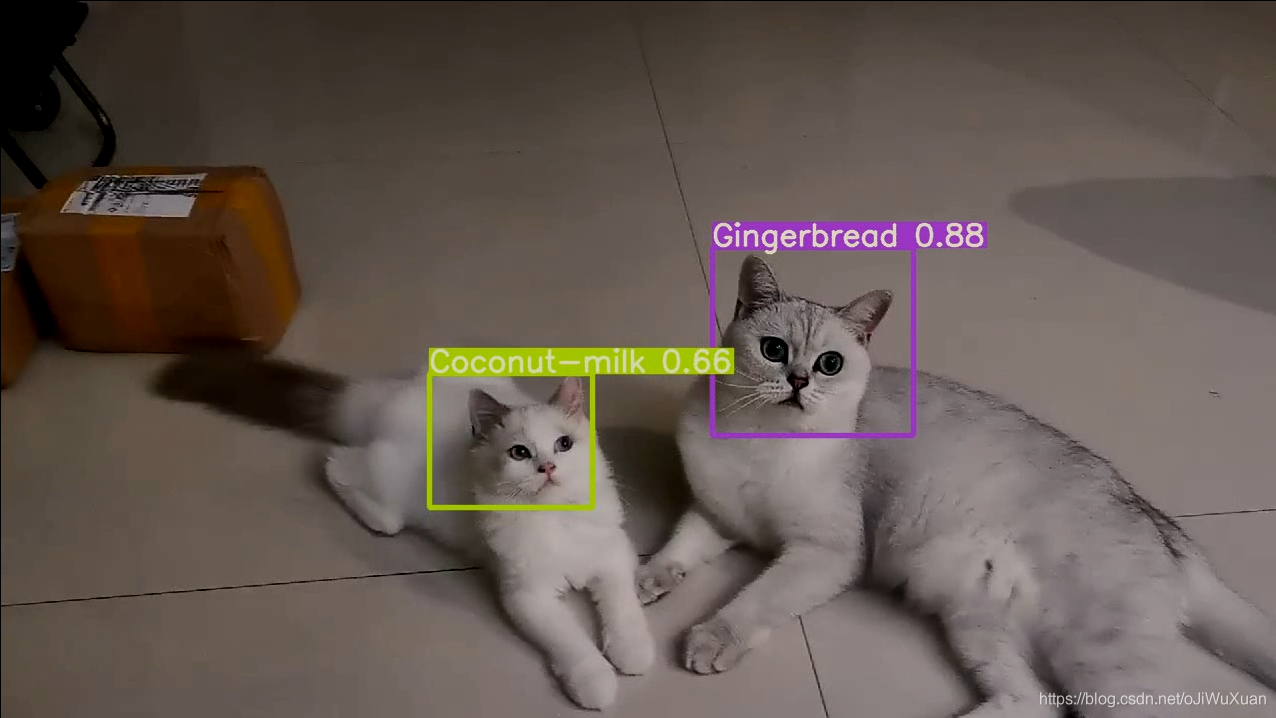

YOLOv5 實現目標檢測(訓練自己的資料集實現貓貓識別)

目前YOLOv5已經更新到v3.1版本了,相對於之前的v1.0,YOLOv5更小更精簡(只有不到1M),同時訓練的模型也更加輕量化,所以特地更新此文章,以適應v3.1版本的各種設定和YOLOv5的使用說明。

———————————————————————————————————

因YOLOv5的官方原始碼7月份進行了一次更新,有些模組比如apex可能在新的原始碼中已不再適用,所以我將6月份的一份原始碼放到了github上,並且在原始碼的基礎上增加了標記和處理資料集的功能,其中含有makeTxt.py和voc_label.py檔案和data目錄下的各種資料夾,大家可以拿過來按照說明設定好資料集後直接使用。

github:https://github.com/jiwuxuan/yolov5-master0

喜歡的話順手點個star,謝謝支援!**

———————————————————————————————————

一、概要

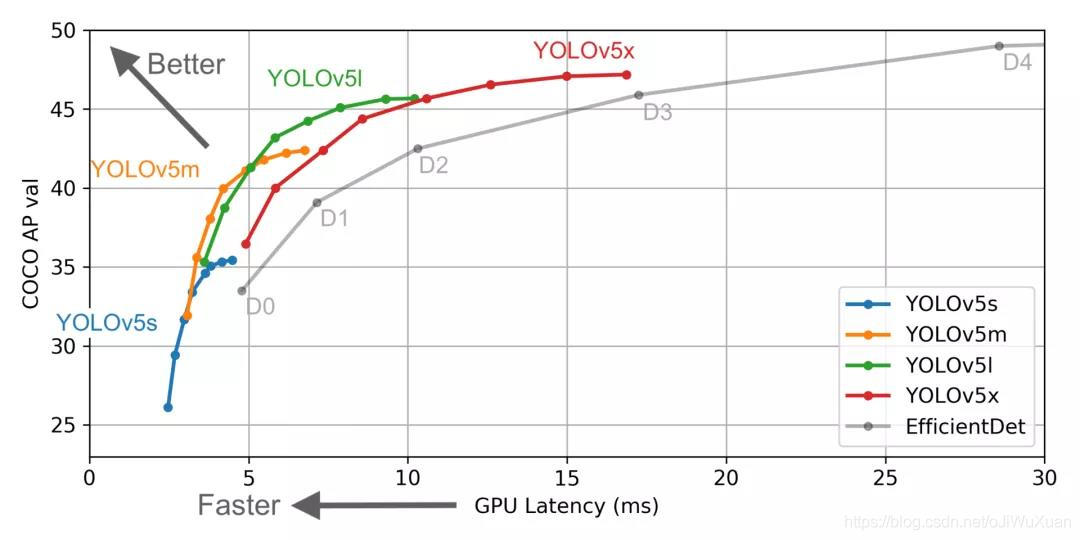

2020年6月10日,Ultralytics在github上正式釋出了YOLOv5。YOLO系列可以說是單機目標檢測框架中的潮流前線了,YOLOv5並不是一個單獨的模型,而是一個模型家族,包括了YOLOv5s(最小)、YOLOv5m、YOLOv5l、YOLOv5x(最大)。

由於YOLOv5是在PyTorch中實現的,它受益於成熟的PyTorch生態系統,支援更簡單,部署更容易,相對於YOLOv4,YOLOv5具有以下優點:

- 速度更快。在YOLOv5 Colab notebook上,執行Tesla

P100,我們看到每張影象的推理時間僅需0.007秒,這意味著每秒140幀(FPS),速度是YOLOv4的2倍還多。 - 精度更高。在Roboflow對血細胞計數和檢測(BCCD)資料集的測試中,只訓練了100個epochs就達到了大約0.895的平均精度(mAP)。誠然EfficientDet和YOLOv4的效能相當,但在準確率沒有任何損失的情況下,看到如此全面的效能提升是非常罕見的。

- 體積更小。YOLOv5的權重檔案是27兆位元組。YOLOv4(採用Darknet架構)的權重檔案是244兆。YOLOv5比YOLOv4小了近90%!這意味著YOLOv5可以更容易地部署到嵌入式裝置上。

既然YOLOv5如此之棒,那我們就體驗以下大神們的開源成果吧!

github地址:https://github.com/ultralytics/yolov5 [不到1M]

大神們還很貼心的把官方模型放到了網上,如果有梯子,可以下載下來直接測試一下,v3.1版本的官方模型的下載地址:https://github.com/ultralytics/yolov5/releases/tag/v3.1。博主這邊沒梯子,不過也無關緊要啦,畢竟我們用YOLOv5是識別具體的某項東西,需要自己用資料集來訓練模型,官方給的模型也不一定適合我們的業務場景。

至於YOLOv5的原理這裡就不多講了(其實是講不清),感興趣的可以自行搜尋。話不多說,直接上乾貨!

二、環境設定

2.1 基本設定

首先將YOLOv5專案下載到本地,然後設定虛擬環境conda create -n yolov5 python==3.7,在YOLOv5中儘量使用python3.7。專案的測試平臺為:

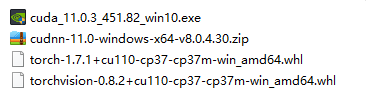

作業系統:windows10

IDE:Pycharm

python版本:anaconda Pyhon3.7

pytorch版本:torch 1.7.1

cuda版本:11.0

顯示卡:RTX 2060

cuda和pytorch的安裝這裡不再闡述,國內的話建議下載下來torch和torchvision的whl再進行安裝,防止網速不穩定出現安裝錯誤。本文所用到的cuda和pytorch的具體版本如下所示。

接著進入虛擬環境,使用pip安裝必要模組(建議換成國內的源後進行安裝):

pip install numpy

pip install matplotlib

pip install pandas

pip install scipy

pip install seaborn

pip install opencv-python

pip install tqdm

pip install pillow

pip install tensorboard

pip install pyyaml

pip install pandas

pip install scikit-image

pip install Cython

pip install thop

pip install pycocotools

2.2 pycocotools安裝

本專案需要pycocotools模組,COCO是一個大型的影象資料集,用於目標檢測、分割、人的關鍵點檢測、素材分割和標題生成,在python中用COCO資料集需要安裝pycocotools。但是在windows環境下無法直接通過pip安裝pycocotools,安裝方法如下:

先安裝Visual C++ 2015 build tools:Microsoft Visual C++ Build Tools 2015,安裝好後,在Terminal中執行下面命令:

pip install git+https://github.com/philferriere/cocoapi.git#subdirectory=PythonAPI

執行後即可安裝完畢。

2.3 apex安裝(v3.1版本暫不需要安裝apex)

apex是一款基於 PyTorch 的混合精度訓練加速神器,單純的inference實際上不需要apex模組,如果還要訓練自己的資料集,就需要安裝這個模組,安裝方法如下:

在github上把apex專案下載或者git到本地,連結為:https://github.com/NVIDIA/apex。

在terminal中啟用pytorch的環境,並且進入到apex的資料夾下,在terminal中執行:

python setup.py install

執行之後即安裝完畢。~~

具體安裝教學可以參考該博文:https://blog.csdn.net/mrjkzhangma/article/details/100704397

執行後可以執行pip list命令檢視當前環境下的所有模組,如果看到環境中有剛才安裝的的模組,則環境已經設定完畢!

三、YOLOv5 實現訓練

3.1 準備工作

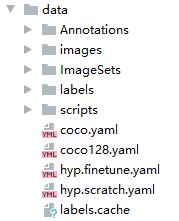

首先從github上下載下來YOLOv5,樓主這裡改名為yolov5-master-cat,因為是識別小貓貓的。然後在data目錄下新建Annotations, images, ImageSets, labels 四個資料夾。

其中images存放的是原始的圖片資料集,Annotations存放的是標記後生成的xml檔案,labels存放的是儲存標記內容的txt檔案,ImageSets存放的是訓練資料集和測試資料集的分類情況。

├── data

│ ├── Annotations 進行 detection 任務時的標籤檔案,xml 形式,檔名與圖片名一一對應

│ ├── images 存放 .jpg 格式的圖片檔案

│ ├── ImageSets 存放的是分類和檢測的資料集分割檔案,包含train.txt, val.txt,trainval.txt,test.txt

│ ├── labels 存放label標註資訊的txt檔案,與圖片一一對應

├── ImageSets(train,val,test建議按照8:1:1比例劃分)

│ ├── train.txt 寫著用於訓練的圖片名稱

│ ├── val.txt 寫著用於驗證的圖片名稱

│ ├── trainval.txt train與val的合集

│ ├── test.txt 寫著用於測試的圖片名稱

3.2 標記資料集

工欲善其事必先利其器,沒有合適的訓練資料集去訓練模型,哪怕YOLOv5這個目標識別框架再優秀那也只是個花架子啊。所以第一步我們要去準備我們的訓練資料集,樓主這裡要識別的是家裡的兩隻活潑可愛黏人乖巧聽話的小貓貓,所以準備了五六十張貓貓的照片。製作資料集時,通常使用labelImge標註工具,具體用法這裡不多做闡述,因為樓主用了另一種感覺更好用的標記工具:精靈標記助手。使用起來那是相當的順手啊,不僅操作簡單上手快,還可以儲存之前標註的資料集,方便後續對資料集標註內容的修改,而且相比於labelImge,RectLabel這些標註工具,精靈標記助手除了支援圖片標註外,還支援文字標註,視訊標註,而且還免費,真的算是業界良心了。

下載地址:http://www.jinglingbiaozhu.com/

參考博文:https://blog.csdn.net/youmumzcs/article/details/79657132

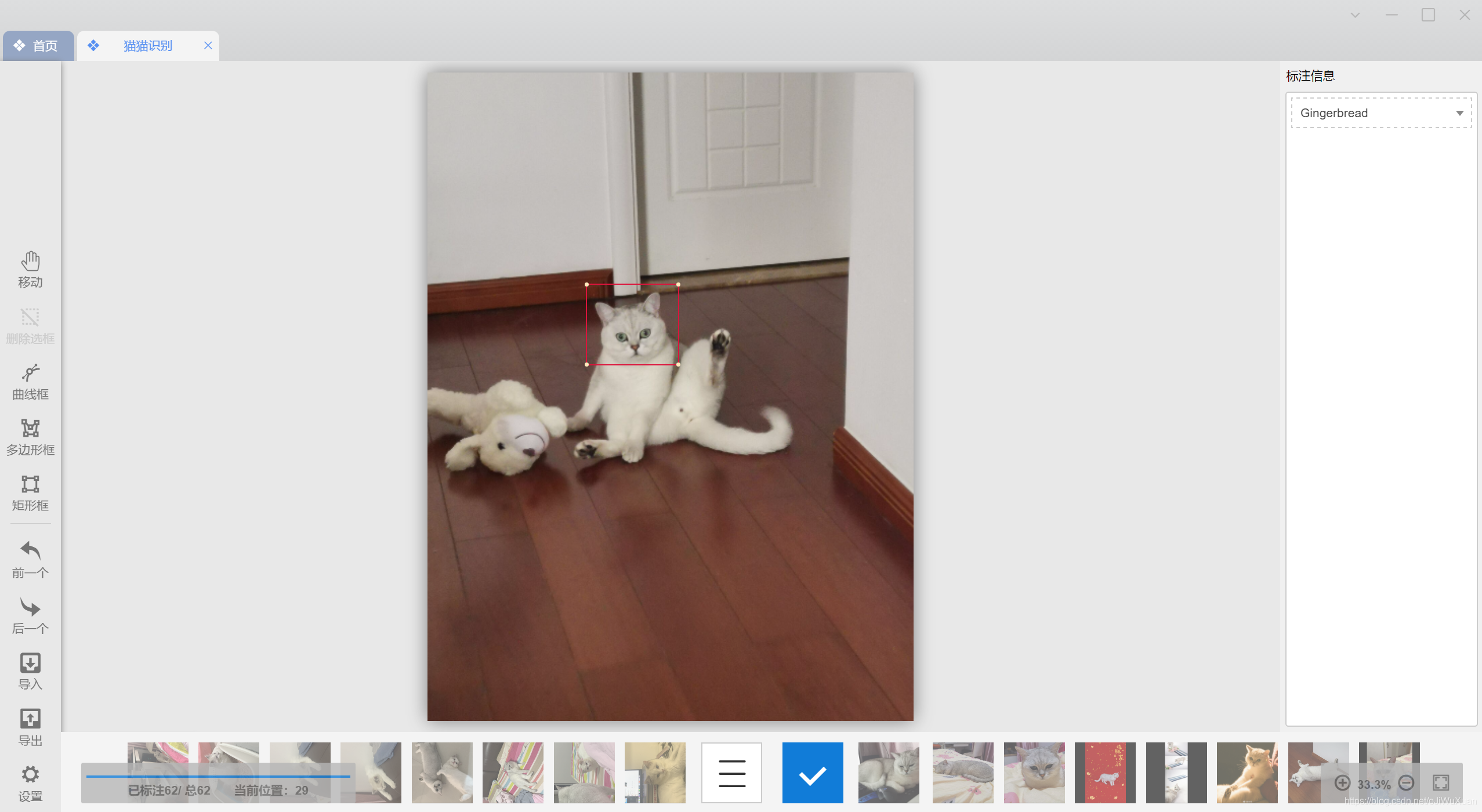

精靈標記助手標記介面如圖所示:

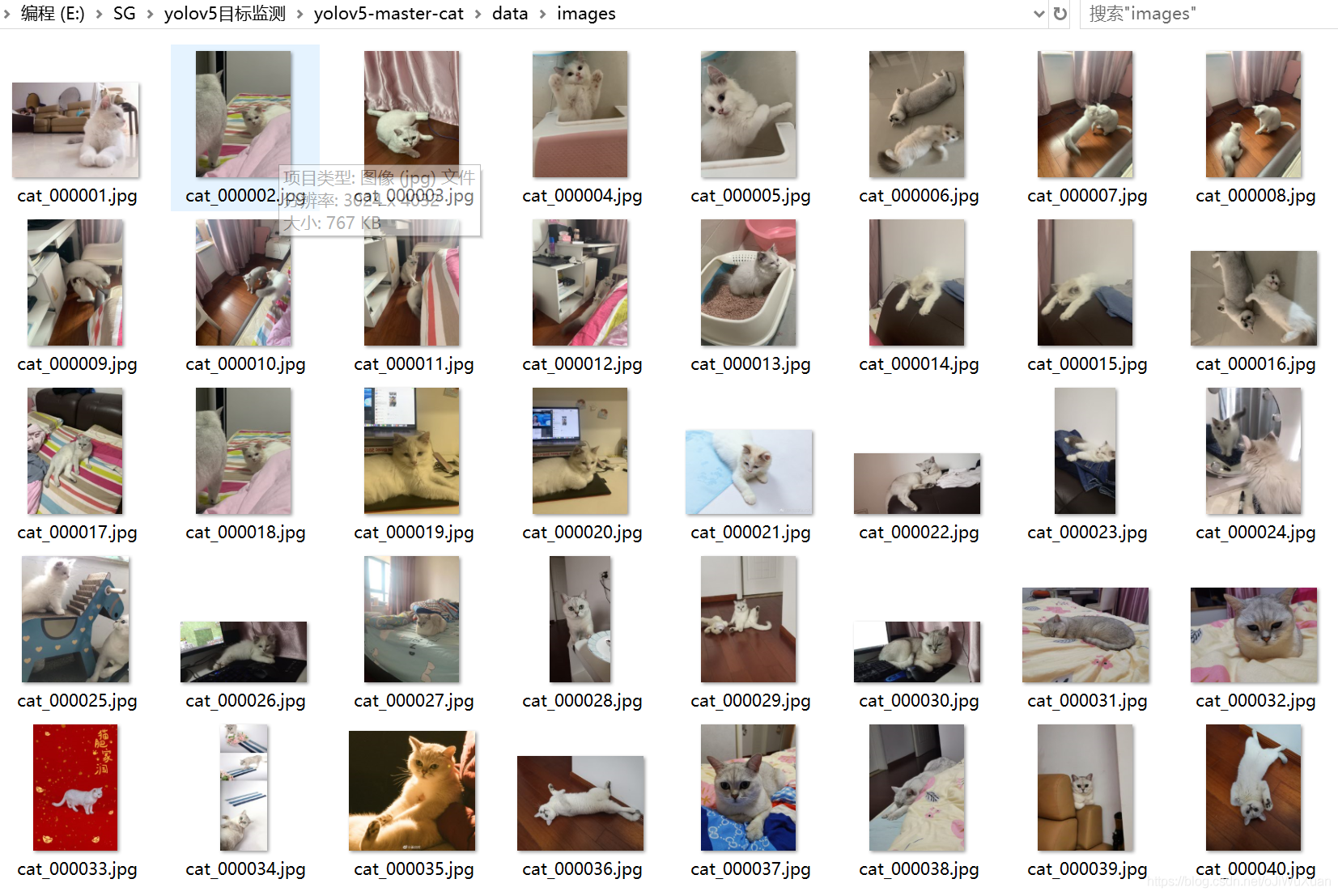

資料集標記好後,將原始圖片資料集放到images資料夾中,如圖所示。

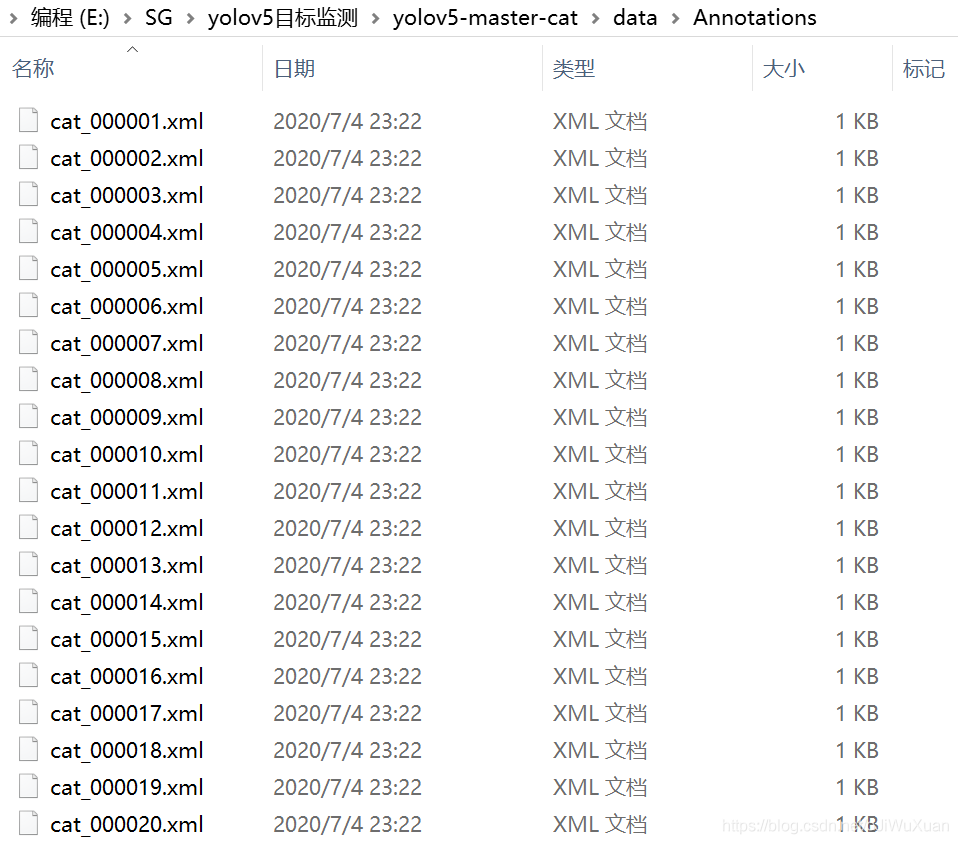

將精靈標記助手所生成的xml檔案全部放入到Annotations資料夾中,如圖所示。

3.3 構建資料集

在yolov5-master-cat的根目錄下新建一個檔案makeTxt.py,程式碼如下:

import os

import random

trainval_percent = 0.9

train_percent = 0.9

xmlfilepath = 'data/Annotations'

txtsavepath = 'data/ImageSets'

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv)

train = random.sample(trainval, tr)

ftrainval = open('data/ImageSets/trainval.txt', 'w')

ftest = open('data/ImageSets/test.txt', 'w')

ftrain = open('data/ImageSets/train.txt', 'w')

fval = open('data/ImageSets/val.txt', 'w')

for i in list:

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftrain.write(name)

else:

fval.write(name)

else:

ftest.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

接著再新建另一個檔案voc_label.py,切記,classes=[……] 中填入的一定要是自己在資料集中所標註的類別名稱,標記了幾個類別就填寫幾個類別名,填寫錯誤的話會造成讀取不出xml檔案裡的標註資訊。程式碼如下:

# xml解析包

import xml.etree.ElementTree as ET

import pickle

import os

# os.listdir() 方法用於返回指定的資料夾包含的檔案或資料夾的名字的列表

from os import listdir, getcwd

from os.path import join

sets = ['train', 'test', 'val']

classes = ['Gingerbread', 'Coconut-milk']

# 進行歸一化操作

def convert(size, box): # size:(原圖w,原圖h) , box:(xmin,xmax,ymin,ymax)

dw = 1./size[0] # 1/w

dh = 1./size[1] # 1/h

x = (box[0] + box[1])/2.0 # 物體在圖中的中心點x座標

y = (box[2] + box[3])/2.0 # 物體在圖中的中心點y座標

w = box[1] - box[0] # 物體實際畫素寬度

h = box[3] - box[2] # 物體實際畫素高度

x = x*dw # 物體中心點x的座標比(相當於 x/原圖w)

w = w*dw # 物體寬度的寬度比(相當於 w/原圖w)

y = y*dh # 物體中心點y的座標比(相當於 y/原圖h)

h = h*dh # 物體寬度的寬度比(相當於 h/原圖h)

return (x, y, w, h) # 返回 相對於原圖的物體中心點的x座標比,y座標比,寬度比,高度比,取值範圍[0-1]

# year ='2012', 對應圖片的id(檔名)

def convert_annotation(image_id):

'''

將對應檔名的xml檔案轉化為label檔案,xml檔案包含了對應的bunding框以及圖片長款大小等資訊,

通過對其解析,然後進行歸一化最終讀到label檔案中去,也就是說

一張圖片檔案對應一個xml檔案,然後通過解析和歸一化,能夠將對應的資訊儲存到唯一一個label檔案中去

labal檔案中的格式:calss x y w h 同時,一張圖片對應的類別有多個,所以對應的bunding的資訊也有多個

'''

# 對應的通過year 找到相應的資料夾,並且開啟相應image_id的xml檔案,其對應bund檔案

in_file = open('data/Annotations/%s.xml' % (image_id), encoding='utf-8')

# 準備在對應的image_id 中寫入對應的label,分別為

# <object-class> <x> <y> <width> <height>

out_file = open('data/labels/%s.txt' % (image_id), 'w', encoding='utf-8')

# 解析xml檔案

tree = ET.parse(in_file)

# 獲得對應的鍵值對

root = tree.getroot()

# 獲得圖片的尺寸大小

size = root.find('size')

# 如果xml內的標記為空,增加判斷條件

if size != None:

# 獲得寬

w = int(size.find('width').text)

# 獲得高

h = int(size.find('height').text)

# 遍歷目標obj

for obj in root.iter('object'):

# 獲得difficult ??

difficult = obj.find('difficult').text

# 獲得類別 =string 型別

cls = obj.find('name').text

# 如果類別不是對應在我們預定好的class檔案中,或difficult==1則跳過

if cls not in classes or int(difficult) == 1:

continue

# 通過類別名稱找到id

cls_id = classes.index(cls)

# 找到bndbox 物件

xmlbox = obj.find('bndbox')

# 獲取對應的bndbox的陣列 = ['xmin','xmax','ymin','ymax']

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

print(image_id, cls, b)

# 帶入進行歸一化操作

# w = 寬, h = 高, b= bndbox的陣列 = ['xmin','xmax','ymin','ymax']

bb = convert((w, h), b)

# bb 對應的是歸一化後的(x,y,w,h)

# 生成 calss x y w h 在label檔案中

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

# 返回當前工作目錄

wd = getcwd()

print(wd)

for image_set in sets:

'''

對所有的檔案資料集進行遍歷

做了兩個工作:

1.將所有圖片檔案都遍歷一遍,並且將其所有的全路徑都寫在對應的txt檔案中去,方便定位

2.同時對所有的圖片檔案進行解析和轉化,將其對應的bundingbox 以及類別的資訊全部解析寫到label 檔案中去

最後再通過直接讀取檔案,就能找到對應的label 資訊

'''

# 先找labels資料夾如果不存在則建立

if not os.path.exists('data/labels/'):

os.makedirs('data/labels/')

# 讀取在ImageSets/Main 中的train、test..等檔案的內容

# 包含對應的檔名稱

image_ids = open('data/ImageSets/%s.txt' % (image_set)).read().strip().split()

# 開啟對應的2012_train.txt 檔案對其進行寫入準備

list_file = open('data/%s.txt' % (image_set), 'w')

# 將對應的檔案_id以及全路徑寫進去並換行

for image_id in image_ids:

list_file.write('data/images/%s.jpg\n' % (image_id))

# 呼叫 year = 年份 image_id = 對應的檔名_id

convert_annotation(image_id)

# 關閉檔案

list_file.close()

# os.system(‘comand’) 會執行括號中的命令,如果命令成功執行,這條語句返回0,否則返回1

# os.system("cat 2007_train.txt 2007_val.txt 2012_train.txt 2012_val.txt > train.txt")

# os.system("cat 2007_train.txt 2007_val.txt 2007_test.txt 2012_train.txt 2012_val.txt > train.all.txt")

分別執行makeTxt.py和voc_label.py。

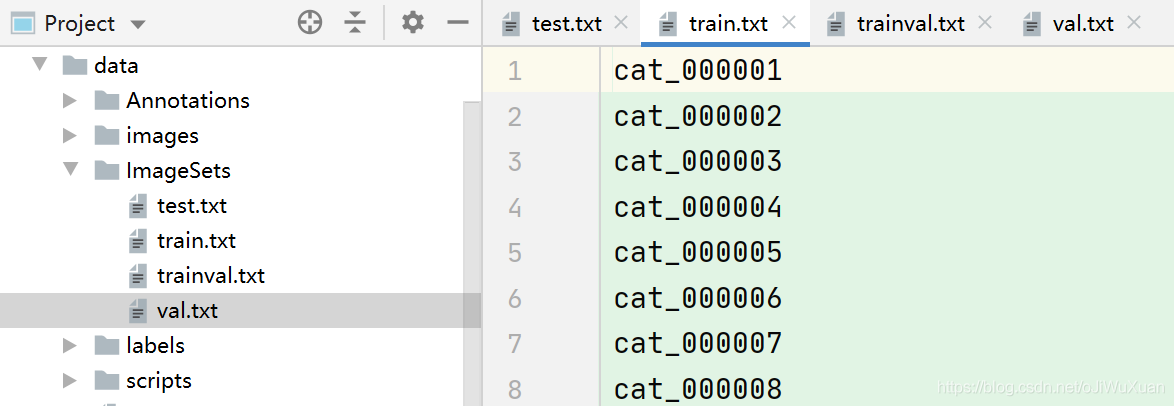

makeTxt.py主要是將資料集分類成訓練資料集和測試資料集,預設train,val,test按照8:1:1的比例進行隨機分類,執行後ImagesSets資料夾中會出現四個檔案,主要是生成的訓練資料集和測試資料集的圖片名稱,如下圖。同時data目錄下也會出現這四個檔案,內容是訓練資料集和測試資料集的圖片路徑。

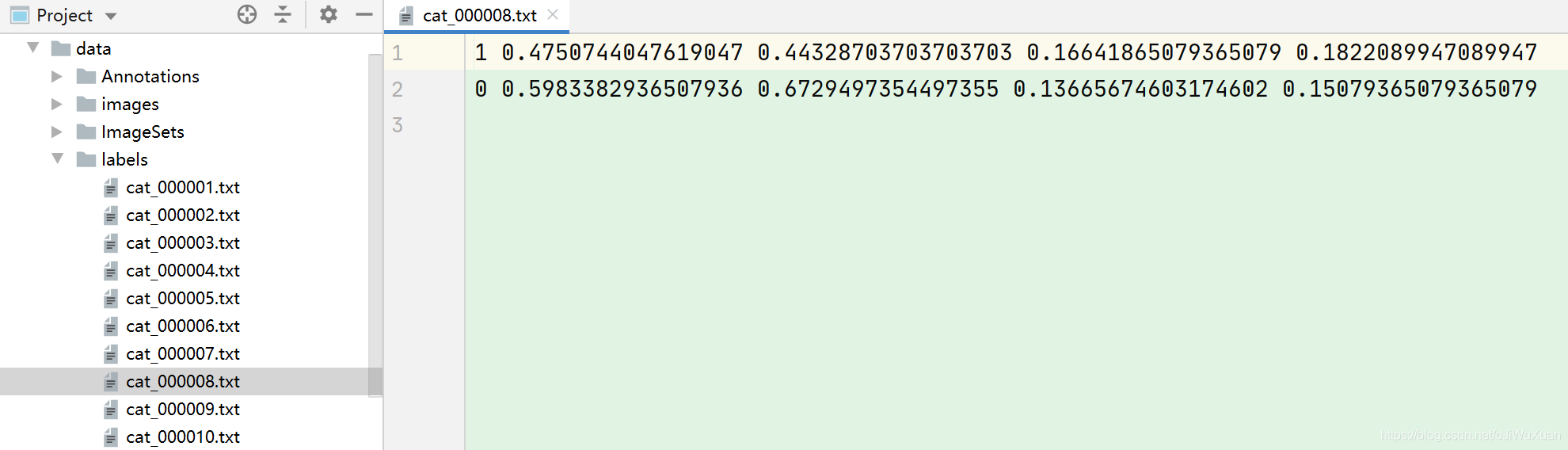

voc_label.py主要是將圖片資料集標註後的xml檔案中的標註資訊讀取出來並寫入txt檔案,執行後在labels資料夾中出現所有圖片資料集的標註資訊,如下圖:

到此,本次訓練所需的資料集已經全部準備好了。

3.4 檔案修改

3.4.1 資料集方面的yaml檔案修改

首先在data目錄下,複製一份coco.yaml檔案並將其重新命名為cat.yaml,放在data目錄下,並對cat.yaml中的引數進行設定。其中train,val,test後面分別為訓練集和測試集圖片的路徑, nc為資料集的類別數,我這裡只分了兩類,names為類別的名稱。這幾個引數均按照自己的實際需求來修改。程式碼如下:

# COCO 2017 dataset http://cocodataset.org

# Download command: bash yolov5/data/get_coco2017.sh

# Train command: python train.py --data ./data/coco.yaml

# Dataset should be placed next to yolov5 folder:

# /parent_folder

# /coco

# /yolov5

# train and val datasets (image directory or *.txt file with image paths)

train: data/train.txt # 118k images

val: data/val.txt # 5k images

test: data/test.txt # 20k images for submission to https://competitions.codalab.org/competitions/20794

# number of classes

nc: 2

# class names

names: ['Gingerbread', 'Coconut-milk']

# Print classes

# with open('data/coco.yaml') as f:

# d = yaml.load(f, Loader=yaml.FullLoader) # dict

# for i, x in enumerate(d['names']):

# print(i, x)

3.4.2 網路引數方面的yaml檔案修改

接著在models目錄下的yolov5s.yaml檔案進行修改,這裡取決於你使用了哪個模型就去修改對於的檔案,該專案中使用的是yolov5s模型。需要修改的程式碼如下:

# parameters

nc: 2 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

3.4.3 train.py中的一些引數修改

最後,在根目錄中對train.py中的一些引數進行修改,主要引數解釋如下。我們平時訓練的話,主要用到的只有這幾個引數而已:–weights,–cfg,–data,–epochs,–batch-size,–img-size,–project。

parser = argparse.ArgumentParser()

# 載入的權重檔案

parser.add_argument('--weights', type=str, default='yolov5s.pt', help='initial weights path')

# 模型組態檔,網路結構,使用修改好的yolov5m.yaml檔案

parser.add_argument('--cfg', type=str, default='models/yolov5s.yaml', help='model.yaml path')

# 資料集組態檔,資料集路徑,類名等,使用資料集方面的cat.yaml檔案

parser.add_argument('--data', type=str, default='data/cat.yaml', help='data.yaml path')

# 超引數檔案

parser.add_argument('--hyp', type=str, default='data/hyp.scratch.yaml', help='hyperparameters path')

# 訓練總輪次,1個epoch等於使用訓練集中的全部樣本訓練一次,值越大模型越精確,訓練時間也越長。

parser.add_argument('--epochs', type=int, default=300)

# 批次大小,一次訓練所選取的樣本數,顯示卡垃圾的話,就調小點

parser.add_argument('--batch-size', type=int, default=16, help='total batch size for all GPUs')

# 輸入圖片解析度大小,nargs='+'表示引數可設定一個或多個

parser.add_argument('--img-size', nargs='+', type=int, default=[640, 640], help='[train, test] image sizes')

# 是否採用矩形訓練,預設False,開啟後可顯著的減少推理時間

parser.add_argument('--rect', action='store_true', help='rectangular training')

# 接著打斷訓練上次的結果接著訓練

parser.add_argument('--resume', nargs='?', const=True, default=False, help='resume most recent training')

# 不儲存模型,預設False

parser.add_argument('--nosave', action='store_true', help='only save final checkpoint')

# 不進行test,預設False

parser.add_argument('--notest', action='store_true', help='only test final epoch')

# 不自動調整anchor,預設False

parser.add_argument('--noautoanchor', action='store_true', help='disable autoanchor check')

# 是否進行超引數進化,預設False

parser.add_argument('--evolve', action='store_true', help='evolve hyperparameters')

# 谷歌雲盤bucket,一般不會用到

parser.add_argument('--bucket', type=str, default='', help='gsutil bucket')

# 是否提前快取圖片到記憶體,以加快訓練速度,預設False

parser.add_argument('--cache-images', action='store_true', help='cache images for faster training')

# 選用加權影象進行訓練

parser.add_argument('--image-weights', action='store_true', help='use weighted image selection for training')

# 訓練的裝置,cpu;0(表示一個gpu裝置cuda:0);0,1,2,3(多個gpu裝置)。值為空時,訓練時預設使用計算機自帶的顯示卡或CPU

parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')

# 是否進行多尺度訓練,預設False

parser.add_argument('--multi-scale', action='store_true', help='vary img-size +/- 50%%')

# 資料集是否只有一個類別,預設False

parser.add_argument('--single-cls', action='store_true', help='train multi-class data as single-class')

# 是否使用adam優化器

parser.add_argument('--adam', action='store_true', help='use torch.optim.Adam() optimizer')

# 是否使用跨卡同步BN,在DDP模式使用

parser.add_argument('--sync-bn', action='store_true', help='use SyncBatchNorm, only available in DDP mode')

# gpu編號

parser.add_argument('--local_rank', type=int, default=-1, help='DDP parameter, do not modify')

# W&B記錄的影象數,最大為100

parser.add_argument('--log-imgs', type=int, default=16, help='number of images for W&B logging, max 100')

# 記錄最終訓練的模型,即last.pt

parser.add_argument('--log-artifacts', action='store_true', help='log artifacts, i.e. final trained model')

# dataloader的最大worker數量

parser.add_argument('--workers', type=int, default=4, help='maximum number of dataloader workers')

# 訓練結果所存放的路徑,預設為runs/train

parser.add_argument('--project', default='runs/train', help='save to project/name')

# 訓練結果所在資料夾的名稱,預設為exp

parser.add_argument('--name', default='exp', help='save to project/name')

# 若現有的project/name存在,則不進行遞增

parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')

opt = parser.parse_args()

3.5 訓練模型

全部設定好後,直接執行train.py檔案開始訓練,這時候就到了考驗顯示卡的時候,可以耐心的等上一兩個小時,可以吃個瓜,看個小電影啥的,千萬別手癢玩什麼3A大作,否則電腦爆炸還得重新訓練。

當程式執行介面出現如下所示並後續不報錯的情況下,說明開始訓練。

Using torch 1.7.1+cu110 CUDA:0 (GeForce RTX 2060, 6144MB)

Namespace(adam=False, batch_size=16, bucket='', cache_images=False, cfg='', data='data/cat.yaml', device='', epochs=300, evolve=False, exist_ok=False, global_rank=-1, hyp='data/hyp.scratch.yaml', image_weights=False, img_size=[640, 640], local_rank=-1, log_artifacts=False, log_imgs=16, multi_scale=False, name='exp', noautoanchor=False, nosave=False, notest=False, project='runs/train', rect=False, resume=False, save_dir='runs\\train\\exp', single_cls=False, sync_bn=False, total_batch_size=16, weights='yolov5s.pt', workers=8, world_size=1)

Start Tensorboard with "tensorboard --logdir runs/train", view at http://localhost:6006/

Hyperparameters {'lr0': 0.01, 'lrf': 0.2, 'momentum': 0.937, 'weight_decay': 0.0005, 'warmup_epochs': 3.0, 'warmup_momentum': 0.8, 'warmup_bias_lr': 0.1, 'box': 0.05, 'cls': 0.5, 'cls_pw': 1.0, 'obj': 1.0, 'obj_pw': 1.0, 'iou_t': 0.2, 'anchor_t': 4.0, 'fl_gamma': 0.0, 'hsv_h': 0.015, 'hsv_s': 0.7, 'hsv_v': 0.4, 'degrees': 0.0, 'translate': 0.1, 'scale': 0.5, 'shear': 0.0, 'perspective': 0.0, 'flipud': 0.0, 'fliplr': 0.5, 'mosaic': 1.0, 'mixup': 0.0}

Analyzing anchors... anchors/target = 5.31, Best Possible Recall (BPR) = 1.0000

Image sizes 640 train, 640 test

Using 6 dataloader workers

Logging results to runs\train\exp

Starting training for 300 epochs...

Epoch gpu_mem box obj cls total targets img_size

0/299 2.2G 0.1117 0.03632 0.02687 0.1749 2 640: 100%|██████████| 4/4 [00:17<00:00, 4.35s/it]

Class Images Targets P R mAP@.5 mAP@.5:.95: 100%|██████████| 1/1 [00:01<00:00, 1.12s/it]

all 6 0 0 0 0 0

在訓練中,也可以隨時檢視每一輪次訓練的結果,可利用tensorboard視覺化訓練過程,訓練開始時會在runs/train/exp資料夾中產生一個「events.out.tfevents.1608924773.JWX.5276.0」檔案,利用tensorboard開啟即可檢視訓練紀錄檔。首先我們通過cmd進去該YOLOv5所在的專案資料夾,然後啟用所用的虛擬環境,輸入如下命令列:

tensorboard --logdir runs/train/exp

命令列輸入資訊的整體顯示如下所示:

E:\SG\yolov5目標監測\yolov5-master-catnew>activate yolov5

(yolov5) E:\SG\yolov5目標監測\yolov5-master-catnew>tensorboard --logdir runs/train/exp

TensorFlow installation not found - running with reduced feature set.

Serving TensorBoard on localhost; to expose to the network, use a proxy or pass --bind_all

TensorBoard 2.4.0 at http://localhost:6006/ (Press CTRL+C to quit)

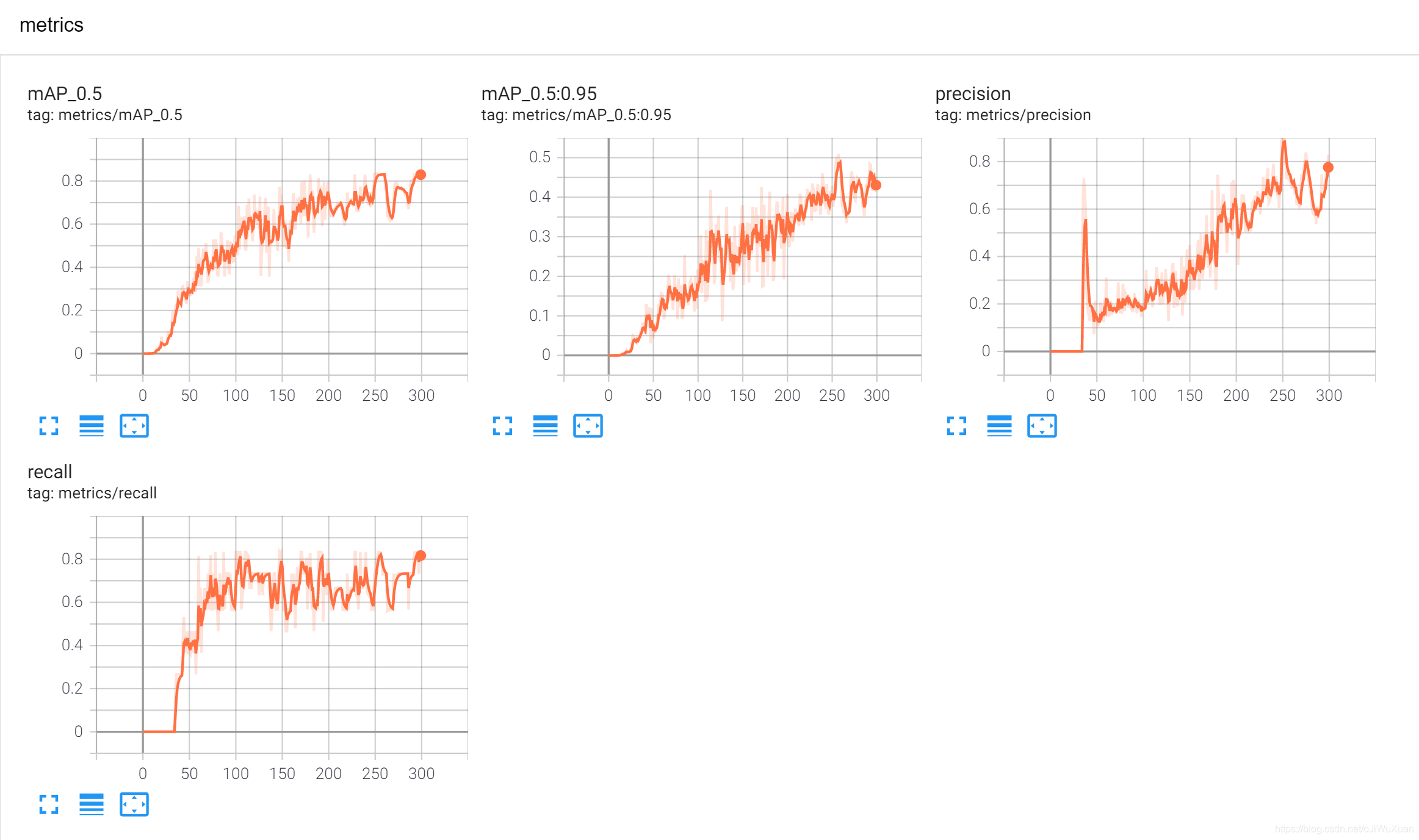

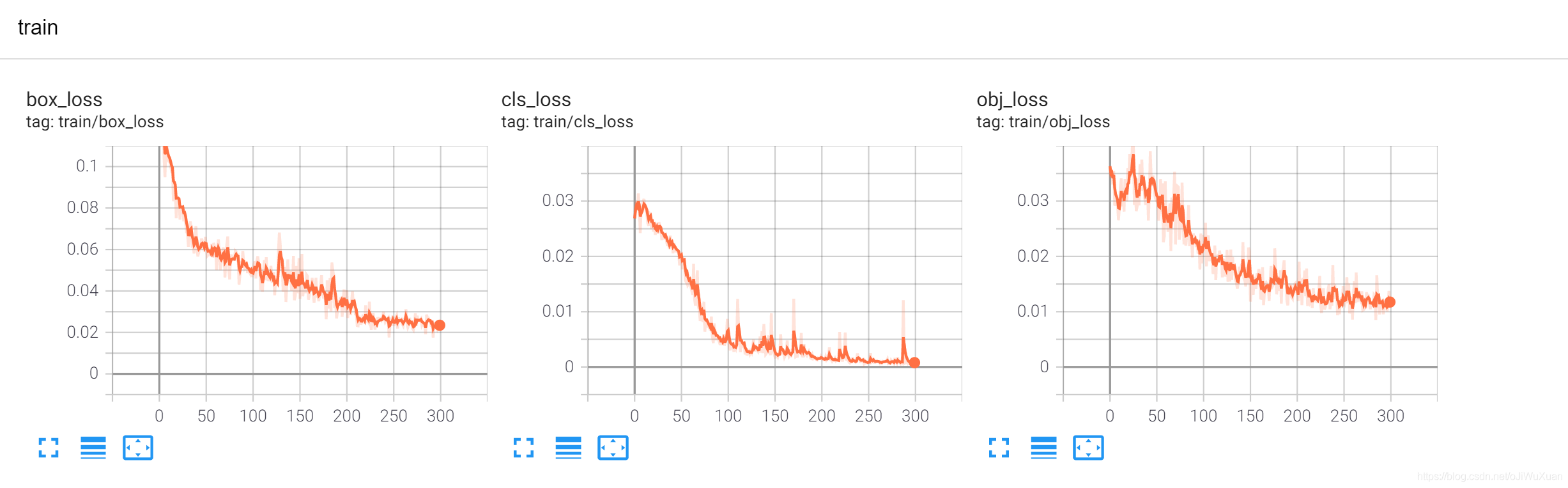

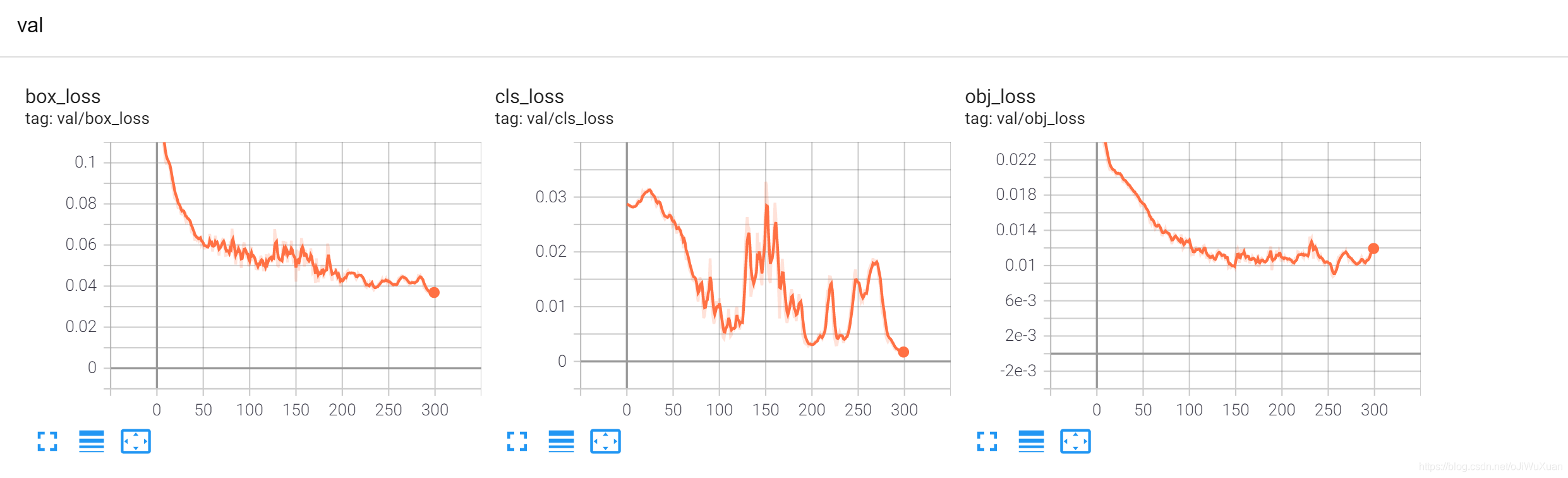

到這一步後,我們就可開啟 http://localhost:6006/ 網頁檢視每一輪次訓練的結果,如圖所示。我這裡由於資料過少(只有62張)的原因,所有模型訓練的很不精準。如果是用於正常工作的情況下,所需的資料集至少要上千張圖片。

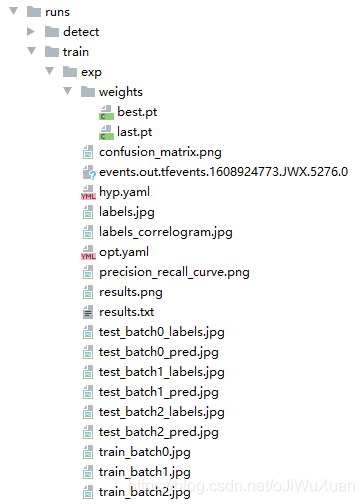

如果不更改訓練結果所產生的路徑的話,訓練好後會在runs/train/exp資料夾得到如下檔案,其中,我們訓練好的權重為weights資料夾中的best.pt和last.pt檔案,顧名思義,best.pt是訓練300輪後所得到的最好的權重,last.pt是最後一輪訓練所得到的權重。

四、YOLOv5 實現檢測

有了訓練好的權重後,就可以就行目標檢測測試了。直接在根目錄的detect.py中進行偵錯,主要引數解釋如下。我們平時用的話,主要用到的只有這幾個引數而已:–weights,–source,–conf-thres,–project。

parser = argparse.ArgumentParser()

# 選用訓練的權重,可用根目錄下的yolov5s.pt,也可用runs/train/exp/weights/best.pt

parser.add_argument('--weights', nargs='+', type=str, default='yolov5s.pt', help='model.pt path(s)')

# 檢測資料,可以是圖片/視訊路徑,也可以是'0'(電腦自帶攝像頭),也可以是rtsp等視訊流

parser.add_argument('--source', type=str, default='inference/videos/貓貓識別.mp4', help='source') # file/folder, 0 for webcam

# 網路輸入圖片大小

parser.add_argument('--img-size', type=int, default=640, help='inference size (pixels)')

# 置信度閾值,檢測到的物件屬於特定類(狗,貓,香蕉,汽車等)的概率

parser.add_argument('--conf-thres', type=float, default=0.25, help='object confidence threshold')

# 做nms的iou閾值

parser.add_argument('--iou-thres', type=float, default=0.45, help='IOU threshold for NMS')

# 檢測的裝置,cpu;0(表示一個gpu裝置cuda:0);0,1,2,3(多個gpu裝置)。值為空時,訓練時預設使用計算機自帶的顯示卡或CPU

parser.add_argument('--device', default='', help='cuda device, i.e. 0 or 0,1,2,3 or cpu')

# 是否展示檢測之後的圖片/視訊,預設False

parser.add_argument('--view-img', action='store_true', help='display results')

# 是否將檢測的框座標以txt檔案形式儲存,預設False

parser.add_argument('--save-txt', action='store_true', help='save results to *.txt')

# 是否將檢測的labels以txt檔案形式儲存,預設False

parser.add_argument('--save-conf', action='store_true', help='save confidences in --save-txt labels')

# 設定只保留某一部分類別,如0或者0 2 3

parser.add_argument('--classes', nargs='+', type=int, help='filter by class: --class 0, or --class 0 2 3')

# 進行nms是否也去除不同類別之間的框,預設False

parser.add_argument('--agnostic-nms', action='store_true', help='class-agnostic NMS')

# 推理的時候進行多尺度,翻轉等操作(TTA)推理

parser.add_argument('--augment', action='store_true', help='augmented inference')

# 如果為True,則對所有模型進行strip_optimizer操作,去除pt檔案中的優化器等資訊,預設為False

parser.add_argument('--update', action='store_true', help='update all models')

# 檢測結果所存放的路徑,預設為runs/detect

parser.add_argument('--project', default='runs/detect', help='save results to project/name')

# 檢測結果所在資料夾的名稱,預設為exp

parser.add_argument('--name', default='exp', help='save results to project/name')

# 若現有的project/name存在,則不進行遞增

parser.add_argument('--exist-ok', action='store_true', help='existing project/name ok, do not increment')

opt = parser.parse_args()

修改好引數後,直接執行detect.py檔案,如果不更改檢測結果所產生的路徑的話,檢測完成後會在runs/detect/exp資料夾得到檢測後的視訊。下面是輸出視訊的截圖,可能是小貓的特徵不是很明顯,尤其是側臉的識別效果並不是很好,訓練資料集如果量大一點應該會有更好的效果。