[Python從零到壹] 四.網路爬蟲之入門基礎及正規表示式抓取部落格案例

歡迎大家來到「Python從零到壹」,在這裡我將分享約200篇Python系列文章,帶大家一起去學習和玩耍,看看Python這個有趣的世界。所有文章都將結合案例、程式碼和作者的經驗講解,真心想把自己近十年的程式設計經驗分享給大家,希望對您有所幫助,文章中不足之處也請海涵。

Python系列整體框架包括基礎語法10篇、網路爬蟲30篇、視覺化分析10篇、機器學習20篇、巨量資料分析20篇、影象識別30篇、人工智慧40篇、Python安全20篇、其他技巧10篇。您的關注、點贊和轉發就是對秀璋最大的支援,知識無價人有情,希望我們都能在人生路上開心快樂、共同成長。

本文參考了作者CSDN的文章,連結如下:

同時,作者新開的「娜璋AI安全之家」將專注於Python和安全技術,主要分享Web滲透、系統安全、人工智慧、巨量資料分析、影象識別、惡意程式碼檢測、CVE復現、威脅情報分析等文章。雖然作者是一名技術小白,但會保證每一篇文章都會很用心地撰寫,希望這些基礎性文章對你有所幫助,在Python和安全路上與大家一起進步。

文章目錄

一.什麼是網路爬蟲

隨著網際網路的迅速發展,全球資訊網成為大量資訊的載體,越來越多的網友可以通過網際網路獲取所需的資訊,同時如何有效地提取並利用這些資訊也成為了一個巨大的挑戰。搜尋引擎(Search Engine)作為輔助人們檢索資訊的工具,它成為了使用者存取全球資訊網的入口和工具,常見的搜尋引擎比如Google、Yahoo、百度、搜狗等。但是,這些通用性搜尋引擎也存在著一定的侷限性,比如搜尋引擎返回的結果包含大量使用者不關心的網頁;再如它們是基於關鍵字檢索,缺乏語意理解,導致反饋的資訊不準確;通用的搜尋引擎無法處理非結構性資料,圖片、音訊、視訊等複雜型別的資料。

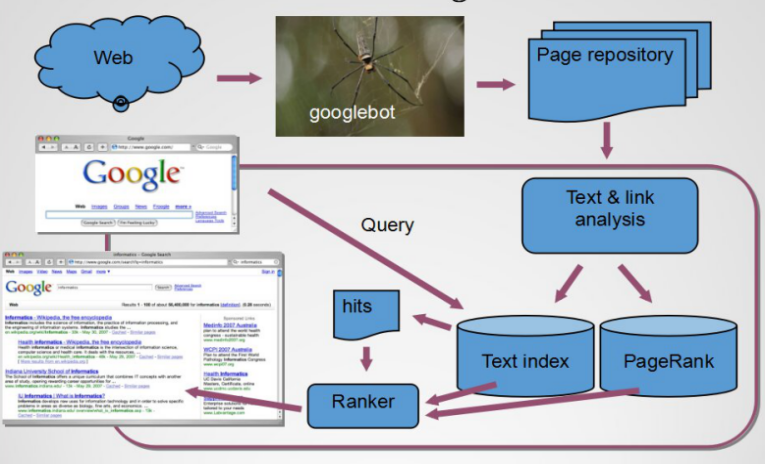

為了解決上述問題,定向抓取相關網頁資源的網路爬蟲應運而生,下圖是Google搜尋引擎的架構圖,它從全球資訊網中爬取相關資料,通過文字和連線分析,再進行打分排序,最後返回相關的搜尋結果至瀏覽器。同時,現在比較熱門的知識圖譜也是為了解決類似的問題而提出的。

網路爬蟲又被稱為網頁蜘蛛或網路機器人,它是一種按照一定的規則,自動地抓取全球資訊網資訊的程式或者指令碼。網路爬蟲根據既定的抓取目標,有選擇的存取全球資訊網上的網頁與相關的連結,獲取所需要的資訊。與通用爬蟲不同,定向爬蟲並不追求大的覆蓋,而將目標定為抓取與某一特定主題內容相關的網頁,為面向主題的使用者查詢準備資料資源。

網路爬蟲按照系統結構和實現技術,大致可以分為以下幾種型別:通用網路爬蟲(General Purpose Web Crawler)、聚焦網路爬蟲(Focused Web Crawler)、增量式網路爬蟲(Incremental Web Crawler)、深層網路爬蟲(Deep Web Crawler)。實際的網路爬蟲系統通常是幾種爬蟲技術相結合實現的。

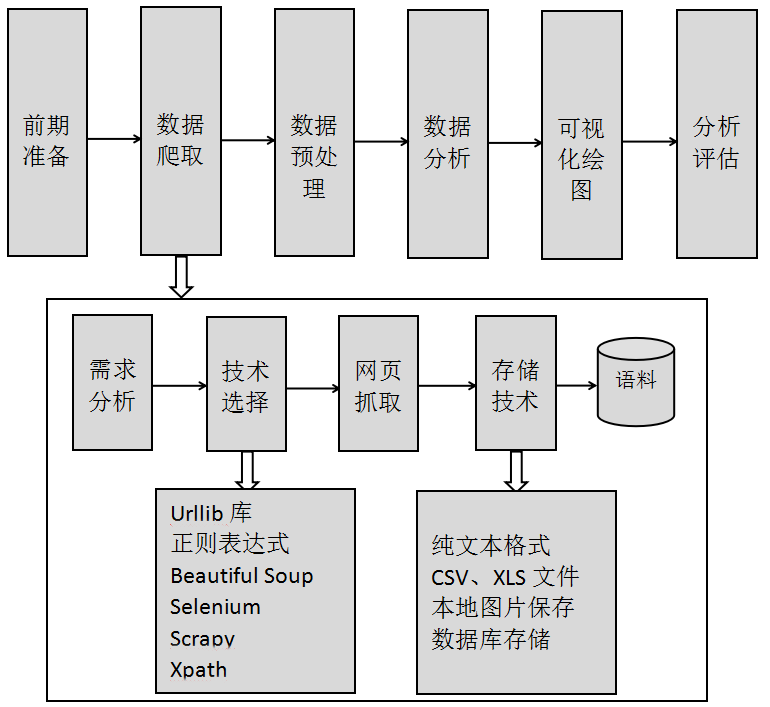

資料分析通常包括前期準備、資料爬取、資料預處理、資料分析、視覺化繪圖及分析評估六個步驟,如下圖所示。其中資料爬取主要劃分為四個步驟:

- 需求分析。首先需要分析網路資料爬取的需求,瞭解所爬取主題的網址、內容分佈,所獲取語料的欄位、圖集等內容。

- 技術選擇。網頁抓取技術可以通過Python、Java、C++、C#等不同程式語言實現,主要涉及的技術包括:Urllib庫、正規表示式、Selenium、BeautifulSoup、Scrapy等技術。

- 網頁抓取。確定好爬取技術後,需要分析網頁的DOM樹結構,通過XPATH技術定位網頁所爬取內容的節點,再抓取資料;同時,部分網站涉及到頁面跳轉、登入驗證等。

- 儲存技術。資料儲存技術主要是儲存爬取的資料資訊,主要包括SQL資料庫、純文字格式、CSV\XLS檔案等。

作者希望大家能從基礎跟著我學習Python知識,最後能抓取你需要的資料集並進行深入的分析,一起加油吧!

二.正規表示式

正規表示式是用於處理字串的強大工具,通常被用來檢索、替換那些符合某種規則的文字。這篇文章首先引入正規表示式的基本概念,然後講解其常用的方法,並結合Python網路資料爬取常用模組和常見正規表示式的網站分析方法進行講解,最後使用正規表示式爬取了個人部落格網站。

正規表示式(Regular Expression,簡稱Regex或RE)又稱為正規表示法或常規表示法,常常用來檢索、替換那些符合某個模式的文字,它首先設定好了一些特殊的字元及字元組合,通過組合的「規則字串」來對錶示式進行過濾,從而獲取或匹配我們想要的特定內容。它非常靈活,其邏輯性和功能性也非常強,並能迅速地通過表示式從字串中找到所需資訊,但對於剛接觸的人來說,比較晦澀難懂。

由於正規表示式主要應用物件是文字,因此它在各種文字編輯器中都有應用,小到著名編輯器EditPlus,大到Microsoft Word、Visual Studio等大型編輯器,都可以使用正規表示式來處理文字內容。

1.re模組

Python通過re模組提供對正規表示式的支援,但在使用正規表示式之前需要匯入re模組,才能呼叫該模組的功能函數。

- import re

其基本步驟是先將正規表示式的字串形式編譯為Pattern範例,然後使用Pattern範例處理文字並獲得一個匹配(match)範例,再使用match範例獲得所需資訊。常用的函數是findall,原型如下:

- findall(string[, pos[, endpos]]) | re.findall(pattern, string[, flags])

該函數表示搜尋字串string,以列表形式返回全部能匹配的子串。其中引數re包括三個常見值,每個常見值括號內的內容是完整的寫法。

- re.I(re.IGNORECASE):使匹配忽略大小寫

- re.M(re.MULTILINE):允許多行匹配

- re.S(re.DOTALL):匹配包括換行在內的所有字元

Pattern物件是一個編譯好的正規表示式,通過Pattern提供的一系列方法可以對文字進行匹配查詢。Pattern不能直接範例化,必須使用re.compile()進行構造。

2.complie方法

re正規表示式模組包括一些常用的操作函數,比如complie()函數。其原型如下:

- compile(pattern[,flags] )

該函數根據包含正規表示式的字串建立模式物件,返回一個pattern物件。引數flags是匹配模式,可以使用按位元或「|」表示同時生效,也可以在正規表示式字串中指定。Pattern物件是不能直接範例化的,只能通過compile方法得到。

簡單舉個範例,使用正規表示式獲取字串中的數位內容,如下所示:

>>> import re

>>> string="A1.45,b5,6.45,8.82"

>>> regex = re.compile(r"\d+\.?\d*")

>>> print regex.findall(string)

['1.45', '5', '6.45', '8.82']

>>>

3.match方法

match方法是從字串的pos下標處起開始匹配pattern,如果pattern結束時已經匹配,則返回一個match物件;如果匹配過程中pattern無法匹配,或者匹配未結束就已到達endpos,則返回None。該方法原型如下:

- match(string[, pos[, endpos]]) | re.match(pattern, string[, flags])

引數string表示字串;pos表示下標,pos和endpos的預設值分別為0和len(string);引數flags用於編譯pattern時指定匹配模式。

4.search方法

search方法用於查詢字串中可以匹配成功的子串。從字串的pos下標處嘗試匹配pattern,如果pattern結束時仍可匹配,則返回一個match物件;若pattern結束時仍無法匹配,則將pos加1後重新嘗試匹配;直到pos=endpos時仍無法匹配則返回None。函數原型如下:

- search(string[, pos[, endpos]]) | re.search(pattern, string[, flags])

引數string表示字串;pos表示下標,pos和endpos的預設值分別為0和len(string));引數flags用於編譯pattern時指定匹配模式。

5.group和groups方法

group([group1, …])方法用於獲得一個或多個分組截獲的字串,當它指定多個引數時將以元組形式返回,沒有截獲字串的組返回None,截獲了多次的組返回最後一次截獲的子串。groups([default])方法以元組形式返回全部分組截獲的字串,相當於多次呼叫group,其引數default表示沒有截獲字串的組以這個值替代,預設為None。

三.Python網路資料爬取的常用模組

本小節介紹Python網路資料爬取的常用模組或庫,主要包括urlparse模組、urllib模組、urllib2模組和requests模組,這些模組中的函數都是基礎知識,但也非常重要。

1.urllib模組

本書首先介紹Python網路資料爬取最簡單並且應用比較廣泛的第三方庫函數urllib。urllib是Python用於獲取URL(Uniform Resource Locators,統一資源定址器)的庫函數,可以用來抓取遠端資料並儲存,甚至可以設定訊息頭(header)、代理、超時認證等。

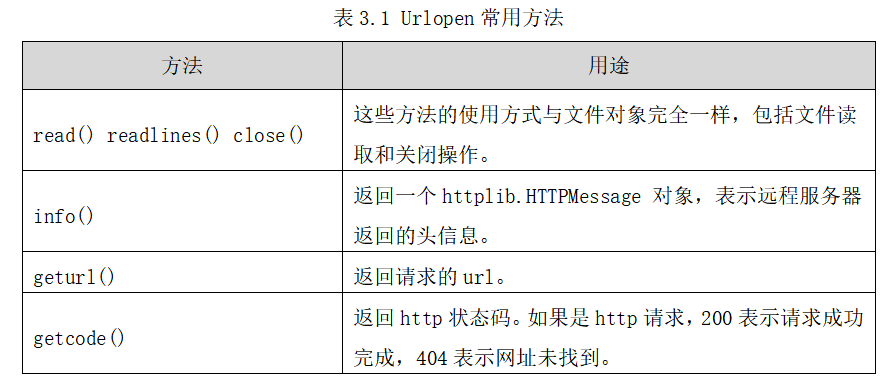

urllib模組提供的上層介面讓我們像讀取本地檔案一樣讀取www或ftp上的資料。它比C++、C#等其他程式語言使用起來更方便。其常用的方法如下:

- urlopen

urlopen(url, data=None, proxies=None)

該方法用於建立一個遠端URL的類檔案物件,然後像本地檔案一樣操作這個類檔案物件來獲取遠端資料。引數url表示遠端資料的路徑,一般是網址;引數data表示以post方式提交到url的資料;引數proxies用於設定代理。urlopen返回一個類檔案物件。urlopen提供瞭如下表所示。

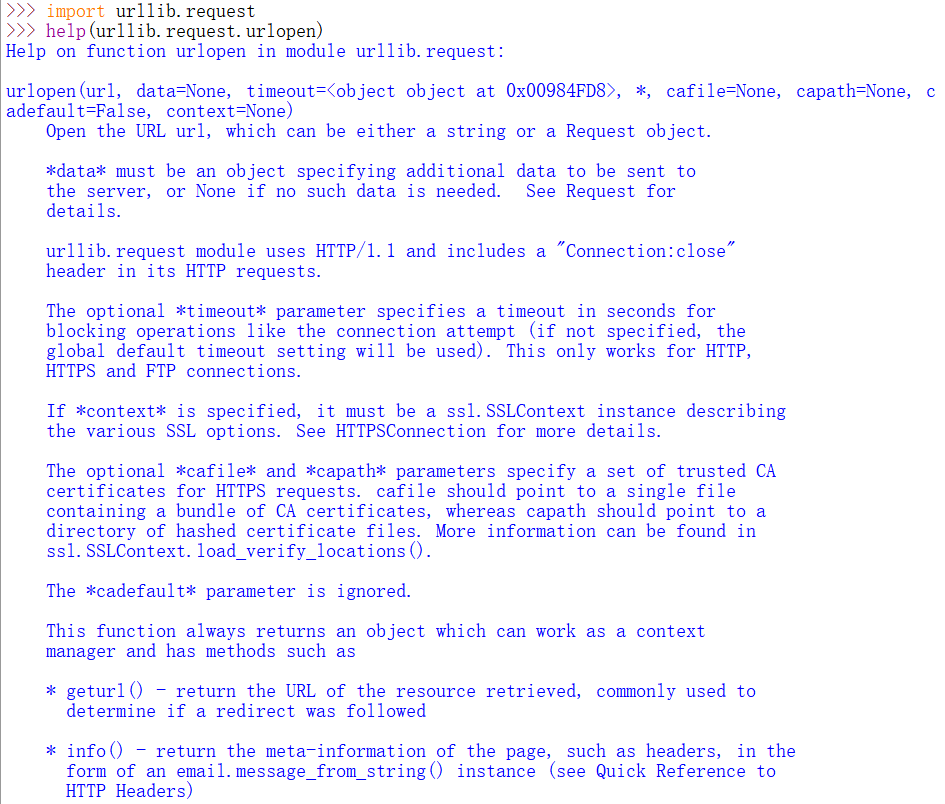

注意,在Python中我們可以匯入相關擴充套件包,通過help函數檢視相關的使用說明,如下圖所示。

下面通過一個範例講述Urllib庫函數爬取百度官網的範例。

# -*- coding:utf-8 -*-

import urllib.request

import webbrowser as web

url = "http://www.baidu.com"

content = urllib.request.urlopen(url)

print(content.info()) #頭資訊

print(content.geturl()) #請求url

print(content.getcode()) #http狀態碼

#儲存網頁至本地並通過瀏覽器開啟

open("baidu.html","wb").write(content.read())

web.open_new_tab("baidu.html")

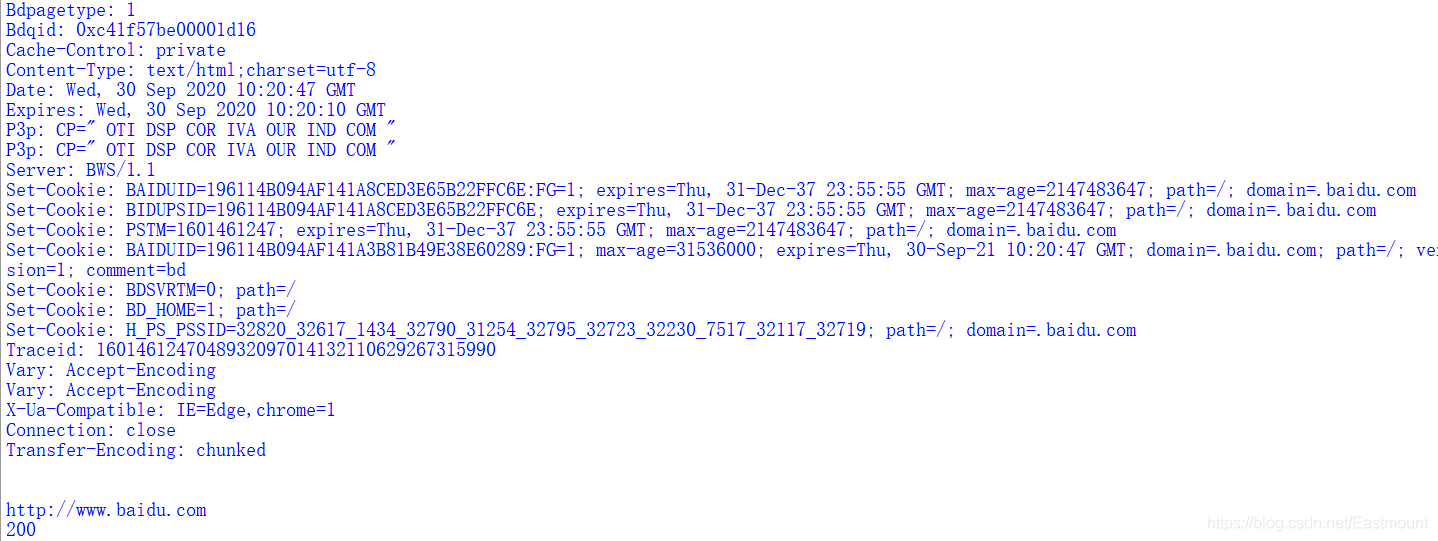

該段呼叫呼叫urllib.urlopen(url)函數開啟百度連結,並輸出訊息頭、url、http狀態碼等資訊,如下圖所示。

程式碼import webbrowser as web參照webbrowser第三方庫,然後可以使用類似於「module_name.method」呼叫對應的函數。open().write()表示在本地建立靜態的baidu.html檔案,並讀取已經開啟的百度網頁內容,執行檔案寫操作。web.open_new_tab(「baidu.html」)表示通過瀏覽器開啟已經下載的靜態網頁新標籤。其中下載並開啟的百度官網靜態網頁「baidu.html」檔案如下圖所示。

同樣可以使用web.open_new_tab(「http://www.baidu.com」)在瀏覽器中直接開啟線上網頁。

- urlretrieve

urlretrieve(url, filename=None, reporthook=None, data=None)

urlretrieve方法是將遠端資料下載到本地。引數filename指定了儲存到原生的路徑,如果省略該引數,urllib會自動生成一個臨時檔案來儲存資料;引數reporthook是一個回撥函數,當連線上伺服器,相應的資料塊傳輸完畢時會觸發該回撥,通常使用該回撥函數來顯示當前的下載進度;引數data指傳遞到伺服器的資料。下面通過例子來演示將新浪首頁網頁抓取到本地,儲存在「D:/sina.html」檔案中,同時顯示下載進度。

# -*- coding:utf-8 -*-

import urllib.request

# 函數功能:下載檔案至本地,並顯示進度

# a-已經下載的資料塊, b-資料塊的大小, c-遠端檔案的大小

def Download(a, b, c):

per = 100.0 * a * b / c

if per > 100:

per = 100

print('%.2f' % per)

url = 'http://www.sina.com.cn'

local = 'd://sina.html'

urllib.request.urlretrieve(url, local, Download)

上面介紹了urllib模組中常用的兩個方法,其中urlopen()用於開啟網頁,urlretrieve()方法是將遠端資料下載到本地,主要用於爬取圖片。注意,Python2可以直接參照,而Python3需要通過urllib.request呼叫。

# -*- coding:utf-8 -*-

import urllib.request

url = 'https://www.baidu.com/img/PCtm_d9c8750bed0b3c7d089fa7d55720d6cf.png'

local = 'baidu.png'

urllib.request.urlretrieve(url, local)

抓取百度logo圖片如下圖所示:

2.urlparse模組

urlparse模組主要是對url進行分析,其主要操作是拆分和合並url各個部件。它可以將url拆分為6個部分,並返回元組,也可以把拆分後的部分再組成一個url。主要有函數有urljoin、urlsplit、urlunsplit、urlparse等。

- urlparse

urlparse.urlparse(urlstring[, scheme[, allow_fragments]])

該函數將urlstring值解析成6個部分,從urlstring中取得url,並返回元組(scheme, netloc, path, params, query, fragment)。該函數可以用來確定網路協定(HTTP、FTP等)、伺服器地址、檔案路徑等。範例程式碼如下所示。

# coding=utf-8

from urllib.parse import urlparse

url = urlparse('http://www.eastmount.com/index.asp?id=001')

print(url) #url解析成六部分

print(url.netloc) #輸出網址

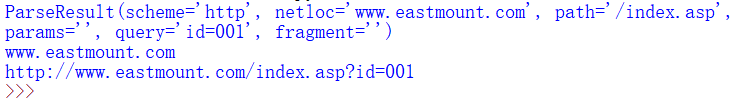

輸出如下所示,包括scheme、netloc、path、params、query、fragment六部分內容。

>>>

ParseResult(

scheme='http',

netloc='www.eastmount.com',

path='/index.asp',

params='',

query='id=001',

fragment=''

)

www.eastmount.com

>>>

同樣可以呼叫urlunparse()函數將一個元組內容構建成一條Url。函數如下:

- urlunparse

urlparse.urlunparse(parts)

該元組類似urlparse函數,它接收元組(scheme, netloc, path, params, query, fragment)後,會重新組成一個具有正確格式的url,以便供Python的其他HTML解析模組使用。範例程式碼如下:

# coding=utf-8

import urllib.parse

url = urllib.parse.urlparse('http://www.eastmount.com/index.asp?id=001')

print(url) #url解析成六部分

print(url.netloc) #輸出網址

#重組URL

u = urllib.parse.urlunparse(url)

print(u)

輸出如下圖所示。

四.正規表示式抓取網路資料的常見方法

接著介紹常用的正規表示式抓取網路資料的一些技巧,這些技巧都是來自於作者自然語言處理和資料抓取的專案經驗,可能不是很系統,但也希望能給讀者提供一些抓取資料的思路,從而更好地解決一些實際問題。

1.抓取標籤間的內容

HTML語言是採用標籤對的形式來編寫網站的,包括起始標籤和結束標籤,比如< head></ head>、< tr></ tr>、< script>< script>等。下面講解抓取標籤對之間的文字內容,比如抓取< title>Python</ title>標籤對之間的「Python」內容。

(1) 抓取title標籤間的內容

'<title>(.*?)</title>'

首先我們可以採用該正規表示式來抓取起始標籤< title >和結束標籤< /title >之間的內容,「(.*?)」就代表著我們需要抓取的內容。下面這段程式碼是爬取百度官網的標題,即「百度一下,你就知道」。

# coding=utf-8

import re

import urllib.request

url = "http://www.baidu.com/"

content = urllib.request.urlopen(url).read()

title = re.findall(r'<title>(.*?)</title>', content.decode('utf-8'))

print(title[0])

# 百度一下,你就知道

程式碼呼叫urllib庫的urlopen()函數開啟超連結,並呼叫正規表示式re庫中的findall()函數尋找title標籤間的內容。由於findall()函數是獲取所有滿足該正規表示式的文字,這裡只需要輸出第一個值title[0]即可。注意,Python3需要轉換utf8編碼,否則會報錯。

下面講解另一種方法,用來獲取標題起始標籤(< title>)和結束標籤(</ title>)之間的內容,同樣輸出百度官網標題「百度一下,你就知道」。

# coding=utf-8

import re

import urllib.request

url = "http://www.baidu.com/"

content = urllib.request.urlopen(url).read()

pat = r'(?<=<title>).*?(?=</title>)'

ex = re.compile(pat, re.M|re.S)

obj = re.search(ex, content.decode('utf-8'))

title = obj.group()

print(title)

# 百度一下,你就知道

2.抓取超連結標籤間的內容

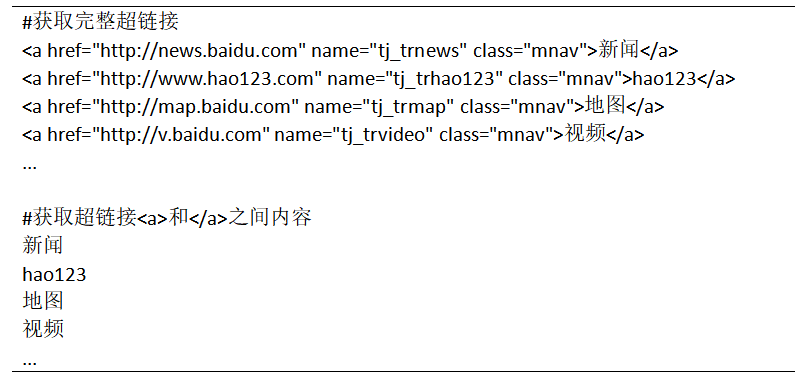

在HTML中,< a href=url>超連結標題</ a>用於標識超連結,下面的程式碼用於獲取完整的超連結,同時獲取超連結< a>和</ a>之間的標題內容。

# coding=utf-8

import re

import urllib.request

url = "http://www.baidu.com/"

content = urllib.request.urlopen(url).read()

#獲取完整超連結

res = r"<a.*?href=.*?<\/a>"

urls = re.findall(res, content.decode('utf-8'))

for u in urls:

print(u)

#獲取超連結<a>和</a>之間內容

res = r'<a .*?>(.*?)</a>'

texts = re.findall(res, content.decode('utf-8'), re.S|re.M)

for t in texts:

print(t)

輸出結果部分內容如下所示,這裡如果採用「print(u)」或「print(t)」語句直接輸出結果。

3.抓取tr標籤和td標籤間的內容

網頁常用的佈局包括table佈局或div佈局,其中table表格佈局中常見的標籤包括tr、th和td,表格行為tr(table row),表格資料為td(table data),表格表頭為th(table heading)。那麼如何抓取這些標籤間的內容呢?下面是獲取它們之間內容的程式碼。假設存在HTML程式碼如下所示:

<html>

<head><title>表格</title></head>

<body>

<table border=1>

<tr><th>學號</th><th>姓名</th></tr>

<tr><td>1001</td><td>楊秀璋</td></tr>

<tr><td>1002</td><td>燕娜</td></tr>

</table>

</body>

</html>

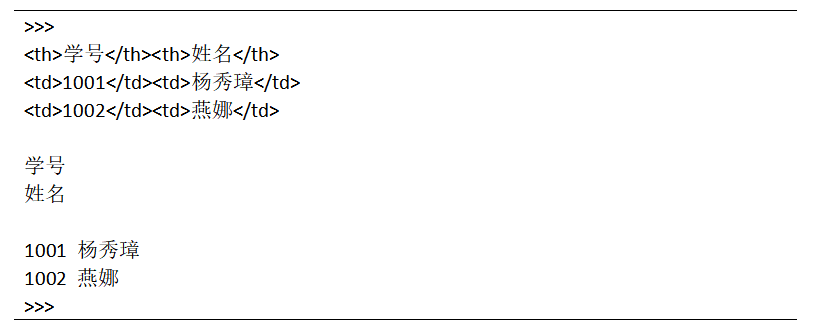

執行結果如下圖所示:

正規表示式爬取tr、th、td標籤之間內容的Python程式碼如下。

# coding=utf-8

import re

import urllib.request

content = urllib.request.urlopen("test.html").read() #開啟本地檔案

#獲取<tr></tr>間內容

res = r'<tr>(.*?)</tr>'

texts = re.findall(res, content.decode('utf-8'), re.S|re.M)

for m in texts:

print(m)

#獲取<th></th>間內容

for m in texts:

res_th = r'<th>(.*?)</th>'

m_th = re.findall(res_th, m, re.S|re.M)

for t in m_th:

print(t)

#直接獲取<td></td>間內容

res = r'<td>(.*?)</td><td>(.*?)</td>'

texts = re.findall(res, content.decode('utf-8'), re.S|re.M)

for m in texts:

print(m[0],m[1])

輸出結果如下,首先獲取tr之間的內容,然後再在tr之間內容中獲取< th>和</ th>之間值,即「學號」、「姓名」,最後是獲取兩個< td>和</ td>之間的內容。注意,Python3解析本地檔案可能會出錯,掌握方法更重要。

如果包含屬性值,則正規表示式修改為「< td id=.?>(.?)</ td>」。同樣,如果不一定是id屬性開頭,則可以使用正規表示式「<td .?>(.?)」。

2.爬取標籤中的引數

(1) 抓取超連結標籤的url

HTML超連結的基本格式為「< a href=url>連結內容</ a>」,現在需要獲取其中的url連結地址,方法如下:

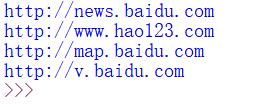

# coding=utf-8

import re

content = '''

<a href="http://news.baidu.com" name="tj_trnews" class="mnav">新聞</a>

<a href="http://www.hao123.com" name="tj_trhao123" class="mnav">hao123</a>

<a href="http://map.baidu.com" name="tj_trmap" class="mnav">地圖</a>

<a href="http://v.baidu.com" name="tj_trvideo" class="mnav">視訊</a>

'''

res = r"(?<=href=\").+?(?=\")|(?<=href=\').+?(?=\')"

urls = re.findall(res, content, re.I|re.S|re.M)

for url in urls:

print(url)

輸出內容如下:

2.抓取圖片超連結標籤的url

在HTML中,我們可以看到各式各樣的圖片,其圖片標籤的基本格式為「< img src=圖片地址 />」,只有通過抓取了這些圖片的原地址,才能下載對應的圖片至本地。那麼究竟怎麼獲取圖片標籤中的原圖地址呢?下面這段程式碼就是獲取圖片連結地址的方法。

content = '''<img alt="Python" src="http://www.yangxiuzhang.com/eastmount.jpg" />'''

urls = re.findall('src="(.*?)"', content, re.I|re.S|re.M)

print urls

# ['http://www.yangxiuzhang.com/eastmount.jpg']

原圖地址為「http://…/eastmount.jpg」,它對應一張圖片,該圖片是儲存在「www.yangxiuzhang.com」網站伺服器端的,最後一個「/」後面的欄位為圖片名稱,即為「eastmount.jpg」。那麼如何獲取url中最後一個引數呢?

3.獲取url中最後一個引數

在使用Python爬取圖片過程中,通常會遇到圖片對應的url最後一個欄位用來命名圖片的情況,如前面的「eastmount.jpg」,需要通過解析url「/」後面的引數來獲取圖片。

content = '''<img alt="Python" src="http://www..csdn.net/eastmount.jpg" />'''

urls = 'http://www..csdn.net/eastmount.jpg'

name = urls.split('/')[-1]

print name

# eastmount.jpg

該段程式碼urls.split(’/’)[-1]表示採用字元「/」分割字串,並且獲取最後一個所獲取的值,即為圖片名稱「eastmount.jpg」。

3.字串處理及替換

在使用正規表示式爬取網頁文字時,通常需要呼叫find()函數找到指定的位置,再進行進一步爬取,比如獲取class屬性為「infobox」的表格table,再進行定位爬取。

start = content.find(r'<table class="infobox"') #起點位置

end = content.find(r'</table>') #終點位置

infobox = text[start:end]

print infobox

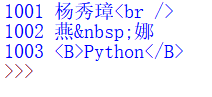

同時,爬取過程中可能會爬取到無關變數,此時需要對無關內容進行過濾,這裡推薦使用replace函數和正規表示式進行處理。比如爬取內容如下所示:

# coding=utf-8

import re

content = '''

<tr><td>1001</td><td>楊秀璋<br /></td></tr>

<tr><td>1002</td><td>燕 娜</td></tr>

<tr><td>1003</td><td><B>Python</B></td></tr>

'''

res = r'<td>(.*?)</td><td>(.*?)</td>'

texts = re.findall(res, content, re.S|re.M)

for m in texts:

print(m[0],m[1])

輸出內容如下所示:

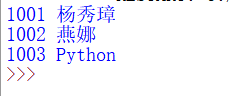

此時需要過濾多餘字串,如換行(< br />)、空格(& nbsp;)、加粗(< B></ B>),過濾程式碼如下:

# coding=utf-8

import re

content = '''

<tr><td>1001</td><td>楊秀璋<br /></td></tr>

<tr><td>1002</td><td>顏 娜</td></tr>

<tr><td>1003</td><td><B>Python</B></td></tr>

'''

res = r'<td>(.*?)</td><td>(.*?)</td>'

texts = re.findall(res, content, re.S|re.M)

for m in texts:

value0 = m[0].replace('<br />', '').replace(' ', '')

value1 = m[1].replace('<br />', '').replace(' ', '')

if '<B>' in value1:

m_value = re.findall(r'<B>(.*?)</B>', value1, re.S|re.M)

print(value0, m_value[0])

else:

print(value0, value1)

採用replace將字串「< br />」和「’& nbsp;」替換成空白,實現過濾,而加粗(< B></ B>)需要使用正規表示式過濾。輸出結果如下:

五.個人部落格爬取範例

切記:這個例子可能不是非常好,但是作為入門及正規表示式結合挺好的。剛開始學習Python網路爬蟲不要嫌麻煩,只有通過類似的訓練,以後面對類似的問題你才會得心應手,更好的抓取需要的資料。

1.分析過程

在講述了正規表示式、常用網路資料爬取模組、正規表示式爬取資料常見方法等內容之後,我們將講述一個簡單的正規表示式爬取網站的範例。這裡講解使用正規表示式爬取作者個人部落格網站的簡單範例,獲取所需內容。

作者的個人網址「http://www.eastmountyxz.com/」開啟如圖所示。假設現在需要爬取的內容如下:

- 部落格網址的標題(title)內容

- 爬取所有圖片的超連結,比如爬取< img src=」xxx.jpg」 />中的「xxx.jpg」

- 分別爬取部落格首頁中的四篇文章的標題、超連結及摘要內容,比如標題為「再見北理工:憶北京研究生的程式設計時光」。

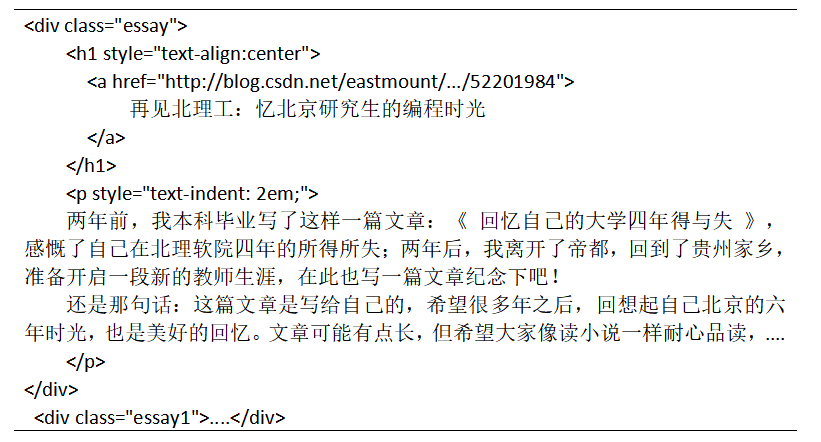

第一步 瀏覽器原始碼定位

首先通過瀏覽器定位需要爬取元素的原始碼,比如文章標題、超連結、圖片等,發現這些元素對應HTML原始碼存在的規律,這稱為DOM樹檔案節點分析。通過瀏覽器開啟網頁,選中需要爬取的內容,右鍵滑鼠並點選「審查元素」或「檢查」,即可找到所需爬取節點對應的HTML原始碼,如圖所示。

標題「再見北理工:憶北京研究生的程式設計時光」位於< div class=」essay」></ div>節點下,它包括一個< h1></ h1>記錄標題,一個< p></ p>記錄摘要資訊,即:

這裡需要通過網頁標籤的屬性和屬性值來標記爬蟲節點,即找到class屬性為「essay」的div,就可以定位第一篇文章的位置。同理,其餘三篇文章為< div class=」essay1」></ div>、< div class=」essay2」></ div>和< div class=」essay3」></ div>,定位這些節點即可。

第二步 正規表示式爬取標題

網站的標題通常位於< head>< title>…</ title></ head>之間,該網站標題HTML程式碼如下:

<head>

<meta charset=」utf-8」>

<title>秀璋學習天地</title>

....

</head>

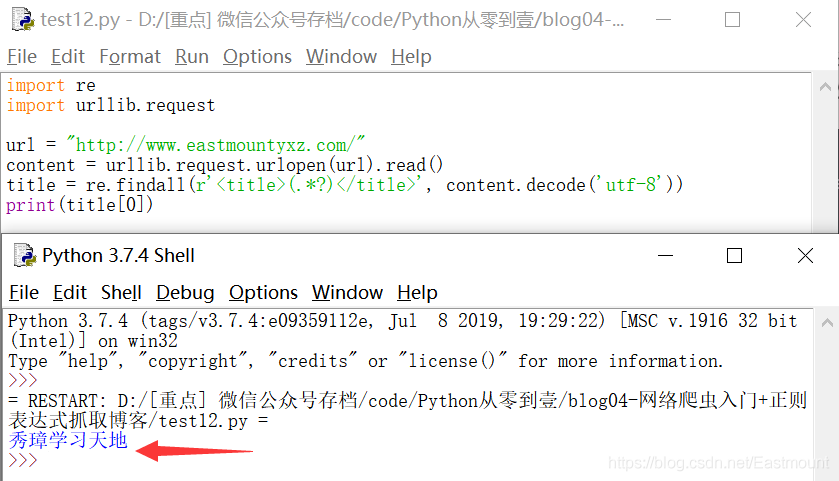

爬取部落格網站的標題「秀璋學習天地」的方法是通過正規表示式「< title>(.*?)</ title>」實現,程式碼如下,首先通過urlopen()函數存取部落格網址,然後定義正規表示式爬取。

import re

import urllib.request

url = "http://www.eastmountyxz.com/"

content = urllib.request.urlopen(url).read()

title = re.findall(r'<title>(.*?)</title>', content.decode('utf-8'))

print(title[0])

輸出結果如下圖所示:

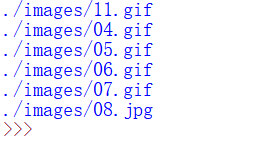

第三步 正規表示式爬取所有圖片地址

由於HTML插入圖片標籤格式為「< img src=圖片地址 />」,則使用正規表示式獲取圖片地址的方法為:獲取以「src=」開頭,以雙引號結尾的內容即可。程式碼如下:

import re

import urllib.request

url = "http://www.eastmountyxz.com/"

content = urllib.request.urlopen(url).read()

urls = re.findall(r'src="(.*?)"', content.decode('utf-8'))

for url in urls:

print(url)

輸出的結果如下所示,共顯示了6張圖片。

需要注意:這裡的每張圖片都省略了部落格地址:

- http://www.eastmountyxz.com/

我們需要對所爬取的圖片地址進行拼接,增加原部落格地址拼成完整的圖片地址,再進行下載,並且該地址通過瀏覽器可以直接存取檢視。如:

- http://www.eastmountyxz.com/images/11.gif

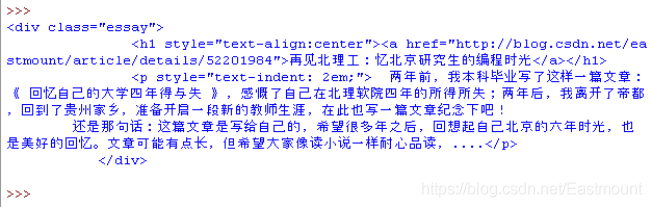

第四步 正規表示式爬取部落格內容

前面第一步講述瞭如何定位四篇文章的標題,第一篇文章位於< div class=」essay」>和</ div>標籤之間,第二篇位於< div class=」essay1」>和</ div>,依次類推。但是該HTML程式碼存在一個錯誤:class屬性通常表示一類標籤,它們的值都應該是相同的,所以這四篇文章的class屬性都應該是「essay」,而name或id才是用來標識標籤的唯一屬性。

這裡使用find(’< div class=「essay」 >’)函數來定位第一篇文章的起始位置,使用find(’< div class=「essay1」 >’)函數來定位第一篇文章的結束位置,從而獲取< div class=」essay」>到</ div>之間的內容。比如獲取第一篇文章的標題和超連結程式碼如下:

import re

import urllib.request

url = "http://www.eastmountyxz.com/"

content = urllib.request.urlopen(url).read()

data = content.decode('utf-8')

start = data.find(r'<div class="essay">')

end = data.find(r'<div class="essay1">')

print(data[start:end])

輸出內容如下,獲取第一篇部落格的HTML原始碼。

該部分程式碼分為三步驟:

- 呼叫urllib庫的urlopen()函數開啟部落格地址,並讀取內容賦值給content變數。

- 呼叫find()函數查詢特定的內容,比如class屬性為「essay」的div標籤,依次定位獲取開始和結束的位置。

- 進行下一步分析,獲取原始碼中的超連結和標題等內容。

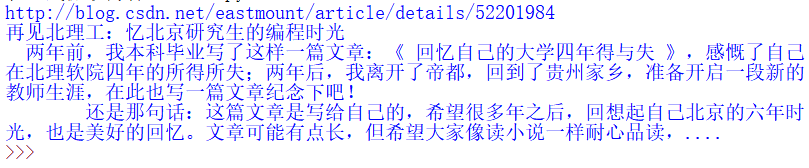

定位這段內容之後,再通過正規表示式獲取具體內容,程式碼如下:

import re

import urllib.request

url = "http://www.eastmountyxz.com/"

content = urllib.request.urlopen(url).read()

data = content.decode('utf-8')

start = data.find(r'<div class="essay">')

end = data.find(r'<div class="essay1">')

page = data[start:end]

res = r"(?<=href=\").+?(?=\")|(?<=href=\').+?(?=\')"

t1 = re.findall(res, page) #超連結

print(t1[0])

t2 = re.findall(r'<a .*?>(.*?)</a>', page) #標題

print(t2[0])

t3 = re.findall('<p style=.*?>(.*?)</p>', page, re.M|re.S) #摘要

print(t3[0])

呼叫正規表示式分別獲取內容,由於爬取的段落(P)存在換行內容,所以需要加入re.M和re.S支援換行查詢,最後輸出結果如下:

2.程式碼實現

完整程式碼如下:

#coding:utf-8

import re

import urllib.request

url = "http://www.eastmountyxz.com/"

content = urllib.request.urlopen(url).read()

data = content.decode('utf-8')

#爬取標題

title = re.findall(r'<title>(.*?)</title>', data)

print(title[0])

#爬取圖片地址

urls = re.findall(r'src="(.*?)"', data)

for url in urls:

print(url)

#爬取內容

start = data.find(r'<div class="essay">')

end = data.find(r'<div class="essay1">')

page = data[start:end]

res = r"(?<=href=\").+?(?=\")|(?<=href=\').+?(?=\')"

t1 = re.findall(res, page) #超連結

print(t1[0])

t2 = re.findall(r'<a .*?>(.*?)</a>', page) #標題

print(t2[0])

t3 = re.findall('<p style=.*?>(.*?)</p>', page, re.M|re.S) #摘要

print(t3[0])

print('')

start = data.find(r'<div class="essay1">')

end = data.find(r'<div class="essay2">')

page = data[start:end]

res = r"(?<=href=\").+?(?=\")|(?<=href=\').+?(?=\')"

t1 = re.findall(res, page) #超連結

print(t1[0])

t2 = re.findall(r'<a .*?>(.*?)</a>', page) #標題

print(t2[0])

t3 = re.findall('<p style=.*?>(.*?)</p>', page, re.M|re.S) #摘要

print(t3[0])

輸出結果如圖所示。

通過上面的程式碼,讀者會發現使用正規表示式爬取網站還是比較繁瑣,尤其是定位網頁節點時,後面將講述Python提供的常用第三方擴充套件包,利用這些包的函數進行定向爬取。

六.總結

正規表示式是通過組合的「規則字串」來對錶示式進行過濾,從複雜內容中匹配想要的資訊。它的主要物件是文字,適合於匹配文字字串等內容,不適合匹配文字意義,比如匹配URL、Email這種純文字的字元就非常適合。各種程式語言都能使用正規表示式,比如C#、Java、Python等。

正規表示式爬蟲常用於獲取字串中的某些內容,比如提取部落格閱讀量和評論數的數位,擷取URL域名或URL中某個引數,過濾掉特定的字元或檢查所獲取的資料是否符合某個邏輯,驗證URL或日期型別等。由於其比較靈活、邏輯性和功能性較強的特點,使它能迅速地以極簡單的方式從複雜字串中達到匹配目的。

但它對於剛接觸的人來說,正規表示式比較晦澀難懂;同時,通過它獲取HTML中某些特定文字也比較困難,尤其是當網頁HTML原始碼中結束標籤缺失或不明顯的情況。接下來作者將講述更為強大、智慧的第三方爬蟲擴充套件包,主要是BeautifulSoup和Selenium技術。

前文賞析:

- [Python從零到壹] 一.為什麼我們要學Python及基礎語法詳解

- [Python從零到壹] 二.語法基礎之條件語句、迴圈語句和函數

- [Python從零到壹] 三.語法基礎之檔案操作、CSV檔案讀寫及物件導向

- [Python從零到壹] 四.網路爬蟲之入門基礎及正規表示式抓取部落格案例

最後,真誠地感謝您關注「娜璋之家」公眾號,感謝CSDN這麼多年的陪伴,會一直堅持分享,希望我的文章能陪伴你成長,也希望在技術路上不斷前行。文章如果對你有幫助、有感悟,就是對我最好的回報,且看且珍惜!2020年8月18日建立的公眾號,再次感謝您的關注,也請幫忙宣傳下「娜璋之家」,哈哈~初來乍到,還請多多指教。

(By:娜璋之家 Eastmount 2020-09-30 夜於武大 https://blog.csdn.net/Eastmount )

參考文獻如下:

- 作者書籍《Python網路資料爬取及分析從入門到精通》

- 作者部落格:https://blog.csdn.net/Eastmount