機器人操作學習系列分享:模仿學習

2020-07-29 20:16:12

隨着學會的隊伍不斷髮展壯大,分支機構的發展愈發完善,豐富多彩的分支活動與學術分享也頻頻呈現。疫情期間,CAAI認知系統與資訊處理專委會積極倡導學會「疫情防控不放鬆,學習充電不間斷」的理念,邀請年輕學者結合本專委會自身領域研究精選相關文獻進行研究與再解讀,與大家分享《機器人操作學習系列分享:模仿學習》。

人類從嬰幼兒時期就學會模仿別人來獲得許多新技能,這種行爲被稱爲模仿學習。我們古代中國就有很多形容人們模仿學習中成語,有如「邯鄲學步」、「畫虎成狗」、「鸚鵡學語」等都是形容模仿不到位的情況,又如「惟妙惟肖」、「栩栩如生」、「有模有樣」等模仿極佳的狀態。因此,智慧體如何通過模仿學習避免出現那些尷尬的狀態,而達到完美的狀態,也是亟待研究的課題。

目前模仿學習也成爲許多研究領域的重要課題,包括心理學、神經科學、人工智慧和機器人學。模仿學習是機器學習諸多領域的交叉點。它對應於一個複雜的優化問題,可以用不同的方式形式化,例如結構化輸出預測問題或半監督學習問題。模仿學習還與強化學習、線上主動學習、多智慧體學習、特徵建構等有着密切的關係。

從機器學習的角度來看,模仿學習是一種解決控制和順序決策問題的學習方法。在模仿學習社羣內,機器人獲得專家的範例數據主要包括運動示教、遙操作、動作捕捉,視覺範例等等。最近,相關研究領域可分爲以下子領域:行爲克隆,獎勵推斷,從觀察中學習,糾正互動。

1、行爲克隆(Behavioral Cloning)

行爲克隆是模仿學習中最簡單方法,採用直接模仿的方式。在這種情況下,從所提供的例子歸納問題通常被簡化爲一個有監督的學習問題,而不必對教師的意圖作出假設。基於監督學習從示教數據學習機器人的策略,通過以任意一條專家示教軌跡的任意一個時刻的狀態 s 作爲演算法的輸入, 與 s 對應的動作 a 設定爲演算法的輸出,就可以應用傳統的監督學習演算法來解決這個模仿學習的問題。比如,通過控制一個機器臂的七個關節的角度來執行一個指定的動作,可以設計神經網路的輸出爲這七個關節的角度值或者這七個關節角度的概率分佈來解決這個問題。如果採用高斯分佈的話,可以設計神經網路輸出對應角度的均值和方差。直接採用上述監督學習的思路來解決模仿學習問題的方法,雖然然很簡單,但是在某些領域卻擁有着很不錯的表現。在理想想情況下所學的策略能夠在新場景中重現所範例的行爲。

2、獎勵推斷 (Reward Inference)

獎勵推斷旨在提取專家的運動/操作意圖,而不是動作本身的低階細節。此類方法通常包括逆強化學習(IRL)、學徒學習(apprenticeshiplearning)或逆最優控制(inverseoptimal control)。該類方法通過假設專家最大化某個獎勵函數來實現操作動作,學習者的目標是找到解釋專家行爲的獎勵函數。推斷獲得的獎勵函數可進一步通過RL演算法來學習任務的策略。IRL範式(IRL paradigm)有以下幾個優點: 1) 如果獎勵函數是世界上物體或特徵的函數,可自然地從人移植到機器人,而不存在遇到對應問題。2) 獎勵函數通常是稀疏的,因此提供了一種自然的方法,從少量的訓練數據進行歸納,即使在非常大的狀態空間中也是如此。3) 人類的行爲可能會編碼有關任務的大量背景資訊,這種資訊很容易在獎勵函數中進行編碼,但在策略中編碼起來較複雜,並且可以在以後的上下文中重新使用。

最值得注意的是,從根本上IRL問題是不適定的(ill-posed)-存在無限多個獎勵函數,且它們會導致相同的最優策略。因此,許多IRL演算法之間的區別在於如何消除歧義或顯示對某些獎勵函數偏好的指標。最大熵(Maximum Entropy)IRL通過利用概率框架(probabilistic framework)和最大熵原則消除了可能的獎勵函數的歧義,較好地解決了範例者次優性和不適定的問題。具體來說,在給定獎勵函數下,給所有會獲得同等回報的軌跡分配相同的概率,然後使用這種分佈以更好地匹配範例的特徵計數,同時避免具有除數據指示偏好之外的任何其他偏好。

目前,IRL演算法常採用高斯過程或神經網路來建立具有狀態特徵的非線性獎勵函數。這種表示法需要仔細的正則化以避免過度擬合。這對於經驗收集昂貴的機器人技術來說尤其成問題。一些最近的IRL方法已經顯示出可以在實際的機器人領域中工作,它通過交替獎勵優化和策略優化步驟或將IRL框架轉化爲執行特徵匹配的更直接的策略搜尋問題來規避此障礙。如果有條件的話,可以通過將IRL問題轉換爲純監督問題,使用分級演示來擺脫推理時間策略優化或MDP求解的需要。另外,主動學習技術已被用來降低IRL的計算複雜度,以及對範例者的資訊性做出non-I.I.D假設的策略。

3、從觀察中學習 (Learning from Observation)

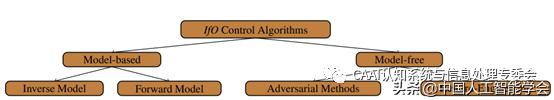

模仿學習是一個agent嘗試使用另一個執行該任務的agent(通常是expert)生成的資訊來學習如何執行特定任務的過程。按照慣例,模仿者可以存取由專家生成的狀態和動作資訊。但是,動作資訊很難直接獲得,而且要求動作資訊會阻止從大量現有的寶貴學習資源(例如,線上視訊)中進行模仿學習。例如,機器人可以觀察人類正在執行的任務,但只能存取原始畫素數據,而不能存取世界的真實基礎狀態,也不能存取人類採取的行動。這個問題被稱爲「從觀察中學習」(LfO),近年來的LfO引起了極大的關注,其中,模仿者只能存取專家生成的狀態資訊(例如,視訊幀)。在LfO的極端情況中,agent被期望從單幀目標狀態影象而不是完整的觀測軌跡中進行學習。圖 1 介紹了當前LfO演算法的分類。

圖 1. LfO控制演算法的分類的圖形表示。這些演算法可以分爲兩組:(1)基於模型的演算法,其中演算法可以使用前向動力學模型或逆動力學模型。(2)無模型演算法,其本身可以歸類爲對抗性方法和獎勵工程。

對抗性訓練技術在計算機視覺領域取得了一些最新的令人興奮的進展。其中一個這樣的進展是在姿勢估計領域,該領域能夠通過關鍵點檢測來檢測雜波視訊中物件的位置和方向,這樣的關鍵點資訊在LfO中也可能被證明是有用的。雖然有少量努力將這些進展納入LfO,但仍有許多工作需要研究。實際上,當前LfO演算法很少在物理機器人上成功測試過。也就是說,大多數討論結果僅在模擬域中進行。例如,儘管對抗性方法當前爲許多基線實驗LfO問題提供了最新的效能,但是這些方法顯示出很高的樣本複雜性,因此僅被應用於相對簡單的模擬任務。因此,LfO中的一個開放問題是找到方法來適應這些技術,以便可以將它們用於像機器人應用一樣禁止高樣本複雜性的場景。

4、糾正互動 (Corrective Interactions)

與其從完整的批次範例中學習,不如經常請求(可能是部分的)糾正範例或其他形式的反饋來學習策略,這通常是有利的。例如,一個人可以在倒水時進行幹預,並且調整杯子的角度和機器人倒水時的角度。這爲在最需要數據的情況下收集數據提供了一種自然的機制 機製——例如,正在發生錯誤的情況,或者機器人非常不確定該做什麼的情況。模仿者主動要求使用者在可信度低或風險較高的狀態空間區域進行額外範例,而其他方法則依靠人工使用者來識別何時發生了錯誤。更高層次的資訊也可以用來進行更穩健的校正,比如更正的基於預測的註釋和高階有限狀態機中的動作建議。TAMER框架沒有使用糾正性的範例,而是利用有關機器人效能的實時數位人工反饋來糾正和塑造行爲。機器人還可以在需要的時候主動尋求幫助,例如,通過自然語言。

本文由CAAI認知系統與資訊處理專委會供稿