第三週:序列模型和注意力機制 機製

2020-08-12 18:42:41

第三週:序列模型和注意力機制 機製

本文是序列模型的筆記

3.1 基礎模型

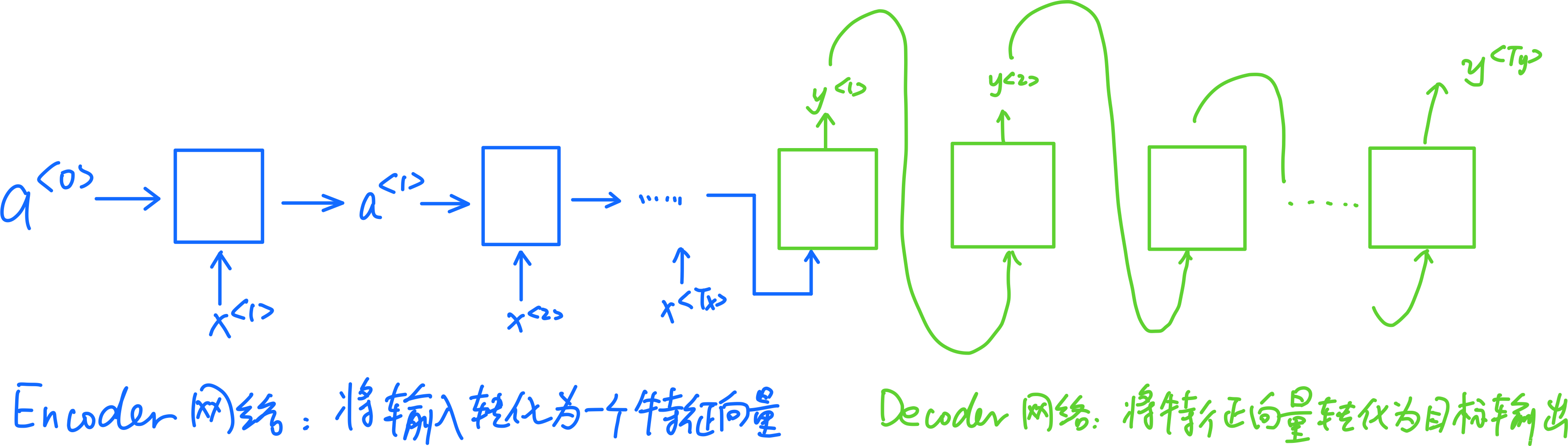

Sequence to sequence model

以法語翻譯成爲中文爲例:(encoder-decoder)

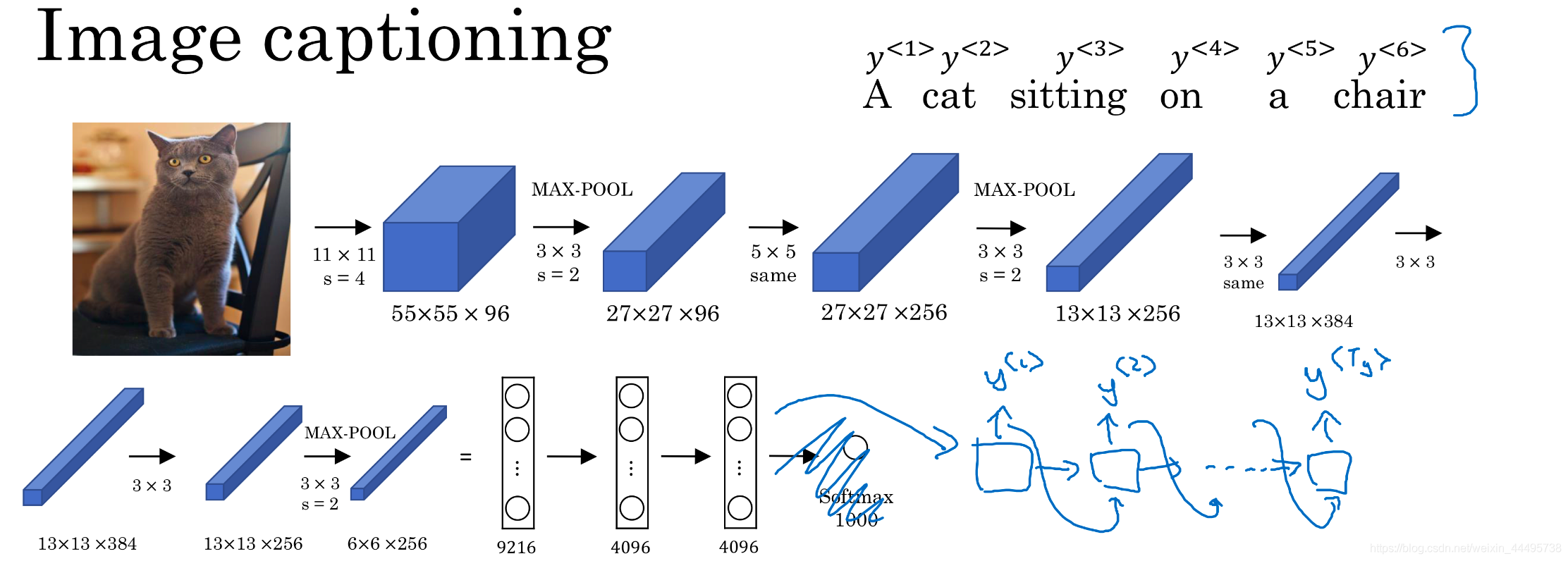

Image Captioning

CNN(AlexNet)+decoder

3.2 選擇最可能的句子

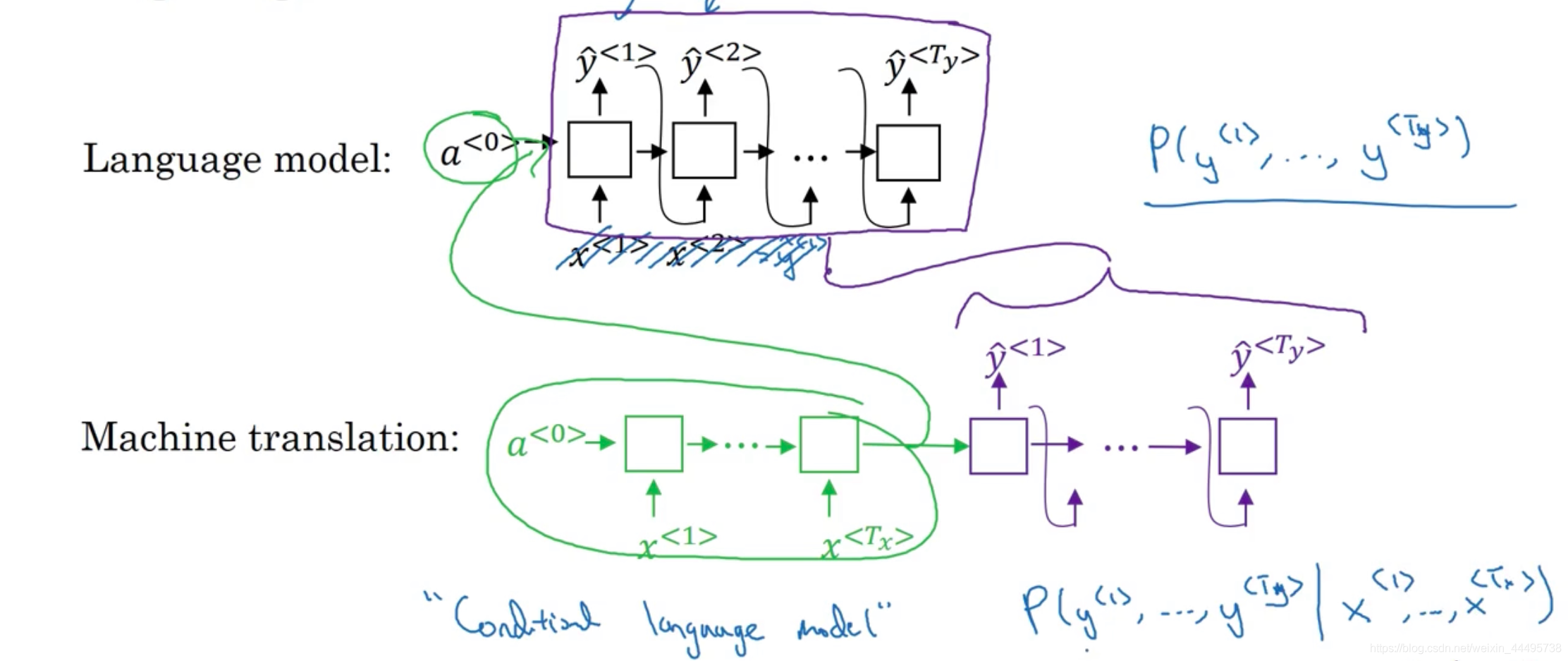

語言模型和機器翻譯的比較:

Rq:

- 我們注意到語言模型和機器翻譯具有很大的相似性,實際上機器翻譯就是把一開始隨機化的向量改成了一個有Encoder模型得到的向量。

-