TensorFlow最出色的30個機器學習數據集

TensorFlow是由谷歌大腦的研究人員建立、最大的機器學習和數據科學的開源數據庫之一。它是一個端到端平臺,適合完全沒有經驗的初學者和有經驗的數據科學家。TensorFlow庫包括工具、預訓練模型、機器學習教學以及一整套公開數據集。爲了幫助你找到所需的訓練數據,本文將簡單介紹一些TensorFlow中用於機器學習的大型數據集。我們將以下數據集的列表分爲影象、視訊、音訊和文字。

TensorFlow影象數據集

1. CelebA:明星臉屬性數據集(CelebA)是最大的公開可用的人臉影象數據集,其中包含200,000多個名人影象。

每個影象包括5個面部標註和40個二進制屬性標註。

2. Downsampling Imagenet:該數據集是爲密度估計和生成性建模任務而建立的。它包括了130多萬張物體、場景、車輛、人物等影象。這些影象有兩種解析度規格:32×32和64×64。

3. Lsun—Lsun是一個大規模的影象數據集,建立該數據集是爲了幫助訓練模型進行場景理解。該數據集包含超過900萬張影象,按場景類別劃分,如臥室、教室和餐廳。

4. Bigearthnet—Bigearthnet是另一個大規模數據集,它包含來自Sentinel-2衛星的航空影象。每張影象覆蓋了1.2公裡×1.2公裡的一片地面。該數據集中有43個類別不平衡的標籤。

5. Places 365—顧名思義,Places 365包含180多萬張不同地方或場景的圖片。其中一些類別包括辦公室、碼頭和別墅。Places 365是用於場景識別任務的最大數據集之一。

6. Quickdraw點陣圖—Quickdraw數據集是由Quickdraw玩家社羣繪製的影象集合。它包含500萬張圖紙,跨越345個類別。這個版本的Quickdraw數據集包括28×28的灰度影象。

7. SVHN Cropped—街景房號(SVHN)是爲訓練數位識別演算法,由斯坦福大學建立的TensorFlow數據集。它包含60萬個真實世界的、被裁剪成32×32畫素的影象數據範例。

8. VGGFace2—最大的人臉影象數據集之一,VGGFace2包含從谷歌搜尋引擎下載的影象。數據集中的人臉在年齡、姿勢和種族上都有所不同。每個類別平均有362張影象。

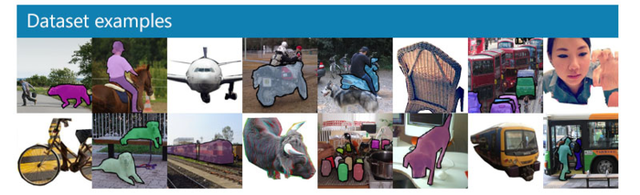

9. COCO—由谷歌、FAIR、加州理工學院等合作者製作,是世界上最大的標籤影象數據集之一。它是爲物體檢測、分割和影象字幕任務而建立的。

通過cocodataset.org

數據集包含330,000張影象,其中20萬張有標籤。在所有影象中,共包含了80個類別的150萬個物件範例。

10. Open Images Challenge 2019—包含約900萬張影象,該數據集是網上最大的、標註的影象數據集之一。這些影象包含影象級標籤、物件邊界框和物件分割掩碼,以及他們之間的視覺關係。

11. Open Images V4—這個數據集是上述Open Images數據集的另一個迭代。V4版本中包含了600個不同物體類別的1460萬個邊界框。這些邊界框是由人類標註者手動繪製的。

12. AFLW2K3D—該數據集包含2000張面部影象,均有3D面部真實標註。它的建立是爲了評估3D面部標註檢測模型。

視訊數據集

13. UCF101—來自中央佛羅裡達大學,UCF101是爲訓練動作識別模型而建立的視訊數據集。該數據集有101個動作類別的13320個視訊,。

14. BAIR Robot Pushing—來自伯克利人工智慧研究,BAIR Robot Pushing包含44000個機器人推的動作的範例視訊。

15. Moving MNIST—這個數據集是MNIST基準數據集的一個變體。Moving MNIST包含10,000個視訊。

每個視訊都顯示了在64×64大小的幀內2個手寫數位的移動過程。

16. EMNIST—擴充套件的MNIST數據集,包含了原始MNIST數據集轉換成28 x 28畫素大小的圖片。

TensorFlow音訊數據集

17. CREMA-D—爲情感識別任務而建立,CREMA-D由語音情感表達組成。 該數據集包含由年齡,種族和性別不同的91位演員表達的7,442個音訊剪輯。

18. Librispeech—Librispeech是一個簡單的音訊數據集,它包含1000小時的英語語音,這些語音來自LibriVox專案的有聲讀物。它被用於訓練聲學模型和語言模型。

19. Libritts—這個數據集包含約585小時的英語語音,是在Google Brain團隊成員的協助下準備的。Libritts最初是爲Text-to-speech(TTS)研究設計的,但可以用於各種語音識別任務。

20. TED-LIUM—TED-LIUM是一個包含110多個小時的英語TED演講的數據集。 所有的演講內容都已被轉錄。

21. VoxCeleb—VoxCeleb是爲演講者識別任務而建立的大型音訊數據集,包含來自1,251位演講者的150,000多個音訊樣本。

文字數據集

22. C4(Common Crawl's Web Crawl Corpus)—Common Crawl是一個開放原始碼的網頁數據庫。它包含了超過40種語言、跨越7年的數據。

23. Civil Comments—這個數據集是由來自50個英文新聞網站的180多萬條公衆評論構成的。

24. IRC Disentanglement—這個TensorFlow數據集包括來自Ubuntu IRC頻道的77000多條評論。每個樣本的元數據包括訊息ID和時間戳。

25. Lm1b—被稱爲語言模型基準,這個數據集包含10億個單詞。它最初是爲了衡量統計語言建模的進展。

26. SNLI—斯坦福自然語言推理數據集是一個包含57萬個人類寫作句子對的語料庫。所有的句對都經過人工標註,類別是均衡的。

27.e-SNLI—這個數據集是上面提到的SNLI的擴充套件,它包含了原始數據集的57萬個句子對,分類爲:包含、矛盾和中性。

28. MultiNLI—仿照SNLI數據集,MultiNLI包含433,000個句子對,都有尾部資訊註釋。

29. Wiki40b—這個大規模的數據集包括40種不同語言的維基百科文章。這些數據已經被清理,其中的非內容部分以及結構化物件已經被去掉。

30. Yelp極性評論—這個數據集包含598,000條高度極性的Yelp評論。它們是從2015年Yelp數據集挑戰賽中的數據提取出來的。

雖然上述數據集是機器學習中最大、最廣泛使用的一些TensorFlow數據集,但TensorFlow庫是龐大的,並在不斷擴充套件。請存取TensorFlow網站,瞭解更多關於該平臺如何幫助您構建自己的模型的資訊。