前饋神經網路解密:深入理解人工智慧的基石

本文深入探討了前饋神經網路(FNN)的核心原理、結構、訓練方法和先進變體。通過Python和PyTorch的實戰演示,揭示了FNN的多樣化應用。

作者TechLead,擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

一、前饋神經網路概述

前饋神經網路(Feedforward Neural Network, FNN)是神經網路中最基本和經典的一種結構,它在許多實際應用場景中有著廣泛的使用。在本節中,我們將深入探討FNN的基本概念、工作原理、應用場景以及優缺點。

什麼是前饋神經網路

前饋神經網路是一種人工神經網路,其結構由多個層次的節點組成,並按特定的方向傳遞資訊。與之相對的是遞迴神經網路,其中資訊可以在不同層之間雙向傳遞。

- 結構特點: 由輸入層、一個或多個隱藏層和輸出層組成。

- 資訊流動: 資訊僅在一個方向上流動,從輸入層通過隱藏層最終到達輸出層,沒有反饋迴圈。

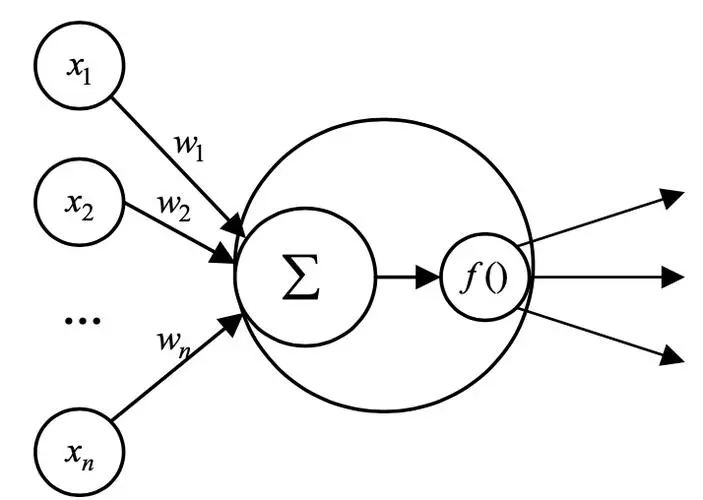

前饋神經網路的工作原理

前饋神經網路的工作過程可以分為前向傳播和反向傳播兩個階段。

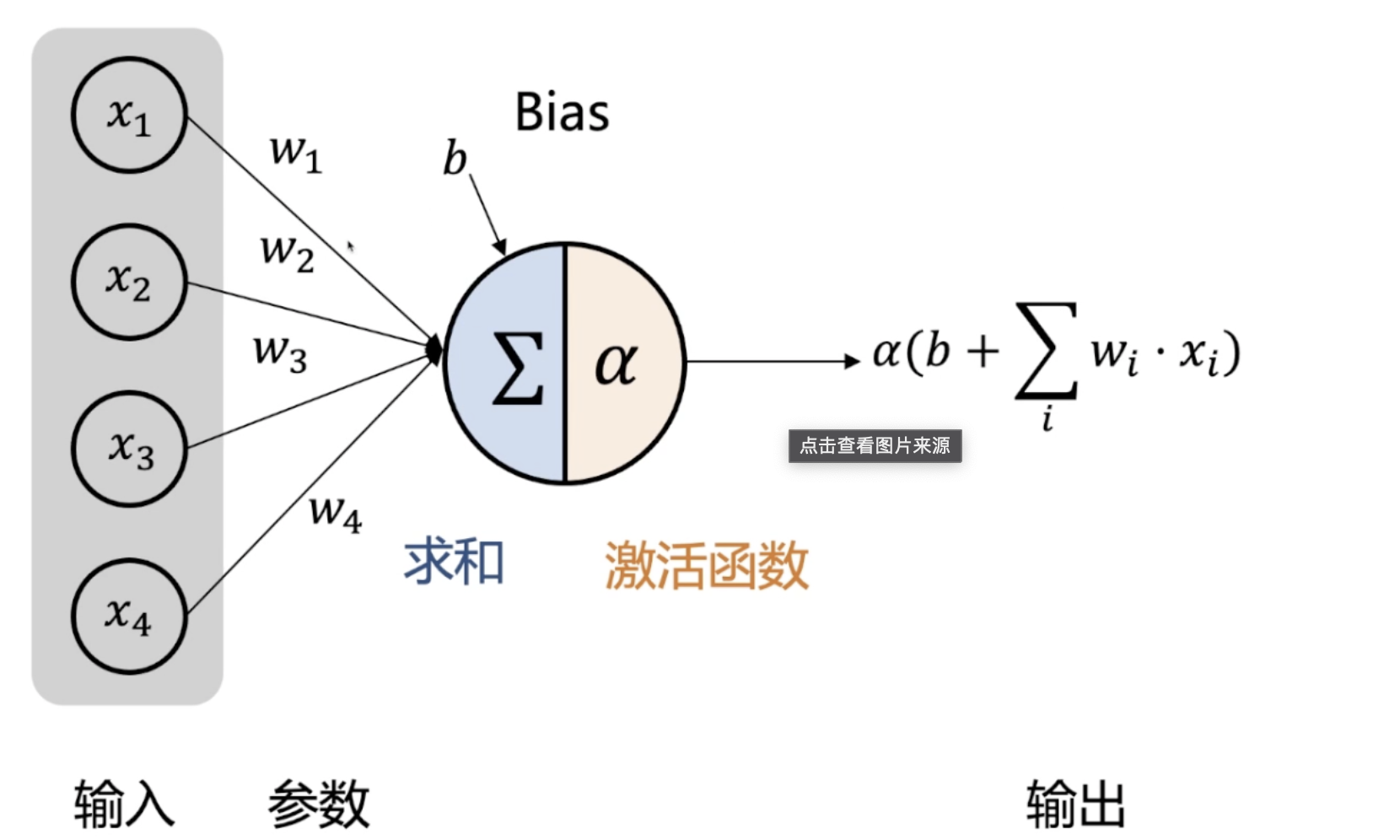

- 前向傳播: 輸入資料在每一層被權重和偏置加權後,通過啟用函數進行非線性變換,傳遞至下一層。

- 反向傳播: 通過計算輸出誤差和每一層的梯度,對網路中的權重和偏置進行更新。

應用場景及優缺點

前饋神經網路在許多領域都有著廣泛的應用,包括影象識別、語音處理、金融預測等。

- 優點:

- 結構簡單,易於理解和實現。

- 可以適用於多種資料型別和任務。

- 缺點:

- 對於具有時序關係的資料處理能力較弱。

- 容易陷入區域性最優解,需要合理選擇啟用函數和優化策略。

二、前饋神經網路的基本結構

前饋神經網路(FNN)的基本結構包括輸入層、隱藏層和輸出層,以及相應的啟用函數、權重和偏置。這些組成部分共同構成了網路的全貌,並定義了網路如何從輸入資料中提取特徵並進行預測。本節將詳細介紹這些核心組成部分。

輸入層、隱藏層和輸出層

前饋神經網路由三個主要部分組成:輸入層、隱藏層和輸出層。

- 輸入層: 負責接收原始資料,通常對應於特徵的維度。

- 隱藏層: 包含一個或多個層,每層由多個神經元組成,用於提取輸入資料的抽象特徵。

- 輸出層: 產生網路的最終預測或分類結果。

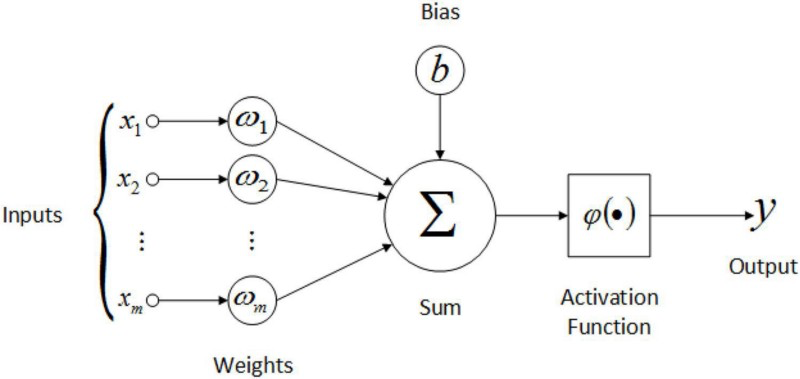

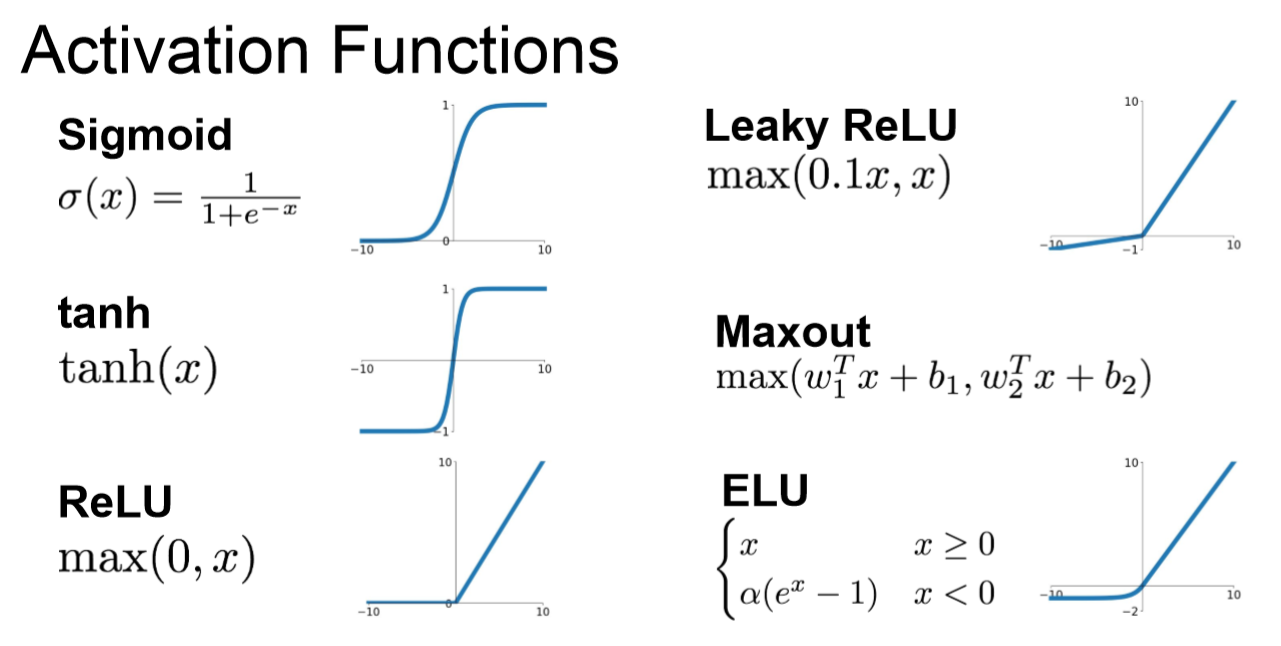

啟用函數的選擇與作用

啟用函數是神經網路中非常重要的組成部分,它向網路引入非線性特性,使網路能夠學習複雜的函數。

- 常見啟用函數: 如ReLU、Sigmoid、Tanh等。

- 作用: 引入非線性,增強網路的表達能力。

網路權重和偏置

權重和偏置是神經網路的可學習引數,它們在訓練過程中不斷調整,以最小化預測錯誤。

- 權重: 連線各層神經元的線性因子,控制資訊在神經元之間的流動。

- 偏置: 允許神經元在沒有輸入的情況下啟用,增加模型的靈活性。

三、前饋神經網路的訓練方法

前饋神經網路(FNN)的訓練是一個複雜且微妙的過程,涉及多個關鍵元件和技術選擇。從損失函數的選擇到優化演演算法,再到反向傳播和過擬合的處理,本節將深入探討FNN的訓練方法。

損失函數與優化演演算法

損失函數和優化演演算法是神經網路訓練的基石,決定了網路如何學習和調整其權重。

- 損失函數: 用於衡量網路預測與實際目標之間的差異,常見的損失函數包括均方誤差(MSE)、交叉熵損失等。

- 優化演演算法: 通過最小化損失函數來更新網路權重,常見的優化演演算法包括隨機梯度下降(SGD)、Adam、RMSProp等。

反向傳播演演算法詳解

反向傳播是一種高效計算損失函數梯度的演演算法,它是神經網路訓練的核心。

- 工作原理: 通過鏈式法則,從輸出層向輸入層逐層計算梯度。

- 權重更新: 根據計算的梯度,使用優化演演算法更新網路的權重和偏置。

避免過擬合的策略

過擬合是訓練神經網路時常遇到的問題,有多種策略可以減輕或避免過擬合。

- 早停法(Early Stopping): 當驗證集上的效能停止提高時,提前結束訓練。

- 正則化: 通過在損失函數中新增額外的懲罰項,約束網路權重,例如L1和L2正則化。

- Dropout: 隨機關閉部分神經元,增加模型的魯棒性。

四、使用Python和PyTorch實現FNN

在理解了前饋神經網路的理論基礎之後,我們將轉向實際的程式設計實現。在本節中,我們將使用Python和深度學習框架PyTorch實現一個完整的前饋神經網路,並逐步完成資料準備、模型構建、訓練和評估等關鍵步驟。

4.1 準備資料集

準備資料集是構建神經網路模型的第一步。我們需要確保資料的質量和格式適合神經網路訓練。

選擇合適的資料集

選擇與任務匹配的資料集是成功訓練模型的關鍵。例如,對於影象分類任務,MNIST和CIFAR-10等都是流行的選擇。

資料預處理

預處理是準備資料集中的重要步驟,包括以下幾個方面:

- 資料標準化/歸一化: 將資料轉換為具有零均值和單位方差的形式,有助於模型的訓練和收斂。

- 資料增強: 通過旋轉、剪裁、縮放等手段增加資料的多樣性,有助於提高模型的泛化能力。

- 劃分訓練集、驗證集和測試集: 合理的資料劃分有助於評估模型在未見資料上的效能。

PyTorch資料載入器

PyTorch提供了DataLoader類,可用於批次載入和混洗資料,使訓練過程更加高效。

from torch.utils.data import DataLoader

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True)

4.2 構建模型結構

在準備了適當的資料集之後,我們將轉向使用Python和PyTorch構建前饋神經網路(FNN)的模型結構。構建模型結構包括定義網路的架構、選擇啟用函數和初始化權重等關鍵步驟。

定義網路架構

我們可以使用PyTorch的nn.Module類來定義自定義的網路結構。以下是一個具有單個隱藏層的FNN範例。

import torch.nn as nn

class SimpleFNN(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim):

super(SimpleFNN, self).__init__()

self.hidden_layer = nn.Linear(input_dim, hidden_dim)

self.output_layer = nn.Linear(hidden_dim, output_dim)

self.activation = nn.ReLU()

def forward(self, x):

x = self.activation(self.hidden_layer(x))

x = self.output_layer(x)

return x

選擇啟用函數

啟用函數的選擇取決於特定的任務和層型別。在隱藏層中,ReLU通常是一個良好的選擇。對於分類任務的輸出層,Softmax可能更合適。

權重初始化

合適的權重初始化可以大大加快訓練的收斂速度。PyTorch提供了多種預定義的初始化方法,例如Xavier和He初始化。

def init_weights(m):

if type(m) == nn.Linear:

nn.init.xavier_uniform_(m.weight)

m.bias.data.fill_(0.01)

model = SimpleFNN(784, 256, 10)

model.apply(init_weights)

構建與任務相匹配的損失函數

損失函數的選擇應與特定任務匹配。例如,對於分類任務,交叉熵損失是一個常見的選擇。

loss_criterion = nn.CrossEntropyLoss()

4.3 訓練模型

一旦構建了前饋神經網路(FNN)的模型結構,下一步就是訓練模型。訓練過程涉及多個關鍵步驟和技術選擇,如下所述:

選擇優化器

優化器用於更新模型的權重以最小化損失函數。PyTorch提供了多種優化器,例如SGD、Adam和RMSProp。

import torch.optim as optim

optimizer = optim.Adam(model.parameters(), lr=0.001)

訓練迴圈

訓練迴圈是整個訓練過程的核心,其中包括前向傳遞、損失計算、反向傳播和權重更新。

for epoch in range(epochs):

for data, target in train_loader:

optimizer.zero_grad()

output = model(data)

loss = loss_criterion(output, target)

loss.backward()

optimizer.step()

模型驗證

在訓練過程中定期在驗證集上評估模型可以提供有關模型泛化能力的資訊。

調整學習率

學習率是訓練過程中的關鍵超引數。使用學習率排程程式可以根據訓練進展動態調整學習率。

scheduler = optim.lr_scheduler.StepLR(optimizer, step_size=10, gamma=0.7)

儲存和載入模型

儲存模型權重並能夠重新載入它們是進行長期訓練和模型部署的關鍵。

# 儲存模型

torch.save(model.state_dict(), 'model.pth')

# 載入模型

model.load_state_dict(torch.load('model.pth'))

視覺化訓練過程

使用例如TensorBoard的工具視覺化訓練過程,有助於理解模型的學習動態和偵錯問題。

4.4 模型評估與視覺化

完成模型的訓練之後,接下來的關鍵步驟是對其進行評估和視覺化。這可以幫助我們理解模型的效能,並行現可能的改進方向。

評估指標

評估模型效能時,需要選擇與任務和業務目標相符的評估指標。例如,分類任務常用的指標有準確率、精確率、召回率和F1分數。

from sklearn.metrics import accuracy_score

# 計算準確率

accuracy = accuracy_score(targets, predictions)

模型驗證

在測試集上驗證模型可以提供對模型在未見過的資料上效能的公正評估。

混淆矩陣

混淆矩陣是一種視覺化工具,可以揭示模型在不同類別之間的效能。

from sklearn.metrics import confusion_matrix

import seaborn as sns

cm = confusion_matrix(targets, predictions)

sns.heatmap(cm, annot=True)

ROC和AUC

對於二元分類任務,接收者操作特性(ROC)曲線和曲線下面積(AUC)是流行的評估工具。

特徵重要性和模型解釋

瞭解模型如何做出預測以及哪些特徵對預測最有影響是可解釋性分析的關鍵部分。

視覺化隱藏層

通過視覺化隱藏層的啟用,我們可以深入瞭解網路是如何學習和表示輸入資料的。

五、前饋神經網路的先進變體與應用

前饋神經網路(FNN)的基本結構已經非常成熟,但隨著研究的不斷深入和技術的不斷進展,已經湧現出許多先進的變體和新穎的應用場景。本節將介紹一些值得關注的方向。

多層感知器(MLP)

MLP是最簡單和常用的前饋神經網路型別,由全連線層組成。它在眾多領域都有廣泛應用,包括分類、迴歸和聚類。

折積神經網路(CNN)

雖然CNN主要用於處理影象資料,但其基本原理和FNN有很多相似之處。通過引入折積層,CNN能夠有效捕獲空間特徵。

迴圈神經網路(RNN)

與FNN不同,RNN能夠處理序列資料。這使得RNN在自然語言處理、時間序列分析等方面有非常廣泛的應用。

Transformer結構

Transformer結構是當前自然語言處理中的前沿技術。雖然其結構與FNN有所不同,但某些設計思想和技術細節與FNN有共通之處。

強化學習中的FNN

FNN在強化學習中作為值函數或策略函數的近似器也有廣泛應用。深度Q網路(DQN)就是一個典型例子。

生成對抗網路(GAN)

在GAN中,生成器和判別器通常採用FNN結構。GAN已經在影象生成、風格遷移等領域取得了令人矚目的成就。

FNN在醫學影象分析中的應用

FNN已經被成功用於解讀醫學影象,例如X光、MRI和CT掃描等,提供輔助診斷。

六、總結與未來展望

前饋神經網路(FNN)作為深度學習的基礎,其影響深遠且廣泛。在本篇文章中,我們深入探討了FNN的基本原理、結構設計、訓練方法,還展示了使用Python和PyTorch構建和訓練FNN的具體步驟。此外,我們還探討了FNN的先進變體和廣泛應用。下面是總結和未來展望。

總結

- 基本結構: FNN的基本結構清晰且靈活,可用於處理各種型別的資料。

- 訓練方法: 藉助梯度下降和反向傳播,FNN可以有效地訓練。

- 實戰應用: 通過Python和PyTorch,我們能夠快速實現和部署FNN。

- 先進變體: FNN的設計理念已被廣泛應用於如CNN、RNN等更復雜的網路結構。

- 多領域應用: FNN已被成功用於眾多領域,從影象識別到自然語言處理,再到醫學診斷等。

未來展望

- 演演算法優化: 隨著研究的深入,可以期待有更高效的訓練演演算法和優化策略的出現。

- 新型結構: FNN的新型變體將繼續湧現,為不同的應用需求提供更好的解決方案。

- 可解釋性和可信賴性: 未來的研究將更加關注FNN的可解釋性和可信賴性,使其更符合現實世界的需求和規範。

- 更廣泛的應用: 隨著技術的進步,FNN將在更多領域找到應用,可能涉及現今尚未涉及的問題領域。

- 跨學科研究: 通過與其他學科的交叉融合,FNN可能會孕育出全新的學科和應用方向。

結語

前饋神經網路作為深度學習領域的一塊基石,其重要性不言而喻。隨著技術的不斷進步,我們可以期待FNN在未來將發揮更大的作用,推動人工智慧領域的不斷髮展。無論是學術研究者還是工業界工程師,對FNN的深入理解和掌握都是探索這一令人興奮領域的關鍵。

作者TechLead,擁有10+年網際網路服務架構、AI產品研發經驗、團隊管理經驗,同濟本復旦碩,復旦機器人智慧實驗室成員,阿里雲認證的資深架構師,專案管理專業人士,上億營收AI產品研發負責人。

如有幫助,請多關注

個人微信公眾號:【TechLead談雲】分享AI與雲服務研發的全維度知識,談談我作為TechLead對技術的獨特洞察。

TeahLead KrisChang,10+年的網際網路和人工智慧從業經驗,10年+技術和業務團隊管理經驗,同濟軟體工程本科,復旦工程管理碩士,阿里雲認證雲服務資深架構師,上億營收AI產品業務負責人。