道德與社會問題簡報 #4: 文生圖模型中的偏見

簡而言之: 我們需要更好的方法來評估文生圖模型中的偏見

介紹

文字到影象 (TTI) 生成 現在非常流行,成千上萬的 TTI 模型被上傳到 Hugging Face Hub。每種模態都可能受到不同來源的偏見影響,這就引出了一個問題: 我們如何發現這些模型中的偏見?在當前的部落格文章中,我們分享了我們對 TTI 系統中偏見來源的看法以及解決它們的工具和潛在解決方案,展示了我們自己的專案和來自更廣泛社群的專案。

影象生成中編碼的價值觀和偏見

偏見和價值 之間有著非常密切的關係,特別是當這些偏見和價值嵌入到用於訓練和查詢給定 文字到影象模型 的語言或影象中時; 這種現象嚴重影響了我們在生成影象中看到的輸出。儘管這種關係在更廣泛的人工智慧研究領域中是眾所周知的,並且科學家們正在進行大量努力來解決它,但試圖在一個模型中表示一個給定人群價值觀的演變性質的複雜性仍然存在。這給揭示和充分解決這一問題帶來了持久的道德挑戰。

例如,如果訓練資料主要是英文,它們可能傳達相當西方化的價值觀。結果我們得到了對不同或遙遠文化的刻板印象。當我們比較 ERNIE ViLG (左) 和 Stable Diffusion v 2.1 (右) 對同一提示「北京的房子」的結果時,這種現象顯得非常明顯:

偏見的來源

近年來,人們在單一模態的 AI 系統中進行了大量關於偏見檢測的重要研究,包括自然語言處理 (Abid et al., 2021) 和計算機視覺 (Buolamwini and Gebru, 2018)。由於機器學習模型是由人類構建的,因此所有機器學習模型 (實際上,所有技術) 都存在偏見。這可能表現為影象中某些視覺特徵的過度和不足 (例如,所有辦公室工作人員都繫著領帶),或者文化和地理刻板印象的存在 (例如,所有新娘都穿著白色禮服和麵紗,而不是更具代表性的世界各地的新娘,如穿紅色紗麗的新娘)。鑑於 AI 系統被部署在社會技術背景下,並且在不同行業和工具中廣泛部署 (例如 Firefly,Shutterstock),它們特別容易放大現有的社會偏見和不平等。我們旨在提供一個非詳盡的偏見來源列表:

訓練資料中的偏見: 一些流行的多模態資料集,如文字到影象的 LAION-5B,影象字幕的 MS-COCO 和視覺問答的 VQA v2.0,已經被發現包含大量的偏見和有害關聯 (Zhao et al 2017,Prabhu and Birhane, 2021,Hirota et al, 2022),這些偏見可能會滲透到在這些資料集上訓練的模型中。例如,來自 Hugging Face Stable Bias project 的初步結果顯示,影象生成缺乏多樣性,並且延續了文化和身份群體的常見刻板印象。比較 Dall-E 2 生成的 CEO (右) 和經理 (左),我們可以看到兩者都缺乏多樣性:

預訓練資料過濾中的偏見: 在將資料集用於訓練模型之前,通常會對其進行某種形式的過濾; 這會引入不同的偏見。例如,在他們的 部落格文章 中,Dall-E 2 的建立者發現過濾訓練資料實際上會放大偏見 - 他們假設這可能是由於現有資料集偏向於在更性感化的背景下呈現女性,或者由於他們使用的過濾方法本身具有偏見。

推理中的偏見: 用於指導 Stable Diffusion 和 Dall-E 2 等文字到影象模型的訓練和推理的 CLIP 模型 有許多 記錄詳細的偏見,涉及年齡、性別和種族或族裔,例如將被標記為 白人 、 中年 和 男性 的影象視為預設。這可能會影響使用它進行提示編碼的模型的生成,例如通過解釋未指定或未明確指定的性別和身份群體來表示白人和男性。

模型潛在空間中的偏見: 已經進行了一些 初步工作,探索模型的潛在空間並沿著不同軸 (如性別) 引導影象生成,使生成更具代表性 (參見下面的影象)。然而,還需要更多工作來更好地理解不同型別擴散模型的潛在空間結構以及影響生成影象中反映偏見的因素。

後期過濾中的偏見: 許多影象生成模型都內建了旨在標記問題內容的安全過濾器。然而,這些過濾器的工作程度以及它們對不同型別內容的魯棒性有待確定 - 例如,對 Stable Diffusion 安全過濾器進行紅隊對抗測試 表明,它主要識別性內容,並未能標記其他型別的暴力、血腥或令人不安的內容。

檢測偏見

我們上面描述的大多數問題都不能用單一的解決方案解決 - 實際上,偏見是一個複雜的話題,不能僅靠技術來有意義地解決。偏見與它所存在的更廣泛的社會、文化和歷史背景緊密相連。因此,解決 AI 系統中的偏見不僅是一個技術挑戰,而且是一個需要多學科關注的社會技術挑戰。其中包括工具、紅隊對抗測試和評估在內的一系列方法可以幫助我們獲得重要的見解,這些見解可以為模型建立者和下游使用者提供有關 TTI 和其他多模態模型中包含的偏見的資訊。

我們在下面介紹一些這些方法:

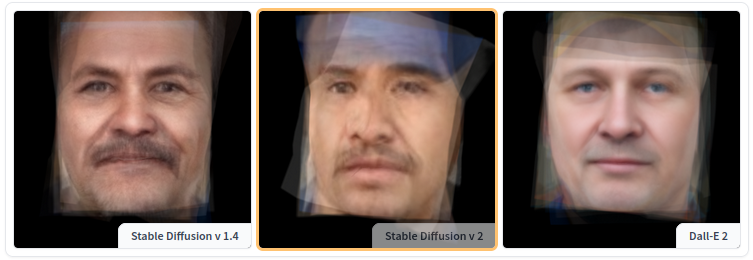

探索偏見的工具: 作為 Stable Bias 專案 的一部分,我們建立了一系列工具來探索和比較不同文字到影象模型中偏見的視覺表現。例如,Average Diffusion Faces 工具讓你可以比較不同職業和不同模型的平均表示 - 如下面所示,對於 ‘janitor’,分別為 Stable Diffusion v1.4、v2 和 Dall-E 2:

其他工具,如 Face Clustering tool 和 Colorfulness Profession Explorer 工具,允許使用者探索資料中的模式並識別相似性和刻板印象,而無需指定標籤或身份特徵。事實上,重要的是要記住,生成的個人影象並不是真實的人,而是人工創造的,所以不要把它們當作真實的人來對待。根據上下文和用例,這些工具可以用於講故事和審計。

紅隊對抗測試: 「紅隊對抗測試」 包括通過提示和分析結果來對 AI 模型進行潛在漏洞、偏見和弱點的壓力測試。雖然它已經在實踐中用於評估語言模型 (包括即將到來的 DEFCON 上的 Generative AI Red Teaming 活動,我們也參加了),但目前還沒有建立起系統化的紅隊對抗測試 AI 模型的方法,它仍然相對臨時性。事實上,AI 模型中有這麼多潛在的故障模式和偏見,很難預見它們全部,而生成模型的 隨機性質 使得難以復現故障案例。紅隊對抗測試提供了關於模型侷限性的可行性見解,並可用於新增防護欄和記錄模型侷限性。目前沒有紅隊對抗測試基準或排行榜,突顯了需要更多開源紅隊對抗測試資源的工作。Anthropic 的紅隊對抗測試資料集 是唯一一個開源的紅隊對抗測試 prompts,但僅限於英語自然語言文字。

評估和記錄偏見: 在 Hugging Face,我們是 模型卡片 和其他形式的檔案 (如 資料表、README 等) 的大力支援者。在文字到影象 (和其他多模態) 模型的情況下,使用探索工具和紅隊對抗測試等上述方法進行的探索結果可以與模型檢查點和權重一起共用。其中一個問題是,我們目前沒有用於測量多模態模型 (特別是文字到影象生成系統) 中偏見的標準基準或資料集,但隨著社群在這個方向上進行更多 工作,不同的偏見指標可以在模型檔案中並行報告。

價值觀和偏見

上面列出的所有方法都是檢測和理解影象生成模型中嵌入的偏見的一部分。但我們如何積極應對它們呢?

一種方法是開發新的模型,代表我們希望它成為社會性模型。這意味著建立不僅模仿我們資料中的模式,而且積極促進更公平、更公正觀點的 AI 系統。然而,這種方法提出了一個關鍵問題: 我們將誰的價值觀程式設計到這些模型中?價值觀在不同文化、社會和個人之間有所不同,使得在 AI 模型中定義一個「理想」的社會應該是什麼樣子成為一項複雜的任務。這個問題確實複雜且多面。如果我們避免在我們的 AI 模型中再現現有的社會偏見,我們就面臨著定義一個「理想」的社會表現的挑戰。社會並不是一個靜態的實體,而是一個動態且不斷變化的構造。那麼,AI 模型是否應該隨著時間的推移適應社會規範和價值觀的變化呢?如果是這樣,我們如何確保這些轉變真正代表了社會中所有群體,特別是那些經常被忽視的群體呢?

此外,正如我們在 上一期簡報 中提到的,開發機器學習系統並沒有一種單一的方法,開發和部署過程中的任何步驟都可能提供解決偏見的機會,從一開始誰被包括在內,到定義任務,到策劃資料集,訓練模型等。這也適用於多模態模型以及它們最終在社會中部署或生產化的方式,因為多模態模型中偏見的後果將取決於它們的下游使用。例如,如果一個模型被用於人機互動環境中的圖形設計 (如 RunwayML 建立的那些),使用者有多次機會檢測和糾正偏見,例如通過更改提示或生成選項。然而,如果一個模型被用作幫助法醫藝術家建立潛在嫌疑人警察素描的 工具 (見下圖),那麼風險就更高了,因為這可能在高風險環境中加強刻板印象和種族偏見。

其他更新

我們也在繼續在道德和社會的其他方面進行工作,包括:

-

內容稽核:

-

AI 問責政策:

結語

從上面的討論中你可以看出,檢測和應對多模態模型 (如文字到影象模型) 中的偏見和價值觀仍然是一個懸而未決的問題。除了上面提到的工作,我們還在與社群廣泛接觸這些問題 - 我們最近在 FAccT 會議上共同主持了一個關於這個主題的 CRAFT 會議,並繼續在這個主題上進行資料和模型為中心的研究。我們特別興奮地探索一個更深入地探究文字到影象模型中所蘊含的 價值 及其所代表的方向 (敬請期待!)。

英文原文: https://hf.co/blog/ethics-soc-4

作者: Sasha Luccioni, Giada Pistilli, Nazneen Rajani, Elizabeth Allendorf, Irene Solaiman, Nathan Lambert, Margaret Mitchell

譯者: innovation64

排版/審校: zhongdongy (阿東)