文心一言,通行銷之學,成一家之言,百度人工智慧AI巨量資料模型文心一言Python3.10接入

「文心」取自《文心雕龍》一書的開篇,作者劉勰在書中引述了一個古代典故:春秋時期,魯國有一位名叫孔文子的大夫,他在學問上非常有造詣,但是他的兒子卻不學無術,孔文子非常痛心。

一天,孔文子在山上遇到了一位神仙,神仙告訴他:「你的兒子之所以不學無術,是因為你沒有給他灌輸文心,讓他懂得文學的魅力和意義。」孔文子聽後深受啟發,回家後開始給兒子灌輸文學知識,兒子也逐漸對學問產生了興趣,最終成為了一位有學問的人。因此,劉勰在書中將「文心」解釋為「灌輸文學知識的心靈」之意。

百度以「文心」命名自己的AI產品線,可見其對自己的中文處理能力是極為自信的,ERNIE3.0對標ChatGPT3.5/4.0,ERNIE-ViLG對標Stable-Diffusion,文心PLATO則可以理解為ChatGPT的embedding,可謂是野心勃勃。

文心一言SDK引入

百度目前已經開源文心一言的sdk工具包:

pip3 install --upgrade wenxin-api

和百度雲產品線一樣,安裝好以後,需要去文心一言官網獲取appkey和appsecret

隨後編寫請求邏輯:

import wenxin_api

from wenxin_api.tasks.free_qa import FreeQA

wenxin_api.ak = "your ak" #輸入您的API Key

wenxin_api.sk = "your sk" #輸入您的Secret Key

input_dict = {

"text": "問題:天為什麼這麼藍?\n回答:",

"seq_len": 512,

"topp": 0.5,

"penalty_score": 1.2,

"min_dec_len": 2,

"min_dec_penalty_text": "。?:![<S>]",

"is_unidirectional": 0,

"task_prompt": "qa",

"mask_type": "paragraph"

}

rst = FreeQA.create(**input_dict)

print(rst)

程式返回:

{

"code": 0,

"msg": "success",

"data": {

"result": "因為我們有個好心情",

"createTime": "2023-03-16 16:02:10",

"requestId": "71a6efb46acbd64394374f44579a01eb",

"text": "天為什麼這麼藍",

"taskId": 1000000,

"status": 1 # 0表示生成中,1表示生成成功

}

}

請求的引數含義請參照官方檔案:

async

非同步標識 int 1

1

是

非同步標識,現階段必傳且傳1

text

使用者輸入文字 string 空

[1, 1000]

是

模型的輸入文字,為prompt形式的輸入。

min_dec_len

最小生成長度 int 1

[1,seq_len]

是

輸出結果的最小長度,避免因模型生成END導致生成長度過短的情況,與seq_len結合使用來設定生成文字的長度範圍。

seq_len

最大生成長度 int 128

[1, 1000]

是

輸出結果的最大長度,因模型生成END或者遇到使用者指定的stop_token,實際返回結果可能會小於這個長度,與min_dec_len結合使用來控制生成文字的長度範圍。

topp

多樣性 float 1.0

[0.0,1.0],間隔0.1

是

影響輸出文字的多樣性,取值越大,生成文字的多樣性越強。

penalty_score

重複懲罰 float 1.0

[1,2]

否

通過對已生成的token增加懲罰,減少重複生成的現象。值越大表示懲罰越大。設定過大會導致長文字生成效果變差。

stop_token

提前結束符 string 空

否

預測結果解析時使用的結束字串,碰到對應字串則直接截斷並返回。可以通過設定該值,可以過濾掉few-shot等場景下模型重複的cases。

task_prompt

任務型別 string 空 PARAGRAPH,

SENT, ENTITY,

Summarization, MT,

Text2Annotation,

Misc, Correction,

QA_MRC, Dialogue,

QA_Closed_book,

QA_Multi_Choice,

QuestionGeneration,

Paraphrasing, NLI,

SemanticMatching,

Text2SQL,

TextClassification,

SentimentClassification,

zuowen, adtext,

couplet,novel,

cloze

否

指定預置的任務模板,效果更好。 PARAGRAPH:引導模型生成一段文章; SENT:引導模型生成一句話; ENTITY:引導模型生成片語; Summarization:摘要; MT:翻譯; Text2Annotation:抽取; Correction:糾錯; QA_MRC:閱讀理解; Dialogue:對話; QA_Closed_book: 閉卷問答; QA_Multi_Choice:多選問答; QuestionGeneration:問題生成; Paraphrasing:複述; NLI:文字蘊含識別; SemanticMatching:匹配; Text2SQL:文字描述轉SQL;TextClassification:文字分類; SentimentClassification:情感分析; zuowen:寫作文; adtext:寫文案; couplet:對對聯; novel:寫小說; cloze:文字補全; Misc:其它任務。

typeId

模型型別 int 1 1

是

通用:

1 ERNIE 3.0 Zeus 通用

2 ERNIE 3.0 Zeus instruct模型

同義改寫

1 ERNIE 3.0 Zeus 同義改寫精調模型

寫作文:

1 ERNIE 3.0 Zeus 記敘文增強包

2 ERNIE 3.0 Zeus 議論文增強包

3 ERNIE 3.0 Zeus 小學作文增強包

寫文案:

1 ERNIE 3.0 百億 社交短文案精調模型

2 ERNIE 3.0 Zeus 商品行銷文案增強包

寫摘要:

1 ERNIE 3.0 Zeus 寫摘要

2 ERNIE 3.0 Zeus 寫標題

3 ERNIE 3.0 百億 寫標題

對對聯:

1 ERNIE 3.0 Zeus 對對聯

2 ERNIE 3.0 百億 對對聯

自由問答:

1 ERNIE 3.0 Zeus 自由問答增強包

2 ERNIE 3.0 百億 自由問答

3 ERNIE 3.0 Zeus instruct模型

寫小說

1 ERNIE 3.0百億 寫小說精調模型

補全文字

1 ERNIE 3.0 Zeus 詞補全增強包

2 ERNIE 3.0 Zeus 句補全增強包

3 ERNIE 3.0 Zeus 段落補全增強包

penalty_text

懲罰文字 string 空

否

模型會懲罰該字串中的token。通過設定該值,可以減少某些冗餘與異常字元的生成。

choice_text

候選文字 string 空

否

模型只能生成該字串中的token的組合。通過設定該值,可以對某些抽取式任務進行定向調優。

is_unidirectional

單雙向控制開關 int 0

0或1

否

0表示模型為雙向生成,1表示模型為單向生成。建議續寫與few-shot等通用場景建議採用單向生成方式,而完型填空等任務相關場景建議採用雙向生成方式。

min_dec_penalty_text

最小懲罰樣本 string 空

否

與最小生成長度搭配使用,可以在min_dec_len步前不讓模型生成該字串中的tokens。

logits_bias

遮蔽懲罰 float -10000

[1, 1000]

否

配合penalty_text使用,對給定的penalty_text中的token增加一個logits_bias,可以通過設定該值遮蔽某些token生成的概率。

mask_type

生成粒度 string word

可選引數為word, sentence, paragraph

否

設定該值可以控制模型生成粒度。

這裡需要注意的是,雖然引數支援async非同步,但那不是指請求的非同步方式返回,換句話說,文心模型返回還是需要等待的,並不是ChatGPT那種流式返回模式。

文心一言API呼叫

文心一言SDK的功能有限,也不支援非同步請求呼叫,如果需要客製化化或者使用別的語言請求文心一言,需要提前發起Http請求獲取token,這裡我們使用非同步請求庫httpx:

pip3 install httpx

新增獲取token邏輯:

class Winxin:

def chat(self,text):

input_dict = {

"text": f"問題:{text}\n回答:",

"seq_len": 512,

"topp": 0.5,

"penalty_score": 1.2,

"min_dec_len": 2,

"min_dec_penalty_text": "。?:![<S>]",

"is_unidirectional": 0,

"task_prompt": "qa",

"mask_type": "paragraph"

}

rst = FreeQA.create(**input_dict)

print(rst)

async def get_token(self):

headers = {"Content-Type":"application/x-www-form-urlencoded"}

async with httpx.AsyncClient() as client:

resp = await client.post(f"https://wenxin.baidu.com/moduleApi/portal/api/oauth/token?grant_type=client_credentials&client_id={wenxin_api.ak}&client_secret={wenxin_api.sk}",headers=headers)

result = resp.json()

print(result)

非同步呼叫文心一言介面的token:

if __name__ == '__main__':

wx = Winxin()

asyncio.run(wx.get_token())

程式返回:

{'code': 0, 'msg': 'success', 'data': '24.3f6a63545345ae6588ea86a353.86400000.1679123673218.92a99f8955c6f9ab2c438a5f31b5d73b-173001'}

這裡返回的資料的data就是token,有效期是一天,吐槽一下,居然沒有refreshtoken,也就是說過期了還得重新去請求,不能做到無感知換取。

隨後請求介面換取taskid:

async def get_task(self,token,text):

url = "https://wenxin.baidu.com/moduleApi/portal/api/rest/1.0/ernie/3.0.25/zeus"

data = {"async": 1, "typeId": 1, "seq_len": 512, "min_dec_len": 2, "topp": 0.8, "task_prompt": "qa", "penalty_score": 1.2, "is_unidirectional": 0, "min_dec_penalty_text": "。?:![<S>]", "mask_type": "word","text":text}

headers = { "Content-Type": "application/x-www-form-urlencoded" }

params = { "access_token": token }

async with httpx.AsyncClient() as client:

result = client.post(url, headers=headers, params=params, data=data)

result = result.json()

print(result)

返回:

{

"code":0,

"msg":"success",

"data":{

"taskId": 1229202,

"requestId":"7fad28872989e274914ee1687b8f2a13"

}

}

最後請求結果:

async def get_res(self,taskid,token):

url = "https://wenxin.baidu.com/moduleApi/portal/api/rest/1.0/ernie/v1/getResult"

access_token = token

task_id = taskid

headers = { "Content-Type": "application/x-www-form-urlencoded" }

params = { "access_token": access_token }

data = { "taskId": task_id }

async with httpx.AsyncClient() as client:

response = client.post(url, headers=headers, params=params, data=data)

print(response.text)

結果和SDK請求方式一致:

{

"code": 0,

"msg": "success",

"data": {

"result": "因為我們有個好心情",

"createTime": "2023-03-16 18:09:40",

"requestId": "71a6efb46acbd64394374f44579a01eb",

"text": "天為什麼這麼藍",

"taskId": 1000000,

"status": 1 # 0表示生成中,1表示生成成功

}

}

文心一格文字生成影象

ERNIE-ViLG AI作畫大模型:文心ERNIE-ViLG2.0 是基於使用者輸入文字、或文字加圖片生成影象及影象編輯功能的技術,主要為使用者提供跨模態的文字生成影象的大模型技術服務。

文心一格和文心一言是共用appkey和appsecret的,新增影象生成邏輯:

class Winxin:

def draw(self,text):

num = 1

input_dict = {

"text": "國畫,工筆畫,女俠,正臉",

"style": "工筆畫",

"resolution":"1024*1024",

"num": num

}

rst = TextToImage.create(**input_dict)

print(rst)

程式返回:

{

"imgUrls":[

"https://wenxin.baidu.com/younger/file/ERNIE-ViLG/61157afdaef4f0dfef0d5e51459160fbex"

]

}

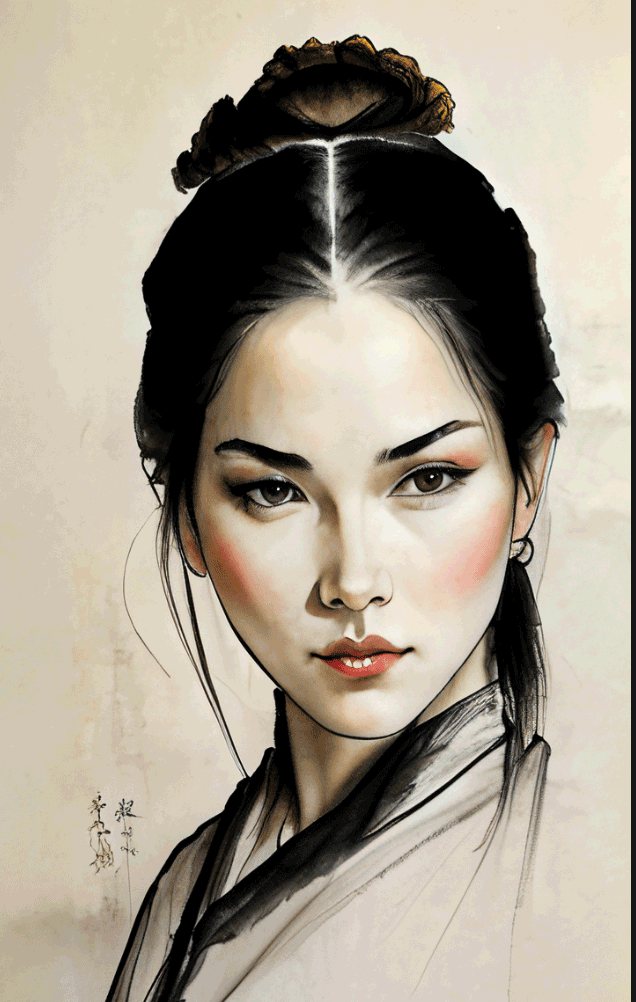

效果:

對比基於Stable-Diffusion演演算法的Lora模型:

大家豐儉由己,各取所需。

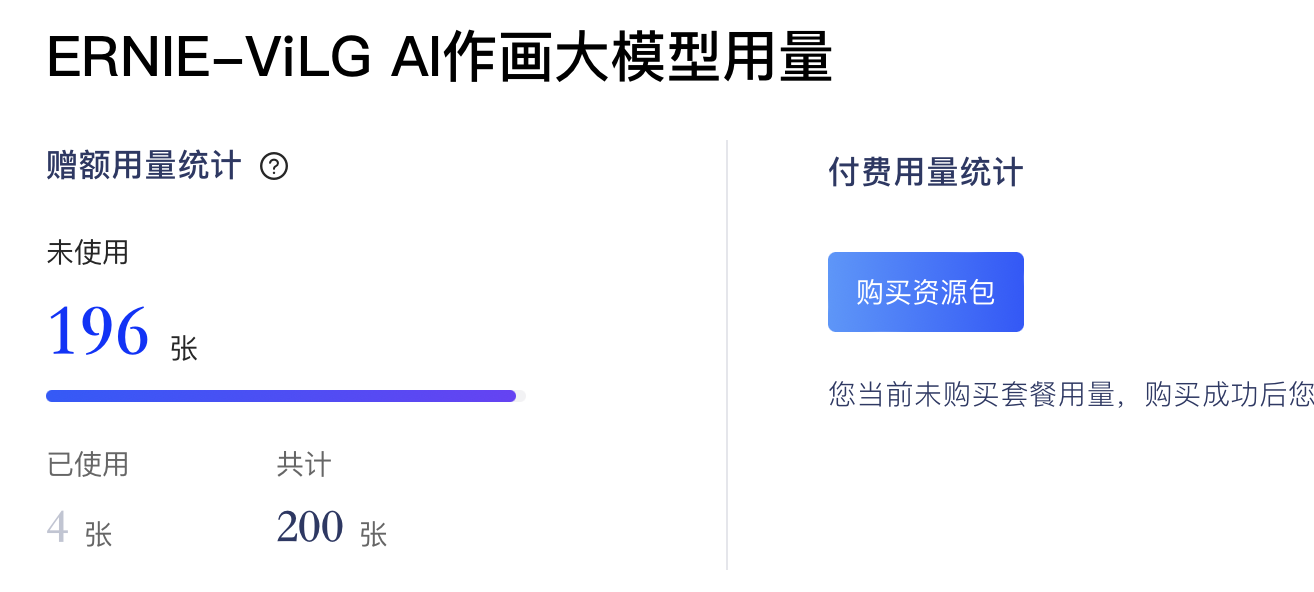

需要注意的是,該產品線並不是免費的:

免費送200張,想繼續玩就得充值,不愧是百度。話說免費的Stable-Diffusion不香嗎?

結語

產品力而言,ChatGPT珠玉在前,文心一言還有很長的路需要走,用三國時期徐庶自比孔明的話來講:「駑馬焉敢並麒麟,寒鴉豈能配鳳凰」。但是,也沒必要一片撻伐之聲,俄國著名作家契訶夫曾經說,「大狗叫,小狗也要叫」,ChatGPT雖然一座遙不可及的高峰,但是其他公司也無須放棄人工智慧領域的研究,畢竟作為最老牌的中文搜尋引擎,百度浸潤幾十年的中文處理能力,還是無人能出其右的。