論文翻譯:2022_騰訊DNS 1th TEA-PSE: Tencent-ethereal-audio-lab personalized speech enhancement system for I

論文地址:TEA-PSE: 用於ICASSP 2022 DNS挑戰賽的Tencent-ethereal-audio-lab 個性化語音增強系統

論文程式碼:

參照格式:Ju Y, Rao W, Yan X, et al. TEA-PSE: Tencent-ethereal-audio-lab personalized speech enhancement system for ICASSP 2022 DNS CHALLENGE[C]//ICASSP 2022-2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2022: 9291-9295.

摘要

本文介紹了 Tencent Ethereal Audio Lab 提交給ICASSP 2022深度噪聲抑制(DNS)挑戰賽第2賽道的個性化語音增強(TEAPSE)系統。我們的系統結合了雙級網路,這是一個卓越的實時語音增強框架和ECAPA-TDNN speaker embedding 網路,實現了最先進的說話人驗證效能。雙級網路旨在將原始語音增強問題解耦為多個更簡單的子問題。具體而言,

- 在階段1,只估計目標語音的幅度,並將其與噪聲相位合併,得到粗略的複頻譜估計。

- 在階段2,輔助網路作為後處理模組,進一步抑制殘餘噪聲和干擾語音,並有效地修改相位資訊。

利用非對稱損失函數懲罰過度抑制,保留了更多的目標語音,有利於語音識別效能和主觀聽覺。我們的系統在挑戰盲測試集的總體音訊質量(OVRL) MOS達到3.97,單詞精度(WAcc)達到0.69,比DNS基線高出0.57 OVRL,在軌道2中排名第一。

指標術語:個性化語音增強,兩級網路,ECAPA-TDNN,實時

1 引言

個性化語音增強(PSE),又稱說話人提取,是利用目標說話人的登記語音,從複雜的多說話人噪聲和混響觀測訊號中提取目標說話人的語音。當系統需要對特定的目標說話者作出響應時,PSE非常有用。它可以廣泛應用於實時通訊(RTC)、說話人分類、自動語音識別等領域。

最新的ICASSP 2022 DNS挑戰賽[1]旨在推動全頻段實時語音增強任務。除了感知語音質量要求外,DNS還將單詞精度(WAcc)作為後端ASR應用的重要評估指標。針對實時全頻帶語音通訊,挑戰非個性化DNS(軌道1)和個性化DNS(軌道2)有兩個軌道,本文主要關注軌道2。與非實時PSE方法不同[2,3,4,5,6,7],實時PSE方法需要具體考慮模型大小、推理時間和有限的未來資訊的要求。近年來,許多實時PSE方法被提出,如Voicefilter-lite [8], pDCCRN [9], personalized PercepNet[10]等,帶來了優越的效能。然而,實際應用環境是複雜多變的。演演算法不僅需要處理噪音和混響,還必須考慮干擾說話人。儘管有了說話人資訊的幫助,但單個實時PSE模型的能力仍然有限,噪聲和干擾抑制還不完善。近年來,多階段方法被引入並在語音增強中取得了巨大成功[11,12]。在多階段方法中,每個階段模型只關注一個任務,通常由一個顯式損失函數指導。對前一階段模型進行預處理後,後一階段模型的增強輸入更加清晰簡單,在自身任務上分配更準確的計算能力。

在[11]中,第一級網路用於估計帶噪語音幅值,第二級網路用於估計第一級輸出的剩餘實部和虛部。

spex++[13]中,首先將第一級網路的輸出傳送到說話人編碼器網路,得到另一個新的speaker embedding,然後將增強語音和兩個speaker embedding饋送到第二級網路,進一步抑制殘留噪聲和干擾語音。

受多階段方法成功的啟發,本文研究了該方法在個性化語音增強任務中的可行性。具體來說,在我們的方法中,第一階段是粗略估計目標語音的幅度,第二階段是進一步抑制殘留噪聲和干擾語音,並修改目標語音的相位資訊。我們還探討了功率壓縮(PC)[14]對PSE任務的影響。此外,考慮到挑戰中的ASR評估指標,我們的TEA-PSE提交系統特別採用了非對稱(Asym)損失[9],以緩解過度抑制可能導致更多語音識別錯誤的影響。我們的TEA-PSE提交系統最終在ICASSP 2022 DNS挑戰賽的盲測集上達到了4.19 SIG, 4.55 BAK, 3.97 OVRL和0.69 WAcc,在第二軌道中排名第一。

2 提出的TEA-PSE系統

本文提出的TEA-PSE系統主要由說話人編碼器和語音增強兩個模組組成。具體來說,我們採用ECAPA-TDNN網路[15]作為說話人編碼器,並研究了一種用於語音增強的雙級網路。我們首先訓練說話人編碼器。訓練好後,說話人編碼器網路將被凍結,並用於提取語音增強網路的speaker embedding,以進行PSE任務。

2.1 說話人編碼器:ECAPA-TDNN

在PSE系統中,speaker embedding用於識別觀測訊號中的目標說話人,以將目標語音與所有干擾聲音和噪聲區分開來。在提出的TEA-PSE系統中,我們採用ECAPA-TDNN作為我們的說話人編碼器網路。ECAPA-TDNN被稱為最先進的speaker embedding網路之一,這要歸功於1D Res2Net[16]上具有擠壓激勵模組[17]的出色設計。在我們的ECAPA-TDNN中,我們在折積幀層中採用2048個通道,在通道和上下文相關的統計池層中採用256個維度。SEblock中的瓶頸尺寸設定為128。最後得到256-dim的speaker embedding。關於ECAPA-TDNN的更多細節可以在[15]中找到。

2.2 語音增強:兩階段網路

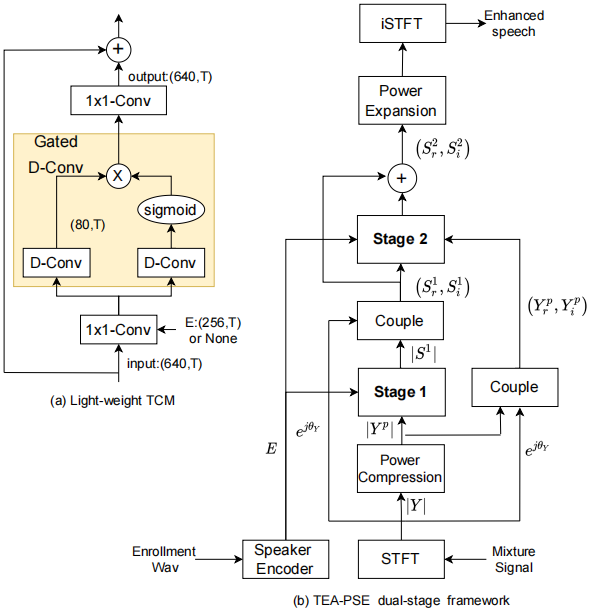

圖1所示。(a):light-weight TCM。(b):用於個性化語音增強的TEA-PSE雙階段框架。

受多級網路[11,12]在語音增強方面成功的啟發,我們在時頻域採用雙級網路進行PSE任務。在多階段網路中,每個階段只關注一個任務,以降低學習複雜度,提高模型的收斂速度。此外,後一階段的輸入被前一階段預先加強,這有利於明確每個階段的學習目標。如圖1(b)所示,在階段1中,我們將觀測訊號的幅值作為輸入,目標幅值作為訓練目標。該階段的目的是粗糙地抑制非自然噪聲成分和干擾語音。在階段1 增強幅度後,我們將其與噪聲相位耦合在一起,並將其轉換為實數譜和虛數譜作為階段2的輸入。我們還將觀測到的噪聲復譜作為第二階段的輸入,進一步去除剩餘噪聲和干擾語音,確定目標語音的相位資訊。階段2的輸入輸出之間採用殘差連線,避免梯度消失。簡單地說,這個過程如下

$$公式1:\mathbf{E}=\mathcal{F}_{s p k}(\operatorname{fbank}(|\mathbf{A}|) ; \mathbf{\Phi}_{s p k})$$

$$公式2:|\mathbf{S}^1|=\mathcal{F}_1(|\mathbf{Y}^p|, \mathbf{E} ; \mathbf{\Phi}_1)$$

$$公式3:(\mathbf{S}_r^2, \mathbf{S}_i^2)=(\mathbf{S}_r^1, \mathbf{S}_i^1)+\mathcal{F}_2(\mathbf{S}_r^1, \mathbf{S}_i^1, \mathbf{Y}_r^p, \mathbf{Y}_i^p, \mathbf{E} ; \mathbf{\Phi}_2)$$

其中A為時域登記訊號頻譜,E為提取出來的說話人 embedding。下標$r$和$i$分別表示複數譜的實部和虛部。$Y^p$為壓縮後的觀測頻譜,$p$為壓縮因子。$S^1$和$S^2$分別為階段1和階段2的增強複數譜。需要注意的是$S_r^1=R(|S^1|e^{j\theta Y})$和$S_i^1=R(|S^1|e^{j\theta Y})$。階段1、階段2和說話人編碼器分別定義為$F_1$、$F_2$、$F_{spk}$,引數集分別為$\Phi_1$、$\Phi _2$、$\Phi _{spk}$。

階段1和階段2的網路拓撲結構類似[11,18],包括門控折積編碼器、解碼器和堆疊時序折積模組(稱為TCMs)[18]。特別是階段1網路只有一個解碼器來估計幅值,而階段2網路有兩個解碼器分別估計實部和虛部。關於說話人embedding到增強網路的融合,我們只在圖1(a)中每個TCM組的第一個TCM處,根據[5],將隱藏特徵和說話人embedding沿通道軸進行拼接。該演演算法能有效、漸進地將說話人資訊與隱藏特徵相結合。

2.2.1 損失函數

對於網路的目標函數,我們首先應用尺度不變訊雜比(SI-SNR)[19]損失,這是一個時域損失函數

$$公式4:\left\{\begin{array}{l}

\mathbf{s}_{\mathrm{target}}=\frac{\langle\hat{\mathbf{s}}, \mathbf{s}\rangle \mathbf{s}}{\|\mathbf{s}\|^2} \\

\mathbf{e}_{\mathrm{noise}}=\hat{\mathbf{s}}-\mathbf{s}_{\mathrm{target}} \\

\mathcal{L}_{\text {si-snr }}=10 \log _{10} \frac{\left\|\mathbf{s}_{\text {target }}\right\|^2}{\left\|\mathbf{e}_{\text {noise }}\right\|^2}

\end{array}\right.$$

式中,$\hat{s} \in R^{1*T}$和$s \in R^{1*T}$分別為估計和原始純淨語音,$||s||^2=<s,s>$為訊號功率。

語音過度抑制是神經去噪器[20]中的一個普遍問題。為了解決語音過度抑制問題,我們在損失函數的幅度部分使用了非對稱損失[9],目的是懲罰目標說話人的聲音被隨意刪除的T-F bins。

$$公式5:\begin{aligned}

& h(x)= \begin{cases}0, & \text { if } x \leq 0, \\

x, & \text { if } x>0,\end{cases} \\

& \mathcal{L}_{\text {asym }}=\frac{1}{T} \sum_t^T \sum_f^F\left|h\left(|S(t, f)|^p-|\hat{S}(t, f)|^p\right)\right|^2

\end{aligned}$$

下面的策略應用於訓練兩階段網路。首先,我們只訓練帶有混合loss的階段1網路

$$公式6:\mathcal{L}_{\mathrm{mag}}=\left.\frac{1}{T} \sum_t^T \sum_f^F|| S(t, f)\right|^p-\left.|\hat{S}(t, f)|^p\right|^2$$

$$公式7:L_1=L_{mag}+L_{si-snr}+L_{asym}$$

然後,載入階段1的預訓練模型,凍結引數,對階段2的網路進行優化

$$公式8:\mathcal{L}_{\mathrm{RI}}=\frac{1}{T} \sum_t^T \sum_f^F \|\left. S(t, f)\right|^p e^{j \theta_{S(t, f)}}-\left.|\hat{S}(t, f)|^p e^{j \theta_{\hat{S}(t, f)}}\right|^2$$

$$公式9:L_2=L_{RI}+L_{mag}+L_{si-snr}+L_{asym}$$

其中L1和L2表示階段1和階段2的損失函數,p是一個譜壓縮因子,設為0.5,運運算元$\theta $計算一個複數的引數,在[21]中使用。

3 實驗步驟

3.1 資料集

DNS挑戰賽向參與者釋出了48kHz的培訓和開發集。訓練集包括大約750小時的乾淨演講和181小時的噪音剪輯。具體來說,清潔語音資料集包括六種語言,即英語、法語、德語、義大利語、俄語和西班牙語。英語部分包括閱讀語音和歌唱語音,其他語言只有閱讀語音。演講資料來自3230位演講者。噪聲資料主要來自Audioset[22]、Freesound和DEMAND[23]。

如第2節所述,我們提出的TEA-PSE系統包括兩個模組:說話者編碼器和語音增強。這兩個模組的訓練資料不一樣。對於說話人編碼器,我們使用了VoxCeleb2[24]開發集,其中包含來自5994個不同說話人的超過100萬個話語。為了訓練語音增強網路,我們使用了675小時的乾淨語音資料,以及144小時的噪聲資料,兩者都是從DNS資料集中提取的。開發集從DNS資料集中選取75小時的乾淨語音資料,從DNS資料集中選取20小時的噪聲資料。我們還基於影象方法生成了10萬個單通道房間脈衝響應(RIRs)。rrr的RT60範圍為0.1s ~ 0.6s。房間面積從3 3 3 m3到8 8 4 m3不等。聲源與麥克風的距離為0.3m ~ 6.0m。訓練和發展集分別包含85,000和10,000個rir。應該提到的是,訓練集和發展集之間沒有重疊。

本文提出的TEA-PSE系統的測試資料可分為三個部分。模擬集旨在測量模型在外設說話人上的效能。我們使用KING-ASR-215資料集作為源語音,來自DNS噪聲集的17小時資料作為源噪聲,加上5000個rir,生成2000個noisyclean對作為模擬集,包含200個說話人。對於每一對噪聲清除對,新增一個SIR範圍為[- 5,20]dB的隨機干擾說話人,並新增一個訊雜比範圍為[- 5,20]dB的隨機噪聲。第二部分是挑戰賽主辦方提供的官方開發集。它有1443個片段,都是用桌上型電腦和筆記型電腦收集的。第三部分是挑戰組織者提供的官方盲測集,由859個片段組成,這些片段是通過桌上型電腦/筆記型電腦和移動裝置收集的。

3.2 說話人編碼器網路的訓練設定

在ECAPA-TDNN說話人編碼器網路的訓練過程中,我們採用了以下資料增強策略

- 波形丟失: 原始波形的一些隨機塊被替換為零。

- SpecAug: 對輸入頻譜[25]進行時間和頻率遮蔽。

- 加性噪聲: 將MUSAN[26]中的三種噪聲新增到VoxCeleb 2的原始語音中。

- 混響: 混響與VoxCeleb 2中的原始演講混淆,rir來自[27]。

- 速度攝動: 不改變螺距的速度攝動(0.9,1.1)。

- 附加噪聲&混響: 同時加入附加噪聲和混響。

提取一組80dim FBank特徵作為輸入,這些特徵的視窗大小為25ms,視窗移位為10ms。在訓練過程中,批次大小設定為256。使用三角2策略[28],模型訓練的學習率在1e-8和1e-3之間變化。訓練期間的優化者是Adam。AAM-softmax的超引數scale設定為30,margin設定為0.3。為了防止過度擬合,我們對模型中的所有權重應用了2e-4的權重衰減。

3.2 語音增強網路的訓練設定

我們的訓練資料是實時生成的,取樣率為48kHz,每批分割為4s塊,訊雜比範圍為[- 5,20]dB, SIR範圍為[- 5,20]dB。具體來說,我們採用以下策略進行資料增強

- 混響:為了模擬遠場場景,隨機選取50%的乾淨語音資料與rir進行折積。

- 下取樣&上取樣:我們選擇20%的訓練資料隨機下取樣到[12,44]kHz,然後上取樣到48kHz。

- 不同干擾場景:在新增干擾說話人時,20%的訓練資料只包含一個干擾說話人,30%的訓練資料包含一個干擾說話人和一種噪聲,30%的訓練資料只包含一種噪聲,剩下20%的訓練資料包含兩種噪聲。

我們使用20ms幀長和10ms幀移,並使用Hanning視窗進行前端處理。STFT點的數量為1024個,導致513個昏暗的光譜特徵。該模型由Adam進行優化。這兩個階段是獨立訓練的。首先訓練階段1的模型,然後將其凍結,作為第二階段模型的預訓練模型。初始學習率為0.001,如果連續兩個epoch的驗證損失不再減少,則學習率將減半。批大小設定為20。與[11]類似,對於兩級網路,編碼器和解碼器中折積層的核大小和步長分別沿頻率軸和時間軸為(3,2)和(2,1)。對於所有折積層,通道數量保持80。每個網路中有6個編碼器和解碼器。在tcm中,壓縮後的特徵大小設定為1x1-Conv後的80。TCMs總數為4個,核大小為3,膨脹率分別為{1,2,5,9}。近年來,功率壓縮譜在語音增強任務中被證明是有效的[12,14]。因此,我們在饋入網路之前對光譜幅度進行了壓縮。其中,壓縮引數β設為0.5。

4. 實驗結果與分析

4.1. 模擬集的效能比較

我們進行了燒蝕實驗,以證明每個提出的模組的有效性,包括a)單級,b)單級PC, c)單級PC和Asym, d)雙級,e)雙級PC, f)雙級PC和Asym。我們還將所提出的模型與voicfilter [3], pDCCRN[9]和GateCRN[29]進行了比較。我們使用上面描述的相同資料實現和訓練這些模型。voicfilter和GateCRN屬於真實域,只對震級進行建模,而pDCCRN是DCCRN[30]的個性化版本,工作在複雜域,同時對震級和相位進行建模。所有實域模型用L1優化,所有複雜域模型用L2優化。對於開發集和盲測試集,由組織者提供DNS基線的結果。

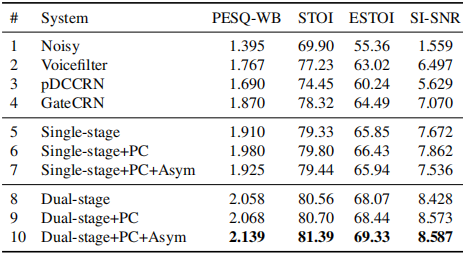

表1。模擬集的效能比較。PESQWB表示16kHz音訊檔的PESQ。

噪聲表示不加語音增強的噪聲語音。單階段表示單一的第一階段模型。

雙級表示雙級網路。PC代表功率壓縮。Asym代表不對稱損失。

根據表1的結果,可以得出以下結論。

1. 首先,我們與PC和Asym的雙級網路在所有指標上都超過了其他比較方法。PC + Asym雙級網路在PESQ-WB、STOI、ESTOI和SI-SNR上的平均效能分別優於voicfilter 0.372、4.16%、6.31%和2.09。其次,對於第一階段,引入第二階段時效能得到了提高。一些令人不快的殘餘噪聲成分和不需要的干擾說話人的聲音可以進一步抑制。第二階段網路還能修復目標語音的相位資訊,在PESQ-WB、STOI、ESTOI和SI-SNR方面的平均增益分別為0.214、1.95%、3.39%和1.051。

2. 功率壓縮採用功率壓縮時,效能略有提高。例如,在階段1中,壓縮頻譜範圍後,對PESQ-WB、STOI、ESTOI和SI-SNR分別有0.07、0.47%、0.58%、0.19個改進。這是因為功率壓縮可以降低頻譜的動態範圍,這提高了低能量區域的意義與更多的資訊語音成分。

3.對於單級模型,非對稱損失將導致PESQ-WB、STOI、ESTOI和SI-SNR分別下降0.055、0.36%、0.49和0.326。然而,對於雙級模型,如果使用不對稱損失,PESQ-WB、STOI、ESTOI和SI-SNR分別獲得0.071、0.69%、0.89%和0.014的改善。可能的原因是為了保留更多的語音而提出了不對稱損失,可能會導致噪聲抑制能力的輕微退化。因此,單級非對稱損失模型的效能略有下降。但是,雙級處理後的語音失真比單級處理後的語音失真更嚴重,非對稱損失有助於雙級模型提高語音質量,這可以從表2中的System 6-11中得到證實。

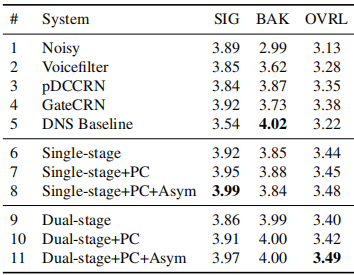

表2。DNSMOS P.835在官方開發集上的效能比較。

DNS challenge使用DNSMOS P.835來測量語音質量(SIG)、背景噪聲質量(BAK)和整體音訊質量(OVRL)。

4.2. 在正式開發和盲測試集上的效能比較

表2給出了DNSMOS P.835[31]在官方開發集上的主觀結果。可以看出,所提出的PC + Asym雙級網路優於OVRL上的其他模型。當使用stage 2網路時,SIG會降低,因為對目標語音引入了更多的失真,而BAK會增加,因為去除了更多的噪聲和干擾語音。此外,如果我們不使用非對稱損失來懲罰過抑制,雙級模型的OVRL略低於單級模型。

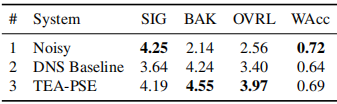

表3。MOS與ITU-T P.835框架和WAcc結果在官方盲測試集

首先,表3比較了MOS與ITU-T P.835框架[32]和WAcc在官方盲測試集上的結果。本文提出的TEA-PSE系統(Dual-stage+PC+Asym)的效能明顯優於DNS基線系統,這與表2的結論一致。此外,與有噪聲語音相比,提交系統的WAcc略有降低。這是合理的,因為該模型對提取的語音進行了輕微的失真,可能會導致與ASR引擎的訓練資料不匹配。

4.3. 演演算法延遲和推理時間

在提交系統中,視窗大小T為20ms,步幅時間Ts為10ms。演演算法時延Td = T + Ts = 30ms,滿足挑戰的時延要求。在提交系統中不使用將來的資訊。此外,我們的兩階段框架的可訓練引數數量為781萬個。在2.4G Hz的Intel(R) Xeon(R) CPU E5-2678 v3上,提交系統的平均每幀處理時間為9.66ms。

5. 結論

本文介紹了我們提交到ICASSP 2022 DNS挑戰賽個性化SE賽道。該系統將ECAPATDNN說話人編碼器網路和兩級語音增強網路相結合,實現個性化語音增強。我們專門研究了雙級網路的有效性,將其與單級網路進行了比較,並探討了功率壓縮和不對稱損耗對系統的影響。該系統在同行業中達到了一流水平。

6 參考文獻

[1] H. Dubey, V. Gopal, R. Cutler, A. Aazami, S. Matusevych, S. Braun, S. E. Eskimez, M. Thakker, T. Yoshioka, H. Gamper, et al., ICASSP 2022 deep noise suppression challenge, .

[2] K. Zmol ıkov a, M. Delcroix, K. Kinoshita, T. Ochiai, T. Nakatani, L. Burget, and J. Cernock`y, SpeakerBeam: Speaker Aware Neural Network for Target Speaker Extraction in Speech Mixtures, IEEE Journal of Selected Topics in Signal Processing, vol. 13, no. 4, pp. 800 814, 2019.

[3] Q. Wang, H. Muckenhirn, K. Wilson, P. Sridhar, Z. Wu, J. R. Hershey, R. A. Saurous, R. J. Weiss, Y. Jia, and I. L. Moreno, VoiceFilter: Targeted Voice Separation by SpeakerConditioned Spectrogram Masking, in Interspeech, 2019, pp. 2728 2732.

[4] C. Xu, W. Rao, E. S. Chng, and H. Li, SpEx: MultiScale Time Domain Speaker Extraction Network, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 28, pp. 1370 1384, 2020.

[5] M. Ge, C. Xu, L. Wang, E. S. Chng, J. Dang, and H. Li, SpEx+: A Complete Time Domain Speaker Extraction Network, in Interspeech, 2020, pp. 1406 1410.

[6] C. Deng, S. Ma, Y. Sha, Y. Zhang, H. Zhang, H. Song, and Wang F, Robust Speaker Extraction Network Based on Iterative Refined Adaptation, in Interspeech, 2021, pp. 3530 3534.

[7] Z. Zhang, B. He, and Z. Zhang, X-TaSNet: Robust and Accurate Time-Domain Speaker Extraction Network, in Interspeech, 2020, pp. 1421 1425.

[8] Q. Wang, I. L. Moreno, M. Saglam, K. Wilson, A. Chiao, R. Liu, Y. He, W. Li, J. Pelecanos, M. Nika, and A. Gruenstein, VoiceFilter-Lite: Streaming Targeted Voice Separation for On-Device Speech Recognition, in Interspeech, 2020, pp. 2677 2681.

[9] S. E. Eskimez, T. Yoshioka, H. Wang, X. Wang, Z. Chen, and X. Huang, Personalized speech enhancement: New models and comprehensive evaluation, arXiv preprint arXiv:2110.09625, 2021.

[10] R. Giri, S. Venkataramani, J. Valin, U. Isik, and A. Krishnaswamy, Personalized PercepNet: Real-Time, LowComplexity Target Voice Separation and Enhancement, in Interspeech, 2021, pp. 1124 1128.

[11] A. Li, W. Liu, X. Luo, C. Zheng, and X. Li, ICASSP 2021 deep noise suppression challenge: Decoupling magnitude and phase optimization with a two-stage deep network, in ICASSP. IEEE, 2021, pp. 6628 6632.

[12] A. Li, W. Liu, X. Luo, G. Yu, C. Zheng, and X. Li, A Simultaneous Denoising and Dereverberation Framework with Target Decoupling, in Interspeech, 2021, pp. 2801 2805.

[13] M. Ge, C. Xu, L. Wang, E. S. Chng, J. Dang, and H. Li, Multistage speaker extraction with utterance and frame-level reference signals, in ICASSP, 2021, pp. 6109 6113.

[14] A. Li, C. Zheng, R. Peng, and X. Li, On the importance of power compression and phase estimation in monaural speech dereverberation, JASA Express Letters, vol. 1, no. 1, pp. 014802, 2021.

[15] B. Desplanques, J. Thienpondt, and K. Demuynck, ECAPATDNN: Emphasized Channel Attention, Propagation and Aggregation in TDNN Based Speaker Verification, in Interspeech, 2020, pp. 3830 3834.

[16] S. Gao, M. M. Cheng, K. Zhao, X. Y. Zhang, M. H. Yang, and P. HS Torr, Res2net: A new multi-scale backbone architecture, IEEE transactions on pattern analysis and machine intelligence, 2019.

[17] J. Hu, L. Shen, and G. Sun, Squeeze-and-excitation networks, in the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2018, pp. 7132 7141.

[18] S. Bai, J Z. Kolter, and V. Koltun, An empirical evaluation of generic convolutional and recurrent networks for sequence modeling, arXiv preprint arXiv:1803.01271, 2018.

[19] Y. Luo and N. Mesgarani, Conv-tasnet: Surpassing ideal time frequency magnitude masking for speech separation, IEEE/ACM transactions on Audio, Speech, and Language Processing, vol. 27, no. 8, pp. 1256 1266, 2019.

[20] S. Lv, Y. Hu, S. Zhang, and L. Xie, DCCRN+: Channel-Wise Subband DCCRN with SNR Estimation for Speech Enhancement, in Interspeech, 2021, pp. 2816 2820.

[21] S. E. Eskimez, X. Wang, M. Tang, H. Yang, Z. Zhu, Z. Chen, H. Wang, and T. Yoshioka, Human Listening and Live Captioning: Multi-Task Training for Speech Enhancement, in Interspeech, 2021, pp. 2686 2690.

[22] J. F. Gemmeke, D. P. Ellis, D. Freedman, A. Jansen, W. Lawrence, R. C. Moore, M. Plakal, and M. Ritter, Audio set: An ontology and human-labeled dataset for audio events, in ICASSP. IEEE, 2017, pp. 776 780.

[23] J. Thiemann, N. Ito, and E. Vincent, The diverse environments multi-channel acoustic noise database (demand): A database of multichannel environmental noise recordings, in Meetings on Acoustics ICA. Acoustical Society of America, 2013, vol. 19, p. 035081.

[24] J. S. Chung, A. Nagrani, and A. Zisserman, VoxCeleb2: Deep Speaker Recognition, in Interspeech, 2018, pp. 1086 1090.

[25] D. S. Park, W. Chan, Y. Zhang, C. Chiu, B. Zoph, E. D. Cubuk, and Q. V. Le, SpecAugment: A Simple Data Augmentation Method for Automatic Speech Recognition, in Interspeech, 2019, pp. 2613 2617.

[26] D. Snyder, G. Chen, and D. Povey, Musan: A music, speech, and noise corpus, arXiv preprint arXiv:1510.08484, 2015.

[27] E. AP Habets, Room impulse response generator, Technische Universiteit Eindhoven, Tech. Rep, vol. 2, no. 2.4, pp. 1, 2006.

[28] L. N Smith, Cyclical learning rates for training neural networks, in IEEE Winter conference on Applications of Computer Vision (WACV). IEEE, 2017, pp. 464 472.

[29] K. Tan and D. L. Wang, Learning complex spectral mapping with gated convolutional recurrent networks for monaural speech enhancement, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 28, pp. 380 390, 2019.

[30] Y. Hu, Y. Liu, S. Lv, M. Xing, S. Zhang, Y. Fu, J. Wu, B. Zhang, and L. Xie, DCCRN: Deep Complex Convolution Recurrent Network for Phase-Aware Speech Enhancement, in Interspeech, 2020, pp. 2472 2476.

[31] C. K. Reddy, V. Gopal, and R. Cutler, DNSMOS P. 835: A non-intrusive perceptual objective speech quality metric to evaluate noise suppressors, arXiv preprint arXiv:2110.01763, 2021.

[32] B. Naderi and R. Cutler, Subjective evaluation of noise suppression algorithms in crowdsourcing, arXiv preprint arXiv:2010.13200, 2020.