【Redis 技術探索】「資料遷移實戰」手把手教你如何實現線上 + 離線模式進行遷移 Redis 資料實戰指南(scan模式遷移)

線上資料遷移方式

對於大多數場景下的Redis的資料遷移,還是比較推薦大家參考我之前的前兩篇文章。

-

【Redis 技術探索】「資料遷移實戰」手把手教你如何實現線上 + 離線模式進行遷移 Redis 資料實戰指南(線上同步資料)

-

【Redis 技術探索】「資料遷移實戰」手把手教你如何實現線上 + 離線模式進行遷移 Redis 資料實戰指南(離線同步資料)

scan模式線上資料遷移的場景和原因

但是還有一種常見是前兩篇文章無法實現的,就是當雲廠商出於種種考慮禁用了Redis的 psync 命令時,前述方案不可用。 對於這種情況可以使用redis-shake的scan模式來進行資料遷移。

scan模式的簡單原理

原理是呼叫scan命令來獲取 Redis 中的 key,然後使用 dump 命令獲取 key 的內容,最終使用 restore 命令恢復 key 至目的端。

scan模式的侷限性

- 如果某個 key 在遷移過程中一直存在,scan 模式能保證他一定被遷移

- 如果某個 key 在遷移過程中不是一直存在,scan 模式不保證其一定被遷移

- 如果某個 key 在遷移過程中被修改,scan 模式不保證修改能同步到對端

- 可見 scan 模式會有許多缺點,所以推薦 sync 模式,其次 restore 模式。

redis-shake 的 scan 模式來遷移資料案例

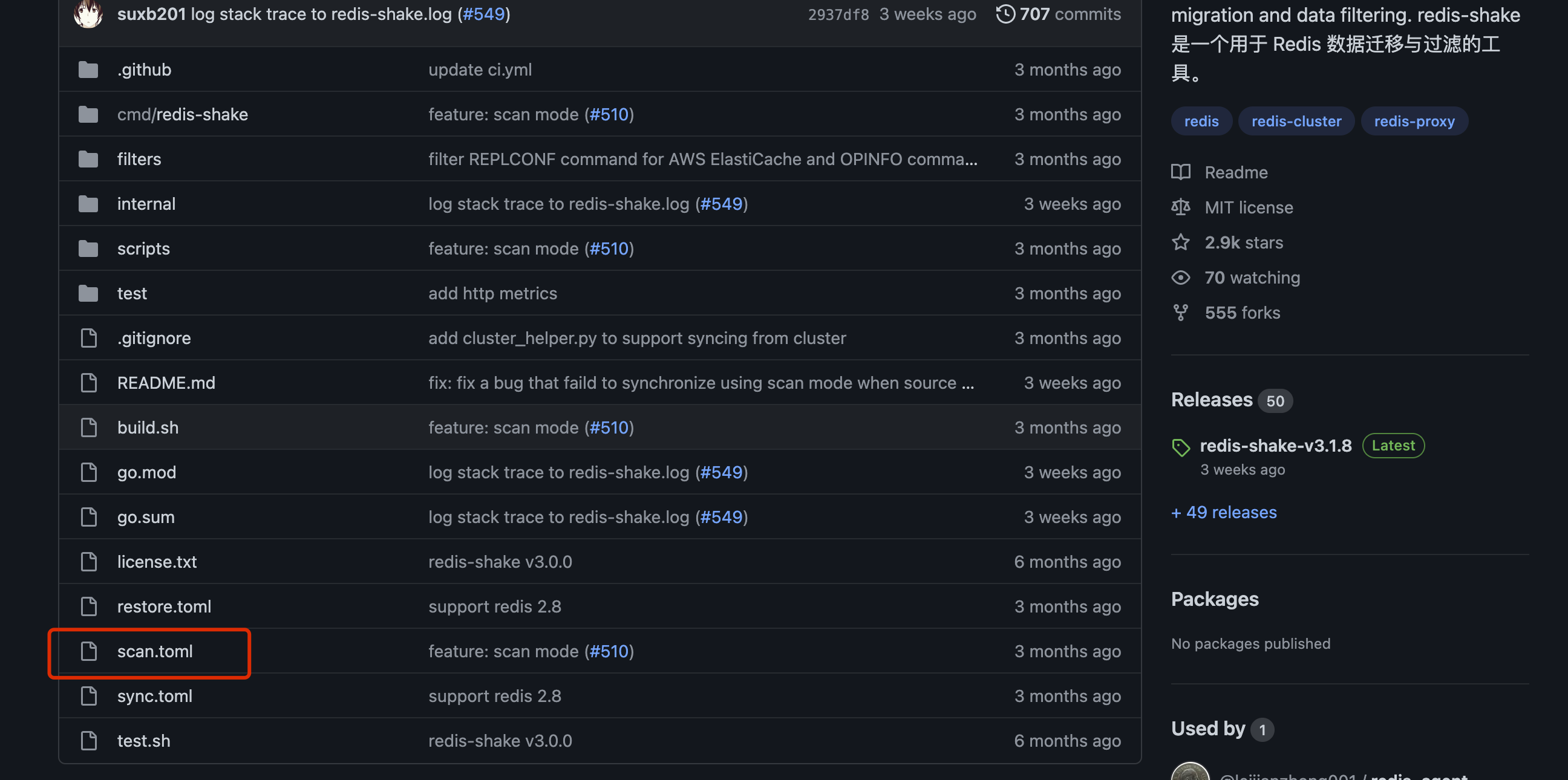

使用redis-shake的scan線上遷移操作,主要通過scan.toml檔案進行設定和執行遷移操作,如下圖所示。

範例資訊

單機範例1

- 地址:ip1

- 埠:6379

- 密碼:123456

單機範例2

- 地址:ip2

- 埠:6379

- 無密碼

叢集範例1

- 地址:

- 192.168.0.1:6379

- 192.168.0.2:6379

- 192.168.0.3:6379

- 192.168.0.4:6379

- 密碼:123456

叢集範例2

- 地址:

- 192.168.1.1:6379

- 192.168.1.2:6379

- 192.168.1.3:6379

- 192.168.1.4:6379

- 密碼:123456

源Redis單機範例(1)到目標Redis單機範例(2)

修改 scan.toml,改為如下設定:

type = "scan"

[source]

address = "ip1:6379"

password = "123456"

[target]

type = "standalone"

address = "ip2:6379"

password =

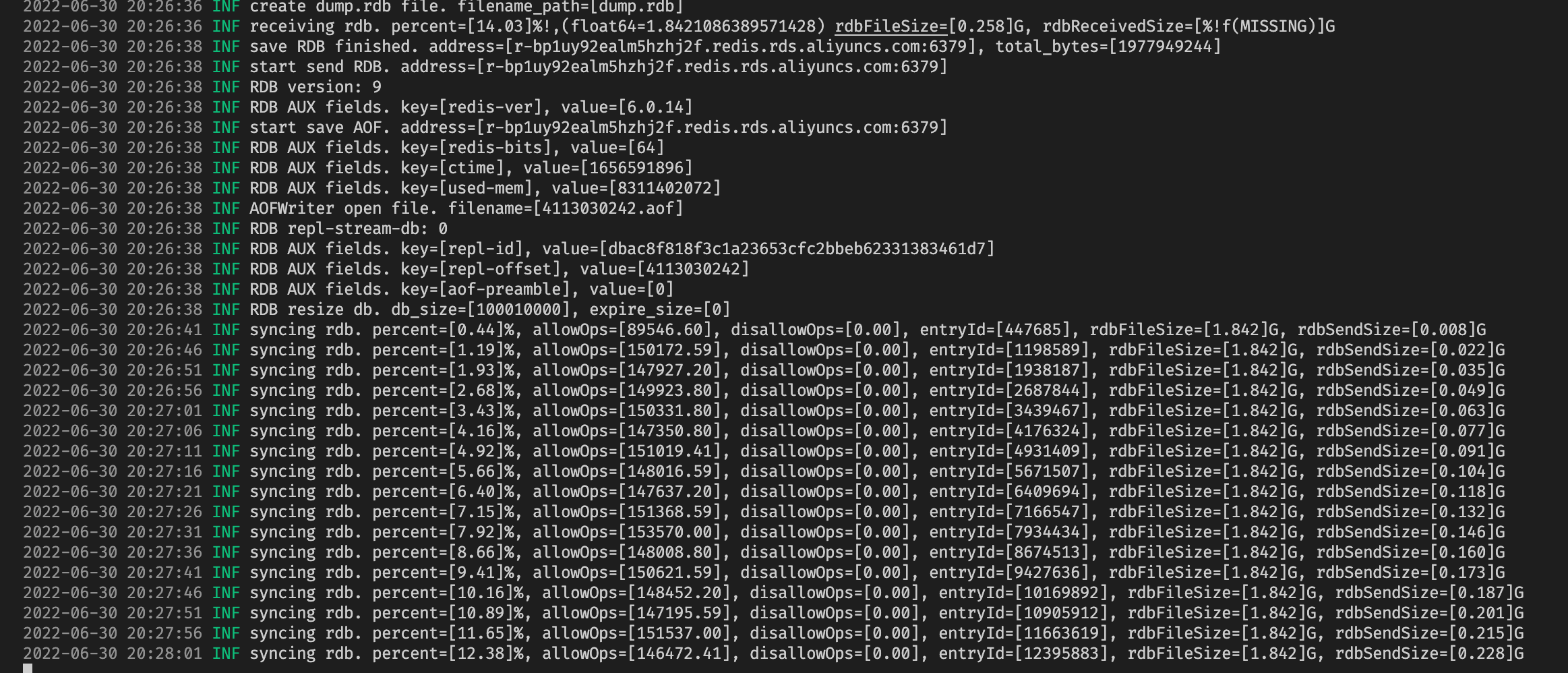

啟動 redis-shake:

./redis-shake scan.toml

源Redis單機範例(1)到目標Redis叢集範例(2)

修改 scan.toml,改為如下設定:

type = "scan"

[source]

address = "ip1:6379"

password = "r-aaaaa:xxxxx"

[target]

type = "cluster"

address = "192.168.0.1:6379" # 這裡寫叢集中的任意一個節點的地址即可,redis-shake可以根據這個ip地址,拉取叢集的其他節點的ip和埠資訊。

password = "123456"

啟動 redis-shake:

./redis-shake scan.toml

源Redis叢集範例(1)到目標Redis叢集範例(2)

方案1-手動起多個redis-shake,叢集1有四個節點:

- 192.168.0.1:6379

- 192.168.0.2:6379

- 192.168.0.3:6379

- 192.168.0.4:6379

把4個節點當成 4 個單機範例,參照前文部署 4 個 redis-shake 進行資料同步。

方案2-藉助 cluster_helper.py 啟動

指令碼cluster_helper.py方便啟動多個 redis-shake 從叢集遷移資料,效果等同於方法1。

注意

源端有多少個分片,cluster_helper.py 就會起多少個 redis-shake 程序,所以如果源端分片數較多的時候,需要評估當前機器是否可以承擔這麼多程序。

cluster_helper.py 異常退出的時候,可能沒有正常退出 redis-shake 程序,需要 ps aux | grep redis-shake 檢查。

每個 redis-shake 程序的執行紀錄檔記錄在 RedisShake/cluster_helper/data/xxxxx 中,反饋問題請提供相關紀錄檔。

依賴

Python 需要 python3.6 及以上版本,安裝 Python 依賴:

cd RedisShake/cluster_helper

pip3 install -r requirements.txt

設定

修改 scan.toml:

type = "scan"

[source]

address = "192.168.0.1:6379" # 叢集 C 中任意一個節點地址

password = "r-ccccc:xxxxx"

[target]

type = "cluster"

address = "192.168.1.1:6380" # 叢集 D 中任意一個節點地址

password = "r-ddddd:xxxxx"

執行

cd RedisShake/cluster_helper

python3 cluster_helper.py ../redis-shake ../scan.toml

- 引數 1 是 redis-shake 可執行程式的路徑

- 引數 2 是組態檔路徑

Redis哨兵模式

sentinel 節點,將哨兵拓撲當成普通的主從節點即可,參照單機到單機:A->B組態檔:

- source 的 address 寫源端的 master 或 slave 節點地址,推薦 slave 節點。

- target 的 address 些目的端的 master 節點地址。

本文來自部落格園,作者:洛神灬殤,轉載請註明原文連結:https://www.cnblogs.com/liboware/p/17039846.html,任何足夠先進的科技,都與魔法無異。