論文翻譯:2022_DNS_1th:Multi-scale temporal frequency convolutional network with axial attention for spee

論文地址:帶軸向注意的多尺度時域頻率折積網路語音增強

論文程式碼:https://github.com/echocatzh/MTFAA-Net

參照:Zhang G, Yu L, Wang C, et al. Multi-scale temporal frequency convolutional network with axial attention for speech enhancement[C]//ICASSP 2022-2022 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2022: 9122-9126.

摘要

語音質量經常因回聲、背景噪聲和混響而降低。在本文中,我們提出了一個由深度學習和訊號處理組成的系統,同時抑制回聲、噪聲和混響。對於深度學習,我們設計了一種新的語音密集預測backbone。在訊號處理中,利用線性回聲消除器作為條件資訊進行深度學習。為了提高語音密集預測(speech dense-prediction)主幹的效能,設計了麥克風和參考相位編碼器、多尺度時頻處理和流式軸向注意(streaming axial attention)等策略。該系統在ICASSP 2022年AEC和DNS挑戰賽(非個人賽道)中均排名第一。此外,該backbone還被擴充套件到多通道語音增強任務,並在ICASSP 2022 L3DAS22挑戰賽中獲得第二名。

索引術語:語音密集預測,語音增強,多尺度,軸向注意

1 引言

在語音通訊應用中,如語音互動或視訊會議系統,語音質量往往會受到回聲、背景噪聲和混響的影響。為了抑制聲學回聲,可以使用一種稱為線性聲學回聲消除器(Linear Acoustic Echo Canceller,LAEC)的音訊處理元件[1]。

然而,由於揚聲器的非線性失真和振動效應的存在,LAEC的效能嚴重下降。因此,通常需要一個基於訊號處理(signal processing,SP)[2]或深度神經網路(DNN)的殘餘回聲抑制器(RES)來進一步抑制聲回聲。基於DNN的RES方法比基於SP的[3]方法具有更好的效能。此外,DNN在去除背景噪聲和抑制混響[4]方面也取得了顯著的效果。

在這項工作中,我們提出了一個同時去噪,去混響和回聲消除系統。該系統是SP和DNN的組合。SP部分由基於廣義相關[5]的簡單時延補償器( time delay compensator,TDC)和基於雙回聲路徑模型[6]和帶PNLMS自適應濾波器[7]的LAEC組成。在DNN部分,我們提出了一種新的語音密度預測backbone,稱為軸向自注意多尺度時間頻率折積網路(Multi-scale Temporal Frequency Convolutional Network with Axial self-Attention,MTFAA-Net)。在這項工作中,我們的貢獻包括:

- 為了消除回聲,我們設計了一種新的組合SP和DNN。與以往的LAEC與DNN拼接不同,我們只使用LAEC作為DNN的條件資訊,避免了LAEC引起的失真引入到估計的目標語音中。

- 提出了一種用於各種語音密度預測任務的主幹。設計了相位編碼器(Phase encoder,PE)、多尺度時頻處理和流式軸向自關注力(ASA)來提高backbone的效能。相位編碼後採用等效矩形頻寬(ERB)的頻頻帶合併模組對全頻帶訊號進行處理,計算複數度較低。

在ICASSP 2022 AEC Challenge[8]和ICASSP 2022 DNS Challenge[9]的評估集和盲測試集上的結果表明,該方案在回聲消除、去噪和去混響方面具有良好的效能。

本文的其餘部分組織如下。第2節介紹問題的表述。第3節提供了用於語音增強的擬議主幹的細節。第4節展示了資料集和實驗結果。最後,我們在第5節得出結論。

2 問題公式化

讓我們考慮短時傅立葉變換(STFT)域中的訊號模型。麥克風訊號$Y(t,f)$由回聲$E(t, f)$、背景噪聲$N(t, f)$和帶混響的近端語音$s(t,f)H^e(f)+s(t,f)H^l(l)$組成。我們稱這個模型為:

$$公式1:Y(t, f)=s(t, f) H^{e}(f)+s(t, f) H^{l}(f)+E(t, f)+N(t, f)$$

其中$s(t,f)H^e(f)$,$s(t,f)H^l(f)$分別是與房間脈衝響應(RIR)早期$H^e(f)$和晚期反射$H^l(f)$折積的近端語音。$t$,$f$分別是時間索引和頻率索引。$s(t, f)H^e(f)$將作為要估計的目標。

LAEC的輸出$Y_{laec}(t,f)$可以看作是純淨語音、殘餘回聲、混響和背景噪聲的混合。與之前[3]方案只將$Y_{laec}(t,f)$和遠端參考訊號輸入網路不同,本文提出的網路也將$Y(t, f)$作為輸入,可以避免LAEC引入的失真帶來的效能下降。它還有助於網路識別哪些T-F區域由於回聲的存在而被LAEC抑制。

3 一種用於語音密集預測的backbone演演算法

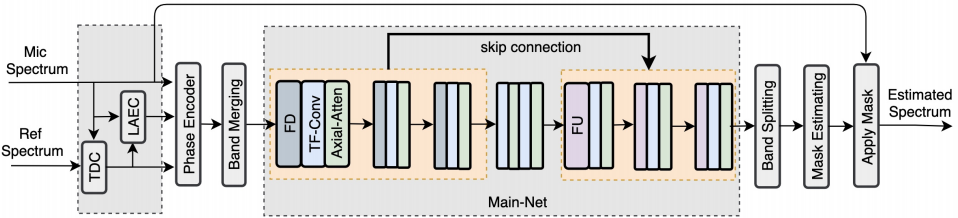

在本節中,我們將展示提議的體系結構的細節。圖1顯示了包含線性回聲消除(LAEC)和時延補償器(TDC)的MTFAA-Net的總體結構。MTFAA-Net由相位編碼器(PE)、頻帶合併(band merging, BM)和頻帶分割(band splitting, BS)模組、掩碼估計和應用(Mask Estimating and Applying, MEA)模組和主網模組(Main-Net module)組成。主網包括幾個相似的部分,每個部分由頻率下取樣(frequency downsampling,FD)或頻率上取樣(frequency upsampling,FU)、T-F折積和流式軸向自關注力(axial self attention, ASA)組成。稍加調整,MTFAA-Net就可以應用於各種語音密度預測任務。

圖1:提出的MTFAA-Net體系結構

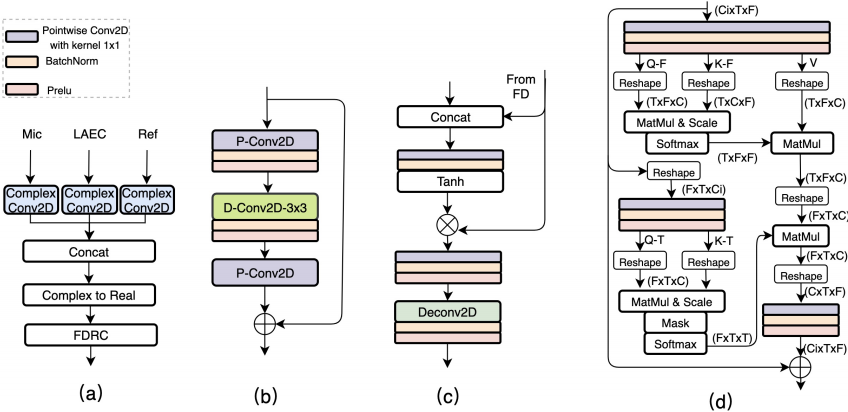

圖2所示:(a) 相位編碼器(PE);(b) TF折積模組(TFCM );(c) 頻率上取樣(FU );(d) 軸向自注意力(ASA)

3.1 相位編碼器

real的語音增強網路更容易實現,並在許多資料集[4]上實現最先進的結果。backbone的主要部分也是一個real的網路。為了將複數頻譜特徵對映到real,我們設計了一個PE模組,如圖2 (a)所示。在PE模組中,有三個複數折積層,分別接收麥克風訊號、LAEC輸出和遠端參考訊號。複數折積層的kernel size和stride分別為(3,1)和(1,1)。此外,PE還包含complex 到real層(complex modulo)和特徵動態範圍壓縮(feature dynamic range compression, FDRC)層。FDRC的目的是減小語音特徵的動態範圍,使模型具有更強的魯棒性。

3.2 頻段合併與分割

語音有有價值資訊在頻率維度上的分佈是不均勻的,特別是在全頻帶訊號中。在高頻段中存在著大量的冗餘特徵。高頻特性合併可以減少冗餘。BS是BM的逆過程。本文將頻帶合併(BM)和頻帶分割(BS)按照ERB刻度[10]進行分割。

3.3 TF折積模組

我們在時間折積網路(TCN)[11]中使用2D深度可分離折積(depthwise convolutions,D-Conv)來代替1D D-Conv。D-Conv還被設計為時間維度上的擴張折積,可以看作是沿時間域的多尺度建模。TF折積模組(TFCM)使用的折積塊如圖2.(b)所示,它由兩個點折積(pointwise convolutional,P-Conv)層和一個核大小為(3,3)的D-Conv層組成。使用B個折積塊將串接在一起形成TFCM,感受野從1擴張到$2^{B-1}$。多尺度建模改進了TFCM的感受野,同時使用小折積核。

3.4 軸向(Axial) Self-Attention

自注意可以提高網路捕捉遠距離特徵之間關係的能力。與計算機視覺[12]中的pixel or patch level注意力不同,本文提出了一種語音識別的ASA機制。ASA可以減少對記憶體和計算的需求,更適合於語音等長序列訊號。圖2(d)是ASA的結構,$C_i$和$C$分別代表輸入通道數和注意力通道數。ASA的注意力得分矩陣沿頻率軸和時間軸計算,分別稱為F-attention和T-attention。分數矩陣可以表示為::

$$公式2:\mathbf{M}_{F}(t)=\operatorname{Softmax}\left(\mathbf{Q}_{f}(t) \mathbf{K}_{f}^{T}(t)\right)$$

$$公式3:\mathbf{M}_{T}(f)=\operatorname{Softmax}\left(\operatorname{Mask}\left(\mathbf{Q}_{t}(f) \mathbf{K}_{t}^{T}(f)\right)\right)$$

其中$Q_f(t)$、$K_f(t)\in R^{T*C}$、$M_F(t)\in R^{F*F}$表示key、query以及F-attention在幀$t$的得分矩陣。$Q_t(f)$、$K_t(f)\in R^{F*C}$、$M_T(F)\in R^{T*T}$表示key、query以及T-attention在頻帶$f$的得分矩陣。$T$,$F$表示幀數和頻帶數。Softmax將沿著最後一個維度計算。T-attention中的Mask(*)用來調整ASA捕獲多長時間的時序依賴性。對於MTFAA-Net-Streaming,使用了掩蔽輸入矩陣的上三角部分,這導致了因果 ASA。

3.5 頻率上下取樣

設計了FD和FU取樣來提取多尺度特徵。在每個尺度上,採用TFCM和ASA進行特徵建模,提高了網路對特徵的描述能力。

- FD是一個折積塊,它包含一個Conv 2D層、一個batchnorm (BN)層和一個PReLU啟用層。

- FU如圖2.(c)所示,其中Deconv 2D為轉置折積。

Conv2D和Deconv2D的核心大小為(1,7),stride為(1,4),分組為2。FU[4]中使用了門控機制。

3.6 Mask估計與應用

掩模估計與應用(mask estimating and applying,MEA)模組由兩個階段組成。第一階段估計的real mask size為$(2V + 1, 2U + 1)$,並以Deepfilter[13]的形式將其應用於幅度譜。第二階段估計complex mask,並將其應用於幅度譜和相位譜。形式上,增強頻譜的實部$R^{s2}(t,f)$和虛部$I^{s2}(t,f)$部分可以表示為:

$$公式4:A^{s 1}(t, f)=\sum_{u=-U}^{U} \sum_{v=-V}^{V}|Y(t+u, f+v)| \cdot M^{s 1}(t, f, u, v)$$

$$公式5:R^{s 2}(t, f)=A^{s 1}(t, f) * M_{A}^{s 2}(t, f) * \cos \left(\theta_{Y}(t, f)+M_{\theta}^{s 2}(t, f)\right)$$

$$公式6:I^{s 2}(t, f)=A^{s 1}(t, f) * M_{A}^{s 2}(t, f) * \sin \left(\theta_{Y}(t, f)+M_{\theta}^{s 2}(t, f)\right)$$

式中,$M^{s1}(t,f,u,v)$、$A^{s1}(t,f)$分別為第1階段估計的mask和增強的幅度譜。$\theta _Y(t,f)$表示帶噪語音的相位譜。$M_A^{s2}(t,f)$、$M_\theta ^{s2}(t,f)$分別表示階段2中幅度和相位部分的Mask。

4 實驗

4.1 資料集

訓練集和評估集都使用純淨語音、背景噪聲、回聲和RIR set進行合成。我們使用 DNS4 的語音和噪聲片段進行訓練。採用VCTK語料庫和DEMAND[14]分別作為評價語音集和噪聲集。ICASSP 2022年AEC挑戰賽訓練和開發遠端單個談話片段被用作訓練和評估回聲集[8]。對於RIR,我們採用映象源方法分別獲取10萬對和1000對混響時間在0.1s到0.8s[15]的RIR進行訓練和評估。所有裝置都以48kHz取樣。訓練時,訊雜比(SNR)和回聲訊號比(SER)分別為[-5,15]dB和[-10,10]dB,評估時,分別為[0,10]dB和[-5,5]dB。

4.2 實現細節

我們使用32ms 幀長,8ms 幀移的 STFT 複數譜作為輸入。 1/2 功率壓縮用於 FDRC [16]。 PE中複數折積層的輸出通道數為4。三個FD的輸出通道數分別為48、96和192。一個TFCM中的折積塊數為6。ASA中的注意通道數為1/4 的輸入通道號。 ERB 波段的數量設定為 256。MEA 中的實際掩碼大小設定為 (3, 1)。 對於 MTFAA-Net -Streaming,折積層和 ASA 也被設定為因果關係,總系統延遲為 40 ms。 目標語音 RIR 的加權函數被設定為與 [17] 中的相同。

具有 STFT 一致性 [18] 的冪律壓縮頻譜(power-law compressed spectrum)的均方誤差用作損失函數。我們使用Adam優化器,學習率為5e-4。 我們將 MTFAA-Net 訓練了 300k 步,batch size為 16。

4.3 結果

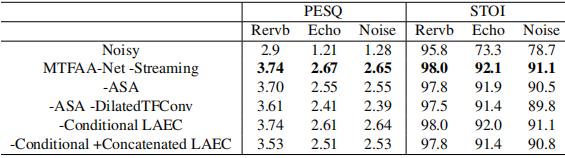

4.3.1 消融實驗

我們首先評估了MTFAA-Net 不同模組的有效性。消融結果見表1。去掉ASA後,模型在三個任務上的效能都下降了,echo任務上的PESQ下降了0.12。當同時去除ASA並將TFCM的 dilation 設定為1時,回聲任務的PESQ降低了0.26。通過從LAEC中引入附加的條件資訊,可以進一步提高模型對回聲任務的效能。但是,如果將LAEC與模型簡單地連線在一起,由於LAEC引入的失真會降低系統的效能。

表1 消蝕研究的去everberation (Rervb),回波消除(Echo)和去噪(Noise)任務

4.3.2 與最先進技術的比較

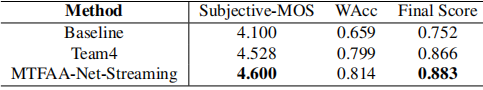

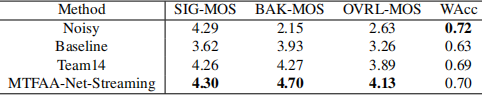

表2 AEC full band 盲測試集與其他方法的比較

表3 DNS full band 盲集方法與其他方法的比較

表2和表3分別顯示了主觀和單詞準確性(WAcc)的結果,由AEC和DNS挑戰組織者提供。結果表明,該方法在主觀評價上明顯優於其他方法。在AEC挑戰賽中,與團隊4相比,可以觀察到主觀mos的0.072增益。對於DNS Challenge,我們的系統在BAK-MOS上獲得了0.47的相當大的增益,與Team14相比。該系統在兩項挑戰中排名第一,證明了所提出的主幹的健壯效能。

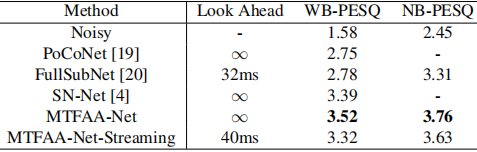

我們還去掉了SP部分,並對DNS寬頻非盲測試集進行了對比評估。訓練和評價集與SN-Net[4]相同。結果如表4所示。MTFAA-Net的表現大大超過了其他所有網路。

表4 DNS寬頻非盲測試集與其他方法的比較。未來的展望表明該模型是非流的

我們還計算了推理時間。在4.2節的設定下,MTFAA-Net的乘法累積運算元量約為每秒2.4G。採用Python實現的系統實時性因子約為0.6(在Intel Core i5核心的MacBook Pro上),滿足了實時性處理的要求。

5 結論

提出了一種新的語音密集預測中樞MTFAA-Net。在引入LAEC的條件資訊後,MTFAA-Net在AEC和ICASSP 2022的DNS挑戰中都達到了最先進的效能。我們希望MTFAA-Net的強大效能將鼓勵統一建模更多語音密度預測任務。未來,我們將改進所提出的backbone的能力,並將backbone擴充套件到其他各種任務,如個人語音增強、源分離等。

6 參考文獻

[1] Jacob Benesty, Tomas G ansler, Dennis R Morgan, M Mohan Sondhi, Steven L Gay, et al., Advances in network and acoustic echo cancellation, 2001.

[2] Amit S Chhetri, Arun C Surendran, Jack W Stokes, and John C Platt, Regression-based residual acoustic echo suppression, in Proc. IWAENC, 2005, vol. 5.

[3] Jean-Marc Valin, Srikanth Tenneti, Karim Helwani, Umut Isik, and Arvindh Krishnaswamy, Lowcomplexity, real-time joint neural echo control and speech enhancement based on percepnet, in ICASSP. IEEE, 2021, pp. 7133 7137.

[4] Chengyu Zheng, Xiulian Peng, Yuan Zhang, Sriram Srinivasan, and Yan Lu, Interactive speech and noise modeling for speech enhancement, AAAI, 2020. [5] Charles Knapp and Glifford Carter, The generalized correlation method for estimation of time delay, IEEE transactions on acoustics, speech, and signal processing, vol. 24, no. 4, pp. 320 327, 1976.

[6] Kazuo Ochiai, Takashi Araseki, and Takasi Ogihara, Echo canceler with two echo path models, IEEE Transactions on Communications, vol. 25, no. 6, pp. 589 595, 1977.

[7] Donald L Duttweiler, Proportionate normalized leastmean-squares adaptation in echo cancelers, IEEE Transactions on speech and audio processing, vol. 8, no. 5, pp. 508 518, 2000.

[8] Ross Cutler, Ando Saabas, Tanel Parnamaa, Marju Purin, Hannes Gamper, Sebastian Braun, Karsten Sorensen, and Robert Aichner, Icassp 2022 acoustic echo cancellation challenge, in ICASSP, 2022.

[9] Harishchandra Dubey, Vishak Gopal, Ross Cutler, Sergiy Matusevych, Sebastian Braun, Emre Sefik Eskimez, Manthan Thakker, Takuya Yoshioka, Hannes Gamper, and Robert Aichner, Icassp 2022 deep noise suppression challenge, in ICASSP, 2022.

[10] Jean-Marc Valin, Umut Isik, Neerad Phansalkar, Ritwik Giri, Karim Helwani, and Arvindh Krishnaswamy, A perceptually-motivated approach for low-complexity, real-time enhancement of fullband speech, 2020.

[11] Yi Luo and Nima Mesgarani, Conv-tasnet: Surpassing ideal time frequency magnitude masking for speech separation, IEEE/ACM transactions on audio, speech, and language processing, vol. 27, no. 8, pp. 1256 1266, 2019.

[12] Ze Liu, Yutong Lin, Yue Cao, Han Hu, Yixuan Wei, Zheng Zhang, Stephen Lin, and Baining Guo, Swin transformer: Hierarchical vision transformer using shifted windows, International Conference on Computer Vision (ICCV), 2021.

[13] Wolfgang Mack and Emanu el AP Habets, Deep filtering: Signal extraction and reconstruction using complex time-frequency filters, IEEE Signal Processing Letters, vol. 27, pp. 61 65, 2019.

[14] J Thiemann, N Ito, and E Vincent, Demand: a collection of multi-channel recordings of acoustic noise in diverse environments (2013), URL http://parole. loria. fr/DEMAND.

[15] David Diaz-Guerra, Antonio Miguel, and Jose R. Beltran, gpuRIR: A Python Library for Room Impulse Response Simulation with GPU Acceleration, Multimed Tools Applx, 2020.

[16] Andong Li, Chengshi Zheng, Renhua Peng, and Xiaodong Li, On the importance of power compression and phase estimation in monaural speech dereverberation, JASA Express Letters, vol. 1, no. 1, pp. 014802, 2021.

[17] Sebastian Braun, Hannes Gamper, Chandan KA Reddy, and Ivan Tashev, Towards efficient models for realtime deep noise suppression, in ICASSP. IEEE, 2021, pp. 656 660.

[18] Sebastian Braun and Ivan Tashev, Data augmentation and loss normalization for deep noise suppression, in International Conference on Speech and Computer. Springer, 2020, pp. 79 86.

[19] Umut Isik, Ritwik Giri, Neerad Phansalkar, Jean-Marc Valin, Karim Helwani, and Arvindh Krishnaswamy, Poconet: Better speech enhancement with frequencypositional embeddings, semi-supervised conversational data, and biased loss, in INTERSPEECH, 2020.

[20] Xiang Hao, Xiangdong Su, Radu Horaud, and Xiaofei Li, Fullsubnet: A full-band and sub-band fusion model for real-time single-channel speech enhancement, in ICASSP. IEEE, 2021, pp. 6633 6637.