【動手學深度學習】學習筆記

線性神經網路

影象分類資料集

import torch

import torchvision

from matplotlib import pyplot as plt

from torch.utils import data

from torchvision import transforms

from d2l import torch as d2l

# 在數位標籤索引以及文字名稱之間轉換

def get_fashion_mnist_labels(labels): #@save

text_labels = ['t-shirt', 'trouser', 'pullover', 'dress', 'coat',

'sandal', 'shirt', 'sneaker', 'bag', 'ankel boot']

return [text_labels[int(i)] for i in labels] # 將索引與標籤一一對應

# 視覺化樣本

def show_images(imgs, num_rows, num_cols, titles=None, scale=1.5): #@save

figsize = (num_cols * scale, num_rows * scale)

_, axes = d2l.plt.subplots(num_rows, num_cols, figsize=figsize)

axes = axes.flatten() # 展開,方便索引

for i, (ax, img) in enumerate(zip(axes, imgs)):

if torch.is_tensor(img):

ax.imshow(img.numpy())

else:

ax.imshow(img)

ax.axes.get_xaxis().set_visible(False) # 隱藏座標軸

ax.axes.get_yaxis().set_visible(False)

if titles:

ax.set_title(titles[i])

return axes

"""

d2l.use_svg_display() # 使用svg顯示圖片,清晰度更高

# 讀取資料集

trans = transforms.ToTensor()

mnist_train = torchvision.datasets.FashionMNIST(root="dataset/FashionMNIST",

train=True, transform=trans,

download=True)

mnist_test = torchvision.datasets.FashionMNIST(root="dataset/FashionMNIST",

train=False, transform=trans,

download=True)

X, y = next(iter(data.DataLoader(mnist_train, batch_size=18)))

show_images(X.reshape(18, 28, 28), 2, 9, titles=get_fashion_mnist_labels(y))

plt.show()

"""

def get_dataloader_workers(): #@save

return 4 # 使用4個程序來讀取資料

# 定義函數用於獲取和讀取該資料集,返回訓練集和驗證集的迭代器

def load_data_fashion_mnist(batch_size, resize = None): #@save

trans = [transforms.ToTensor()]

if resize: # 如果需要更改尺寸

trans.insert(0,transforms.Resize(resize))

trans = transforms.Compose(trans)

mnist_train = torchvision.datasets.FashionMNIST(root="dataset/FashionMNIST",

train=True, transform=trans,

download=False)

mnist_test = torchvision.datasets.FashionMNIST(root="dataset/FashionMNIST",

train=False, transform=trans,

download=False)

return (data.DataLoader(mnist_train,batch_size,shuffle=True,

num_workers=get_dataloader_workers()),

data.DataLoader(mnist_test, batch_size, shuffle=True,

num_workers=get_dataloader_workers()))

softmax迴歸的從零開始實現

import torch

from IPython import display

from d2l import torch as d2l

from matplotlib import pyplot as plt

btach_size = 256

# 呼叫之間的函數獲取兩個迭代器

train_iter,test_iter = d2l.load_data_fashion_mnist(batch_size=btach_size)

num_inputs = 784 # 將每個28和28的圖片展開成就是784,輸入大小

num_outputs = 10 # 輸入要預測十個類別

# 使用正態分佈來初始化權重,第三個引數是為了待會要計算梯度

W = torch.normal(0,0.01, size=(num_inputs,num_outputs),requires_grad=True)

b = torch.zeros(num_outputs,requires_grad=True)

def softmax(X):

X_exp = torch.exp(X)

partition = X_exp.sum(1,keepdim = True) # 求和仍然保持維度不變

return X_exp / partition

# 定義模型

def net(X):

return softmax(torch.matmul(X.reshape((-1,W.shape[0])),W)+b)

# 定義損失函數

def cross_entropy(y_hat,y):

return -torch.log(y_hat[range(len(y_hat)),y])

# 計算分類精度

def accuracy(y_hat,y): #@save

if len(y_hat.shape) > 1 and y_hat.shape[1] > 1:

y_hat = y_hat.argmax(axis = 1) # 取出預測概率最大的下標

cmp = y_hat.type(y.dtype) == y

return float(cmp.type(y.dtype).sum())

# 定義一個用來計算變數累加的類

class Accumulator: #@save

def __init__(self,n):

self.data = [0.0] * n

def add(self,*args): # 不限制輸入數目

self.data = [ a + float(b) for a,b in zip(self.data,args)]

def reset(self):

self.data = [0.0] * len(self.data) # 重置為0

def __getitem__(self, idx):

return self.data[idx]

# 評估在模型上的精度

def evaluate_accuracy(net,data_iter): #@save

if isinstance(net,torch.nn.Module): # 如果是當前已有的模組

net.eval() # 轉為評估模式,常在計算測試集精度時使用,該模式下不可以計算梯度

metric = Accumulator(2)

with torch.no_grad(): # 不計算精度

for X,y in data_iter:

metric.add(accuracy(net(X),y),y.numel()) # 第二個引數是統計tensor的個數

return metric[0] / metric[1]

# 訓練

def train_epoch_ch3(net,train_iter,loss,updater): #@save

# 將模型設定為訓練模式

if isinstance(net,torch.nn.Module):

net.train()

# 訓練損失總和,訓練精確度總和,樣本數

metric = Accumulator(3)

for X,y in train_iter:

y_hat = net(X) # 計算網路的輸出

l = loss(y_hat,y)

if isinstance(updater,torch.optim.Optimizer):

# 使用內建的優化器和損失函數

updater.zero_grad()

l.mean().backward()

updater.step()

else:

# 使用客製化的優化器和損失函數

l.sum().backward()

updater(X.shape[0])

metric.add(float(l.sum()),accuracy(y_hat,y),y.numel())

return metric[0]/metric[2],metric[1]/metric[2] # 返回訓練損失和訓練準確度

class Animator: #@save

def __init__(self,xlabel=None, ylabel = None, legend=None, xlim = None,ylim=None,xscale='linear',

yscale='linear',fmts=('-','m--','g-','r:'),nrows=1,ncols=1, figsize=(3.5,2.5)):

# 增量地繪製多條線

if legend is None:

legend=[]

d2l.use_svg_display()

self.fig,self.axes = d2l.plt.subplots(nrows,ncols,figsize=figsize) # 建立繪圖視窗

if nrows * ncols == 1:

self.axes = [self.axes,]

# 使用lambda函數捕獲引數

self.config_axes = lambda : d2l.set_axes(self.axes[0],xlabel,ylabel,xlim,ylim,xscale,yscale,legend)

self.X,self.Y,self.fmts = None,None,fmts

def add(self,x,y):

# 向圖表中新增多個資料點

if not hasattr(y,"__len__"): # 判斷範例物件y是否包含某個屬性或方法

y = [y]

n = len(y)

if not hasattr(x,"__len__"):

x = [x] * n

if not self.X:

self.X = [[] for _ in range(n)]

if not self.Y:

self.Y = [[] for _ in range(n)]

for i,(a,b) in enumerate(zip(x,y)):

if a is not None and b is not None:

self.X[i].append(a)

self.Y[i].append(b)

self.axes[0].cla()

for x,y,fmt in zip(self.X,self.Y,self.fmts):

self.axes[0].plot(x,y,fmt)

self.config_axes()

display.display(self.fig)

display.clear_output(wait=True)

# 實現一個訓練函數,它會在訓練資料集上訓練模型,並每輪會在測試集上計算誤差

def train_ch3(net,train_iter, test_iter, loss, num_epochs, updater): #@sace

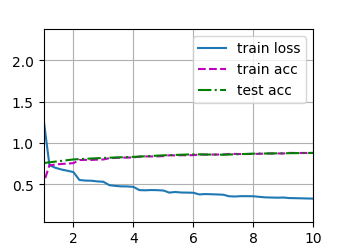

animator = Animator(xlabel='epoch',xlim=[1,num_epochs],ylim = [0.3,0.9],

legend=['train loss','train acc','test acc'])

for epoch in range(num_epochs):

train_metrics = train_epoch_ch3(net,train_iter,loss,updater) # 每一輪的已寫過,返回誤差和精度

test_acc = evaluate_accuracy(net, test_iter) # 計算在測試集上的精度

animator.add(epoch+1, train_metrics+(test_acc,))

train_loss, train_acc = train_metrics # 遍歷了單次資料集當前的誤差和精度

assert train_loss < 0.5, train_loss # 如果不小於0.5就發生異常

assert train_acc <=1 and train_acc > 0.7, train_acc

assert test_acc <=1 and test_acc > 0.7, test_acc

lr = 0.1

def updater(batch_size):

return d2l.sgd([W,b],lr,batch_size)

num_epochs = 10

train_ch3(net, train_iter, test_iter, cross_entropy, num_epochs, updater) # 訓練模型

plt.show() # 在pycharm中最終使用這一句才會顯示出影象

# 預測測試集

def predict_ch3(net,test_iter, n=6): #@save

for X,y in test_iter:

break # 這裡只為了展示因此只取出第一份

trues = d2l.get_fashion_mnist_labels(y)

preds = d2l.get_fashion_mnist_labels(net(X).argmax(axis=1))

titles = [true + '\n' + pred for true,pred in zip(trues,preds)] # 訓練取出真實和預測標籤

d2l.show_images(X[0:n].reshape((n,28,28)),1,n,titles = titles[0:n])

plt.show()

predict_ch3(net,test_iter)

softmax迴歸的簡潔實現

import torch

from torch import nn

from d2l import torch as d2l

batch_size = 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

# 初始化模型引數

net = nn.Sequential(nn.Flatten(), nn.Linear(784, 10))

def init_weight(m):

if type(m) == nn.Linear:

nn.init.normal_(m.weight, std=0.01) # 給tensor初始化,一般是給網路中引數weight初始化,初始化引數值符合正態分佈

net.apply(init_weight) # 將初始化權重的操作應用於該父模組和各個子模組

loss = nn.CrossEntropyLoss(reduction='none') # 不對輸出執行均值或者求和的操作

optimer = torch.optim.SGD(net.parameters(),lr = 0.01)

num_epoch = 10

d2l.train_ch3(net,train_iter,test_iter, loss, num_epoch, optimer)

多層感知機

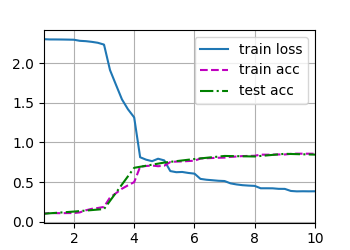

多層感知機的從零開始實現

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

batch_size = 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

# 初始化模型引數

num_inputs, num_outputs, num_hiddens = 784, 10, 256

W1 = nn.Parameter(torch.randn(num_inputs, num_hiddens, requires_grad=True) * 0.01)

b1 = nn.Parameter(torch.zeros(num_hiddens, requires_grad=True))

W2 = nn.Parameter(torch.randn(num_hiddens, num_outputs, requires_grad=True) * 0.01)

b2 = nn.Parameter(torch.zeros(num_outputs, requires_grad=True))

params = [W1, b1, W2, b2]

def relu(X):

a = torch.zeros_like(X)

return torch.max(X, a)

def net(X):

X = X.reshape((-1, num_inputs))

H = relu(X @ W1 + b1) # @代表矩陣乘法的簡寫

return H @ W2 + b2

loss = nn.CrossEntropyLoss(reduction='none')

num_epochs, lr = 10, 0.1

updater = torch.optim.SGD(params, lr=lr)

d2l.train_ch3(net, train_iter, test_iter, loss, num_epochs, updater)

plt.show()

d2l.predict_ch3(net,test_iter)

plt.show()

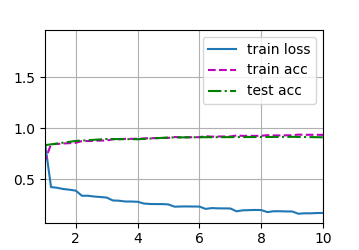

多層感知機的簡潔實現

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

net = nn.Sequential(nn.Flatten(), nn.Linear(784, 256), nn.ReLU(), nn.Linear(256, 10))

def init_weights(m):

if type(m) == nn.Linear:

nn.init.normal_(m.weight, std=0.01)

net.apply(init_weights)

batch_size, lr, num_epochs = 256, 0.01, 10

loss = nn.CrossEntropyLoss(reduction='none')

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

optimer = torch.optim.SGD(net.parameters(), lr=lr)

d2l.train_ch3(net, train_iter,test_iter, loss, num_epochs, optimer)

plt.show()

權重衰減

簡潔實現

net = nn.Sequential(nn.Linear(num_inputs, 1))

for param in net.parameters():

param.data.normal_()

optimer = torch.optim.SGD([ {"params":net[0].weight,'weight_decay':wd},

{"params":net[0].bias}],lr=lr)

上面設定「weight_decay」為wd就是設定其使用權重衰減。

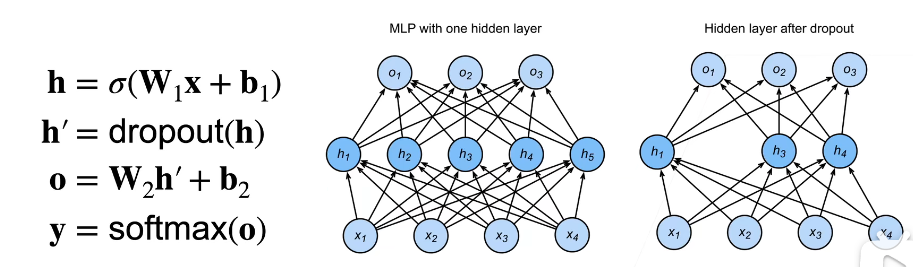

Dropout

一個好的模型需要對輸入資料的擾動魯棒,也就是不能夠受噪聲的影響。那麼如果使用帶有噪聲的資料來學習的話,如果能夠使得其不學習到噪聲的那部分內容,那麼也相當於是正則化。因此丟棄法(Dropout)就是在層之間加入噪音。

那麼從定義方向出發,它就是無偏差的加入噪音,即對原本輸入\(\pmb{x}\)加入噪音得到\(\pmb{x}^{\prime}\),希望其均值不變,即:

那麼丟棄法具體的做法是對每個元素執行如下擾動:

那麼這樣可以保證期望不變:

那麼這個丟棄概率就是控制模型複雜度的超引數

具體是通常將丟棄法作用在多層感知機的隱藏層的輸出上,即:

這是在訓練過程中使用,它將會影響模型引數的更新,而在測試的時候並不會進行dorpout操作,這樣能夠保證確定性的輸出。從實驗上來說,它和正則化能夠達到類似的效果。

那麼Dropout放在隱藏層的輸出,會將那些被置為0的神經元的權重在本次不進行更新,那麼就可以認為是每一次Dropout都是從所有的隱藏層神經元中挑選出一部分來進行更新。

具體的實現直接呼叫nn.Dropout()層即可。

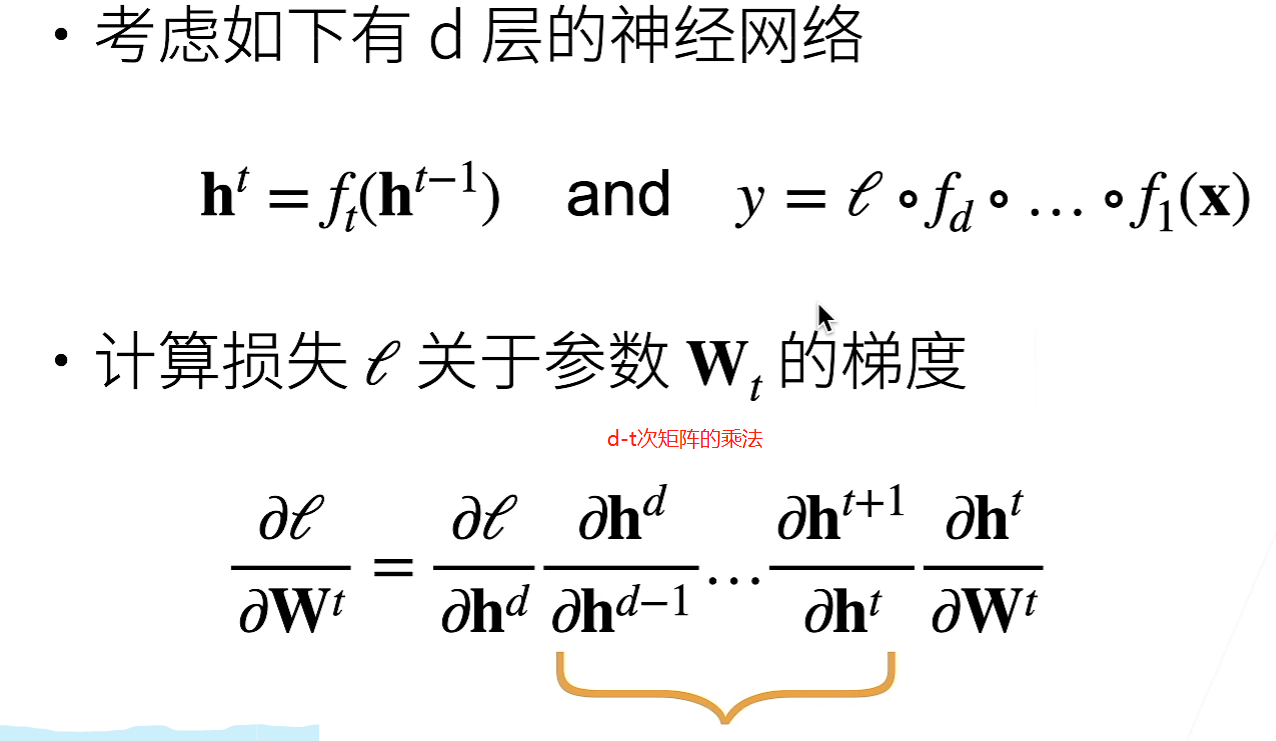

數值穩定性

在計算梯度時:

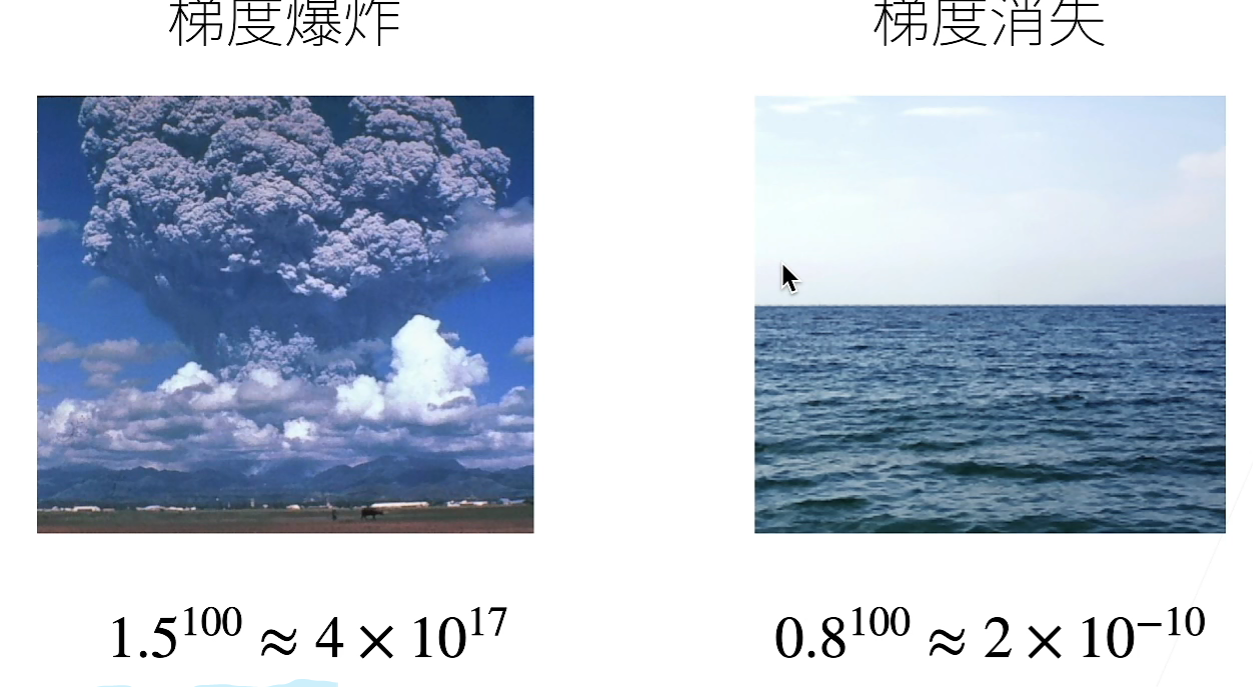

因為向量對向量的求導是矩陣,因此這麼多次矩陣的運算可能會遇見梯度爆炸或者梯度消失的問題。

假設矩陣中的梯度大部分都是比1大一點的數,那麼經過這麼多次梯度計算就可能出現梯度過大而爆炸;那麼梯度如果稍微小於1也就會經過這麼多次迭代之後接近於0。

那麼梯度爆炸就會帶來如下的問題:

- 值超過了數值型別可以表示的範圍

- 對學習率更加敏感

- 當學習率比較大,乘上較大的梯度就更新程度比較大,難以穩定

- 當學習率太小,那麼可能導致在除開梯度爆炸的那些權重外的正常權重無法正常更新

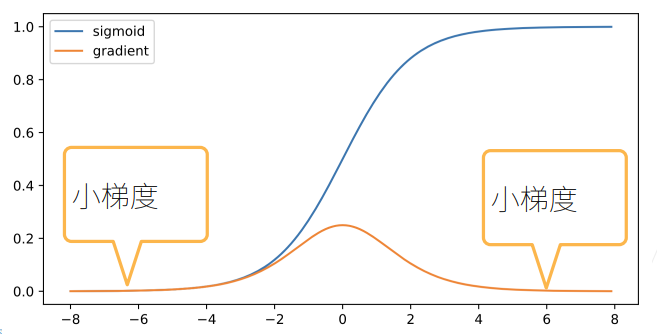

而對於梯度消失,例如採用sigmoid函數:

這麼小的梯度在多個疊加之後就可能會出現梯度消失的問題。它的主要問題是:

- 也是超過表示範圍,直接就使大部分梯度值為0,無法更新

- 訓練因為梯度值為0,無法正常更新

- 對於底部層尤為嚴重,因為梯度是從輸出層反向傳播計算得到的,越到底部層,疊加的層數越多,梯度越可能消失,那就使得只有頂部層能夠正常訓練更新

那麼如何使訓練更加穩定的首要目標,就是讓梯度值在合理的範圍內,例如在某些演演算法中它們將梯度的乘法轉換成加法,或者是對梯度進行歸一化、裁剪等。但還有一種重要的方法就是合理的進行權重初始化,以及選擇適合的啟用函數。

具體來說,結論就是在對權重進行初始化的時候,讓權重是從一個均值為0,方差為\(\gamma_t=\frac{2}{n_{t-1}+n_t}\)中取樣得到的。其中\(n_{t-1}、n_{t}\)代表該權重所連線的兩個層的神經元的數目。因此需要根據層的形狀來選擇權重所服從分佈的方差。

而啟用函數經過推導,可以認為tanh(x)和ReLU(x)這兩個啟用函數能夠具有較好的特性,而sigmoid(x)需要調整為\(4\times sigmoid(x)-2\)才能夠達到與前兩個相同的效果。

環境和分佈偏移

1、分佈偏移的型別

主要有以下幾種偏移型別:

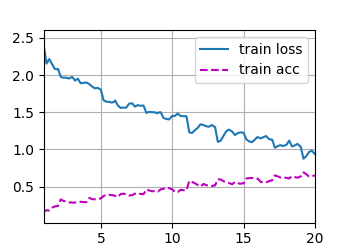

- 協變數偏移:指的是資料的分佈\(p(x)\)發生了變化,例如在訓練的時候用到的訓練資料集分佈\(p_1(x)\)和測試的時候用到的測試集分佈\(p_2(x)\)不同,那麼這就很難使得模型在測試資料集上表現好。不過這種變化還有一個架設計就是雖然輸入的分佈可能隨時間發生變化,但是標籤函數(即條件分佈\(P(y\mid x)\))不會改變。例如在訓練的時候我們用真實的貓和狗來讓機器學會分類,但是在測試的時候我們用的是卡通的貓和狗,這就是訓練和測試兩部分的資料集不相同,但是它們的標籤函數是相同的,可以正確地對貓和狗進行標註。

- 標籤偏移:指的是和協變數偏移相反的問題,因為這裡假設標籤邊緣概率\(P(y)\)可以改變,但是類別條件分佈\(P(x\mid y)\)在不同的領域之間保持不變。這裡可以舉一個例子就是預測患者的疾病,症狀就是x,而所患的疾病就是標籤y,那麼疾病的相對流行率,或者說各種疾病之間的比例可能發生變化(即\(P(y)\))可能發生變化,而對於某種特定疾病所對應的症狀(\(P(x\mid y))\)不會發生變化。

- 概念偏移:指的是標籤的定義出現了變化。舉個例子就是我們對於美貌的定義,可能會隨著時間的變化而發生變化,那麼這個「美貌」的標籤的概念就發生了變化。

2、分佈偏移糾正

首先需要了解什麼是經驗風險與實際風險:在訓練時我們通常是最小化損失函數(不考慮正則化項),即:

這一項在訓練資料集上的損失稱為經驗風險。那麼經驗風險就是為了來近似真實風險的,也就是資料的真實分佈下的損失。然而在實際中我們無法獲得真實資料的分佈。因此一般認為最小化經驗風險可以近似於最小化真實風險。

協變數偏移糾正

對於目前已有的資料集(x,y),我們要評估\(P(y\mid x)\),但是當前的資料\(x_i\)是來源於某些源分佈\(q(x)\)(可以認為是訓練資料集的分佈),而不是來源於目標分佈\(p(x)\)(可以認為是真實資料的分佈,或者認為是測試資料的分佈)。但存在協變數偏移的假設即\(p(y\mid x)=q(y\mid x)\)。因此:

因此當前我們需要計算資料來自於目標分佈和來自於源分佈之間的比例,來重新衡量每個樣本的權重,即:

那麼將該權重代入到每個資料樣本中,就可以使用加權經驗風險最小化來訓練模型:

因此接下來的問題就是估計\(\beta\)。具體的方法為:從兩個分佈中抽取樣本來進行分佈估計。即對於目標分佈\(p(x)\)我們就可以通過存取測試資料集來獲取;而對於源分佈\(q(x)\)則直接通過訓練資料集獲取。這裡需要考慮到存取測試資料集是否會導致資料洩露的問題,其實是不會的,因為我們只存取了特徵\(x \sim p(x)\),並沒有存取其標籤y。在這種方法下,有一種非常有效的辦法來計算\(\beta\):對數機率迴歸。

我們假設從兩個分佈中抽取相同資料的樣本,對於p抽取的樣本資料標籤為z=1,對於q抽取的樣本資料標籤為z=-1。因此該混合資料集的概率為:

因此如果我們使用對數機率迴歸的方法,即\(P(z=1\mid x)=\frac{1}{1+exp(-h(x))}\)(h是一個引數化函數,設定的),那麼就有:

因此只要訓練得到\(h(x)\)即可。

但上述演演算法依賴一個重要的假設:需要目標分佈(測試集分佈)中的每個資料樣本在訓練時出現的概率非零,否則將會出現\(p(x_i)>0,q(x_i)=0\)的情況。

標籤偏移糾正

同樣,這裡假設標籤的分佈隨時間變化\(q(y)\neq p(y)\),但類別條件分佈保持不變\(q(x\mid y)=p(x\mid y)\)。那麼:

因此重要性權重將對應於標籤似然比率:

因為,為了顧及目標標籤的分佈,我們首先採用效能相當好的現成的分類器(通常基於訓練資料訓練得到),並使用驗證集計算混淆矩陣。那麼混淆矩陣是一個\(k\times k\)的矩陣(k為分類類別數目)。每個單元格的值\(c_{ij}\)是驗證集中真實標籤為j,而模型預測為i的樣本數量所佔的比例。

但是現在我們無法計算目標資料上的混淆矩陣,因為我們不知道真實分佈。那麼我們所能做的就是**將現有的模型在測試時的預測取平均數,得到平均模型輸出\(\mu (\hat{y})\in R^k\),其中第i個元素為我們的模型預測測試集中第i個類別的總預測分數。

那麼具體來說,如果我們的分類器一開始就相當準確,並且目標資料只包含我們以前見過的類別(訓練集和測試集的擁有的類別是相同的),那麼如果標籤偏移假設成立,就可以通過一個簡單的線性系統來估計測試集的標籤分佈:

因此若C可逆,則可得:

概念偏移糾正

這個很難用什麼確切的方法來糾正。不過這種變化通常是很罕見的,或者是特別緩慢的。我們能夠做的一般是訓練時要適應網路的變化,使用新的資料來更新網路。

實戰kaggle比賽:預測房價

import numpy as np

import pandas as pd

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

import hashlib

import os

import tarfile

import zipfile

import requests

DATA_HUB = dict()

DATA_URL = 'http://d2l-data.s3-accelerate.amazonaws.com/'

def download(name, cache_dir=os.path.join("dataset", "data_kaggle")): # @save

assert name in DATA_HUB, f"{name} 不存在於 {DATA_HUB}"

url, shal_hash = DATA_HUB[name]

os.makedirs(cache_dir, exist_ok=True) # 按照第一個引數建立目錄,第二引數代表如果目錄已存在就不發出異常

fname = os.path.join(cache_dir, url.split('/')[-1])

if os.path.exists(fname): # 如果已存在這個資料集

shal = hashlib.sha1()

with open(fname, 'rb') as f:

while True:

data = f.read(1048576) # 這裡進行資料集的讀取,一次能夠讀取的最大行數為1048576

if not data: # 如果讀取到某一次不成功

break

shal.update(data)

if shal.hexdigest() == shal_hash:

return fname # 命中快取

print(f'正在從{url}下載{fname}...')

r = requests.get(url, stream=True, verify=True)

# 向連結傳送請求,第二個引數是不立即下載,當資料迭代器存取的時候再去下載那部分,不然全部載入會爆記憶體,第三個引數為不驗證證書

with open(fname, 'wb') as f:

f.write(r.content)

return fname

# 下載並解壓一個zip或tar檔案

def download_extract(name, folder=None): # @save

fname = download(name)

base_dir = os.path.dirname(fname) # 獲取檔案的路徑,fname是一個相對路徑,那麼就返回從當前檔案到目標檔案的路徑

data_dir, ext = os.path.splitext(fname) # 將這個路徑最後的檔名分割,返回路徑+檔名,和一個檔案的擴充套件名

if ext == '.zip': # 如果為zip檔案

fp = zipfile.ZipFile(fname, 'r')

elif ext in ('.tar', '.gz'):

fp = tarfile.open(fname, 'r')

else:

assert False, "只有zip/tar檔案才可以被解壓縮"

fp.extractall(base_dir) # 解壓壓縮包內的所有檔案到base_dir

return os.path.join(base_dir, folder) if folder else data_dir

def download_all(): # @save

for name in DATA_HUB:

download(name)

# 下載並快取房屋資料集

DATA_HUB['kaggle_house_train'] = ( # @save

DATA_URL + 'kaggle_house_pred_train.csv',

'585e9cc93e70b39160e7921475f9bcd7d31219ce'

)

DATA_HUB['kaggle_house_test'] = ( # @save

DATA_URL + 'kaggle_house_pred_test.csv',

'fa19780a7b011d9b009e8bff8e99922a8ee2eb90'

)

train_data = pd.read_csv(download('kaggle_house_train'))

test_data = pd.read_csv(download('kaggle_house_test'))

# print(train_data.shape)

# print(test_data.shape)

# print(train_data.iloc[0:4,[0,1,2,3,-3,-2,-1]])

# 將序號列去掉,訓練資料也不包含最後一列的價格列,然後將訓練資料集和測試資料集縱向連線在一起

all_features = pd.concat((train_data.iloc[:, 1:-1], test_data.iloc[:, 1:]))

# 將數值型的資料統一減去均值和方差

numeric_features = all_features.dtypes[all_features.dtypes != 'object'].index # 在panda中object型別代表字串

all_features[numeric_features] = all_features[numeric_features].apply(

lambda x: (x - x.mean()) / (x.std()) # 應用匿名函數

)

# 在標準化資料後,所有均值消失,因此我們可以設定缺失值為0

all_features[numeric_features] = all_features[numeric_features].fillna(0)

# 對離散值進行處理

all_features = pd.get_dummies(all_features, dummy_na=True) # 第二個引數代表是否對nan型別進行編碼

# print(all_features.shape)

n_train = train_data.shape[0] # 訓練資料集的個數

train_features = torch.tensor(all_features[:n_train].values, dtype=torch.float32) # 取出訓練資料

test_features = torch.tensor(all_features[n_train:].values, dtype=torch.float32) # 取出測試資料

train_labels = torch.tensor(train_data.SalePrice.values.reshape(-1, 1), dtype=torch.float32) # 取出訓練資料的價格列

loss = nn.MSELoss()

in_features = train_features.shape[1] # 特徵的個數

# 網路架構

def get_net():

net = nn.Sequential(nn.Linear(in_features, 1))

return net

# 取對數約束輸出的數量級

def log_rmes(net, features, labels):

clipped_preds = torch.clamp(net(features), 1, float('inf'))

# 第一個為要約束的引數,第二個為最小值,第三個為最大值,小於最小值就為1

rmse = torch.sqrt(loss(torch.log(clipped_preds), torch.log(labels)))

return rmse.item()

# 訓練的函數

def train(net, train_features, train_labels, test_features, test_labels, num_epochs, learning_rate,

weight_decay, batch_size):

train_ls, test_ls = [], []

train_iter = d2l.load_array((train_features, train_labels), batch_size) # 獲取資料迭代器

optimizer = torch.optim.Adam(net.parameters(), lr=learning_rate, weight_decay=weight_decay)

# 這是另外一個優化器,它對lr的數值不太敏感,第三個引數代表是否使用正則化

for epoch in range(num_epochs):

for X, y in train_iter:

optimizer.zero_grad() # 梯度先清零

l = loss(net(X), y) # 計算損失

l.backward() # 反向傳播計算梯度

optimizer.step() # 更新引數

train_ls.append(log_rmes(net, train_features, train_labels))

if test_labels is not None:

test_ls.append(log_rmes(net, test_features, test_labels))

return train_ls, test_ls

# K折交叉驗證

def get_k_fold_data(k, i, X, y):

assert k > 1

fold_size = X.shape[0] // k

X_train, y_train = None, None

for j in range(k):

idx = slice(j * fold_size, (j + 1) * fold_size) # 建立一個切片物件

X_part, y_part = X[idx, :], y[idx] # 將切片物件應用於索引

if j == i: # 取出第i份作為驗證集

X_valid, y_valid = X_part, y_part

elif X_train is None: # 如果當前訓練集沒有資料就初始化

X_train, y_train = X_part, y_part

else:

X_train = torch.cat([X_train, X_part], 0) # 如果是訓練集那麼就進行合併

y_train = torch.cat([y_train, y_part], 0)

return X_train, y_train, X_valid, y_valid

# k次的k折交叉驗證

def k_fold(k, X_train, y_train, num_epochs, learning_rate, weight_decay, batch_size):

train_l_sum, valid_l_sum = 0, 0

for i in range(k):

data = get_k_fold_data(k, i, X_train, y_train)

net = get_net()

train_ls, valid_ls = train(net, *data, num_epochs, learning_rate, weight_decay, batch_size)

train_l_sum += train_ls[-1]

valid_l_sum += valid_ls[-1]

if i == 0:

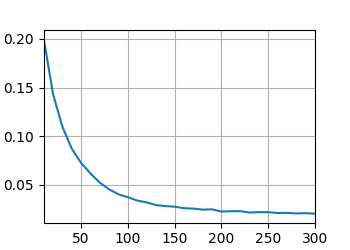

d2l.plot(list(range(1, num_epochs + 1)), [train_ls, valid_ls], xlabel="epoch",

ylabel='ylabel', xlim=[1, num_epochs], legend=["train", 'valid'], yscale='log')

print(f"折{i + 1},訓練log rmse{float(train_ls[-1]):f},"

f"驗證log rmse{float(valid_ls[-1]):f}")

return train_l_sum / k, valid_l_sum / k

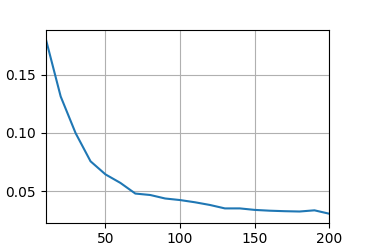

k, num_epochs, lr, weight_decay, batch_size = 5, 100, 5, 0, 64

train_l,valid_l = k_fold(k,train_features, train_labels, num_epochs, lr, weight_decay, batch_size)

print(f"{k}折驗證:平均訓練log rmse:{float(train_l):f}",

f"平均驗證log rmse:{float(valid_l):f}")

plt.show()

下面為我自己偵錯的結果:

def get_net():

net = nn.Sequential(nn.Linear(in_features, 256),

nn.ReLU(),

nn.Linear(256,1))

return net

k, num_epochs, lr, weight_decay, batch_size = 5, 100, 5, 0, 64

5折驗證:平均訓練log rmse:0.045112 平均驗證log rmse:0.157140

我總感覺256直接到1不太好,因此調整了模型的結構:

def get_net():

net = nn.Sequential(nn.Linear(in_features, 128),

nn.ReLU(),

nn.Linear(128,1))

return net

k, num_epochs, lr, weight_decay, batch_size = 5, 100, 0.03, 1, 64

5折驗證:平均訓練log rmse:0.109637 平均驗證log rmse:0.136201

更復雜的模型總感覺沒辦法再降低誤差了。

深度學習計算

層與塊

自定義Sequential模組:

class MySequential(nn.Module):

def __init__(self, *args):

super().__init__()

for idx, module in enumerate(args):

self._modules[str(idx)] = module

# _modules是一個用來存放模組的地方,它的好處是方便存取,類似於一個字典

def forward(self,X):

for block in self._modules.values():

X = block(X)

return X

如果想要某些引數不更新,那麼可以設定requires_grad=False,即

self.rand_weight = torch.rand((20,20),requires_grad=False)

小結:

一個塊可以由許多層組成,一個塊也可以由許多塊組成

塊內可以包含我們自定義的程式碼

塊負責大量的內部處理,包括引數初始化和反向傳播

層與塊的順序連線由Sequential塊處理

引數管理

引數存取有很多種方式,如下:

net = nn.Sequential(nn.Linear(4,8),nn.ReLU(), nn.Linear(8,1))

net[2].state_dict() # 存取索引為2的模型(第二個Linear)的狀態字典,其中就包含權重和偏置的引數

net[2].bias

net[2].bias.data # 取出值

引數初始化:

def init_normal(m):

if type(m) == nn.Linear:

nn.init.normal_(m.weight, mean=0, std=0.01) # 呼叫正態分佈初始化,當然也有很多其他分佈方法

nn.init.zeros_(m.bias) # 初始化為0

net.apply(m) # 為nn內部的linear全部初始化引數

引數繫結:

shared = nn.Linear(8,8)

net = nn.Sequential(nn.Linear(4,8),nn.ReLU(), shared, nn.ReLU(), shard, nn.ReLU())

這樣兩個shared層之間的引數就一直保持相同,共用引數。需要是同一個範例化物件才會共用引數的。

自定義層

自定義層和自定義網路很類似:

class MyLinear(nn.Module): # 要整合這個負類

def __init__(self, in_units, units):

super().__init__() # 同樣初始化

self.weight = nn.Parameter(torch.randn(in_units, units)) # 定義引數時要用這個函數

self.bias = nn.Parameter(torch.randn(units,))

def forward(self,X):

linear = torch.matmul(X, self.weight.data)+self.bias.data

return F.relu(linear)

那麼就跟其他層一樣可以正常使用了。

讀寫檔案

對於資料的儲存可採用如下方式:

torch.save(x,"檔名")

y = torch.load("檔名")

也可以多個x,y進行儲存。

而對於模型的儲存:

class MLP(nn.Module):

---------這裡省略了定義

net = MLP()

torch.save(net.state_dict(), "檔名") # 將引數儲存起來

clone = MLP() # 必須先範例化一個物件才可以來接收儲存的引數

clone.load_state_dict(torch.load("檔名"))

GPU

import torch

from torch import nn

print(torch.cuda.device_count()) # 查詢可用的GPU數量

def try_gpu(i=0): # @save

if torch.cuda.device_count() >= i + 1:

return torch.device(f'cuda:{i}') # 返回目標的那個gpu

return torch.device('cpu') # 如果不滿足則返回cpu

def try_all_gpus(): # @save

devices = [torch.device(f'cuda:{i}') for i in range(torch.cuda.device_count())]

return devices if devices else [torch.device('cpu')]

print(try_gpu())

print(try_gpu(10))

print(try_all_gpus())

1

cuda:0

cpu

[device(type='cuda', index=0)]

那麼接下來就是將模型、輸入、loss這三部分挪到GPU上,那麼就可以在GPU上進行計算。

X = torch.ones(2, 3, device=try_gpu())

# 如果有多個gpu,也需要在同一個gpu上運算:Z = X.cuda(1)

net = nn.Sequential(nn.Linear(3,1))

net = net.to(device=try_gpu())

print(net[0].weight.data.device)

需要注意的是,一般來說資料的處理是先在cpu上做,處理完成後再移動到GPU上和網路進行計算。

折積神經網路

從全連線層到折積

小結:

- 影象的平移不變性使得我們以相同的方式處理區域性影象,而不在乎它所在的位置

- 區域性性意味著計算相應的隱藏表示只需要一小部分的區域性影象畫素

- 在影象處理中,折積層通常比全連線層需要更少的引數,但依舊獲得高效用的效能

- 折積神經網路CNN是一類特殊的神經網路,它可以包含多個折積層

- 多個輸入和輸出通道使模型造每個空間位置可以獲得影象的多方面特徵

影象折積

import torch

from torch import nn

from d2l import torch as d2l

def corr2d(X, K): # @save

h, w = K.shape # 折積核的大小

Y = torch.zeros((X.shape[0] - h + 1, X.shape[1] - w + 1))

for i in range(Y.shape[0]):

for j in range(Y.shape[1]):

Y[i, j] = (X[i:i + h, j:j + w] * K).sum()

return Y

class Conv2D(nn.Module):

def __init__(self, kernel_size):

super().__init__()

self.weight = nn.Parameter(torch.rand(kernel_size))

self.bias = nn.Parameter(torch.zeros(1))

def forward(self, x):

return corr2d(x, self.weight) + self.bias

X = torch.ones((6,8))

X[:,2:6] = 0

K = torch.tensor([[1.0,-1.0]])

Y = corr2d(X,K)

print(Y)

填充和步幅度

噹噹輸入影象的形狀為\(n_h \times n_w\),折積形狀為\(k_h \times k_w\)時,那麼輸出形狀為\((n_h-k_h+1)\times (n_w -k_w+1)\)。

那麼若填充\(p_h\)行和\(p_w\)列(分別進行上下左右平均分類),那麼最終輸出的形狀為:

若調整垂直步幅為\(s_h\),水平步幅為\(s_w\)時,輸出形狀為:

import torch

from torch import nn

def comp_conv2d(conv2d,x):

x = x.reshape((1,1) + X.shape) # 將維度弄成4個,前兩個為填充和步幅

y = conv2d(x)

return y.reshape(y.shape[2:])

conv2d = nn.Conv2d(1,1,kernel_size=(3,5),padding=(0,1),stride=(3,4))

X = torch.rand(size=(8,8))

print(comp_conv2d(conv2d,X).shape)

小結:

- 填充可以增加輸出的高度和寬度,這常用來使得輸出與輸入具有相同的高和寬

- 步幅可以減小輸出的高和寬,例如輸出的高和寬僅為輸入的高和寬的\(\frac{1}{n}\)

- 填充和步幅可用於有效地調整資料的維度

多輸入多輸出通道

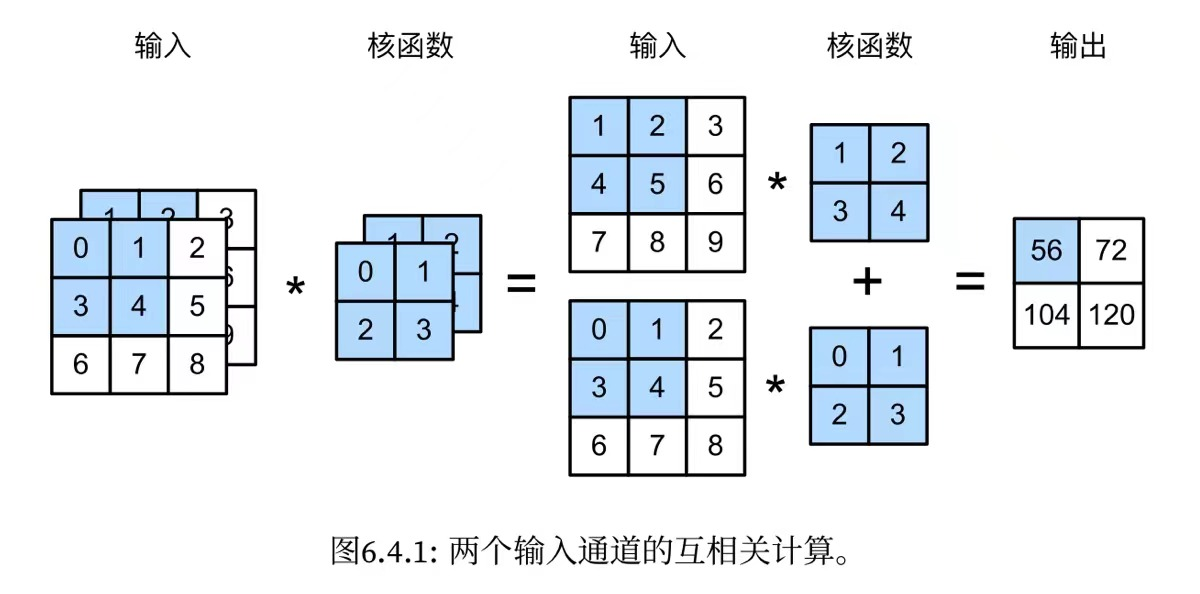

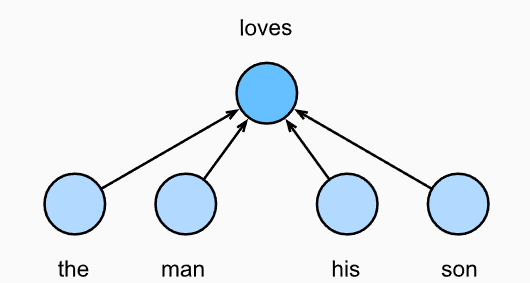

對於多輸入通道來說,一般都有相同通道數的折積核來跟其進行匹配,然後計算的過程就是對每個通道輸入的二維張量和對應通道的折積核的二維張量進行運算,每個通道得到一個計算結果,然後就將各個計算結果相加作為輸出的單通道的那個位置的數值,如下圖:

對於多輸出通道來說,可以將每個通道看作是對不同特徵的響應,假設\(c_i、c_o\)分別為輸入和輸出通道的數目,那麼為了得到這多個通道的輸出,我們需要為每個輸出通道建立一個形狀為\(c_i\times k_h \times k_w\)大小的折積核張量,因此總的折積核的形狀為\(c_o\times c_i \times k_h \times k_w\)。

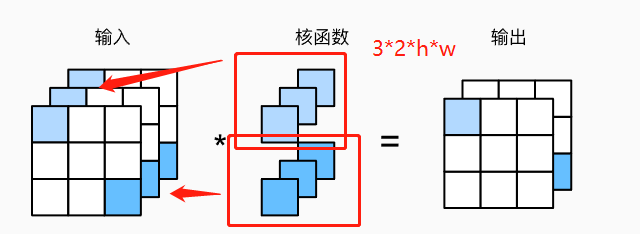

而還有一種特殊的折積層,為\(1\times 1\)折積層。因為高寬只有1,因此它無法造高度和寬度的維度上,識別相鄰元素間相互作用的能力,它唯一的計算髮生在通道上。如下圖:

這種折積層會導致輸入和輸出具有相同的高度和寬度,但是通道數發生了變化,輸出中的每個元素都是從輸入影象中同一位置的元素的線性組合,這就說明可以將這個折積層起的作用看成是一個全連線層,輸入的每個通道就是一個輸入結點,然後折積核的每一個通道就是對應的權重。

因此\(1\times 1\)折積層通常用於調整網路層的通 道數量和控制模型的複雜度

池化層(匯聚層)

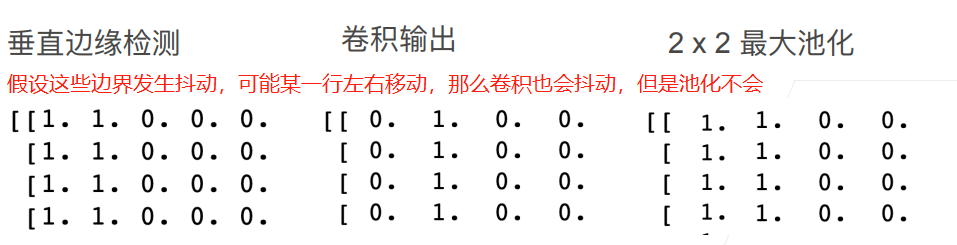

池化層可以用來處理折積對於畫素位置尤其敏感的問題,例如下面:

那麼池化有最大池化以及平均池化

具體實現為:

pool2d = nn.MaxPool2d((2,3),padding=(1,1),stride=(2,3))

如果應對多通道的場景,會保持輸入和輸出通道相等。

小結:

- 對於給定輸入元素,最大池化層會輸出該視窗內的最大值,平均池化層會輸出該視窗內的平均值

- 池化層的主要優點之一是減輕折積層對位置的過度敏感

- 可以指定池化層的填充和步幅

- 使用最大池化層以及大於1的步幅,可以減小空間的維度

- 池化層的輸出通道數和輸入通道數相同

折積神經網路(LeNet)

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

class Reshape(torch.nn.Module):

def forward(self, x):

return x.view(-1, 1, 28, 28)

net = nn.Sequential(

Reshape(),

nn.Conv2d(1, 6, kernel_size=5, padding=2),

nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2),

nn.Conv2d(6, 16, kernel_size=5),

nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2),

nn.Flatten(),

nn.Linear(16 * 5 * 5, 120),

nn.Sigmoid(),

nn.Linear(120, 84),

nn.Sigmoid(),

nn.Linear(84, 10)

)

# 載入資料集

batch_size = 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size=batch_size)

# 修改評估函數,使用GPU來計算

def evaluate_accuracy_gpu(net, data_iter, device=None): # @save

if isinstance(net, torch.nn.Module):

net.eval() # 轉為評估模式

if not device: # 如果不是為None

device = next(iter(net.parameters())).device

metric = d2l.Accumulator(2)

for X,y in data_iter:

if isinstance(X, list):

X = [x.to(device) for x in X]

else:

X = X.to(device)

y = y.to(device)

metric.add(d2l.accuracy(net(X),y), y.numel())

return metric[0] / metric[1]

# 對訓練函數做改動,使其能夠在GPU上跑

def train_ch6(net, train_iter, test_iter, num_eopchs, lr, device): #@ save

def init_weights(m):

if type(m) == nn.Linear or type(m) == nn.Conv2d:

nn.init.xavier_uniform_(m.weight)

net.apply(init_weights)

print("training on:",device)

net.to(device)

optimizer = torch.optim.SGD(net.parameters(), lr=lr)

loss = nn.CrossEntropyLoss()

animator = d2l.Animator(xlabel='epoch', xlim=[1,num_eopchs],

legend=["train loss",'train acc', 'test,acc'])

timer, num_batches = d2l.Timer(), len(train_iter)

for epoch in range(num_eopchs):

metric = d2l.Accumulator(3)

net.train() # 開啟訓練模式

for i,(X,y) in enumerate(train_iter):

timer.start() # 開始計時

optimizer.zero_grad() # 清空梯度

X, y = X.to(device), y.to(device)

y_hat = net(X)

l = loss(y_hat, y)

l.backward()

optimizer.step()

with torch.no_grad():

metric.add(l * X.shape[0], d2l.accuracy(y_hat,y), X.shape[0])

timer.stop() # 停止計時

train_l = metric[0] / metric[2]

train_acc = metric[1] / metric[2]

if (i+1) % (num_batches // 5) == 0 or i==num_batches-1:

animator.add(epoch + (i+ 1) / num_batches,

(train_l, train_acc ,None))

test_acc = evaluate_accuracy_gpu(net, test_iter)

animator.add(epoch+1, (None, None, test_acc))

print(f'loss{ train_l:.3f},train acc{train_acc:.3f},'

f'test acc{test_acc:.3f}')

print(f'{metric[2] * num_eopchs / timer.sum():1f} examples / sec'

f'on{str(device)}')

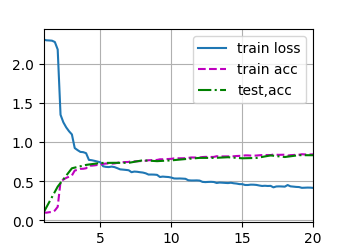

lr, num_epoch = 0.5,20

train_ch6(net, train_iter, test_iter, num_epoch, lr ,d2l.try_gpu())

plt.show()

loss0.417,train acc0.847,test acc0.836

36144.960085 examples / seconcuda:0

小結:

- 折積神經網路是一類使用折積層的網路

- 在折積神經網路中,組合使用折積層、非線性啟用函數和池化層

- 為了構造高效能的CNN,我們通常對摺積層進行排序,逐漸降低其表示的空間解析度,同時增加通道數

- 在傳統的折積神經網路中,折積塊編碼得到的表徵在輸出之前需要由一個或多個全連線層進行處理

- LeNet是最早釋出的折積神經網路之一

深度折積神經網路(AlexNet)

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

net = nn.Sequential(

nn.Conv2d(1, 96, kernel_size=11, stride=4, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2),

nn.Conv2d(96, 256, kernel_size=5, padding=2),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2),

nn.Conv2d(256, 384, kernel_size=3, padding=1),

nn.ReLU(),

nn.Conv2d(384, 384, kernel_size=3, padding=1),

nn.ReLU(),

nn.Conv2d(384, 256, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2),

nn.Flatten(),

nn.Linear(6400, 4096),

nn.ReLU(),

nn.Dropout(p=0.5),

nn.Linear(4096, 4096),

nn.ReLU(),

nn.Dropout(p=0.5),

nn.Linear(4096, 10)

)

batch_size = 128

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=224)

# 讀取資料然後將其高和寬都拉成224

lr, num_epochs = 0.01, 10

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

跑了好久:

loss 0.328, train acc 0.881, test acc 0.881

666.9 examples/sec on cuda:0

使用塊的網路(VGG)

VGG就是沿用了AlexNet的思想,將多個折積層和一個池化層組成一個塊,然後可以指定每個塊內折積層的數目,以及塊的數目,經過多個塊對影象資訊的提取後再經過全連線層。

VGG塊中包含以下內容:

- 多個帶填充以保持解析度不變的折積層

- 每個折積層後都帶有非線性啟用函數

- 最後一個池化層

具體程式碼如下:

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

def vgg_block(num_convs, in_channels, out_channels):

# 該函數用來建立單個的VGG塊

layers = []

for _ in range(num_convs):

layers.append(nn.Conv2d(in_channels, out_channels, kernel_size=3, padding=1))

layers.append(nn.ReLU())

in_channels = out_channels

layers.append(nn.MaxPool2d(kernel_size=2, stride=2))

return nn.Sequential(*layers)

def vgg(conv_arch):

conv_blks = []

in_channels = 1

# 構建折積層

for (num_convs, out_channels) in conv_arch:

conv_blks.append(vgg_block(num_convs, in_channels, out_channels))

in_channels = out_channels

return nn.Sequential(

*conv_blks,

nn.Flatten(),

nn.Linear(out_channels * 7 * 7, 4096),

nn.ReLU(),

nn.Dropout(p=0.5),

nn.Linear(4096, 4096),

nn.ReLU(),

nn.Dropout(p=0.5),

nn.Linear(4096, 10)

)

conv_arch = ((1, 64), (1, 128), (2, 256), (2, 512), (2, 512))

# 第一個為塊內折積層個數,第二個為輸出通道數

ratio = 4

small_conv_arch = [(pair[0], pair[1] // ratio) for pair in conv_arch]

# 除以ratio減少通道數目

net = vgg(small_conv_arch)

lr, num_epochs, batch_size = 0.05, 10, 128

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=224)

d2l.train_ch6(net,train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

loss 0.170, train acc 0.936, test acc 0.912

378.0 examples/sec on cuda:0

小結:

- VGG-11使用可複用的折積塊來構造網路,不同的VGG模型可通過每個塊中折積層數量和輸出通道數量的差異來定義

- 塊的使用導致網路定義得非常簡潔,使用塊可以有效地設計複雜的網路

- 在研究中發現深層且窄的折積(多層\(3\times 3\))比淺層且寬(例如少層\(5\times 5\))的效果更好

網路中的網路(NiN)

之前的網路都有一個共同的特點在於最後都會通過全連線層來對特徵的表示進行處理,這就導致引數數量很大。那麼NiN就是希望能夠很其他的模組來替換掉全連線層,那麼就用到了\(1 \times 1\)的折積層,因此1個NiN塊就是一個正常的折積層和兩個\(1 \times 1\)的折積層,那麼經過多個NiN塊後,將通道數拓展到希望輸出的類別數,然後用一個具有輸出類別數目的通道數的全域性平均池化層來進行處理,也就是對每個通道進行全部平均得到單個標量,那麼有\(out\_channels\)個通道就有相應個數值,再經過softmax就可以作為輸出了。

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

def nin_block(in_channels, out_channels, kernel_size, strides, padding):

return nn.Sequential(

nn.Conv2d(in_channels, out_channels, kernel_size, strides, padding),

# 在第一個折積層就將其轉換為對應的通道數和大小

nn.ReLU(),

nn.Conv2d(out_channels, out_channels, kernel_size=1),

nn.ReLU(),

nn.Conv2d(out_channels, out_channels, kernel_size=1),

nn.ReLU() # 兩個1*1的折積層都不改變大小和通道

)

net = nn.Sequential(

nin_block(1, 96, kernel_size=11, strides=4, padding=0),

nn.MaxPool2d(3, stride=2), # 使得高寬減半

nin_block(96, 256, kernel_size=5, strides=1, padding=2),

nn.MaxPool2d(3,stride=2),

nin_block(256, 384, kernel_size=3, strides=1, padding=1),

nn.MaxPool2d(3,stride=2),

nn.Dropout(p=0.5),

# 標籤類別數為10,因此最後一個輸出通道數設為10

nin_block(384, 10, kernel_size=3, strides=1, padding=1),

nn.AdaptiveAvgPool2d((1,1)),

nn.Flatten() # 將四維度的轉成兩個維度(批次大小,輸出通道數)

)

lr, num_epochs, batch_size = 0.1, 10, 128

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=224)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

loss 0.383, train acc 0.857, test acc 0.847

513.3 examples/sec on cuda:0

小結:

- NiN使用由一個折積層和多個\(1\times 1\)折積層組成的塊,該塊可以在折積神經網路中使用,以允許更多的畫素非線性

- NiN去除了容易造成過擬合的全連線層,將它們替換成全域性平均池化層,該池化層通道數量為所需的輸出數目

- 移除全連線層可以減少過擬合,同時顯著減少引數量

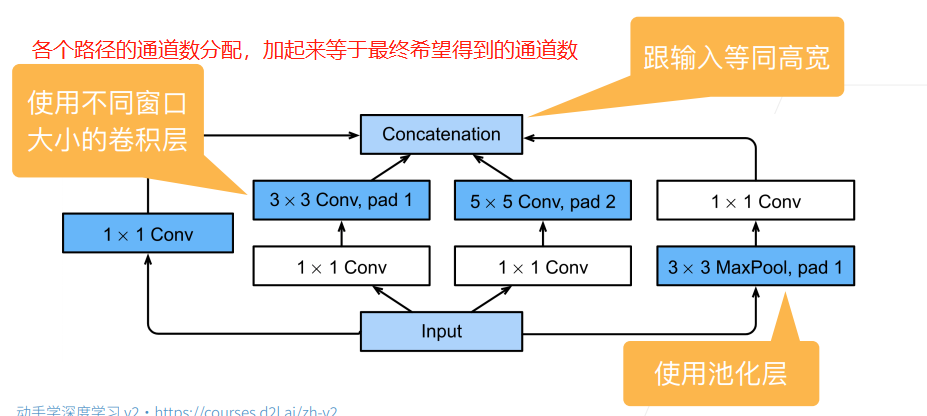

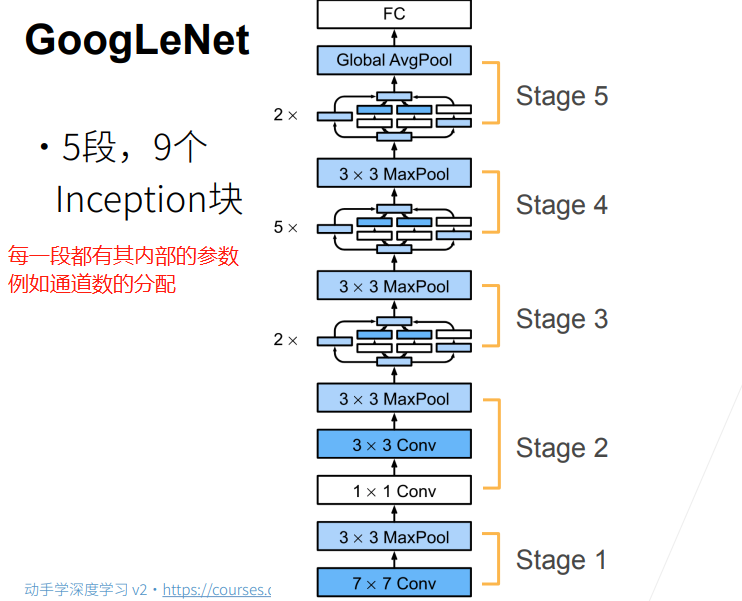

含並行連線的網路(GoogLeNet)

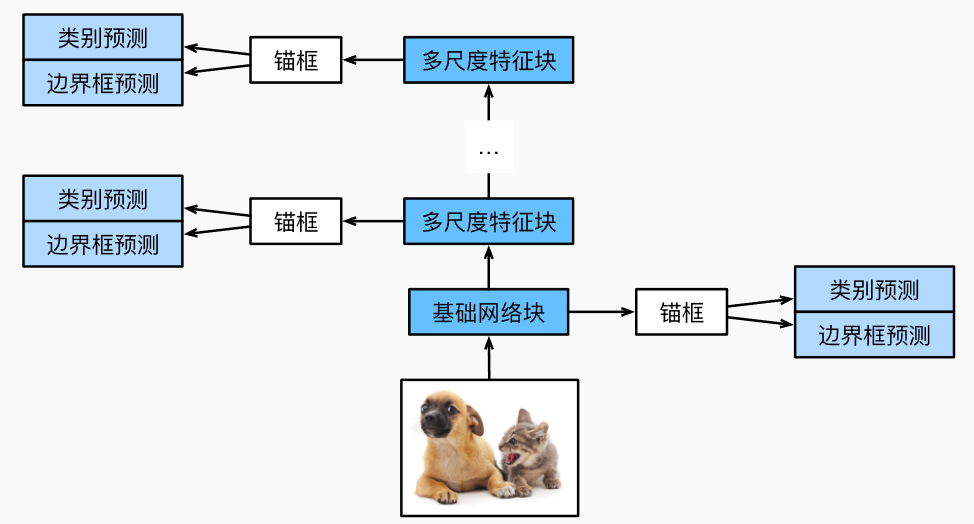

前面提到的各種網路,其中的問題在於各個折積層的引數可能都是不一樣的,而DNN的解釋性如此之差,我們很難解釋清楚哪一個超引數的折積層才是我們需要的,才是最好的。因此在GoogLeNet網路中,其引入了Inception塊,這種塊引入了平行計算的思想,將常見的多種不同超引數的折積層都放入,希望能夠通過多種提取特徵的方式來得到最理想的特徵提取效果,如下圖:

其具體的結構為:

import torch

from matplotlib import pyplot as plt

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2l

class Inception(nn.Module):

def __init__(self, in_channels, c1,c2,c3, c4, **kwargs):

super(Inception, self).__init__(**kwargs)

# 線路1,單1*1折積層

self.p1_1 = nn.Conv2d(in_channels, c1, kernel_size=1)

# 線路2,1*1折積層後接3*3折積層

self.p2_1 = nn.Conv2d(in_channels, c2[0], kernel_size=1)

self.p2_2 = nn.Conv2d(c2[0],c2[1], kernel_size=3, padding=1)

# 線路3,1*1折積層後接上5*5折積層

self.p3_1 = nn.Conv2d(in_channels, c3[0], kernel_size=1)

self.p3_2 = nn.Conv2d(c3[0], c3[1], kernel_size=5, padding=2)

# 線路4,3*3最大池化層後接上1*1折積層

self.p4_1 = nn.MaxPool2d(kernel_size=3, stride=1,padding=1)

self.p4_2 = nn.Conv2d(in_channels, c4, kernel_size=1)

def forward(self,x):

p1 = F.relu(self.p1_1(x))

p2 = F.relu(self.p2_2(F.relu(self.p2_1(x))))

p3 = F.relu(self.p3_2(F.relu(self.p3_1(x))))

p4 = F.relu(self.p4_2(self.p4_1(x)))

# 再在通道維度上疊加在一起

return torch.cat((p1,p2,p3,p4),dim=1)

b1 = nn.Sequential(

nn.Conv2d(1,64, kernel_size=7, stride=2, padding=3),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

)

b2 = nn.Sequential(

nn.Conv2d(64, 64, kernel_size=1),

nn.ReLU(),

nn.Conv2d(64, 192, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

)

b3 = nn.Sequential(

Inception(192,64,(96,128),(16,32),32),

Inception(256,128,(128,192),(32,96),64),

nn.MaxPool2d(kernel_size=3,stride=2,padding=1)

)

b4 = nn.Sequential(

Inception(480, 192, (96,208),(16,48), 64),

Inception(512, 160, (112,224),(24,64), 64),

Inception(512,128,(128,256),(24,64),64),

Inception(512,112, (144,288),(32,64), 64),

Inception(528, 256, (160,320),(32,128),128),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

)

b5 = nn.Sequential(

Inception(832,256, (160,320),(32,128),128),

Inception(832, 384, (192,384), (48,128),128),

nn.AdaptiveAvgPool2d((1, 1)), nn.Flatten()

)

net = nn.Sequential(

b1,b2,b3,b4,b5,nn.Linear(1024,10)

)

lr, num_epochs, batch_size = 0.05, 10, 128

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=96)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

"""

x = torch.rand(size=(1,1,96,96))

for layer in net:

x = layer(x)

print(layer.__class__.__name__, 'output shape \t', x.shape)

"""

loss 0.284, train acc 0.891, test acc 0.884

731.9 examples/sec on cuda:0

小結:

- Inception塊相當於一個有4條路徑的子網路,它通過不同視窗形狀的折積層和最大池化層來並行抽取資訊,並使用\(1\times 1\)折積層減少每畫素級別上的通道維數從而降低模型複雜度

- GoogLeNet將多個設計精細的Inception塊與其他層(折積層、全連線層)串聯起來,其中Inception塊的通道數分配之比是在ImageNet資料集上通過大量的實驗得到的

- GoogLeNet和它的後繼者們一度是ImageNet上最有效的模型之一:它以較低的計算複雜度提供了類似的測試精度

批次歸一化

在訓練過程中,一般正常情況下,後面的層的梯度會比較大,而前面層的梯度會因為經過多層的傳播一直相乘而變得比較小,而此時學習率如果固定的話,那麼前面的層就會更新得比較慢,後面層會更新得比較快,那麼當後面層更新即將完成時,會因為前面的層發生了變動,那麼後面層就需要重新更新。

那麼批次規範化的思想是:在每一個折積層或線型層後應用,將其輸出規範到某一個分佈之中(不同的層所歸到的分佈是不一樣的,是各自學習的),那麼限制到一個想要的分佈後便可以使得收斂更快。

假設當前批次B得到的樣本為\(\pmb{x}=(x_1,x_2,...,x_n)\),那麼:

可以認為\(\gamma、\beta\)分別為要規範到的分佈的方差和均值,是兩個待學習的引數。

研究指出,其作用可能就是通過在每個小批次中加入噪音來控制模型的複雜度,因為批次是隨機取得的,因此批次的均值和方差也就不同,相當於對該次批次加入了隨機偏移\(\hat{\mu}_B\)和隨機縮放\(\hat{\sigma}_B\)。需要注意的是它不需要與Dropout一起使用。

它可以作用的全連線層和折積層的輸出上,啟用函數之前,也可以作用到全連線層和折積層的輸入上:

- 對於全連線層來說,其作用在特徵維

- 對於折積層,作用在通道維

而當我們在訓練中採用和批次歸一化,我們就需要記下來每個用到批次歸一化的地方,其整個樣本資料集的均值和方差是多少,這樣才能夠在進行預測的時候也對預測樣本進行規範。

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

def batch_norm(X, gamma, beta, moving_mean, moving_var, eps, momentum):

if not torch.is_grad_enabled(): # 說明當前在預測

X_hat = (X - moving_mean) / torch.sqrt(moving_var + eps) # 防止方差為0

# 這兩個引數就是整個資料集的均值和方差

else:

assert len(X.shape) in (2,4) # 維度數目為2,是全連線層,為4是折積層

if len(X.shape) == 2:

mean = X.mean(dim = 0)

var = ((X - mean) ** 2 ).mean(dim = 0)

else:

mean = X.mean(dim=(0,2,3),keepdim=True)

# 每一個通道是一個不同的特徵,其提取了影象不同的特徵,因此對通道維計算均值方差

var = ((X - mean) ** 2).mean(dim=(0,2,3), keepdim = True)

# 當前在訓練模式

X_hat = (X - mean) / torch.sqrt(var + eps)

moving_mean = momentum * moving_mean + (1.0 - momentum) * mean

moving_var = momentum * moving_var + (1.0 - momentum) * var

Y = gamma * X_hat + beta

return Y, moving_mean.data, moving_var.data

class BatchNorm(nn.Module):

def __init__(self,num_features, num_dims):

super().__init__()

if num_dims == 2:

shape = (1, num_features)

else:

shape = (1, num_features, 1, 1)

self.gamma = nn.Parameter(torch.ones(shape))

self.beta = nn.Parameter(torch.zeros(shape))

self.moving_mean = torch.zeros(shape)

self.moving_var = torch.ones(shape)

def forward(self, X):

if self.moving_mean.device != X.device:

self.moving_mean = self.moving_mean.to(X.device)

self.moving_var = self.moving_var.to(X.device)

Y,self.moving_mean, self.moving_var = batch_norm(X,self.gamma, self.beta, self.moving_mean,

self.moving_var, eps=1e-5, momentum=0.9)

return Y

net = nn.Sequential(nn.Conv2d(1, 6, kernel_size=5),

BatchNorm(6, num_dims=4),

nn.Sigmoid(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Conv2d(6, 16,kernel_size=5),

BatchNorm(16, num_dims=4),

nn.Sigmoid(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Flatten(),

nn.Linear(16 * 4 * 4, 120),

BatchNorm(120, num_dims=2),

nn.Sigmoid(),

nn.Linear(120, 84),

BatchNorm(84, num_dims=2),

nn.Sigmoid(),

nn.Linear(84, 10))

lr, num_epochs, batch_size = 1.0, 10 ,256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

d2l.train_ch6(net,train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

loss 0.251, train acc 0.908, test acc 0.883

17375.8 examples/sec on cuda:0

而nn中也有簡單的實現方法:

net = nn.Sequential(nn.Conv2d(1, 6, kernel_size=5),

nn.BatchNorm2d(6),

nn.Sigmoid(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Conv2d(6, 16,kernel_size=5),

nn.BatchNorm2d(16),

nn.Sigmoid(),

nn.MaxPool2d(kernel_size=2, stride=2),

nn.Flatten(),

nn.Linear(16 * 4 * 4, 120),

nn.BatchNorm2d(120),

nn.Sigmoid(),

nn.Linear(120, 84),

nn.BatchNorm2d(84),

nn.Sigmoid(),

nn.Linear(84, 10))

小結:

- 在模型訓練的過程中,批次歸一化利用小批次的均值和標準差,不斷調整神經網路的中間輸出,使整個神經網路各層的中間輸出更加穩定

- 批次歸一化在全連線層和折積層的使用略有不同,需要注意作用的維度

- 批次歸一化和Dropout一樣,在訓練模式和預測模式下計算不同

- 批次歸一化有許多有益的副作用,主要是正則化

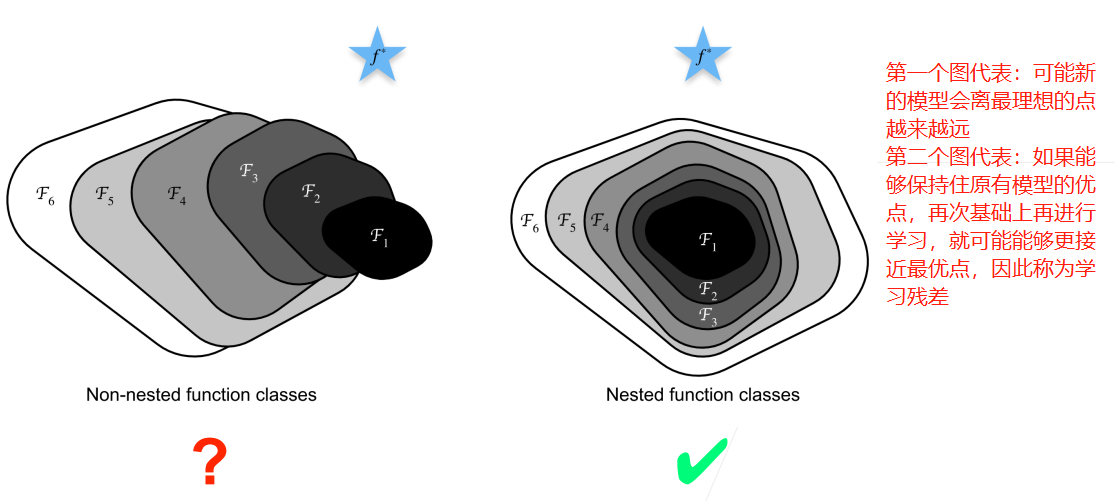

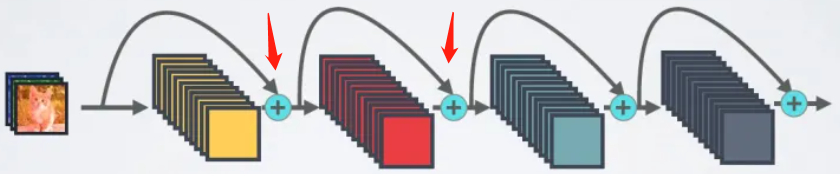

殘差網路(ResNet)

我們需要討論一個問題是:是否加入更多的層就能夠使得精度進一步提高?

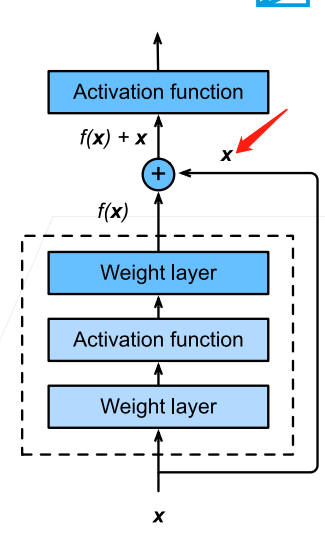

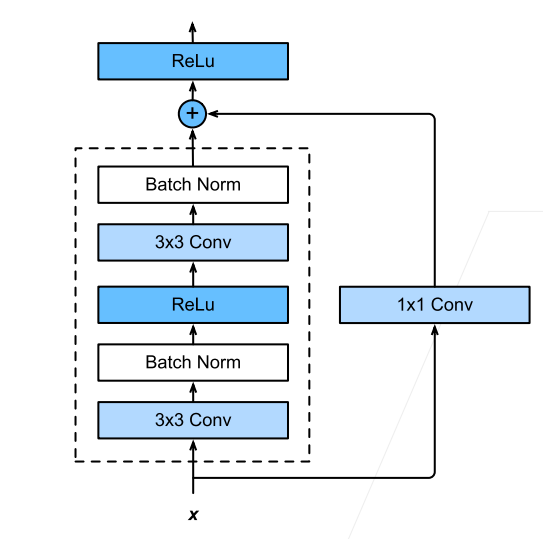

因此ResNet就是這種思想,最具體的表現是:

那麼將該塊的輸入連線到輸出,就需要輸入和輸出的維度是相同的,可以直接相加,因此如果塊內部對維度進行了改變,那麼就需要對輸入也進行維度的變化才能夠相加:

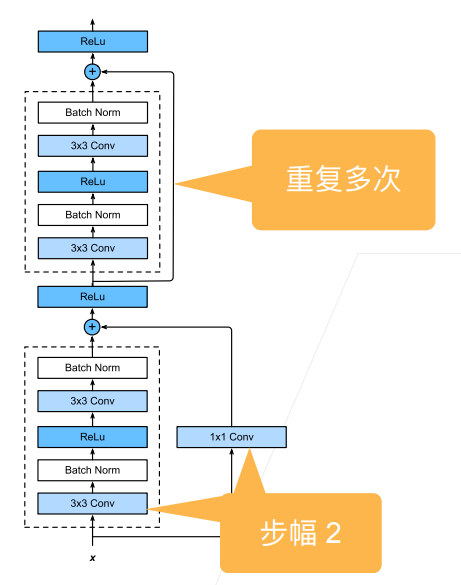

那麼一般來說,是先對輸入進行多個高寬減半的ResNet塊,後面再接多個高寬不變的ResNet塊,可以使得後面提取特徵的時候減少計算量:

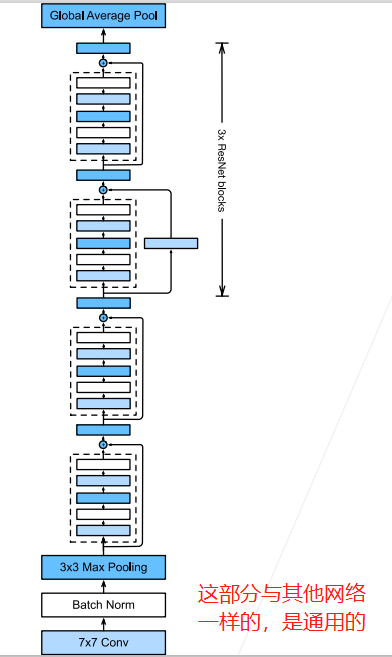

那麼整體的架構就是:

因此,程式碼為:

import torch

from matplotlib import pyplot as plt

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2l

class Residual(nn.Module): #@save

def __init__(self, input_channels, num_channels,

use_1x1conv=False, strides=1):

super().__init__()

self.conv1 = nn.Conv2d(input_channels, num_channels,

kernel_size=3, padding=1, stride=strides)

self.conv2 = nn.Conv2d(num_channels, num_channels,

kernel_size=3, padding=1)

if use_1x1conv:

self.conv3 = nn.Conv2d(input_channels, num_channels,

kernel_size=1, stride=strides)

else:

self.conv3 = None

self.bn1 = nn.BatchNorm2d(num_channels)

self.bn2 = nn.BatchNorm2d(num_channels)

def forward(self, X):

Y = F.relu(self.bn1(self.conv1(X)))

Y = self.bn2(self.conv2(Y))

if self.conv3:

X = self.conv3(X)

Y += X

return F.relu(Y)

# 第一個模組基本上在折積神經網路中都是一樣的

b1 = nn.Sequential(nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64), nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

def resnet_block(input_channels, num_channels, num_residuals,first_block=False):

blk = []

for i in range(num_residuals):

if i == 0 and not first_block:

blk.append(Residual(input_channels, num_channels,use_1x1conv=True, strides=2))

else:

blk.append(Residual(num_channels, num_channels))

return blk

b2 = nn.Sequential(*resnet_block(64,64,2,first_block=True))

b3 = nn.Sequential(*resnet_block(64,128,2))

b4 = nn.Sequential(*resnet_block(128,256,2))

b5 = nn.Sequential(*resnet_block(256,512,2))

# *號代表把resnet_block返回的列表展開,可以理解為把元素都拿出來,不是單個列表了

net = nn.Sequential(

b1,b2,b3,b4,b5,

nn.AdaptiveAvgPool2d((1,1)),

nn.Flatten(),

nn.Linear(512,10)

)

"""

X = torch.rand(size=(1, 1, 224, 224))

for layer in net:

X = layer(X)

print(layer.__class__.__name__,'output shape:\t', X.shape)

"""

lr, num_epochs, batch_size = 0.05, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=96)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

loss 0.014, train acc 0.996, test acc 0.914

883.9 examples/sec on cuda:0

李沐老師後面又補充了一節關於ResNet的梯度計算的內容,具體如下:

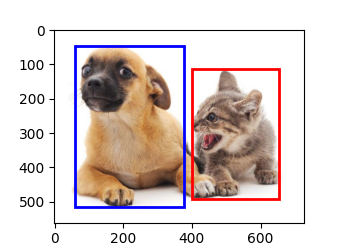

影象分類競賽

本次我先是採用了李沐老師上課講過的ResNet11去跑,結果達到了0.8多一點,具體的程式碼請見下:

# 首先匯入包

import torch

import torch.nn as nn

import pandas as pd

import numpy as np

from torch.utils.data import Dataset, DataLoader

from torchvision import transforms

from PIL import Image

import os

from d2l import torch as d2l

import matplotlib.pyplot as plt

from LeavesDataset import LeavesDataset # 資料載入器

先是要對標籤類的資料進行處理,將其從字串轉換為對應的類別數位,同時在這兩者之間建立關係方便後續:

label_dataorgin = pd.read_csv("dataset/classify-leaves/train.csv") # 讀取csv檔案

leaves_labels = sorted(list(set(label_dataorgin['label']))) # 取出標籤列然後set去重再列表排序

num_class = len(leaves_labels) # 總共的類別數目

class_to_num = dict(zip(leaves_labels, range(num_class))) # 建立字典,類別名稱對應數位

num_to_class = {i:j for j,i in class_to_num.items()} # 數位對應類別名稱

接下來就是寫我們資料載入器,因為我發現一個問題就是如果把資料載入器和整體的程式碼寫在同樣的檔案中會報錯,會在之後呼叫d2l的訓練函數時說找不到這個資料載入器的定義,那麼我們需要在另外的檔案寫資料載入器的定義然後參照,我在另外的LeavesDataset.py檔案中為其定義:

class LeavesDataset(Dataset):

def __init__(self, csv_path, file_path, mode = 'train', valid_ratio = 0.2,

resize_height = 256, resize_width=256):

self.resize_height = resize_height # 拉伸的高度

self.resize_width = resize_width # 寬度

self.file_path = file_path # 檔案路徑

self.mode = mode # 模式

self.data_csv = pd.read_csv(csv_path, header=None) # 讀取csv檔案去除表頭

self.dataLength = len(self.data_csv.index) - 1 # 資料長度

self.trainLength = int(self.dataLength * (1 - valid_ratio)) # 訓練集的長度

if mode == 'train':

# 訓練模式

self.train_images = np.asarray(self.data_csv.iloc[1:self.trainLength, 0]) # 第0列為影象的名稱

self.train_labels = np.asarray(self.data_csv.iloc[1:self.trainLength, 1]) # 第1列為影象的標籤

self.image_arr = self.train_images

self.label_arr = self.image_arr

elif mode == 'valid':

self.valid_images = np.asarray(self.data_csv.iloc[self.trainLength:, 0])

self.valid_labels = np.asarray(self.data_csv.iloc[self.trainLength:, 1])

self.image_arr = self.valid_images

self.label_arr = self.valid_labels

elif mode == 'test':

self.test_images = np.asarray(self.data_csv.iloc[1:,0]) # 測試集沒有標籤列

self.image_arr = self.test_images

self.realLen_now = len(self.image_arr)

print("{}模式下已完成資料載入,得到{}個資料".format(mode, self.realLen_now))

def __getitem__(self, index):

image_name = self.image_arr[index] # 得到檔名

img = Image.open(os.path.join(self.file_path, image_name)) # 拼接後得到當前存取圖片的完整路徑

transform = transforms.Compose([

transforms.Resize((224,224)), # 更改為224*224

transforms.ToTensor()

])

img = transform(img)

if self.mode == 'test':

return img

else:

label = self.label_arr[index]

number_label = class_to_num[label]

return img, number_label

def __len__(self):

return self.realLen_now

那麼接下來就是載入各個資料集了:

train_path = "dataset/classify-leaves/train.csv" # 根據你的實際情況修改

test_path = "dataset/classify-leaves/test.csv"

img_path = "dataset/classify-leaves/"

train_dataset = LeavesDataset(train_path, img_path, mode = 'train')

valid_dataset = LeavesDataset(train_path, img_path, mode = 'valid')

test_dataset = LeavesDataset(test_path, img_path, mode = 'test')

batch_size = 64 # 這裡如果視訊記憶體不夠可以調小

train_loader = DataLoader(dataset=train_dataset,batch_size=batch_size, shuffle=False,num_workers=5) # 不隨機打亂,程序數為5

valid_loader = DataLoader(dataset=valid_dataset,batch_size=batch_size, shuffle=False,num_workers=5)

test_loader = DataLoader(dataset=test_dataset,batch_size=batch_size, shuffle=False,num_workers=5)

得到資料後接下來就是定義模型了,我先是採用了ResNet11:

b1 = nn.Sequential(nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64), nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

def resnet_block(input_channels, num_channels, num_residuals,first_block=False):

blk = []

for i in range(num_residuals):

if i == 0 and not first_block:

blk.append(d2l.Residual(input_channels, num_channels,use_1x1conv=True, strides=2))

else:

blk.append(d2l.Residual(num_channels, num_channels))

return blk

b2 = nn.Sequential(*resnet_block(64,64,2,first_block=True))

b3 = nn.Sequential(*resnet_block(64,128,2))

b4 = nn.Sequential(*resnet_block(128,256,2))

b5 = nn.Sequential(*resnet_block(256,512,2))

net = nn.Sequential(

b1,b2,b3,b4,b5,

nn.AdaptiveAvgPool2d((1,1)),

nn.Flatten(),

nn.Linear(512,176)

)

然後因為我希望如果模型能夠達到要求的精度我就將其儲存下來,因此修改了訓練函數:

def train_ch6_save(net, train_iter, test_iter, num_epochs, lr, device, best_acc): #@save

"""Train a model with a GPU (defined in Chapter 6).

Defined in :numref:`sec_lenet`"""

def init_weights(m):

if type(m) == nn.Linear or type(m) == nn.Conv2d:

nn.init.xavier_uniform_(m.weight)

net.apply(init_weights)

print('training on', device)

net.to(device)

optimizer = torch.optim.SGD(net.parameters(), lr=lr)

loss = nn.CrossEntropyLoss()

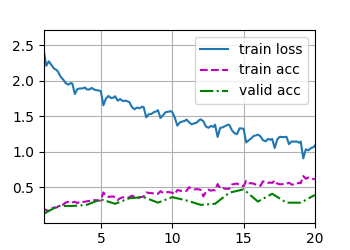

animator = d2l.Animator(xlabel='epoch', xlim=[1, num_epochs],

legend=['train loss', 'train acc', 'test acc'])

timer, num_batches = d2l.Timer(), len(train_iter)

for epoch in range(num_epochs):

# Sum of training loss, sum of training accuracy, no. of examples

metric = d2l.Accumulator(3)

net.train()

for i, (X, y) in enumerate(train_iter):

timer.start()

optimizer.zero_grad()

X, y = X.to(device), y.to(device)

y_hat = net(X)

l = loss(y_hat, y)

l.backward()

optimizer.step()

with torch.no_grad():

metric.add(l * X.shape[0], d2l.accuracy(y_hat, y), X.shape[0])

timer.stop()

train_l = metric[0] / metric[2]

train_acc = metric[1] / metric[2]

if (i + 1) % (num_batches // 5) == 0 or i == num_batches - 1:

animator.add(epoch + (i + 1) / num_batches,

(train_l, train_acc, None))

test_acc = d2l.evaluate_accuracy_gpu(net, test_iter)

animator.add(epoch + 1, (None, None, test_acc))

print(f'loss {train_l:.3f}, train acc {train_acc:.3f}, '

f'test acc {test_acc:.3f}')

print(f'{metric[2] * num_epochs / timer.sum():.1f} examples/sec '

f'on {str(device)}')

if test_acc > best_acc:

print("模型精度較高,值得儲存!")

torch.save(net.state_dict(), "Now_Best_Module.pth")

else:

print("模型精度不夠,不值得儲存")

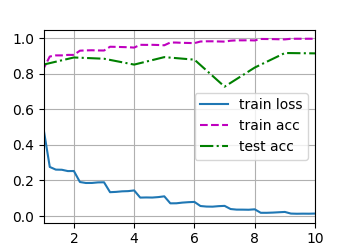

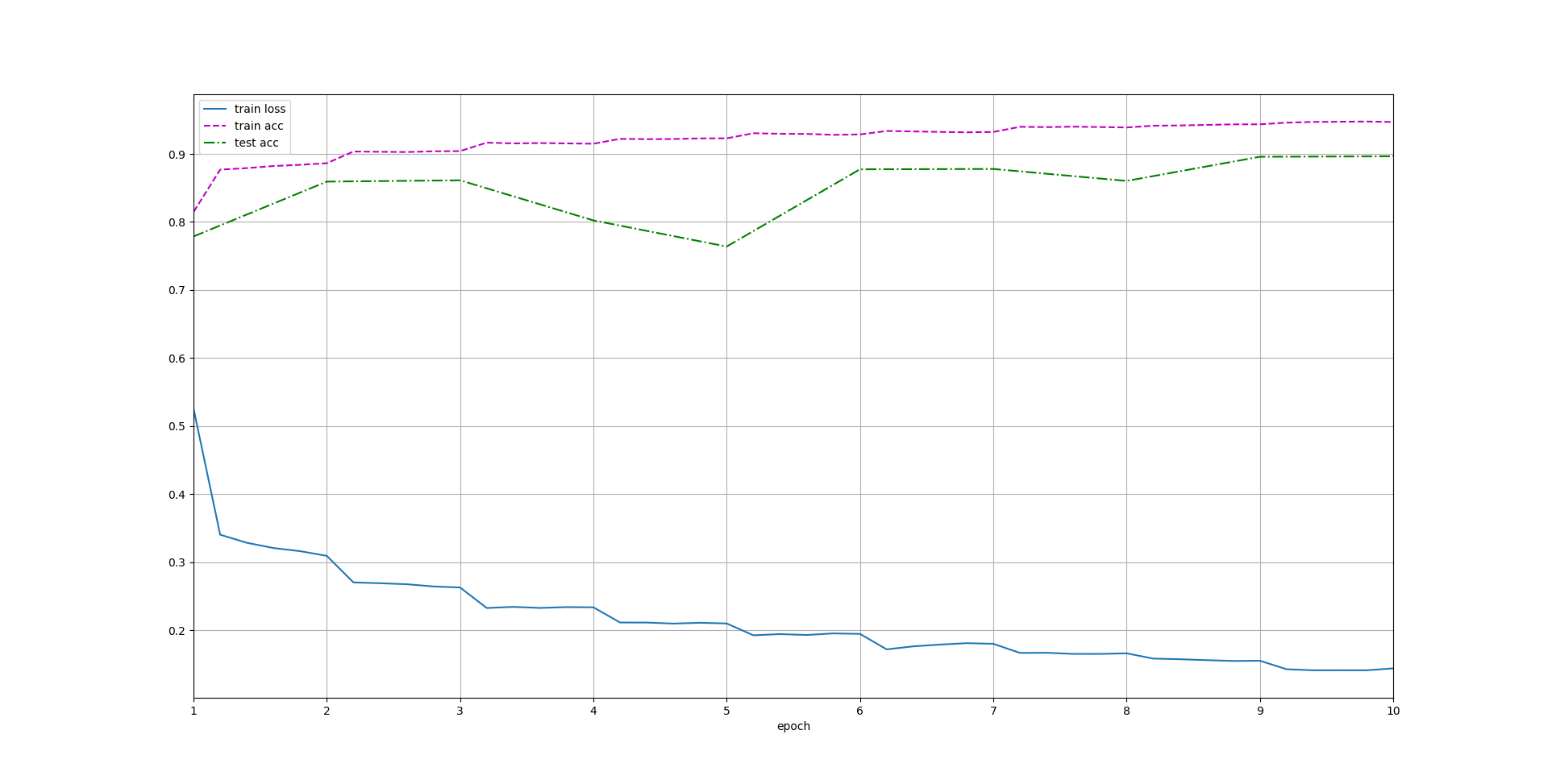

lr, num_epochs,best_acc = 0.05, 25, 0.8 # epoch太小訓練不完全

train_ch6_save(net, train_loader, valid_loader, num_epochs, lr, device=d2l.try_gpu(), best_acc=best_acc)

plt.show()

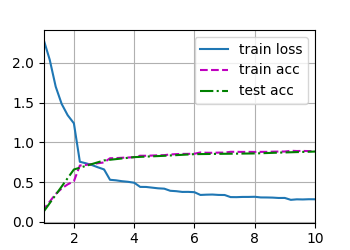

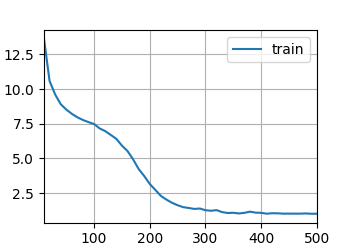

得到結果為:

那麼我接下來希望加大ResNet的深度來提高模型複雜度,用了網上的ResNet50模型發現太大了,讀完模型之後再讀資料,就算把batch_size設定小也視訊記憶體爆了,因此只能修改模型小一點:

b2 = nn.Sequential(*resnet_block(64,64,2,first_block=True))

b3 = nn.Sequential(*resnet_block(64,256,2))

b4 = nn.Sequential(*resnet_block(256,512,2))

b5 = nn.Sequential(*resnet_block(512,2048,3))

net = nn.Sequential(

b1,b2,b3,b4,b5,

nn.AdaptiveAvgPool2d((1,1)),

nn.Flatten(),

nn.Linear(2048,176)

)

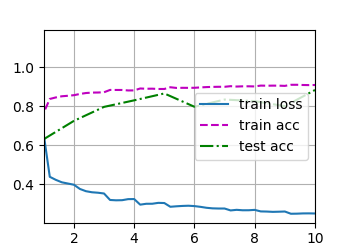

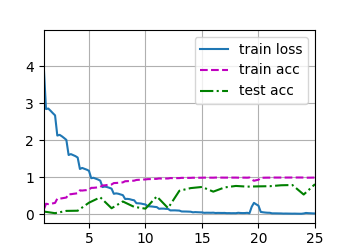

跑了五個小時結果過擬合了...

loss 0.014, train acc 0.996, test acc 0.764

31.6 examples/sec on cuda:0

最終偵錯了好幾個模型花費了一整天的時間,還是沒有最開始的ResNet11的效果好,最終決定就用這個了。

因此完整的程式碼為:

# 首先匯入包

import torch

import torch.nn as nn

import pandas as pd

import numpy as np

from torch.utils.data import Dataset, DataLoader

from torchvision import transforms

from PIL import Image

import os

from d2l import torch as d2l

import matplotlib.pyplot as plt

from tqdm import tqdm

from LeavesDataset import LeavesDataset

def resnet_block(input_channels, num_channels, num_residuals, first_block=False): # 這是ResNet定義用到的函數

blk = []

for i in range(num_residuals):

if i == 0 and not first_block:

blk.append(d2l.Residual(input_channels, num_channels, use_1x1conv=True, strides=2))

else:

blk.append(d2l.Residual(num_channels, num_channels))

return blk

def train_ch6_save(net, train_iter, test_iter, num_epochs, lr, device, best_acc): # @save

"""Train a model with a GPU (defined in Chapter 6).

這是因為我需要訓練完儲存因此將老師的訓練函數進行了修改,就放在這裡了

Defined in :numref:`sec_lenet`"""

def init_weights(m):

if type(m) == nn.Linear or type(m) == nn.Conv2d:

nn.init.xavier_uniform_(m.weight)

net.apply(init_weights)

print('training on', device)

net.to(device)

optimizer = torch.optim.SGD(net.parameters(), lr=lr)

loss = nn.CrossEntropyLoss()

animator = d2l.Animator(xlabel='epoch', xlim=[1, num_epochs],

legend=['train loss', 'train acc', 'test acc'])

timer, num_batches = d2l.Timer(), len(train_iter)

for epoch in range(num_epochs):

# Sum of training loss, sum of training accuracy, no. of examples

metric = d2l.Accumulator(3)

net.train()

for i, (X, y) in enumerate(train_iter):

timer.start()

optimizer.zero_grad()

X, y = X.to(device), y.to(device)

y_hat = net(X)

l = loss(y_hat, y)

l.backward()

optimizer.step()

with torch.no_grad():

metric.add(l * X.shape[0], d2l.accuracy(y_hat, y), X.shape[0])

timer.stop()

train_l = metric[0] / metric[2]

train_acc = metric[1] / metric[2]

if (i + 1) % (num_batches // 5) == 0 or i == num_batches - 1:

animator.add(epoch + (i + 1) / num_batches,

(train_l, train_acc, None))

test_acc = d2l.evaluate_accuracy_gpu(net, test_iter)

animator.add(epoch + 1, (None, None, test_acc))

print(f'loss {train_l:.3f}, train acc {train_acc:.3f}, '

f'test acc {test_acc:.3f}')

print(f'{metric[2] * num_epochs / timer.sum():.1f} examples/sec '

f'on {str(device)}')

if test_acc > best_acc:

print("模型精度較高,值得儲存!")

torch.save(net.state_dict(), "Now_Best_Module.pth") # 對模型進行儲存

else:

print("模型精度不夠,不值得儲存")

if __name__ == "__main__": # 一定要將執行的程式碼放在這裡!否則會報錯,我目前還不知道原因

label_dataorgin = pd.read_csv("dataset/classify-leaves/train.csv") # 讀取訓練的csv檔案

leaves_labels = sorted(list(set(label_dataorgin['label']))) # 取出標籤列然後去重再排序

num_class = len(leaves_labels) # 類別的個數

class_to_num = dict(zip(leaves_labels, range(num_class))) # 轉換為字典

num_to_class = {i: j for j, i in class_to_num.items()}

train_path = "dataset/classify-leaves/train.csv"

test_path = "dataset/classify-leaves/test.csv"

img_path = "dataset/classify-leaves/"

submission_path = "dataset/classify-leaves/submission.csv" # 最終要提交的檔案的路徑

train_dataset = LeavesDataset(train_path, img_path, mode='train')

valid_dataset = LeavesDataset(train_path, img_path, mode='valid')

test_dataset = LeavesDataset(test_path, img_path, mode='test')

#print("資料載入完成")

batch_size = 64

train_loader = DataLoader(dataset=train_dataset, batch_size=batch_size, shuffle=False, num_workers=5)

valid_loader = DataLoader(dataset=valid_dataset, batch_size=batch_size, shuffle=False, num_workers=5)

test_loader = DataLoader(dataset=test_dataset, batch_size=batch_size, shuffle=False, num_workers=5)

#print("資料已變換為loader")

# 定義模型

# 第一個模組基本上在折積神經網路中都是一樣的

b1 = nn.Sequential(nn.Conv2d(3, 64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64), nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

b2 = nn.Sequential(*resnet_block(64, 64, 2, first_block=True))

b3 = nn.Sequential(*resnet_block(64, 128, 2))

b4 = nn.Sequential(*resnet_block(128, 256, 2))

b5 = nn.Sequential(*resnet_block(256, 512, 2))

net = nn.Sequential(

b1, b2, b3, b4, b5,

nn.AdaptiveAvgPool2d((1, 1)),

nn.Flatten(),

nn.Linear(512, 176)

)

lr, num_epochs, best_acc = 0.02, 15, 0.85

device = d2l.try_gpu()

train_ch6_save(net, train_loader, valid_loader, num_epochs, lr, device=device, best_acc=best_acc)

plt.show()

# 開始做預測

net.load_state_dict(torch.load("Now_Best_Module.pth")) # 載入模型

# print("模型載入完成")

net.to(device)

net.eval() # 開啟預測模式

predictions = [] # 用來存放結果類別對應的數位

for i, data in enumerate(test_loader):

imgs = data.to(device)

with torch.no_grad():

logits = net(imgs) # 計算結果是一個176長的向量

predictions.extend(logits.argmax(dim=-1).cpu().numpy().tolist())

# 取出最大的作為結果,並且放回cpu中,再轉換成列表方便插入到predictions中

preds = []

for i in predictions:

preds.append(num_to_class[i]) # 轉換為字串

test_csv = pd.read_csv(test_path)

test_csv['label'] = pd.Series(preds) # 將結果作為一個新的列新增

submission = pd.concat([test_csv['image'], test_csv['label']], axis=1) # 拼接

submission.to_csv(submission_path, index=False) # 寫入檔案

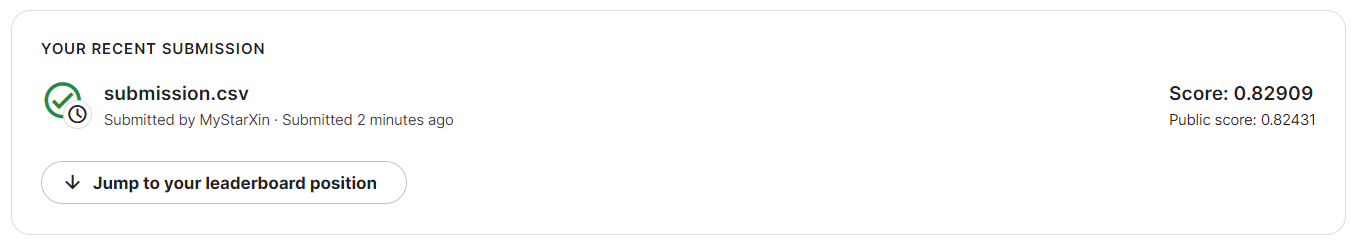

提交的分數為:

自己還是非常開心的!第一次完完整整地完成了一個專案,真正地學到了很多東西!只有自己動手從零開始才真正明白自己哪部分欠缺,因此才能夠有進步!

請繼續努力吧!

稠密連線網路(DenseNet)

與ResNet相比,DenseNet具有更加稠密連線的特點。

之前的ResNet通常是每個層,會與它前面的某一層相連線,按照元素相加的方式結合,如下圖:

而DenseNet不同,它是每個層都會與前面所有層相連線,而且連線的方式是在通道維度上拼接在一起,這樣對於一個\(L\)層的網路,DenseNet共包含有\(\frac{L(L+1)}{2}\)個連線,因此是一種密集連線型。

如果要數位化來表示這種關係,假設傳統的網路在第\(l\)層的輸出為:

那麼ResNet的輸出為:

而DenseNet的輸出為:

稠密網路主要由兩部分構成:稠密塊和過渡層。前者定義如何連線輸入和輸出,後者則控制通道數量,使其不會太複雜。

具體程式碼如下:

import torch

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

def conv_block(input_channels, num_channels): # 改良版的折積

return nn.Sequential(

nn.BatchNorm2d(input_channels), nn.ReLU(),

nn.Conv2d(input_channels, num_channels, kernel_size=3, padding=1)

)

class DenseBlock(nn.Module):

# 一個稠密塊由多個折積塊組成,每個折積塊使用相同數量的輸出通道

def __init__(self, num_convs, input_channels, num_channels):

super(DenseBlock,self).__init__()

layer = []

for i in range(num_convs):

layer.append(conv_block( num_channels * i + input_channels, num_channels))

# 因此每次都會加上前面輸入的通道數目

self.net = nn.Sequential(*layer)

def forward(self,X):

for blk in self.net:

Y = blk(X)

X = torch.cat((X,Y), dim = 1) # 進行通道維度的連線

return X

def transition_block(input_channels, num_channels):

# 這一層使用1*1的折積層來減小通道數,使用步幅為2的平均池化層來減半高寬,防止模型太複雜

return nn.Sequential(

nn.BatchNorm2d(input_channels), nn.ReLU(),

nn.Conv2d(input_channels, num_channels, kernel_size=1),

nn.AvgPool2d(kernel_size=2, stride=2)

)

if __name__ == "__main__":

"""

blk = DenseBlock(2,3,10)

X = torch.rand(4,3,8,8)

Y = blk(X)

print(Y.shape)

blk2 = transition_block(23,10)

print(blk2(Y).shape)

"""

b1 = nn.Sequential(

nn.Conv2d(1,64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

)

num_channels, growth_rate = 64,32 # 第二個引數是指每一個折積層輸出為多少通道

num_convs_in_dense_blocks = [4,4,4,4] # 這個是每一個稠密塊中有多少個折積層

# 每個稠密塊4個折積層,每個折積層輸出為32,因此每個稠密塊增加通道數為4*32=128

blks = []

for i, num_convs in enumerate(num_convs_in_dense_blocks):

blks.append(DenseBlock(num_convs, num_channels, growth_rate))

num_channels += num_convs * growth_rate # 每個稠密塊執行完都要修改輸出通道數

if i != len(num_convs_in_dense_blocks) - 1:

# 在稠密塊之間新增轉換層,使其通道數量減半

blks.append(transition_block(num_channels, num_channels//2))

num_channels = num_channels // 2

net = nn.Sequential(

b1,

*blks,

nn.BatchNorm2d(num_channels),

nn.ReLU(),

nn.AdaptiveAvgPool2d((1,1)),

nn.Flatten(),

nn.Linear(num_channels,10)

)

lr, num_epochs, batch_size = 0.1, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=96)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

plt.show()

loss 0.144, train acc 0.947, test acc 0.896

1030.5 examples/sec on cuda:0

小結:

- 在跨層連線上,不同於ResNet中將輸入與輸出按元素相加,DenseNet在通道維上連線輸入和輸出

- DenseNet的主要構建模組是稠密塊與過渡層

- 在構建DenseNet時,我們需要通過新增過渡層來控制網路的維數,從而再次減少通道的數量

計算機視覺

影象增廣

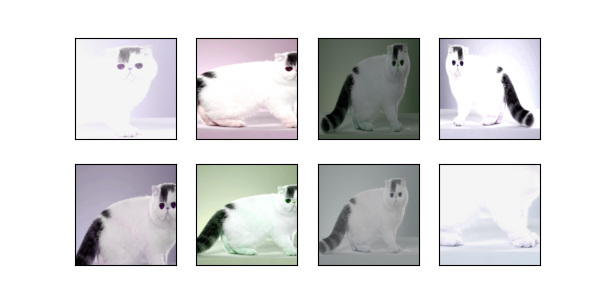

影象增廣實際上就是對資料進行增強,使得資料集具有更多的多樣性,常見的增強方法有:

- 切割:從圖片中切割一塊,然後變形到固定形狀

- 顏色:改變色調、飽和度、明亮度等等

具體程式碼如下:

import torch

import torchvision

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

d2l.set_figsize()

img = d2l.Image.open("cat.jpg")

d2l.plt.imshow(img)

plt.show()

定義函數方便應用各種變幻效果:

# 該函數可以將各種變幻直接用aug引數傳入

def apply(img, aug, num_row=2, num_cols=4, scale=1.5):

Y = [aug(img) for _ in range(num_row * num_cols)]

d2l.show_images(Y, num_row, num_cols, scale=scale)

翻轉:

左右翻轉:

apply(img, torchvision.transforms.RandomHorizontalFlip()) # 隨機左右翻轉

plt.show()

上下翻轉:

apply(img, torchvision.transforms.RandomVerticalFlip()) # 隨機上下翻轉

plt.show()

裁剪:

shape_aug = torchvision.transforms.RandomResizedCrop(

(200,200), scale=(0.1,1), ratio=(0.5,2)

) # 隨機裁剪面積為10%到100%,裁剪後縮放到200,寬高比從0.5到2之間取值

apply(img,shape_aug)

plt.show()

改變亮度:

apply(img, torchvision.transforms.ColorJitter(

brightness=0.5, contrast=0, saturation=0, hue=0

)) # 隨機改變亮度為原始的50% 到150%之間

plt.show()

改變色調:

apply(img, torchvision.transforms.ColorJitter(

brightness=0, contrast=0, saturation=0, hue=0.5))

plt.show()

隨機改變亮度、對比度、飽和度、色調:

color_aug = torchvision.transforms.ColorJitter(

brightness=0.5, contrast=0.5, saturation=0.5, hue=0.5)

apply(img, color_aug)

plt.show()

結合多種影象增廣辦法:

augs = torchvision.transforms.Compose([

torchvision.transforms.RandomHorizontalFlip(), color_aug, shape_aug])

apply(img, augs)

plt.show()

利用影象增廣來訓練模型:

batch_size, devices, net = 256, d2l.try_gpu(), d2l.resnet18(10,3)

def load_cifar10(is_train, augs, batch_size):

dataset = torchvision.datasets.CIFAR10(root="dataset", train=is_train,

transform=augs, download=True)

dataloader = DataLoader(dataset, batch_size=batch_size,

shuffle=is_train, num_workers=d2l.get_dataloader_workers())

return dataloader

def train_with_data_aug(train_augs, test_augs, net, lr=0.001):

train_iter = load_cifar10(True, train_augs, batch_size=batch_size)

test_iter = load_cifar10(False, test_augs, batch_size=batch_size)

loss = nn.CrossEntropyLoss(reduction='none')

trainer = torch.optim.Adam(net.parameters(),lr=lr)

d2l.train_ch6(net, train_iter, test_iter, 10, lr, devices)

train_augs = torchvision.transforms.Compose([

torchvision.transforms.RandomHorizontalFlip(), # 隨機左右翻轉

torchvision.transforms.ToTensor()])

test_augs = torchvision.transforms.Compose([ # 測試集不做增廣,只轉為tensor

torchvision.transforms.ToTensor()])

def init_weights(m):

if type(m) in [nn.Linear, nn.Conv2d]:

nn.init.xavier_uniform_(m.weight)

net.apply(init_weights)

train_with_data_aug(train_augs, test_augs, net)

plt.show()

因為我的電腦只有一個GPU,因此就直接用原來的訓練函數了。

不知道為什麼跑出來的結果就很爛...

loss 0.181, train acc 0.943, test acc 0.655

650.8 examples/sec on cuda:0

小結:

- 影象增廣基於現有的訓練資料生成隨機影象,來提高模型的泛化能力

- 為了在預測過程中得到確切的結果,我們通常只對訓練樣本進行影象增廣,而對於測試樣本不使用帶有隨機操作的影象增廣

- 深度學習框架提供了許多不同的影象增廣辦法,這些方法可以被同時應用

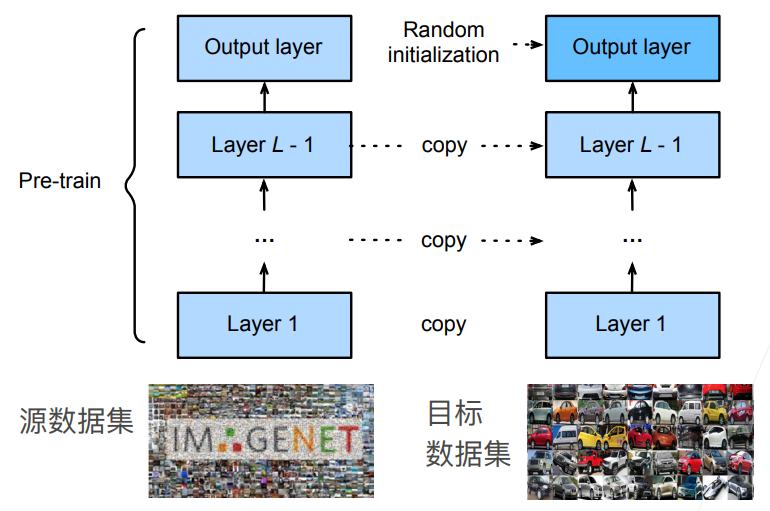

微調

一個神經網路一般可以分成兩個部分,分別是特徵抽取和線性分類器部分,前者將原始畫素變成容易線型分割的特徵,後者用來進行分類。

那麼如果我們擁有一個在龐巨量資料集上已經訓練好的模型,那麼可以認為特徵提取部分學習到了比較通用的提取方法,對我們想要應用的新資料集可能是有用的,而線性部分因為標籤已經發生了變化因此無法重複利用,因此一般是將已經訓練好的模型的特徵提取部分直接copy到新模型中,然後隨機初始化最後的線性分類層,這樣就叫做微調,

而在訓練的時候通常會採用更強的正則化,即在那些重用的特徵提取層的引數一般使用很小的學習率進行修改,並且學習迭代次數也比較少,而最後的線性分類層是使用較大的學習率來修改,甚至可以固定底部的某些特徵提取層不變(因為底部的才是更加通用的)來減少模型複雜度。

具體程式碼如下:

import os

import torch

import torchvision

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

#@save

from torch.utils.data import DataLoader

#d2l.DATA_HUB['hotdog'] = (d2l.DATA_URL + 'hotdog.zip','fba480ffa8aa7e0febbb511d181409f899b9baa5')

#data_dir = d2l.download_extract('hotdog')

data_dir = "dataset/hotdog/hotdog" # 因為我一直下載不了,就手動下載解壓到這個目錄下了

train_imgs = torchvision.datasets.ImageFolder(os.path.join(data_dir, 'train'))

test_imgs = torchvision.datasets.ImageFolder(os.path.join(data_dir, 'test'))

# 使用RGB通道的均值和標準差,以標準化每個通道

normalize = torchvision.transforms.Normalize(

[0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

# 這個是imageNet中資料的均值方差,因為模型在這上面訓練的時候進行了標準化,因此我們也需要標準化

train_augs = torchvision.transforms.Compose([

torchvision.transforms.RandomResizedCrop(224),

torchvision.transforms.RandomHorizontalFlip(),

torchvision.transforms.ToTensor(),

normalize])

test_augs = torchvision.transforms.Compose([

torchvision.transforms.Resize(256),

torchvision.transforms.CenterCrop(224),

torchvision.transforms.ToTensor(),

normalize])

finetune_net = torchvision.models.resnet18(pretrained=True) # 獲取預先訓練的模型

finetune_net.fc = nn.Linear(finetune_net.fc.in_features, 2) # 調整線性分類層

nn.init.xavier_uniform_(finetune_net.fc.weight) # 隨機初始化線性分類層的權重

# 如果param_group=True,輸出層中的模型引數將使用十倍的學習率

def train_fine_tuning(net, learning_rate, batch_size=128, num_epochs=5,

param_group=True):

train_iter = DataLoader(torchvision.datasets.ImageFolder(

os.path.join(data_dir, 'train'), transform=train_augs),

batch_size=batch_size, shuffle=True)

test_iter = DataLoader(torchvision.datasets.ImageFolder(

os.path.join(data_dir, 'test'), transform=test_augs),

batch_size=batch_size)

devices = d2l.try_all_gpus()

loss = nn.CrossEntropyLoss(reduction="none")

if param_group:

params_1x = [param for name, param in net.named_parameters()

if name not in ["fc.weight", "fc.bias"]]

trainer = torch.optim.SGD([{'params': params_1x},

{'params': net.fc.parameters(),

'lr': learning_rate * 10}],

lr=learning_rate, weight_decay=0.001)

else:

trainer = torch.optim.SGD(net.parameters(), lr=learning_rate,

weight_decay=0.001)

d2l.train_ch13(net, train_iter, test_iter, loss, trainer, num_epochs,

devices)

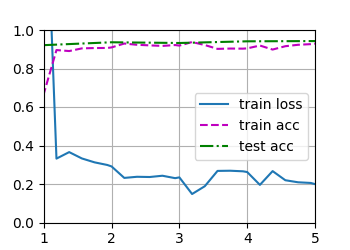

train_fine_tuning(finetune_net, 5e-5)

plt.show()

結果為:

loss 0.200, train acc 0.929, test acc 0.943

188.7 examples/sec on [device(type='cuda', index=0)]

可以看到效果是很好的。

小結:

- 遷移學習將從源資料集中學到的知識「遷移」到目標資料集,微調是遷移學習的常見技巧。

- 除輸出層外,目標模型從源模型中複製所有模型設計及其引數,並根據目標資料集對這些引數進行微調。但是,目標模型的輸出層需要從頭開始訓練。

- 通常,微調引數使用較小的學習率,而從頭開始訓練輸出層可以使用更大的學習率。

實戰Kaggle比賽:影象分類(CIFAR-10)

import collections

import math

import os

import shutil

import pandas as pd

import torch

import torchvision

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

from torch.utils.data import DataLoader

d2l.DATA_HUB['cifar10_tiny'] = (d2l.DATA_URL + 'kaggle_cifar10_tiny.zip',

'2068874e4b9a9f0fb07ebe0ad2b29754449ccacd')

# 如果你使用完整的Kaggle競賽的資料集,設定demo為False

demo = True

if demo:

data_dir = d2l.download_extract('cifar10_tiny')

else:

data_dir = 'dataset/cifar-10/'

# @save

def read_csv_labels(fname):

with open(fname, 'r') as f:

lines = f.readlines()[1:] # 跳過檔案頭一行

tokens = [l.rstrip().split(',') for l in lines]

return dict(((name, label) for name, label in tokens))

#@save

def copyfile(filename, target_dir):

# 將檔案複製到目標路徑,一個類別佔有一個資料夾

os.makedirs(target_dir, exist_ok=True)

shutil.copy(filename, target_dir)

#@save

def reorg_train_valid( data_dir, labels, valid_ratio):

# 該函數將驗證集從原始的訓練集中拆分出來

n = collections.Counter(labels.values()).most_common()[-1][1] # 取出訓練資料集中樣本最少的類別中的樣本數

n_valid_per_label = max(1, math.floor(n * valid_ratio)) # 至少不能小於1

label_count = {}

for train_file in os.listdir(os.path.join(data_dir, 'train')): # 該資料夾下的類別名稱的檔名列表

label = labels[train_file.split(".")[0]]

fname = os.path.join(data_dir, "train", train_file)

copyfile(fname, os.path.join(data_dir, "train_valid_test","train_valid", label))

if label not in label_count or label_count[label] < n_valid_per_label:

copyfile(fname, os.path.join(data_dir, "train_valid_test", "valid", label))

label_count[label] = label_count.get(label,0) + 1

else:

copyfile(fname, os.path.join(data_dir, "train_valid_test", "train", label))

return n_valid_per_label

#@save

def reorg_test(data_dir):

# 在預測期間整理測試集方便讀取

for test_file in os.listdir(os.path.join(data_dir, 'test')):

copyfile(os.path.join(data_dir, 'test', test_file),

os.path.join(data_dir, 'train_valid_test','test','unknown'))

def reorg_cifar10_data(data_dir, valid_ratio):

labels = read_csv_labels(os.path.join(data_dir, 'trainLabels.csv'))

reorg_train_valid( data_dir, labels, valid_ratio)

reorg_test(data_dir)

def get_net():

num_classes = 10

net = d2l.resnet18(num_classes,3)

return net

def train(net, train_iter, valid_iter, num_epochs, lr, wd, devices, lr_period, lr_decay):

# 這裡主要不同是後面兩個引數,就是學習率每經過幾個epoch後就乘以lr_decay來縮小

trainer = torch.optim.SGD(net.parameters(), lr=lr, momentum=0.9, weight_decay=wd)

scheduler = torch.optim.lr_scheduler.StepLR(trainer, lr_period,lr_decay)

# 這個就可以存取trainer中的lr並修改了

num_batches, timer = len(train_iter), d2l.Timer()

legend = ['train loss', 'train acc']

if valid_iter is not None:

legend.append('valid acc')

animator = d2l.Animator(xlabel='epoch', xlim=[1, num_epochs],legend=legend)

net = nn.DataParallel(net, device_ids=devices).to(devices[0])

for epoch in range(num_epochs):

net.train()

metric = d2l.Accumulator(3)

for i, (features, labels) in enumerate(train_iter):

timer.start()

l, acc = d2l.train_batch_ch13(net, features, labels,

loss, trainer, devices)

metric.add(l, acc, labels.shape[0])

timer.stop()

if (i + 1) % (num_batches // 5) == 0 or i == num_batches - 1:

animator.add(epoch + (i + 1) / num_batches,

(metric[0] / metric[2], metric[1] / metric[2],

None))

if valid_iter is not None:

valid_acc = d2l.evaluate_accuracy_gpu(net, valid_iter)

animator.add(epoch + 1, (None, None, valid_acc))

scheduler.step() # 更新學習率

print("第{}個epoch已更新完成!".format(epoch+1))

measures = (f'train loss {metric[0] / metric[2]:.3f}, '

f'train acc {metric[1] / metric[2]:.3f}')

if valid_iter is not None:

measures += f', valid acc {valid_acc:.3f}'

print(measures + f'\n{metric[2] * num_epochs / timer.sum():.1f}'

f' examples/sec on {str(devices)}')

if __name__ == '__main__':

labels = read_csv_labels(os.path.join(data_dir, 'trainLabels.csv'))

print("訓練樣本數目為:\t", len(labels))

print("類別數目為:\t", len(set(labels.values())))

batch_size = 32 if demo else 128

valid_ratio = 0.1

reorg_cifar10_data(data_dir, valid_ratio)

# 下面做影象的增廣

transform_train = torchvision.transforms.Compose(

[torchvision.transforms.Resize(40), # 因為原尺寸32,加大到40後再隨機裁剪32的大小

torchvision.transforms.RandomResizedCrop(32, scale=(0.64,1.0), ratio=(1.0,1.0)),

# 裁剪後生成一個面積為原來0.64到1倍大小的正方形(ratio保持不變就是原來的比例)

torchvision.transforms.RandomHorizontalFlip(),

torchvision.transforms.ToTensor(),

torchvision.transforms.Normalize([0.4914, 0.4822,0.4465],[0.2023,0.1994,0.2010])

# 這是imageNet資料集三個通道的均值和方差

])

transform_test = torchvision.transforms.Compose([

torchvision.transforms.ToTensor(),

torchvision.transforms.Normalize([0.4914, 0.4822, 0.4465], [0.2023, 0.1994, 0.2010])

])

train_ds, train_valid_ds = [torchvision.datasets.ImageFolder(

os.path.join(data_dir, "train_valid_test",folder),

transform=transform_train) for folder in ['train','train_valid']]

valid_ds, test_ds = [torchvision.datasets.ImageFolder(

os.path.join(data_dir, "train_valid_test",folder),

transform=transform_test) for folder in ['valid','test']]

train_iter, train_valid_iter = [DataLoader(dataset, batch_size, shuffle=True, drop_last=True)

for dataset in (train_ds, train_valid_ds)] # shuffle隨機打亂

valid_iter = DataLoader(valid_ds, batch_size, shuffle=False, drop_last=True)

test_iter = DataLoader(test_ds, batch_size, shuffle=False, drop_last=False)

loss = nn.CrossEntropyLoss(reduction='none')

devices, num_epochs, lr,wd = d2l.try_all_gpus(), 20, 5e-4, 5e-4

lr_period, lr_decay, net = 4, 0.9, get_net()

train(net, train_iter, valid_iter, num_epochs, lr, wd, devices, lr_period, lr_decay)

plt.show()

# 訓練完,前面是根據驗證集不斷調整引數,調整好了現在要將驗證集加入然後重新按照剛才的引數訓練來預測

net, preds = get_net(), []

train(net, train_valid_iter, None, num_epochs, lr, wd, devices, lr_period, lr_decay)

plt.show()

for X,_ in test_iter:

y_hat = net(X.to(devices[0]))

preds.extend(y_hat.argmax(dim=1).type(torch.int32).cpu().numpy())

sorted_ids = list(range(1,len(test_ds) + 1))

sorted_ids.sort(key=lambda x:str(x))

df = pd.DataFrame({'id':sorted_ids,"label":preds})

df['label'] = df['label'].apply(lambda x : train_valid_ds.classes[x])

df.to_csv("submission_cifar10.csv",index=False)

訓練結果為:

train loss 1.088, train acc 0.609, valid acc 0.391

482.5 examples/sec on [device(type='cuda', index=0)]

train loss 0.936, train acc 0.653

521.7 examples/sec on [device(type='cuda', index=0)]

實戰Kaggle比賽:狗的品種識別

import os

import torch

import torchvision

from matplotlib import pyplot as plt

from torch import nn

from d2l import torch as d2l

# @save

from torch.utils.data import DataLoader

d2l.DATA_HUB['dog_tiny'] = (d2l.DATA_URL + 'kaggle_dog_tiny.zip',

'0cb91d09b814ecdc07b50f31f8dcad3e81d6a86d')

# 如果你使用Kaggle比賽的完整資料集,請將下面的變數更改為False

demo = True

if demo:

data_dir = d2l.download_extract('dog_tiny')

else:

data_dir = os.path.join('dataset', 'dog-breed-identification')

# 這裡同樣是整理資料集,將資料集按照標籤分類到對應的資料夾中

def reorg_dog_data(data_dir, valid_ratio):

labels = d2l.read_csv_labels(os.path.join(data_dir, 'labels.csv'))

d2l.reorg_train_valid(data_dir, labels, valid_ratio) # 這個函數在上個實戰中已經實現過

d2l.reorg_test(data_dir) # 測試集也是一樣

# 載入預訓練好的模型

def get_net(devices):

finetune_net = nn.Sequential() # 一開始是空的

finetune_net.features = torchvision.models.resnet34(pretrained=True) # 新增一個名為特徵的Sequential

# 其內容就是resnet34的整個模型

# 定義一個新的輸出網路,共有120個輸出類別,因為原始的resnet34輸出為1000,因此需要從1000開始

finetune_net.output_new = nn.Sequential(nn.Linear(1000, 256), nn.ReLU(), nn.Linear(256, 120))

# 將模型引數分配給用於計算的CPU或GPU

finetune_net = finetune_net.to(devices[0])

# 特徵提取部分不更新,因為資料集是imageNet的子集

for param in finetune_net.features.parameters():

param.requires_grad = False

return finetune_net

# 用來計算損失

def evaluate_loss(data_iter, net, devices):

l_sum, n = 0.0, 0

for features, labels in data_iter:

features, labels = features.to(devices[0]), labels.to(devices[0])

outputs = net(features)

l = loss(outputs, labels)

l_sum += l.sum()

n += labels.numel()

return (l_sum / n).to('cpu')

# 定義訓練函數

def train(net, train_iter, valid_iter, num_epochs, lr, wd, devices, lr_period,

lr_decay):

# 只訓練小型自定義輸出網路

net = nn.DataParallel(net, device_ids=devices).to(devices[0]) # 多GPU

trainer = torch.optim.SGD((param for param in net.parameters() # 這裡是必須requires_grad為True才訓練

if param.requires_grad), lr=lr, # 也就只有我們剛才新增的MLP

momentum=0.9, weight_decay=wd)

scheduler = torch.optim.lr_scheduler.StepLR(trainer, lr_period, lr_decay)

num_batches, timer = len(train_iter), d2l.Timer()

legend = ['train loss']

if valid_iter is not None:

legend.append('valid loss')

animator = d2l.Animator(xlabel='epoch', xlim=[1, num_epochs],

legend=legend)

for epoch in range(num_epochs):

metric = d2l.Accumulator(2)

for i, (features, labels) in enumerate(train_iter):

timer.start()

features, labels = features.to(devices[0]), labels.to(devices[0])

trainer.zero_grad()

output = net(features)

l = loss(output, labels).sum()

l.backward()

trainer.step()

metric.add(l, labels.shape[0])

timer.stop()

if (i + 1) % (num_batches // 5) == 0 or i == num_batches - 1:

animator.add(epoch + (i + 1) / num_batches,

(metric[0] / metric[1], None))

measures = f'train loss {metric[0] / metric[1]:.3f}'

if valid_iter is not None:

valid_loss = evaluate_loss(valid_iter, net, devices)

animator.add(epoch + 1, (None, valid_loss.detach().cpu()))

scheduler.step()

if valid_iter is not None:

measures += f', valid loss {valid_loss:.3f}'

print(measures + f'\n{metric[1] * num_epochs / timer.sum():.1f}'

f' examples/sec on {str(devices)}')

if __name__ == '__main__':

batch_size = 32 if demo else 128

valid_ratio = 0.1

reorg_dog_data(data_dir, valid_ratio)

# 進行影象增廣處理

transform_train = torchvision.transforms.Compose([

torchvision.transforms.RandomResizedCrop(224, scale=(0.08, 1.0), ratio=(3.0 / 4.0, 4.0 / 3.0)),

# 隨機裁剪影象,面積為原來的0.08到1之間,並且高寬比控制在3/4到4/3之間,然後縮放到224的大小

torchvision.transforms.RandomHorizontalFlip(),

torchvision.transforms.ColorJitter(brightness=0.4, contrast=0.4, saturation=0.4),

# 隨機改變亮度、對比度和飽和度

torchvision.transforms.ToTensor(),

torchvision.transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

])

transform_test = torchvision.transforms.Compose([

torchvision.transforms.Resize(256), # 先縮放的256

# 從影象中心裁切224x224大小的圖片

torchvision.transforms.CenterCrop(224),

torchvision.transforms.ToTensor(),

torchvision.transforms.Normalize([0.485, 0.456, 0.406],

[0.229, 0.224, 0.225])])

# 讀取資料集

train_ds, train_valid_ds = [torchvision.datasets.ImageFolder(