MindStudio模型訓練場景精度比對全流程和結果分析

摘要:MindStudio是一套基於華為昇騰AI處理器開發的AI全棧開發平臺

本文分享自華為雲社群《MindStudio模型訓練場景精度比對全流程和結果分析》,作者:yd_247302088 。

一、基於MindStudio模型精度比對介紹

1.1 MindStudio介紹

MindStudio是一套基於華為昇騰AI處理器開發的AI全棧開發平臺,包括基於晶片的運算元開發、以及自定義運算元開發,同時還包括網路層的網路移植、優化和分析,另外在業務引擎層提供了視覺化的AI引擎拖拽式程式設計服務,極大的降低了AI引擎的開發門檻。MindStudio工具中的功能框架如圖1所示:

圖1 MindStudio功能框架

MindStudio工具中的主要幾個功能特性如下:

- 工程管理:為開發人員提供建立工程、開啟工程、關閉工程、刪除工程、新增工程檔案目錄和屬性設定等功能。

- SSH管理:為開發人員提供新增SSH連線、刪除SSH連線、修改SSH連線、加密SSH密碼和修改SSH密碼儲存方式等功能。

- 應用開發:針對業務流程開發人員,MindStudio工具提供基於AscendCL(Ascend Computing Language)和整合MindX SDK的應用開發程式設計方式,程式設計後的編譯、執行、結果顯示等一站式服務讓流程開發更加智慧化,可以讓開發者快速上手。

- 自定義運算元開發:提供了基於TBE和AI CPU的運算元程式設計開發的整合式開發環境,讓不同平臺下的運算元移植更加便捷,適配昇騰AI處理器的速度更快。

- 離線模型轉換:訓練好的第三方網路模型可以直接通過離線模型工具匯入並轉換成離線模型,並可一鍵式自動生成模型介面,方便開發者基於模型介面進行程式設計,同時也提供了離線模型的視覺化功能。

- 紀錄檔管理:MindStudio為昇騰AI處理器提供了覆蓋全系統的紀錄檔收集與紀錄檔分析解決方案,提升執行時演演算法問題的定位效率。提供了統一形式的跨平臺紀錄檔視覺化分析能力及執行時診斷能力,提升紀錄檔分析系統的易用性。

- 效能分析:MindStudio以圖形介面呈現方式,實現針對主機和裝置上多節點、多模組異構體系的高效、易用、可靈活擴充套件的系統化效能分析,以及針對昇騰AI處理器的效能和功耗的同步分析,滿足演演算法優化對系統效能分析的需求。

- 裝置管理:MindStudio提供裝置管理工具,實現對連線到主機上的裝置的管理功能。

- 精度比對:可以用來比對自有模型運算元的運算結果與Caffe、TensorFlow、ONNX標準運算元的運算結果,以便用來確認神經網路運算誤差發生的原因。

- 開發工具包的安裝與管理:為開發者提供基於昇騰AI處理器的相關演演算法開發套件包Ascend-cann-toolkit,旨在幫助開發者進行快速、高效的人工智慧演演算法開發。開發者可以將開發套件包安裝到MindStudio上,使用MindStudio進行快速開發。Ascend-cann-toolkit包含了基於昇騰AI處理器開發依賴的標頭檔案和庫檔案、編譯工具鏈、調優工具等。

1.2 精度比對介紹

自有實現的運算元在昇騰AI處理器上的運算結果與業界標準運算元(如Caffe、ONNX、TensorFlow、PyTorch)的運算結果可能存在差異:

- 在模型轉換過程中對模型進行了優化,包括運算元消除、運算元融合、運算元拆分,這些動作可能會造成自有實現的運算元運算結果與業界標準運算元(如Caffe、TensorFlow、ONNX)運算結果存在偏差。

- 使用者原始網路可以遷移到昇騰910 AI處理器上執行訓練,網路遷移可能會造成自有實現的運算元運算結果與用業界標準運算元(如TensorFlow、PyTorch)運算結果存在偏差。

為了幫助開發人員快速解決運算元精度問題,需要提供比對自有實現的運算元運算結果與業界標準運算元運算結果之間差距的工具。精度比對工具提供Vector比對能力,包含餘弦相似度、最大絕對誤差、累積相對誤差、歐氏相對距離、KL散度、標準差、平均絕對誤差、均方根誤差、最大相對誤差、平均相對誤差的演演算法比對維度。

二、環境準備

在進行實驗之前需要設定好遠端Linux伺服器並下載安裝MindStudio。

首先在Linux伺服器上安裝部署好Ascend-cann-toolkit開發套件包、Ascend-cann-tfplugin框架外掛包和TensorFlow 1.15.0深度學習框架。之後在Windows上安裝MindStudio,安裝完成後通過設定遠端連線的方式建立MindStudio所在的Windows伺服器與Ascend-cann-toolkit開發套件包所在的Linux伺服器的連線,實現全流程開發功能。

接下來設定環境變數,以執行使用者登入伺服器,在任意目錄下執行vi ~/.bashrc命令,開啟.bashrc檔案,在檔案最後一行後面新增以下內容(以非root使用者的預設安裝路徑為例)。

然後執行:wq!命令儲存檔案並退出。

最後執行source ~/.bashrc命令使其立即生效。

關於MindStudio的具體安裝流程可以參考Windows安裝MindStudio(點我跳轉),MindStudio環境搭建指導視訊(點我跳轉)。MindStudio官方下載地址:點我跳轉。

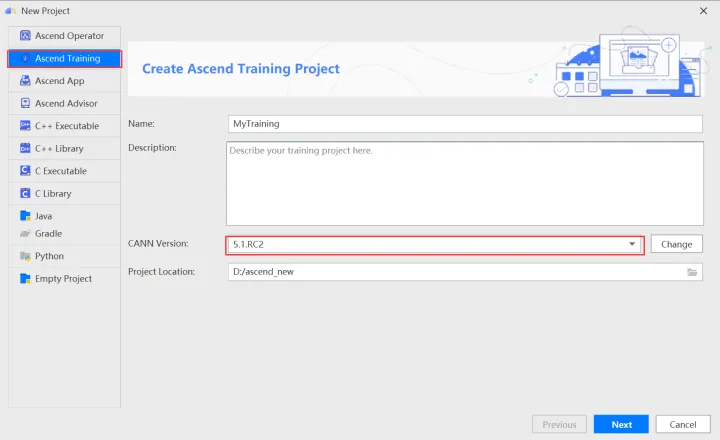

本文教學基於MindStudio5.0.RC2 x64,CANN版本5.1.RC2實現。

三、準備基於GPU執行生成的原始訓練網路npy資料檔案

3.1 獲取專案程式碼

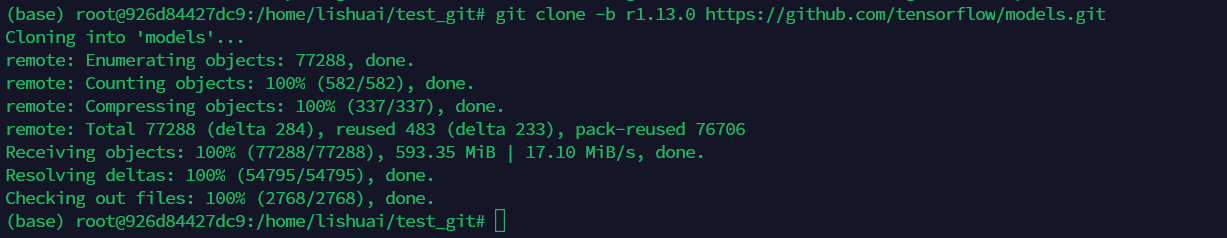

本樣例選擇resnet50模型,利用git克隆程式碼(git clone -b r1.13.0 https://github.com/tensorflow/models.git),下載成功後如下圖所示:

3.2 生成資料前處理

資料比對前,需要先檢查並去除訓練指令碼內部使用到的隨機處理,避免由於輸入資料不一致導致資料比對結果不可用。

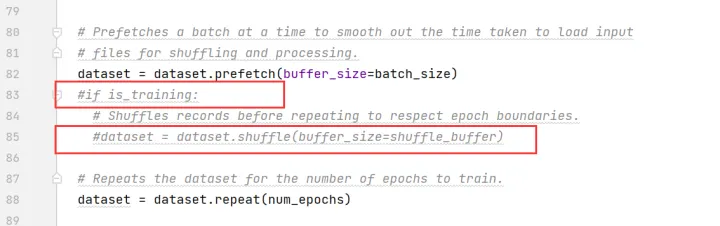

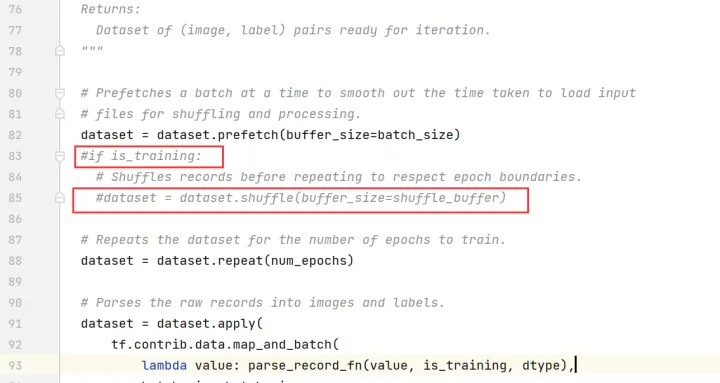

編輯resnet_run_loop.py檔案,修改如下(以下行數僅為範例,請以實際為準):

註釋掉第83、85行

註釋掉第587~594行

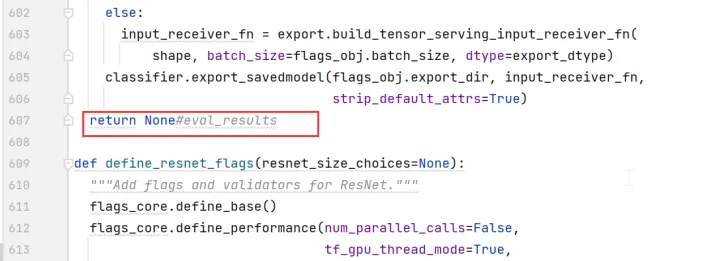

第607行,修改為「return None」

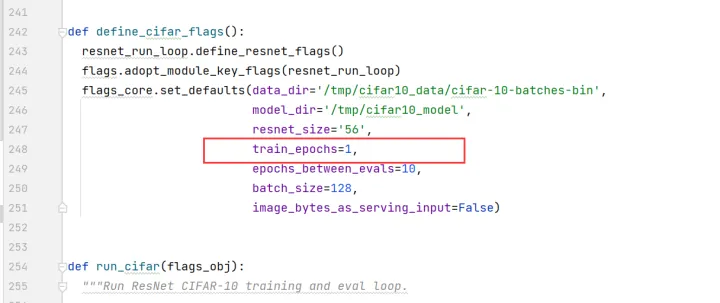

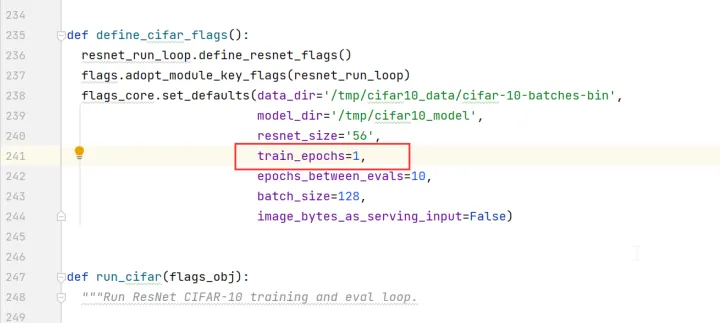

編輯cifar10_main.py檔案,將train_epochs的值改為1。

3.3 生成npy檔案

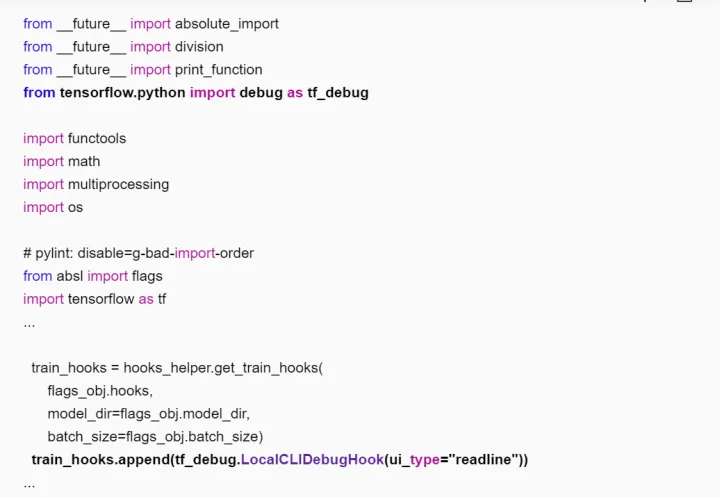

進入訓練指令碼所在目錄(如「~/models/official/resnet」),修改訓練指令碼,新增tfdbg的hook。編輯resnet_run_loop.py檔案,新增如下加粗字型的資訊。

設定環境變數

執行訓練指令碼

訓練任務停止後,在命令列輸入run,訓練會往下執行一個step。

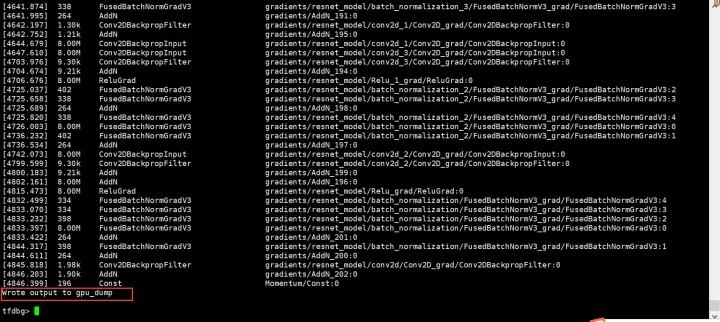

執行lt>gpu_dump命令將所有tensor的名稱暫存到自定義名稱的gpu_dump檔案裡。命令列中會有如下回顯。

另外開啟一個終端,在linux命令列下進入gpu_dump檔案所在目錄,執行下述命令,用以生成在tfdbg命令列執行的命令。

timestamp=$[$(date +%s%N)/1000] ; cat gpu_dump | awk '{print "pt",$4,$4}' | awk '{gsub("/", "_", $3);gsub(":", ".", $3);print($1,$2,"-n 0 -w "$3".""'$timestamp'"".npy")}'>dump.txt

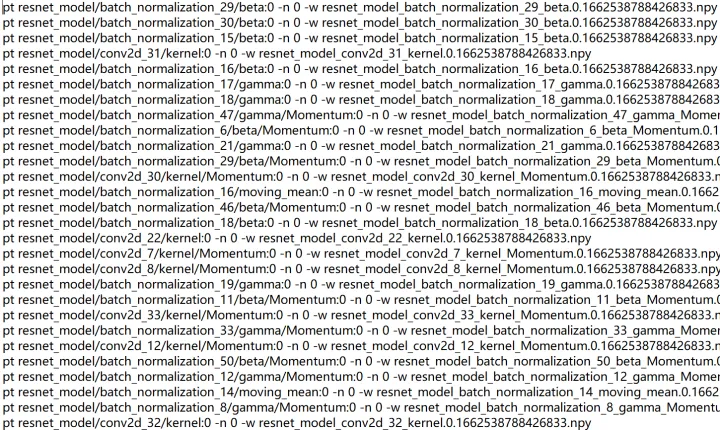

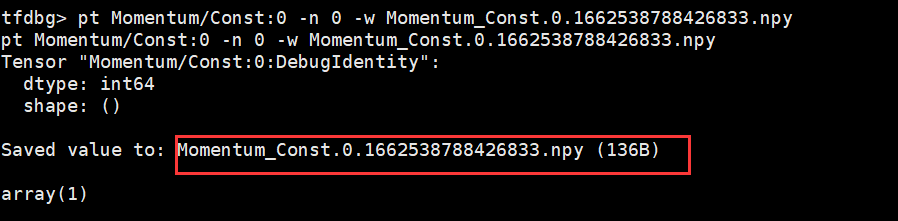

將上一步生成的dump.txt檔案中所有tensor儲存的命令複製(所有以「pt」開頭的命令),然後回到tfdbg命令列(剛才執行訓練指令碼的控制檯)貼上執行,即可儲存所有的npy檔案,儲存路徑為訓練指令碼所在目錄。

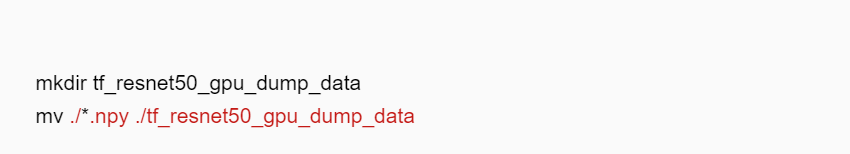

退出tfdbg命令列,將生成的npy檔案儲存到tf_resnet50_gpu_dump_data(使用者可自定義)目錄下。

四、準備基於NPU執行生成的訓練網路dump資料和計算圖檔案

4.1 分析遷移

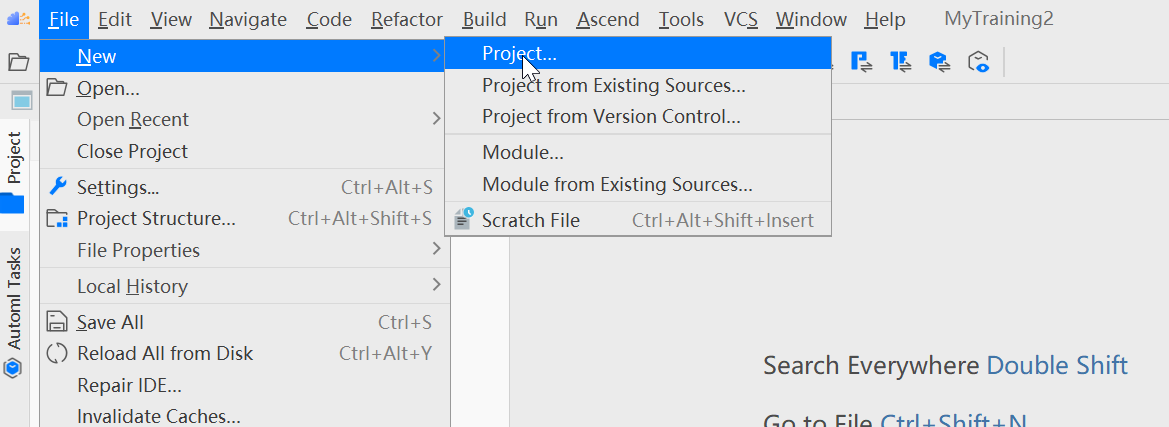

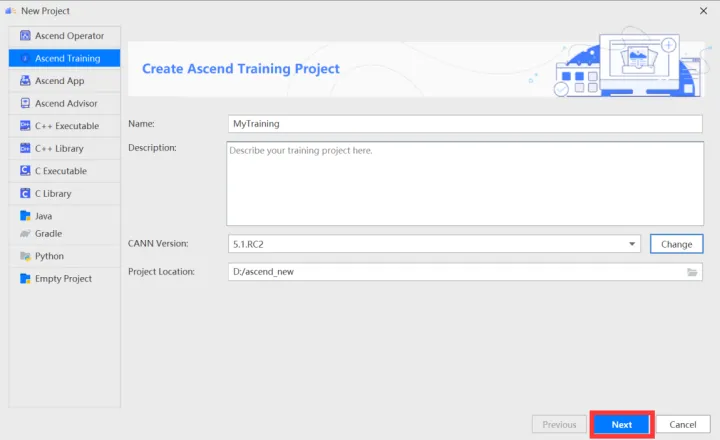

單擊選單欄「File > New > Project...」彈出「New Project」視窗。

在New Project視窗中,選擇Ascend Training。輸入專案的名稱、CANN遠端地址以及本地地址。點選Change設定CANN,如下圖所示:

- Name:工程名稱,可自定義。

- Description:工程描述,可按需補充關於工程的詳細資訊。

- CANN Version:CANN軟體包版本,如未識別或想要更換使用的版本,可單擊「Change」,在彈出介面中選擇Ascend-cann-toolkit開發套件包的安裝路徑(注意需選擇到版本號一級)。

- Project Location:工程目錄,預設在「$HOME/AscendProjects」下建立。

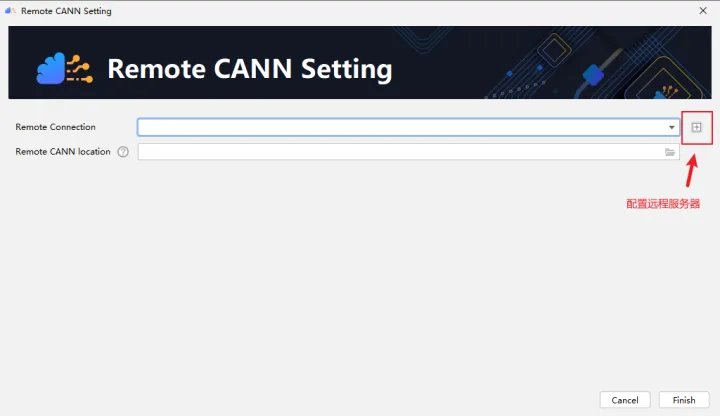

點選右側 + 進行設定遠端伺服器,如下圖所示:

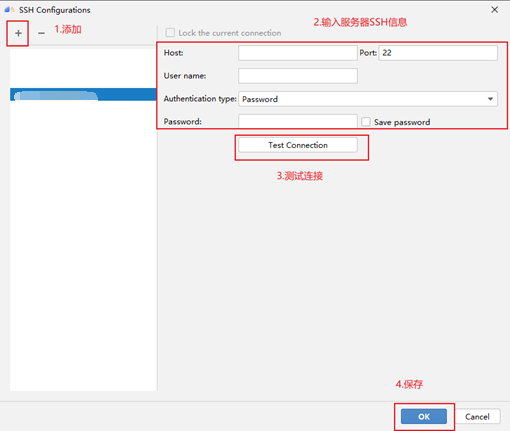

在出現的資訊設定框輸入相關設定資訊,如下圖所示:

輸入伺服器的SSH資訊,如果測試連線失敗,建議使用CMD或XShell等工具進行排查。

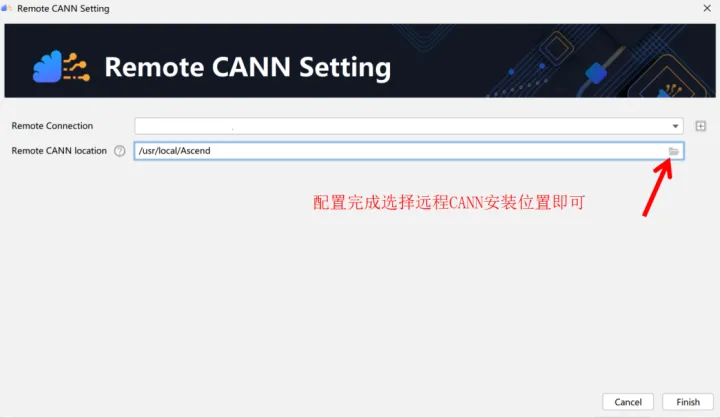

選擇遠端 CANN 安裝位置,如下圖所示:

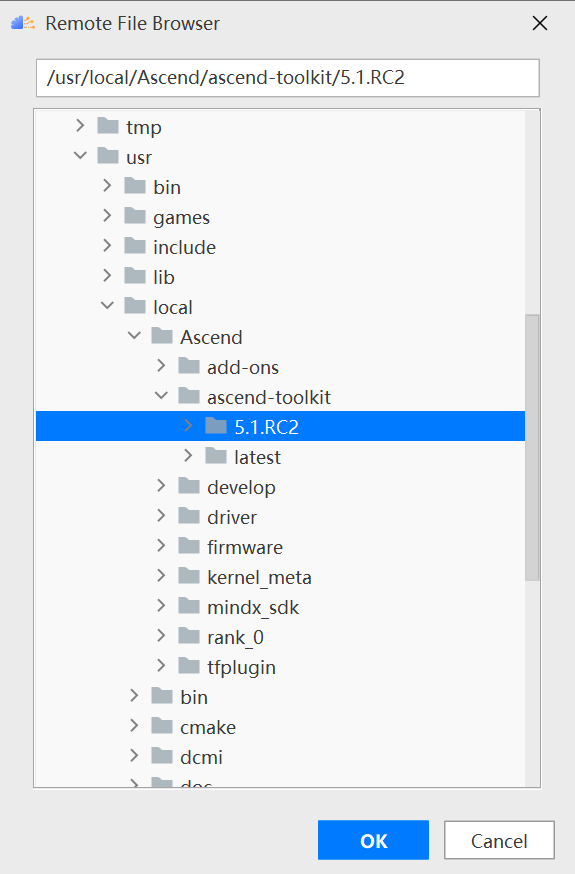

在Remote CANN location中選擇CANN的路徑,需要注意的是必須選擇到CANN的版本號目錄,這裡選擇的是5.1.RC2版本,如下圖所示:

點選確定後,需要等待MindStudio進行檔案同步操作,這個過程會持續數分鐘,期間如果遇到Sync remote CANN files error.錯誤,考慮是否無伺服器root許可權。

設定完成CANN點選下一步

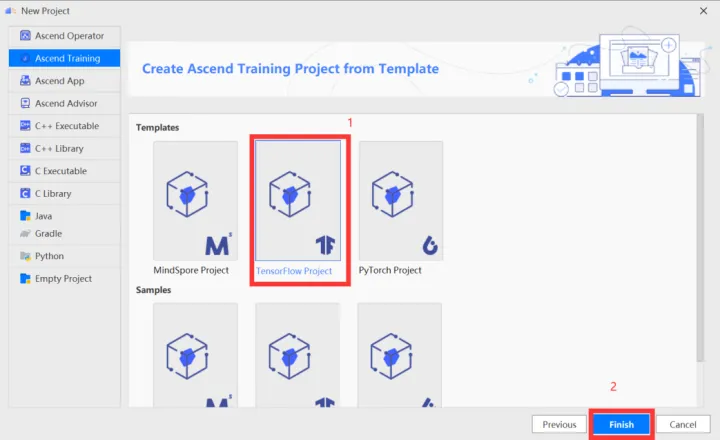

在訓練工程選擇介面,選擇「TensorFlow Project」,單擊「Finish」。

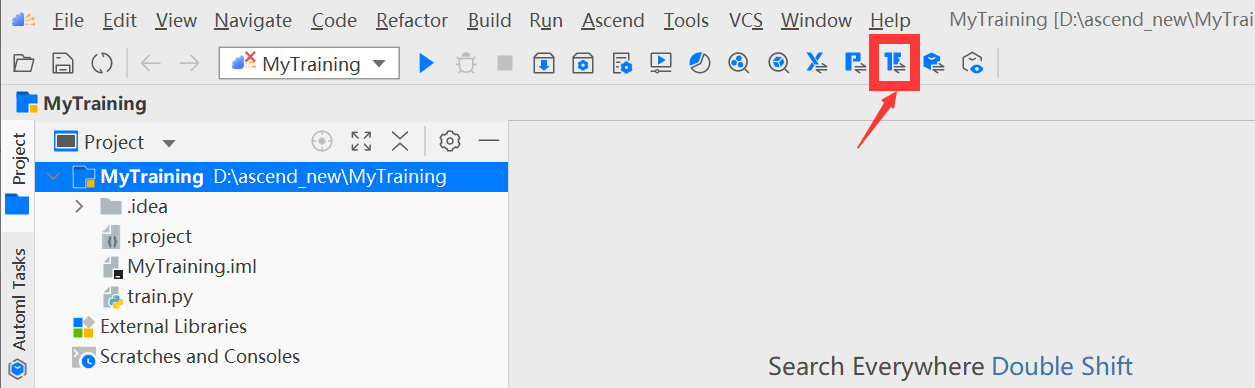

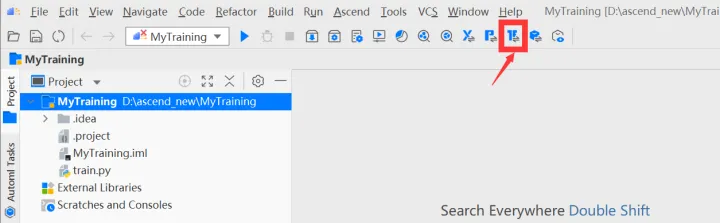

進入工程介面,單擊工具列中

按鈕( TensorFlow GPU2Ascend工具)。

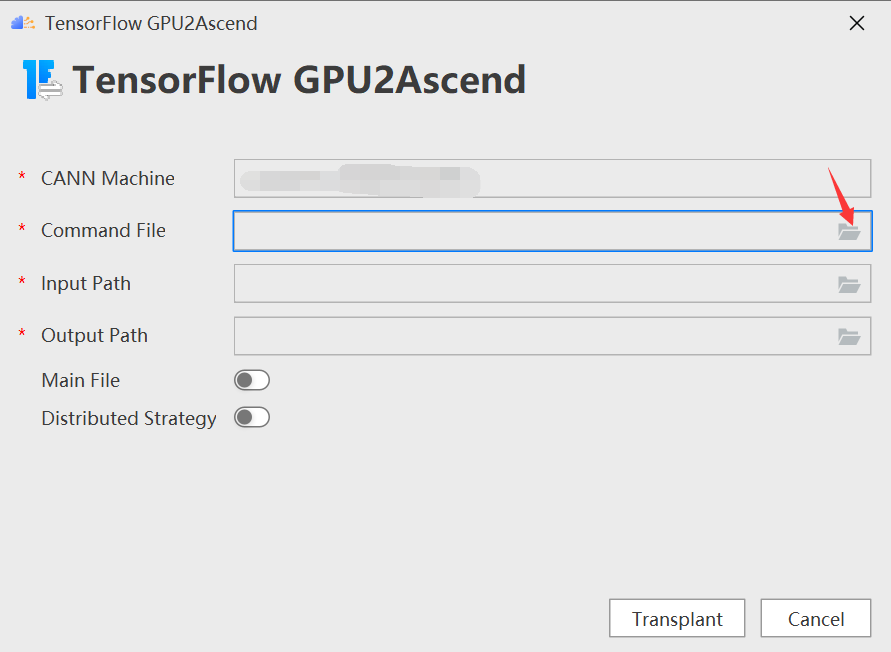

進入「TensorFlow GPU2Ascend」引數設定頁,設定command file

- Command File:tfplugin外掛包中的工具指令碼檔案。

- Input Path:待轉換指令碼檔案的路徑。

- Output Path:指令碼轉換後的輸出路徑。

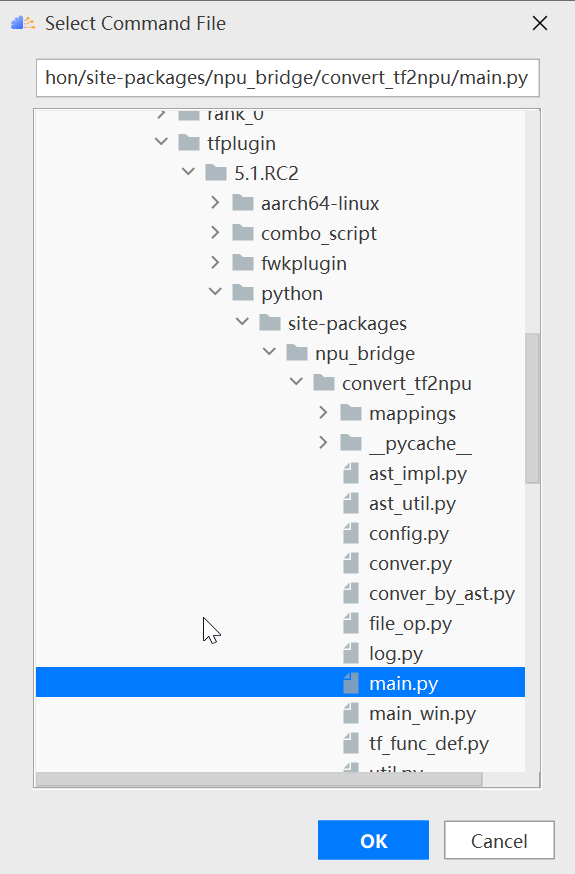

根據tfplugin檔案所在路徑選擇/Ascend/tfplugin/5.1.RC2/python/site-packages/npu_bridge/convert_tf2npu/main.py,如下圖所示

同樣的,選擇下載的程式碼路徑作為input path,並選擇輸出路徑,如下圖所示:

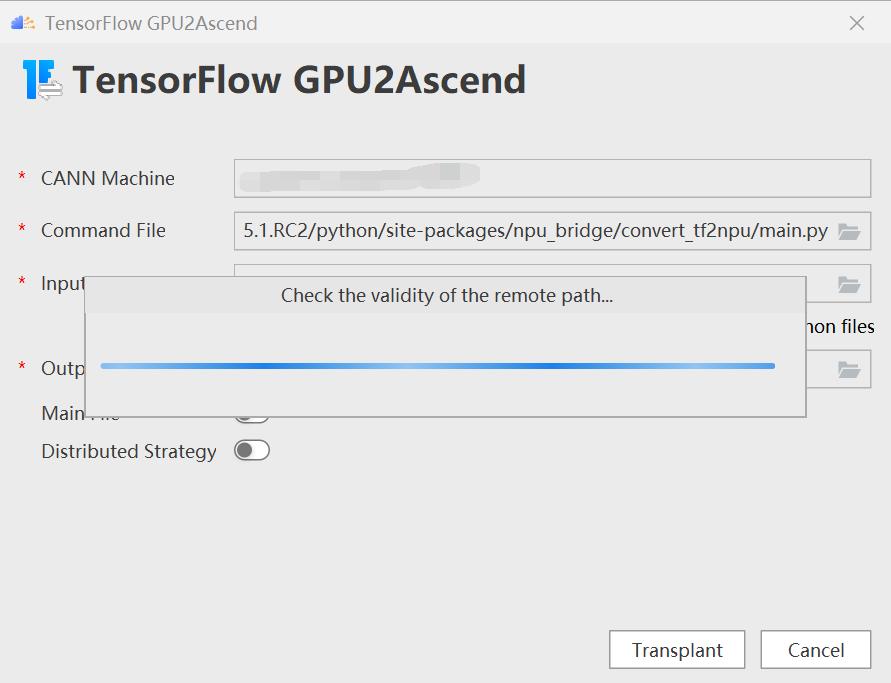

點選Transplant進行轉換,如下圖所示:

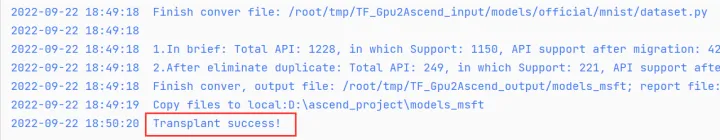

出現「Transplant success!」的回顯資訊,即轉換成功。如下圖所示:

4.2 生成dump資料和計算圖檔案

步驟一 dump前準備。

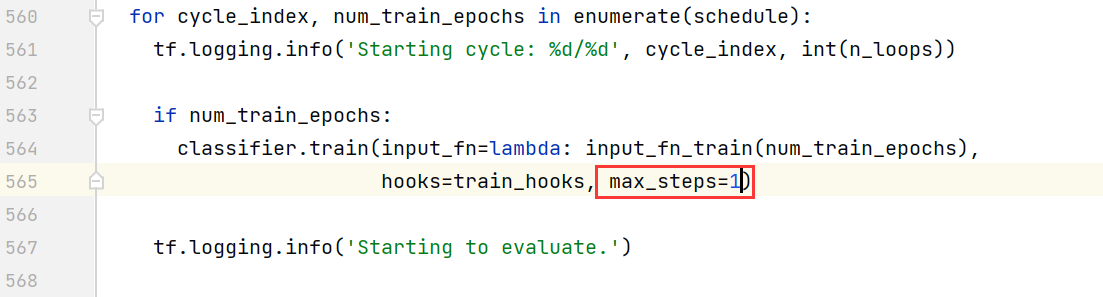

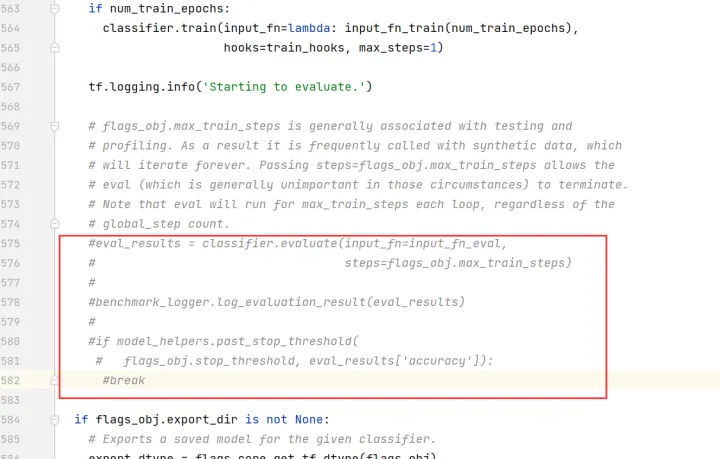

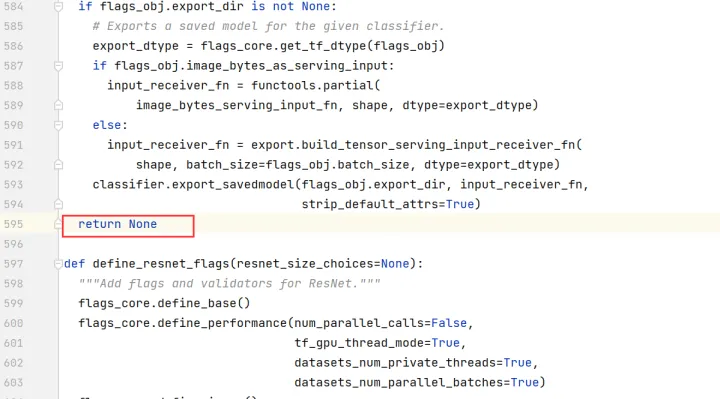

編輯resnet_run_loop.py檔案,修改如下(以下行數僅為範例,請以實際為準):

註釋掉第83、85行

把max_steps設定為1。

註釋掉第575~582行

註釋掉第595行,修改為「return None」。

編輯cifar10_main.py檔案,將train_epochs的值改為1。

步驟二 dump引數設定。

為了讓訓練指令碼能夠dump出計算圖,我們在訓練指令碼中的包參照區域引入os,並在構建模型前設定DUMP_GE_GRAPH引數。設定完成後,在訓練過程中,計算圖檔案會儲存在訓練指令碼所在目錄中。

編輯cifar10_main.py,新增如下方框中的資訊。

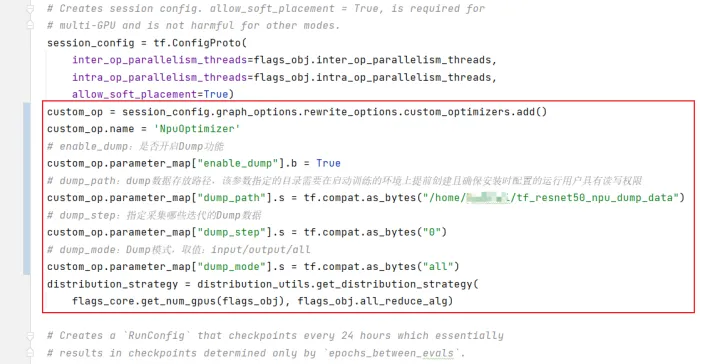

修改訓練指令碼(resnet_run_loop.py),開啟dump功能。在相應程式碼中,增加如下方框中的資訊。

步驟三 環境設定。

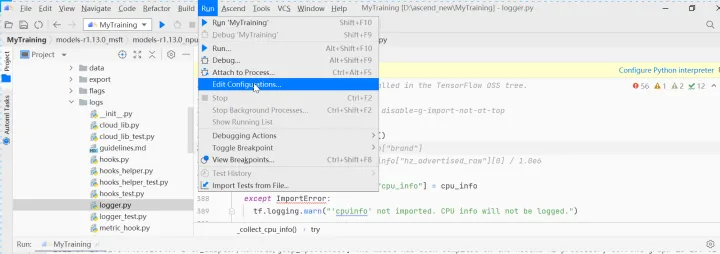

單擊MindStudio選單欄「Run > Edit Configurations...」。

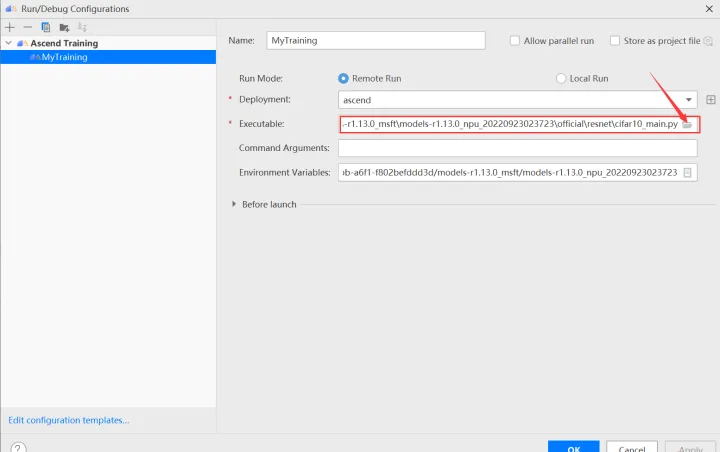

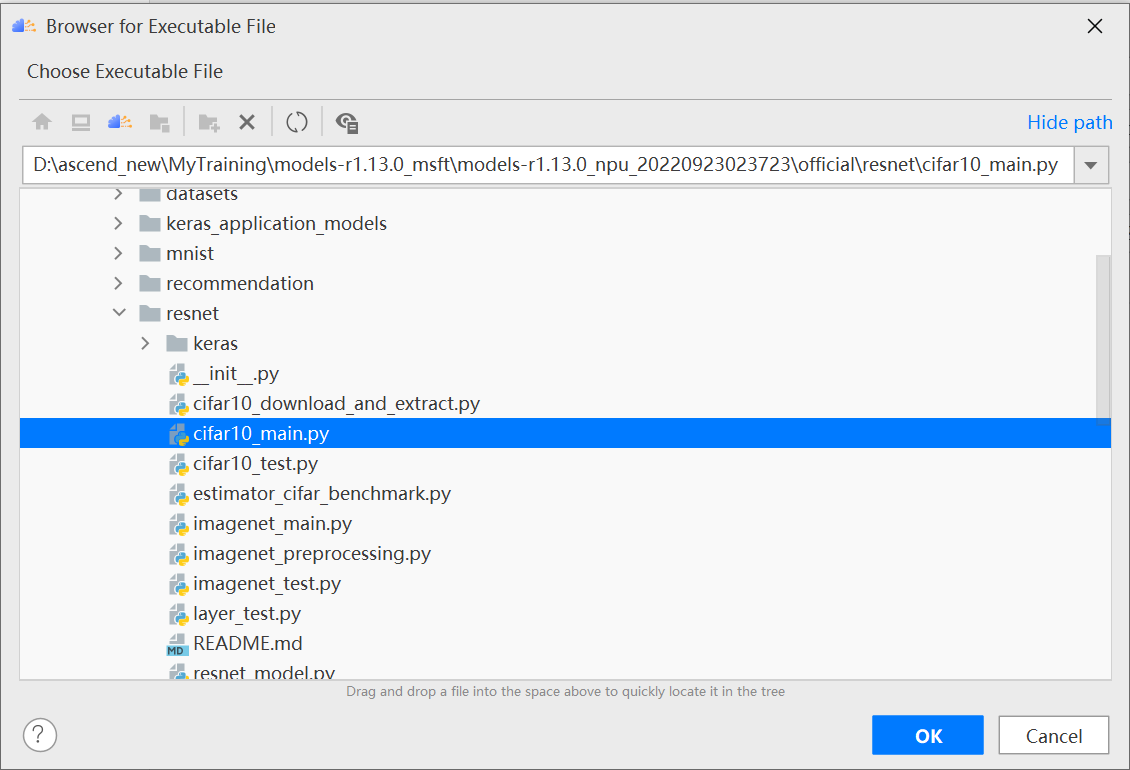

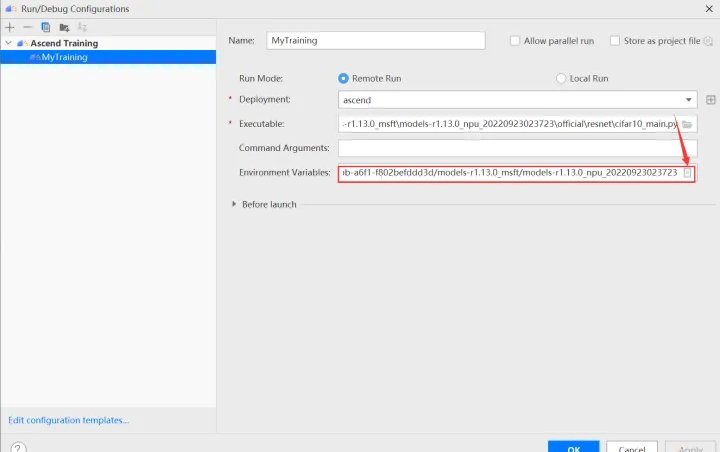

進入執行設定介面,選擇遷移後的訓練指令碼。

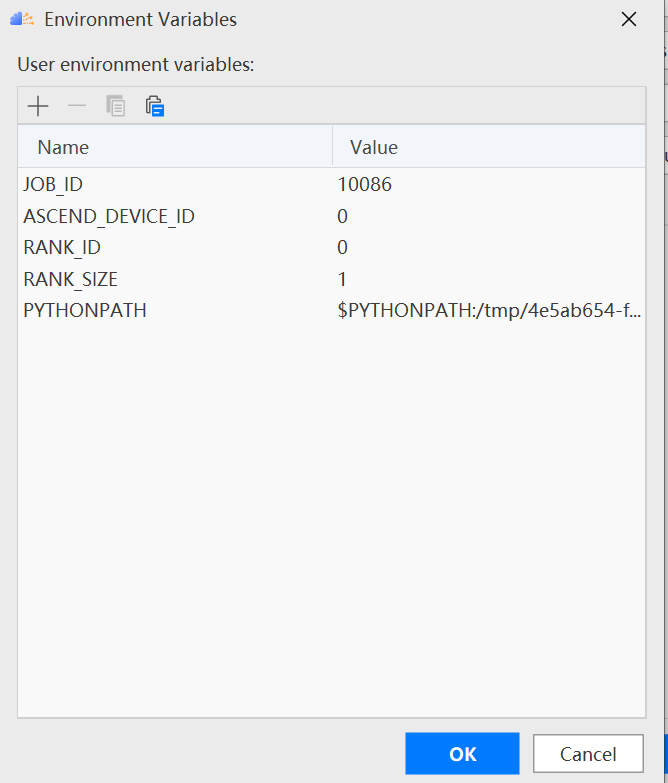

設定環境變數,開啟下圖所示介面,設定訓練程序啟動依賴的環境變數,引數設定完成後,單擊「OK」,環境變數設定說明請參見下表。

環境變數的解釋如下表所示:

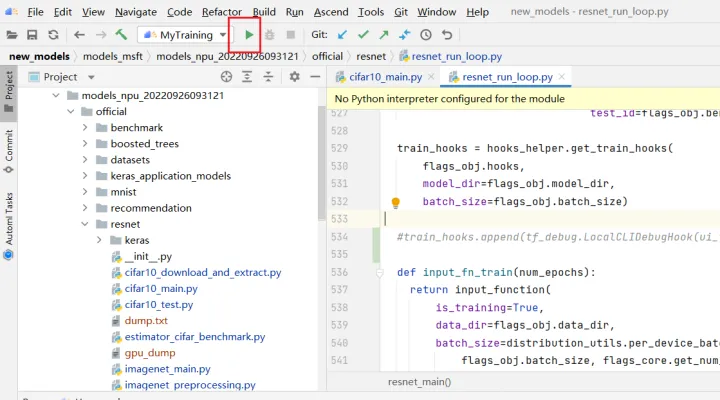

步驟四 執行訓練生成dump資料。

點選按鈕開始訓練

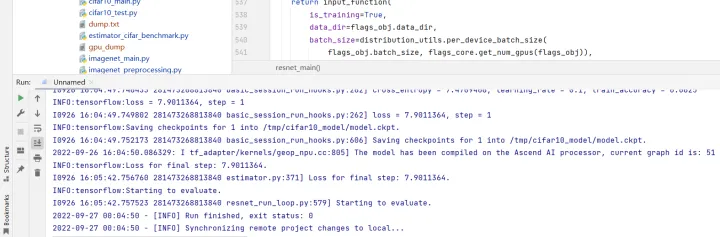

訓練時控制檯輸出如下所示:

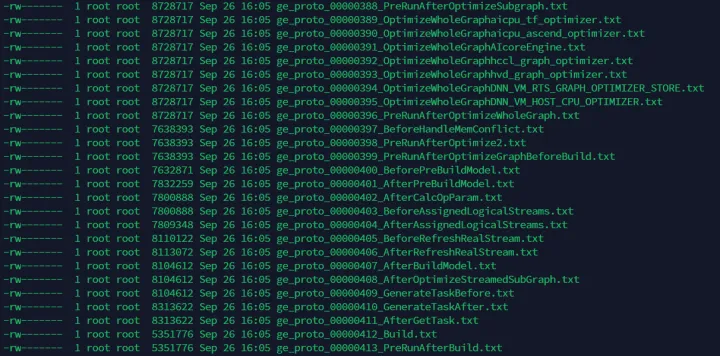

resnet目錄下生成的資料檔案展示如下:

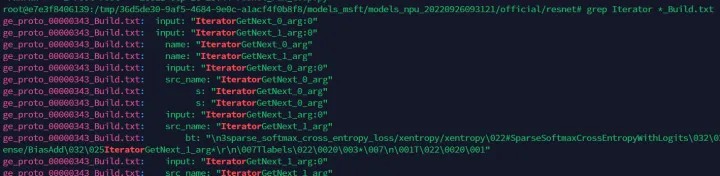

在所有以「_Build.txt」為結尾的dump圖檔案中,查詢「Iterator」這個關鍵詞。記住查詢出的計算圖檔名稱,用於後續精度比對。

如上圖所示,「ge_proto_00000343_Build.txt」檔案即是我們需要找到的計算圖檔案。將此檔案拷貝至使用者家目錄下,便於在執行比對操作時選擇。

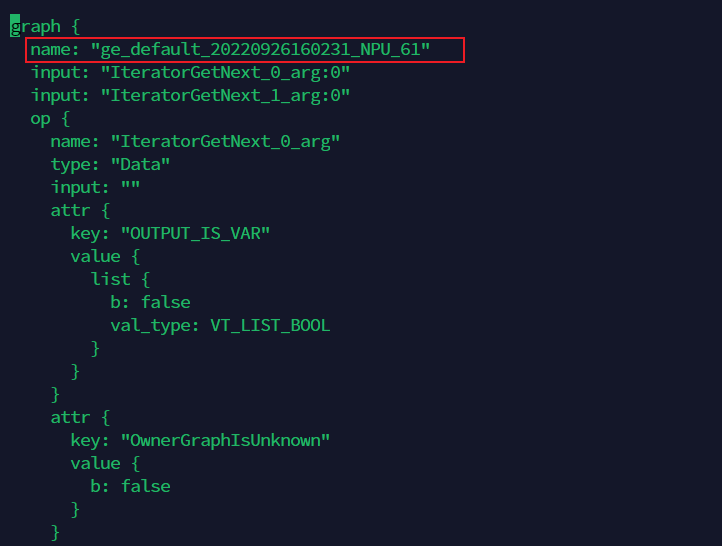

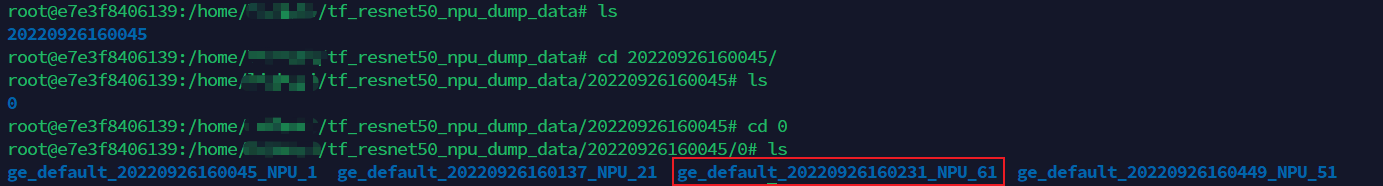

開啟上面找到的計算圖檔案,記錄下第一個graph中的name欄位值。如下範例中,記錄下「ge_default_20220926160231_NPU_61」。

進入以時間戳命名的dump檔案存放路徑下,找到剛記錄的名稱為name值的資料夾,例如ge_default_20220926160231_NPU_61,則下圖目錄下的檔案即為需要的dump資料檔案:

五 比對操作

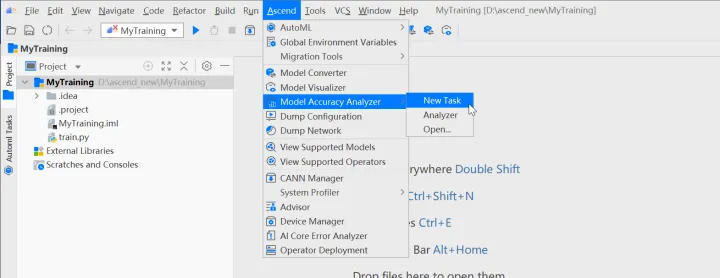

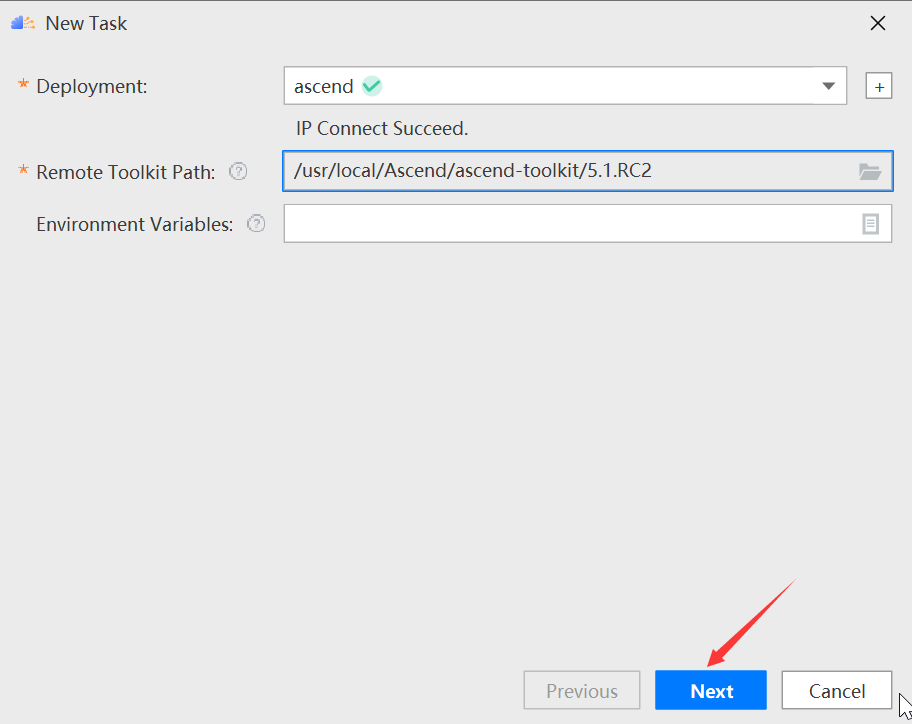

在MindStudio選單欄選擇「Ascend > Model Accuracy Analyzer > New Task」,進入精度比對引數設定介面。

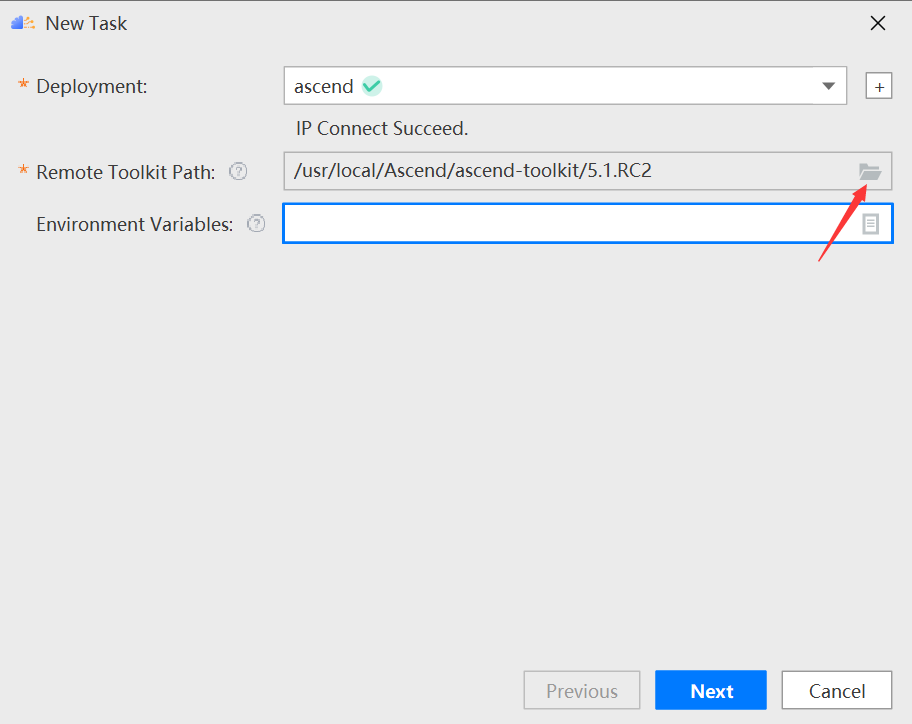

設定tookit path,點選檔案標識,如下圖所示:

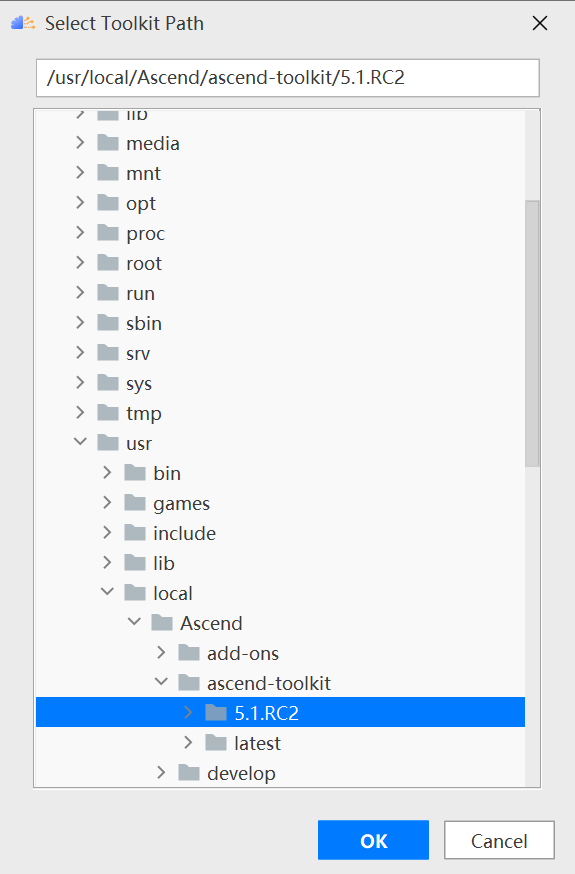

選擇對應的版本,如5.1.RC2版本,單擊ok:

單擊next進入引數設定頁面:

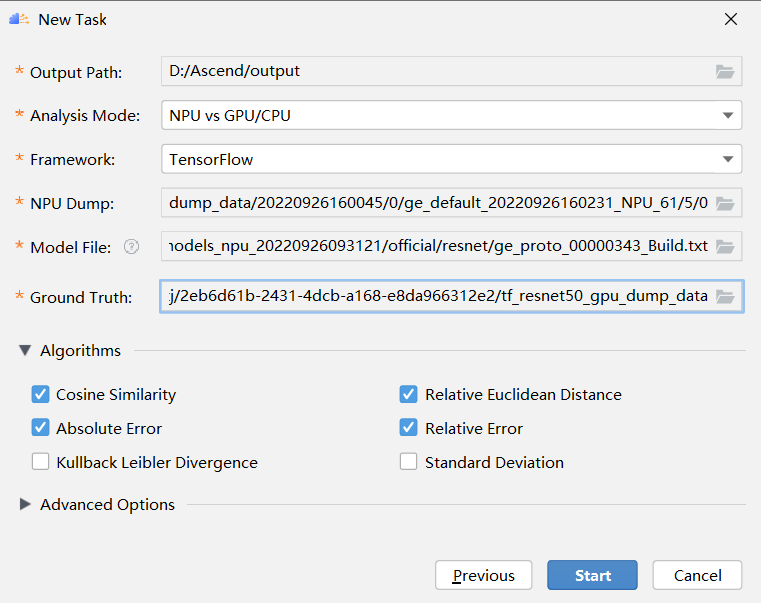

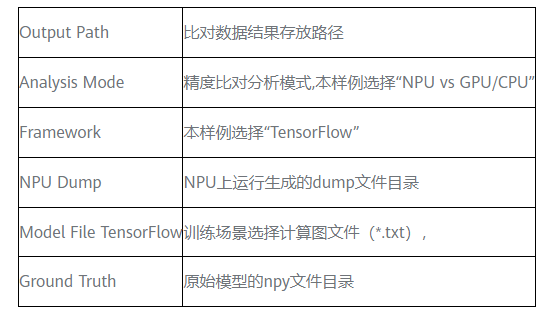

接著填寫gpu和npu的資料的相關資訊,如下圖所示:

引數解釋如下所示:

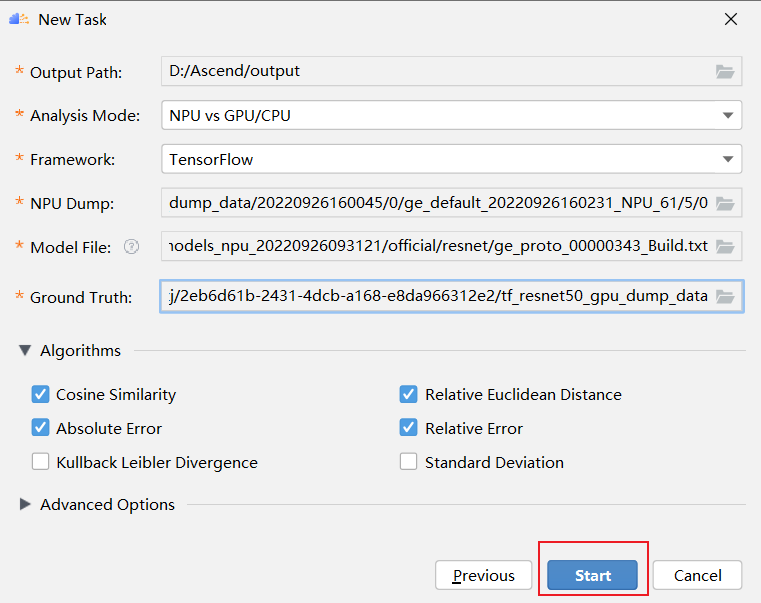

點選start:

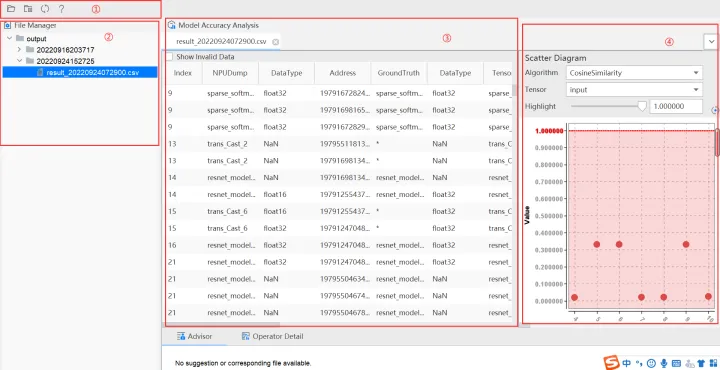

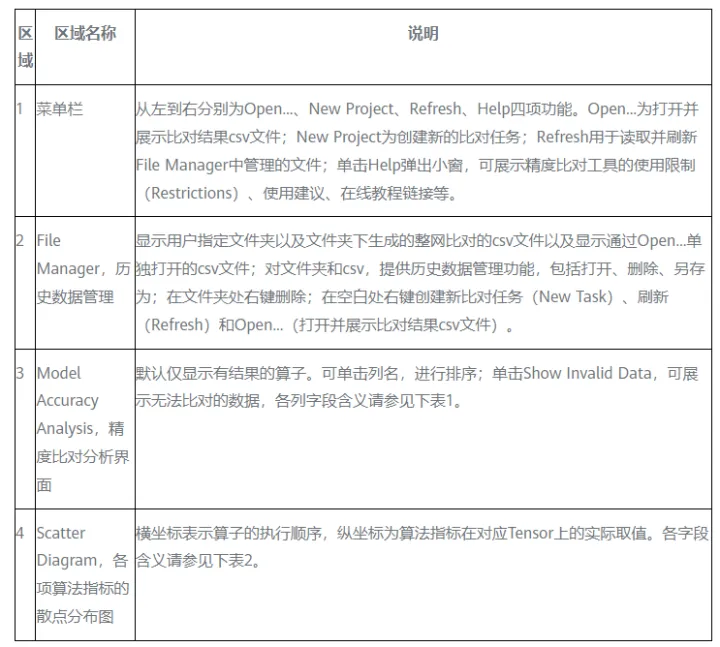

結果展示:

如上圖所示將Vector比對結果介面分為四個區域分別進行介紹。

表1 精度比對分析介面欄位說明

表2 散點分佈圖欄位說明

六、常見問題 & 解決方案彙總

Q:tfdbg複製pt命令時執行出錯

A:由於tfdbg將多行的pt命令識別為了單個命令,使得命令執行失敗。解決辦法如下:

- 先退出tfdbg命令列

- 安裝pexpect庫,命令為 pip install pexpect --user(--user只針對普通使用者,root使用者是沒有的)

- 進入resnet所在的目錄,cd ~/models/official/resnet

- 確保目錄下有dump.txt檔案,即生成的pt命令

- 編寫下述程式碼,vim auto_run.py

import pexpect import sys cmd_line = 'python3 -u ./cifar10_main.py' tfdbg = pexpect.spawn(cmd_line) tfdbg.logfile = sys.stdout.buffer tfdbg.expect('tfdbg>') tfdbg.sendline('run') pt_list = [] with open('dump.txt', 'r') as f: for line in f: pt_list.append(line.strip('\n')) for pt in pt_list: tfdbg.expect('tfdbg>') tfdbg.sendline(pt) tfdbg.expect('tfdbg>') tfdbg.sendline('exit')

6.儲存退出vim,執行python auto_run.py

七、從昇騰官方體驗更多內容

更多的疑問和資訊可以在昇騰論壇進行討論和交流:https://bbs.huaweicloud.com/forum/forum-726-1.html