剖析虛幻渲染體系(18)- 作業系統

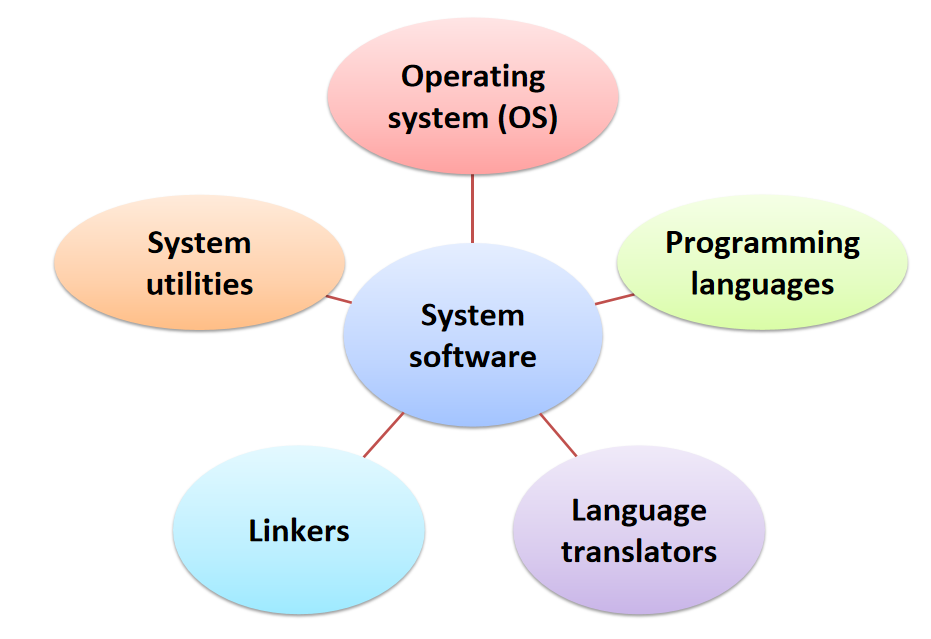

- 18.1 作業系統綜述

- 18.2 計算機硬體概覽

- 18.3 核心

- 18.4 程序

- 18.5 執行緒

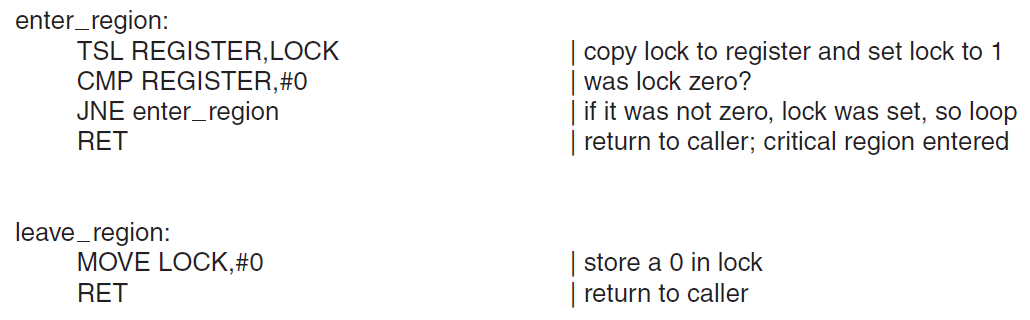

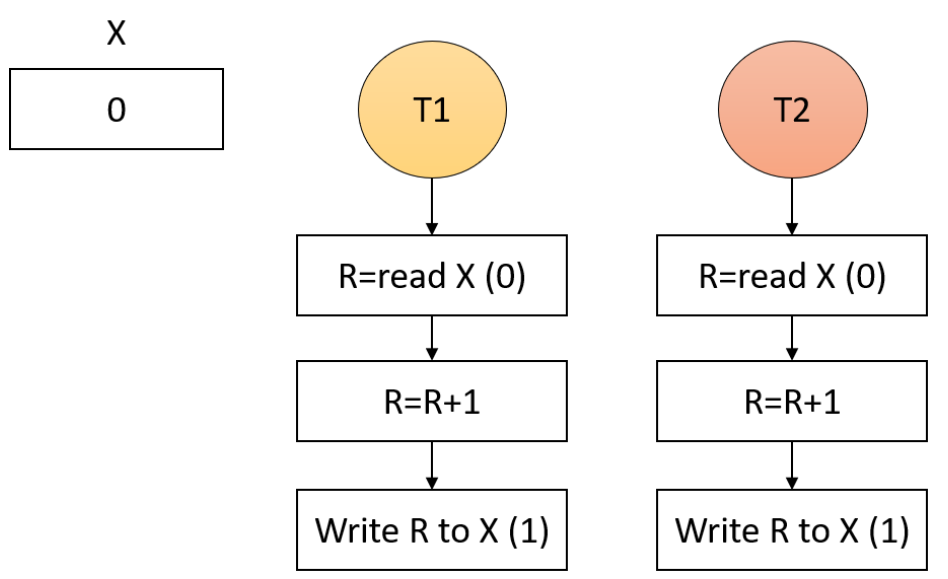

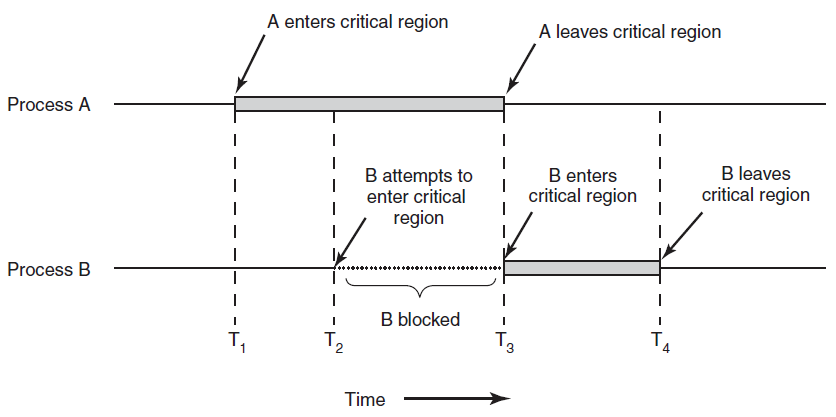

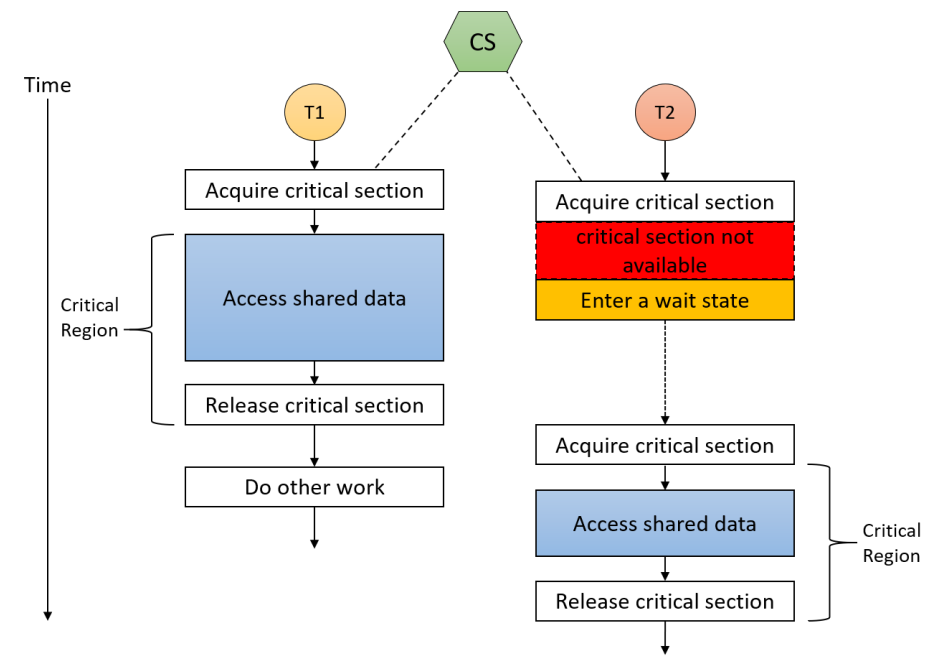

- 18.6 同步機制

- 18.7 執行緒高階主題

- 18.8 作業

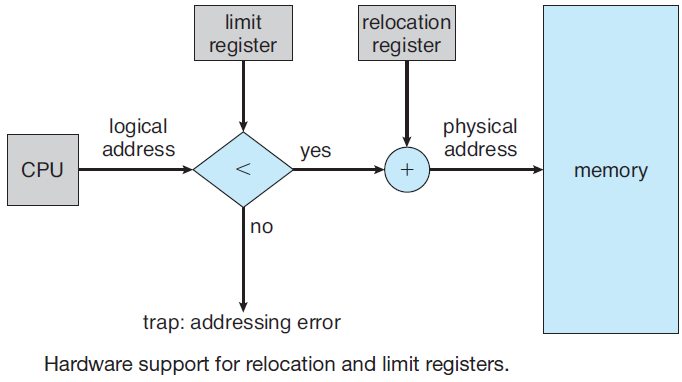

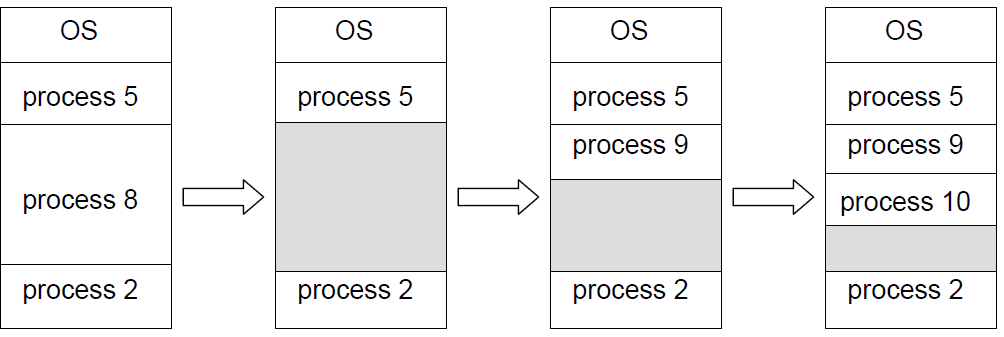

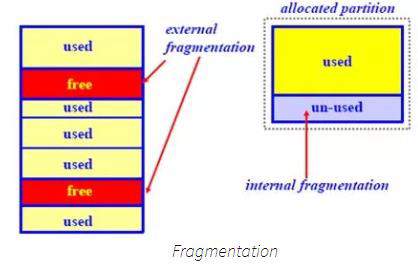

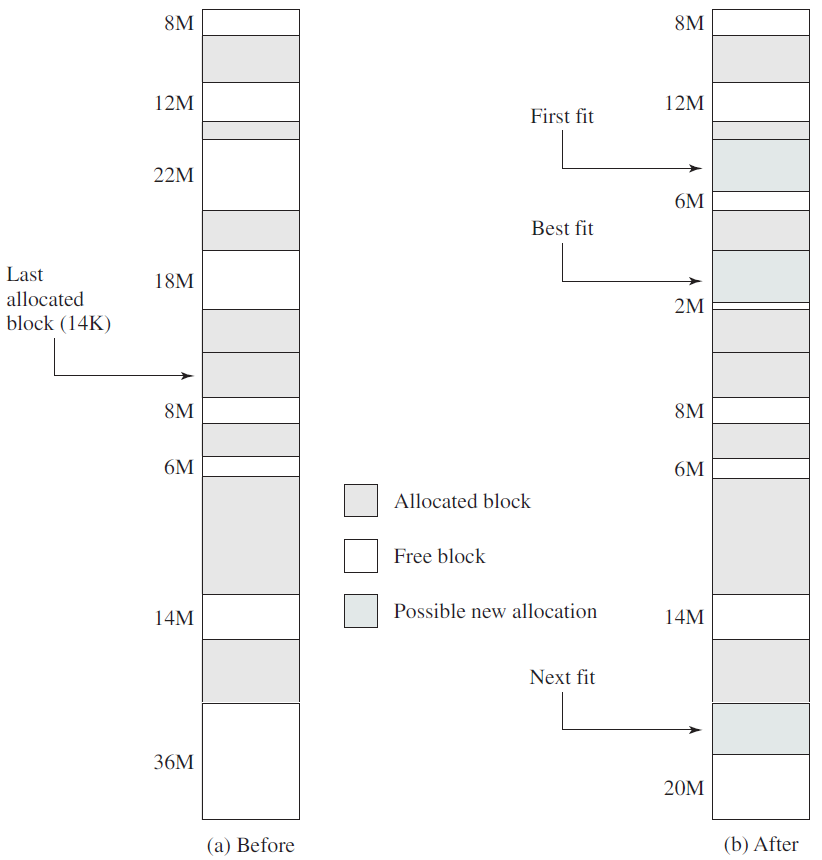

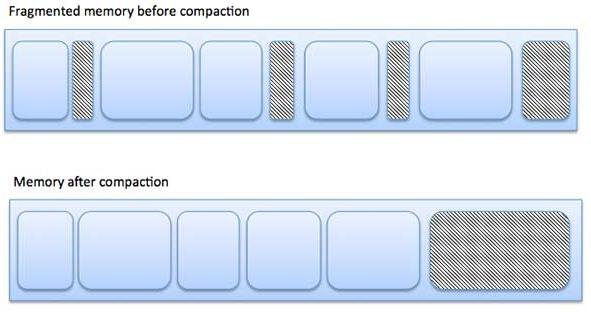

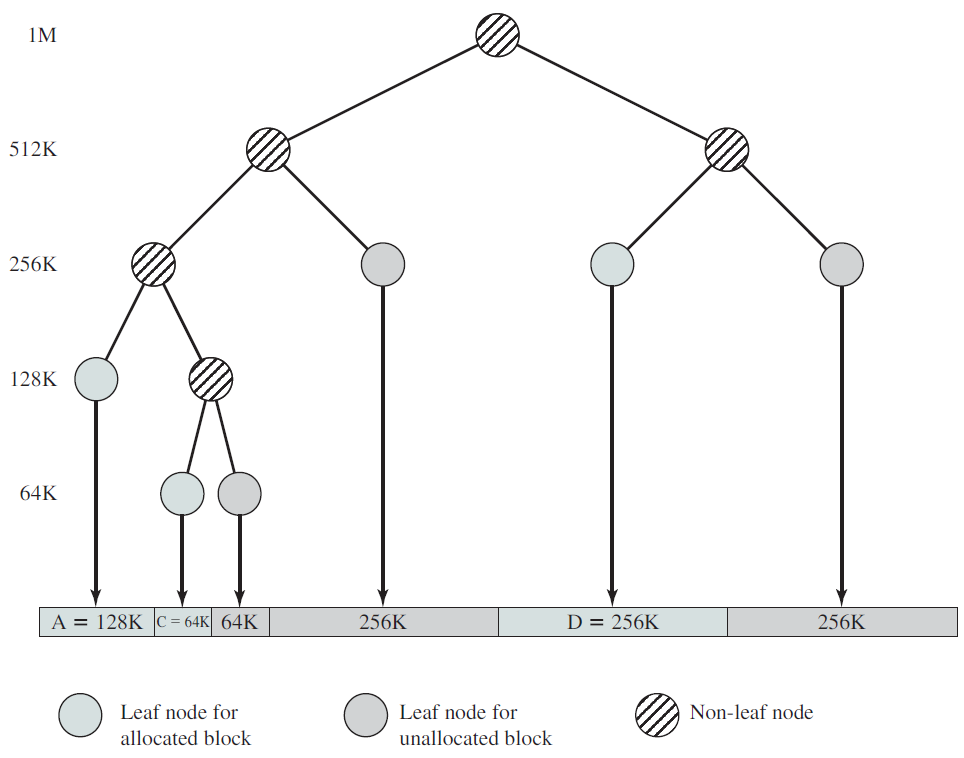

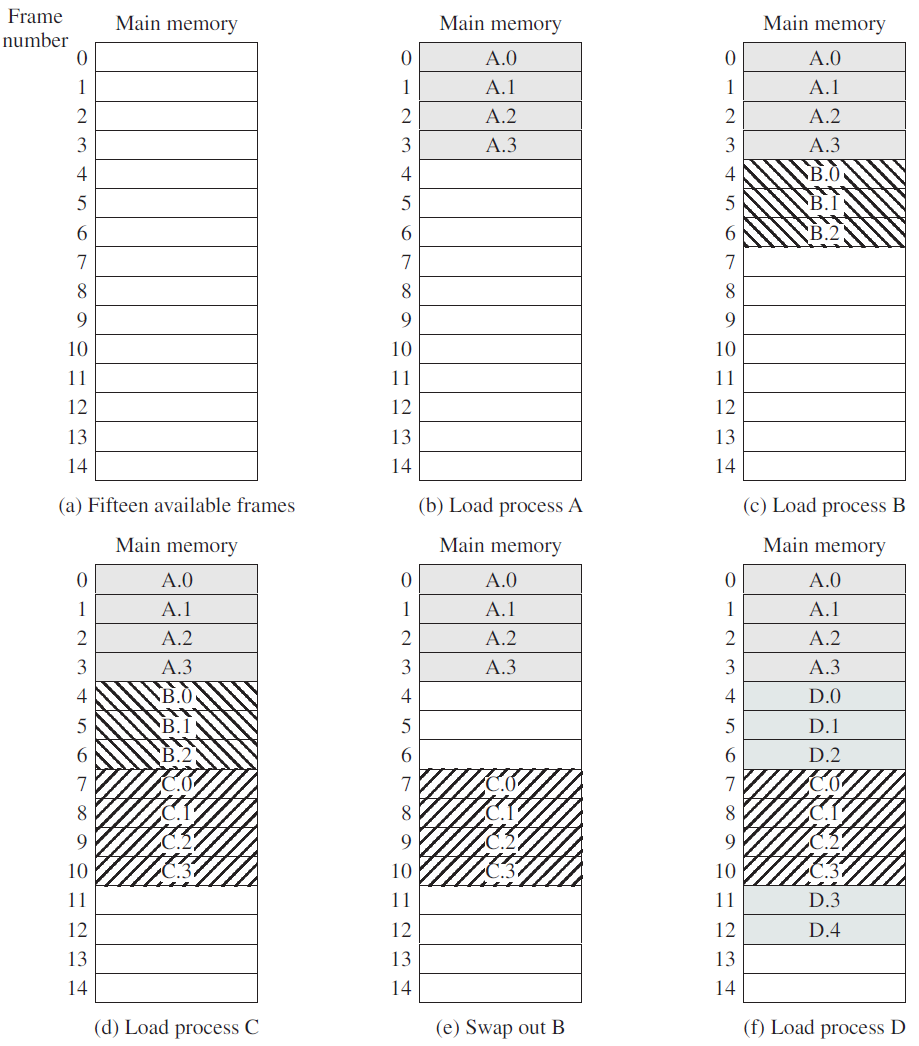

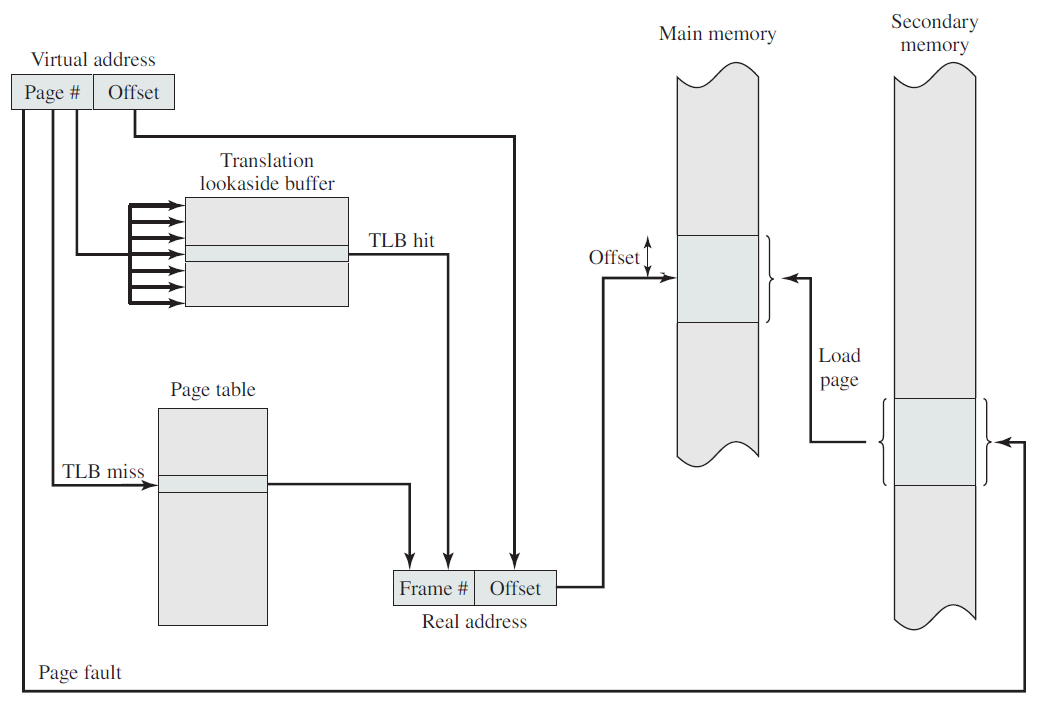

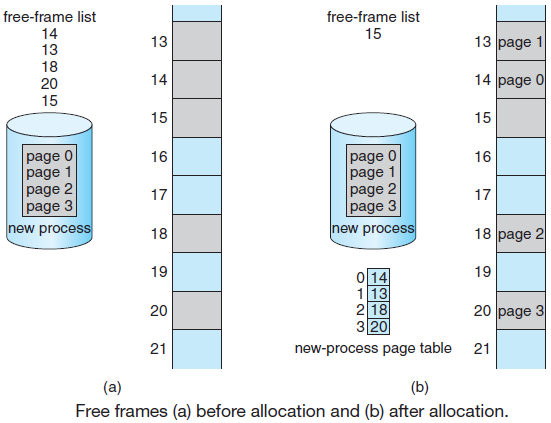

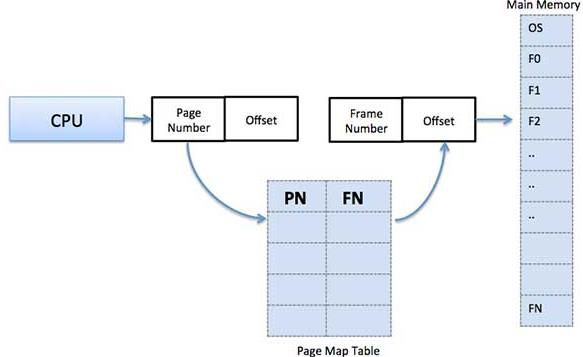

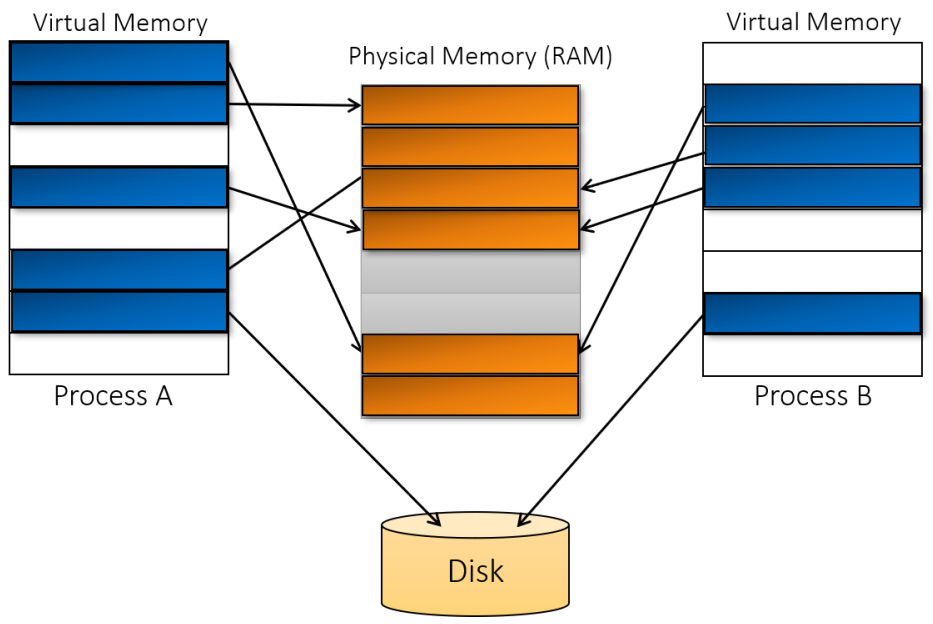

- 18.9 記憶體

- 18.10 動態連結庫

- 18.11 檔案和I/O

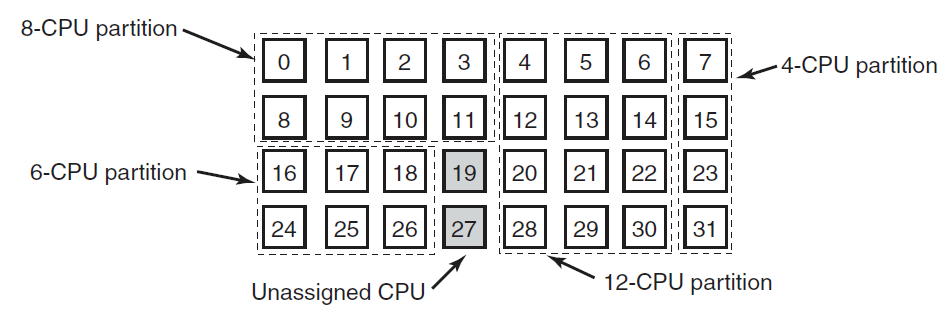

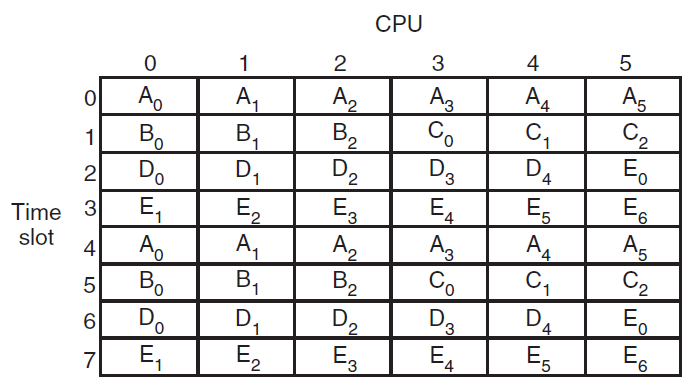

- 18.12 多處理器系統

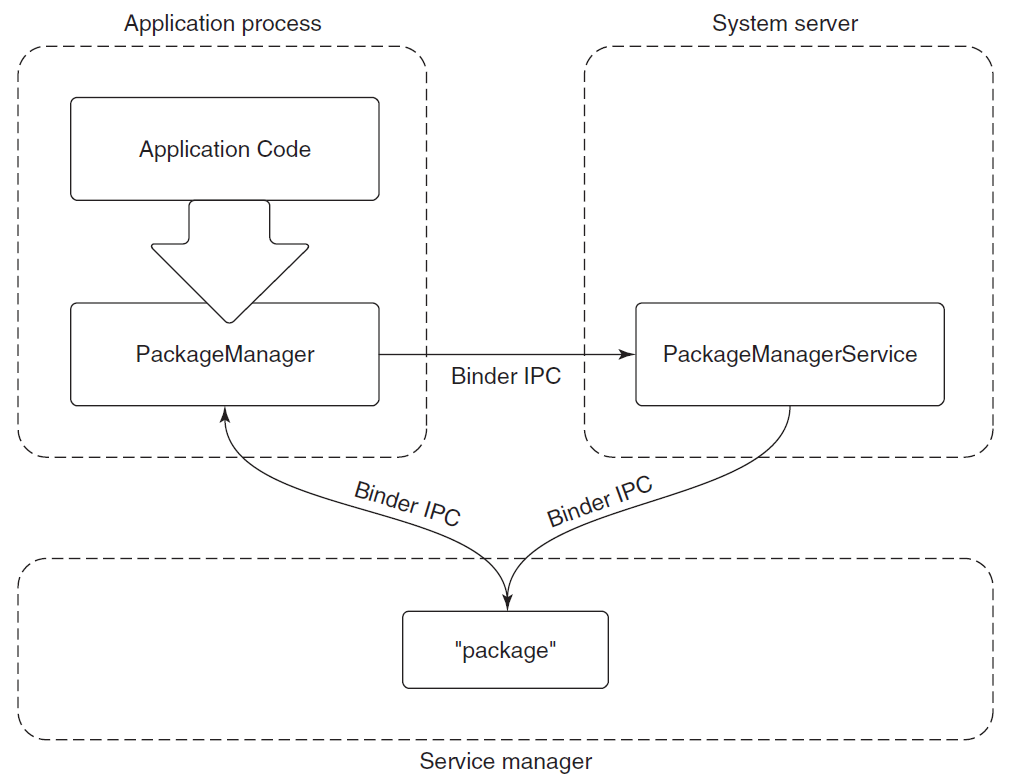

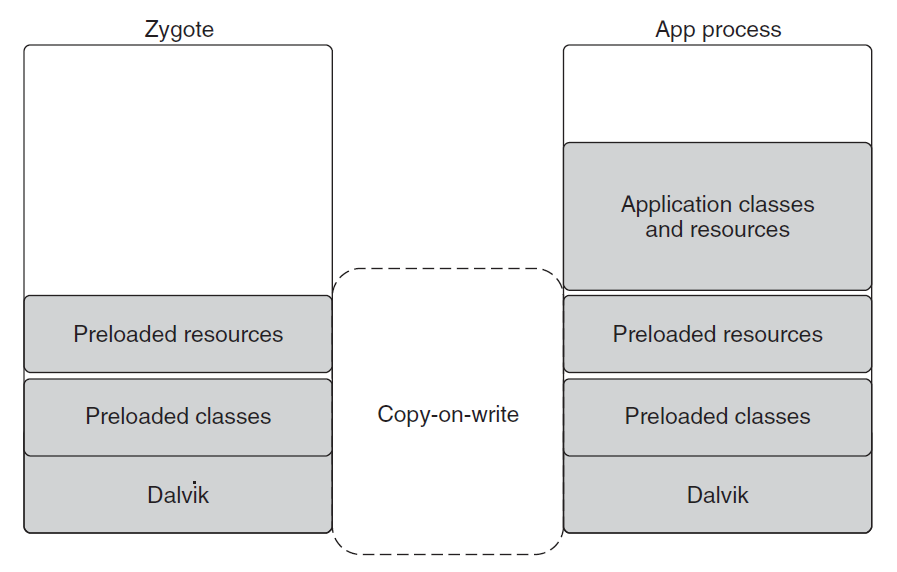

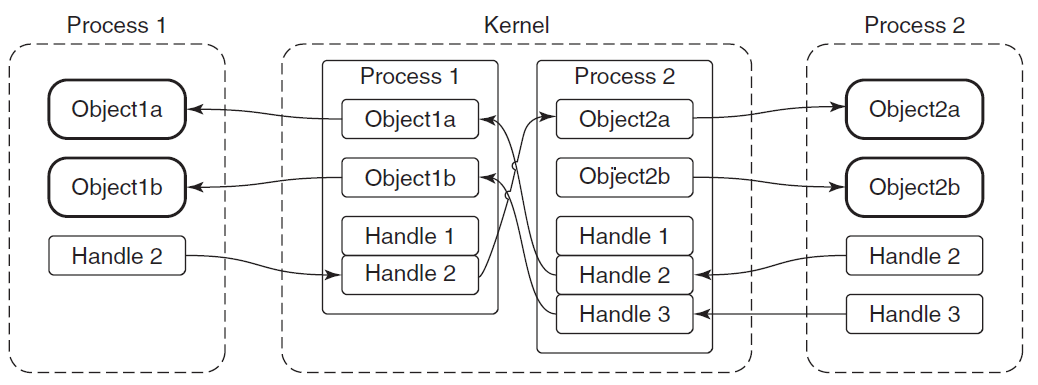

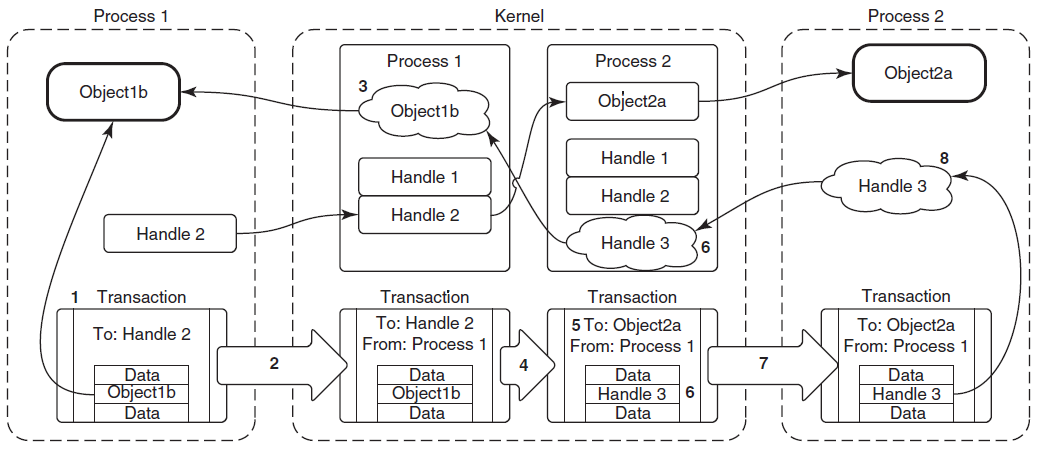

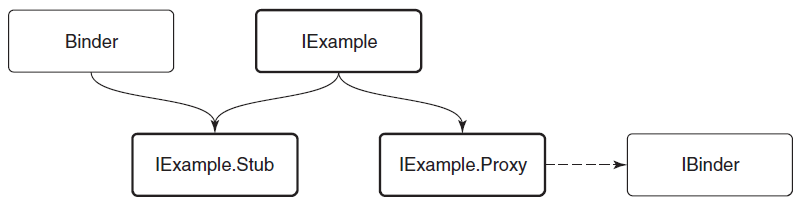

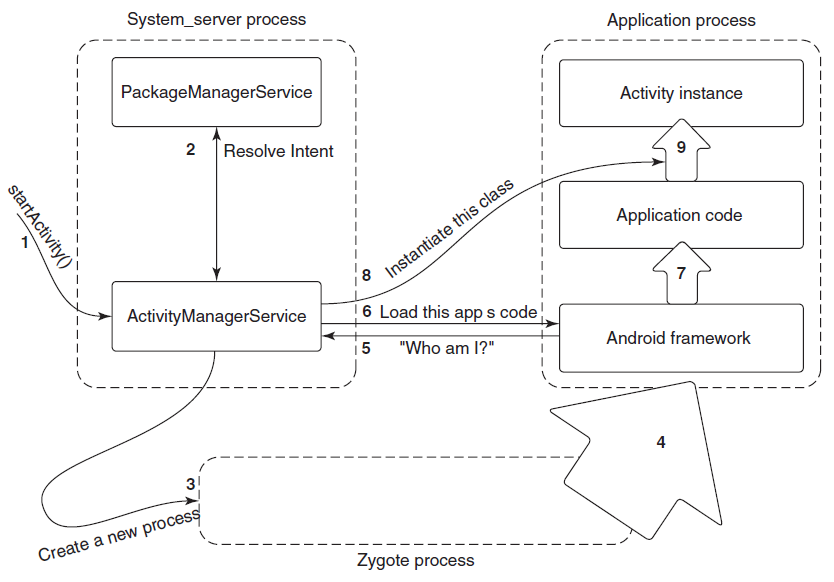

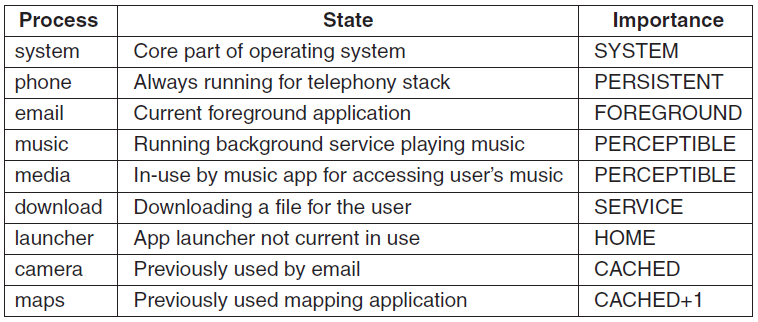

- 18.13 Android

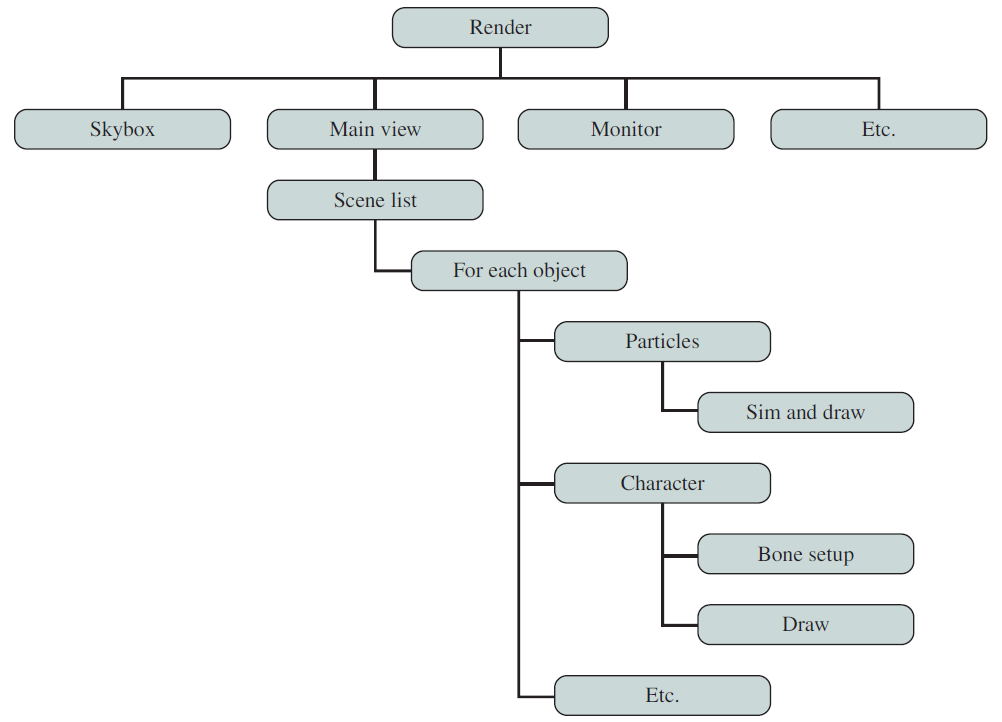

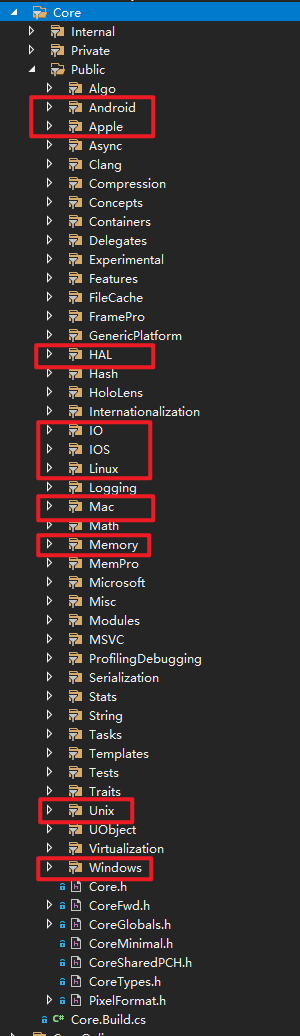

- 18.14 UE Platform

- 18.15 本篇總結

- 特別說明

- 參考文獻

18.1 作業系統綜述

迄今為止,博主在部落格中闡述的內容包含渲染技術、效能優化、圖形API、Shader、GPU、遊戲引擎架構、圖形驅動等等技術範疇的內容,這些內容都僅僅侷限於單個應用程式之中,常常讓人有」只緣身在此山中「的感嘆。現在是時候更進一步了——進入作業系統(Operating System,OS)的範疇,以更高的層次去看待渲染體系,以便我們能夠高屋建瓴,練就深厚的技術內功。

本篇將站在應用層開發者的視角,去闡述Windows、Linux等作業系統的相關技術內幕(如果是作業系統開發者,則博主不認為是很貼切的目標讀者),主要包含但不限於以下內容:

- 作業系統的架構。

- 作業系統的概念。

- 作業系統的技術。

- 作業系統的機制和原理。

- 作業系統的UE封裝和實現。

作業系統經歷了數十年的發展歷程,從最初的形態,到當前的琳琅滿目,無論是技術、體驗、應用等方面都有了質的飛躍。

UNIX作業系統最早於20世紀70年代開發,是一個支援多個使用者同時使用的多工作業系統。它的特點是基於命令列,支援同時執行數千個小程式,易於從單個程式建立管道,內建多使用者支援和分割區。面臨的挑戰是基於命令列,尋找幫助和檔案可能很繁瑣,許多不同的變體(下圖)。

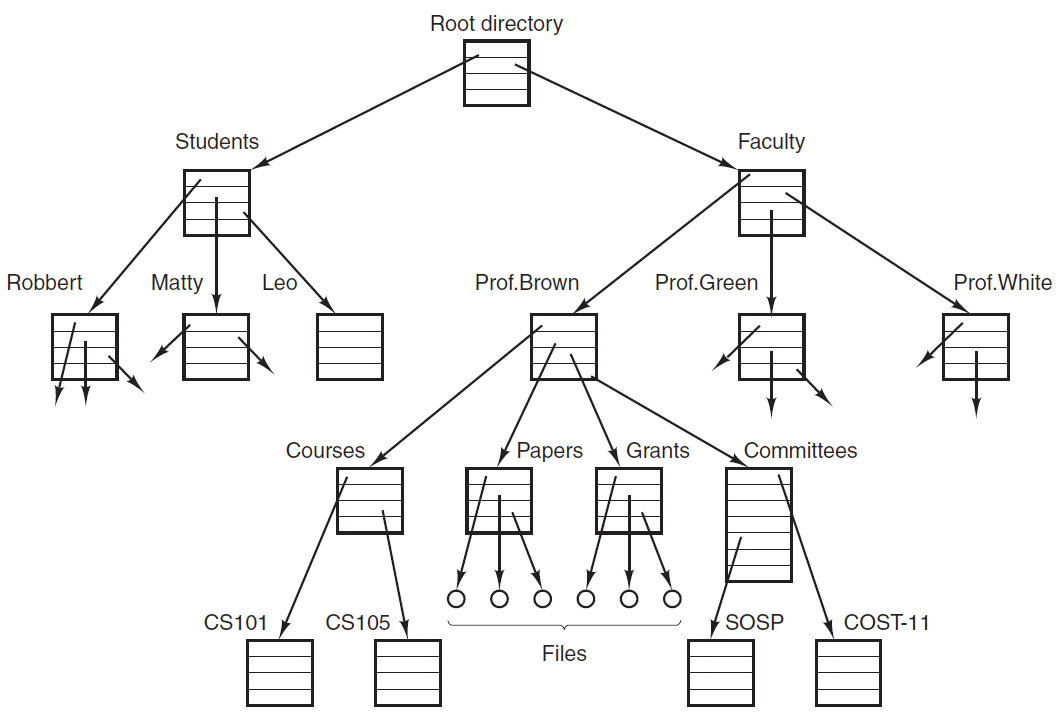

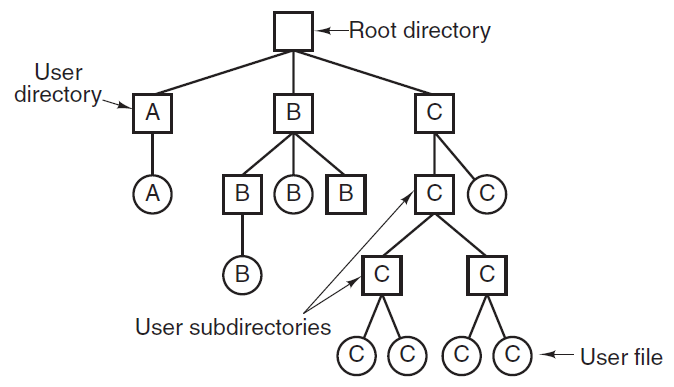

Unix系統和它的衍生體。

同樣流行且知名的還有Windows、MacOS、Android、Linux等作業系統。

18.1.1 作業系統功能

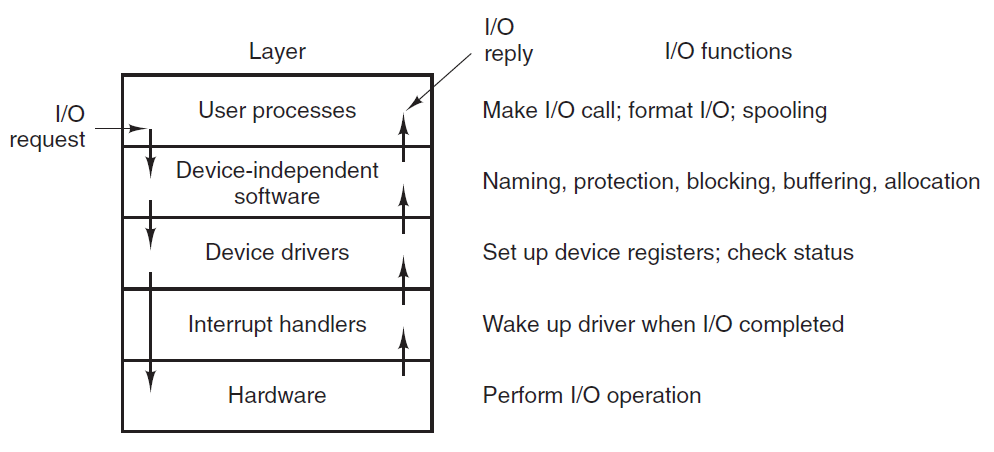

作業系統位於應用程式和硬體之間,調解存取並抽象出介面,程式通過陷阱或例外請求服務,裝置通過中斷請求關注等。作業系統執行許多功能,具體而言,有:

- 實現使用者介面。

- 在使用者之間共用硬體。

- 允許使用者之間共用資料。

- 防止使用者相互干擾。

- 在使用者之間排程資源。

- 促進I/O操作。

- 從錯誤中恢復。

- 資源儲存核算。

- 促進並行操作。

- 組織資料以實現安全快速存取。

- 處理網路通訊。

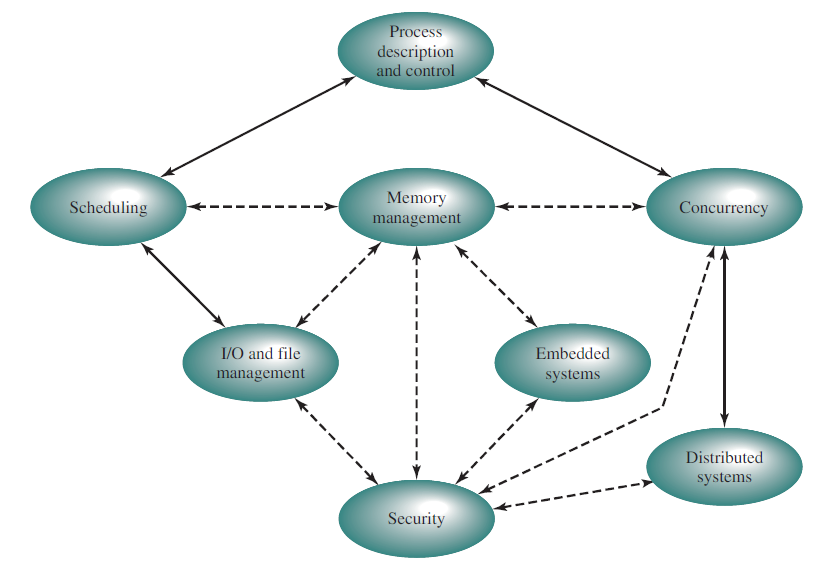

作業系統是一組程式,用於控制應用程式的執行,並充當計算機使用者和計算機硬體之間的中介。作業系統是一種管理計算機硬體併為應用程式執行提供環境的軟體,範例有Windows、Windows/NT、Linux、OS/2和MacOS。OS涉及的主題常常是以下幾方面:

作業系統提供以下幾大類功能:

- 作業管理:識別作業,確定優先順序,確定主記憶體的可用性,並準備執行作業或程式的時間表。

- 程序管理:減少計算機系統處理器和輸入/輸出裝置的空閒時間。

- 輸入/輸出管理:在各種裝置及其驅動程式的幫助下,管理計算機的輸入和輸出流。

- 資料管理:跟蹤磁碟和其他儲存裝置上的資料。

- 檔案管理:負責檔案相關活動,如:建立、刪除、操作檔案和目錄。

- 記憶體管理:根據不同程式的需要分配和釋放可用記憶體。

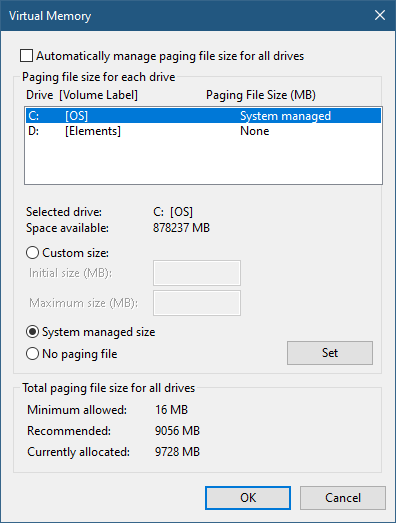

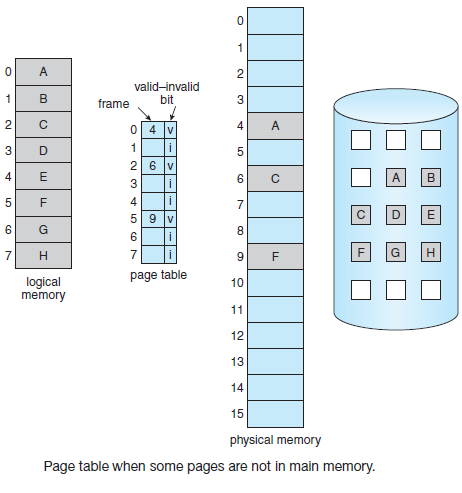

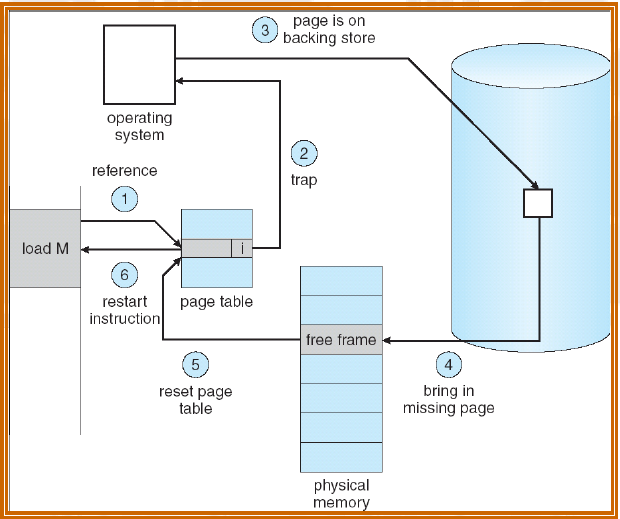

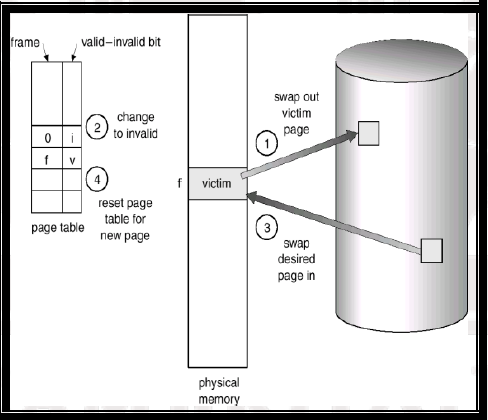

- 虛擬儲存:在不增加物理大小的情況下增加主記憶體的容量,使用虛擬記憶體儲存指令和資料。

- 安全管理:為敏感資料提供密碼安全,以阻止未經授權的存取。

- 線上處理:等待使用者的操作指令,並立即執行。

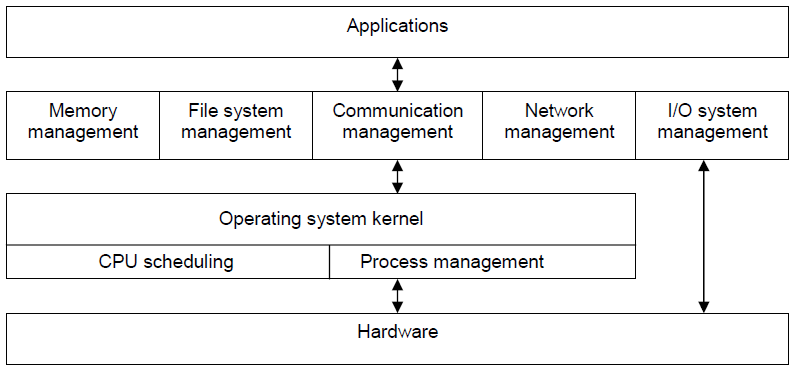

常見的模組或子系統有記憶體管理、IO系統、檔案系統、程序、執行緒、中斷、安全、資訊服務等等,它們之間有著錯綜複雜的關聯:

作業系統的目標是:1、使計算機系統方便使用者使用;2、有效地使用計算機硬體;3、執行使用者程式並使解決使用者問題更容易。

可以分別從使用者、系統視角來看待作業系統。

計算機的使用者檢視取決於使用的介面。一些使用者可能使用PC,在這種情況下,系統設計為只有一個使用者可以利用資源,並且主要是為了便於使用,其中主要關注的是效能而不是資源利用率。一些使用者可能使用連線到大型電腦或小型計算機的終端,其他使用者可以通過其他終端存取同一臺計算機,這些使用者可以共用資源和交換資訊。在這種情況下,作業系統被設計為最大限度地利用資源,以便有效地利用所有可用的CPU時間、記憶體和I/O。其他使用者可以坐在工作站上,連線到其他工作站和伺服器的網路,在這種情況下,作業系統被設計為在個人可見性和資源利用率之間進行折衷。

而從系統角度來看,可以將系統視為資源分配器,也就是說,一個計算機系統有許多可用於解決問題的資源。作業系統充當這些資源的管理器,必須決定如何將這些資源分配給程式和使用者,以便能夠高效、公平地操作計算機系統。作業系統的不同視角是,它需要控制各種I/O裝置和使用者程式,即作業系統是用於管理使用者程式執行的控制程式,以防止錯誤和不當使用計算機。資源可以是CPU時間、記憶體空間、檔案儲存空間、I/O裝置等。

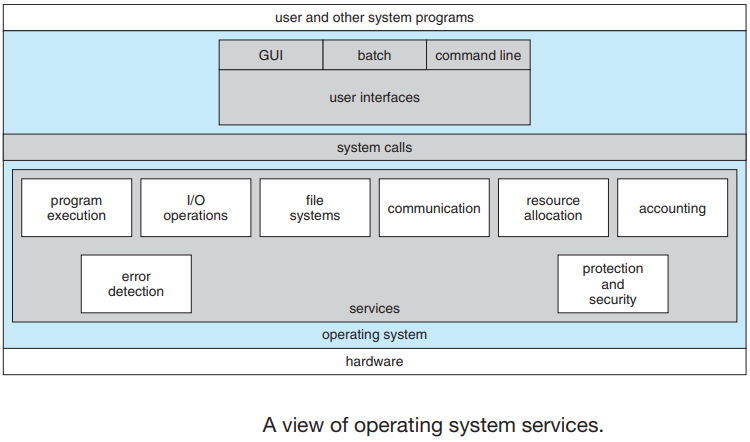

作業系統服務是作業系統為程式的執行提供了環境,也為程式提供一些服務,每個作業系統提供的服務可能與其他作業系統不同,使得程式設計任務更容易。

作業系統服務概覽。

作業系統提供的各種服務如下:

-

程式執行:系統必須能夠將程式載入到主記憶體分割區並執行該程式,程式必須能夠正常終止此執行以成功執行,或異常終止以顯示錯誤。

-

I/O操作:完成裝置分配和I/O裝置控制任務,提供通知裝置錯誤、裝置狀態等。

-

檔案系統操作:完成開啟檔案、關閉檔案的任務,程式需要按名稱建立和刪除檔案,允許檔案操作,如讀取檔案、寫入檔案、附加檔案。

-

通訊:在同一計算機系統上或在計算機網路上的不同計算機系統之間完成程序間通訊的任務,在安全模式下提供訊息傳遞和共用記憶體存取。

-

錯誤檢測:作業系統應針對任何型別的溢位(如算術溢位)採取適當的操作;除以零錯誤、存取非法記憶體位置和使用者CPU時間過大。完成錯誤檢測和恢復任務(如果有),例如印表機卡紙或缺紙。跟蹤CPU、記憶體、I/O裝置、儲存裝置、檔案系統、網路等的狀態。如果出現致命錯誤,如RAM奇偶校驗錯誤、功率波動,則中止執行。

-

資源分配:完成資源分配到多個作業的任務,在資源使用後或作業終止時回收分配的資源,當多個使用者登入到系統時,必須將資源分配給每個使用者。對於資源在各個程序之間的當前分配,作業系統使用CPU排程執行時間,以確定將為哪個程序分配資源。

-

賬戶:作業系統跟蹤哪些使用者使用了多少和哪種計算機資源,維護系統活動紀錄檔以進行效能分析和錯誤恢復。

-

保護:完成保護系統資源免受惡意使用的任務,採用安全方案防止未經授權的存取/使用者進行安全計算,使用登入密碼和註冊對合法使用者進行身份驗證。作業系統負責硬體和軟體保護,作業系統保護儲存在多使用者計算機系統中的資訊。

-

系統呼叫:系統呼叫提供程序和作業系統之間的介面,它們通常以組合語言指令的形式提供。有些系統允許直接從高階語言程式(如C、BCPL和PERL等)進行系統呼叫,根據使用的計算機,系統呼叫以不同的方式進行。系統呼叫可以大致分為5大類:

-

程序管理和控制:

- 結束,中止:執行中的程式需要能夠正常(結束)或異常(中止)執行。

- 載入、執行:執行一個程式的程序或作業可能要載入並執行另一個程式。

- 建立、終止程序:有一個系統呼叫指定用於建立新程序或作業(建立流程或提交作業),或者終止建立的作業或程序。

- 獲取或設定程序屬性:如果建立新作業或程序,我們應該能夠控制其執行,以便確定和重置作業或程序的屬性。

- 等待時間:建立新作業或程序後,我們可能需要等待它們完成執行(等待時間)。

- 等待事件、訊號事件:我們可以等待特定事件發生(等待事件),然後,作業或程序在該事件發生時發出訊號(訊號事件)。

- 分配、釋放記憶體。

-

檔案管理/檔案操作/檔案處理:

- 建立檔案,刪除檔案:我們首先需要能夠建立和刪除檔案。兩個系統呼叫都需要檔名及其某些屬性。

- 開啟檔案,關閉檔案:建立檔案後,我們需要開啟並使用它。當不再使用該檔案時,我們將其關閉。

- 讀取、寫入、重新定位檔案:開啟後,我們還可以讀取、寫入或重新定位檔案(回放或跳到檔案末尾)。

- 獲取檔案屬性,設定檔案屬性:對於檔案或目錄,我們需要能夠確定各種屬性的值,並在必要時重置它們。需要兩個系統呼叫獲取檔案屬性和設定檔案屬性

-

裝置管理:

- 請求裝置,釋放裝置:如果系統有多個使用者,首先請求裝置,在完成裝置後,必須釋放它。

- 讀取、寫入、重新定位:一旦裝置被請求並分配,就可以讀取、寫入和重新定位裝置。

-

資訊維護/管理:

- 獲取時間或日期、設定時間或日期:大多數系統都有一個系統呼叫來返回當前的日期和時間或設定當前的日期與時間。

- 獲取系統資料,設定系統資料:其他系統呼叫可能會返回有關係統的資訊,如當前使用者數、作業系統版本號、可用記憶體量等。

- 獲取程序屬性,設定程序屬性:作業系統保留有關其所有程序的資訊,並且有系統呼叫來存取這些資訊。

-

通訊管理:

- 建立、刪除連線。

- 傳送、接收訊息。

- 連線、分離遠端裝置(安裝/遠端登入)。

- 傳輸狀態資訊(位元組)。

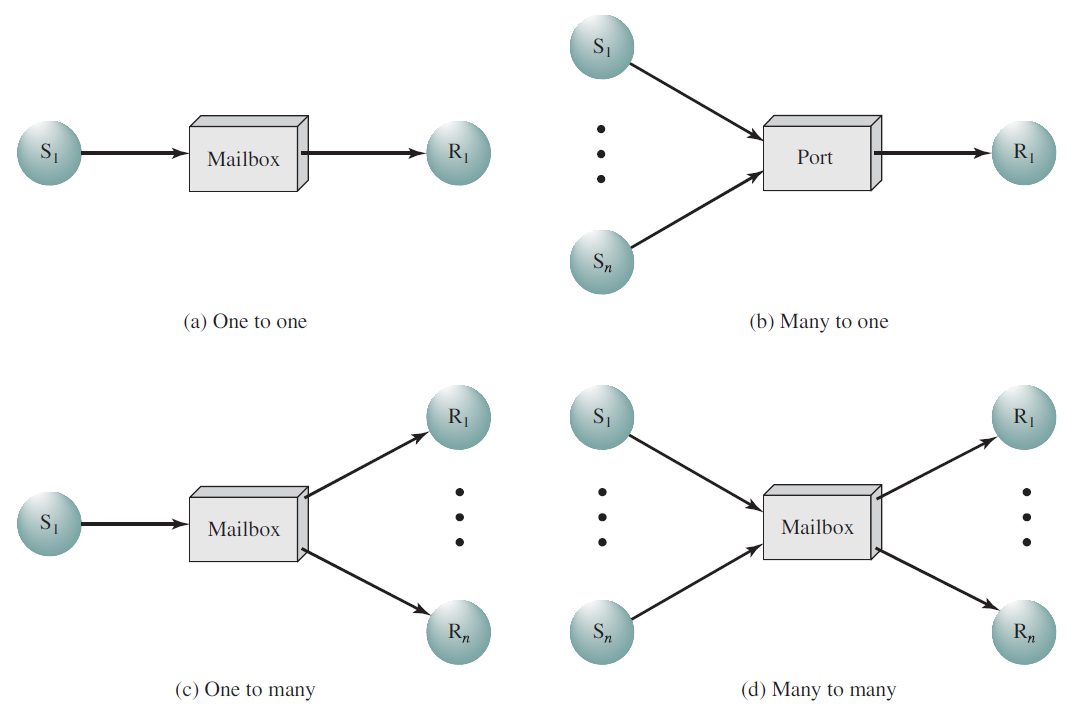

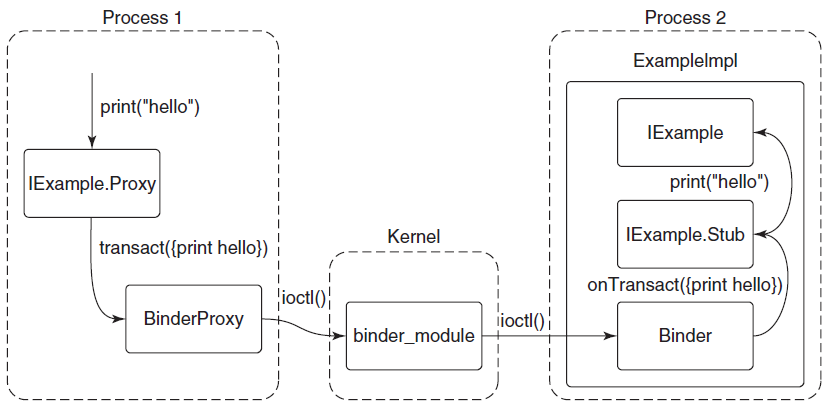

通訊管理有兩種模式:

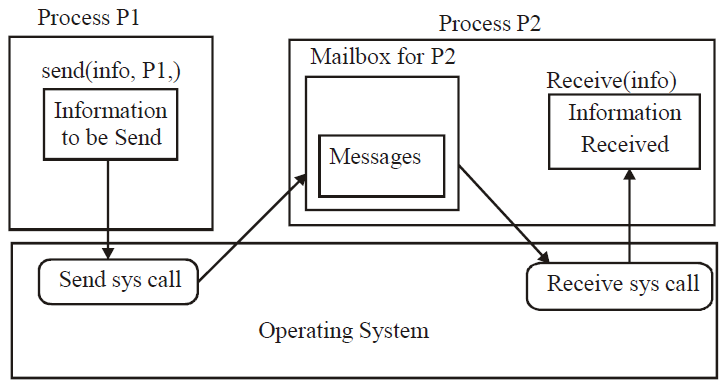

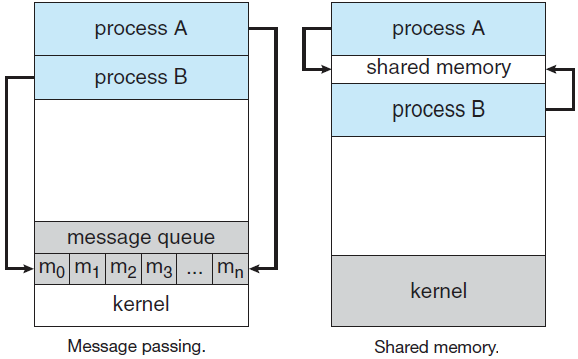

- 訊息傳遞模式:資訊通過作業系統提供的程序間通訊設施進行交換,網路中的每臺計算機都有一個已知的名稱。類似地,每個程序都有一個程序名,該程序名被轉換為作業系統可以參照的等效識別符號。get-host-id和get-processed系統呼叫來執行此轉換,然後將這些識別符號傳遞給檔案系統提供的通用開啟和關閉呼叫,或傳遞給特定的開啟連線系統呼叫。收件人程序必須授予其許可權,才能與接受連線呼叫進行通訊。通訊源稱為使用者端和接收方,稱為伺服器,通過讀訊息和寫訊息系統呼叫交換訊息。關閉連線呼叫終止連線。

- 共用記憶體模式:程序使用對映記憶體系統呼叫存取其他程序擁有的記憶體區域,他們通過讀寫共用區域中的資料來交換資訊,這些程序確保它們不會同時寫入同一位置。

-

18.1.2 作業系統種類

作業系統可分為以下幾類。

18.1.2.1 批次處理作業系統

在批次處理系統(Batch System)型別的作業系統中,使用者定期(如每天、每週、每月)將作業提交到一箇中心位置,該位置的系統使用者不直接與計算機系統互動。為了加快處理速度,具有類似需求的作業被分批次處理,並作為一個組在計算機中執行。因此,程式設計師將把程式留給操作員,每個作業的輸出將傳送給適當的程式設計師。這種型別的主要任務是自動將控制權從一個作業轉移到下一個作業。

此種作業系統的優勢是簡單、連續的作業排程,儘量減少人為干預,由於作業成批次處理,提高了效能和系統吞吐量。缺點是從使用者的角度來看,由於批次處理,週轉時間可能會很長,程式偵錯困難,作業可以進入無限迴圈,可能會損壞顯示器,由於缺乏保護方案,一項作業可能會影響待定作業。

應用案例是工資系統、銀行對賬單等。注意,週轉時間是指使用者提交流程或作業與完成該流程或作業之間所用的時間。

聯機的全稱是線上同步外圍裝置操作(Simultaneous Peripheral Operation On-Line,SPOOL),是暫時儲存資料以供裝置、程式或系統使用和執行的過程,資料被傳送到其他易失性(臨時記憶體)記憶體並儲存在其中,直到程式或計算機請求執行。

18.1.2.2 分時作業系統

時間共用系統(Time-Sharing)也被稱為分時系統、多使用者系統,提供使用者與系統之間的線上通訊,使用者直接發出指令並接收中間響應,因此稱為互動式系統。它允許多個使用者同時共用計算機系統,CPU在幾個程式之間快速多路複用,這些程式儲存在記憶體和磁碟上,一個程式在磁碟上交換記憶體和記憶體。

CPU通過在多個作業之間切換來執行多個作業,但切換頻繁,使用者可以在每個程式執行時與之互動。互動式計算機系統提供使用者和系統之間的直接通訊,使用者直接使用鍵盤或滑鼠向作業系統或程式發出指令,並等待即時結果。因此,響應時間將很短。分時系統允許許多使用者同時共用計算機,由於此係統中的每個操作都很短,因此每個使用者只需要很少的CPU時間。系統可以快速地從一個使用者切換到另一個使用者,因此每個使用者都會感覺整個計算機系統都是專門用於自己的使用的,即使它是由許多使用者共用的。

在上圖中,使用者5處於活動狀態,但使用者1、使用者2、使用者3和使用者4處於等待狀態,而使用者6處於就緒狀態。一旦使用者5的時間片完成,時間片就移到下一個就緒使用者,即使用者6。在此狀態下,使用者2、使用者3、使用者4和使用者5處於等待狀態,使用者1處於就緒狀態。這個過程以同樣的方式繼續,以此類推。

分時系統的優點是有效共用和利用計算機資源,對許多使用者的快速響應時間,CPU空閒時間完全消除,適合線上資料處理和使用者對話。

分時系統的缺點是比多道程式作業系統更復雜,系統必須具有記憶體管理和保護,因為多個作業同時儲存在記憶體中,分時系統還必須提供檔案系統,因此需要磁碟管理,它為需要複雜CPU排程方案的並行執行提供了機制。範例:Multics、UNIX等。

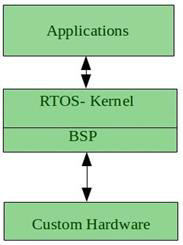

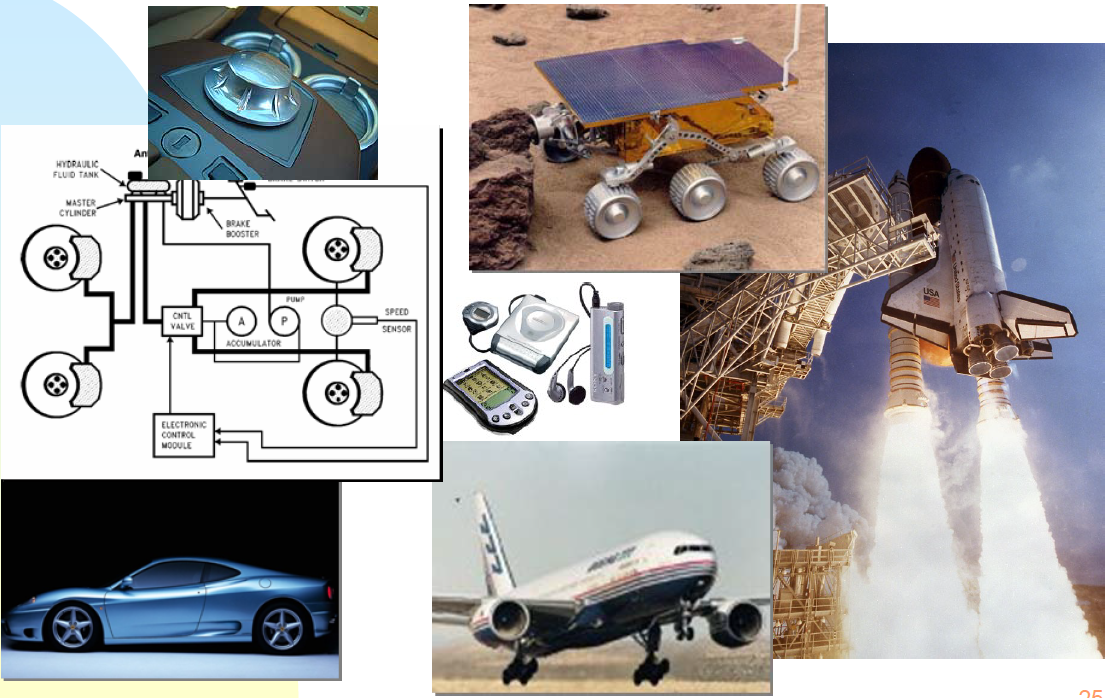

18.1.2.3 實時作業系統

實時系統(Real-Time System)的特點是提供即時響應,保證關鍵任務按時完成。對於要在計算機上執行的每個功能,此型別必須具有已知的最大時間限制。當處理器的操作或資料流有嚴格的時間要求時,使用實時系統,實時系統可用作專用應用中的控制裝置。

當處理器的操作或資料流有嚴格的時間要求時,使用實時系統,控制科學實驗、醫學成像系統和一些顯示系統的系統是實時系統。感測器將資料傳送到計算機,計算機分析資料並調整控制元件以修改感測器輸入。

實時系統的缺點是:只有當實時系統在時間限制內返回正確的結果時,才認為它能夠正確執行,輔助儲存有限或丟失,而資料通常儲存在短期記憶體或ROM中,缺少高階作業系統功能。

實時系統有兩種型別:

- 硬實時系統:保證關鍵任務按時完成,例如突如其來的任務發生在一個突然的時刻。

- 軟實時系統:是一種限制較少的實時系統,其中關鍵任務的優先順序高於其他任務,並在計算之前保持該優先順序。與硬實時系統相比,這些系統的實用性更為有限。偶爾錯過最後期限是可以接受的。

範例:QNX、VX工作,數位音訊或多媒體包含在這一類別中,是一種特殊用途的作業系統,其中對處理器的操作有嚴格的時間要求。實時作業系統有明確定義的固定時間限制,處理必須在時間限制內完成,否則系統將失敗。只有在時間限制內返回正確的結果,實時系統才能正常執行。這些系統的特點是將時間作為關鍵引數。

實時作業系統的優點:

- 最大化消費:裝置和系統的最大利用率,從而從所有資源中獲得更多輸出。

- 任務轉移:在這些系統中分配給轉移任務的時間非常少。例如,在較舊的系統中,將一個任務轉移到另一個任務大約需要10微秒,而在最新的系統中則需要3微秒。

- 專注於應用程式:專注於執行應用程式,而對佇列中的應用程式不那麼重要。

- 嵌入式系統中的實時作業系統:由於程式的大小很小,RTOS也可以用於嵌入式系統,如傳輸和其他系統。

- 無錯誤:這些型別的系統是無錯誤的。

- 記憶體分配:記憶體分配在這些型別的系統中管理得最好。

實時作業系統的缺點:

- 有限的任務:同一時間執行的任務很少,並且它們很少集中在少數應用程式上,以避免錯誤。

- 使用繁重的系統資源:有時系統資源不是很好,而且也很昂貴。

- 複雜演演算法:演演算法非常複雜,設計者很難寫下去。

- 裝置驅動和中斷訊號:需要特定的裝置驅動程式和中斷訊號來儘早響應中斷。

- 執行緒優先順序:設定執行緒優先順序並不好,因為這些系統不太容易切換任務。

實時作業系統的例子有:科學實驗、醫學成像系統、工業控制系統、武器系統、機器人、空中交通控制系統等。

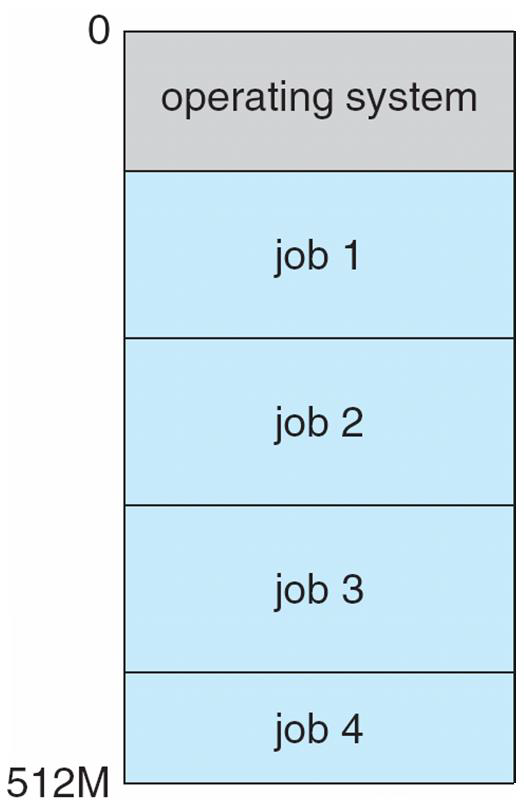

18.1.2.4 多道程式作業系統

多程式設計(Multiprogramming)概念通過組織作業增加CPU利用率,CPU總有一個作業要執行。作業系統同時在記憶體中保留多個作業,如下圖所示。

這組作業是作業池中保留的作業的子集,作業系統拾取並開始執行記憶體中的一個作業,當一個作業需要等待時,CPU只需切換到另一個作業,依此類推。

多道程式作業系統很複雜,因為作業系統為使用者做出決定,稱為作業排程。如果多個作業準備同時執行,系統將從中選擇一個,稱為CPU排程。其他功能包括記憶體管理、裝置和檔案管理。

多道程式系統的優點是有效的資源利用率(CPU、記憶體、外圍裝置),消除或最小化浪費的CPU空閒時間,增加的吞吐量(在給定的時間間隔內,相對於提交執行的作業數量,執行的作業數)。

多道程式系統的缺點是在程式執行期間,不提供使用者與計算機系統的互動,磁碟技術的引入解決了這些問題,而不是將卡片從讀卡器讀入磁碟,這種處理形式稱為聯機,複雜且相當昂貴。

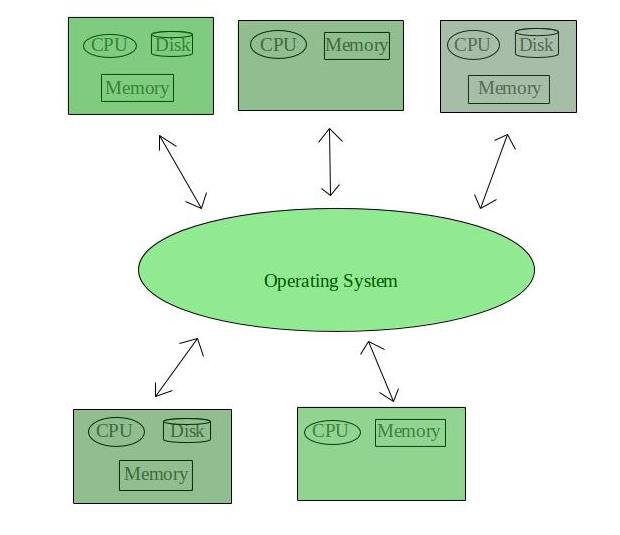

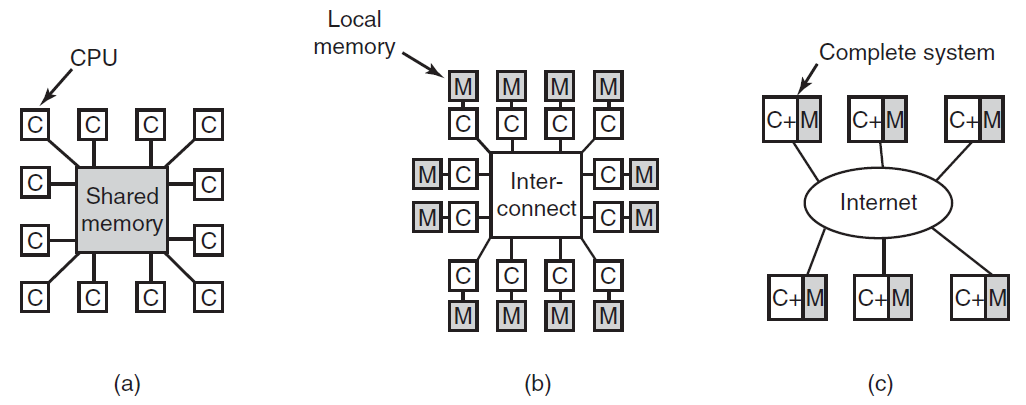

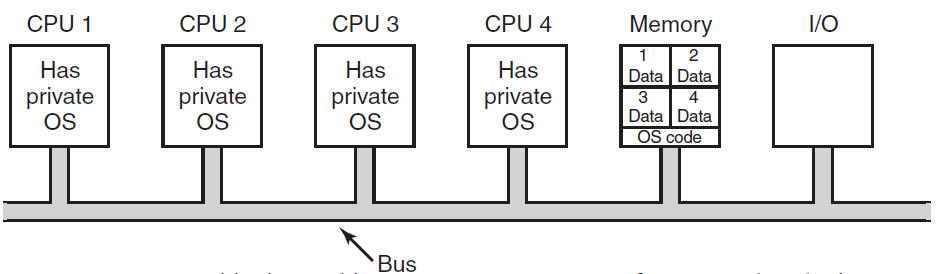

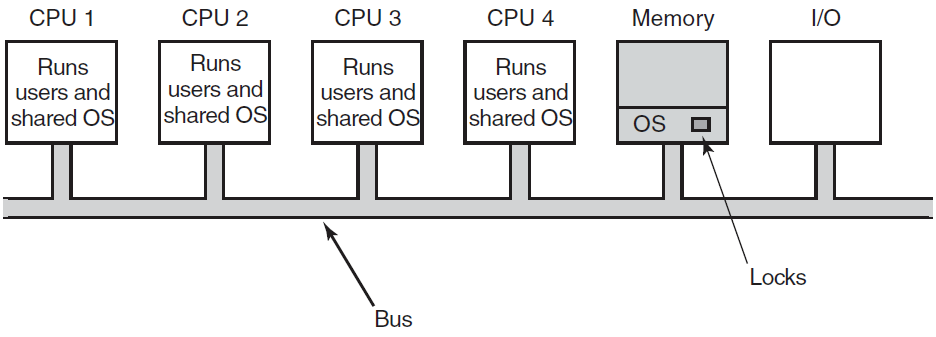

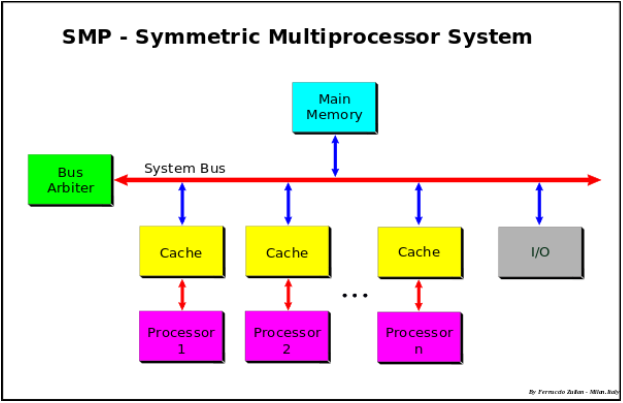

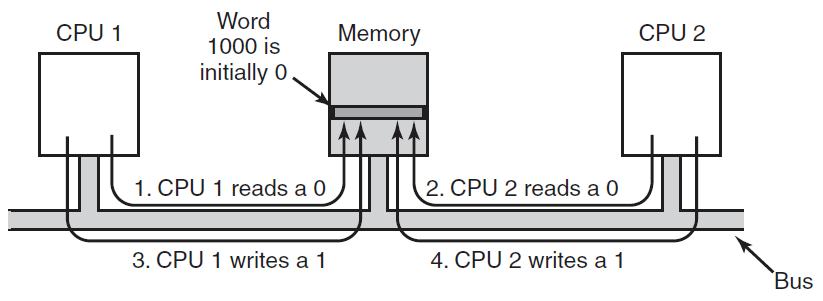

18.1.2.5 多處理器/並行/緊耦合系統

這些系統有多個處理器進行緊密通訊,共用計算機匯流排、時鐘、記憶體和外圍裝置,例如UNIX、LINUX。多處理器系統有三個主要優點:

- 增加的吞吐量:每單位時間計算的程序數。通過增加處理器的數量,可以在更短的時間內完成工作。N個處理器的加速比不是N,但小於N。因為在保持所有部件正常工作時會產生一定的開銷。

- 提高可靠性:如果功能可以在多個處理器之間正確分配,那麼一個處理器的故障不會停止系統,而是會降低系統速度。這種即使發生故障仍能繼續執行的能力使系統具有容錯能力。

- 經濟伸縮:多處理器系統可以節省資金,因為它們可以共用外圍裝置、儲存和電源。

多處理系統的型別包括:

- 對稱多處理(Symmetric Multiprocessing,SMP):每個處理器執行作業系統的相同副本,這些副本根據需要彼此通訊。例如:Encore版本的UNIX for multi-max計算機。實際上,包括Windows NT、Solaris、Digital UNIX、OS/2和LINUX在內的所有現代作業系統現在都支援SMP。

- 非對稱多處理(主-從處理器,Master – Slave Processors):每個處理器都是為特定任務設計的。主處理器控制系統,並將工作安排和分配給從處理器。Ex-Sun的作業系統SUNOS版本4提供非對稱多處理。

18.1.2.6 分散式/鬆耦合系統

與緊耦合系統相比,處理器不共用記憶體或時鐘,相反,每個處理器都有自己的本地記憶體。處理器通過各種通訊線路(如高速匯流排或電話線)相互通訊,分散式系統的功能依賴於網路。通過能夠通訊,分散式系統能夠共用計算任務併為使用者提供豐富的功能集,網路因所使用的協定、節點和傳輸媒介之間的距離而異。

TCP/IP是最常見的網路協定,分散式系統中的處理器大小和功能各不相同,可以是微處理器、工作站、小型計算機和大型通用計算機,網路型別基於節點之間的距離,例如LAN(在房間、樓層或建築物內)和WAN(在建築物、城市或國家之間)。

分散式作業系統的優點:資源共用,計算速度加快,負載共用/負載平衡,可靠性,通訊。

分散式作業系統的缺點:主網路故障將停止整個通訊,為了建立分散式系統,所使用的語言還沒有很好的定義,這些型別的系統並不容易獲得,因為它們非常昂貴。不僅底層軟體非常複雜,而且還沒有被很好地理解。範例是LOCUS等。

18.1.2.7 網路作業系統

這些系統在伺服器上執行,並提供管理資料、使用者、組、安全、應用程式和其他網路功能的能力。此類作業系統允許通過小型專用網路共用存取檔案、印表機、安全、應用程式和其他網路功能。網路作業系統的另一個重要方面是,所有使用者都清楚底層設定、網路中所有其他使用者的設定、他們的個人連線等,這就是為什麼這些計算機通常被稱為緊耦合系統的原因。

網路作業系統的優點:高度穩定的集中式伺服器,安全問題通過伺服器處理,新技術和硬體升級很容易整合到系統中,可以從不同位置和型別的系統遠端存取伺服器。網路作業系統的缺點:伺服器成本高昂,使用者必須依賴中央位置進行大多數操作,需要定期維護和更新。

網路作業系統的範例有Microsoft Windows Server 2003、Microsoft Windows Server 2008、UNIX、Linux、Mac OS X、Novell NetWare和BSD等。

18.1.3 作業系統結構

作業系統體系結構的設計傳統上遵循關注點分離原則,這一原則建議將作業系統結構化為相對獨立的部分,這些部分提供簡單的單個功能,從而使設計的複雜性保持可控。

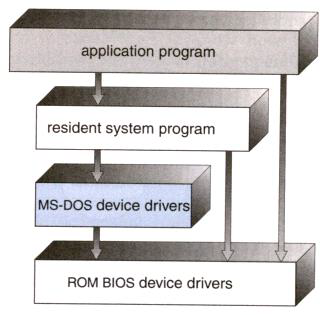

18.1.3.1 簡單結構

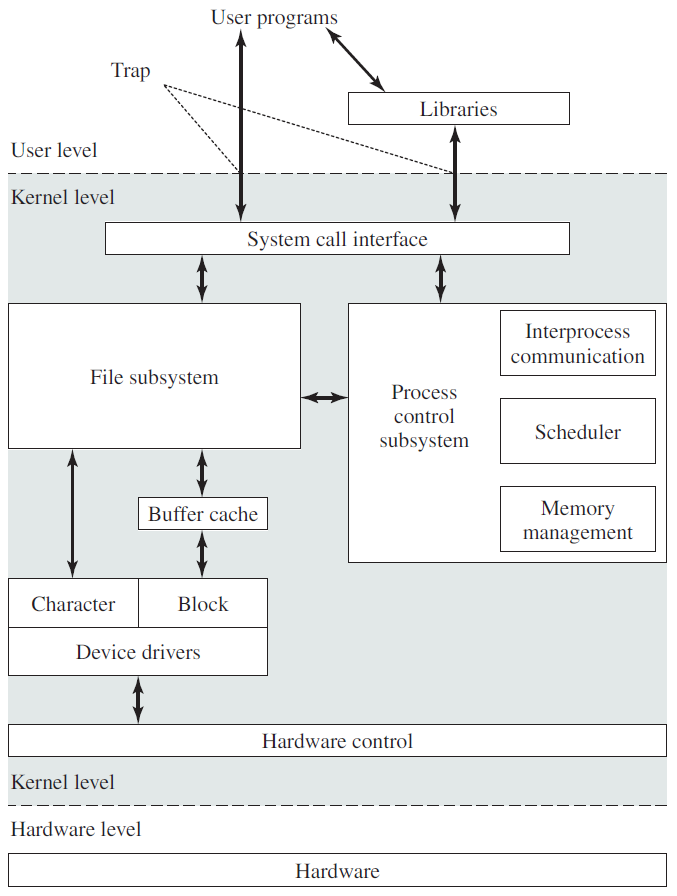

有幾個商業系統沒有定義良好的結構,例如作業系統開始時是小的、簡單的和有限的系統,然後擴充套件到超出其原始範圍。MS-DOS就是這種系統的一個例子,沒有仔細地劃分成模組。另一個有限結構的例子是UNIX作業系統,沒有CPU執行模式(使用者和核心),因此應用程式中的錯誤可能會導致整個系統崩潰。

g)

g)

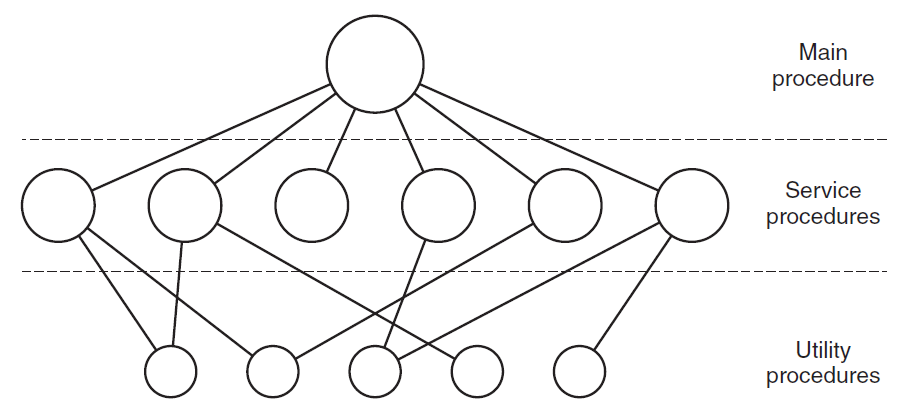

18.1.3.2 單片結構

在這個模型中,對於每個系統呼叫,都有一個服務過程來處理和執行它。實用程式執行多個服務程式所需的操作,例如從使用者程式中獲取資料。程式分為三層,如下圖所示。

作業系統體系結構的單片設計不適合作業系統的特殊性質。儘管設計遵循關注點分離,但沒有嘗試限制授予作業系統各個部分的許可權,整個作業系統以最大許可權執行。

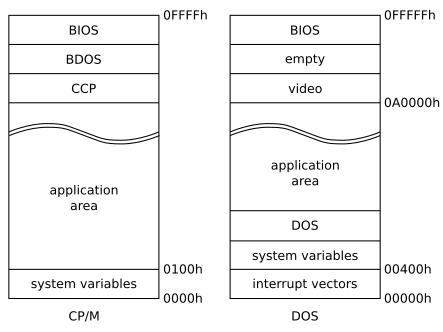

單片作業系統內的通訊開銷與任何其他軟體內的通訊開支相同,被認為相對較低。CP/M和DOS是單片作業系統的簡單範例,CP/M和DOS都是與應用程式共用單個地址空間的作業系統。在CP/M中,16位元地址空間以系統變數和應用程式區域開始,以作業系統的三個部分結束,即CCP(控制檯命令處理器)、BDOS(基本磁碟作業系統)和BIOS(基本輸入/輸出系統)。在DOS中,20位地址空間從中斷向量陣列和系統變數開始,然後是DOS的常駐部分和應用程式區域,最後是視訊卡和BIOS使用的記憶體塊。

18.1.3.3 分層結構

在分層方法中,作業系統被劃分為多個層(級別),每個層都構建在較低層之上。底層(第0層)是硬體,最頂層(第N層)是使用者介面。

作業系統的分層通用架構。

分層方法的主要優點是模組化,層的選擇使得每個使用者只具有較低層的功能(或操作)和服務。這種方法簡化了偵錯和系統驗證,即可以偵錯第一層,而不必考慮系統的其餘部分。一旦偵錯了第一層,就假定它在偵錯第二層時正常工作,依此類推。如果在偵錯特定層的過程中發現錯誤,則該錯誤必須位於該層上,因為它下面的層已被偵錯。

這樣,當系統被分解為多個層次時,系統的設計和實現就簡化了。每個層僅使用較低層提供的操作來實現,層不需要知道這些操作是如何實現的;它只需要知道這些操作是做什麼的。分層方法首先在作業系統中使用。它被定義為六層。

| 層 | 功能 |

|---|---|

| 5 | 使用者程式 |

| 4 | I/O管理 |

| 3 | 操作程序通訊 |

| 2 | 記憶體管理 |

| 1 | CPU排程 |

| 0 | 硬體 |

分層方法的主要缺點:

1、主要困難在於對層的仔細定義,因為一個層只能使用它下面的那些層。例如,虛擬記憶體演演算法使用的磁碟空間的裝置驅動程式必須低於記憶體管理例程的級別,因為記憶體管理需要使用磁碟空間的能力。

2、效率低於非分層系統(每一層都會增加系統呼叫的開銷,最終的結果是系統呼叫比非分層系統花費的時間更長)。

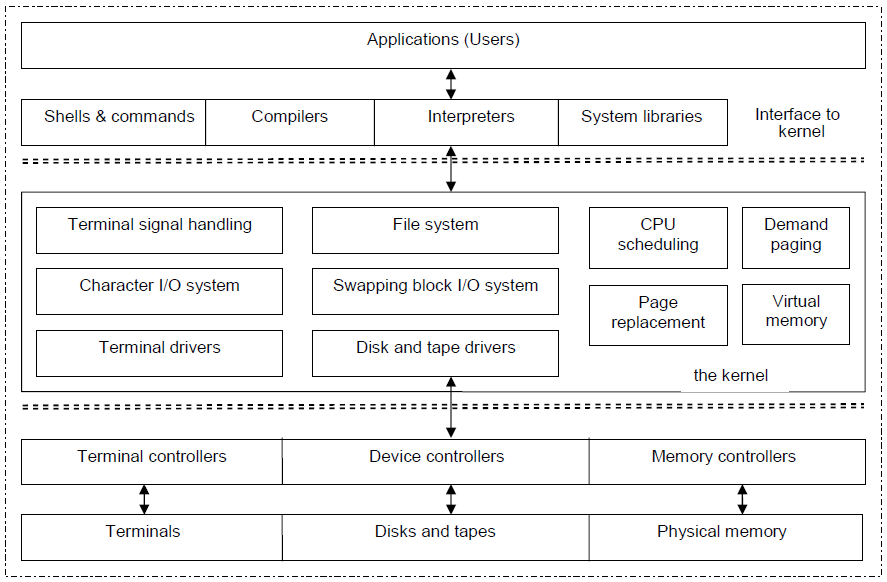

其中,Unix系統的架構如下圖所示:

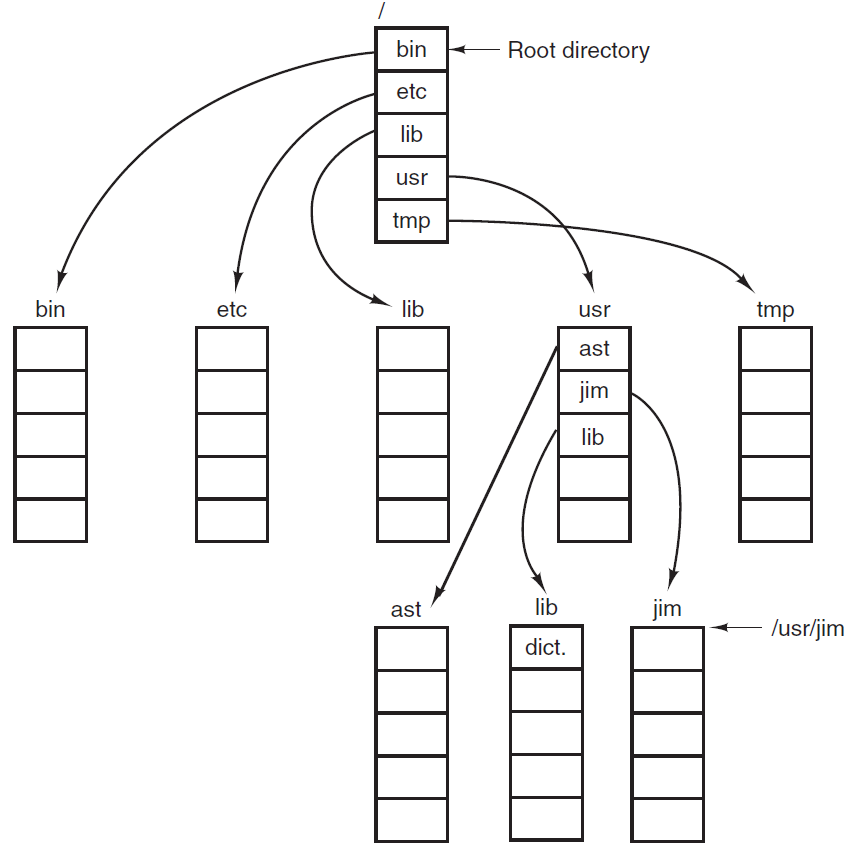

Unix可分為核心和系統程式。Unix核心包括系統資源管理、介面和裝置驅動程式,如CPU排程、檔案系統、記憶體管理和I/O管理。

Linux是針對Intel 386/486/Pentium機器的完整Unix克隆,充當計算機系統的硬體和軟體之間的通訊服務,其核心包含了任何作業系統中所期望的所有特性,部分功能包括:

- 多工處理(一種在多個獨立作業之間共用單個處理器的技術)。

- 虛擬記憶體(允許重複、擴充套件使用計算機的RAM以提高效能)。

- 快速TCP/IP驅動程式(用於快速通訊)。

- 共用庫(使應用程式能夠共用公共程式碼)。

- 多使用者能力(意味著數百人可以通過網路、網際網路、筆記型電腦/計算機或連線到這些計算機串列埠的終端同時使用計算機)。

- 保護模式(允許程式存取實體記憶體,並保護系統的穩定性)。

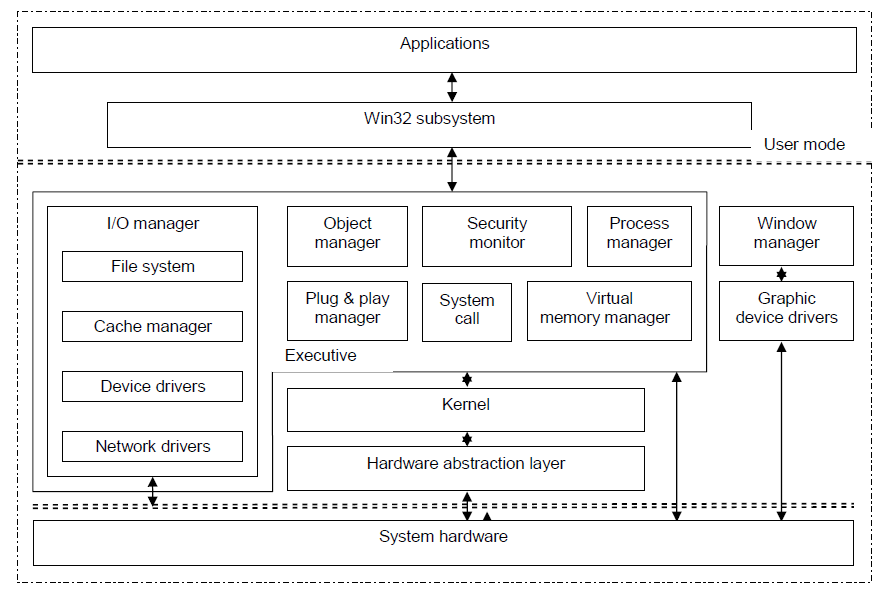

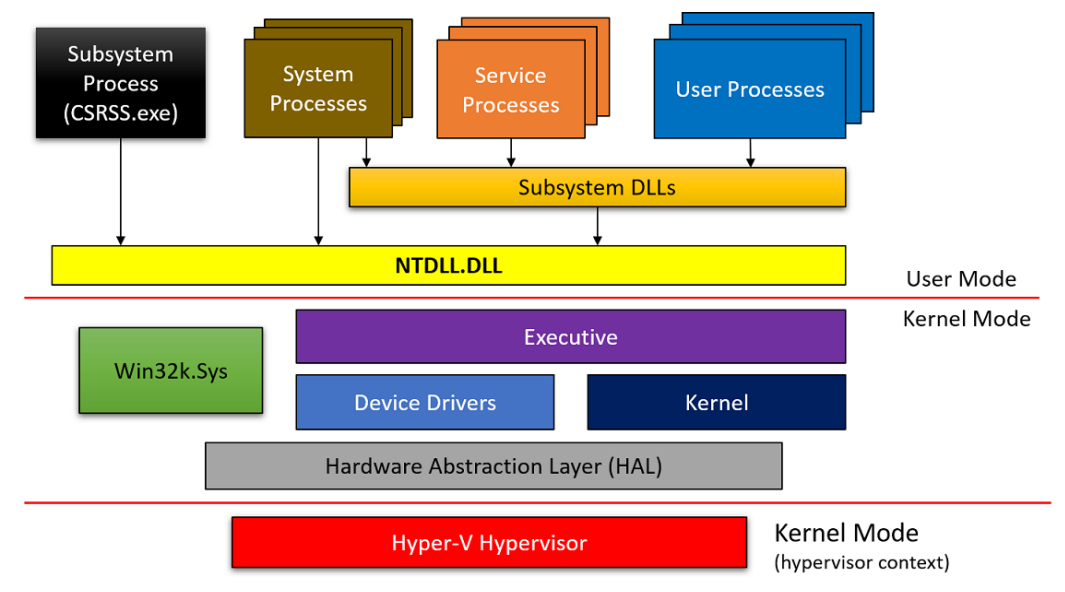

Windows XP是一個基於增強技術的多工作業系統,整合了Windows 2000的優點,如基於標準的安全性、可管理性和可靠性,以及Windows 98和Windows Me的最佳功能,如隨插即用和易於使用的使用者介面。Windows XP的體系結構如下圖所示,採用分層結構,由硬體抽象層、核心層、執行層、使用者模式層和應用程式組成。

Windows XP的每個核心實體都被視為一個物件,由執行程式中的物件管理器管理。使用者模式應用程式可以通過程序中的物件控制程式碼呼叫核心物件。使用核心物件來提供基本服務,以及對使用者端-伺服器計算的支援,使Windows XP能夠支援多種應用程式。Windows XP還提供虛擬記憶體、整合快取、搶佔式排程、更強的安全模式和國際化功能。

Windows和Windows Vista架構圖。

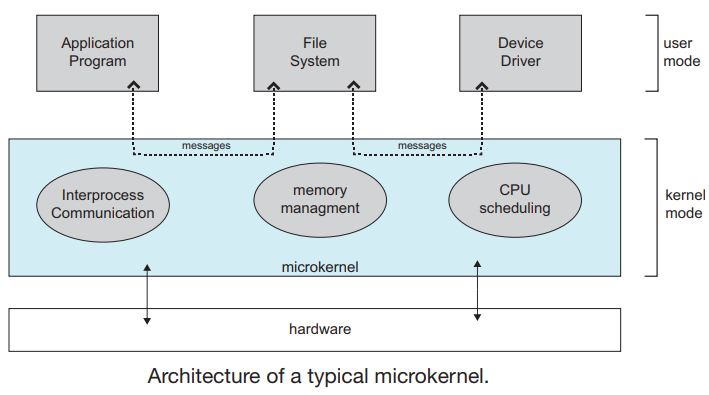

18.1.3.4 微核心結構

通過刪除核心的所有不重要部分並將其作為系統級和使用者級程式實現來構建作業系統,通常提供最少的程序和記憶體管理以及通訊設施, 作業系統元件之間的通訊通過訊息傳遞提供。

微核心的優點是擴充套件作業系統變得容易得多,對核心的任何更改都會減少,因為核心更小,微核心還提供了更高的安全性和可靠性。主要缺點是由於訊息傳遞增加了系統開銷,效能較差。

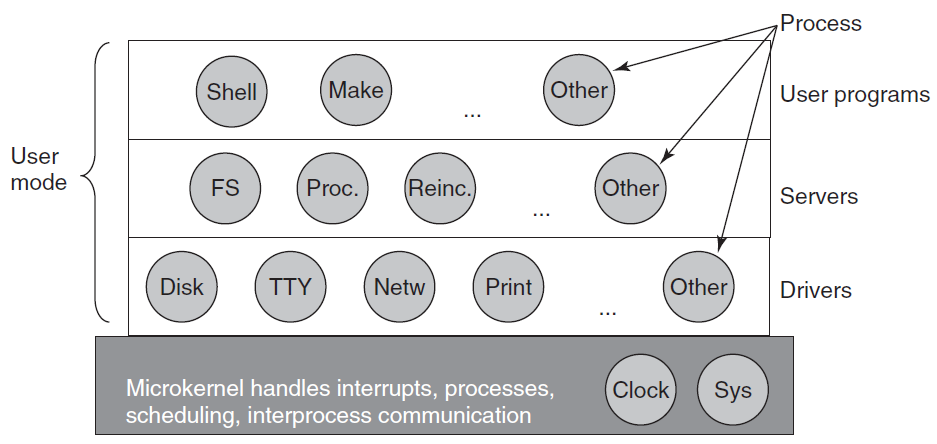

MINIX 3微核心只有大約12000行C語言和1400行組合語言,用於捕捉中斷和切換程序等非常低階的功能。C程式碼管理和排程程序,處理程序間通訊(通過在程序之間傳遞訊息),並提供一組大約40個核心呼叫,以允許作業系統的其餘部分完成其工作。這些呼叫執行諸如將處理程式掛接到中斷、在地址空間之間行動資料以及為新程序安裝記憶體對映等功能。MINIX 3的程序結構如下圖所示,核心呼叫處理程式標記為Sys。時鐘的裝置驅動程式也在核心中,因為排程程式與它緊密互動。其他裝置驅動程式作為單獨的使用者程序執行。

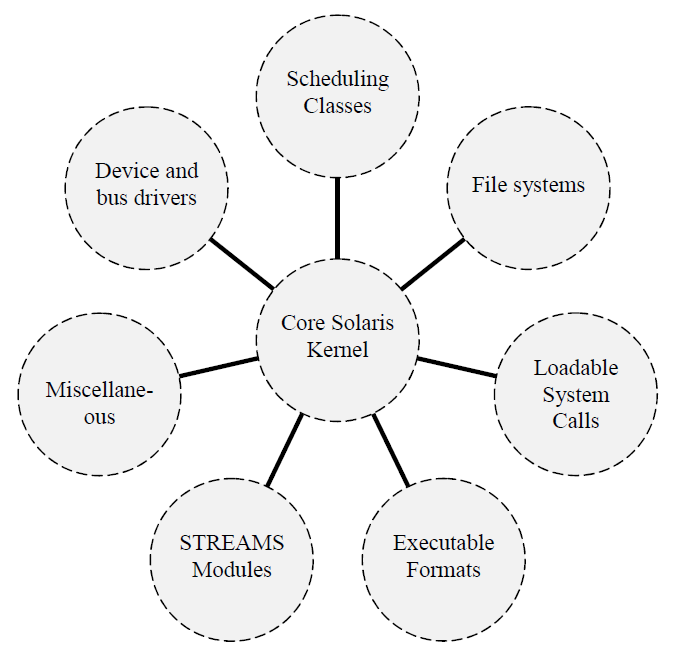

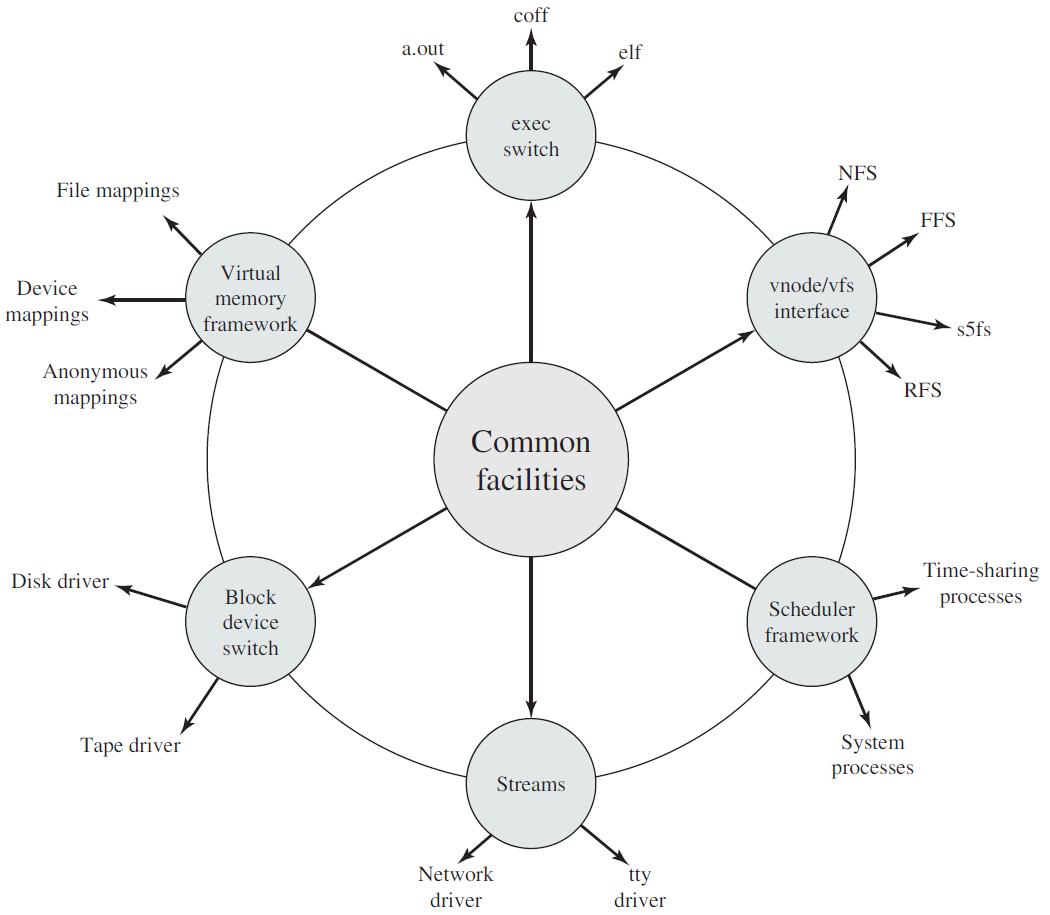

Solaris結構圖如下:

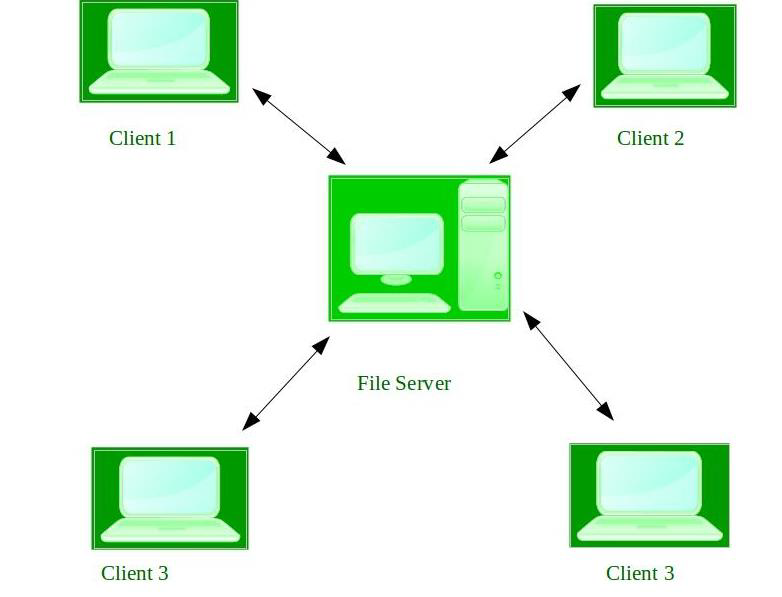

18.1.3.5 使用者端-伺服器結構

微核心思想的一個微小變化是區分兩類程序,即伺服器(每個程序都提供一些服務)和使用者端(使用這些服務)。此模型稱為客戶機-伺服器模型,通常最底層是微核心(但非必需),其本質是使用者端程序和伺服器程序的存在。

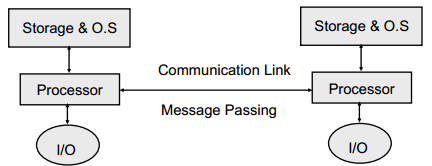

使用者端和伺服器之間的通訊通常是通過訊息傳遞進行的。為了獲得服務,使用者端程序構造一條訊息,說明它想要什麼,並將其傳送到適當的服務。然後,該服務完成工作並返回答案。如果客戶機和伺服器碰巧在同一臺機器上執行,則可以進行某些優化,如訊息傳遞。

這種想法的一個明顯的概括是讓使用者端和伺服器執行在不同的計算機上,通過區域網或廣域網連線,如下圖所示。由於使用者端通過傳送訊息與伺服器通訊,使用者端不需要知道訊息是在自己的機器上本地處理的,還是通過網路傳送到遠端機器上的伺服器。就客戶而言,在這兩種情況下都會發生同樣的事情:傳送請求,然後回覆。因此,客戶機-伺服器模型是一種抽象,可以用於單個機器或機器網路。

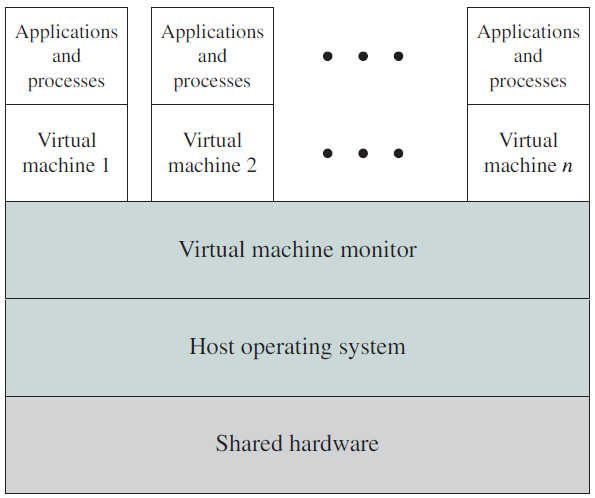

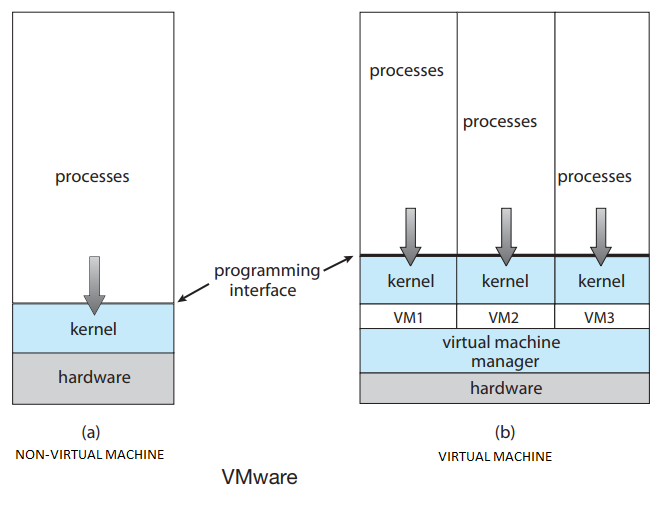

18.1.3.6 虛擬機器器

虛擬機器器涉及的概念。

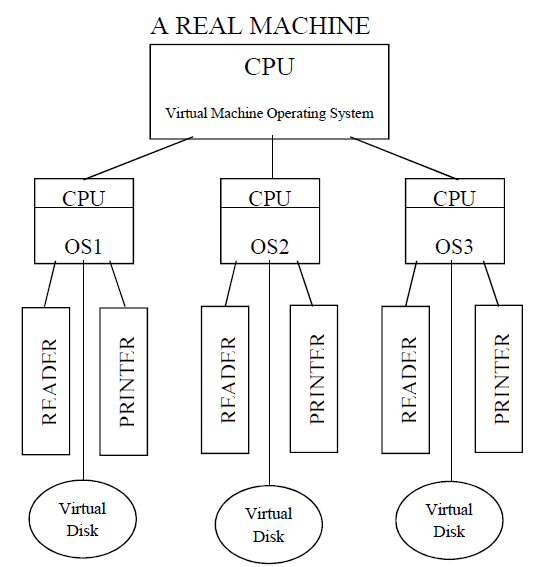

虛擬機器器採用分層方法得出其邏輯結論,將硬體和作業系統核心視為硬體,提供與底層裸硬體相同的介面。作業系統產生了多個程序的錯覺,每個程序都使用自己的(虛擬)記憶體在自己的處理器上執行,共用物理計算機的資源以建立虛擬機器器。CPU排程可以建立使用者擁有自己處理器的外觀。聯機和檔案系統可以提供虛擬讀卡器和虛擬行印表機。普通使用者分時終端充當虛擬機器器操作員的控制檯。

虛擬機器器概念提供了對系統資源的完全保護,因為每個虛擬機器器都與所有其他虛擬機器器隔離。然而,這種隔離不允許直接共用資源。虛擬機器器系統是作業系統研究和開發的完美工具。系統開發是在虛擬機器器上進行的,而不是在物理機上進行,因此不會中斷正常的系統操作。虛擬機器器概念很難實現,因為需要為底層機器提供精確的副本。它的缺點是虛擬機器器包括由於大量模擬虛擬機器器操作而增加的系統開銷,VM OS的效率取決於VM監視器必須模擬的運算元。虛擬機器器可分為程序和系統兩個級別:

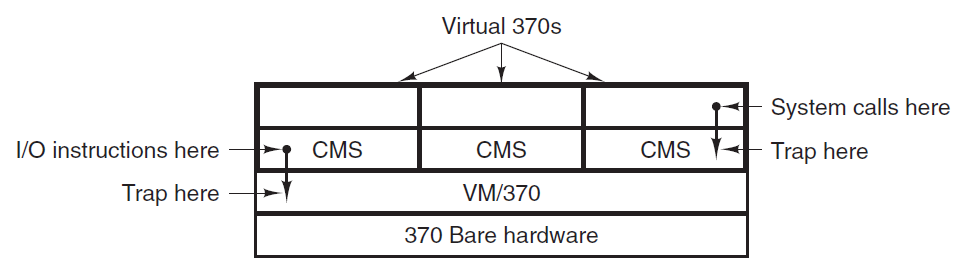

VM/370是於1979由Seawright和MacKinnon推出的虛擬機器器,它基於一個敏銳的觀察:分時系統提供(1)多道程式設計和(2)擴充套件機器,與裸硬體相比,具有更方便的介面。VM/370的本質是將這兩個功能完全分離。

系統的核心,即虛擬機器器監視器,在裸硬體上執行並執行多道程式設計,向上一層提供的不是一個,而是幾個虛擬機器器,如圖1-28所示。然而,與所有其他作業系統不同,這些虛擬機器器不是擴充套件機,具有檔案和其他漂亮的功能。相反,它們是裸硬體的精確副本,包括核心/使用者模式、I/O、中斷以及真實機器所擁有的所有其他內容。

虛擬化在Web託管領域也很流行。如果沒有虛擬化,Web託管客戶就不得不在共用託管和專用託管之間進行選擇。當一家網路託管公司提供虛擬機器器出租時,一臺物理機可以執行許多虛擬機器器,每個虛擬機器器看起來都是一臺完整的機器。租用虛擬機器器的客戶可以執行他們想要的任何作業系統和軟體,但成本僅為專用伺服器的一小部分(因為同一物理機同時支援多個虛擬機器器)。

虛擬化的另一個用途是為那些希望能夠同時執行兩個或更多作業系統(例如Windows和Linux)的終端使用者提供的,因為他們喜歡的一些應用程式包在一個上執行,而另一些在另一個上執行。這種情況如圖下圖(a)所示,其中術語「虛擬機器器監控器」已重新命名為型別1虛擬機器器監控程式,現在常用的是,因為「虛擬機器器監控」需要的擊鍵次數比人們現在準備好的要多。

(a) 1類虛擬機器器監控程式。(b) 純型別2管理程式。(c) 一個實用的2型管理程式。

虛擬計算機的一種架構範例。

使用虛擬機器器的另一個領域是執行Java程式,但方式有所不同。當Sun Microsystems發明Java程式語言時,它還發明瞭一種稱為JVM(Java Virtual Machine)的虛擬機器器(即電腦架構)。Java編譯器為JVM生成程式碼,然後通常由軟體JVM直譯器執行。這種方法的優點是,JVM程式碼可以通過Internet傳送到任何具有JVM直譯器並在其中執行的計算機,例如,如果編譯器生成了SPARC或x86二進位制程式,那麼它們就不可能如此容易地釋出和執行。使用JVM的另一個優點是,如果直譯器實現正確(並不是小事),可以檢查傳入的JVM程式的安全性,然後在受保護的環境中執行,這樣它們就不會竊取資料或造成任何損壞。

18.1.4 作業系統元件

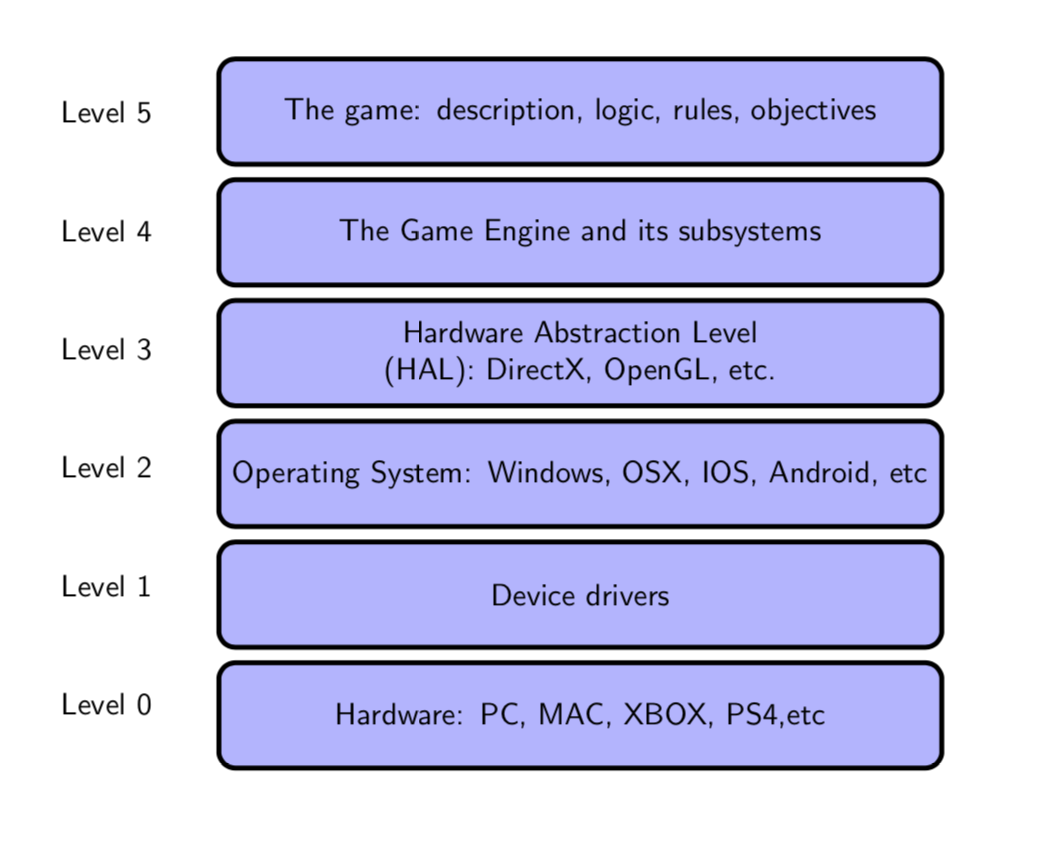

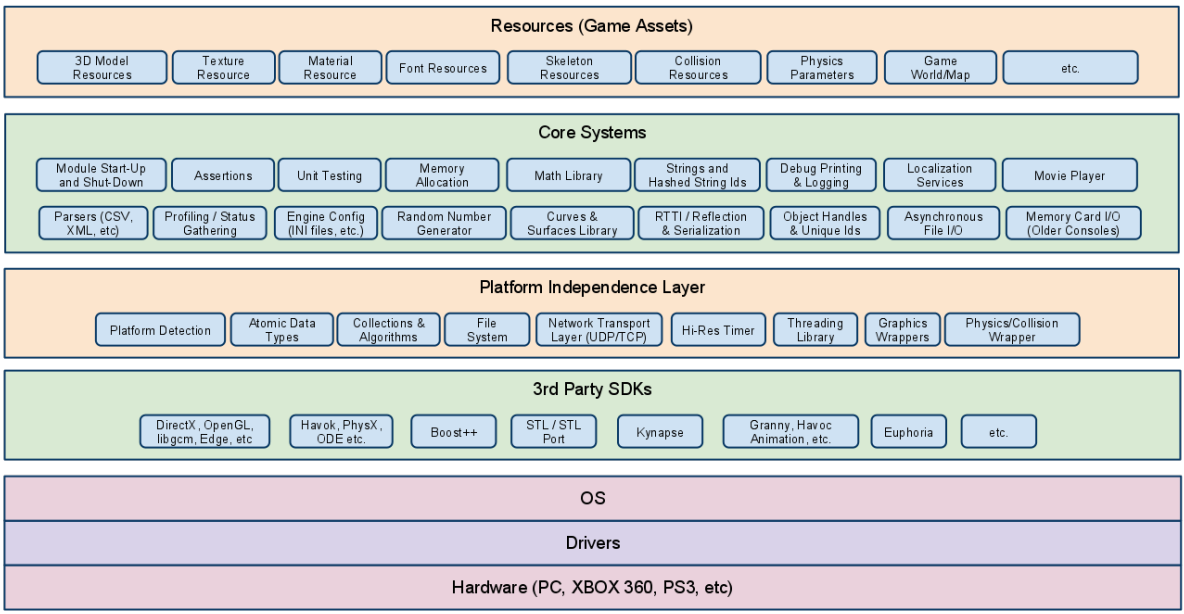

遊戲開發是一個非常複雜的過程和專案,如果沒有模組化架構和高效開發環境的幫助,幾乎是不可行的。當前市面上的各種產品共用由以下抽象層次組成的結構,從上到下分別是:遊戲應用、遊戲引擎、圖形API、作業系統、裝置驅動、硬體裝置。

下圖是更加詳細的層級模組,其中作業系統(OS)處於圖形API等第三方SDK和驅動之間,充當著承上啟下的重要作用和通訊橋樑,是整個計算機層級架構極其重要的組成部分。

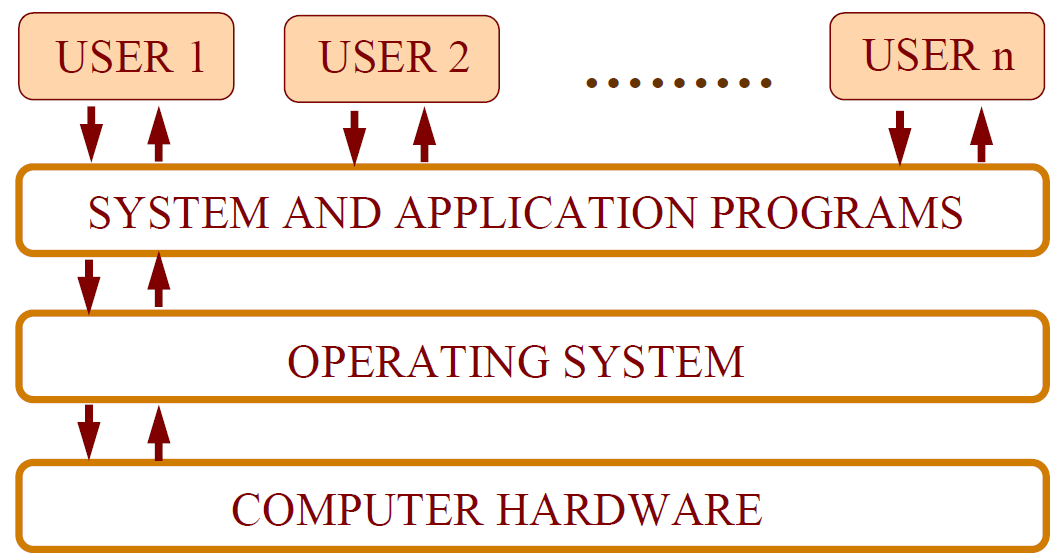

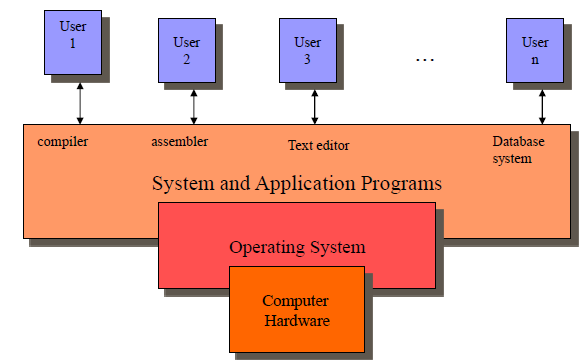

計算機系統可以分為四個部分:硬體、作業系統、應用程式和使用者。系統元件的抽象檢視如圖1所示。

1、硬體:如CPU、記憶體和I/O裝置。

2、作業系統:在計算機系統的操作中提供正確使用硬體的方法,類似於政府。

3、應用程式:解決使用者的計算問題,如:編譯器、資料庫系統和web瀏覽器。

4、使用者:人、機器或其他計算機。

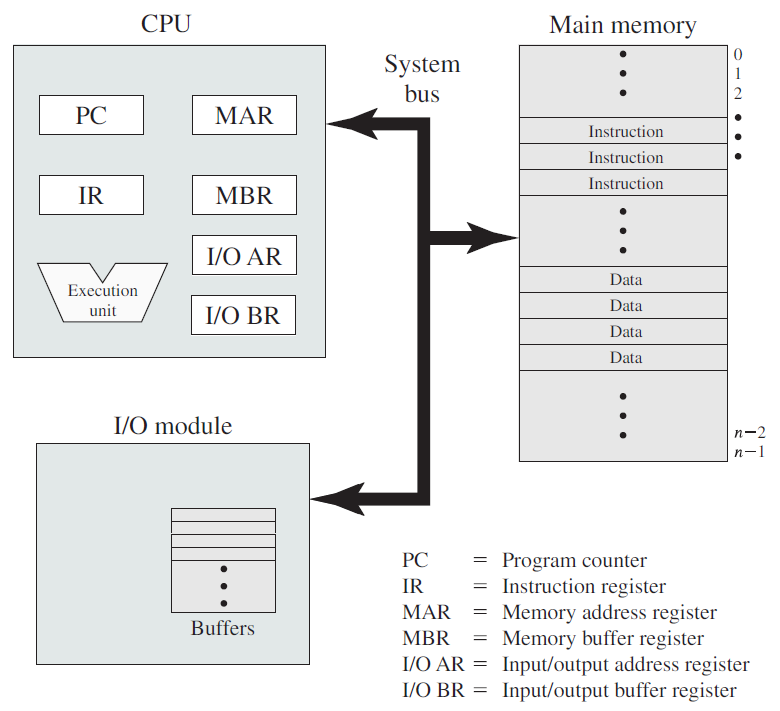

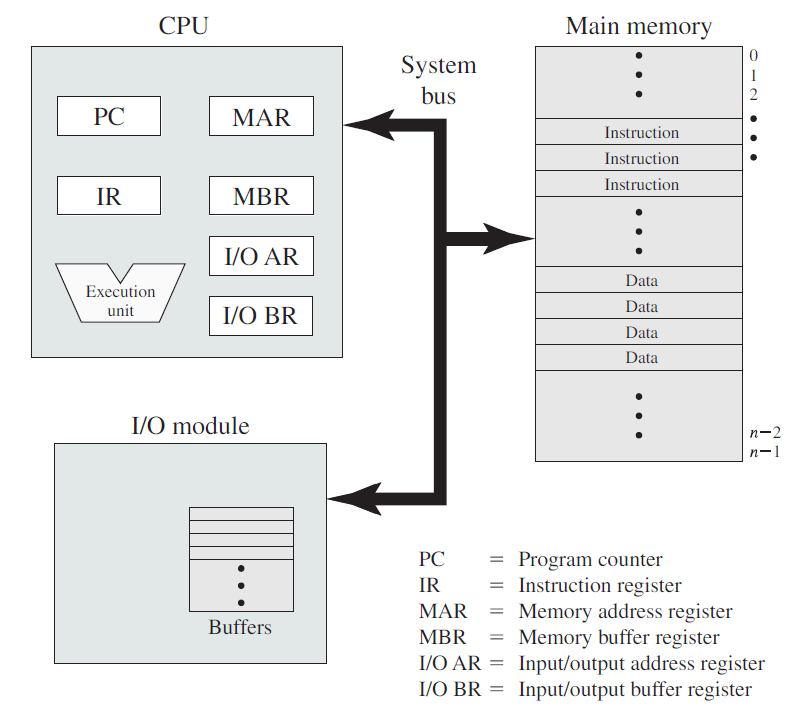

在頂層,計算機由處理器、記憶體和I/O元件組成,每種型別有一個或多個模組。這些元件以某種方式互連,以實現計算機的主要功能,即執行程式。有四個主要結構要素:

- 處理器:控制計算機的操作並執行其資料處理功能。當只有一個處理器時,它通常被稱為中央處理單元(CPU)。

- 主記憶體儲器:儲存資料和程式。易丟失,當計算機關閉時,記憶體中的內容會丟失。相反,即使計算機系統關閉,磁碟記憶體的內容也會保留。主記憶體儲器也稱為實記憶體或主記憶體儲器。

- I/O模組:在計算機及其外部環境之間行動資料外部環境由各種裝置組成,包括輔助記憶體裝置(如磁碟)、通訊裝置和終端。

- 系統匯流排:提供處理器、主記憶體儲器和I/O模組之間的通訊。

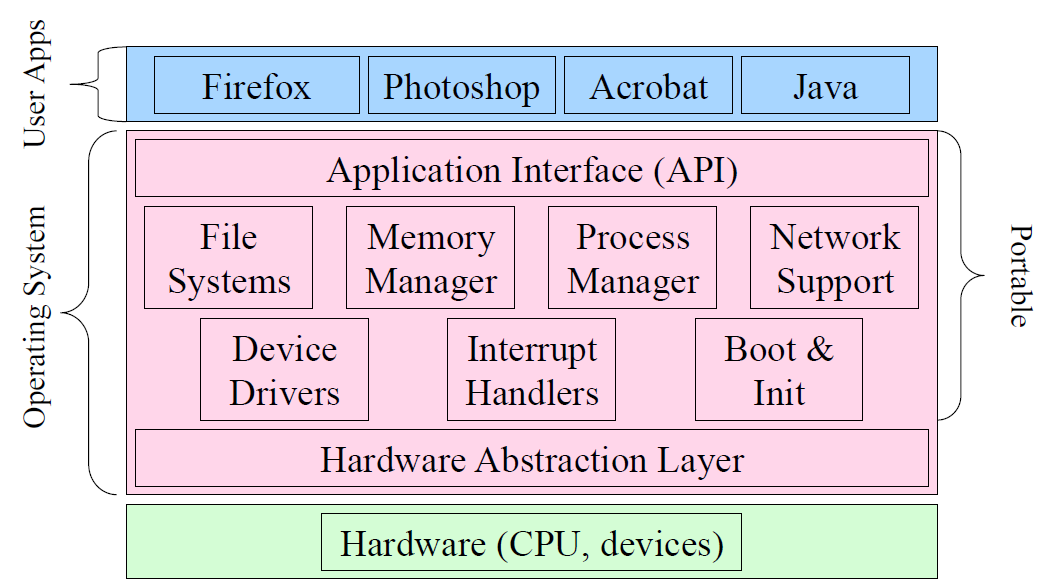

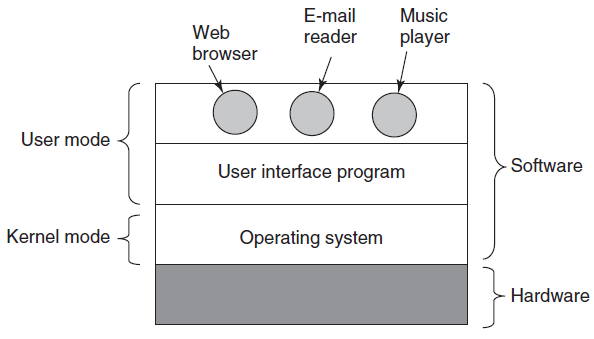

作業系統所處的層級如下圖所示:

通用系統架構如下圖,展示了Windows的總體架構,包含了使用者模式和核心模式元件。

上圖中出現的概念的簡要說明如下:

-

使用者模式:

-

使用者程序。是基於映象檔案(image file)的普通程序,在系統上執行,例如Notepad.exe、cmd.exe、explorer.exe等。

-

子系統DLL。子系統DLL是實現子系統API的動態連結庫(DLL),子系統是核心公開的功能的特定檢視。從技術上講,從Windows 8.1開始,只有一個子系統——Windows子系統。子系統dll包括眾所周知的檔案,如kernel32.dll、user32.dll、gdi32.dll,advapi32.dll和combase.dll和許多其他dll。它們主要實現了Windows的官方API。

-

NTDLL.DLL。實現Windows本機API的系統範圍DLL,是程式碼的最底層,仍處於使用者模式,最重要的作用是將系統呼叫轉換到核心模式,還實現了堆管理器、映像載入器和使用者模式執行緒池的某些部分。

-

服務程序。服務程序是正常的Windows程序,與服務控制管理器(SCM,在services.exe中實現)通訊,並允許對其生命週期進行一些控制。SCM可以啟動、停止、暫停、恢復並向服務傳送其他訊息。

-

系統程序。系統程序是一個概括術語,用於描述通常「就在那裡」的程序,在通常情況下,這些程序不會直接通訊。儘管如此,它們仍然很重要,其中一些對系統的功能至關重要,終止其中一些會導致致命的系統崩潰。一些系統程序是原生程序,意味著它們只使用原生API(由NTDLL實現的API)。系統程序的範例包括Smss.exe、Lsass.exe、Winlogon.exe、Services.exe等。

-

子系統程序。Windows子系統程序,執行映象Csrss.exe,可視為核心助手,用於管理在Windows系統下執行的程序。它是一個關鍵的程序,如果被殺死,系統將崩潰。通常有一個CSRS.exe範例,因此在標準系統中存在兩個範例——一個用於對談(通常為0),一個用於登入使用者對談(通常為1)。儘管CSRS.exe是Windows子系統的「管理器」(目前僅剩的一個),其重要性不僅僅是此角色。

-

-

核心模式:

- 執行層(Executive)。執行層是NtOskrnl.exe(「核心」)的上層,承載了核心模式下的大部分程式碼。主要包括各種管理器:物件管理器、記憶體管理器、I/O管理器、隨插即用管理器、電源管理器、設定管理器等,遠遠大於底層的核心層。

-

核心。核心層實現核心模式作業系統程式碼的最基本和時間敏感部分,包括執行緒排程、中斷和異常排程以及各種核心原語(如互斥和號誌)的實現。一些核心程式碼是用CPU特定的機器語言編寫的,以提高效率並直接存取CPU特定的細節。

- 裝置驅動程式。裝置驅動程式是可載入的核心模組,其程式碼以核心模式執行,因此擁有核心的全部功能。經典裝置驅動程式提供了硬體裝置和作業系統其餘部分之間的粘合劑,其他型別的驅動程式提供過濾功能。

-

Win32k.sys。Windows子系統的核心模式元件,本質上是一個核心模組(驅動程式),用於處理Windows的使用者介面部分和經典的圖形裝置介面(GDI)API。意味著所有視窗操作都由該元件處理,系統的其餘部分對UI幾乎一無所知。

- 硬體抽象層(HAL)。HAL是最接近CPU的硬體上的抽象層,允許裝置驅動程式使用不需要中斷控制器或DMA控制器等詳細和特定知識的API。當然,這一層對於為處理硬體裝置而編寫的裝置驅動程式非常有用。目標是將特定於硬體的例程從「核心」作業系統中分離出來,提供便攜性,提高可讀性。

-

Hyper-V管理程式。如果支援基於虛擬化的安全性(VBS),則Hyper-V管理程式存在於Windows 10和server 2016(及更高版本)系統上。VBS提供了額外的安全層,其中實際的機器實際上是由Hyper-V控制的虛擬機器器。

下圖是微核心結構示意圖:

OS的元件通常包含控制程式、系統服務程式、工具類程式等。其中,控制程式建立環境以執行其它程式,通過圖形介面,控制和維護計算機操作,例如windows環境的GUI。系統服務程式無需使用者干預即可執行特定功能,可以手動啟動,也可以設定為在啟動作業系統時自動啟動,在執行作業系統時在後臺執行,可能會影響系統效能、響應能力、能效和安全性,例如任務排程程式、windows更新、信使服務、隨插即用、索引服務等。工具類程式執行與管理系統資源相關的非常具體的任務,關注各種計算機元件的操作方式,常用實用程式是磁碟格式化實用程式、防病毒實用程式、備份實用程式、檔案管理器、磁碟清理等。

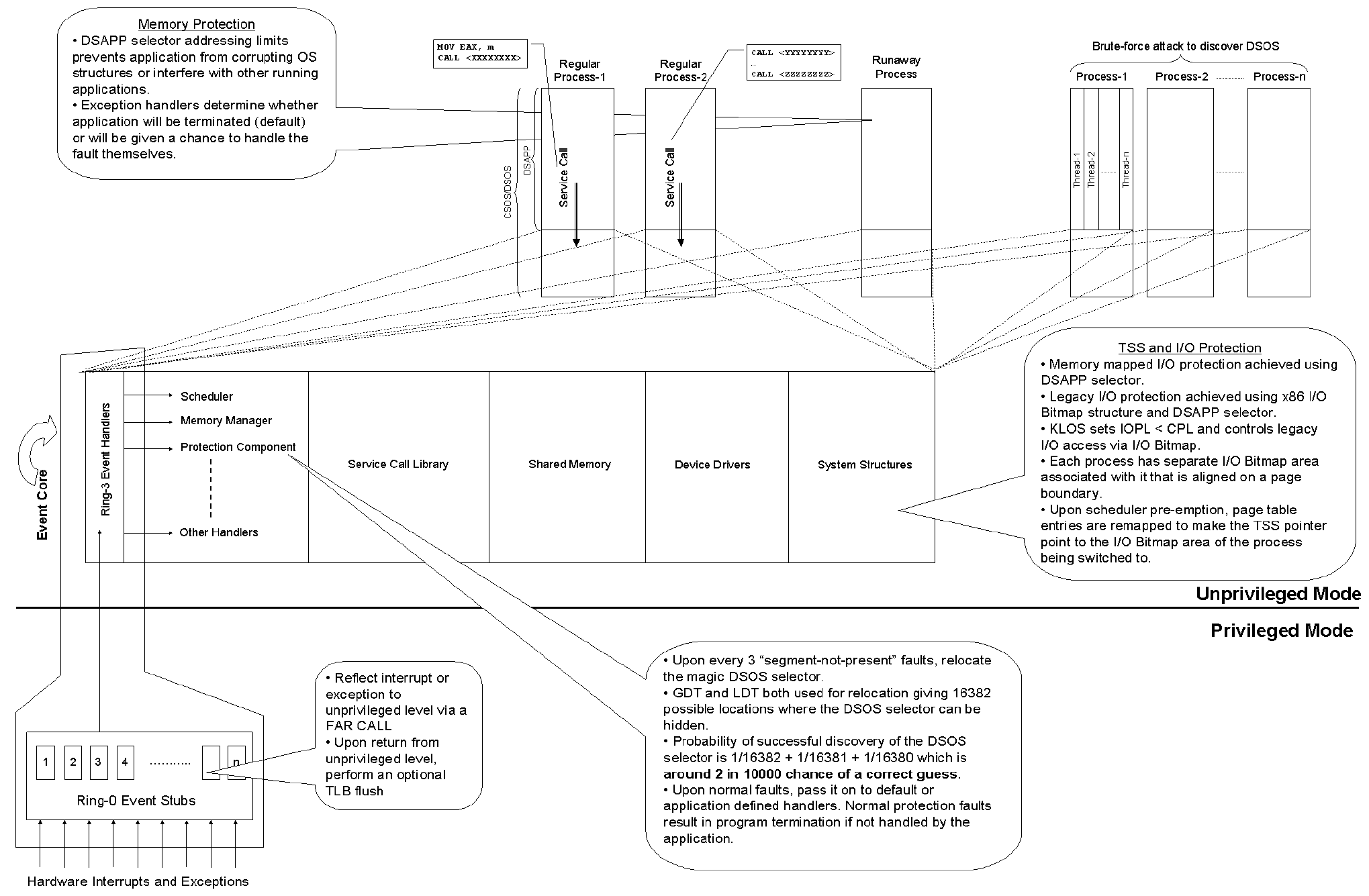

作業系統提供由程序通過涉及環轉換的機制存取的服務,以將控制轉移到執行所需功能的核心。這有一個顯著的缺點,即每個服務呼叫都涉及上下文切換的開銷,其中儲存處理器狀態並執行保護域傳輸。然而,正如A High Performance Kernel-Less Operating System Architecture所發現的,在支援分段的處理器體系結構上,通過不執行環轉換,可以在存取作業系統提供的服務時獲得顯著的效能提升。KLOS是基於這種設計構建的無核心作業系統,它的服務呼叫機制比當前廣泛實施的服務或系統呼叫機制快了一個數量級,比傳統陷阱/中斷提高了4倍,比Intel SYSENTER/SYSEXIT快速系統呼叫模型提高了2倍。

KLOS的架構圖。

18.1.5 作業系統高效能開發

常見的OS高效能開發技術包含:

-

線上和離線操作。為每個I/O裝置編寫了一個稱為裝置控制器的特殊子程式,一些I/O裝置已配備用於線上操作(它們連線到處理器)或離線操作(它們由控制單元執行)。

-

緩衝。緩衝區是一個主記憶體儲器區域,用於在I/O傳輸期間儲存資料。輸入時,資料通過I/O通道放入緩衝區,當傳輸完成時,處理器可以存取資料。可以是單緩衝或雙緩衝。

-

聯機(同時進行外圍裝置線上操作)。聯機將磁碟用作非常大的緩衝區,它很有用,因為裝置存取不同速率的資料。緩衝區提供了一個等待站,當較慢的裝置趕上時,資料可以在這裡暫存。聯機允許一個作業的計算和另一個作業I/O之間的重疊。

-

多道程式處理。在多道程式設計中,幾個程式同時儲存在主記憶體中,CPU在它們之間切換,因此CPU總是有一個要執行的程式。作業系統開始從記憶體執行一個程式,如果該程式需要等待,例如I/O操作,作業系統將切換到另一個程式。多程式設計提高了CPU利用率。多道程式設計系統提供了一種環境,在這種環境中,各種系統資源得到了有效利用,但它們不提供使用者與計算機系統的互動。優勢是CPU利用率高,似乎許多程式幾乎同時分配CPU。缺點是需要CPU排程,要在記憶體中容納許多作業,需要記憶體管理。

-

並行系統。系統中的處理器上有2個及以上,這些處理器共用計算機匯流排、時鐘、記憶體和I/O裝置。優點是提高吞吐量(以時間單位完成的程式數)。

-

分散式系統。在幾個物理處理器之間分配計算,涉及通過通訊鏈路連線2個或多個獨立的計算機系統。因此,每個處理器都有自己的OS和本地記憶體,處理器通過各種通訊線路(如高速匯流排或電話線)相互通訊。

分散式系統的優點:

- 資源共用,可以共用檔案和印表機。

- 計算速度加快。可以對作業進行分割區,以便每個處理器可以並行執行一部分任務(負載共用)。

- 可靠性。如果一個處理器出現故障,其餘處理器仍然可以正常工作。

- 通訊。如電子郵件、ftp。

-

個人計算機。專用於單個使用者的計算機系統,PC作業系統既不是多使用者系統,也不是多工系統。PC作業系統的目標是最大限度地提高使用者的便利性和響應能力,而不是最大限度地利用CPU和I/O。比如Microsoft Windows和Apple Macintosh。

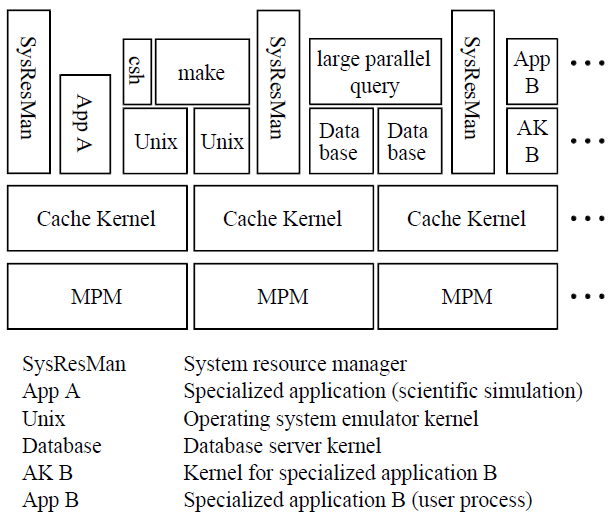

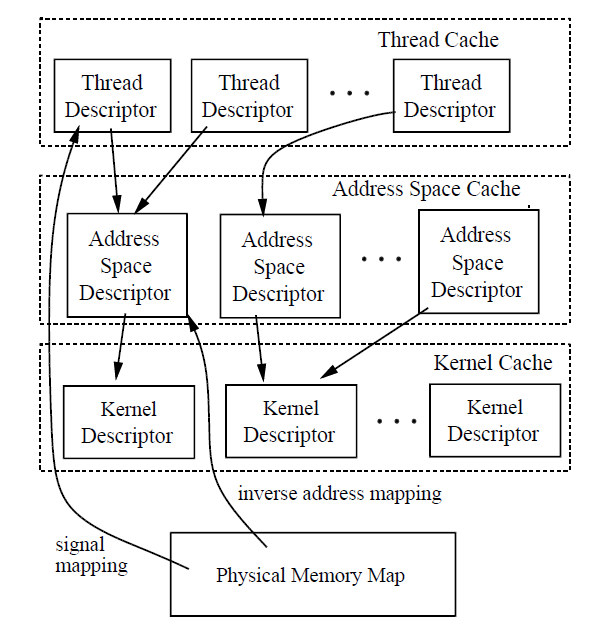

A caching model of operating system kernel functionality描述了作業系統功能的快取模型,可以快取核心快取執行緒和地址空間等作業系統物件,就像傳統硬體快取記憶體資料一樣。使用者模式應用程式核心處理這些物件的載入和寫回,實現特定於應用程式的管理策略和機制。在多處理器上實現快取核心及其效能測量的經驗表明,該快取模型可以提供與傳統單片作業系統相比具有競爭力的效能,同時還可以提供系統資源的應用程式級控制、更好的模組化、更好的可伸縮性、更小的大小以及故障控制的基礎。

如下圖所示,各種應用程式、伺服器核心和作業系統模擬器可以在同一硬體上同時執行。一個稱為系統資源管理器(SRM)的特殊應用程式核心,每個快取核心/MPM複製一個,管理其他應用程式核心之間的資源共用,以便它們可以同時共用相同的硬體,而不會產生不合理的干擾。例如,它可以防止執行大型模擬的惡意應用程式核心中斷提供在同一ParaDiGM設定上執行的分時服務的UNIX模擬器的執行。

軟體架構一覽。

下圖顯示了Cache Kernel物件之間的依賴關係。圖中的箭頭表示從箭頭尾部的物件到頭部的物件的參照,因此是快取依賴項。例如,實體記憶體對映中的訊號對映參照一個執行緒,該執行緒參照一個參照其所屬核心物件的地址空間。因此,當執行緒、地址空間或核心被解除安裝時,必須解除安裝訊號對映。

快取資料架構。

18.2 計算機硬體概覽

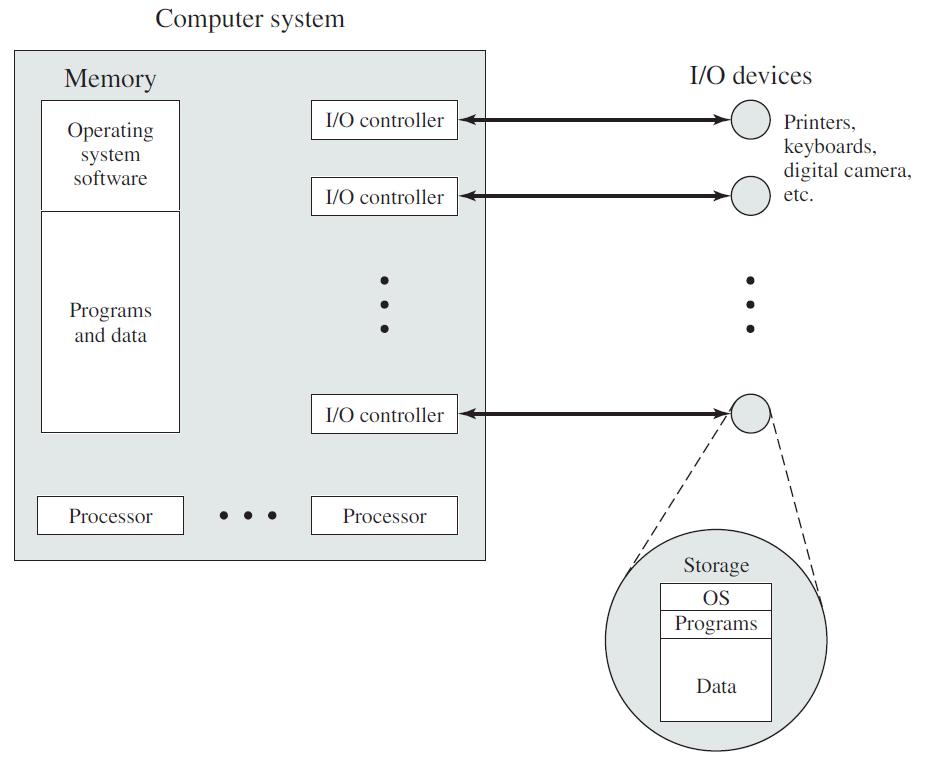

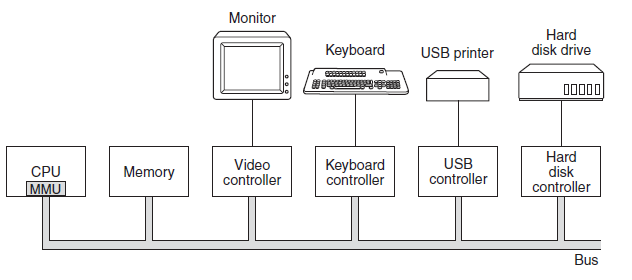

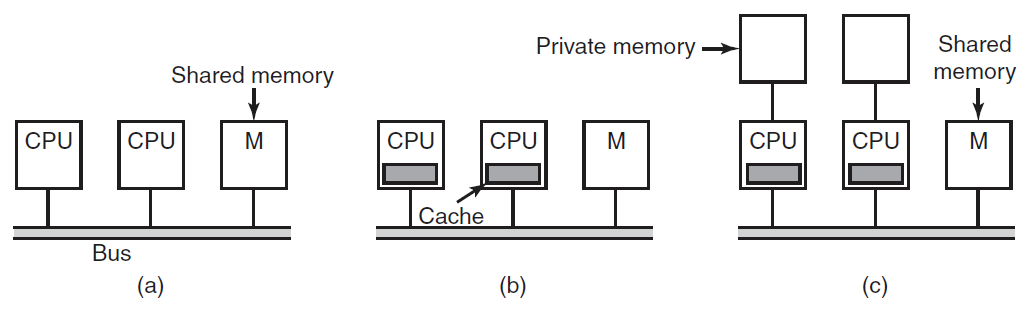

作業系統與執行它的計算機的硬體緊密相連,它擴充套件了計算機的指令集並管理其資源。一臺簡單的個人計算機可以抽象為類似於下圖的模型,CPU、記憶體和I/O裝置都通過系統匯流排連線,並通過它彼此通訊。現代個人電腦的結構更復雜,涉及多條匯流排。

計算機硬體架構抽象圖。

計算機硬體組成圖。

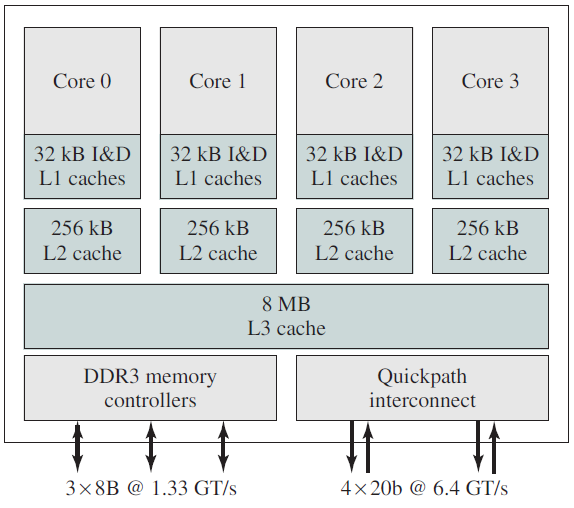

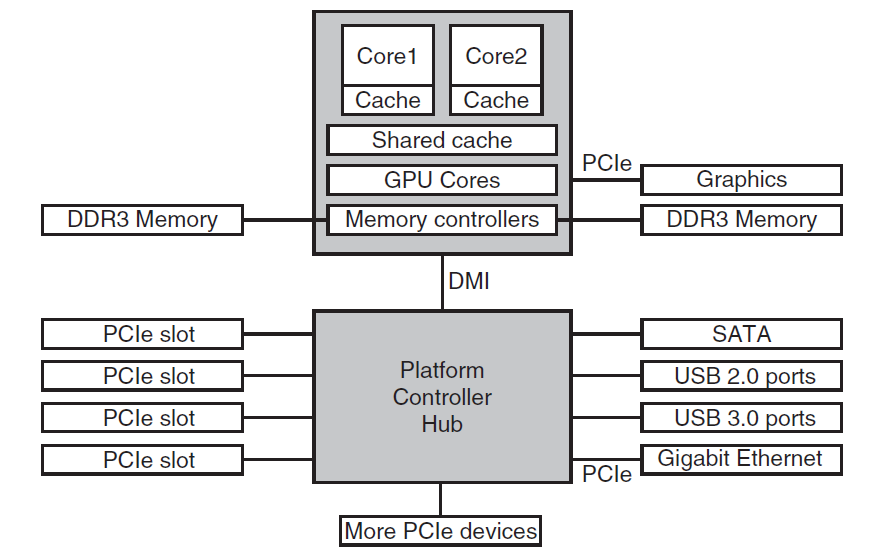

Intel Core i7結構圖。

18.2.1 CPU

計算機的「大腦」是CPU,它從記憶體中獲取指令並執行它們。每個CPU的基本週期是從記憶體中獲取第一條指令,對其進行解碼以確定其型別和運算元,然後執行,然後獲取、解碼和執行後續指令。迴圈重複,直到程式結束。以這種方式執行程式。

每個CPU都有一組特定的指令可以執行。因此,x86處理器無法執行ARM程式,而ARM處理器無法執行x86程式。因為存取記憶體以獲取指令或資料字比執行指令需要更長的時間,所以所有CPU都包含一些暫存器來儲存關鍵變數和臨時結果。因此,指令集通常包含將字從記憶體載入到暫存器,並將字從暫存器儲存到記憶體的指令。其他指令將來自暫存器、記憶體或兩者的兩個運算元組合成一個結果,例如新增兩個字並將結果儲存在暫存器或記憶體中。

除了用於儲存變數和臨時結果的通用暫存器外,大多數計算機還具有程式設計師可見的幾個專用暫存器。其中之一是程式計數器,它包含要提取的下一條指令的記憶體地址。獲取該指令後,程式計數器將更新為指向其後續指令。另一個暫存器是堆疊指標,它指向記憶體中當前堆疊的頂部。堆疊包含每個已進入但尚未退出的過程的一個幀。過程的堆疊框架儲存那些不儲存在暫存器中的輸入引數、區域性變數和臨時變數。另一個暫存器是PSW(程式狀態字)。該暫存器包含由比較指令、CPU優先順序、模式(使用者或核心)和各種其他控制位設定的條件程式碼位。使用者程式通常可以讀取整個PSW,但通常只能寫入其部分欄位。PSW在系統呼叫和I/O中起著重要作用。

作業系統必須完全瞭解所有暫存器。當對CPU進行多路複用時,作業系統通常會停止正在執行的程式以(重新)啟動另一個程式。每次停止執行的程式時,作業系統必須儲存所有暫存器,以便在程式稍後執行時恢復。

為了提高效能,CPU設計者早已放棄了一次獲取、解碼和執行一條指令的簡單模型。許多現代CPU都具有同時執行多條指令的功能。例如,CPU可能有單獨的提取、解碼和執行單元,因此在執行指令n時,它也可能是解碼指令n+1和提取指令n+2。這種組織稱為管道,如下圖(a)所示,用於三級管道。較長的管道是常見的。在大多數管道設計中,一旦指令被提取到管道中,就必須執行它,即使前面的指令是執行的條件分支。管道給編譯器編寫者和作業系統編寫者帶來了極大的麻煩,因為它們向他們暴露了底層機器的複雜性,並且他們必須處理它們。

比管道設計更先進的是超標量(superscalar)CPU,如上圖(b)所示。在這種設計中,有多個執行單元,例如一個用於整數運算,一個用於浮點運算,另一個用於布林運算。兩個或多個指令被同時獲取、解碼並轉儲到一個保持緩衝區,直到它們可以執行為止。一旦執行單元可用,它就會檢視保持緩衝區中是否有它可以處理的指令,如果有,就從緩衝區中刪除該指令並執行它。這種設計的一個含義是,程式指令經常亂序執行。在大多數情況下,要由硬體來確保產生的結果與順序實現所產生的結果相同,但正如我們將看到的那樣,作業系統上強加了令人討厭的複雜性。

如前所述,除嵌入式系統中使用的非常簡單的CPU外,大多數CPU都有兩種模式,核心模式和使用者模式。通常,PSW中的一個位控制模式。在核心模式下執行時,CPU可以執行其指令集中的每一條指令,並使用硬體的每一項功能。在桌上型電腦和伺服器上,作業系統通常以核心模式執行,從而可以存取整個硬體。在大多數嵌入式系統上,一小部分以核心模式執行,其餘作業系統以使用者模式執行。

使用者程式總是在使用者模式下執行,該模式只允許執行指令的子集和存取功能的子集。通常,在使用者模式下,所有涉及I/O和記憶體保護的指令都是不允許的。當然,也禁止將PSW模式位設定為進入核心模式。

要從作業系統獲取服務,使用者程式必須進行系統呼叫,該呼叫會進入核心並呼叫作業系統。TRAP指令從使用者模式切換到核心模式,並啟動作業系統。工作完成後,根據系統呼叫後的指令將控制權返回給使用者程式。可以將其視為一種特殊的程序呼叫,它具有從使用者模式切換到核心模式的附加屬性。

值得注意的是,除了執行系統呼叫的指令之外,計算機還有陷阱(trap),大多數其它陷阱是由硬體警告異常情況(如試圖除以0或浮點下溢)引起的。在所有情況下,作業系統都會得到控制,並且必須決定要做什麼。有時程式必須因錯誤而終止,其他時候可以忽略錯誤(下溢數位可以設定為0)。最後,當程式事先宣佈要處理某些型別的條件時,可以將控制權傳遞迴程式,讓它處理問題。

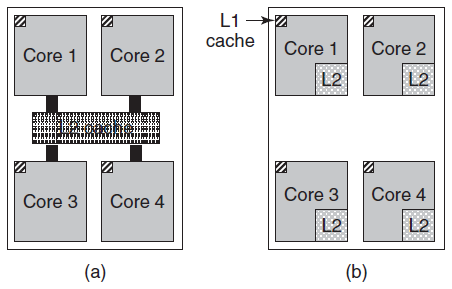

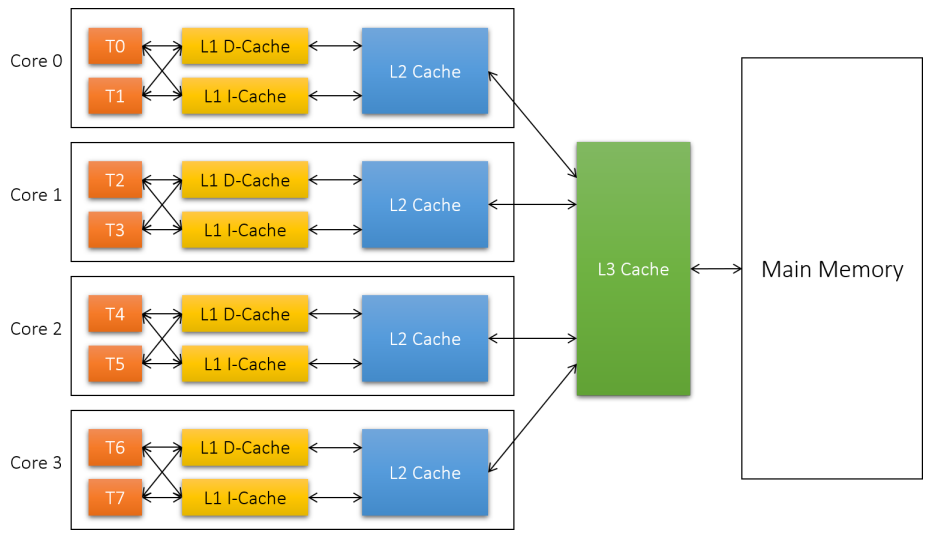

除了多執行緒之外,現在許多CPU晶片上都有四個、八個或更多完整的處理器或核心。下圖中的多核晶片有效地攜帶了四個微型晶片,每個晶片都有自己的獨立CPU,一些處理器(如Intel Xeon Phi和Tilera TilePro)已經在單個晶片上執行了60多核。使用這種多核晶片肯定需要多處理器作業系統。

順便說一句,就絕對數量而言,沒有什麼能比得上現代GPU(圖形處理單元),GPU是一個擁有數千個微核心的處理器,它們對於許多並行完成的小計算非常有用,比如在圖形應用程式中渲染多邊形。他們不太擅長連續任務,也很難程式設計。雖然GPU對作業系統很有用(例如,加密或處理網路流量),但作業系統本身不太可能在GPU上執行。

(a) 具有共用二級快取的四核晶片。(b) 具有獨立二級快取的四核晶片。

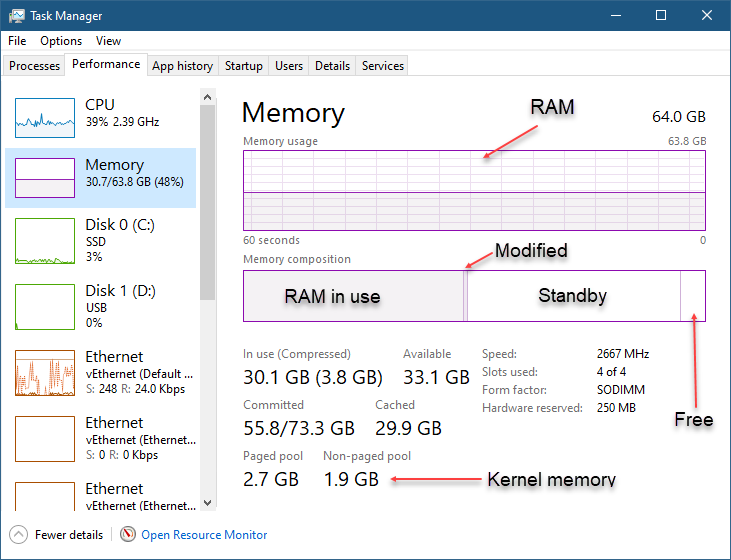

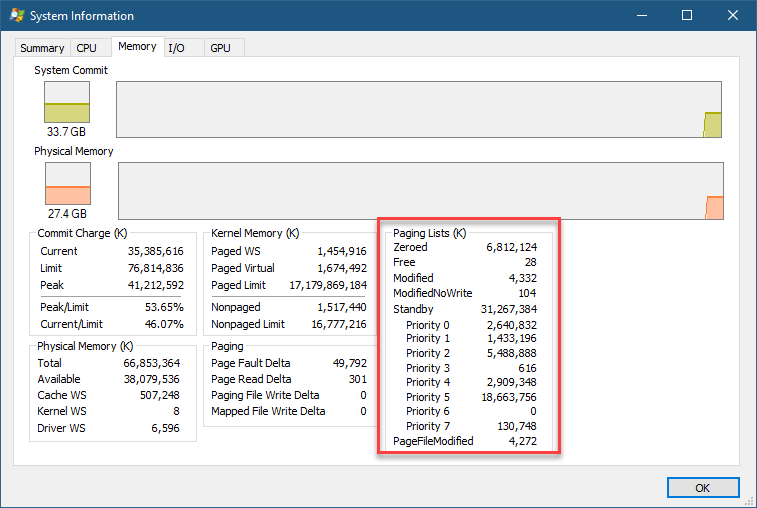

18.2.2 記憶體

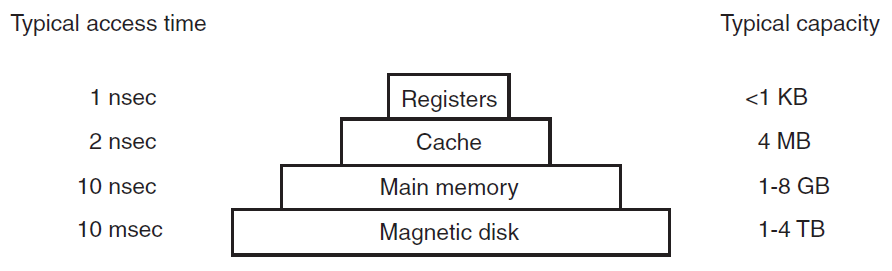

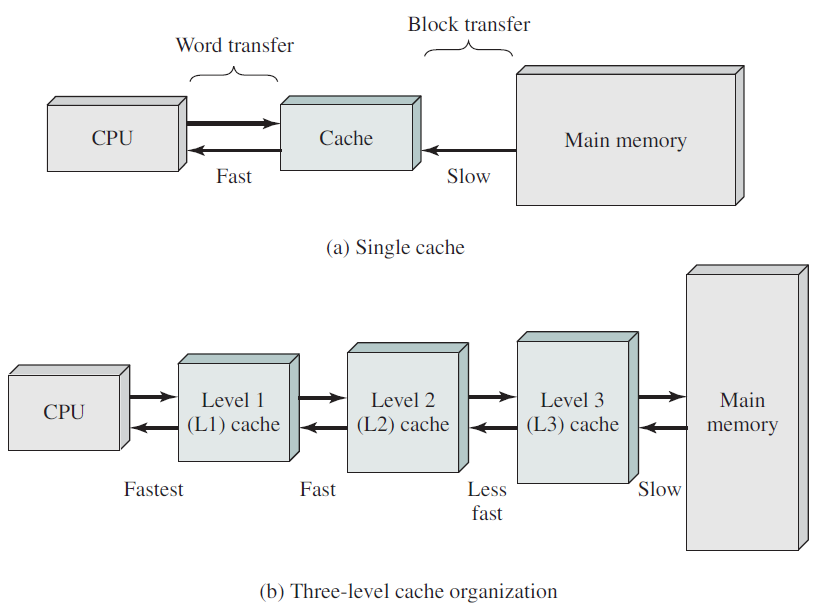

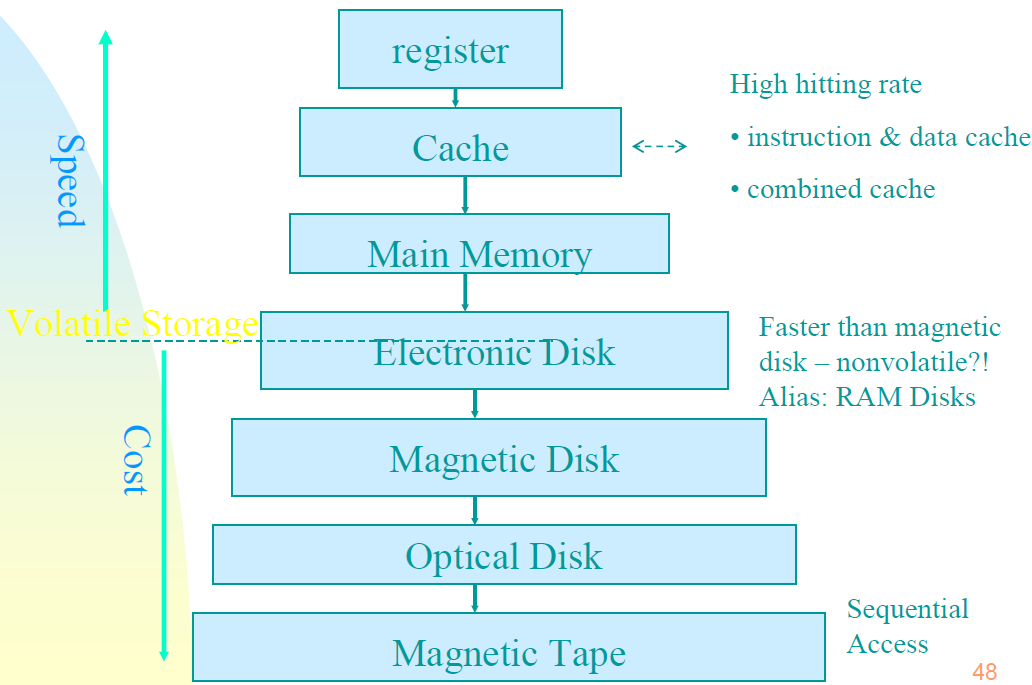

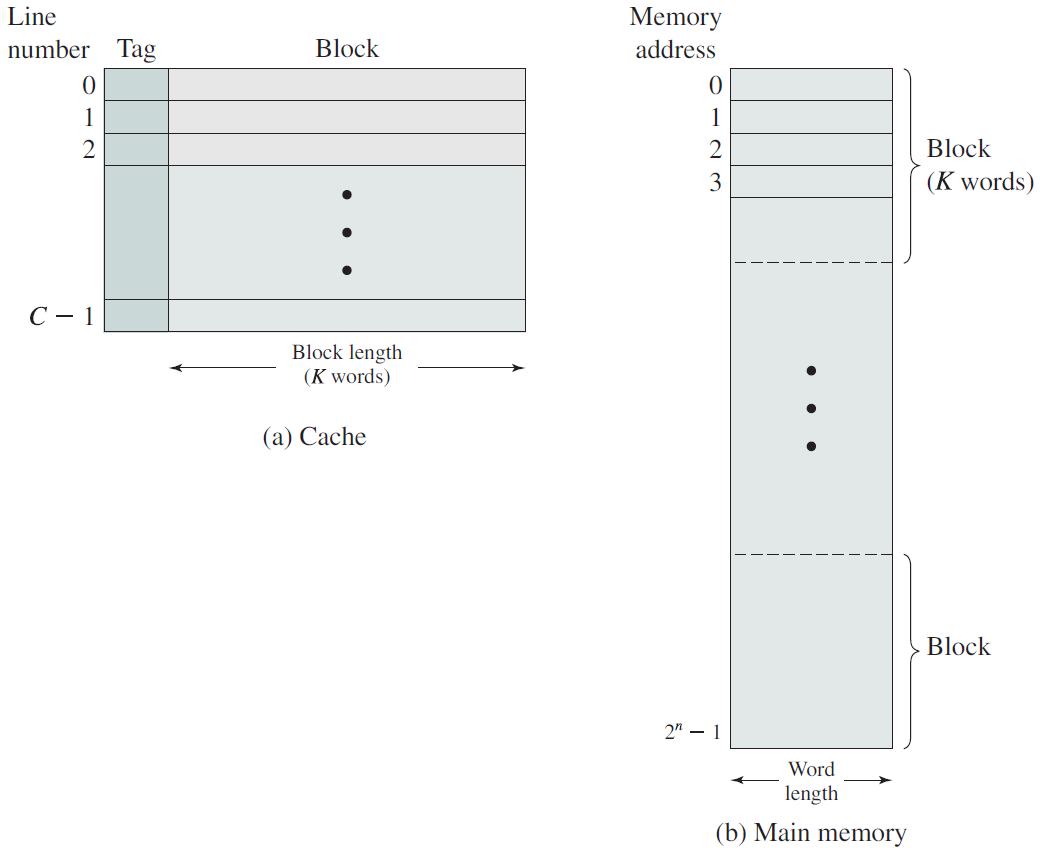

任何計算機的第二個主要部件是記憶體。理想情況下,記憶體應該非常快(比執行指令快,這樣CPU就不會被記憶體佔用),非常大且非常便宜。目前沒有任何技術能夠滿足所有這些目標,因此採取了不同的方法。記憶體系統被構造為一個層次結構,如下圖所示。與低層相比,頂層具有更高的速度、更小的容量和更高的每位元成本,通常是10億或更多倍。

記憶體層級架構和速度示意圖。

頂層由CPU內部的暫存器組成,它們由與CPU相同的材料製成,因此與CPU一樣快,因此,存取它們沒有任何延誤。它們的可用儲存容量通常是32位元CPU上的32×32位元,64位元CPU上為64×64位元,兩種情況下都小於1 KB。程式必須在軟體中自行管理暫存器(即決定在其中儲存什麼)。

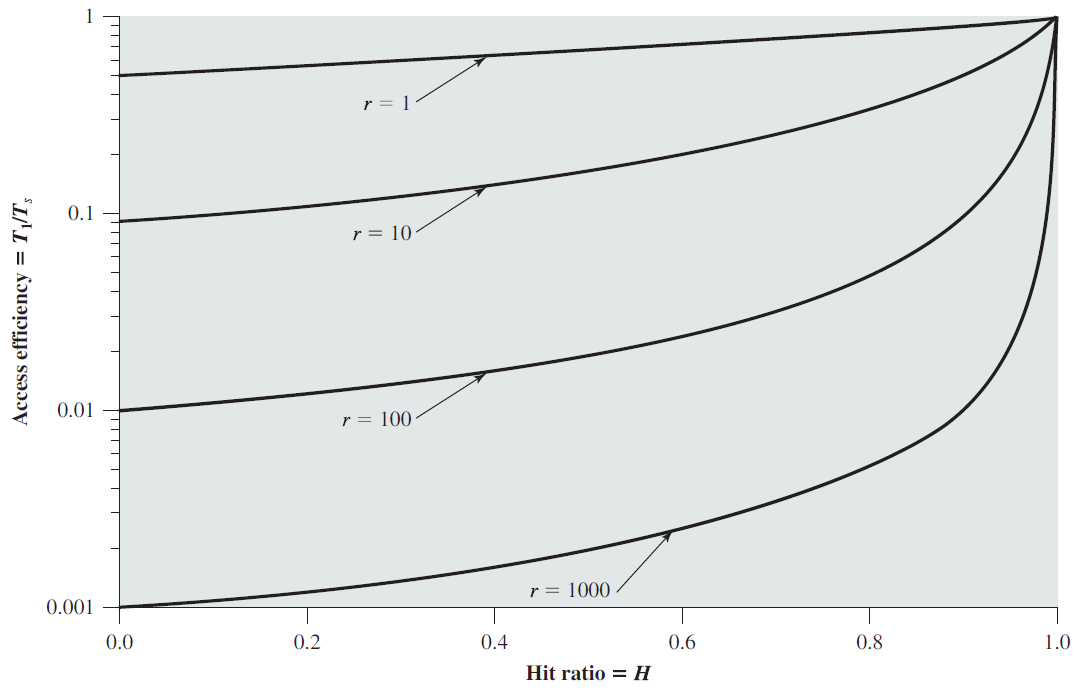

快取記憶體主要由硬體控制。主記憶體被劃分為快取行,通常為64位元組,快取線0中的地址為0到63,快取線1中的地址是64到127,依此類推。最常用的快取行儲存在CPU內部或非常靠近CPU的快取記憶體中,當程式需要讀取記憶體字時,快取硬體會檢查所需的行是否在快取中。如果是,稱為快取命中,則請求從快取中得到滿足,並且沒有記憶體請求通過匯流排傳送到主記憶體。快取命中通常需要大約兩個時鐘週期,快取未命中必須轉移到記憶體中,會導致大量時間損失。由於快取記憶體的成本較高,其大小受到限制,有些機器有兩級甚至三級快取,每級快取都比前一級快取更慢、更大。

快取和記憶體結構。

快取在電腦科學的許多領域都扮演著重要角色,不僅僅是快取RAM行。每當一個資源可以劃分為多個部分時,其中一些部分的使用量比其他部分大得多,快取通常用於提高效能。作業系統一直在使用它。例如,大多數作業系統將頻繁使用的檔案(片段)儲存在主記憶體中,以避免重複從磁碟獲取它們。類似地,轉換長路徑名的結果如下:

/home/ast/projects/minix3/src/kernel/clock.c

可以快取到檔案所在的磁碟地址,以避免重複查詢。最後,當網頁(URL)的地址轉換為網路地址(IP地址)時,可以快取結果以供將來使用。還有許多其他用途。在任何快取系統中,很快就會出現幾個問題,包括:

1、何時將新專案放入快取。

2、將新專案放入哪個快取行。

3、需要插槽時要從快取中刪除的項。

4、將新收回的專案放在較大記憶體中的何處。

並非每個問題都與每個快取情況相關。對於CPU快取中的主記憶體快取行,通常在每次快取未命中時都會輸入一個新項。要使用的快取行通常是通過使用參照的記憶體地址的一些高位來計算的。例如,對於4096條64位元組和32位元地址的快取行,可以使用位6到17來指定快取行,其中位0到5是快取行內的位元組。在這種情況下,要刪除的項與新資料進入的項相同,但在其他系統中可能不是。最後,當快取行被重寫到主記憶體時(如果快取行在被快取後已被修改),記憶體中要重寫它的位置是由所討論的地址唯一確定的。

快取是一個好主意,現代CPU有兩個快取。第一級快取或L1快取始終位於CPU內部,通常將解碼的指令送入CPU的執行引擎。大多數晶片都有第二個L1快取,用於儲存大量使用的資料字,一級快取通常每個為16 KB。此外,通常還有一個稱為L2快取的第二個快取,它儲存了幾兆位元組的最近使用的記憶體字。一級快取和二級快取的區別在於定時,對一級快取的存取不會有任何延遲,而對二級快取的存取會延遲一個或兩個時鐘週期。

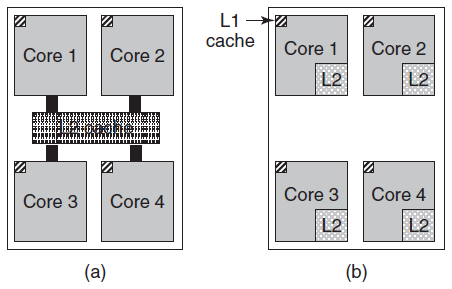

在多核晶片上,設計者必須決定快取的位置。在下圖(a),所有核心共用一個二級快取。這種方法用於Intel多核晶片。相反,在下圖(b)中,每個核心都有自己的二級快取,AMD採用了這種方法。每種策略都有其優缺點,例如,Intel共用的二級快取需要更復雜的快取控制器,但AMD方法使保持二級快取一致性更加困難。

在上上圖的層次結構中,主記憶體緊隨其後,是記憶體系統的主力,通常稱為RAM(隨機存取記憶體),更早之前稱之為磁芯記憶體,因為20世紀50年代和60年代的計算機使用微小的可磁化鐵氧體磁芯作為主記憶體儲器,所有無法從快取中滿足的CPU請求都會轉到主記憶體。

除了主記憶體儲器之外,許多計算機還有少量非易失性隨機存取記憶體。與RAM不同,非易失性記憶體在電源關閉時不會丟失其內容。ROM(唯讀記憶體)是在工廠程式設計的,以後不能更改。它既快又便宜,在一些計算機上,用於啟動計算機的引導載入程式包含在ROM中。此外,一些I/O卡附帶ROM,用於處理低階裝置控制。

EEPROM(電可擦除PROM)和快閃記憶體也是非易失性的,但與ROM相反,它們可以擦除和重寫。然而,寫它們比寫RAM需要更多數量級的時間,因此它們的使用方式與ROM相同,只是有了一個額外的功能,即現在可以通過在現場重寫它們來糾正程式中的錯誤。

快閃記憶體也常用作行動式電子裝置的儲存媒介,在數碼相機中用作膠片,在行動式音樂播放器中用作磁碟,僅舉兩個用途。快閃記憶體的速度介於RAM和磁碟之間。此外,與磁碟記憶體不同,如果擦除次數太多,它就會磨損。

另一種記憶體是CMOS,它是易失性的。許多計算機使用CMOS記憶體來儲存當前時間和日期,CMOS記憶體和增加時間的時鐘電路由一個小電池供電,因此即使拔下電腦插頭,時間也能正確更新。CMOS記憶體還可以儲存設定引數,例如從哪個磁碟啟動。之所以使用CMOS,是因為它耗電很少,以至於原廠安裝的電池通常可以使用幾年。然而,當它開始出現故障時,計算機可能會出現阿爾茨海默病,忘記它多年來知道的事情,比如從哪個硬碟啟動。

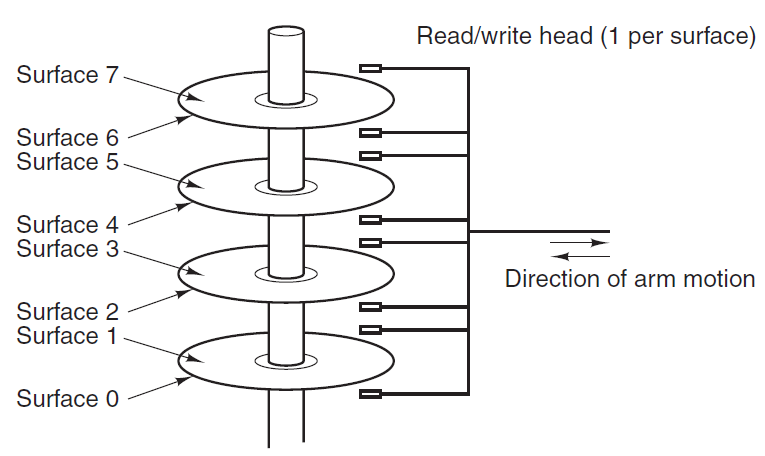

18.2.3 磁碟

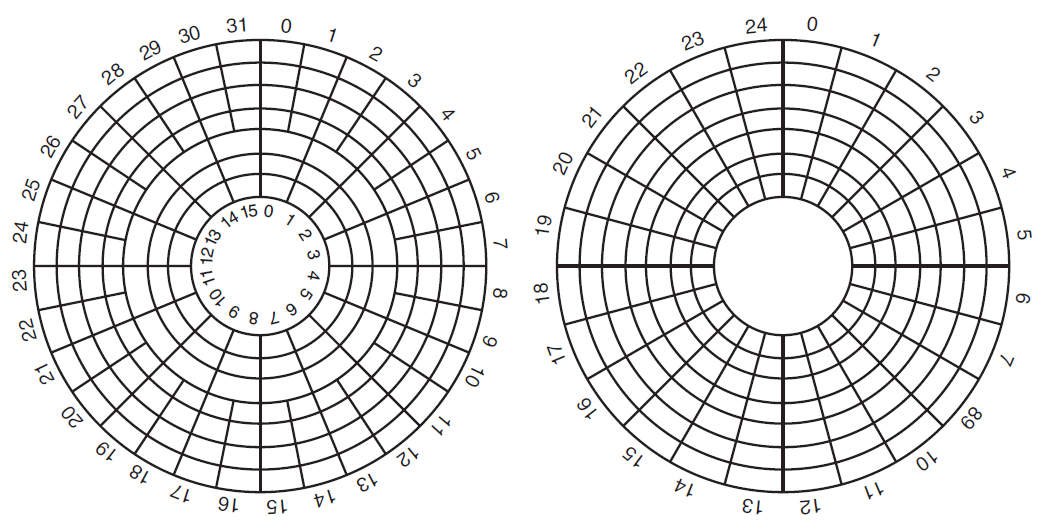

磁碟儲存每位元比RAM便宜兩個數量級,通常也要大兩個數量級別,唯一的問題是隨機存取資料的時間慢了近三個數量級,原因是磁碟是一種機械裝置,如下圖所示。

磁碟由一個或多個旋轉速度為5400、7200、10800 RPM或以上的金屬盤組成。一個機械臂從角落繞著碟片旋轉,類似於老式33-RPM留聲機上播放乙烯基唱片的拾取臂,資訊以一系列同心圓寫入磁碟。在任何給定的手臂位置,每個頭部都可以讀取一個稱為軌道的環形區域,給定手臂位置的所有軌道一起構成一個圓柱體。

每個磁軌被劃分為若干磁區,通常每個磁區512位元組。在現代磁碟上,外圓柱體包含的磁區比內圓柱體多。將臂從一個圓柱體移動到另一個圓柱體大約需要1毫秒。根據驅動器的不同,將其移動到隨機圓柱體通常需要5到10毫秒。一旦臂位於正確的軌道上,驅動器必須等待所需磁區在磁頭下旋轉,根據驅動器的RPM,額外延遲5毫秒到10毫秒。一旦磁區位於磁頭之下,低端磁碟的讀取或寫入速度為50 MB/秒,而高速磁碟的讀取和寫入速度為160 MB/秒。

有時,我們會聽到人們談論實際上根本不是磁碟的磁碟,如SSD(固態磁碟)。SSD沒有移動部件,不包含磁碟形狀的碟片,並將資料儲存在(快閃記憶體)記憶體中。它們與磁碟相似的唯一方式是,儲存了大量資料,這些資料在斷電時不會丟失。

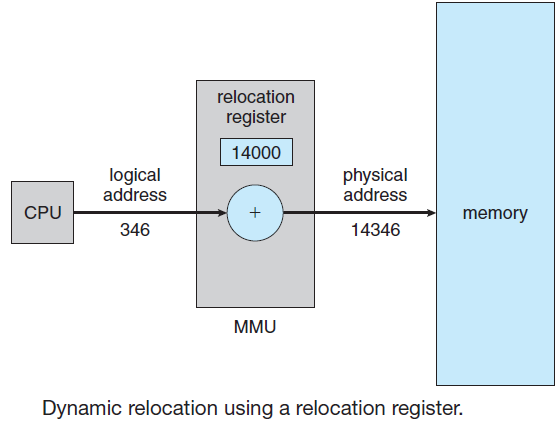

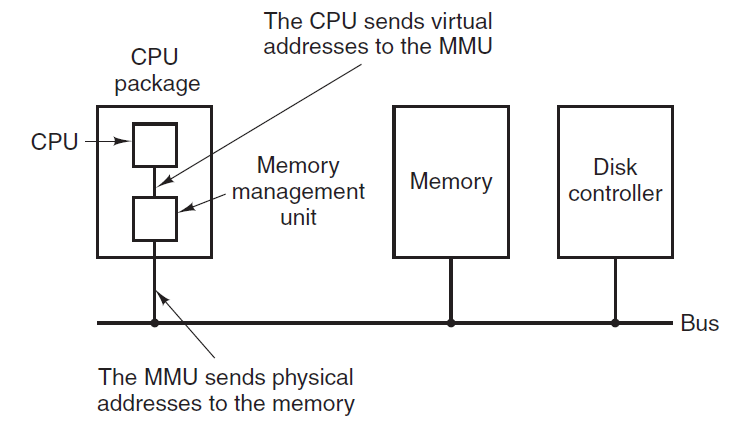

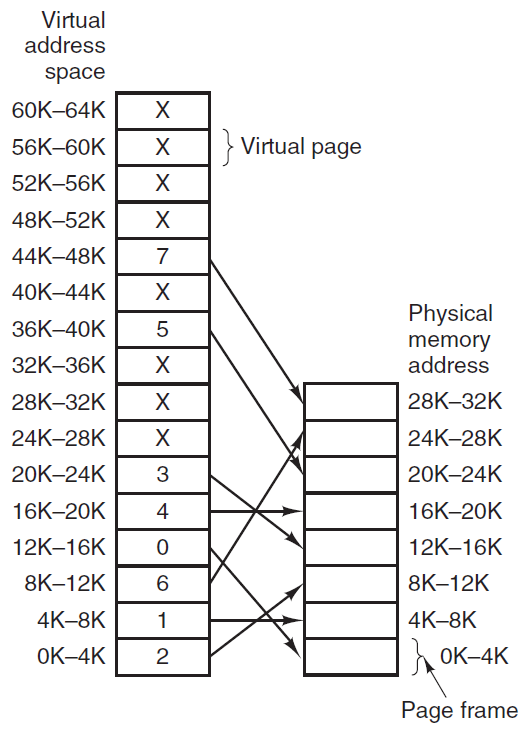

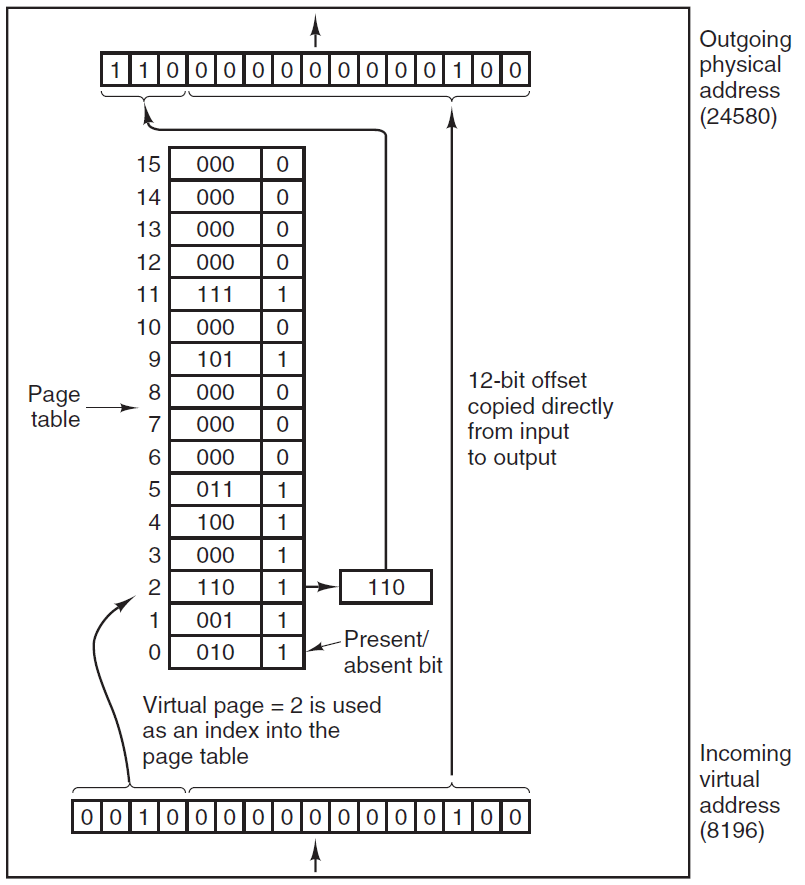

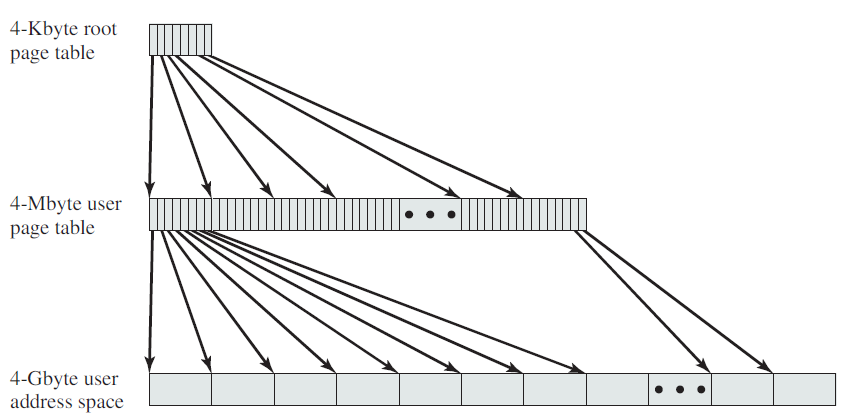

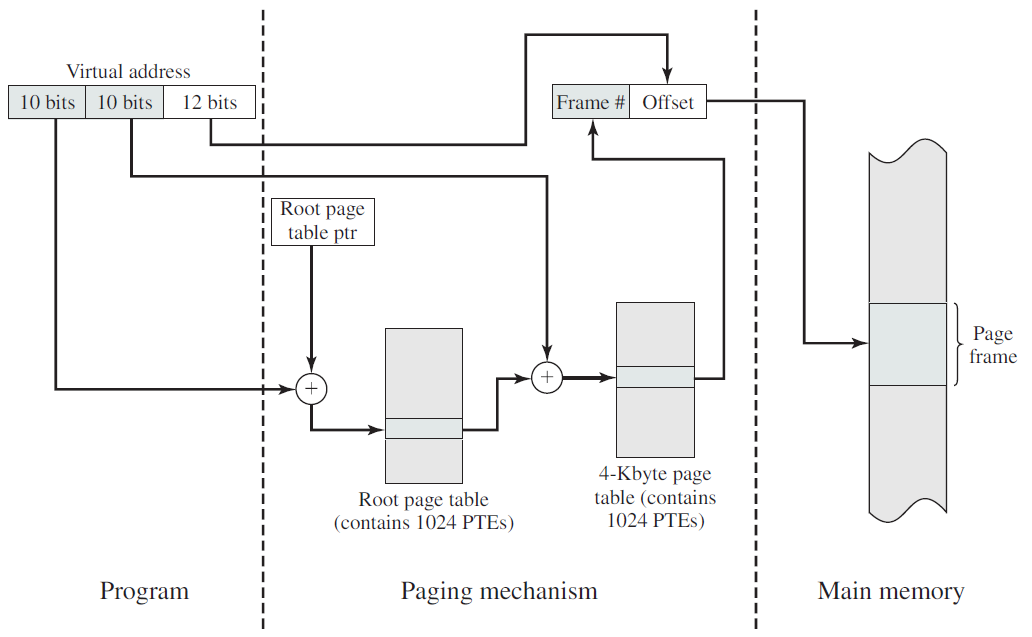

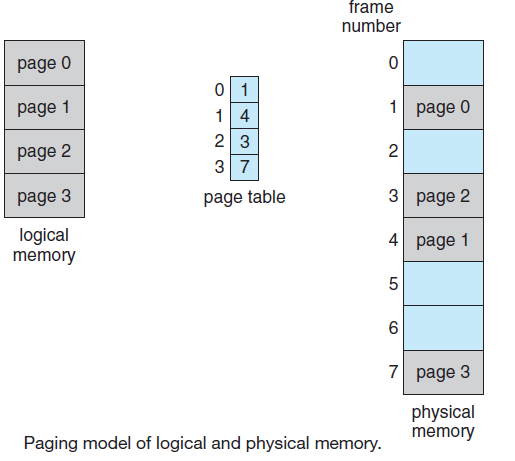

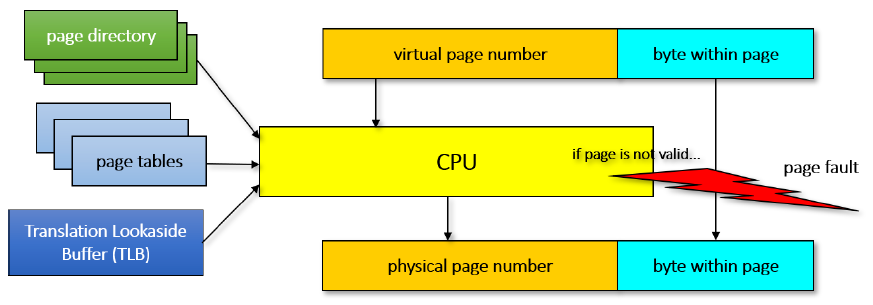

許多計算機支援一種稱為虛擬記憶體的方案,該方案通過將程式放在磁碟上並將主記憶體用作執行最頻繁的部分的快取,使執行大於實體記憶體的程式成為可能。此方案需要動態重新對映記憶體地址,以將程式生成的地址轉換為字所在的RAM中的實體地址。此對映由CPU的一部分MMU(記憶體管理單元)完成。

快取和MMU的存在會對效能產生重大影響。在多道程式設計系統中,當從一個程式切換到另一個程式(有時稱為上下文切換)時,可能需要從快取中清除所有修改過的塊,並更改MMU中的對映暫存器。這兩種操作昂貴很大,應該被開發者注意並規避。

18.2.4 I/O裝置

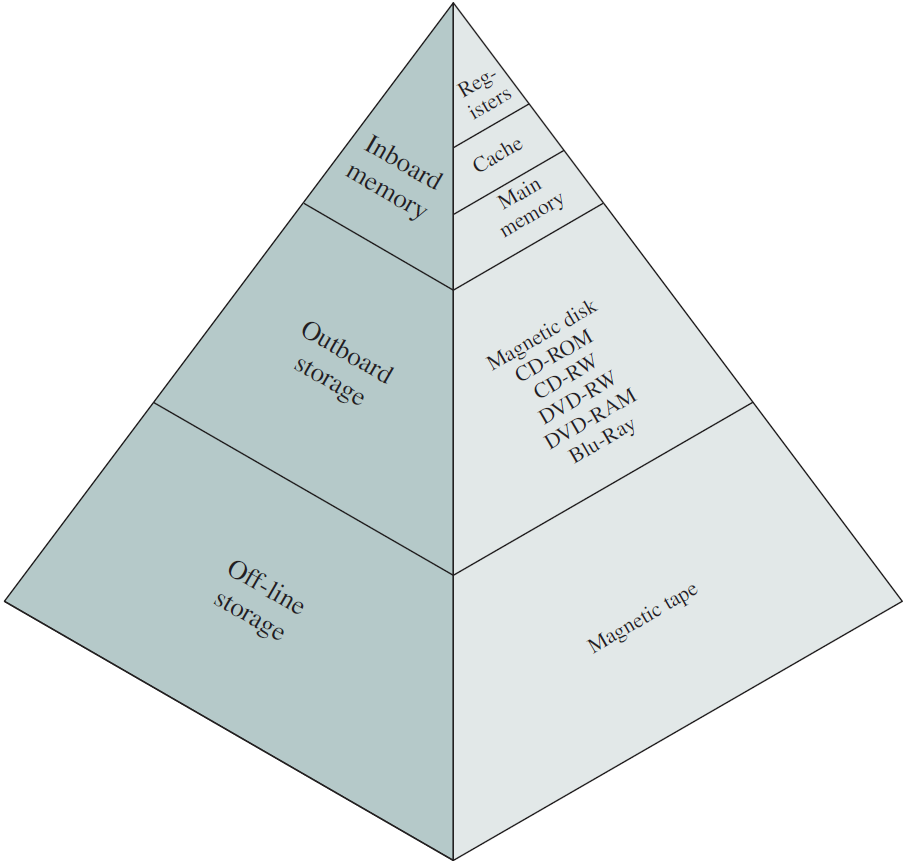

IO儲存裝置根據速度和媒介,有著以下的層級關係:

Linux中的網路分層如下:

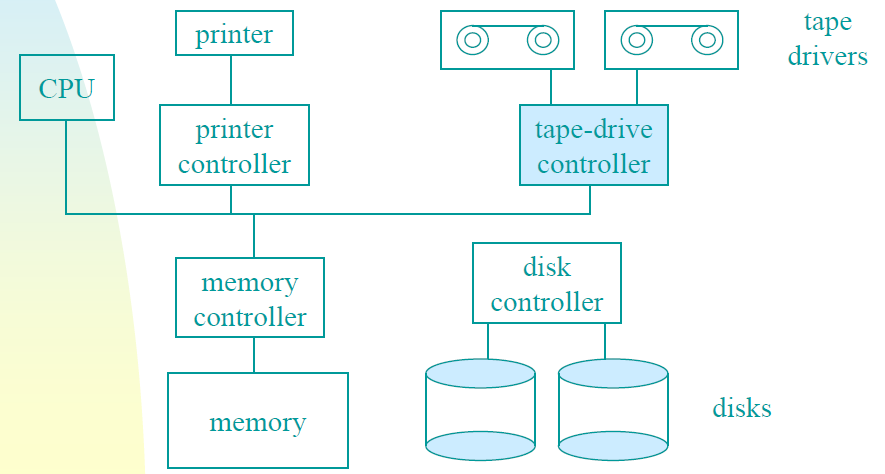

CPU和記憶體不是作業系統必須管理的唯一資源,I/O裝置還與作業系統進行大量互動,通常由兩部分組成:控制器和裝置本身。

控制器是物理控制裝置的一個或一組晶片,接受來自作業系統的命令,例如從裝置讀取資料,並執行這些命令。在許多情況下,裝置的實際控制是複雜和詳細的,因此控制器的工作是為作業系統提供一個更簡單(但仍然非常複雜)的介面。例如,磁碟控制器可能會接受從磁碟2讀取磁區11206的命令。然後,控制器必須將此線性磁區編號轉換為圓柱體、磁區和磁頭。由於外部圓柱體的磁區比內部圓柱體的多,並且一些壞磁區已重新對映到其他磁區,因此這種轉換可能會變得複雜。然後,控制器必須確定磁碟臂在哪個圓柱體上,並向其發出命令,以移入或移出所需數量的圓柱體。它必須等到正確的磁區在磁頭下旋轉,然後開始讀取和儲存從驅動器上下來的位,刪除前導碼並計算校驗和。最後,它必須將輸入的位組合成單詞並儲存在記憶體中。為了完成所有這些工作,控制器通常包含小型嵌入式計算機,這些計算機被程式設計來完成它們的工作。

另一部分是實際裝置本身。裝置有相當簡單的介面,既是因為它們不能做很多事情,也是為了使它們成為標準。例如,需要後者,以便任何SATA磁碟控制器都可以處理任何SATA盤。SATA代表序列ATA,ATA代表AT附件,是圍繞當時功能極為強大的6-MHz 80286處理器而構建的。SATA目前是許多計算機上的標準磁碟型別。由於實際的裝置介面隱藏在控制器後面,作業系統看到的只是控制器的介面,可能與裝置的介面有很大的不同。

因為每種型別的控制器都不同,所以需要不同的軟體來控制每種控制器,與控制器對話、發出命令並接受響應的軟體稱為裝置驅動程式,每個控制器製造商必須為其支援的每個作業系統提供一個驅動程式。例如掃描器可能附帶OS X、Windows 7、Windows 8和Linux的驅動程式。

要使用該驅動程式,必須將其放入作業系統中,以便它可以在核心模式下執行。驅動程式實際上可以在核心外執行,現在像Linux和Windows這樣的作業系統確實提供了一些支援,絕大多數驅動程式仍在核心邊界以下執行。目前只有極少數系統(如MINIX 3)在使用者空間中執行所有驅動程式,必須允許使用者空間中的驅動程式以受控方式存取裝置,但並不簡單。

有三種方法可以將驅動程式放入核心。第一種方法是用新的驅動程式重新連結核心,然後重新啟動系統,例如許多較舊的UNIX系統。第二種方法是在作業系統檔案中輸入一個條目,告訴它需要驅動程式,然後重新啟動系統。在引導時,作業系統會找到所需的驅動程式並載入它們,如Windows。第三種方法是讓作業系統能夠在執行時接受新的驅動程式,並動態安裝它們,而無需重新啟動。這種方式過去很少見,但現在越來越普遍了。熱插拔裝置,如USB和IEEE 1394裝置,始終需要動態載入的驅動程式。

每個控制器都有少量用於與其通訊的暫存器。例如,最小磁碟控制器可能具有指定磁碟地址、記憶體地址、磁區計數和方向(讀或寫)的暫存器。為了啟用控制器,驅動程式從作業系統獲取命令,然後將其轉換為適當的值,寫入裝置暫存器。所有裝置暫存器的集合構成I/O埠空間。

在某些計算機上,裝置暫存器被對映到作業系統的地址空間(它可以使用的地址),因此它們可以像普通記憶體字一樣讀取和寫入。在這類計算機上,不需要特殊的I/O指令,使用者程式可以通過不將這些記憶體地址放在其可及範圍內而遠離硬體(例如,通過使用基址和限制暫存器)。在其他計算機上,裝置暫存器放在一個特殊的I/O埠空間中,每個暫存器都有一個埠地址。在這些機器上,核心模式下有特殊的IN和OUT指令,允許驅動程式讀取和寫入暫存器。前一種方案不需要特殊的I/O指令,但會佔用一些地址空間。後者不使用地址空間,但需要特殊說明。這兩種系統都被廣泛使用。

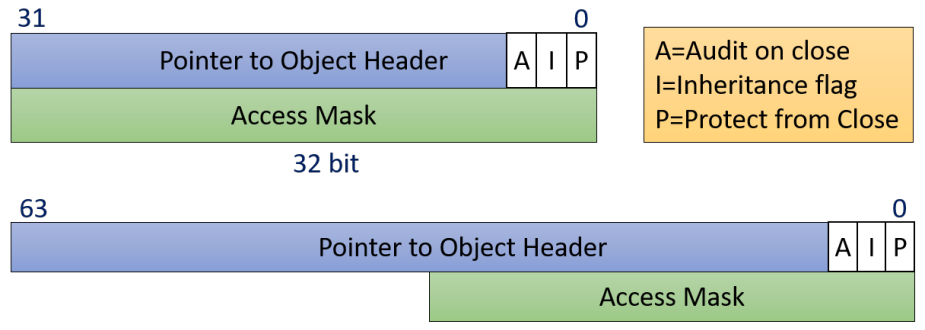

輸入和輸出可以用三種不同的方式完成。在最簡單的方法中,使用者程式發出一個系統呼叫,然後核心將其轉換為對相應驅動程式的過程呼叫。然後,驅動程式啟動I/O並在一個緊密的迴圈中持續輪詢裝置,以檢視是否完成了操作(通常有一些位表示裝置仍在忙)。當I/O完成時,驅動程式將資料(如果有)放在需要的位置並返回。然後,作業系統將控制權返回給呼叫者。這種方法稱為繁忙等待,其缺點是佔用CPU輪詢裝置直到完成。

第二種方法是驅動程式啟動裝置,並在完成時要求其中斷。此時,驅動返回。然後,如果需要,作業系統會阻止呼叫者,並尋找其他工作。當控制器檢測到傳輸結束時,它會生成一箇中斷以完成訊號。

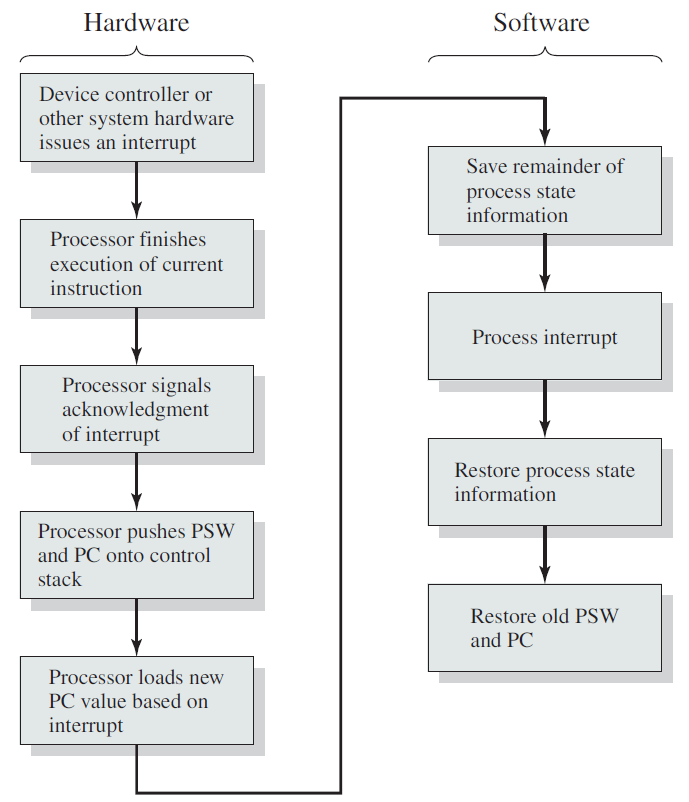

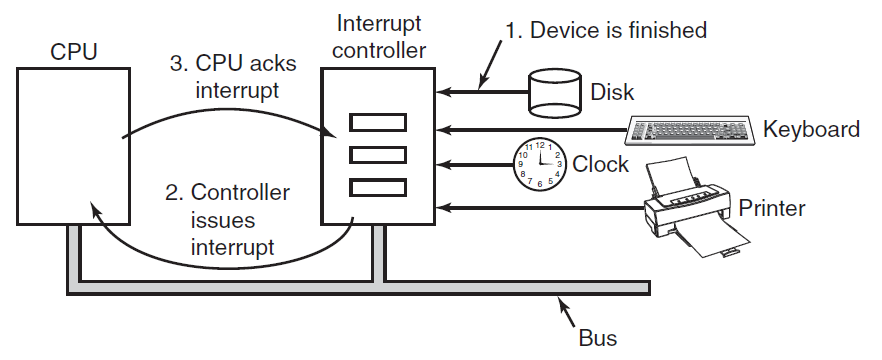

中斷在作業系統中非常重要,所以讓我們更仔細地研究一下這個想法。在下圖(a)中,我們看到I/O的三步過程。在步驟1中,驅動程式通過寫入其裝置暫存器來告訴控制器要做什麼。然後,控制器啟動裝置。當控制器完成讀取或寫入它被要求傳輸的位元組數時,它在步驟2中使用某些匯流排向中斷控制器晶片傳送訊號。如果中斷控制器準備接受中斷(如果它忙於處理更高優先順序的中斷,則可能不會接受),它在CPU晶片上斷言一個管腳,在步驟3中告訴它。在步驟4中,中斷控制器將裝置的編號放在匯流排上,這樣CPU就可以讀取它,並知道哪個裝置剛剛完成(許多裝置可能同時執行)。

一旦CPU決定接受中斷,程式計數器和PSW通常被推到當前堆疊上,CPU切換到核心模式。裝置編號可用作記憶體部分的索引,以查詢該裝置的中斷處理程式的地址。這部分記憶體稱為中斷向量。一旦中斷處理程式(中斷裝置驅動程式的一部分)啟動,它將刪除堆疊程式計數器和PSW並儲存它們,然後查詢裝置以瞭解其狀態。當處理程式全部完成時,它返回到以前執行的使用者程式,返回到尚未執行的第一條指令。這些步驟如下圖(b)所示。

(a)啟動I/O裝置並獲得中斷的步驟。(b) 中斷處理包括接受中斷、執行中斷處理程式和返回使用者程式。

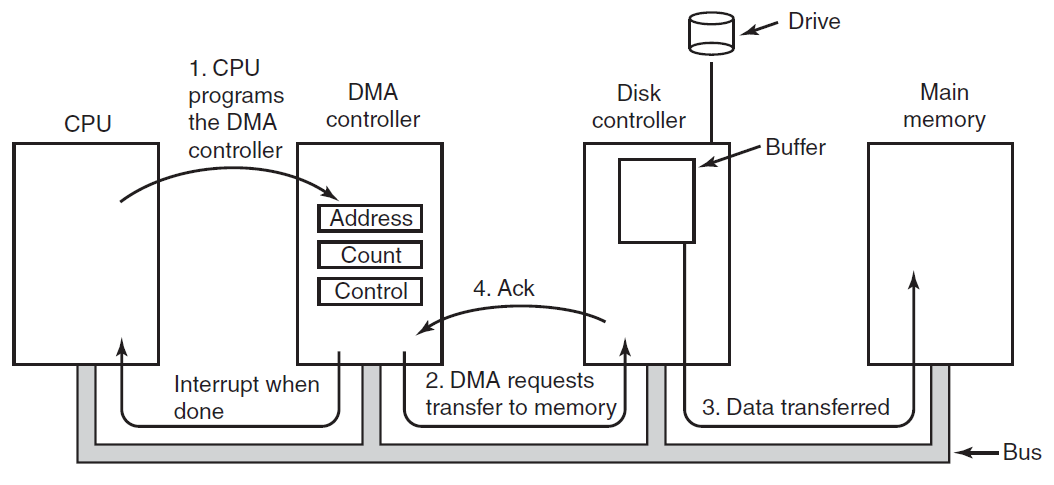

執行I/O的第三種方法使用特殊的硬體:DMA(直接記憶體存取)晶片,可以控制記憶體和某些控制器之間的位元流,而無需持續的CPU干預。CPU設定DMA晶片,告訴它要傳輸多少位元組、涉及的裝置和記憶體地址以及方向,然後讓它執行。當DMA晶片完成時,它會觸發中斷,如上文所述進行處理。

例如,當另一箇中斷處理程式正在執行時,中斷可能(而且經常)發生在非常不方便的時刻。因此,CPU有一種方法可以禁用中斷,然後稍後重新啟用它們。當中斷被禁用時,任何完成的裝置都會繼續斷言其中斷訊號,但CPU不會中斷,直到再次啟用中斷。如果多個裝置在中斷被禁用時完成,中斷控制器通常根據分配給每個裝置的靜態優先順序決定首先讓哪個裝置通過。優先順序最高的裝置獲勝並首先得到服務。其他必須等待。

18.2.5 匯流排

隨著處理器和記憶體的速度越來越快,單個匯流排(當然還有IBM PC匯流排)處理所有流量的能力已經到了極限。為了更快的I/O裝置和CPU到記憶體的通訊量,新增了額外的匯流排。由於這一演變,一個大型x86系統目前看起來類似於下圖。

大型x86系統的結構。

該系統有許多匯流排(例如,快取、記憶體、PCIe、PCI、USB、SATA和DMI),每個匯流排具有不同的傳輸速率和功能。作業系統必須瞭解所有這些資訊,以便進行設定和管理。

主匯流排是PCIe(外圍元件互連高速)匯流排,PCIe匯流排是Intel作為舊PCI匯流排的繼承者而發明的,而舊PCI匯流排又是原始ISA(行業標準體系結構)匯流排的替代品。PCIe能夠每秒傳輸數十Gb的資料,比其前代產品快得多,它的性質也非常不同。直到2004年建立,大多數匯流排都是並行共用的,共用匯流排架構意味著多個裝置使用相同的線路傳輸資料。因此,當多個裝置有資料要傳送時,需要一個仲裁器(arbiter)來確定誰可以使用匯流排。相反,PCIe使用專用的點到點連線,傳統PCI中使用的並行匯流排架構意味著可以通過多條導線傳送每個字的資料。例如,在常規PCI匯流排中,單個32位元數位通過32條並行線傳送。與此相反,PCIe使用序列匯流排體系結構,並通過單個連線(稱為通道)傳送訊息中的所有位,就像網路封包一樣。這種方式簡單得多,因為不必確保所有32位元都在同一時間到達目的地。仍然使用平行性,因為可以有多條平行通道(lane),例如可以使用32條通道並行傳輸32條訊息。隨著網路卡和圖形介面卡等外圍裝置速度的快速增長,PCIe標準每3-5年升級一次。例如,16通道PCIe 2.0提供每秒64 Gb的速率,升級到PCIe 3.0將使速度提高一倍,而PCIe 4.0將使速度再次提高一倍。

與此同時,仍有許多適用於舊PCI標準的傳統裝置,如上圖所示,這些裝置連線到單獨的集線器處理器。未來,當我們認為PCI不再僅僅是老式的,而是老式的時,所有PCI裝置都有可能連線到另一個集線器,而該集線器又將它們連線到主集線器上,從而形成匯流排樹。

在此設定中,CPU通過快速DDR3匯流排與記憶體通訊,通過PCIe與外部圖形裝置通訊,並通過DMI(直接媒體介面)匯流排上的集線器與所有其他裝置通訊。集線器依次連線所有其他裝置,使用通用序列匯流排與USB裝置通訊,使用SATA匯流排與硬碟和DVD驅動器互動,使用PCIe傳輸乙太網幀。

此外,每個核心都有一個專用快取和一個更大的快取,在它們之間共用,每個快取都引入另一條匯流排。

發明USB(通用序列匯流排)是為了將所有低速I/O裝置(如鍵盤和滑鼠)連線到計算機上。然而,對於以8-Mbps ISA作為第一臺IBM PC的主匯流排而成長起來的一代人來說,將以5 Gbps「低速」執行的現代USB 3.0裝置稱為「低速」可能不是自然而然的。USB使用一個帶有四到十一根線(取決於版本)的小聯結器,其中一些線為USB裝置供電或接地。USB是一種集中式匯流排,其中根裝置每1毫秒輪詢一次所有I/O裝置,以檢視它們是否有流量。USB 1.0可以處理12 Mbps的總負載,USB 2.0將速度提高到480 Mbps,USB 3.0最高不低於5 Gbps。任何USB裝置都可以連線到計算機上,將立即執行,而無需重新啟動計算機,這是USB裝置之前所需的,讓一代受挫的使用者非常震驚。

SCSI(小型計算機系統介面)匯流排是一種高效能匯流排,用於快速磁碟、掃描器和其他需要大量頻寬的裝置。如今,它們大多在伺服器和工作站上,可以以高達640 MB/秒的速度執行。

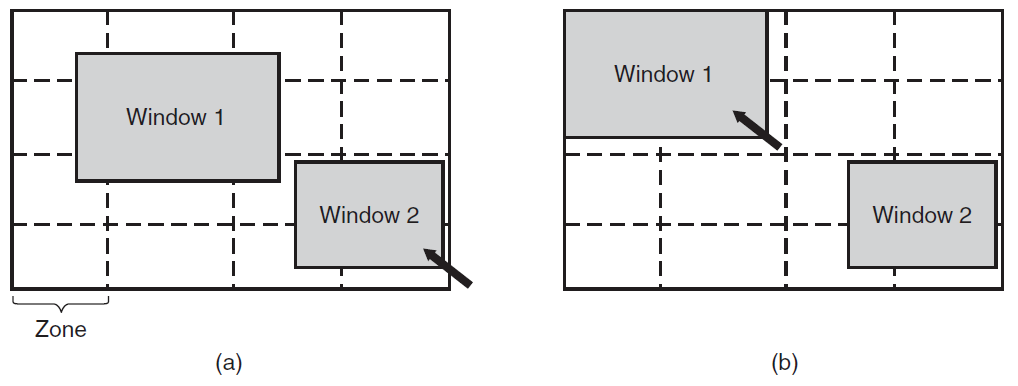

要在上圖所示的環境中工作,作業系統必須知道哪些外圍裝置連線到計算機並對其進行設定。這一要求促使英特爾和微軟基於蘋果Macintosh首次實現的類似概念,設計了一種稱為隨插即用的PC系統。在隨插即用之前,每個I/O卡都有一個固定的中斷請求級別和其I/O暫存器的固定地址。例如,鍵盤為中斷1並使用I/O地址0x60至0x64,軟碟控制器為中斷6並使用I/O位置0x3F0至0x3F7,印表機為中斷7並使用I/O位址0x378至0x37A,依此類推。

到目前為止,一切都很好。當用戶購買了一張音效卡和一張資料機卡,而這兩張卡都碰巧使用了同一中斷(如中斷4)時,問題就出現了——會發生衝突,不能一起工作。解決方案是在每個I/O卡上包括DIP開關或跳線,並指示使用者請將其設定為選擇一箇中斷級別和I/O裝置地址,該中斷級別和輸入/輸出裝置地址不會與使用者系統中的任何其他地址衝突。不幸的是,極少人能做到,導致混亂。

隨插即用所做的是讓系統自動收集有關I/O裝置的資訊,集中分配中斷級別和I/O地址,然後告訴每個卡的編號。這項工作與啟動計算機密切相關,且不是簡單的小事。

18.3 核心

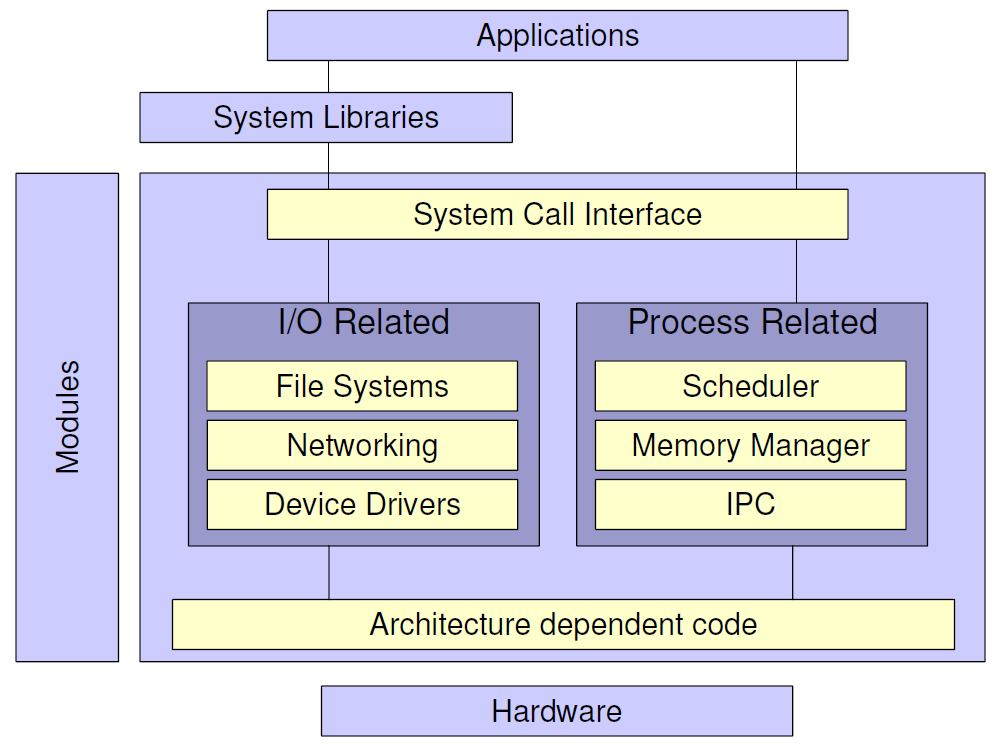

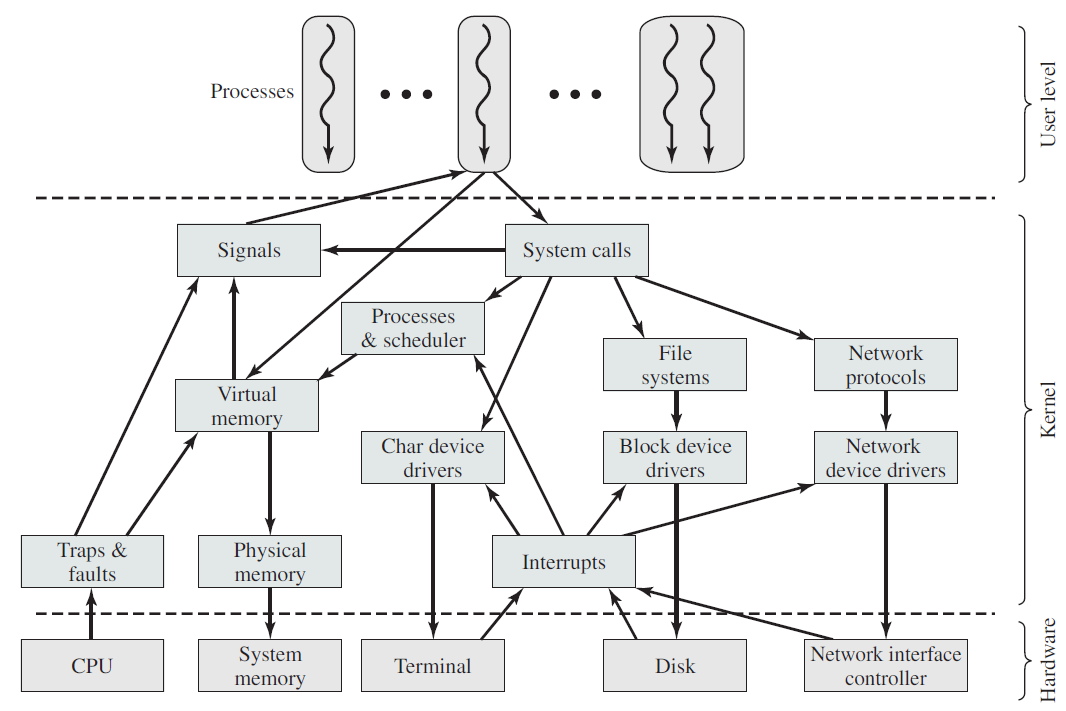

下面兩圖顯示了主流的核心總體架構。

核心架構1。

核心架構2。

圖的底部顯示了核心的一部分,該部分(以及從那裡呼叫的函數)在監督者模式下執行。在監督器模式下執行的所有程式碼都是用組合程式編寫的,幷包含在檔案crt0.S中。crt0.S中的程式碼分為啟動程式碼、存取硬體的函數、中斷服務例程、任務開關(排程程式)和出於效能原因而用組合程式寫的號誌函數。

圖的中間部分顯示了在使用者模式下執行的核心的其餘部分。對crt0.S中程式碼的任何呼叫都需要更改為監控模式,即從中間到下部的每個箭頭都與一個或多個TRAP指令相關,這些指令會導致監控模式的更改。類os包含一組帶有TRAP指令的包裝函數,使應用程式能夠存取某些硬體部件。SerialIn和SerialOut類稱為序列I/O,需要硬體存取,也可以從中斷服務例程存取。Class Task包含與任務管理相關的任何內容,並使用核心的supervisor部分進行(顯式)工作切換。工作切換也由中斷服務例程引起。Semaphore類提供包裝函數,使其成員函數的實現在使用者模式下可用。核心內部使用了幾個Queue類,並且應用程式也可以使用這些類;他們中的大多數使用Semaphore類。

通常,應用程式與內部核心介面無關,與核心相關的介面是在類os、SerialIn、SerialOut、Task、Queue和Semaphore中定義的介面。

18.3.1 核心概述

下圖給出了核心的主要元件的簡單概述。可以看到底部的硬體,硬體由晶片、電路板、磁碟、鍵盤、顯示器和類似的物理物件組成。硬體之上是軟體,大多數計算機有兩種操作模式:核心模式和使用者模式。作業系統是軟體中最基本的部分,它以核心模式(也稱為管理器模式)執行。在這種模式下,它可以完全存取所有硬體,並可以執行機器能夠執行的任何指令。軟體的其餘部分以使用者模式執行,在該模式下,只有機器指令的一個子集可用。特別是,那些影響機器控制或進行I/O輸入/輸出的指令「被禁止用於使用者模式程式。本文反覆討論核心模式和使用者模式之間的區別,它在作業系統的工作方式中起著至關重要的作用。

更詳細的結構圖如下:

傳統的Unix核心架構圖如下:

現代Unix核心已經進化成如下架構:

Linux核心模組列表樣例如下:

Linux核心元件如下所示:

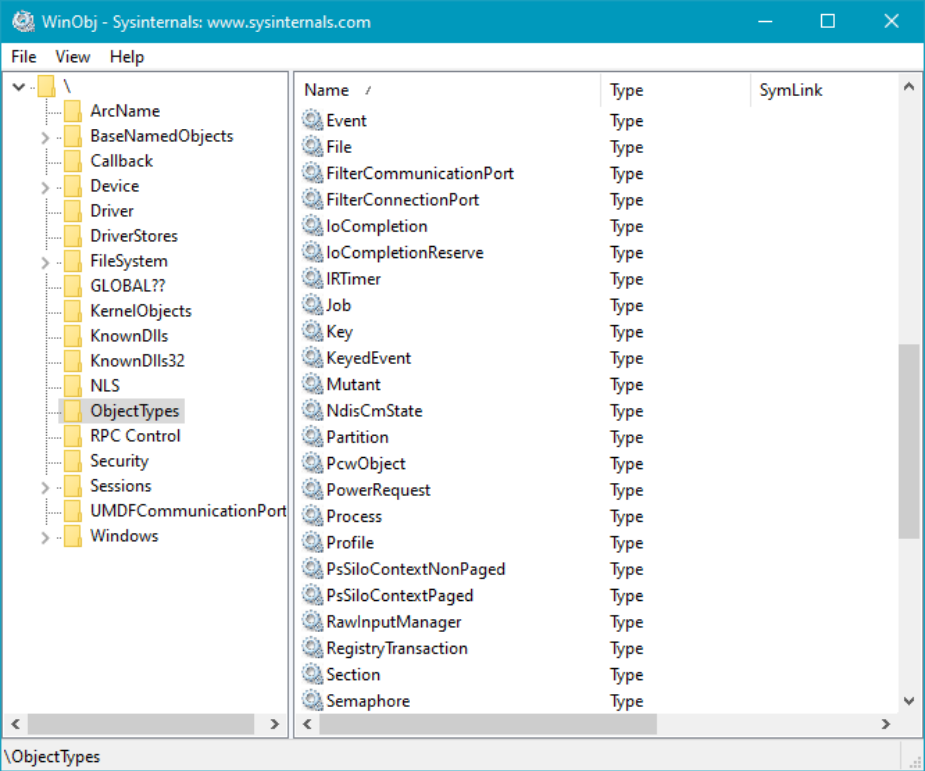

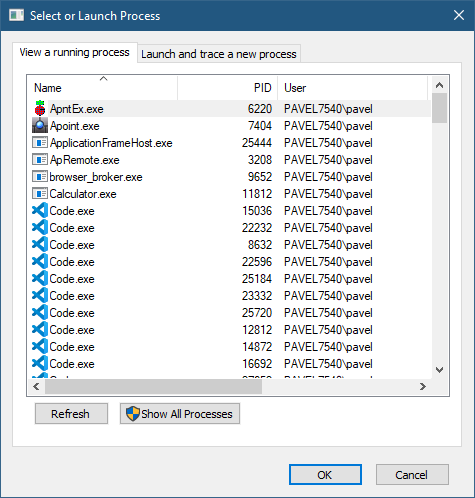

18.3.2 核心物件

Windows核心公開各種型別的物件,供使用者模式程序、核心本身和核心模式驅動程式使用。這些型別的範例是系統(核心)空間中的資料結構,當用戶或核心模式程式碼請求時,由物件管理器(執行程式的一部分)建立和管理。核心物件使用了參照計數,因此只有當物件的最後一個參照被釋放時,物件才會被銷燬並從記憶體中釋放。

Windows核心支援很多物件型別,可從Sysinternals執行WinObj工具,並找到ObjectTypes目錄(下圖)。可以根據其可見性和用途進行分類:

- 通過Windows API匯出到使用者模式的型別。例如:互斥、號誌、檔案、程序、執行緒和計時器。

- 未匯出到使用者模式,但記錄在Windows驅動程式工具包(WDK)中供裝置驅動程式編寫者使用的型別。例如裝置、驅動程式和回撥。

- 即使在WDK中也沒有記錄的型別(至少在編寫時),僅由核心本身使用。例如分割區、鍵控事件和核心訊息傳遞。

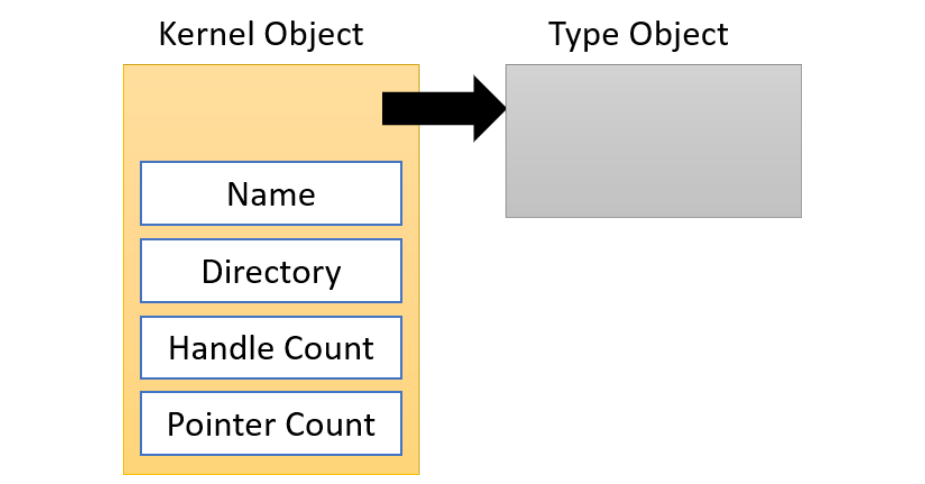

核心物件的主要屬性如下圖所示:

某些型別的物件可以具有基於字串的名稱,這些名稱可用於使用適當的開啟函數按名稱開啟物件。注意,並非所有物件都有名稱,例如程序和執行緒沒有名稱——它們有ID。這就是為什麼OpenProcess和OpenThread函數需要程序/執行緒識別符號(數位)而不是基於string的名稱。

在使用者模式程式碼中,如果不存在具有名稱的物件,則呼叫具有名稱的建立函數將建立具有該名稱的物件;如果存在,則只開啟現有物件。

提供給建立函數的名稱不是物件的最終名稱。在經典(桌面)程序中,它前面有\Sessions\x\BaseNamedObjects\其中x是呼叫方的對談ID。如果對談為零,則名稱前面只加上\BaseNamedObjects\。如果呼叫方碰巧在AppContainer(通常是通用Windows平臺程序)中執行,則字首字串更復雜,由唯一的AppContainerSID: \Sessions\x\AppContaineerNameObjects\組成。

18.3.3 核心物件共用

核心物件的控制程式碼是程序私有的,但在某些情況下,程序可能希望與另一個程序共用核心物件。這樣的程序不能簡單地將控制程式碼的值傳遞給其他程序,因為在其他程序的控制程式碼表中,控制程式碼值可能指向其他物件或為空。顯然,必須有某種機制來允許這種分享。事實上,有三種分享機制:

-

按名稱共用。如果可用,是最簡單的方法。「可用」表示所討論的物件可以有名稱,並且確實有名稱。典型的場景是,共同作業程序(2個或更多)將使用相同的物件名呼叫相應的Create函數。進行呼叫的第一個程序將建立物件,其他程序的後續呼叫將為同一物件開啟其他控制程式碼。

-

通過控制程式碼繼承共用。通常是父程序建立子程序時,傳入繼承屬性和資料而達成。

-

通過複製控制程式碼共用。控制程式碼複製沒有固有的限制(除了安全性),幾乎可以在任何核心物件上工作,無論是有命字的還是沒有名字的,並且可以在任何時間點工作。然而,有一個缺陷,是實踐中最困難的分享方式(後面會提及)。Windows通過呼叫

DuplicateHandle複製控制程式碼。

Windows複製控制程式碼應用案例圖示。

18.3.4 控制程式碼

由於核心物件駐留在系統空間中,因此無法直接從使用者模式存取它們。應用程式必須使用間接機制來存取核心物件,稱為控制程式碼(Handle)。控制程式碼至少具有以下優點:

- 在未來的Windows版本中,物件型別資料結構的任何更改都不會影響任何使用者端。

- 可通過安全存取檢查控制對物件的存取。

- 控制程式碼是程序私有的,因此在一個程序中擁有特定物件的控制程式碼在另一個程序上下文中沒有意義。

核心物件是參照計數的。物件管理器維護控制程式碼計數和指標計數,其和是物件的總參照計數(直接指標可以從核心模式獲得)。一旦不再需要使用者模式使用者端使用的物件,使用者端程式碼應通過呼叫CloseHandle關閉用於存取該物件的控制程式碼。之後控制程式碼將無效,嘗試通過關閉控制程式碼存取物件將失敗。在一般情況下,使用者端不知道物件是否已被銷燬。如果物件的參照降至零,則物件管理器將刪除該物件。

控制程式碼值是4的倍數,其中第一個有效控制程式碼是4;零永遠不是有效的控制程式碼值,在64位元系統上亦是如此。控制程式碼間接指向核心空間中的一個小資料結構,該結構包含控制程式碼的一些資訊。下圖描述了32位元和64位元系統的資料結構。

在32位元系統上,該控制程式碼條目的大小為8位元組,在64位元系統上為16位元組(從技術上而言,12位元組已足夠,但為了對齊目的,會擴充套件為16位元組)。每個條目包含以下成分:

- 指向實際物件的指標。由於低位用於標記,並通過地址對齊提高CPU存取時間,因此在32位元系統上,物件的地址是8的倍數,在64位元系統上是16的倍數。

- 存取掩碼,指示可使用此手柄執行的操作。換句話說,存取掩碼是控制程式碼的力量。

- 三個標誌:繼承、關閉時保護和關閉時核驗。

存取掩碼是位掩碼,其中每個「1」位表示可以使用該控制程式碼執行的特定操作。當通過建立物件或開啟現有物件建立控制程式碼時,將設定存取掩碼。如果建立了物件,則呼叫者通常具有對該物件的完全存取權。但是,如果物件被開啟,呼叫方需要指定所需的存取掩碼,它可能會得到,也可能不會得到。

某些控制程式碼具有特殊值,不可關閉,被稱為偽控制程式碼(Pseudo Handles),儘管它們在需要時與任何其他控制程式碼一樣使用。在偽控制程式碼上呼叫CloseHandle總是失敗。

當不再需要控制程式碼時,關閉控制程式碼非常重要。如果應用程式未能正確執行此操作,則可能會出現「控制程式碼洩漏」,即如果應用程式開啟控制程式碼但「忘記」關閉它們,則控制程式碼的數量將無法控制地增長。幫助程式碼管理控制程式碼而不忘記關閉它們的一種方法是使用C++實現一個眾所周知的習慣用法,稱為資源獲取即初始化(Resource Acquisition is Initialization,RAII)。其思想是對包裝在型別中的控制程式碼使用解構函式,以確保在包裝物件被銷燬時關閉控制程式碼。下面是一個簡單的控制程式碼RAII封裝器:

struct Handle

{

explicit Handle(HANDLE h = nullptr)

:_h(h) // 初始化

{}

// 解構函式關閉控制程式碼。

~Handle() { Close(); }

// 刪除拷貝構造和拷貝賦值

Handle(const Handle&) = delete;

Handle& operator=(const Handle&) = delete;

// 允許移動(所有權轉移)

Handle(Handle&& other) : _h(other._h)

{

other._h = nullptr;

}

Handle& operator=(Handle&& other)

{

if (this != &other)

{

Close();

_h = other._h;

other._h = nullptr;

}

return *this;

}

operator bool() const

{

return _h != nullptr && _h != INVALID_HANDLE_VALUE;

}

HANDLE Get() const

{

return _h;

}

void Close()

{

if (_h)

{

::CloseHandle(_h);

_h = nullptr;

}

}

private:

HANDLE _h;

};

18.3.5 其它核心物件

Windows中還有其他常用核心物件,即使用者物件和GDI物件。以下是這些物件的簡要描述以及這些物件的控制程式碼。

- 工作管理員。可以通過新增「使用者物件」和「GDI物件」列來顯示每個程序的此類物件的數量。

- 使用者物件。使用者物件是視窗(HWND)、選單(HNU)和掛鉤(HHOOK)。這些物件的控制程式碼具有以下屬性:

- 無參照計數。第一個銷燬使用者物件的呼叫方——它已經消失了。

- 控制程式碼值的範圍在視窗工作站(Window Station)下。視窗工作站包含剪貼簿、桌面和原子表。例如,意味著這些物件的控制程式碼可以在共用桌面的所有應用程式之間自由傳遞。

- GDI物件。圖形裝置介面(GDI)是Windows中的原始圖形API,即使有更豐富和更好的API(例如Direct2D)。例如裝置上下文(HDC)、筆(HPEN)、畫筆(HBRUSH)、點陣圖(HBITMAP)等。以下是它們的屬性:

- 無參照計數。

- 控制程式碼僅在建立過程中有效。

- 不能在程序之間共用。

18.3.6 中斷

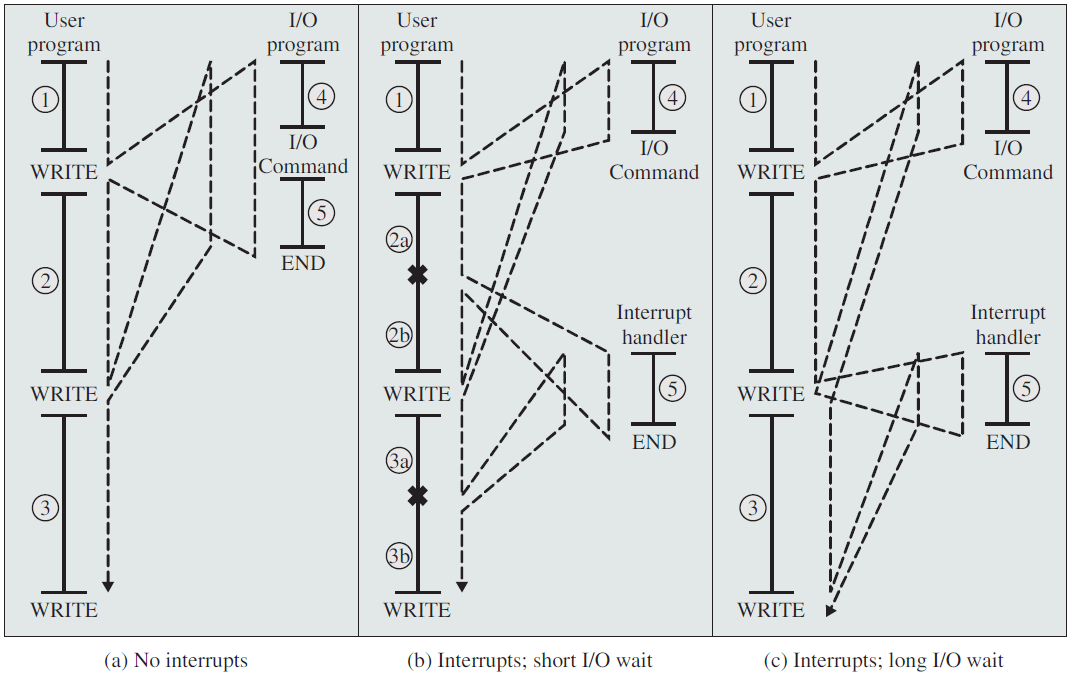

任何作業系統核心的核心職責是管理連線到機器硬碟機和藍光光碟、鍵盤和滑鼠、3D處理器和無線收音機的硬體。為了履行這一職責,核心需要與機器的各個裝置進行通訊。考慮到處理器的速度可能比它們與之對話的硬體快幾個數量級,核心發出請求並等待明顯較慢的硬體的響應是不理想的。相反,由於硬體的響應速度相對較慢,核心必須能夠自由地去處理其他工作,只有在硬體實際完成工作之後才處理硬體。

處理器如何在不影響機器整體效能的情況下與硬體一起工作?這個問題的一個答案是輪詢(polling),核心可以定期檢查系統中硬體的狀態並做出相應的響應。然而,輪詢會產生開銷,因為無論硬體是活動的還是就緒的,輪詢都必須重複進行。更好的解決方案是提供一種機制,讓硬體在需要注意時向核心發出訊號,這種機制稱為中斷(interrupt)。在本節中,我們將討論中斷以及核心如何響應它們,並使用稱為中斷處理程式(interrupt handler)的特殊函數。

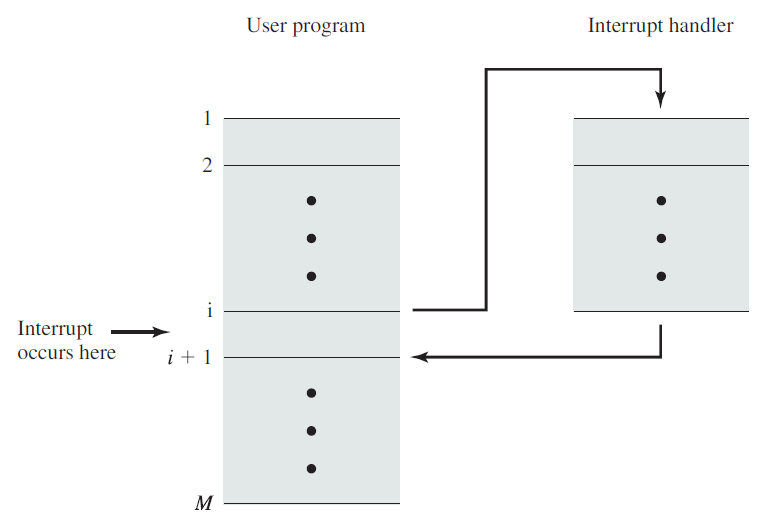

無中斷和有中斷的程式控制流程。

18.3.6.1 中斷概述

中斷使硬體能夠向處理器傳送訊號,例如,當用鍵盤鍵入時,鍵盤控制器(管理鍵盤的硬體裝置)向處理器發出電訊號,以提醒作業系統新可用的按鍵,這些電訊號就是中斷。處理器接收中斷並向作業系統傳送訊號以使作業系統能夠響應新資料,硬體裝置相對於處理器時鐘非同步地生成中斷,它們可以在任何時間發生。因此,核心可以隨時中斷以處理中斷。

中斷是由來自硬體裝置的電子訊號物理產生的,並被引導到中斷控制器的輸入引腳,中斷控制器是一個簡單的多執行緒晶片,將多條中斷線組合成一條到處理器的單線。在接收到中斷時,中斷控制器向處理器傳送訊號,處理器檢測到該訊號並中斷其當前執行以處理該中斷。然後,處理器可以通知作業系統發生了中斷,作業系統可以適當地處理中斷。

不同的裝置可以通過與每個中斷相關聯的唯一值與不同的中斷相關聯,來自鍵盤的中斷與來自硬碟的中斷是不同的,使得作業系統能夠區分中斷並知道哪個硬體裝置導致了哪個中斷。反過來,作業系統可以使用相應的處理程式為每個中斷提供服務。

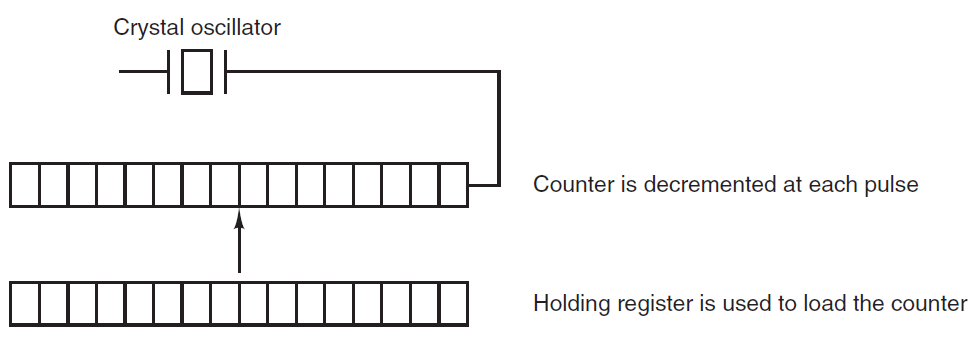

這些中斷值通常稱為中斷請求(interrupt request,IRQ)線(line)。每個IRQ行都分配了一個數值,例如,在經典PC上,IRQ 0是計時器中斷,IRQ 1是鍵盤中斷。然而,並非所有的中斷號都是如此嚴格地定義的,例如,與PCI匯流排上的裝置相關的中斷通常是動態分配的。其他非PC架構對中斷值具有類似的動態分配,重要的是,一個特定的中斷與一個特定裝置相關聯,核心知道這一點。然後硬體發出中斷以引起核心的注意:「嘿,我有新的按鍵在等待!讀取並處理這些壞孩子!」

帶中斷的指令週期。

18.3.6.2 中斷請求級別

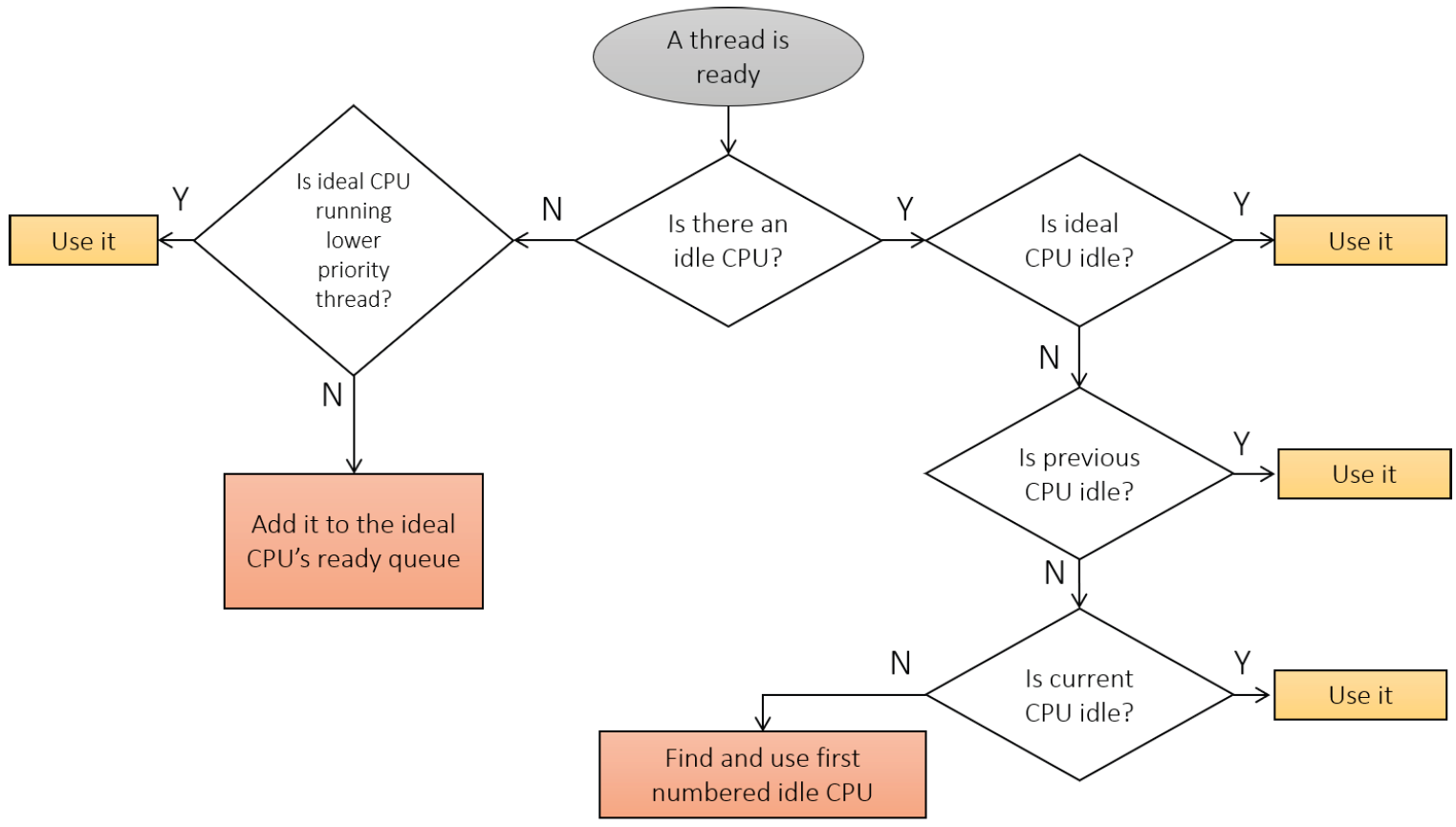

每個硬體中斷都與一個優先順序相關聯,稱為中斷請求級別(Interrupt Request Level,IRQL)(注意,不要與稱為IRQ的中斷物理線混淆),由HAL確定。每個處理器的上下文都有自己的IRQL,就像任何暫存器一樣。IRQL可以由CPU硬體實現,也可以不由CPU硬體來實現,但本質上並不重要,IRQL應該像其他CPU暫存器一樣對待。

基本規則是處理器執行具有最高IRQL的程式碼。例如,如果某個CPU的IRQL在某個時刻為零,並且出現了一個IRQL為5的中斷,它將在當前執行緒的核心堆疊中儲存其狀態(上下文),將其IRQL提升到5,然後執行與該中斷相關聯的ISR。一旦ISR完成,IRQL將下降到其先前的級別,繼續執行先前執行的程式碼,就像中斷不存在一樣。當ISR執行時,IRQL為5或更低的其他中斷無法中斷此處理器。另一方面,如果新中斷的IRQL高於5,CPU將再次儲存其狀態,將IRQL提升到新級別,執行與第二個中斷相關聯的第二個ISR,完成後,將返回到IRQL 5,恢復其狀態並繼續執行原始ISR。本質上,提升IRQL會暫時阻止IRQL等於或低於IRQL的程式碼。中斷髮生時的基本事件序列如下圖所示,下下圖顯示了中斷巢狀的樣子。

基本中斷排程流程。

巢狀中斷流程。

上兩圖所示場景的一個重要事實是,所有ISR的執行都是由最初被中斷的同一執行緒完成的。Windows沒有處理中斷的特殊執行緒,它們由當時在中斷的處理器上執行的任何執行緒處理。我們很快就會發現,當處理器的IRQL為2或更高時,上下文切換是不可能的,因此在這些ISR執行時,不可能有其他執行緒潛入。

由於這些「中斷」,被中斷的執行緒不會減少其數量。可以說,這不是它的錯。

當執行使用者模式程式碼時,IRQL始終為0,這就是為什麼在任何使用者模式檔案中都沒有提到IRQL這個術語的原因之一——它總是為0,不能更改。大多數核心模式程式碼也使用IRQL 0執行,在核心模式下,可以在當前處理器上提升IRQL。

Windows使用API提升或降低IRQL的範例:

// assuming current IRQL <= DISPATCH_LEVEL

KIRQL oldIrql; // typedefed as UCHAR

// 提升IRQL

KeRaiseIrql(DISPATCH_LEVEL, &oldIrql);

NT_ASSERT(KeGetCurrentIrql() == DISPATCH_LEVEL);

// 在IRQL的DISPATCH_LEVEL執行工作。

// 降低IRQ

KeLowerIrql(oldIrql);

18.3.6.3 執行緒優先順序和IRQL

IRQL是處理器的一個屬性,優先順序是執行緒的屬性,執行緒優先順序僅在IRQL<2時才有意義。一旦執行執行緒將IRQL提升到2或更高,它的優先順序就不再有任何意義了,理論上它擁有無限量程——會一直執行,直到IRQL降低到2以下。

當然,在IRQL>=2上花費大量時間不是一件好事,使用者模式程式碼肯定沒有執行,這只是在這些級別上執行程式碼的能力受到嚴格限制的原因之一。

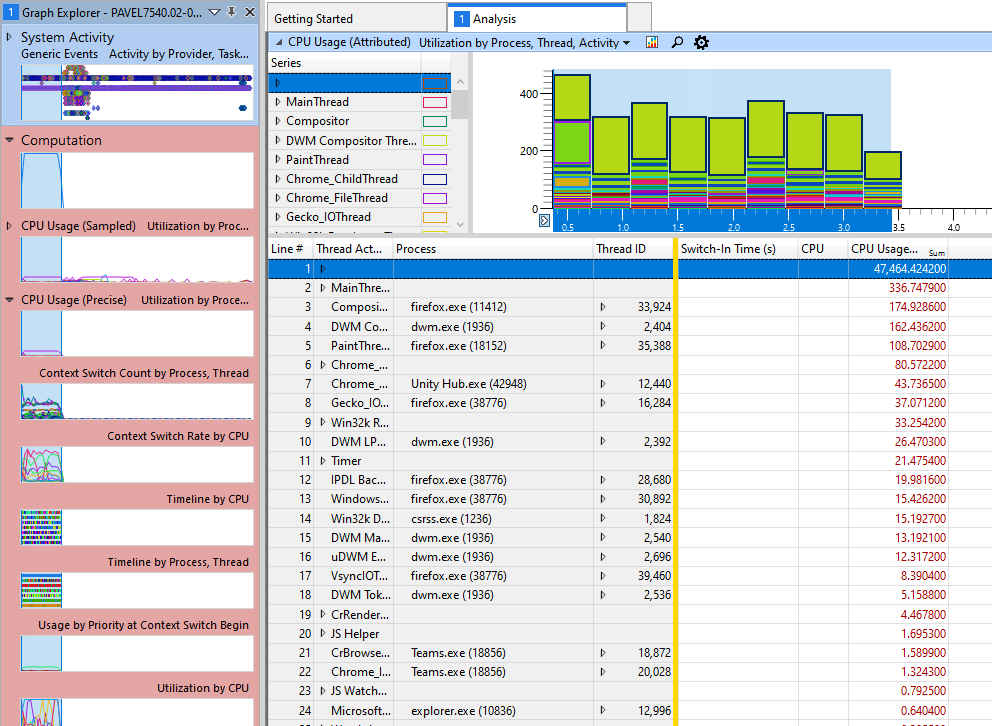

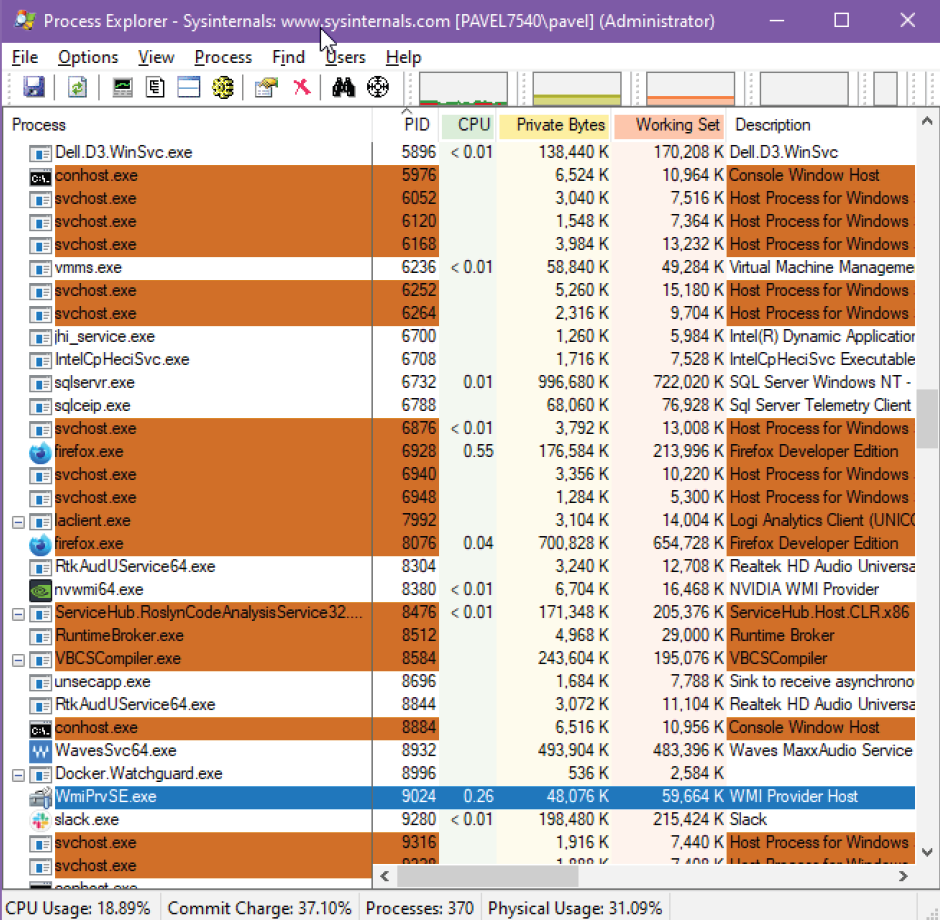

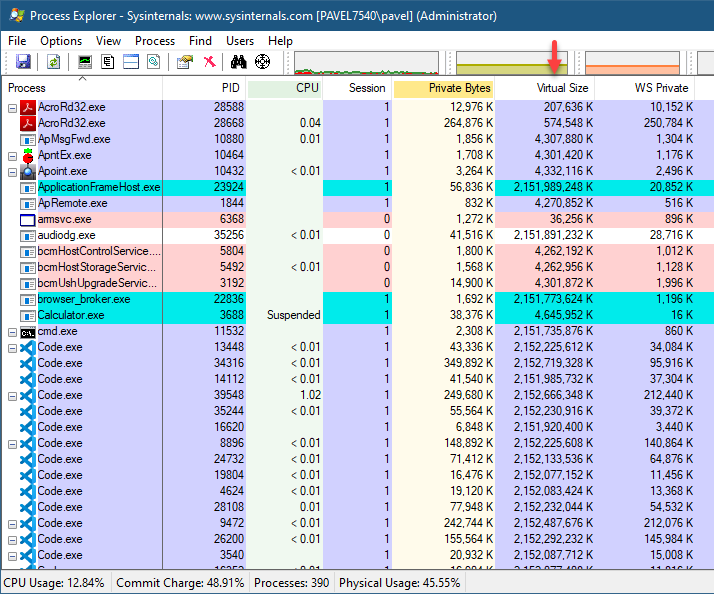

Windows工作管理員顯示使用稱為系統中斷的偽程序在IRQL2或更高版本中花費的CPU時間,Process Explorer將其稱為「中斷」。下圖上半部分顯示了Task Manager的螢幕截圖,下半部分顯示了Process Explorer中的相同資訊。

18.3.6.4 中斷處理器

核心響應特定中斷而執行的函數稱為中斷處理程式或中斷服務例程(interrupt service routine,ISR),每個產生中斷的裝置都有一個相關的中斷處理程式。例如,一個函數處理來自系統計時器的中斷,而另一個函數則處理鍵盤產生的中斷。裝置的中斷處理程式是裝置驅動程式(管理裝置的核心程式碼)的一部分。

在Linux中,中斷處理程式是正常的C函數。它們匹配一個特定的原型,這使得核心能夠以標準方式傳遞處理程式資訊,但除此之外,它們都是普通函數。中斷處理程式與其他核心函數的區別在於,核心在響應中斷時呼叫它們,並且它們在一個稱為中斷上下文(interrupt context)的特殊上下文中執行,這個特殊的上下文有時被稱為原子上下文(atomic context),在此上下文中執行的程式碼不能被阻塞。

因為中斷可以在任何時候發生,所以中斷處理程式可以在任何時間執行,處理程式必須快速執行,以便儘快恢復被中斷程式碼的執行。因此,雖然作業系統無延遲地為中斷提供服務對硬體很重要,但對系統的其餘部分來說,中斷處理程式在儘可能短的時間內執行也是很重要的。

至少,中斷處理程式的工作是向硬體確認中斷的接收:「嘿,硬體,我聽到了;現在回去工作吧!」然而,中斷處理程式通常要執行大量的工作,例如,考慮網路裝置的中斷處理程式。除了響應硬體之外,中斷處理器還需要將網路封包從硬體複製到記憶體中,對其進行處理,並將封包向下推播到適當的協定棧或應用程式。顯然,可能需要大量工作,尤其是今天的千兆和10千兆乙太網卡。

通過中斷傳輸控制權。

在Linux的驅動程式中,請求中斷行並安裝處理程式是通過request_irq()完成的:

if(request_irq(irqn, my_interrupt, IRQF_SHARED, "my_device", my_dev))

{

printk(KERN_ERR "my_device: cannot register IRQ %d\n", irqn);

return -EIO;

}

18.3.6.5 中斷上下文

執行中斷處理程式時,核心處於中斷上下文中,程序上下文是核心代表程序執行時的操作模式,例如,執行系統呼叫或執行核心執行緒。在程序上下文中,當前宏指向關聯的任務。此外,由於程序在程序上下文中耦合到核心,程序上下文可以休眠或以其他方式呼叫排程器。

另一方面,中斷上下文與程序無關,當前宏不相關(儘管它指向被中斷的程序)。如果沒有後備程序,中斷上下文將無法休眠,它將如何重新排程?因此,不能從中斷上下文中呼叫某些函數,如果函數處於休眠狀態,則不能從中斷處理程式中使用它,這限制了從中斷處理常式中呼叫的函數。

中斷上下文是時間關鍵的,因為中斷處理程式會中斷其他程式碼。程式碼應該快速簡單。繁忙的迴圈是可能的,但不鼓勵。請記住,中斷處理程式中斷了其他程式碼(甚至可能是另一行上的另一箇中斷處理程式!)。由於這種非同步特性,所有中斷處理程式都必須儘可能快和簡單。儘可能地,工作應該從中斷處理程式中推出,並在下半部分中執行,在更方便的時間執行。

中斷處理程式堆疊的設定是一個設定選項,從歷史上看,中斷處理程式沒有收到自己的堆疊,相反,他們將共用中斷的程序堆疊。核心堆疊大小為兩頁,通常在32位元體系結構上為8KB,在64位元體系結構中為16KB。因為在這種設定中,中斷處理程式共用堆疊,所以它們在分配資料時必須格外節約。當然,核心堆疊一開始是有限的,因此所有核心程式碼都應該謹慎。

在核心程序的早期,可以將堆疊大小從兩頁減少到一頁,在32位元系統上只提供4KB的堆疊,此舉減少了記憶體壓力,因為系統上的每個程序以前都需要兩頁連續的、不可延伸的核心記憶體。為了處理減少的堆疊大小,中斷處理程式被賦予了自己的堆疊,每個處理器一個堆疊,一個頁面大小,此堆疊稱為中斷堆疊(interrupt stack)。儘管中斷堆疊的總大小是原始共用堆疊的一半,但可用的平均堆疊空間更大,因為中斷處理程式可以自己獲取整個記憶體頁。

中斷處理程式不應該關心正在使用的堆疊設定或核心堆疊的大小,應該始終使用絕對最小的堆疊空間。

18.3.6.6 實現中斷處理程式

Linux中中斷處理系統的實現依賴於體系結構,實現取決於處理器、使用的中斷控制器型別以及體系結構和機器的設計。下圖是中斷通過硬體和核心的路徑圖。

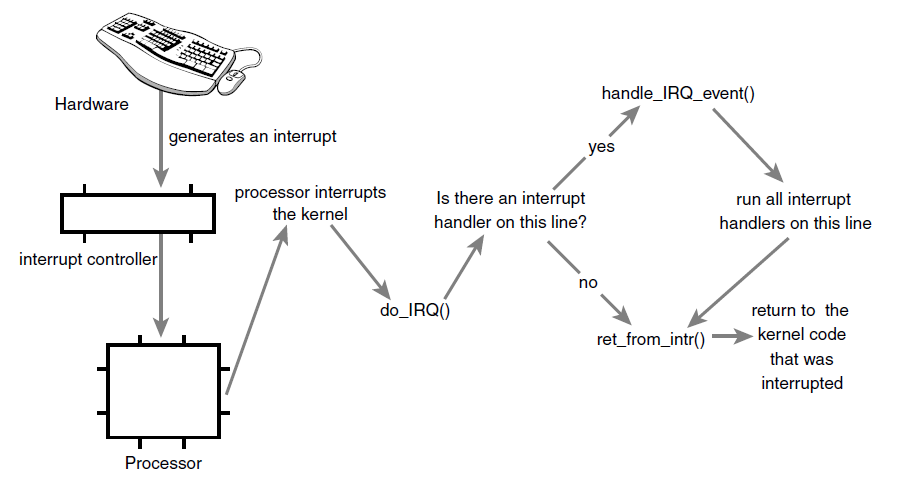

裝置通過其匯流排向中斷控制器傳送電訊號來發出中斷,如果中斷線被啟用,中斷控制器將中斷傳送到處理器。在大多數架構中,通過特殊引腳傳送到處理器的電訊號來實現。除非中斷在處理器中被禁用,否則處理器會立即停止它正在做的事情,禁用中斷系統,並跳轉到記憶體中的一個預定義位置並執行位於該位置的程式碼。這個預定義點由核心設定,是中斷處理程式的入口點。

中斷在核心中的過程從這個預定義的入口點開始,就像系統呼叫通過預定義的例外處理程式進入核心一樣。對於每個中斷行,處理器跳轉到記憶體中的一個唯一位置並執行位於該位置的程式碼。通過這種方式,核心知道傳入中斷的IRQ號,初始入口點簡單地儲存該值並將當前暫存器值(屬於中斷的任務)儲存在堆疊上,則核心呼叫do_IRQ()。從這裡開始,大多數中斷處理程式碼都是用C編寫的,然而,它仍然依賴於體系結構。下面是處理IRQ的程式碼:

/**

* handle_IRQ_event - irq action chain handler

* @irq: the interrupt number

* @action: the interrupt action chain for this irq

*

* Handles the action chain of an irq event

*/

irqreturn_t handle_IRQ_event(unsigned int irq, struct irqaction* action)

{

irqreturn_t ret, retval = IRQ_NONE;

unsigned int status = 0;

if (!(action->flags & IRQF_DISABLED))

local_irq_enable_in_hardirq();

do {

trace_irq_handler_entry(irq, action);

ret = action->handler(irq, action->dev_id);

trace_irq_handler_exit(irq, action, ret);

switch (ret) {

case IRQ_WAKE_THREAD:

/*

* Set result to handled so the spurious check

* does not trigger.

*/

ret = IRQ_HANDLED;

/*

* Catch drivers which return WAKE_THREAD but

* did not set up a thread function

*/

if (unlikely(!action->thread_fn)) {

www.it - ebooks.info

warn_no_thread(irq, action);

break;

}

/*

* Wake up the handler thread for this

* action. In case the thread crashed and was

* killed we just pretend that we handled the

* interrupt. The hardirq handler above has

* disabled the device interrupt, so no irq

* storm is lurking.

*/

if (likely(!test_bit(IRQTF_DIED,

&action->thread_flags))) {

set_bit(IRQTF_RUNTHREAD, &action->thread_flags);

wake_up_process(action->thread);

}

/* Fall through to add to randomness */

case IRQ_HANDLED:

status |= action->flags;

break;

default:

break;

}

retval |= ret;

action = action->next;

} while (action);

if (status & IRQF_SAMPLE_RANDOM)

add_interrupt_randomness(irq);

local_irq_disable();

return retval;

}

18.3.6.7 延遲過程呼叫

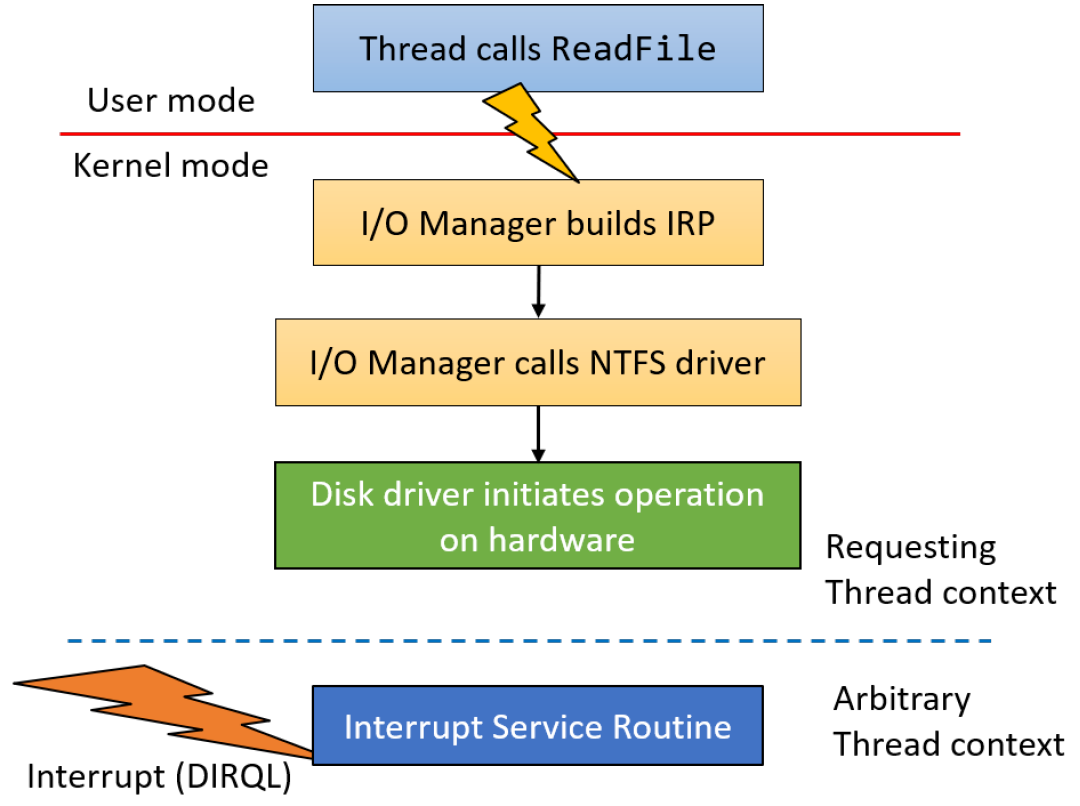

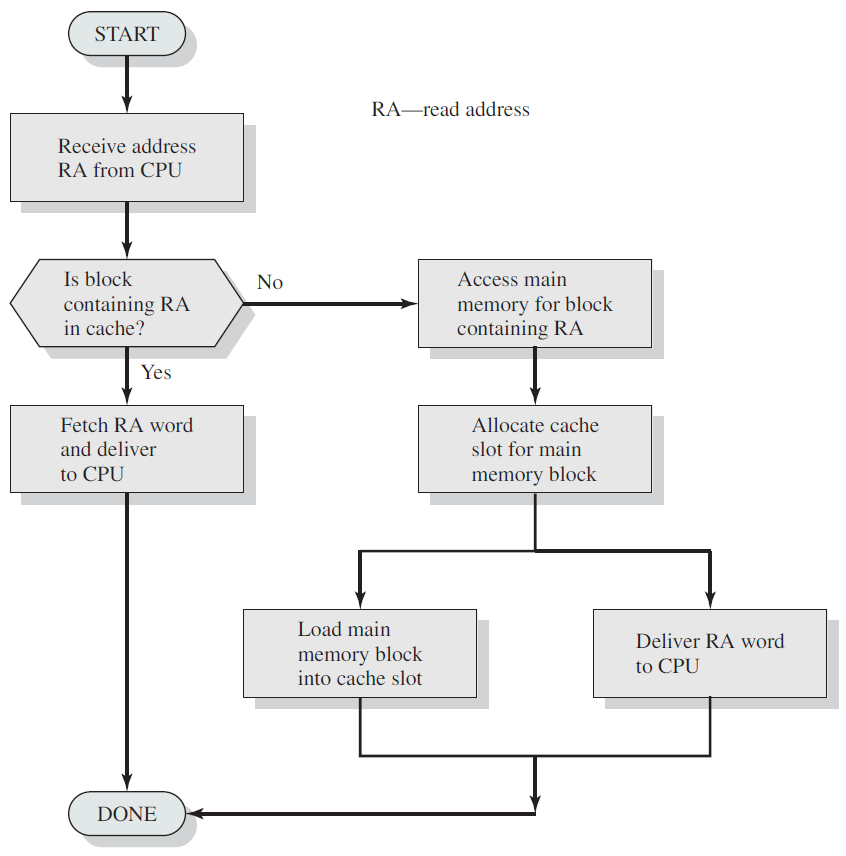

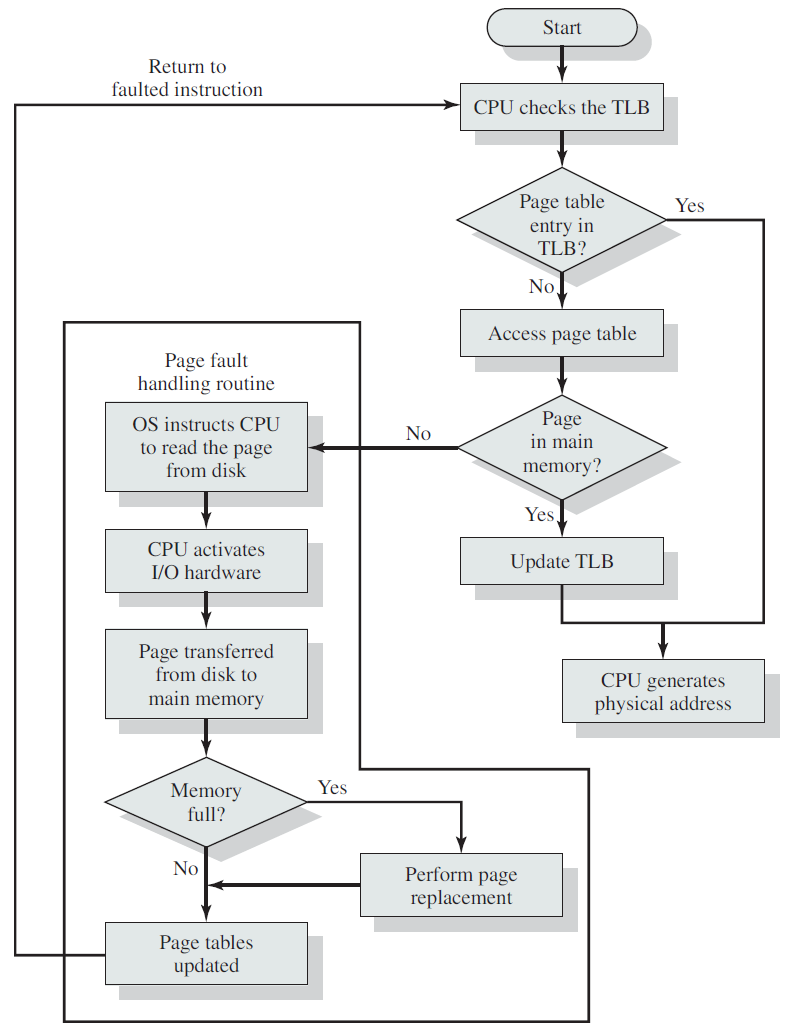

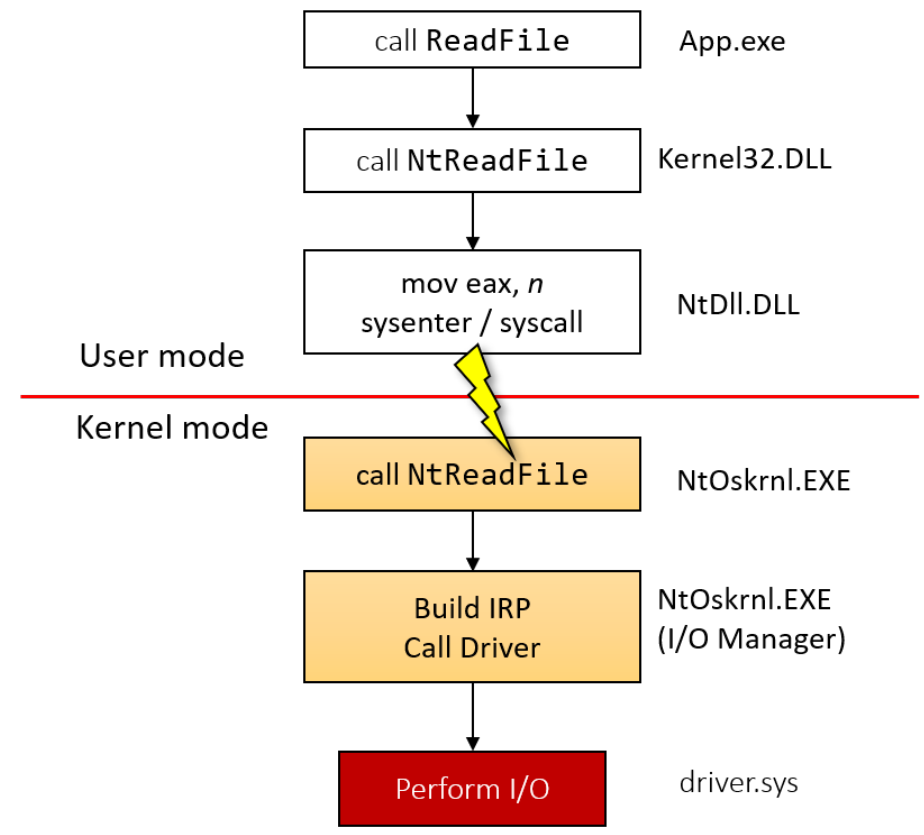

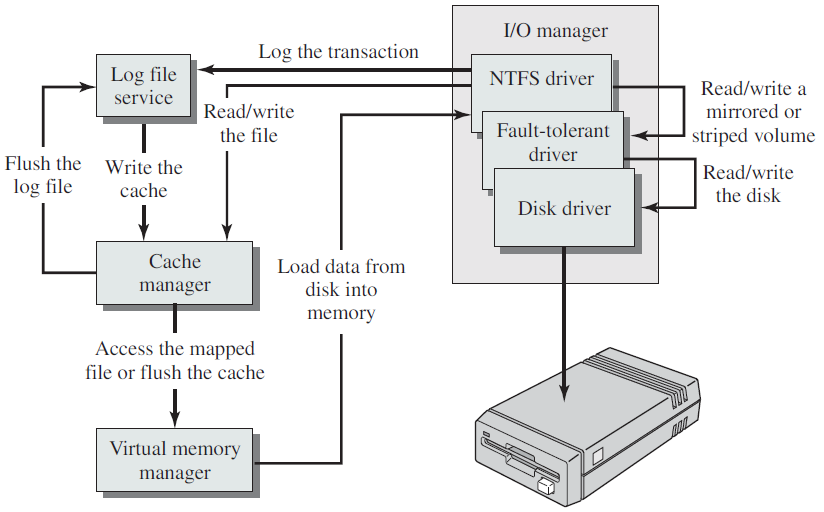

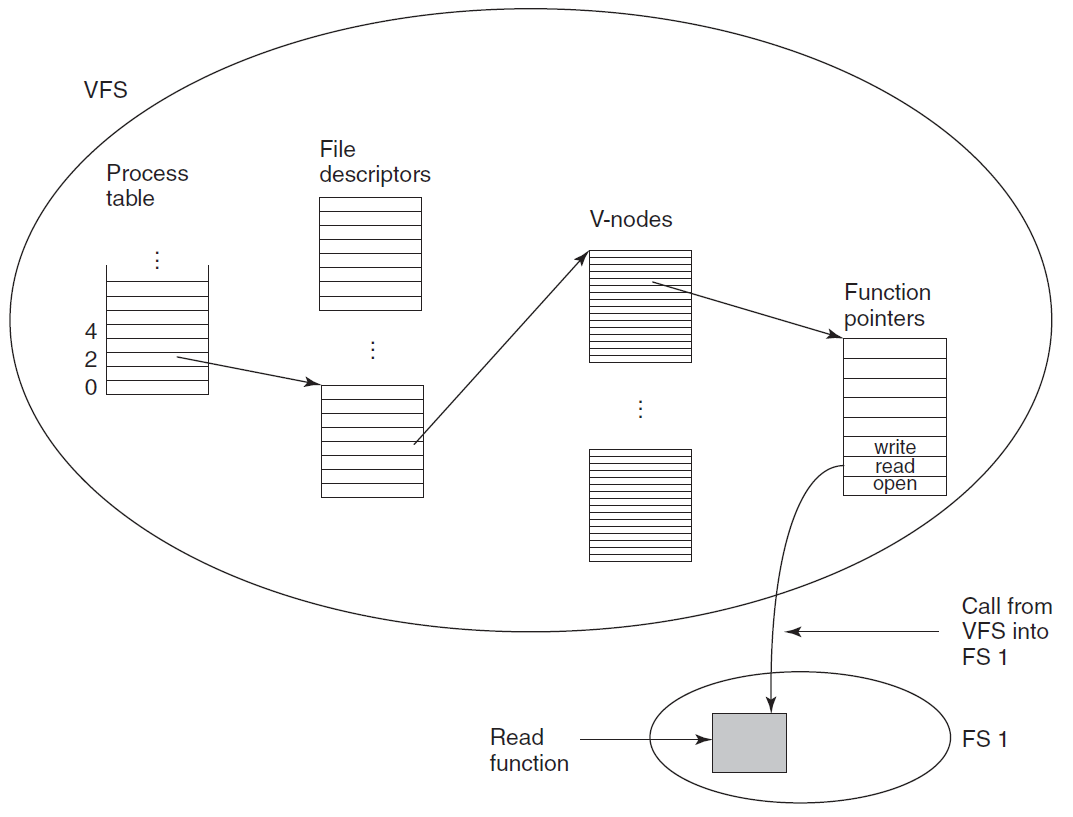

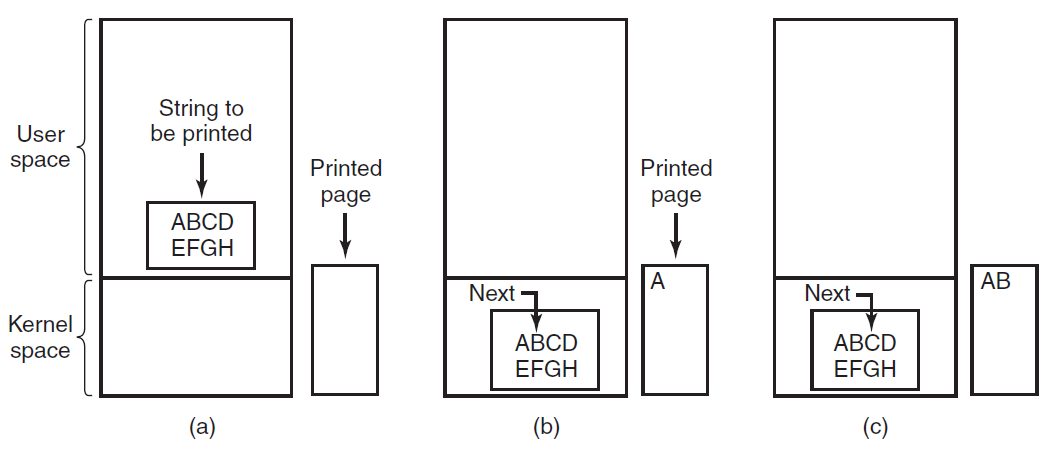

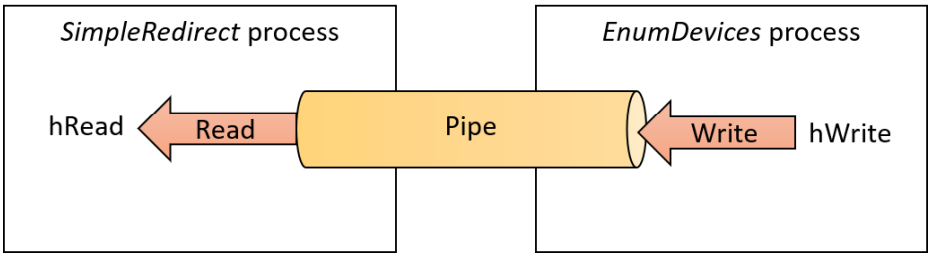

下圖顯示了使用者端呼叫某些I/O操作時的典型事件序列,在圖中,使用者模式執行緒開啟檔案的控制程式碼,並使用ReadFile函數發出讀取操作。由於執行緒可以進行非同步呼叫,因此它幾乎立即重新獲得控制權,並可以執行其他工作。接收到此請求的驅動程式將呼叫檔案系統驅動程式(例如NTFS),該驅動程式可能會呼叫其下面的其他驅動程式,直到請求到達磁碟驅動程式,該磁碟驅動程式將在實際磁碟硬體上啟動操作。在這一點上,沒有程式碼需要執行,因為硬體「做它的事情」。

當硬體完成讀取操作時,它發出一箇中斷,導致與中斷相關聯的中斷服務例程在裝置IRQL上執行(請注意,處理請求的執行緒是任意的,因為中斷是非同步到達的)。典型的ISR存取裝置的硬體以獲得操作結果,它的最終行動應該是完成最初的請求。

簡單的中斷處理過程。

18.3.6.8 非同步過程呼叫

在Windows中,延遲過程呼叫(DPC)是封裝在IRQLDISPATCH_LEVEL呼叫的函數的物件。就DPC而言,呼叫執行緒並不重要。非同步過程呼叫(APC)也是封裝要呼叫的函數的資料結構。但與DPC相反,APC的目標是特定執行緒,因此只有該執行緒才能執行該函數,意味著每個執行緒都有一個與其關聯的APC佇列。APC有三種型別:

- 使用者模式APC。僅當執行緒進入可報警狀態時,這些APC在IRQL PASSIVE_LEVEL的使用者模式下執行,通常通過呼叫API(如SleepEx、WaitForSingleObjectEx、WaitForMultipleObjectsEx和類似API)來完成。這些函數的最後一個引數可以設定為TRUE,以使執行緒處於可報警狀態。在此狀態下,它檢視其APC佇列,如果不是空的,則APC現在執行,直到佇列為空。

- 正常核心模式APC。這些APC在IRQL PASSIVE_LEVEL的核心模式下執行,並搶佔使用者模式程式碼和使用者模式APC。

- 特殊核心APC。這些APC在IRQL APC_LEVEL(1)的核心模式下執行,並搶佔使用者模式程式碼、正常核心APC和使用者模式APC。I/O系統使用這些APC來完成I/O操作。

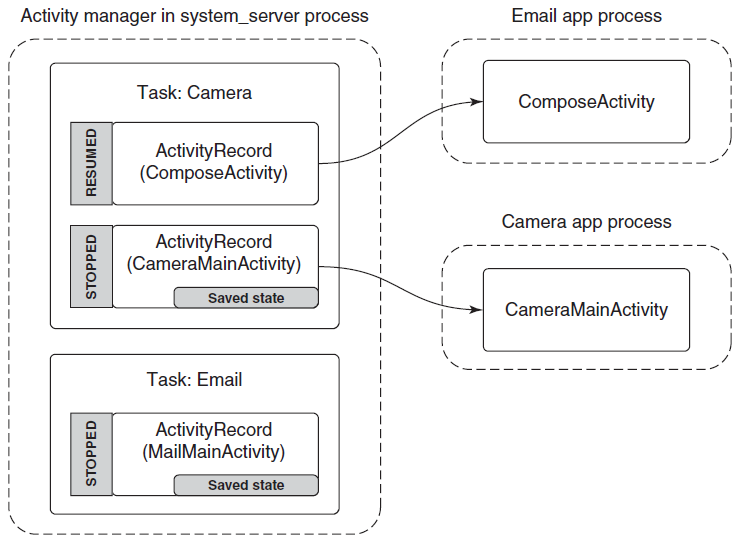

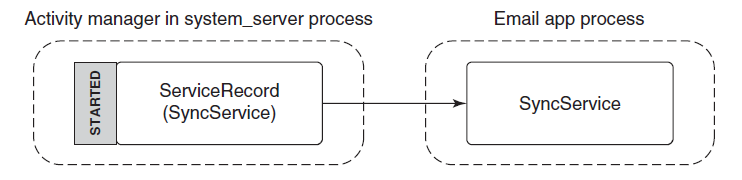

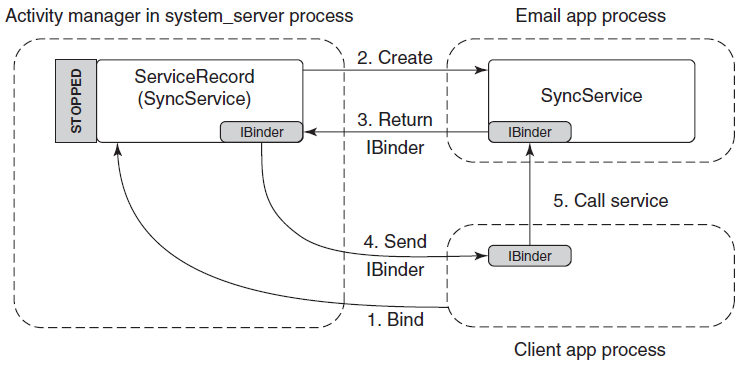

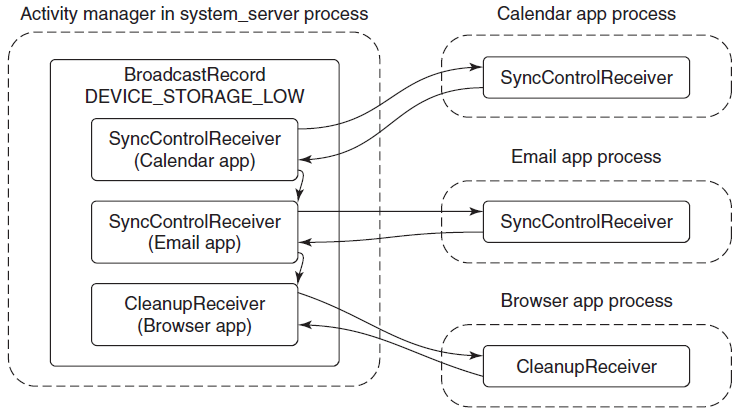

18.4 程序

本章將闡述各種作業系統下的程序的概念、特點和技術內幕。

18.4.1 程序模型

在這種模型中,計算機上所有可執行的軟體,有時包括作業系統,都被組織成若干順序程序,或者簡稱為程序。程序只是執行程式的一個範例,包括程式計數器、暫存器和變數的當前值。從概念上講,每個程序都有自己的虛擬CPU。當然,在現實中,真正的CPU在程序之間來回切換,但為了理解系統,考慮以(偽)並行方式執行的程序集合要比跟蹤CPU如何在程式之間切換容易得多。這種快速的來回切換稱為多道程式設計(multiprogramming)。

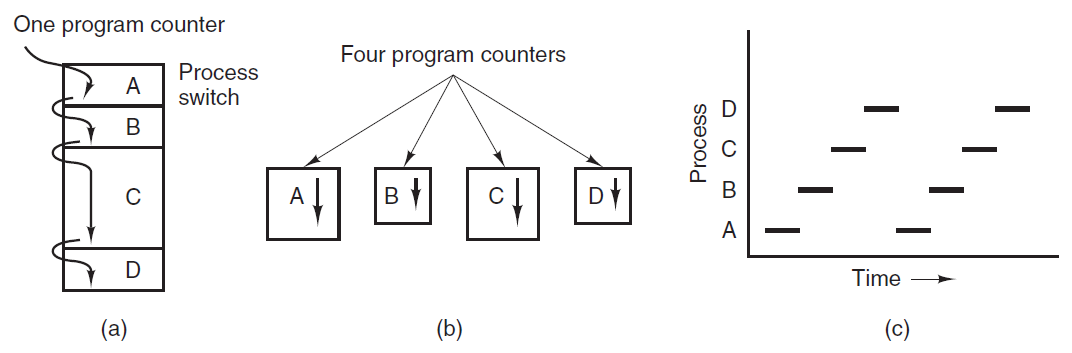

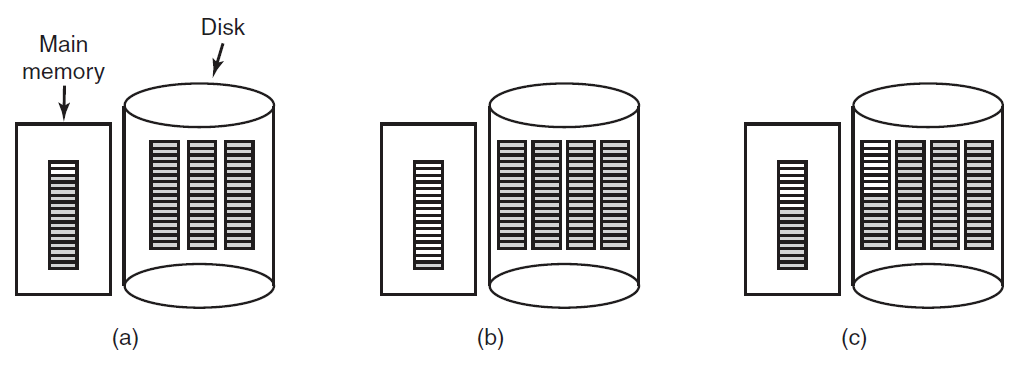

在下圖(a)中,我們看到一臺計算機在記憶體中多道程式設計四個程式。在下圖(b)中,我們看到四個程序,每個程序都有自己的控制流(即自己的邏輯程式計數器),每個程序獨立於其他程序執行。當然,只有一個物理程式計數器,因此當每個程序執行時,其邏輯程式計數器被載入到實際程式計數器中。當它完成時(暫時),物理程式計數器儲存在記憶體中程序的儲存邏輯程式計數器中。在下圖(c)中,我們可以看到,從足夠長的時間間隔來看,所有程序都取得了進展,但在任何給定的時刻,只有一個程序實際在執行。

(a) 多道程式設計四個程式。(b) 四個獨立、連續程序的概念模型。(c) 一次只有一個程式處於活動狀態。

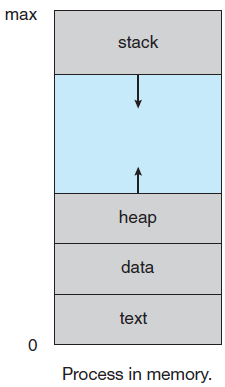

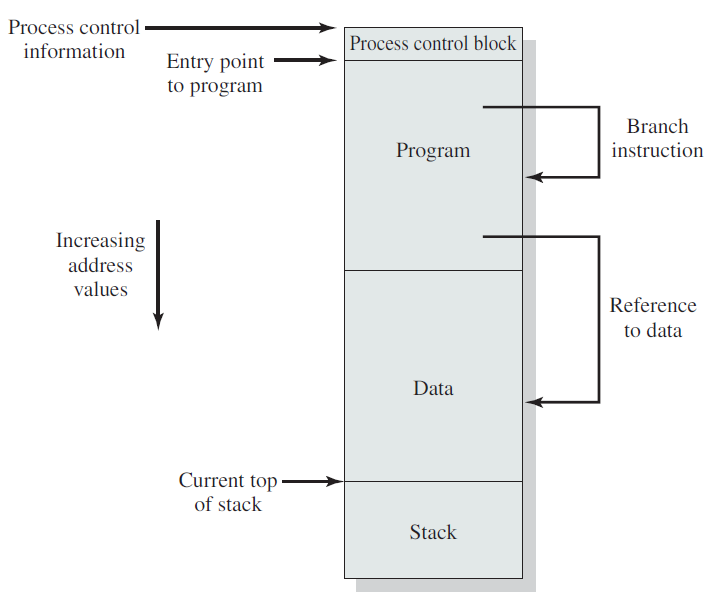

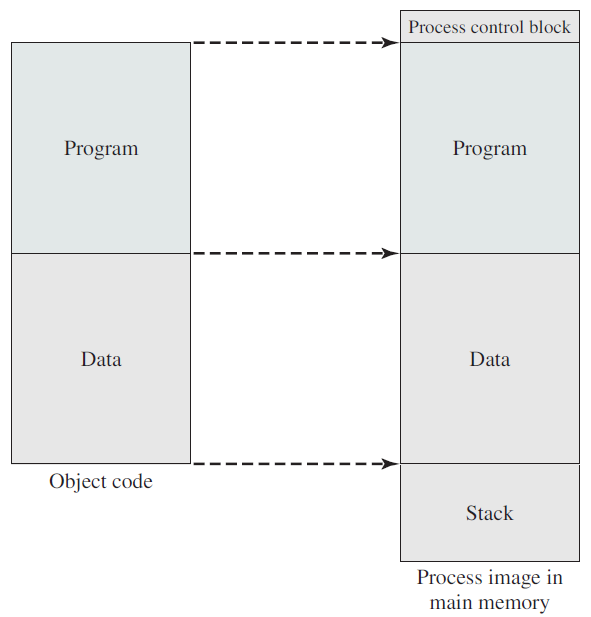

程序或任務是正在執行的程式的範例,程序的執行必須按程式設計順序。任何時候最多執行一條指令,包括由程式計數器的值和處理器暫存器的內容表示的當前活動,還包括包含臨時資料(如方法引數返回地址和區域性變數)的程序堆疊和包含全域性變數的資料段。程序還可能包括堆,堆是在程序執行時動態分配的記憶體。

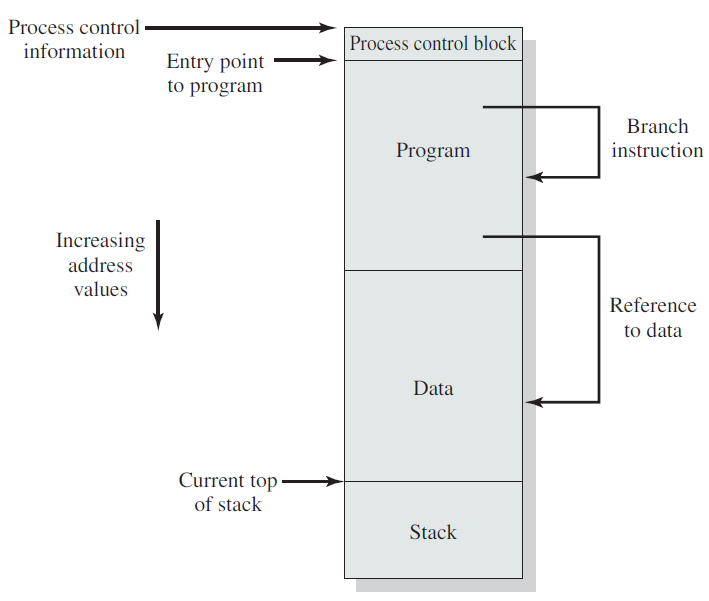

常規的程序實現和記憶體結構。

程序和程式之間的差異:程式本身不是一個程序,正在執行的程式稱為程序。程式是一個被動實體,例如儲存在磁碟上的檔案的內容,而程序是一個活動實體,有一個程式計數器指定要執行的下一條指令,一組相關的資源可以在多個程序之間共用,使用一些排程演演算法來確定何時停止一個程序併為另一個程序服務。

當程序執行時,它會改變狀態,其狀態由該程序的正確活動定義。每個程序可能處於以下狀態之一:

- 新建(New):正在建立程序。

- 就緒(Ready):程序正在等待分配給處理器。

- 正在執行(Running Man):正在執行指令。

- 等待(Waiting):程序正在等待某些事件發生。

- 已終止(Terminated:):程序已完成執行。

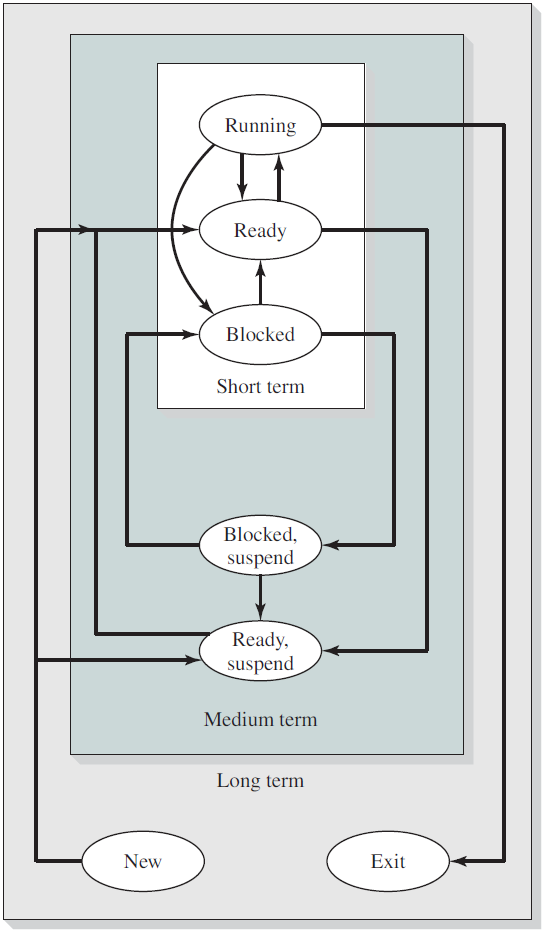

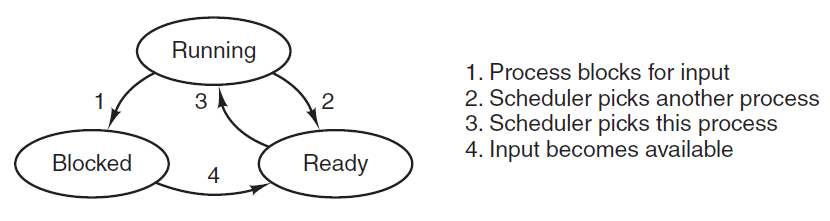

許多程序可能同時處於就緒和等待狀態,但在任何一個處理器上,任何時候都只能執行一個程序。下圖是程序不同狀態之間的切換:

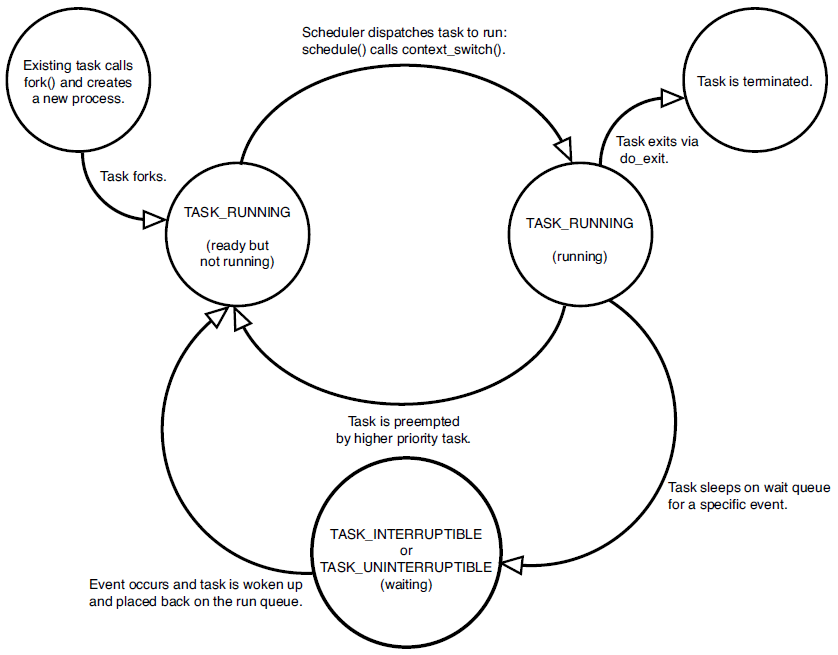

RTOS+的程序狀態切換如下:

Linux程序狀態切換如下:

兩狀態的程序模型:

五狀態的程序模型:

程序佇列模型樣例圖:

帶一個或兩個暫停狀態的程序狀態轉換圖:

Unix程序狀態轉換表:

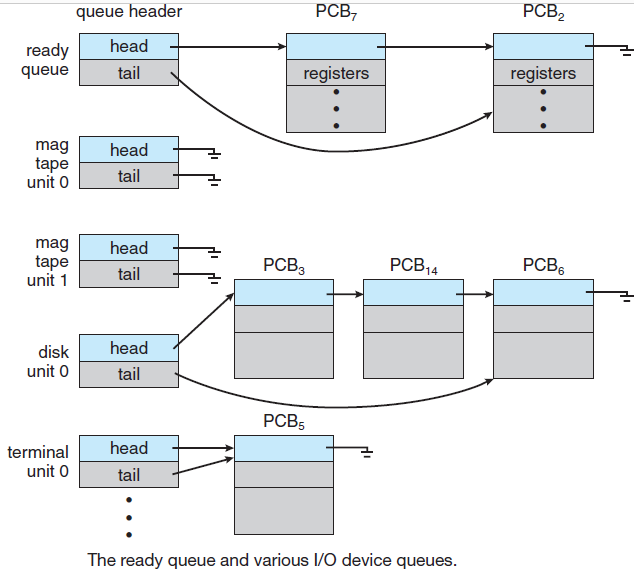

18.4.2 過程控制塊

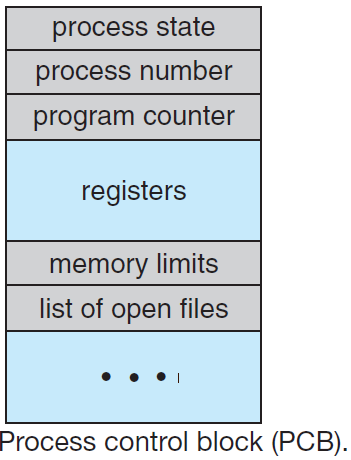

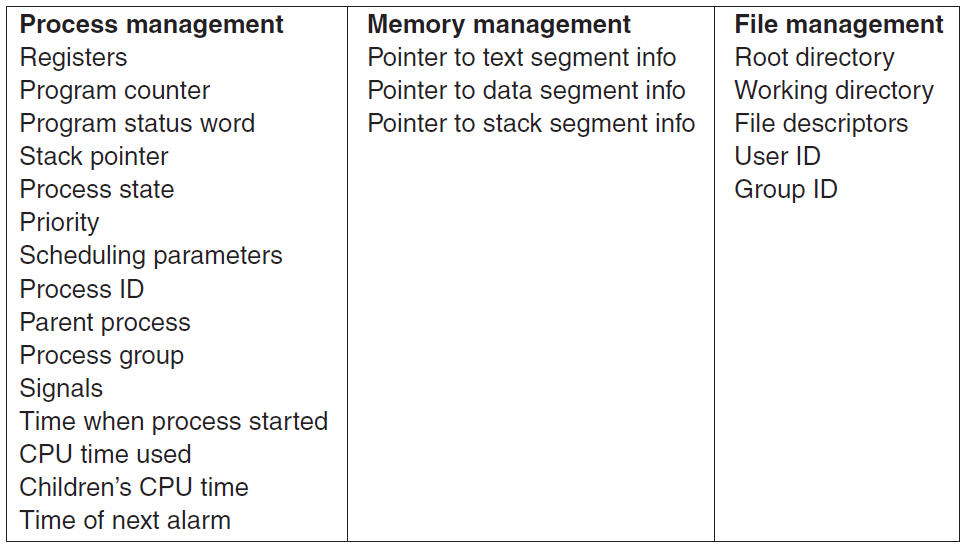

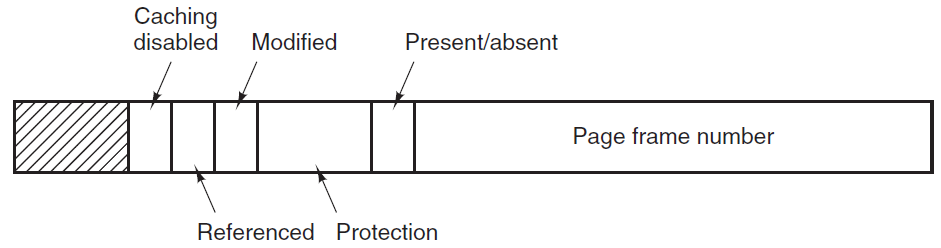

每個程序在作業系統中由過程控制塊(Process Control Block,PCB)表示,也由過程控制塊控制。過程控制塊也稱為任務控制塊,包含與特定過程相關聯的許多資訊,包括以下資訊:

- 程序狀態:狀態可以是新狀態、就緒狀態、執行狀態、等待狀態或終止狀態。

- 程式計數器:它指示為此目的執行的下一條指令的地址。

- CPU暫存器:暫存器的數量和型別因計算機架構而異。它包括累加器、索引暫存器、堆疊指標和通用暫存器,加上在發生中斷時必須儲存的任何條件程式碼資訊,以便在之後正確地繼續處理。

- CPU排程資訊:此資訊包括排程佇列的程序優先順序指標和任何其他排程引數。

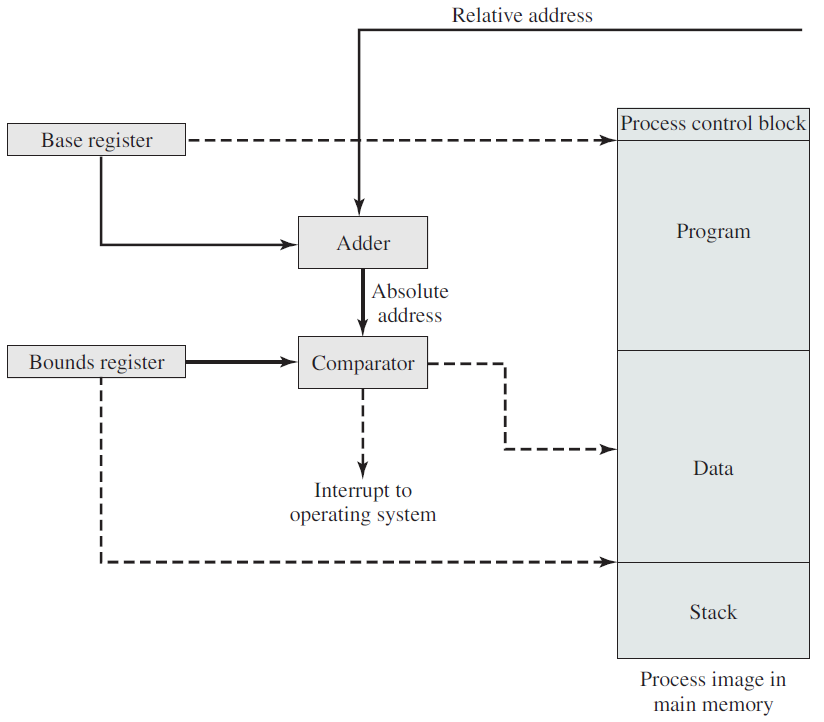

- 記憶體管理資訊:根據作業系統使用的記憶體系統,該資訊可能包括諸如條形和限制暫存器、頁面表或段表的值等資訊。

- 賬號資訊:此資訊包括CPU數量和實時使用時間、時間限制、帳號、作業或程序編號等。

- I/O狀態資訊:此資訊包括分配給此程序的I/O裝置列表、開啟的檔案列表等,PCB只是用作儲存可能因程序而異的任何資訊的儲存庫。

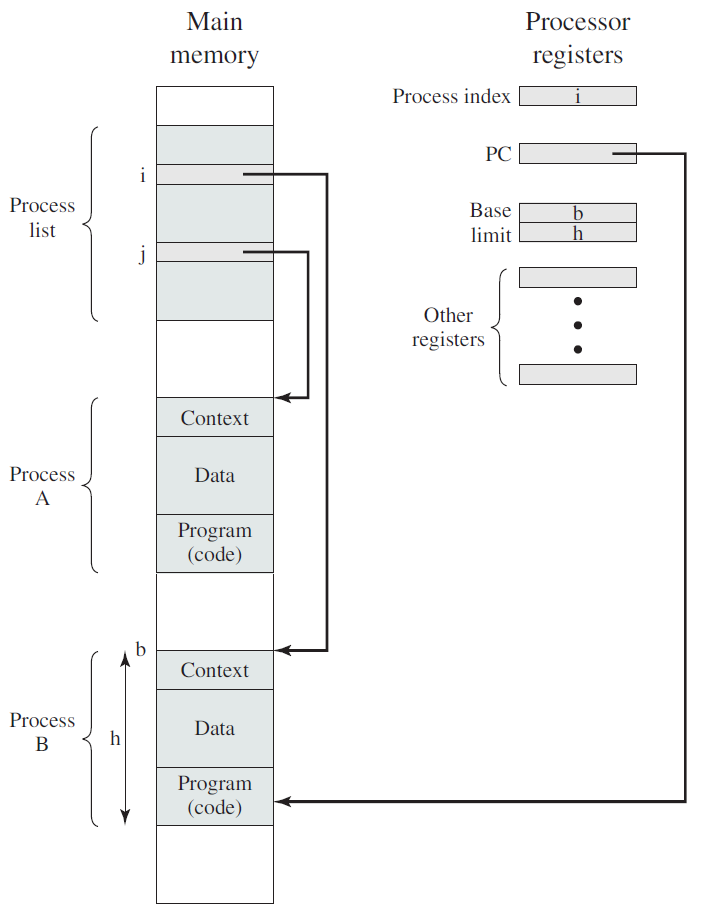

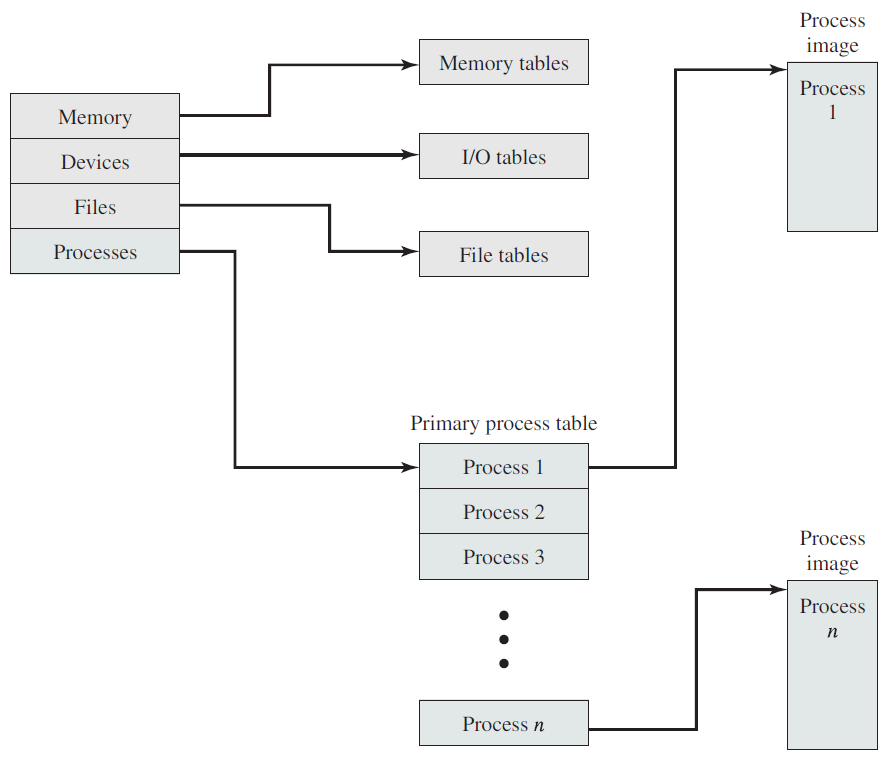

CPU利用PCB來切換程序的執行。

18.4.3 上下文切換

當CPU切換到另一個程序時,系統必須儲存舊程序的狀態,並載入新程序的儲存狀態,這個行為稱為上下文切換。上下文切換時間開銷大,系統在切換時沒有做任何有用的工作。切換速度因機器而異,具體取決於記憶體速度、必須複製的暫存器數量以及特殊指令的存在,典型的速度是幾毫秒。上下文切換時間高度依賴於硬體支援。

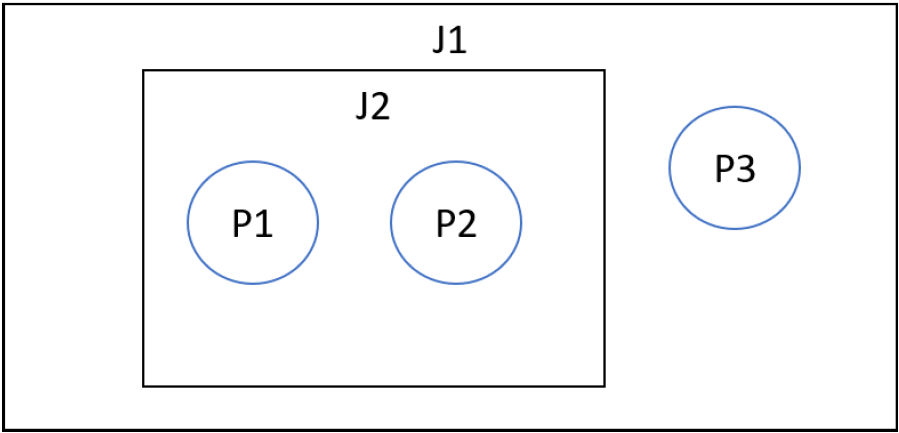

18.4.4 行程群組成

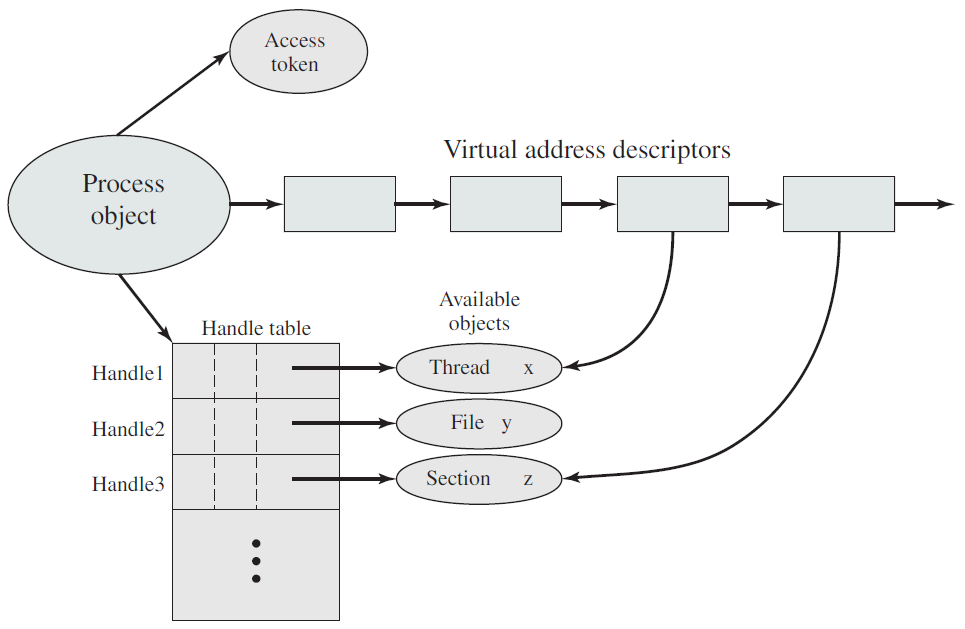

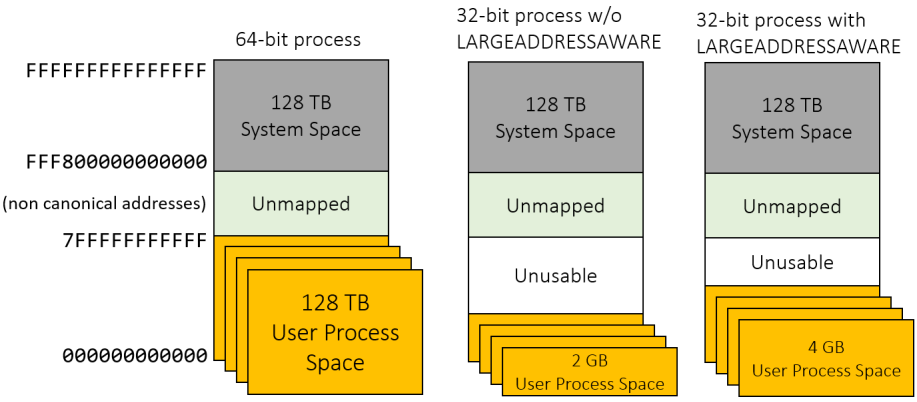

程序是一個包含和管理物件,表示程式的執行範例。以往經常使用的「程序執行」是不準確的,程序實際上不執行——而是程序管理。執行緒才是執行程式碼並在技術上執行的載體。從高層次的角度來看,一個程序具有以下特點:

- 一個可執行程式,其中包含用於在程序中執行程式碼的初始程式碼和資料。

- 一個私有虛擬地址空間,用於為程序內的程式碼需要的任何目的分配記憶體。

- 存取令牌(有時稱為主令牌),是儲存程序預設安全上下文的物件,由程序內執行程式碼的執行緒使用(除非執行緒通過模擬使用不同的令牌)。

- 執行(核心)物件的私有控制程式碼表,如事件、號誌和檔案。

- 一個或多個執行執行緒。使用一個執行緒(執行程序的主入口點)建立普通使用者模式程序,沒有執行緒的使用者模式程序通常是無用的,通常情況下會被核心銷燬。

一個程序的重要組成部分。

程序的定址需求。

作業系統控制表的常規結構。

Windows程序和它的資源構成。

程序由其程序ID唯一標識,只要核心程序物件存在,程序ID就保持唯一。一旦它被銷燬,相同的ID就可以重新用於新的程序。可執行檔案本身不是程序的唯一識別符號,例如,Windows的記事本(notepad.exe)可能有5個範例的exe同時執行,每個程序都有自己的地址空間、執行緒、控制程式碼表、程序ID等。這5個程序都使用相同的映象檔案(notepad.exe)作為其初始程式碼和資料,但每個範例都有自己的屬性。

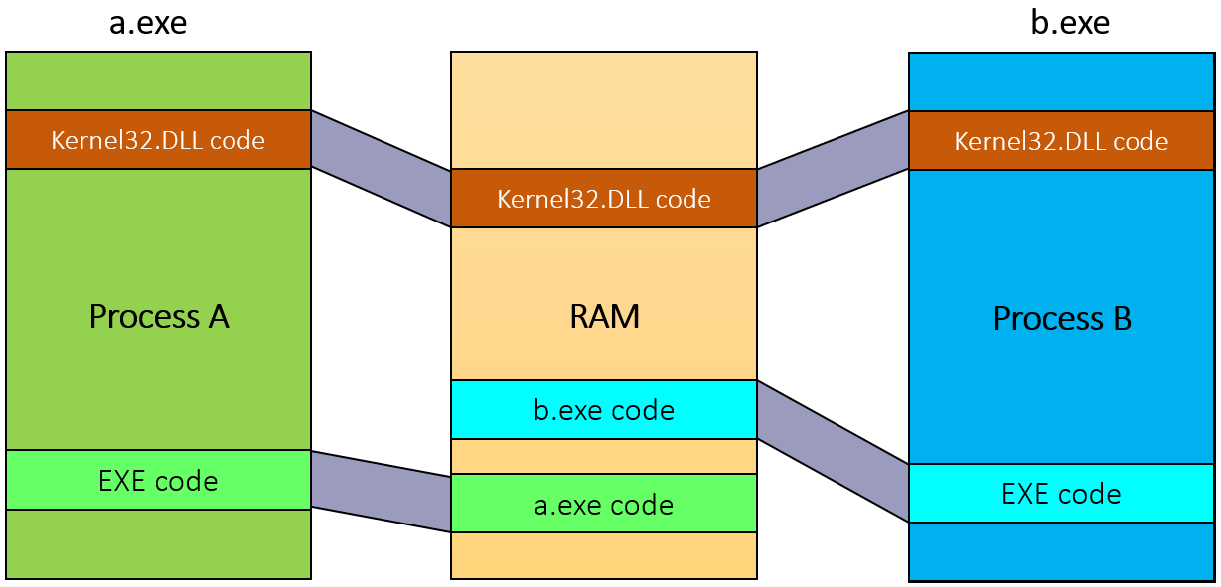

動態連結庫(DLL)是可執行檔案,可以包含程式碼、資料和資源(至少其中之一)。DLL在程序初始化時(稱為靜態連結)或在顯式請求時(動態連結)動態載入到程序中。DLL由於不包含可執行檔案等標準主函數,因此無法直接執行。DLL允許在使用同一DLL的多個程序之間共用實體記憶體中的程式碼,下圖顯示使用對映到相同物理(和虛擬)地址的共用DLL的兩個程序。

儘管自Windows NT第一次釋出以來,程序的基本結構和屬性沒有改變,但新的程序型別已經引入到具有特殊行為或結構的系統中。以下是當前支援的所有程序型別的快速概述:

- 受保護程序。是在Windows Vista中引入的。建立它們是為了通過防止對呈現受數位版權管理(DRM)保護內容的程序的侵入性存取來支援數位版權管理。例如,沒有其他程序(即使以管理員許可權執行)可以讀取具有受保護程序地址空間的記憶體,因此DRM保護的資料不能直接被竊取。

- UWP程序。從Windows 8開始可用,承載Windows執行時,通常釋出到Microsoft應用商店。UWP程序在AppContainer中執行——是一個沙盒,限制了該程序可以執行的操作。

- 受保護的輕量程序(PPL)。擴充套件了Vista的保護機制,增加了多個級別的保護,甚至允許第三方服務作為PPL執行,保護它們免受入侵存取和終止,即使是管理級程序。

- 最小化程序(Minimal Process)。是一種真正新的程序形式,其地址空間不包含正常程序所包含的常用影象和資料結構。例如,沒有對映到程序地址空間的可執行檔案,也沒有DLL,程序地址空間實際上是空的。

- 微程序(Pico Process)。這些程序是最小的程序,只有一個附加:微提供程式,它是一個核心驅動程式,可以攔截Linux系統呼叫並將其轉換為等效的Windows系統呼叫。這些程序用於Windows Subsystem for Linux(WSL),可從Windows 10版本1607獲得。

18.4.5 程序排程

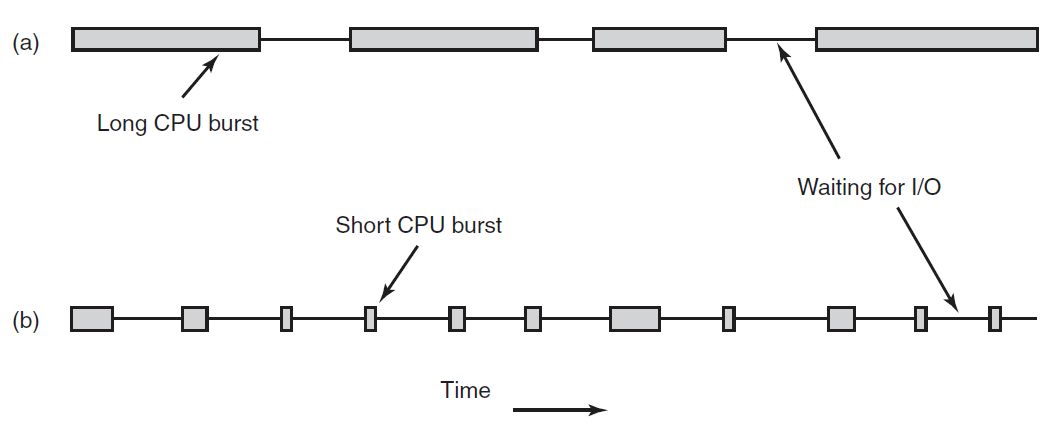

幾乎所有程序都會交替使用(磁碟或網路)I/O請求進行計算,如下圖所示。通常,CPU會執行一段時間而不停止,然後進行系統呼叫以讀取檔案或寫入檔案。當系統呼叫完成時,CPU會再次計算,直到需要更多資料或必須寫入更多資料,依此類推。請注意,一些I/O活動算作計算。例如,當CPU將位複製到視訊RAM以更新螢幕時,它是在計算,而不是執行I/O,因為CPU正在使用中。在這種意義上,I/O是指程序進入阻塞狀態,等待外部裝置完成其工作。

CPU使用的突發與等待I/O的時間交替發生。(a) CPU受限的程序。(b) I/O受限的程序。

關於上圖,需要注意的重要一點是,一些程序,如(a)中的程序,花費了大部分時間進行計算,而其他程序,如(b)所示,花費了大量時間等待I/O。

前者稱為計算受限或CPU受限;後者稱為I/O受限。計算受限的程序通常有較長的CPU突發,因此很少有I/O等待,而I/O受限程序有較短的CPU突發時間,因此頻繁的I/O等待。注意,關鍵因素是CPU突發的長度,而不是I/O突發的長度。I/O受限程序是I/O受限的,因為它們不會在I/O請求之間進行大量計算,而不是因為它們有特別長的I/O請求。發出讀取磁碟塊的硬體請求需要同樣的時間,無論資料到達後處理資料需要多少時間。

值得注意的是,隨著CPU的速度越來越快,程序往往會獲得更多的I/O受限。出現這種效果是因為CPU的改進速度比磁碟快得多。因此,I/O受限程序的排程在未來可能會成為一個更重要的主題。這裡的基本思想是,如果一個I/O受限的程序想要執行,它應該能夠很快獲得機會,以便發出磁碟請求並保持磁碟繁忙。當程序受到I/O限制時,需要相當多的程序來保持CPU的完全佔用。

與程序排程相關的一個關鍵問題是何時做出程序排程策略。事實證明,在各種情況下都需要排程。首先,建立新程序時,需要決定是執行父程序還是子程序。由於這兩個程序都處於就緒狀態,這是一個正常的排程決策,可以選擇任何一種方式,也就是說,排程程式可以合法地選擇下一個執行父程序或子程序。

其次,當程序退出時,必須做出排程決策。該程序無法再執行(因為它不再存在),因此必須從就緒程序集中選擇其他程序。如果沒有程序就緒,則系統提供的空閒程序通常會執行。

第三,當一個程序在I/O、號誌或其他原因上阻塞時,必須選擇另一個程序來執行。有時,阻塞的原因可能會影響選擇。例如,如果A是一個重要的程序,它正在等待B退出其關鍵區域,那麼讓B接下來執行將允許它退出其關鍵區,從而讓A繼續。然而,問題是排程程式通常沒有必要的資訊來考慮這種依賴關係。

第四,當發生I/O中斷時,可以做出排程決策。如果中斷來自現已完成其工作的I/O裝置,則等待I/O的某些程序可能已準備好執行。由排程程式決定是執行新準備好的程序、中斷時正在執行的程序還是第三個程序。

如果硬體時鐘以50或60 Hz或其他頻率提供週期性中斷,則可以在每個時鐘中斷或每個第k個時鐘中斷時做出排程決策。排程演演算法可以根據如何處理時鐘中斷分為兩類。非臨時排程演演算法選擇要執行的程序,然後讓它執行,直到它阻塞(在I/O上或等待另一個程序)或自動釋放CPU。即使它執行了許多小時,也不會被強制暫停。實際上,在時鐘中斷期間不會做出排程決策。時鐘中斷處理完成後,中斷前執行的程序將恢復,除非高優先順序程序正在等待現已滿足的超時。

相比之下,搶佔式排程演演算法選擇一個程序,並讓它最多執行一段固定時間。如果它在時間間隔結束時仍在執行,那麼它將被掛起,並且排程程式會選擇另一個要執行的程序(如果有的話)。執行搶佔式排程需要在時間間隔結束時發生時鐘中斷,以便將CPU控制權交還給排程程式。如果沒有可用的時鐘,則非臨時排程是唯一的選擇。

在不同的環境中,需要不同的排程演演算法。排程程式應該優化的內容在所有系統中並不相同,值得區別的三種環境是:批次、互動、實時。

為了設計排程演演算法,有必要了解好的演演算法應該做什麼。有些目標取決於環境(批次處理、互動式或實時),但有些目標在所有情況下都是可取的。下面列出了一些目標:

- 所有系統:

- 公平性:給每個程序公平的CPU份額。

- 策略執行:確保所述策略得到執行。

- 平衡:使系統的所有部分保持忙碌。

- 批次處理系統:

- 吞吐量:最大化每小時作業數。

- 週轉時間:最小化提交和終止之間的時間。

- CPU利用率:使CPU始終處於繁忙狀態。

- 互動式系統:

- 響應時間:快速響應請求。

- 比例:滿足使用者的期望。

- 實時系統:

- 滿足最後期限:避免丟失資料。

- 可預測性:避免多媒體系統的質量下降。

在任何情況下,公平都很重要。可比程序應獲得可比服務,給一個程序比同等程序多很多CPU時間是不公平的。當然,不同類別的程序可能會有不同的處理方式。與公平相關的是執行系統的策略,如果本地策略是安全控制程序可以在任何時候執行,即使意味著工資單延遲30秒,排程程式也必須確保執行此策略。

另一個總體目標是儘可能使系統的所有部分保持繁忙。如果CPU和所有I/O裝置都可以一直執行,那麼與某些元件處於空閒狀態相比,每秒完成的工作量會更多。例如,在批次處理系統中,排程程式可以控制哪些作業進入記憶體以執行。

在記憶體中同時使用一些CPU受限程序和一些I/O受限程序比首先載入和執行所有CPU受限作業,然後在它們完成時載入和執行全部I/O受限作業要好。如果使用後一種策略,當CPU受限的程序正在執行時,它們將爭奪CPU,磁碟將處於空閒狀態。稍後,當I/O受限作業進入時,它們將爭奪磁碟,CPU將處於空閒狀態。最好通過仔細混合程序來保持整個系統同時執行。

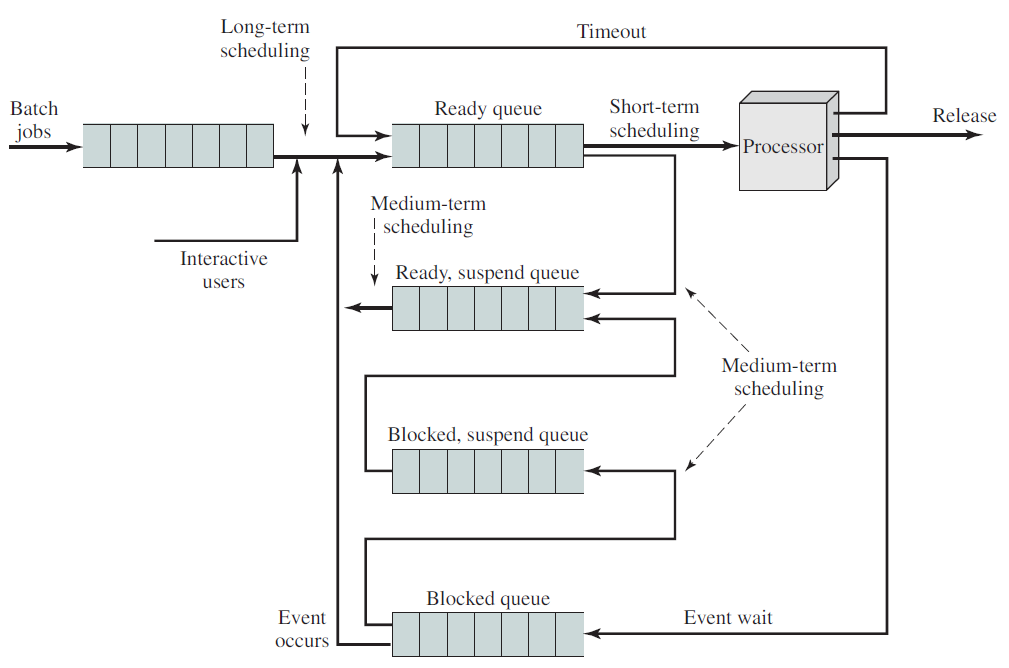

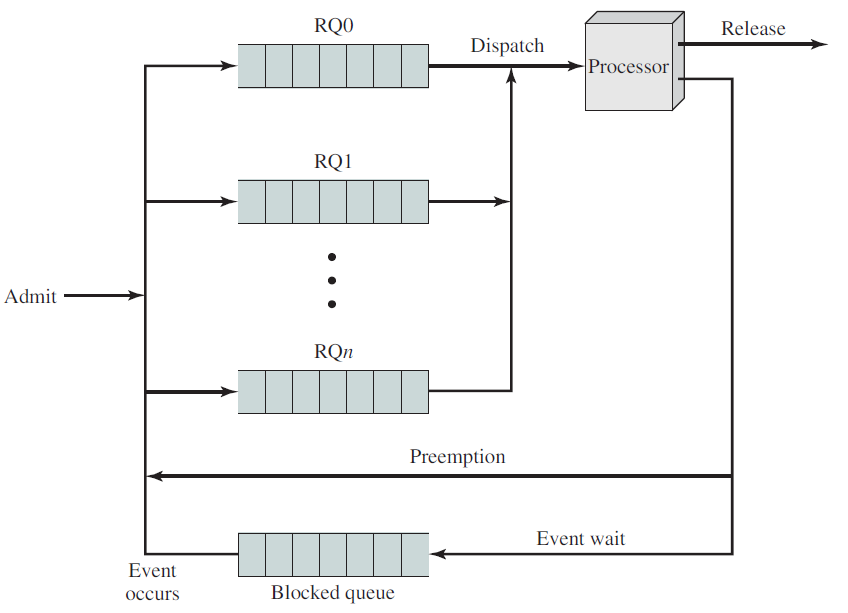

系統在不同排程級別下的狀態轉換圖如下:

排程佇列圖如下:

18.4.5.1 排程基礎

程序排程是作業系統的基本功能。當一臺計算機進行多程式設計時,它有多個程序同時競爭CPU。如果只有一個CPU可用,那麼必須選擇下一個執行哪個程序。這一決策過程稱為排程(scheduling),做出此選擇的作業系統部分稱為排程程式(scheduler),用於進行此選擇的演演算法稱為排程演演算法(scheduling algorithm)。

排程佇列(Scheduling queue)是程序進入系統時被放入的作業佇列,此佇列由系統中的所有行程群組成,駐留在主記憶體中並已準備好等待執行或儲存在名為就緒佇列的列表中的程序。

此佇列通常儲存為連結列表,就緒佇列標題包含指向列表中第一個和最後一個PCB的指標,PCB包含一個指向就緒佇列中下一個PCB的指標欄位。等待特定I/O裝置的程序列表儲存在名為裝置佇列的列表中,每個裝置都有自己的裝置佇列。新程序最初被放入就緒佇列。它在就緒佇列中等待,直到它被選中執行並被賦予CPU。

0.png)

0.png)

18.4.5.2 排程程式

排程程式的描述如下:

- 程序在其生命週期內在各種排程佇列之間遷移。作業系統必須以某種方式從這些佇列中選擇排程程序。此選擇過程由適當的排程程式執行。

- 在批次處理系統中,會提交更多程序,然後立即執行。因此,這些程序被假離線到一個大容量儲存裝置(如磁碟)中,並儲存在那裡供以後執行。

排程程式的型別有以下幾種:

長期排程程式(Long term scheduler)

長期排程程式從磁碟中選擇程序並將其載入到記憶體中以便執行。它控制多重程式設計的程度,即記憶體中程序的數量,執行頻率低於其他排程程式。如果多道程式設計的程度是穩定的,那麼程序建立的平均速度等於程序離開系統的平均離開速度。因此,僅當程序離開系統時才需要呼叫長期排程程式。由於執行之間的間隔較長,它可以花費更多的時間來決定應該選擇哪個程序來執行。

CPU中的大多數程序要麼是I/O密集的,要麼是CPU密集的。I/O密集的程序(互動式「C」程式)是一個將大部分時間花在I/O操作上的程序,而不是花在執行I/O操作上,CPU密集的程序在計算上花費的時間比I/O操作(複雜的排序程式)要多。長期排程程式應選擇I/O繫結和CPU繫結程序的良好組合,這一點很重要。

短期排程程式(Short term scheduler)

短期排程程式在準備執行的程序中進行選擇,並將CPU分配給其中一個程序,這兩個排程程式之間的主要區別是它們的執行頻率。短期排程程式必須經常為CPU選擇新程序,它必須在100毫秒內至少執行一次。由於兩次執行之間的時間間隔很短,因此必須非常快。

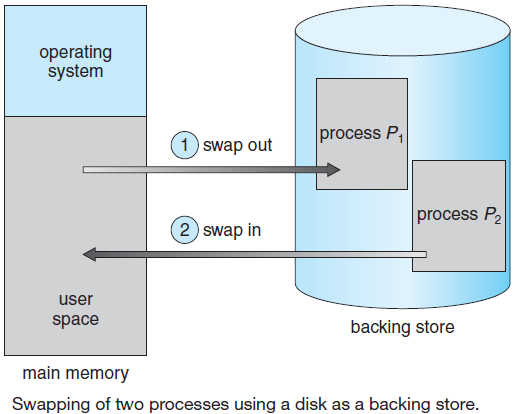

中期排程程式(Medium term scheduler)

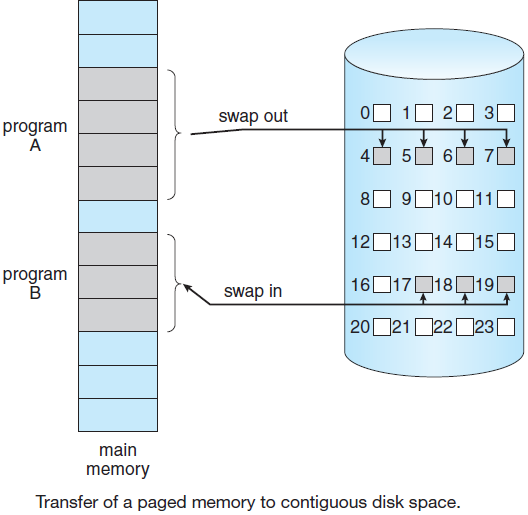

一些作業系統引入了一種稱為中期排程程式的額外中間級別的排程,這個排程器背後的主要思想是,有時從記憶體中刪除程序是有利的,從而降低多道程式的程度。然後,該程序可以重新引入記憶體,並且可以從中斷的地方繼續執行,稱為交換。程序稍後由中期排程程式調出和調入。交換對於改善程序未命中是必要的,或者由於記憶體需求的某些變化,超出了可用記憶體限制,這需要釋放一些記憶體。

18.4.5.3 排程目標

排程的目標有:

- CPU利用率:使CPU儘可能繁忙。

- 吞吐量:每個時間單位完成其執行的程序數。

- 週轉時間:執行特定流程的時間量。

- 等待時間:程序在就緒佇列中等待的時間。

- 響應時間:從提交請求到生成第一個響應(而不是輸出)所用的時間(對於分時環境)。

排程的總體目標:

- 公平。在任何情況下,公平都很重要。排程程式確保每個程序都能獲得其CPU的公平份額,並且沒有程序會無限期延遲。

請注意,給予同等或同等的時間是不公平的。想想核電站的安全控制和工資單。 - 政策執行。排程程式必須確保系統的策略得到執行。例如,如果區域性策略是安全的,那麼安全控制處理必須能夠在任何時候執行,即使意味著工資單處理延遲。

- 效率。如果可能的話,排程程式應該使系統(特別是CPU)在百分之幾的時間內保持繁忙。如果CPU和所有輸入/輸出裝置可以一直執行,那麼與某些元件處於空閒狀態時相比,每秒完成的工作更多。

- 響應時間。排程程式應儘量減少互動式使用者的響應時間。

- 輪迴。排程程式應最小化批次處理使用者必須等待輸出的時間。

- 吞吐量。排程程式應最大化單位時間內處理的作業數。

稍加思考就會發現其中一些目標是相互矛盾的。可以看出,任何支援某類作業的排程演演算法都會損害另一類作業。畢竟,可用的CPU時間是有限的。

就如何處理時鐘中斷而言,排程演演算法可以分為兩類:

-

非搶佔式排程。如果一個程序一旦被賦予CPU,CPU就不能從該程序中取出,那麼排程程式是非搶佔性的。以下是非搶佔式排程的一些特徵:

- 在非搶佔式系統中,短作業由長作業等待,但所有程序的總體處理是公平的。

- 在非搶佔式系統中,響應時間更容易預測,因為傳入的高優先順序作業不能取代等待的作業。

- 在非搶佔式排程中,排程程式在兩種情況下執行作業:1、當程序從執行狀態切換到等待狀態時;2、當程序終止時。

-

搶佔式排程。如果一個程序一旦被給予,CPU就可以被拿走,那麼排程規程是優先的。允許邏輯上可執行的程序暫時掛起的策略稱為搶佔式排程,它與「執行到完成」方法相反。

18.4.5.4 CPU排程演演算法

CPU排程處理決定就緒佇列中的哪些程序將分配給CPU的問題。下面是我們將要研究的一些排程演演算法。

先到先服務(FCFS)

FCFS是最簡單的CPU排程演演算法。首先請求CPU的程序,即首先分配給CPU的程序。可以通過FIFO佇列輕鬆管理,當程序進入就緒佇列時,其PCB連結到佇列的後部。但是,FCFS的平均等待時間很長。考慮以下情況:

| 程序 | CPU時間 |

|---|---|

| P1 | 3 |

| P2 | 4 |

| P3 | 2 |

| P4 | 4 |

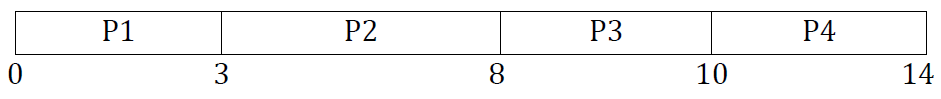

如果順序為P1、P2、P3、P4,則使用FCFS演演算法計算平均等待時間和平均週轉時間。解決方案:如果程序以P1、P2、P3、P4的順序到達,則根據FCFS,甘特圖將為:

不同的時間描述如下:

-

程序等待時間:P1 = 0,P2 = 3,P3 = 8,P4 = 10。

-

程序週轉(Turnaround)時間:P1 = 0 + 3 = 3,P2 = 3 + 5 = 8,P3 = 8 + 2 = 10,P4 = 10 + 4 =14。

-

平均等待時間:(0 + 3 + 8 + 10) / 4 = 21 / 4 = 5.25。

-

平均週轉時間:(3 + 8 + 10 + 14)/4 = 35 / 4 = 8.75。

FCFS演演算法是非搶佔式的,即一旦CPU分配給程序,該程序就會通過終止或請求I/O來保持CPU,直到釋放CPU為止。

最短作業優先(SJF)

此演演算法的另一個名稱是下一個最短程序(SPN),如果CPU可用,此演演算法將與每個程序關聯。這種排程也稱為最短的下一次CPU迸發(burst),因為排程是通過檢查程序的下一個CPU迸發的長度而不是其總長度來完成的。考慮以下情況:

| 程序 | CPU時間 |

|---|---|

| P1 | 3 |

| P2 | 5 |

| P3 | 2 |

| P4 | 4 |

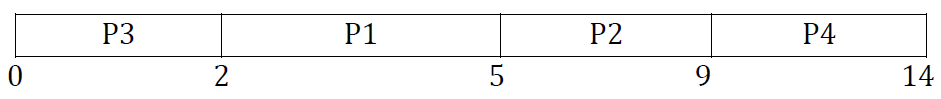

解決方案:根據SJF,甘特圖將是:

不同的時間描述如下:

- 程序等待時間:P1 = 0,P2 = 2,P3 = 5,P4 = 9。

- 程序週轉時間:P3 = 0 + 2 = 2,P1 = 2 + 3 = 5,P4 = 5 + 4 = 9,P2 = 9 + 5 =14。

- 平均等待時間:(0 + 2 + 5 + 9) / 4 = 16 / 4 = 4。

- 平均週轉時間:(2 + 5 + 9 + 14)/4 = 30 / 4 = 7.5。

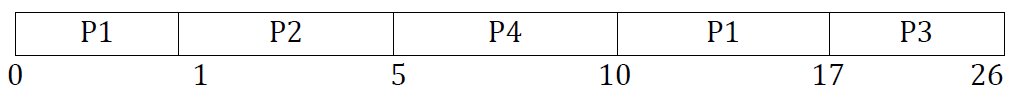

SJF演演算法可以是搶佔式或非搶佔式演演算法,搶佔式的SJF也稱為最短剩餘時間優先。考慮以下範例:

| 程序 | 到達時間 | CPU時間 |

|---|---|---|

| P1 | 0 | 8 |

| P2 | 1 | 4 |

| P3 | 2 | 9 |

| P4 | 3 | 5 |

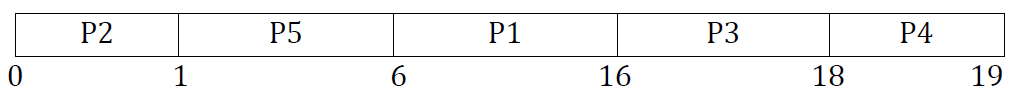

此情況的甘特圖如下:

程序等待時間:P1 = 10 - 1 = 9,P2 = 1 – 1 = 0,P3 = 17 – 2 = 15,P4 = 5 – 3 = 2。

平均等待時間:(9 + 0 + 15 + 2) / 4 = 26 / 4 = 6.5。

優先順序排程

在這個排程中,每個程序都有一個優先順序編號(整數),CPU被分配給優先順序最高的程序(最小的整數,最高的優先順序),可分為搶佔式和非搶佔式。同等優先順序的流程以FCFS方式安排。SJF是一種優先順序排程,其中優先順序是預測的下一個CPU突發時間。

存在飢餓問題——低優先順序程序可能永遠不會執行,解決方案是老化——隨著時間的推移,程序的優先順序增加。

優先順序可以在內部或外部定義。內部優先事項的例子有:時間限制、記憶體要求、檔案要求(如開啟檔案的數量)、CPU與I/O要求。外部定義的優先順序由作業系統外部的標準設定,例如程序的重要性、為使用計算機而支付的資金型別或金額、贊助工作的部門、政策。

優先順序佇列。

考慮以下範例:

| 程序 | 到達時間 | CPU時間 |

|---|---|---|

| P1 | 10 | 3 |

| P2 | 1 | 1 |

| P3 | 2 | 3 |

| P4 | 1 | 4 |

| P5 | 5 | 2 |

根據優先順序排程,甘特圖將為:

程序等待時間:P1 = 6,P2 = 0,P3 = 16,P4 = 18,P5 = 1。

平均等待時間:(0 + 1 + 6 + 16 + 18) / 5 = 41 / 5 = 8.2。

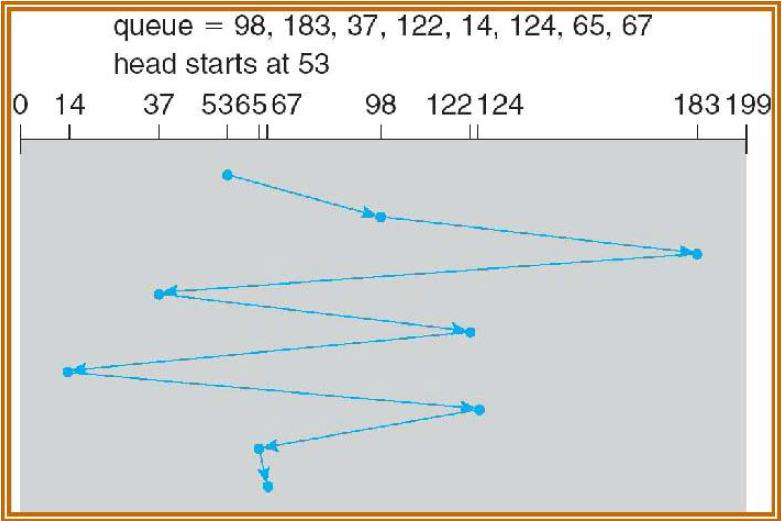

輪詢(Round Robin)

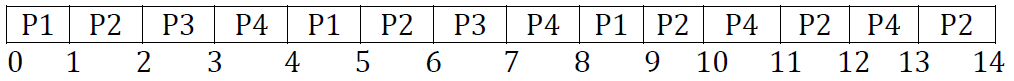

這種演演算法僅用於分時系統設計,類似於具有搶佔條件的FCFS排程,可以在程序之間切換。一個稱為量程時間或時間片的小時間單位用於在程序之間切換,輪詢制下的平均等待時間很長。考慮以下範例:

| 程序 | CPU時間 |

|---|---|

| P1 | 3 |

| P2 | 5 |

| P3 | 2 |

| P4 | 4 |

時間片 = 1ms,則甘特圖為:

程序等待時間:

- P1 = 0 + (4 – 1) + (8 – 5) = 0 + 3 + 3 = 6

- P2 = 1 + (5 – 2) + (9 – 6) + (11 – 10) + (13 – 12) = 1 + 3 + 3 + 1 + 1 = 9

- P3 = 2 + (6 – 3) = 2 + 3 = 5

- P4 = 3 + (7 – 4) + (10 – 8) + (12 – 11) = 3 + 3 + 2 + 1 = 9

平均等待時間:(6 + 9 + 5 + 9) / 4 = 7.2

最短剩餘時間(SRT)

SRT是SJF的搶佔式對等物,在分時環境中很有用。在SRT排程中,下一步執行估計執行時間最短的程序,包括新到達的程序。在SJF方案中,一旦作業開始執行,它就會一直執行到完成,一個正在執行的程序可以被一個估計執行時間最短的新到達程序搶佔。SRT的開銷高於對應的SJF,必須跟蹤執行程序的執行時間,並且必須處理偶爾的搶佔。在這個方案中,小程序的到達幾乎會立即執行,然而,更長的工作意味著更長的等待時間。

最短程序優先(Shortest Process Next)

因為最短的作業首先總是為批次處理系統產生最小的平均響應時間,所以如果它也可以用於互動式流程,那就更好了。在一定程度上是可以的。互動程序通常遵循等待命令、執行命令、等待命令、執行命令等模式。如果我們將每個命令的執行視為單獨的「作業」,那麼我們可以通過先執行最短的一個來最小化總體響應時間,前提是找出當前可執行的程序中最短的程序。

保證排程(Guaranteed Scheduling)

排程的一種完全不同的方法是向用戶作出關於效能的真正承諾,然後兌現這些承諾。一個切實可行且易於實現的承諾是:如果在你工作時有n個使用者登入,你將獲得大約1/n的CPU電量。類似地,在一個執行n個程序的單使用者系統上,在所有條件都相同的情況下,每個程序應該獲得1/n的CPU週期,這似乎很公平。

為了兌現這一承諾,系統必須跟蹤每個程序自建立以來有多少CPU。然後,它計算每個程序有權使用的CPU數量,即自建立以來的時間除以n。由於每個程序實際擁有的CPU時間量也是已知的,因此計算實際消耗的CPU時間與有權使用CPU時間的比率非常簡單。比率為0.5意味著一個程序只擁有它應該擁有的一半,比率為2.0意味著程序擁有的是它應有的兩倍。然後,演演算法以最低比率執行該程序,直到其比率超過其最接近的競爭對手的比率。然後選擇下一個執行。

彩票排程

雖然向用戶作出承諾,然後兌現承諾是一個好主意,但很難實現。然而,可以使用另一種演演算法以更簡單的實現給出類似的可預測結果。這被稱為彩票排程(Lottery Scheduling)。

基本思想是為各種系統資源(如CPU時間)提供程序彩票。每當必須做出排程決策時,都會隨機選擇彩票,持有該彩票的程序將獲得資源。當應用於CPU排程時,系統可能每秒舉行50次抽獎,每個優勝者都會獲得20毫秒的CPU時間作為獎品。

公平排程(Fair-Share Scheduling)

到目前為止,我們假設每個程序都是自己排程的,而不管其所有者是誰。因此,如果使用者1啟動九個程序,而使用者2啟動一個程序,並且具有迴圈或同等優先順序,則使用者1將獲得90%的CPU,使用者2僅獲得10%的CPU。

為了防止這種情況,一些系統在排程程序之前會考慮哪個使用者擁有程序。在這個模型中,每個使用者都被分配了CPU的一部分,排程程式以強制執行的方式選擇程序。因此,如果向兩個使用者承諾每人50%的CPU,那麼無論他們有多少程序,他們都會得到50%的CPU。

舉個例子,考慮一個有兩個使用者的系統,每個使用者承諾佔用50%的CPU。使用者1有四個程序(A、B、C和D),使用者2只有一個程序(E)。如果使用迴圈排程,則滿足所有約束的可能排程式列如下:

A E B E C E D E A E B E C E E D E ...

另一方面,如果使用者1有權獲得使用者2兩倍的CPU時間,我們可能會得到:

A B E C D E A B E C D E ...

當然,還有許多其他的可能性,可以利用,取決於公平的概念是什麼。

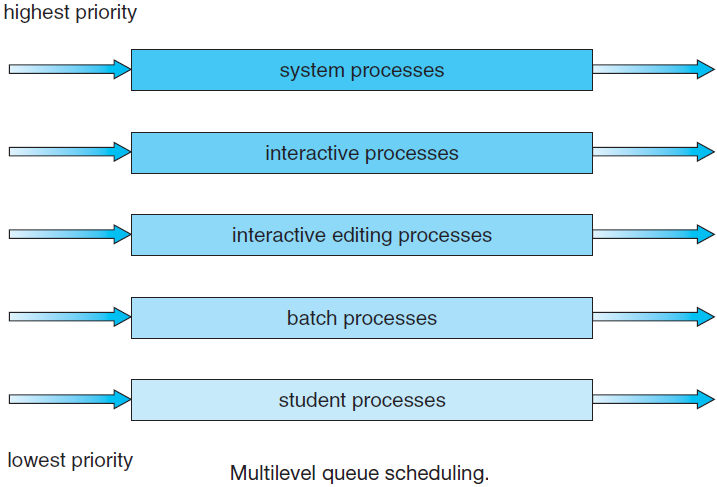

多佇列

多級佇列排程演演算法將就緒佇列劃分為幾個單獨的佇列,例如,在多級佇列排程中,程序被永久分配給一個佇列。根據程序的某些屬性,如記憶體大小、程序優先順序、程序型別,這些程序被永久分配給另一個程序。演演算法從具有最高優先順序的已佔用佇列中選擇程序,然後執行該程序。

多級反饋佇列

多級反饋佇列排程演演算法允許程序在佇列之間移動,使用許多就緒佇列,並將不同的優先順序與每個佇列相關聯。演演算法從佔用的佇列中選擇優先順序最高的程序,並以搶佔或非搶佔方式執行該程序,如果程序使用了太多CPU時間,它將移動到低優先順序佇列。類似地,在較低優先順序佇列中等待時間過長的程序可能會被移動到較高優先順序佇列,也可能被移動到最高優先順序佇列。請注意,這種形式的老化可以防止飢餓。例子:

- 進入就緒佇列的程序被放置在佇列0中。

- 如果未在8毫秒內完成,則會將其移動到佇列1的尾部。

- 如果它沒有完成,它將被搶佔並放入佇列2中。

- 佇列2中的程序僅在佇列0和佇列1為空時,在FCFS基礎上執行,只有當佇列2在FCFS基本佇列上執行。

三個佇列:Q0–RR,時間量為8毫秒;Q1–RR時間量16毫秒;Q2–FCFS。

通常,多級反饋佇列排程程式定義的引數有:佇列數,每個佇列的排程演演算法,用於確定何時將程序升級到更高優先順序佇列的方法,用於確定何時將程序降級到較低優先順序佇列的方法,用於確定程序需要服務時將進入哪個佇列的方法。

18.4.5.5 排程總結

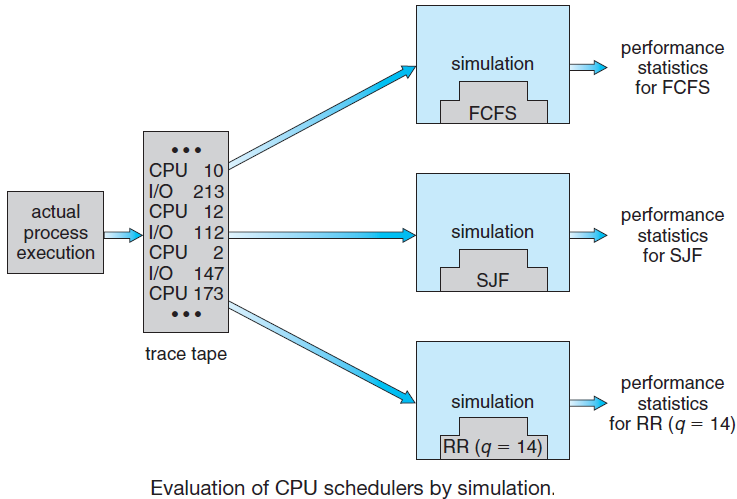

程序排程在實際執行環境中,需要考量CPU、核心數量、IO等因素的影響,然後通過不同的排程演演算法來統計其資料,從而得出相對客觀且有參考價值的排程資料。評估示意圖如下:

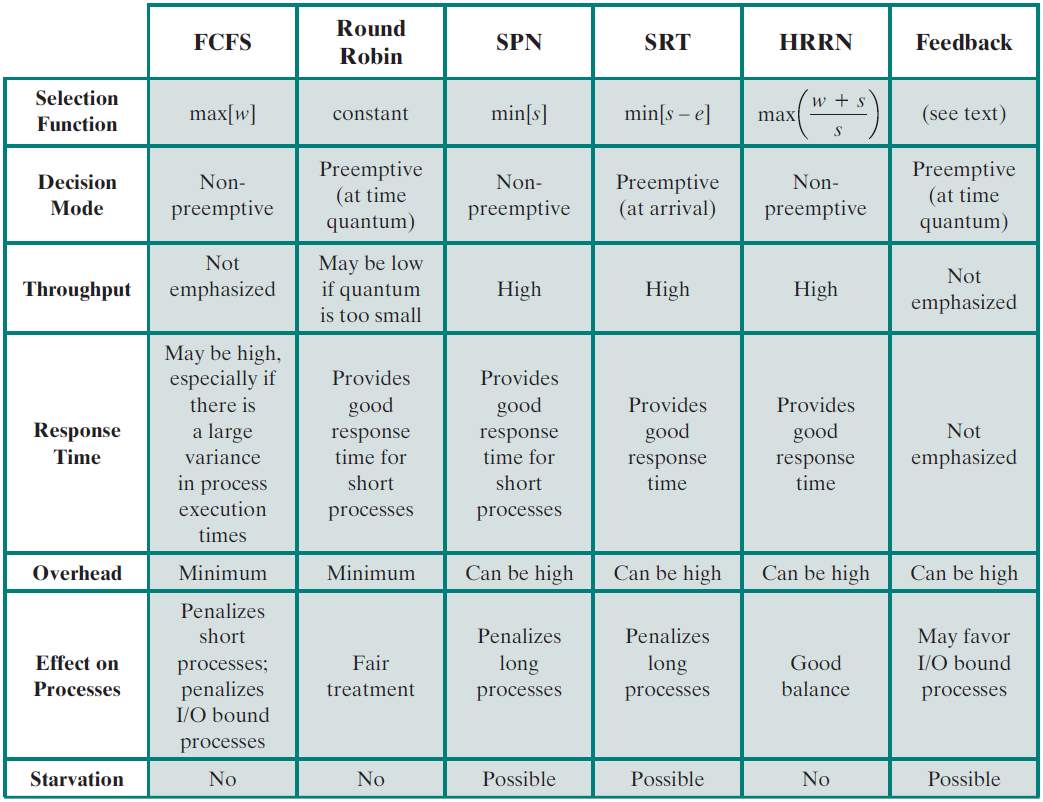

各種排程策略的特點:

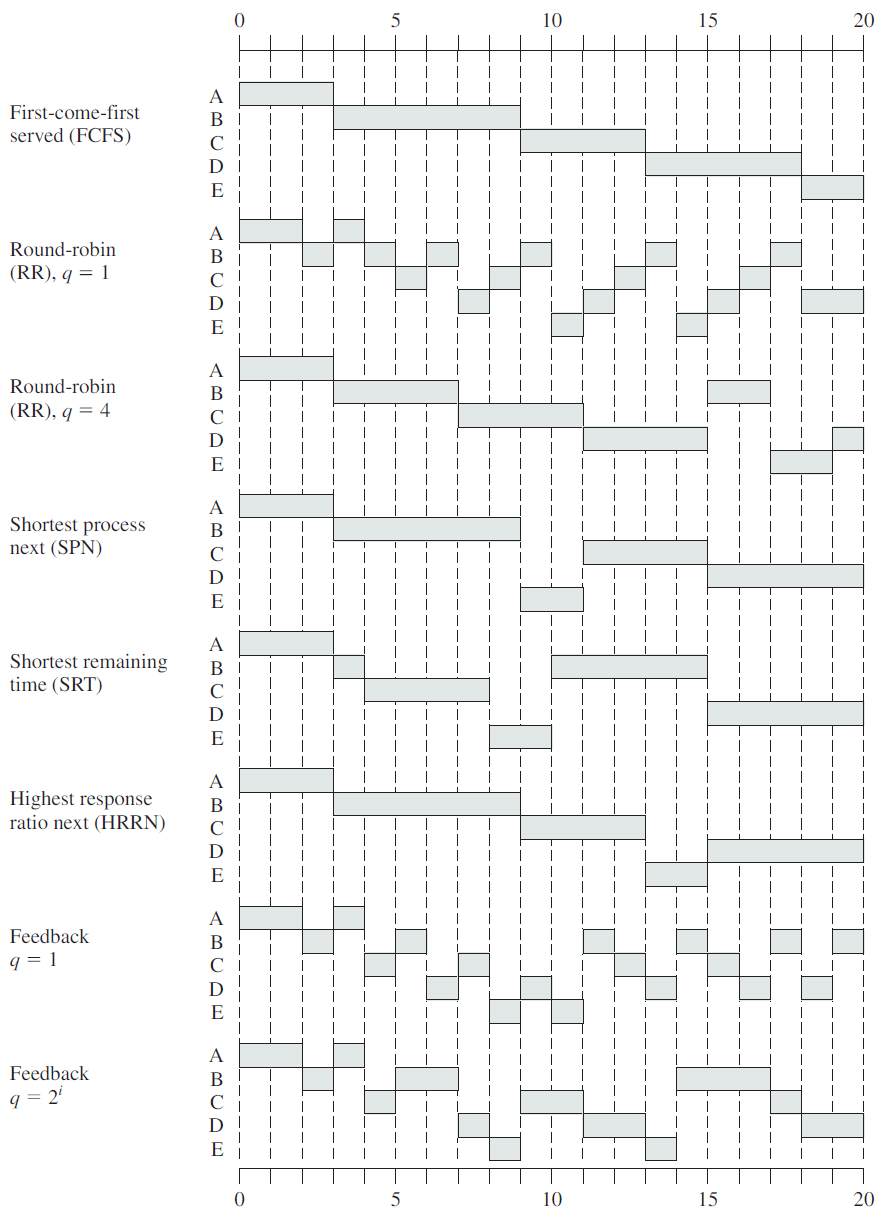

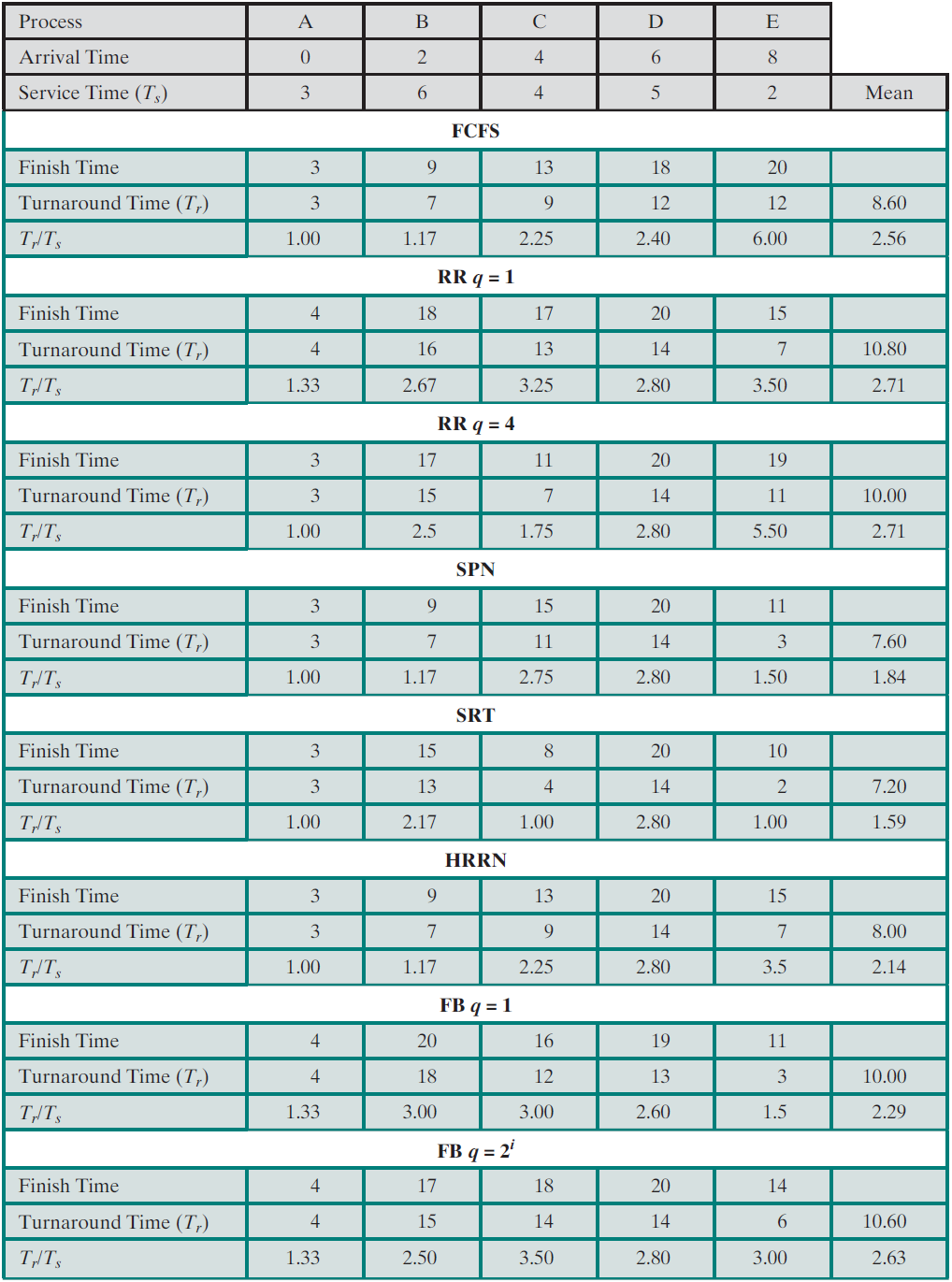

排程策略的時序對比圖:

排程策略的綜合對比:

除了上述出現的排程演演算法,實際上還有很多其它排程策略,如適用於實時作業系統的時限排程(Deadline Scheduling)、比率單調排程(Rate Monotonic Scheduling)等。

另外,還存在優先順序反轉(Priority Inversion),它是一種可能發生在任何基於優先順序的搶佔式排程方案中的現象,但在實時排程環境中尤其相關。優先順序反轉的最著名例子涉及火星探路者(Pathfinder)任務,這個漫遊機器人於1997年7月4日登陸火星,開始收集大量資料並將其傳送回地球。但在任務開始幾天之後,著陸器軟體開始經歷整個系統重置,每次都會導致資料丟失。在建造「探路者」號的噴氣推進實驗室團隊進行了大量努力之後,問題被追溯到優先順序反轉。

在任何優先順序排程方案中,系統應始終以最高優先順序執行任務。當系統內的情況迫使較高優先順序的任務等待較低優先順序的任務時,會發生優先順序反轉。如果較低優先順序的任務鎖定了資源(如裝置或二進位制號誌),而較高優先順序的任務試圖鎖定同一資源,則會發生優先順序反轉的簡單範例。在資源可用之前,優先順序較高的任務將處於阻塞狀態。如果較低優先順序的任務很快完成並釋放資源,則較高優先順序的任務可能會很快恢復,並且可能不會違反實時約束。

一種更嚴重的情況稱為無限優先順序反轉(Unbound Priority Inversion),其中優先順序反轉的持續時間不僅取決於處理共用資源所需的時間,還取決於其他不相關任務的不可預測的操作。Pathfinder軟體中經歷的優先順序反轉是無限的,是個很好的例子。

18.4.6 程序屬性

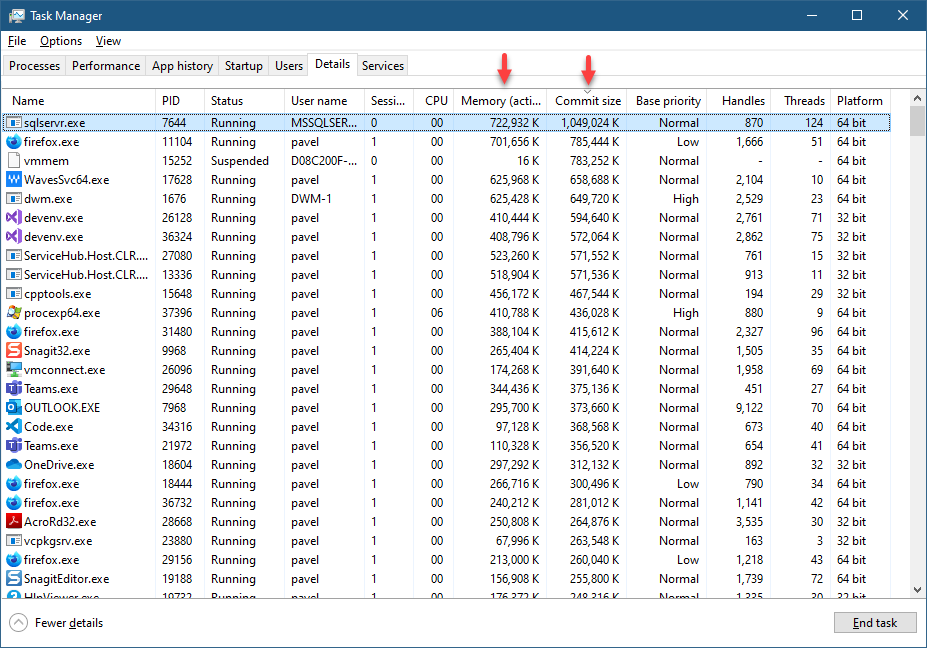

Windows程序的常見屬性在工作管理員中可以檢視,它們的詳情如下所述:

-

名字。通常是程序所基於的可執行檔名,但不是程序的唯一識別符號。有些程序似乎根本沒有可執行名稱,例如包括系統、安全系統、登入檔、記憶體壓縮、系統空閒程序和系統中斷。

- 系統中斷(System Interrupt)實際上不是一個程序,只是用來衡量核心服務硬體中斷和延遲過程呼叫所花費的時間。

- 系統空閒程序也不是真正的程序,它的程序ID(PID)始終為零,只是描述了Windows空閒時間——CPU無事可做時的佔比。

- 系統程序是一個真正的過程,在技術上也是一個最小化程序,總是有一個4的PID。它代表核心空間中發生的一切——核心和核心驅動程式使用的記憶體、開放控制程式碼、執行緒等。

- 安全系統程序僅在Windows 10和Server 2016(及更高版本)系統上可用,這些系統啟動時啟用了基於虛擬化的安全性。它代表了安全核心中發生的一切。

- 登入檔程序是Windows 10版本1803(RS4)中可用的最小化程序,用作管理登入檔的「工作區」,而不是像以前版本那樣使用分頁池。

- 記憶體壓縮排程是Windows 10版本1607上可用的最小化程序,並在其地址空間中儲存壓縮記憶體。記憶體壓縮是Windows 10中新增的一項功能,用於儲存實體記憶體(RAM),特別適用於資源有限的裝置,如手機和物聯網裝置。令人困惑的是,工作管理員沒有顯示此程序,但可被Process Explorer正確顯示。

-

PID。程序的唯一ID,是4的倍數,其中最低有效PID值為4(屬於系統程序)。一旦程序終止,程序ID將被重用,因此可以看到一個新程序。如果程序需要唯一識別符號,則PID和流程啟動時間的組合在特定系統上確實是唯一的。

-

狀態(Status)。狀態可以有三個值之一:執行(Running)、掛起(Suspended)和不響應(Not Responding),根據程序型別總結了它們的含義。

程序型別 執行時的情況 掛起的情況 不響應的情況 GUI程序(非UWP) GUI執行緒可響應時 程序中的所有執行緒都掛起 GUI執行緒至少5秒未檢查訊息佇列 CUI程序(非UWP) 至少有一個執行緒未掛起 程序中的所有執行緒都掛起 用不 UWP程序 在後臺 在後臺 GUI執行緒至少5秒未檢查訊息佇列 常見的狀態轉換如下圖所示:

-

使用者名稱。使用者名稱指示程序正在哪個使用者下執行。令牌物件附加到程序(稱為主令牌),該程序基於使用者儲存程序的安全上下文。該安全上下文包含使用者所屬的組、許可權等資訊。程序可以在特定的內建使用者下執行,例如本地系統(在工作管理員中顯示為系統)、網路服務和本地服務。這些使用者帳戶通常用於執行服務。

-

對談ID。程序在其下執行對談的對談號,對談0用於系統程序和服務,對談1及以上用於互動式登入。

-

CPU。顯示該程序的CPU消耗百分比,注意它僅顯示整數。要獲得更好的精度,請使用Process Explorer。

-

記憶體。與記憶體相關的列有些棘手,工作管理員顯示的預設列是記憶體(活動專用工作集)或記憶體(專用工作集,早期版本)。術語工作集是指RAM(物理記憶體),私有工作集是程序使用的RAM,不與其他程序共用。共用記憶體最常見的例子是DLL程式碼。活動專用工作集與專用工作集相同,但對於當前掛起的UWP程序設定為零。以上兩個計數器是否能很好地指示程序使用的記憶體量?不幸的是,不是。這些指示使用的是專用RAM,但是當前被調出的記憶體呢?還有另一列——提交大小(Commit Size),用於瞭解程序記憶體使用情況的最佳列。工作管理員預設情況下不顯示此列。

-

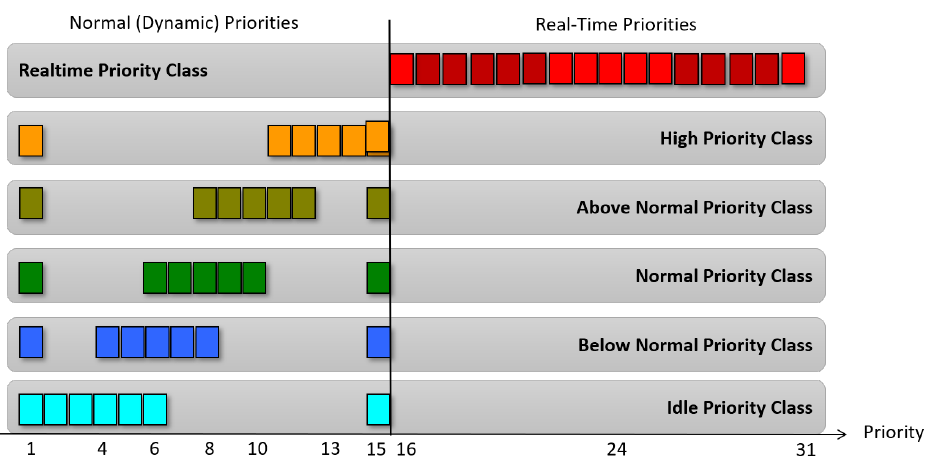

基本優先順序。基本優先順序列(正式稱為優先順序類)顯示了六個值中的一個,為該程序中執行的執行緒提供基本排程優先順序。與優先順序相關聯的可能值如下:

- 低(Idle)= 4

- 低於正常 = 6

- 正常(Normal) = 8。最常見(預設)的優先順序類別是正常(8)。

- 高於正常 = 10

- 高(High) = 13

- 實時(Real-Time) = 24

-

控制程式碼。顯示在特定程序中開啟的核心物件的控制程式碼數量。

-

執行緒。「執行緒」列顯示每個程序中的執行緒數量。通常至少應該是一個,因為沒有執行緒的程序是無用的。但是,一些程序顯示為沒有執行緒。具體來說,安全系統顯示為沒有執行緒,因為安全核心實際上使用普通核心進行排程。系統中斷偽程序根本不是程序,因此不能有任何執行緒。最後,系統空閒程序也不擁有執行緒。此程序顯示的執行緒數是系統上的邏輯處理器數。

程序更詳細的屬性表如下:

在虛擬記憶體的使用者程序:

18.4.7 程序操作

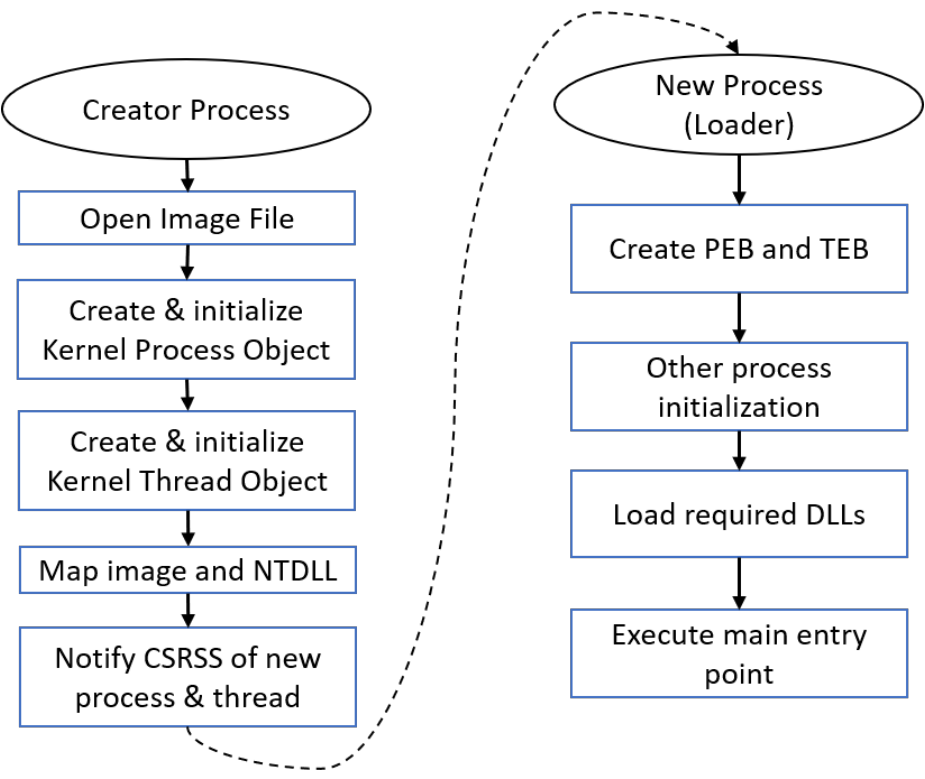

程序建立中涉及的主要部分如下圖所示。

1、Open Image File

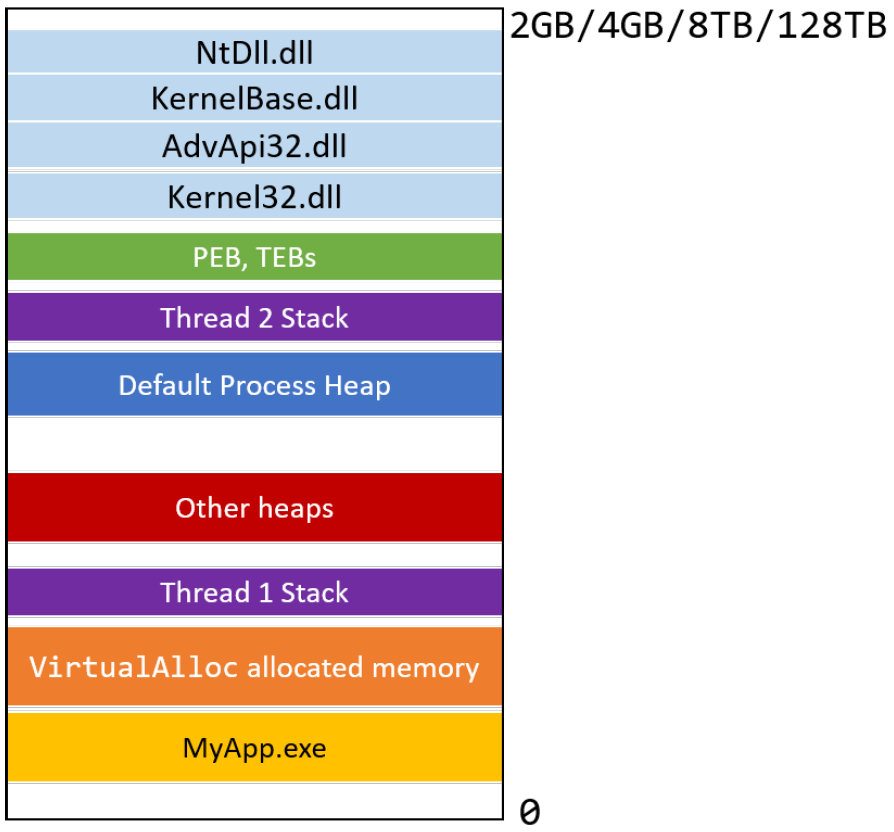

核心開啟映象(可執行檔案)檔案,並驗證其是否為可移植可執行檔案(PE)的正確格式。副檔名並不重要,實際內容才重要。假設各種標頭檔案有效,核心將建立一個新的程序核心物件和一個執行緒核心物件,因為一個正常程序是由一個執行緒建立的,最終應該執行主入口點。

2、Create & Initialize Kernel Process Object

此時,核心將映像對映到新程序的地址空間以及NtDll.Dll。NtDll對映到每個程序(最小和微程序除外),因為它在程序建立的最後階段具有非常重要的職責,並且是呼叫系統呼叫的最終階段。建立程序仍在執行的最後一個主要步驟是通知Windows子系統程序(Csrss.exe)已建立新程序和執行緒。(Csrss可以被認為是核心管理Windows子系統程序某些方面的助手)。

3、Create & Initialize Kernel Thread Object

此時,從核心的角度來看,程序已經成功建立,因此呼叫方呼叫的程序建立函數(通常是CreateProcess)返回成功。然而,新程序尚未準備好執行其初始程式碼。程序初始化的第二部分必須在新程序的上下文中由新建立的執行緒執行。

一些開發人員認為,在新流程中執行的第一件事是可執行檔案的主要功能。然而,在實際的主函數開始執行之前,還有很多事情要做,最明顯的是NtDll,因為目前程序中沒有其他作業系統級程式碼。此時,NtDll有幾個職責:

- 首先,它為程序建立使用者模式管理物件,稱為程序環境塊(PEB),併為第一個執行緒建立使用者模式控制物件,稱之為執行緒環境塊(TEB)。這些結構部分記錄(在<winternl.h>中),正式不應由開發人員直接使用。也就是說,在某些情況下,此結構是有用的,特別是在試圖實現難以實現的事情時。

- 然後執行其他一些初始化,包括建立預設程序堆、建立和初始化預設程序執行緒池等。

- 入口點開始執行之前的最後一個主要部分是載入所需的DLL,通常稱為載入器。載入程式檢視可執行檔案的匯入部分,其中包括可執行檔案所依賴的所有庫。這些通常包括Windows子系統dll,如kernel32.dll、user32.dll,gdi32.dll和advapi32.dll。

實際上,開發人員可以編寫四個主要函數,每個函數都有相應的C/C++執行時函數。下表總結了這些名稱及其使用時間。

| 開發人員的main | C/C++執行時起點 | 場景 |

|---|---|---|

| main | mainCRTStartup | 使用ASCII字元的控制檯應用程式 |

| wmain | wmainCRTStartup | 使用Unicode字元的控制檯應用程式 |

| WinMain | WinMainCRTStartup | 使用ASCII字元的GUI應用程式 |

| wWinMain | wWinMainCRTStartup | 使用Unicode字元的GUI應用程式 |

大多數程序將在系統關閉之前的某個時間點終止,有幾種方法可以退出或終止程序。需要記住的一點是,無論程序如何終止,核心都會確保程序沒有私有的內容:釋放所有私有(非共用)記憶體,並關閉程序控制程式碼表中的所有控制程式碼。如果滿足以下任一條件,則過程終止:

1、程序中的所有執行緒退出或終止。

2、程序中的任何執行緒呼叫了ExitProcess。

3、使用TerminateProcess終止程序(通常在外部,但可能是由於未處理的異常)。

編寫Windows應用程式的開發者通常會在某個時刻發現執行主函數的執行緒是「特殊的」,通常稱為主執行緒。可以觀察到,無論何時主函數返回,程序都會退出——似乎是上述流程退出原因中未列出的場景。然而,它確實如此,實際是上述的情形2。C/C++執行時庫呼叫main/WinMain,然後執行所需的清理,如呼叫全域性C++解構函式、C執行時清理等,最後呼叫ExitProcess,導致程序退出。

從核心的角度來看,程序中的所有執行緒都是相等的,並且沒有主執行緒。當核心中的所有執行緒退出/終止時,核心會銷燬程序,因為沒有執行緒的程序幾乎是無用的。實際上,這種情況只能在原生程序(僅依賴於NtDll.dll且沒有C/C++執行時的可執行檔案)中實現。換句話說,在正常的Windows程式設計中不太可能發生。

18.4.8 程序補述

18.4.8.1 多程式設計建模

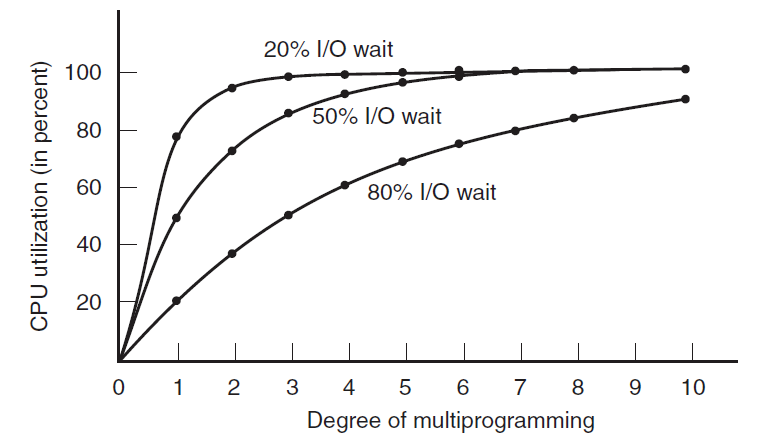

當使用多道程式設計時,CPU利用率可以提高。粗略地說,如果平均程序只計算了它在記憶體中的20%的時間,那麼當五個程序同時在記憶體中時,CPU應該一直處於繁忙狀態。然而,這個模型是不切實際的樂觀,因為它預設所有五個程序永遠不會同時等待I/O。

一個更好的模型是從概率的角度來看CPU的使用情況。假設一個程序花了一小部分時間等待I/O完成,當記憶體中同時有\(n\)個程序時,所有\(n\)個程序等待I/O的概率為\(p^n\)(在這種情況下,CPU將處於空閒狀態)。CPU利用率由以下公式給出:

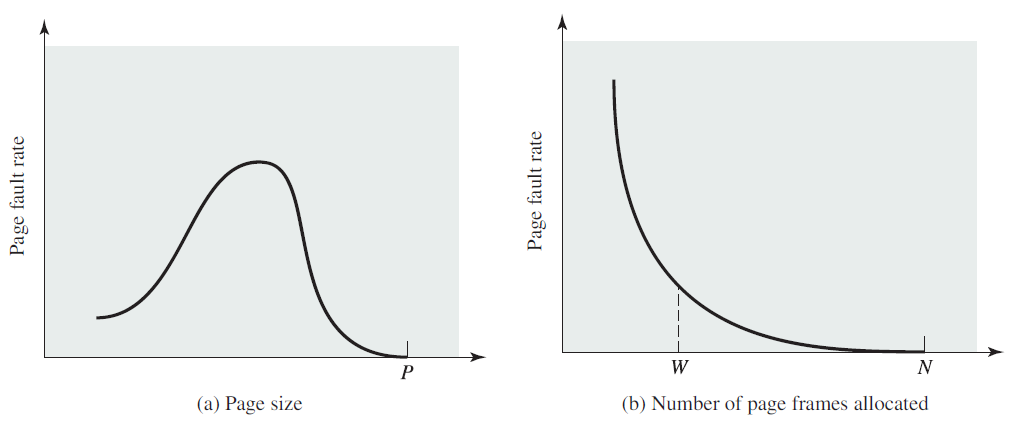

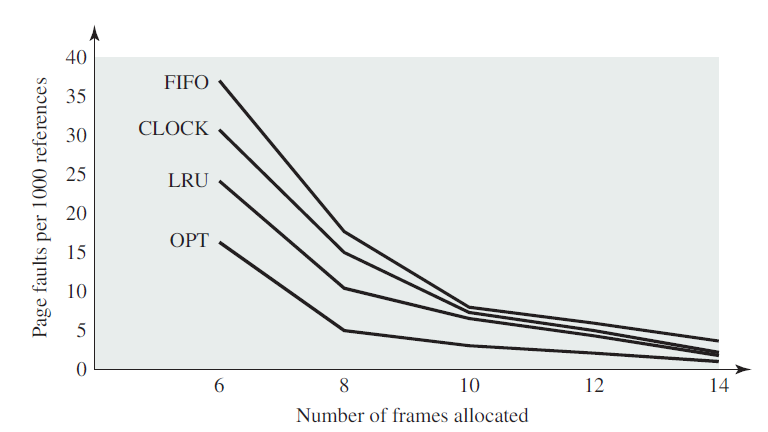

下圖顯示了CPU利用率作為\(n\)的函數——稱為多道程式設計的程度。

CPU利用率是記憶體中程序數的函數。

從圖中可以明顯看出,如果程序花費80%的時間等待I/O,那麼必須同時在記憶體中至少有10個程序才能使CPU浪費低於10%。當你意識到等待使用者在終端鍵入內容(或單擊圖示)的互動式程序處於I/O等待狀態時,應該很清楚,80%以上的I/O等待時間並不罕見。但即使在伺服器上,執行大量磁碟I/O的程序通常也會有這個百分比或更多。

為了準確起見,應該指出,剛才描述的概率模型只是一個近似值。它隱式假設所有n個程序都是獨立的,意味著記憶體中有5個程序的系統可以有三個執行,兩個等待。但是,對於單個CPU,我們不能同時執行三個程序,因此在CPU繁忙時準備就緒的程序將不得不等待,因此,這些程序不是獨立的。使用排隊論可以構建更精確的模型,但我們所做的多道程式設計讓程序在CPU空閒時使用它,當然,即使上圖中的真實曲線與圖中所示的曲線略有不同,它仍然有效。

儘管上圖中的模型思想簡單,但它仍然可以用於對CPU效能進行具體的、儘管是近似的預測。例如,假設一臺計算機有8GB記憶體,作業系統及其表佔2GB,每個使用者程式也佔2GB。這些大小允許三個使用者程式同時在記憶體中,平均I/O等待時間為80%時,CPU利用率(忽略作業系統開銷)為\(1− 0.8^3\)或約49%。再增加8GB記憶體,系統就可以從三路多道程式設計過渡到七路多道程式設計,從而將CPU利用率提高到79%。換句話說,額外的8GB將提高30%的吞吐量。

再增加8GB只會將CPU利用率從79%提高到91%,因此吞吐量只會再提高12%。使用這個模型,計算機的所有者可能會認為第一次增加記憶體是一項不錯的投資,但第二次不是。

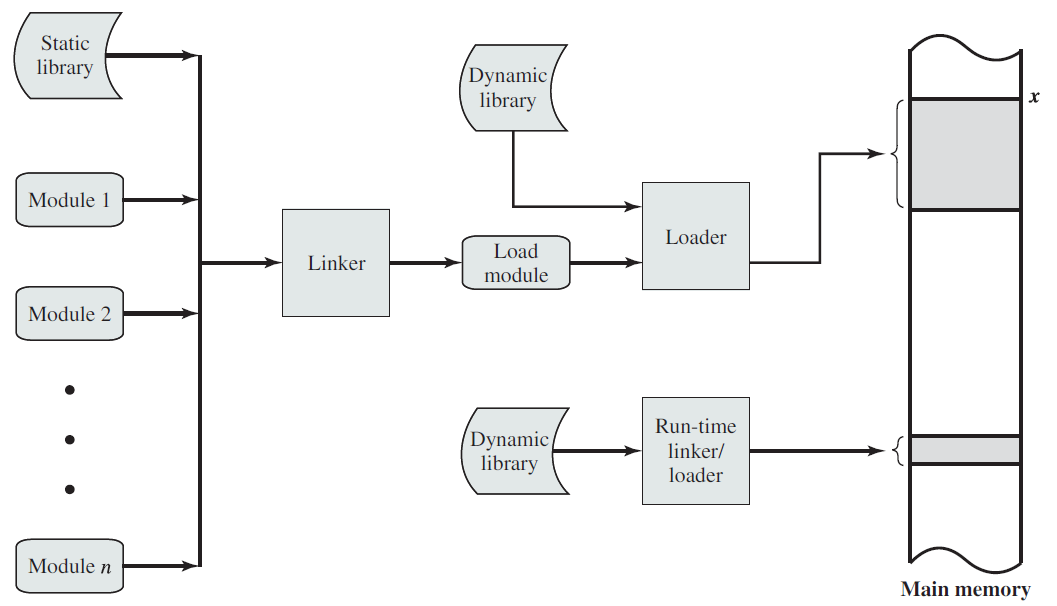

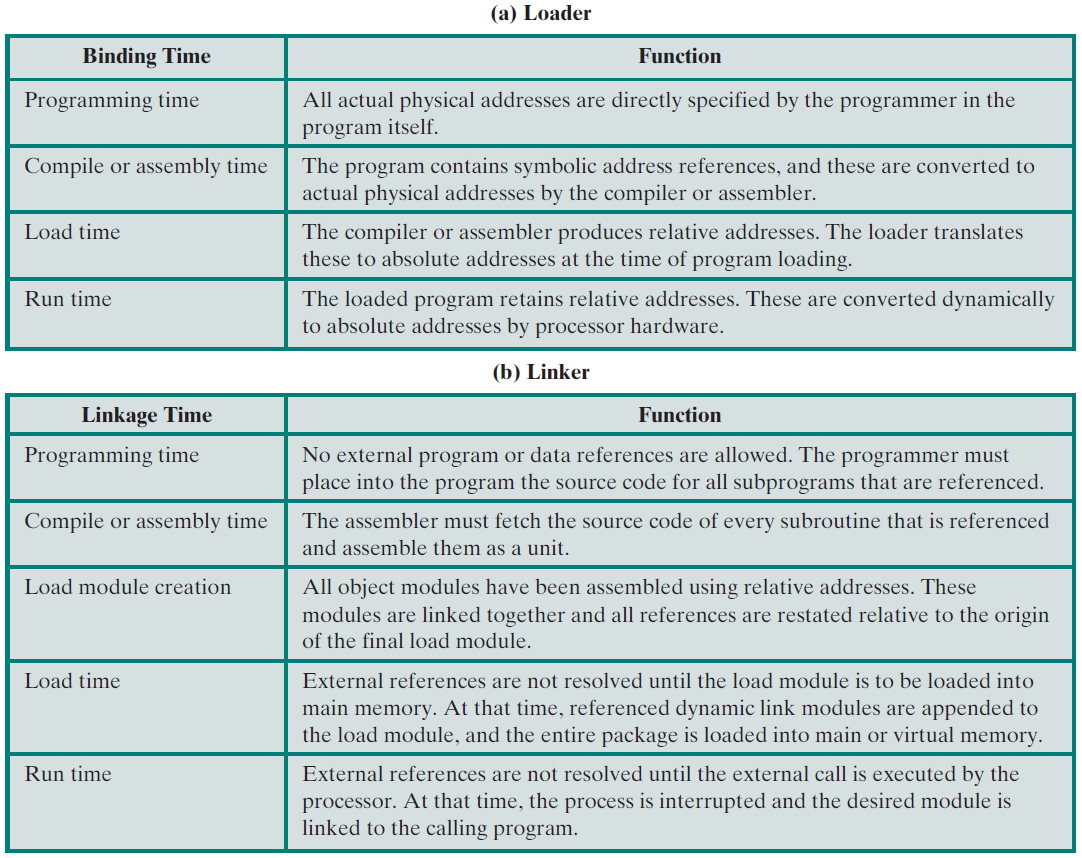

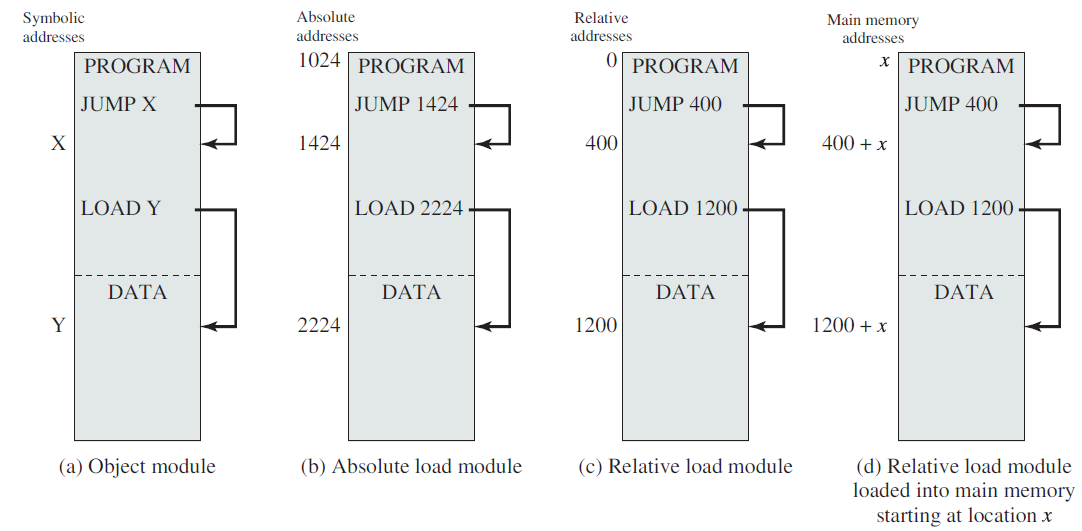

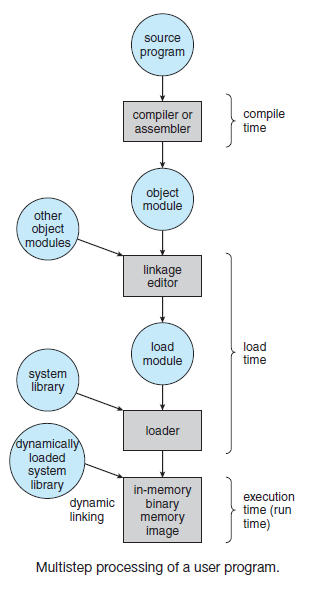

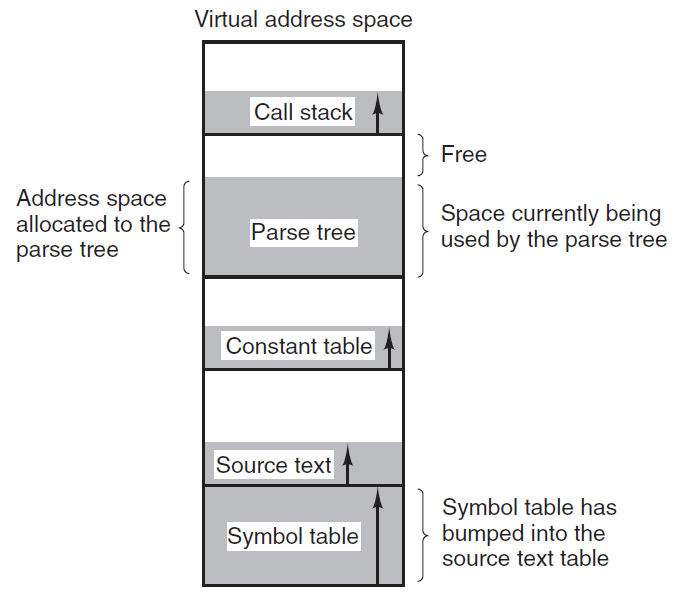

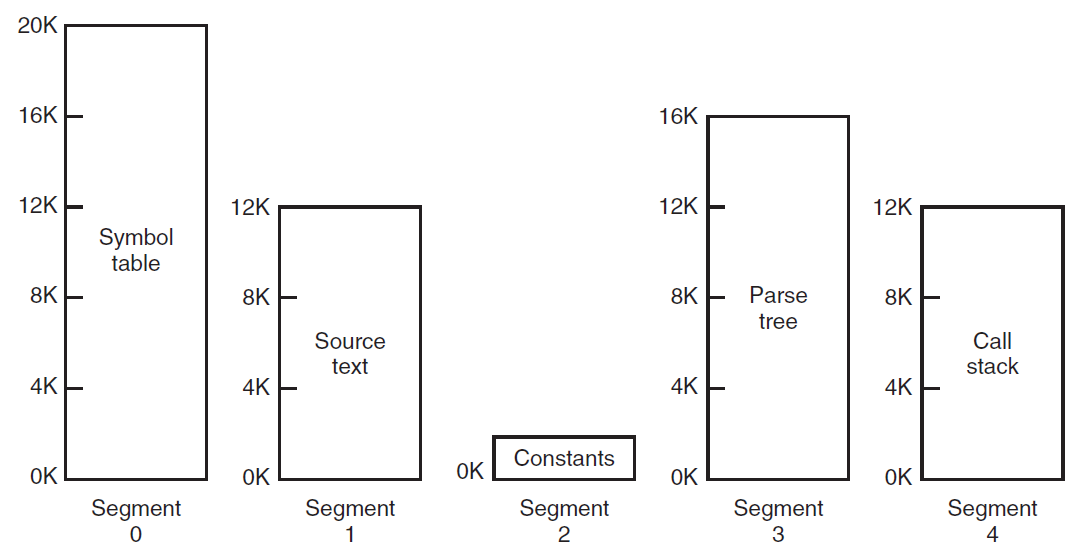

18.4.8.2 載入和連結

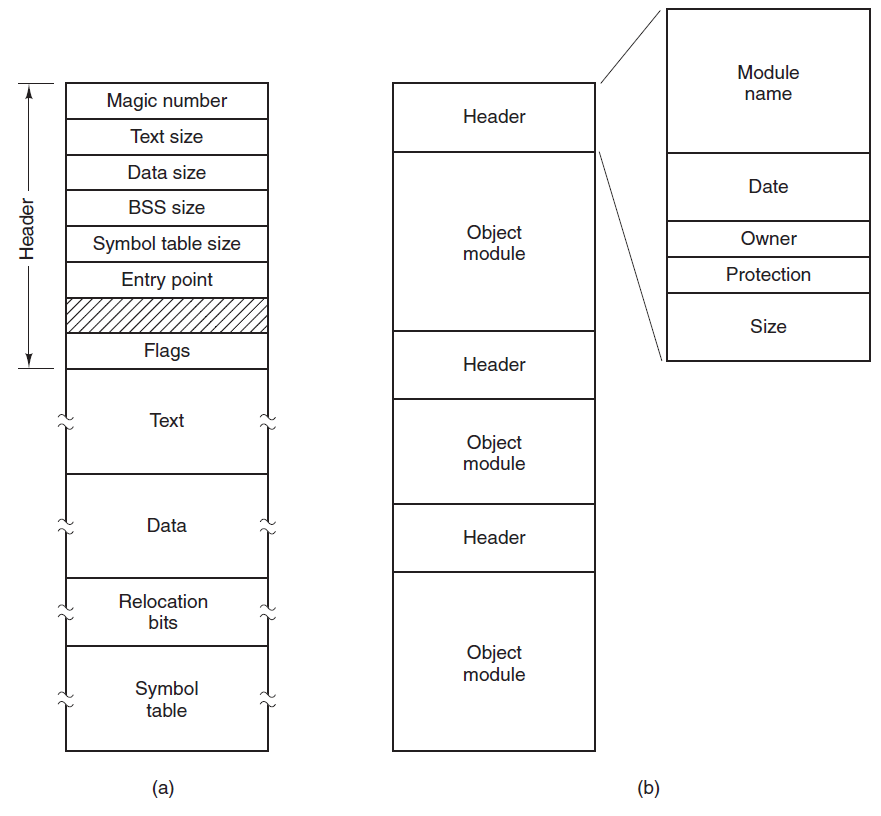

建立活動程序的第一步是將程式載入到主記憶體中並建立程序映像(下圖),下下圖描述了大多數系統的典型場景。應用程式由多個編譯或組裝的目的碼形式的模組組成,這些模組被連結以解析模組之間的任何參照,同時,解析對庫例程的參照。庫例程本身可以合併到程式中或作為共用程式碼參照,這些程式碼必須在執行時由作業系統提供。

載入函數。

一個載入和連結的場景。

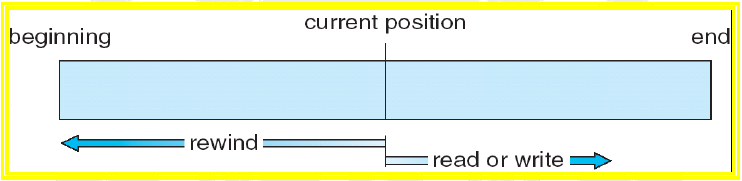

- 載入

在上圖中,載入器從位置開始將載入模組放置在主記憶體儲器中。在載入程式時,必須滿足定址要求。一般來說,可以採取三種方法:

1、絕對載入。

絕對載入絕對載入程式要求將給定的載入模組始終載入到主記憶體中的同一位置。因此,在呈現給載入器的載入模組中,所有地址參照都必須指向特定的或絕對的主記憶體地址。例如,如果上圖中的x是位置1024,那麼載入模組中指定給該記憶體區域的第一個字具有地址1024。

將特定地址值分配給程式內的記憶體參照可以由程式設計師完成,也可以在編譯或組合時完成。前一種方法有幾個缺點,首先,每個程式設計師都必須知道將模組放入主記憶體的預期分配策略,其次,如果對程式進行了任何修改,涉及到模組主體中的插入或刪除,那麼所有地址都必須更改。因此,最好允許程式中的記憶體參照以符號方式表示,然後在編譯或組合時解析這些符號參照,如下圖所示,對指令或資料項的每個參照最初都用符號表示,在準備模組輸入到絕對載入器時,組合程式或編譯器將把所有這些參照轉換為特定地址(在本例中,對於從1024位元置開始載入的模組),如下下圖b所示。

2、可重定位載入。

可重定位載入在載入之前將記憶體參照系結到特定地址的缺點是,生成的載入模組只能放在主記憶體的一個區域中。然而,當許多程式共用主記憶體時,可能不希望提前決定將特定模組載入到記憶體的哪個區域。最好在載入時做出該決定,因此,我們需要一個可以位於主記憶體中任何位置的載入模組。

為了滿足這個新的要求,組合程式或編譯器生成的不是實際的主記憶體儲器地址(絕對地址),而是與某個已知點(例如程式的開始)相關的地址。這種技術如下圖c所示。載入模組的開頭被分配了相對地址0,並且模組內的所有其他記憶體參照都是相對於模組的開始來表示的。

由於所有記憶體參照都以相對格式表示,所以載入器將模組放置在所需的位置就成為一項簡單的任務。如果要從位置開始載入模組,則載入程式必須在將模組載入到記憶體中時簡單地新增到每個記憶體參照中。為了協助該任務,載入模組必須包含告訴載入器地址參照在哪裡以及如何解釋地址參照的資訊(通常相對於程式源,但也可能相對於程式中的其他點,例如當前位置)。這組資訊由編譯器或組合程式準備,通常稱為重定位字典(relocation dictionary)。

3、動態執行時載入。

重定位載入比較常見,相對於絕對載入,它具有明顯的優勢。然而,在多道程式設計環境中,即使是不依賴虛擬記憶體的環境,可重定位的載入方案依然不夠。需要在主記憶體中交換程序映像,以最大限度地提高處理器的利用率。為了最大限度地提高主記憶體利用率,我們希望能夠在不同的時間將程序映像交換回不同的位置。因此,一個程式一旦載入,就可以交換到磁碟上,然後在不同的位置重新交換。如果在初始載入時將記憶體參照系結到絕對地址,是不可能的。

另一種方法是推遲絕對地址的計算,直到在執行時實際需要它。為此,載入模組被載入到主記憶體中,所有記憶體參照都以相對形式(上圖c)。直到實際執行了一條指令,才計算出絕對地址。為了確保此功能不會降低效能,必須通過特殊的程式或硬體而不是軟體來完成。

動態地址計算提供了完全的靈活性。程式可以載入到主記憶體儲器的任何區域,隨後,程式的執行可以被中斷,程式可以從主記憶體儲器中調出,稍後再調回另一個位置。

- 連結

連結器的功能是將一組目標模組作為輸入,並生成一個載入模組,該載入模組由一組整合的程式和資料模組組成,並傳遞給載入器。在每個物件模組中,可能存在對其他模組中位置的地址參照。每個這樣的參照只能在未連結的物件模組中用符號表示。連結器建立一個載入模組,它是所有物件模組的連續連線。每個模組內參照必須從符號地址更改為對整個載入模組內某個位置的參照。例如,圖7中的模組A包含模組B的過程呼叫。當這些模組在載入模組中組合時,對模組B的符號參照將更改為對載入模組中B入口點位置的特定參照。

連結編輯器此地址連結的性質將取決於要建立的載入模組的型別以及連結髮生的時間(上表b)。通常情況下,如果需要可重新定位的負載模組,則通常按以下方式進行連線。每個編譯或組裝的物件模組都是用相對於物件模組開頭的參照建立的,所有這些模組都被放在一個單獨的可重定位載入模組中,其中包含相對於載入模組原點的所有參照,該模組可以用作可重定位載入或動態執行時載入的輸入。

產生可重定位載入模組的連結器通常被稱為連結編輯器。下圖顯示了連結編輯器功能。

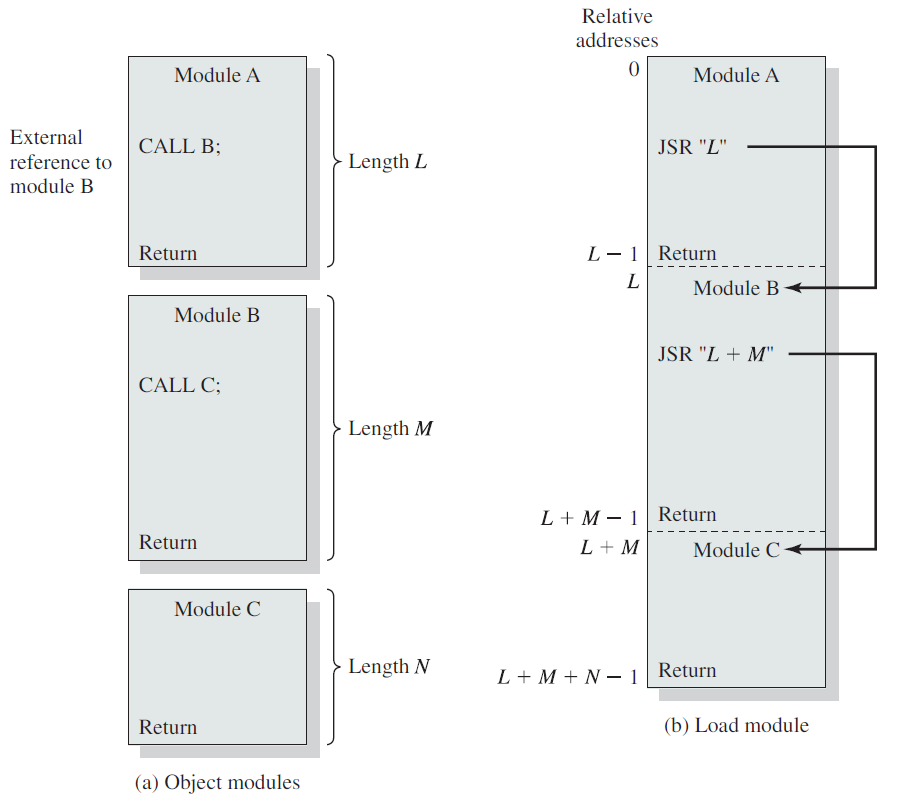

與載入一樣,可以延遲某些連結功能。術語動態連結用於指將某些外部模組的連結延遲到載入模組建立之後的做法,因此載入模組包含對其他程式的未解析參照,這些參照可以在載入時或執行時解析。

對於載入時動態連結,需要執行以下步驟。將要載入的載入模組(應用程式模組)讀入記憶體,對外部模組(目標模組)的任何參照都會導致載入器找到目標模組,載入它,並從應用程式模組的開頭將參照更改為記憶體中的相對地址。與所謂的靜態連結相比,動態連結有幾個優點:

1、合併目標模組的更改或升級版本變得更容易,目標模組可以是作業系統實用程式或其他通用例程。對於靜態連結,對這種支援模組的更改將需要重新連結整個應用程式模組,這不僅效率低下,而且在某些情況下可能是不可能的。例如,在個人計算機領域,大多數商業軟體都是以載入模組的形式釋出的:原始碼和物件版本不釋出。

2、在動態連結檔案中包含目的碼為自動程式碼共用鋪平了道路。作業系統可以識別多個應用程式正在使用相同的目的碼,因為它載入並連結了該程式碼。它可以使用該資訊載入目的碼的單個副本並將其連結到兩個應用程式,而不必為每個應用程式載入一個副本。

3、獨立軟體開發人員更容易擴充套件廣泛使用的作業系統(如Linux)的功能。開發人員可以提出一個對各種應用程式有用的新函數,並將其打包為動態連結模組。

對於執行時動態連結,一些連結被推遲到執行時。目標模組的外部參照保留在載入的程式中。當呼叫不存在的模組時,作業系統定位該模組,載入該模組,並將其連結到呼叫模組。這些模組通常是可共用的,在Windows環境中,這些稱為動態連結庫(DLL)。因此,如果一個程序已經在使用動態連結的共用模組,則該模組位於主記憶體中,新程序可以簡單地連結到已載入的模組。

如果兩個或多個程序共用一個DLL模組,但期望該模組的不同版本,則使用DLL可能會導致通常稱為DLL地獄(DLL hell)的問題。例如,可能會重新安裝應用程式或系統功能,並將較舊版本的DLL檔案帶入其中。

我們已經看到,動態載入允許整個載入模組到處移動,但是,模組的結構是靜態的,在整個程序的執行過程中以及從一個執行到下一個執行都保持不變。但是,在某些情況下,無法在執行之前確定需要哪些物件模組,例如事務處理應用程式(如航空公司預訂系統或銀行應用程式),事務的性質決定了需要哪些程式模組,它們被適當地載入並與主程式連結。使用這種動態連結器的優點是,除非參照了程式單元,否則不必為程式單元分配記憶體。此功能用於支援分段系統。

一個額外的細化是可行的:應用程式不需要知道可能被呼叫的所有模組或入口點的名稱。例如,可以編寫繪圖程式以與各種繪圖儀配合使用,每個繪圖儀都由不同的驅動程式包驅動。應用程式可以從另一個程序或在組態檔中查詢當前安裝在系統上的繪圖儀的名稱,這允許應用程式的使用者安裝在編寫應用程式時不存在的新繪圖儀。

18.5 執行緒

執行緒是通過程序程式碼的執行流,有自己的程式計數器、系統暫存器和堆疊,是通過並行提高應用程式效能的一種流行方法。執行緒有時稱為輕量級程序,代表了一種通過減少超執行緒來提高作業系統效能的軟體方法,相當於一個經典的程序。每個執行緒只屬於一個程序,程序外不能存在任何執行緒,每個執行緒代表一個單獨的控制流。

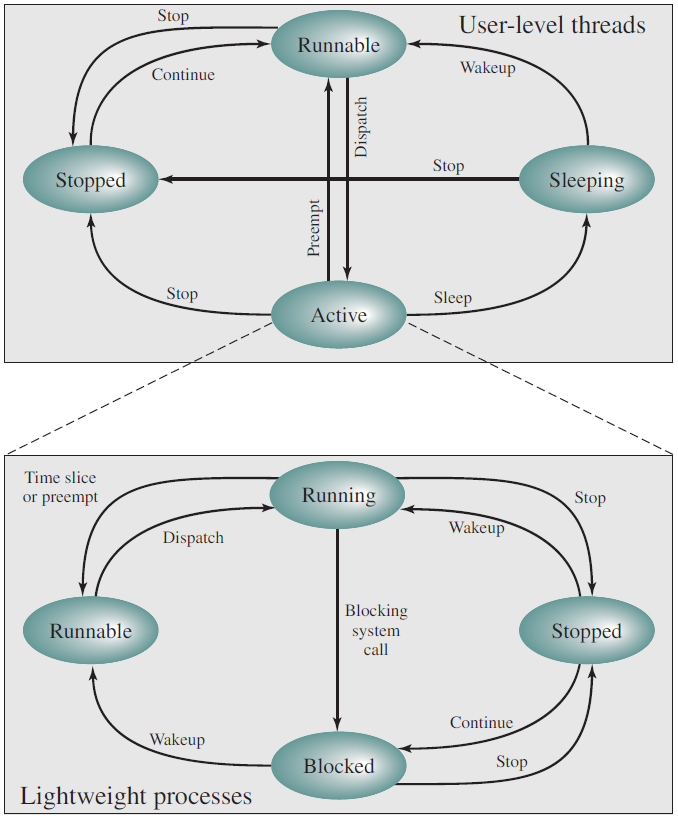

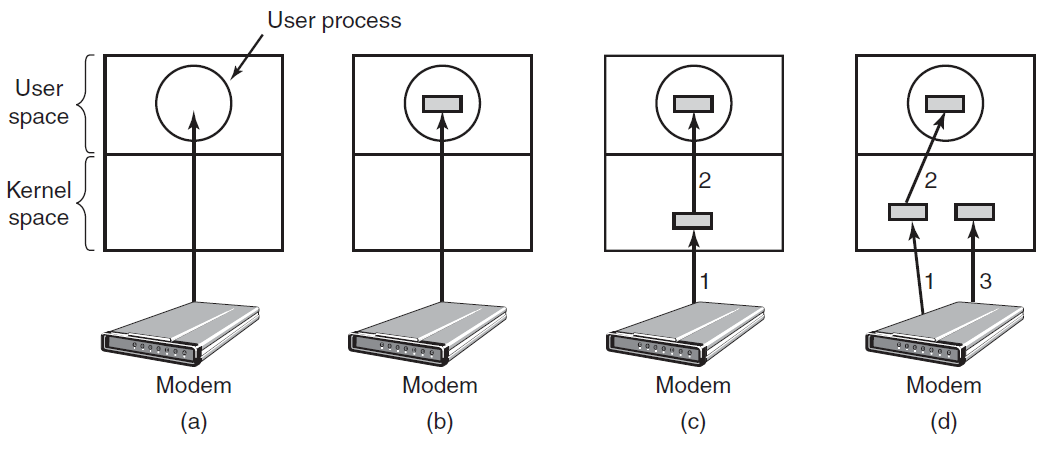

一些作業系統提供了使用者級執行緒和核心級執行緒的組合功能,Solaris就是這種組合方法的一個很好的例子。在組合系統中,同一應用程式中的多個執行緒可以在多個處理器上並行執行,阻塞系統呼叫不需要阻塞整個程序。

18.5.1 執行緒和程序

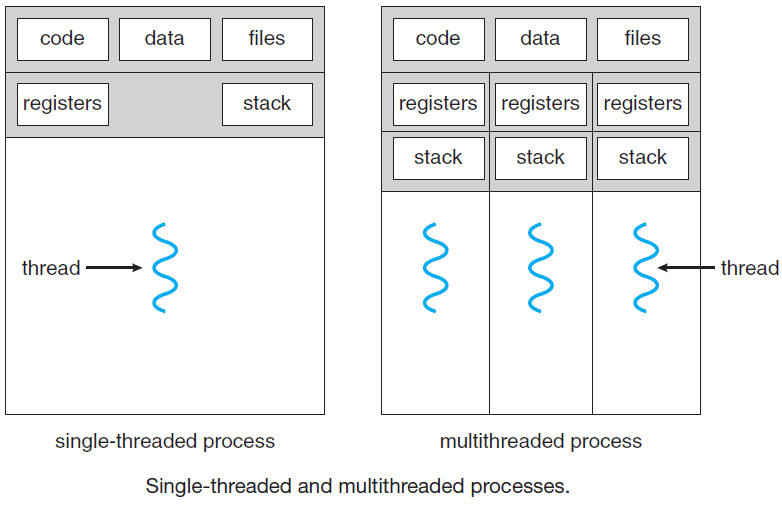

在下圖(a)中,我們看到了三個傳統程序,每個程序都有自己的地址空間和單個控制執行緒。相反,在下圖(b)中,我們看到一個具有三個控制執行緒的單個程序。儘管在這兩種情況下,我們都有三個執行緒,但在下圖(a)中,每個執行緒都在不同的地址空間中執行,而在下圖(b)中,三個執行緒共用相同的地址空間。當多執行緒程序在單個CPU系統上執行時,執行緒輪流執行。通過在多個程序之間來回切換,系統提供了並行執行的獨立順序程序的錯覺。多執行緒的工作方式相同,CPU線上程之間快速來回切換,提供了執行緒並行執行的假象,儘管在比實際CPU慢的CPU上執行。在一個程序中有三個計算繫結執行緒,這些執行緒看起來是並行執行的,每個執行緒在一個CPU上的速度是實際CPU的三分之一。

(a) 三個程序,每個程序有一個執行緒。(b) 一個程序有三個執行緒。

程序中的不同執行緒不像不同程序那樣獨立。所有執行緒都有完全相同的地址空間,意味著它們也共用相同的全域性變數。由於每個執行緒都可以存取程序地址空間內的每個記憶體地址,因此一個執行緒可以讀取、寫入甚至清除另一個執行緒的堆疊。執行緒之間沒有保護,原因有二:其一,這是不可能的;其二,不應該有保護。不同的程序可能來自不同的使用者,並且可能相互競爭,不同的是,一個程序總是由一個使用者擁有,該使用者可能建立了多個執行緒,以便他們能夠合作,而不是競爭。除了共用地址空間外,所有執行緒還可以共用同一組開啟的檔案、子程序、警報和訊號等,如下表所示。因此,當三個程序基本無關時,將使用上圖(a)的組織,然而,當三個執行緒實際上是同一工作的一部分並且相互積極密切合作時,上圖(b)是合適的。

| 逐程序資料項 | 逐執行緒資料項 |

|---|---|

| 地址空間 全域性變數 開啟檔案 子程序 待定報警 訊號和訊號處理 賬號資訊 |

程式計數器 暫存器 堆疊 狀態 |

第一列中的專案是程序屬性,而不是執行緒屬性。例如,如果一個執行緒開啟了一個檔案,則該檔案對程序中的其他執行緒可見,並且它們可以讀取和寫入該檔案。這是合乎邏輯的,因為程序是資源管理的單元,而不是執行緒。如果每個執行緒都有自己的地址空間、開啟的檔案、掛起的警報等,那麼它將是一個單獨的程序。我們試圖通過執行緒概念實現的是多個執行執行緒共用一組資源的能力,以便它們能夠緊密共同作業來執行某些任務。

Windows程序和執行緒對比圖。

與傳統程序(即只有一個執行緒的程序)一樣,執行緒可以處於以下幾種狀態之一:執行、阻塞、就緒或終止。正在執行的執行緒當前具有CPU並且處於活動狀態。相反,阻塞的執行緒正在等待某個事件解除阻塞。例如,當執行緒執行從鍵盤讀取的系統呼叫時,它會被阻塞,直到輸入被鍵入為止。執行緒可以阻止等待某個外部事件發生或其他執行緒解除阻止。就緒執行緒計劃執行,並在輪到它時立即執行,執行緒狀態之間的轉換與程序狀態之間的過渡相同。

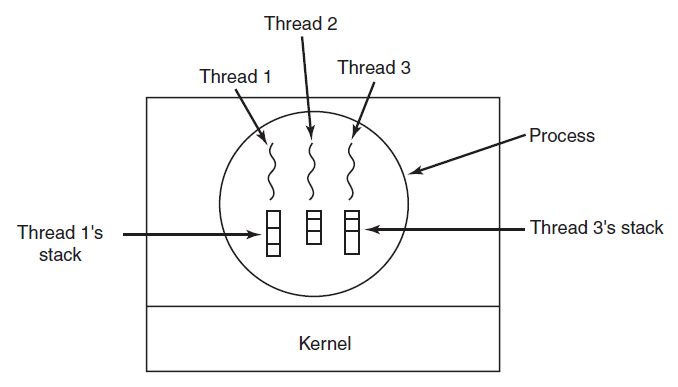

重要的是要認識到每個執行緒都有自己的堆疊,如下圖所示。每個執行緒的堆疊包含一個幀,用於每個呼叫但尚未返回的過程。此幀(frame)包含過程的區域性變數和過程呼叫完成時要使用的返回地址。例如,如果過程X呼叫過程Y,而Y呼叫過程Z,那麼在執行Z時,X、Y和Z的幀都將位於堆疊上。每個執行緒通常會呼叫不同的過程,因此具有不同的執行歷史。這就是為什麼每個執行緒都需要自己的堆疊。

每個執行緒都有自己的堆疊。

當存在多執行緒時,程序通常以單個執行緒開始。此執行緒能夠通過呼叫庫過程(如執行緒建立)來建立新執行緒。執行緒建立的引數指定要執行新執行緒的過程的名稱。沒有必要(甚至不可能)指定任何關於新執行緒地址空間的內容,因為它會自動在建立執行緒的地址空間中執行。有時執行緒是分層的,具有父子關係,但通常不存在這種關係,所有執行緒都是相等的。無論是否具有層次關係,建立執行緒通常都會返回一個執行緒識別符號,用於命名新執行緒。

當一個執行緒完成它的工作時,它可以通過呼叫庫過程來退出,比如執行緒退出。然後它會消失,不再可排程。在某些執行緒系統中,一個執行緒可以通過呼叫過程等待(特定)執行緒退出,例如執行緒聯接。此過程將阻塞呼叫執行緒,直到(特定)執行緒退出。在這方面,執行緒建立和終止與程序建立和終止非常相似,也有大致相同的選項。

另一個常見的執行緒呼叫是執行緒放棄(thread yield),它允許一個執行緒自願放棄CPU時間片,讓另一個執行緒執行。這種機制很重要,因為沒有時鐘中斷來實際執行多道程式,就像程序一樣。因此,執行緒要有禮貌,並不時主動放棄CPU,以給其他執行緒一個執行的機會。其他呼叫允許一個執行緒等待另一個執行緒完成一些工作,等待一個執行緒宣佈它已經完成了一些工作,依此類推。

雖然執行緒通常很有用,但它們也給程式設計模型帶來了許多複雜性。首先,考慮UNIX fork系統呼叫的效果。如果父程序有多個執行緒,那麼子程序是否也應該有它們?如果沒有,程序可能無法正常執行,因為所有這些可能都是必需的。

但是,如果子程序獲得的執行緒數與父程序相同,那麼如果父程序中的執行緒在讀呼叫(例如從鍵盤進行的讀呼叫)中被阻塞,會發生什麼情況?現在鍵盤上有兩個執行緒被阻塞了嗎?一個在父執行緒,一個在子執行緒?當一行被鍵入時,兩個執行緒都會得到它的副本嗎?只有父母?只有孩子?開啟的網路連線也存在同樣的問題。

另一類問題與執行緒共用許多資料結構有關。如果一個執行緒關閉一個檔案,而另一個執行緒仍在讀取該檔案,會發生什麼情況?假設一個執行緒注意到記憶體太少,並開始分配更多記憶體。中途,執行緒切換髮生,新執行緒還注意到記憶體太少,並開始分配更多記憶體,結果記憶體可能會分配兩次。這些問題可以通過一些努力來解決,但要使多執行緒程式正確工作,需要仔細考慮和設計。

18.5.2 多執行緒模型

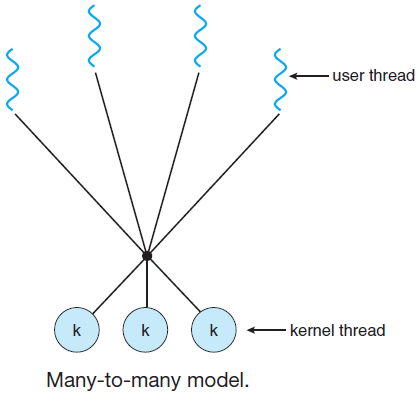

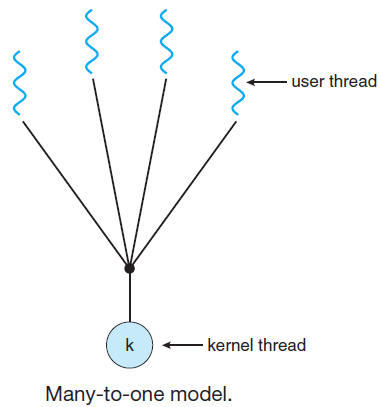

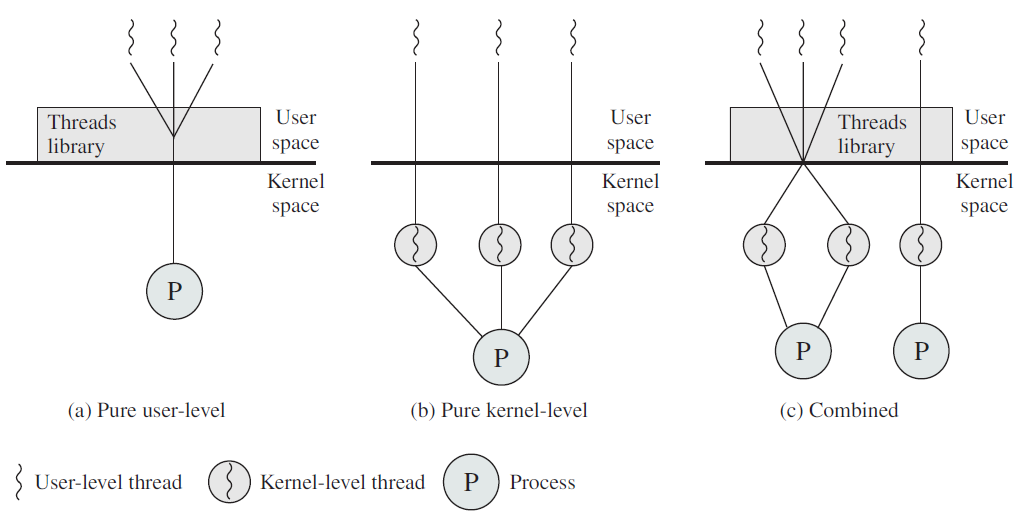

多執行緒模型有三種型別:

-

多對多關係。在這個模型中,許多使用者級執行緒多路複用到數量較小或相等的核心執行緒,核心執行緒的數量可能特定於特定的應用程式或特定的計算機。在這個模型中,開發人員可以根據需要建立任意多個使用者執行緒,相應的核心執行緒可以在多處理器上並行執行。

-

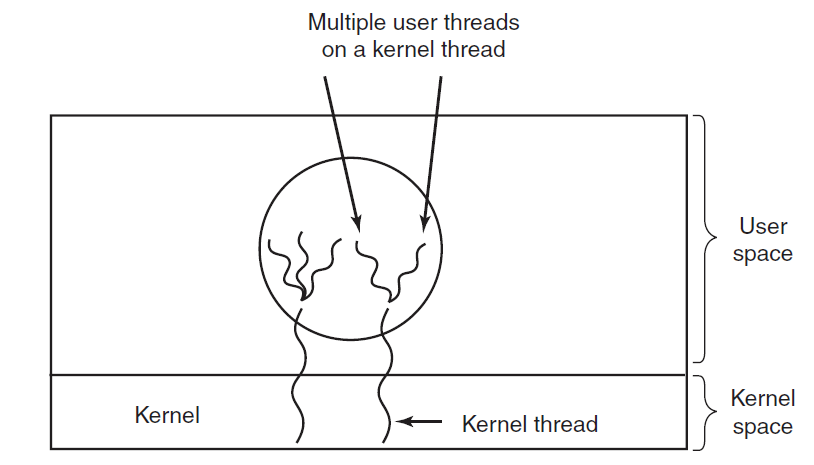

多對一關係。多對一模型將多個使用者級執行緒對映到一個核心級執行緒,執行緒管理是在使用者空間中完成的。當執行緒進行阻塞系統呼叫時,整個程序將被阻塞。一次只有一個執行緒可以存取核心,因此多個執行緒無法在多處理器上並行執行。如果使用者級執行緒庫是在作業系統中實現的,則該系統不支援核心執行緒使用多對一關係模式。

-

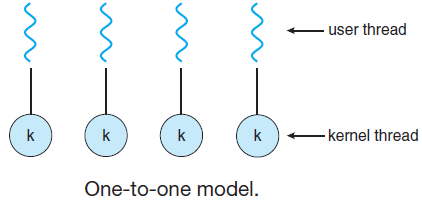

一對一關係。使用者級執行緒與核心級執行緒之間存在一對一的關係,此模型比多對一模型提供更多並行性。當一個執行緒進行阻塞的系統呼叫時,它允許另一個執行緒執行,支援在微處理器上並行執行多個執行緒。

此模型的缺點是建立使用者執行緒需要相應的核心執行緒。OS/2、Windows NT和Windows 2000使用一對一關係模型。

18.5.3 多執行緒優點

多執行緒程式設計的好處可以分為四大類:

- 響應性。多執行緒互動應用程式可以允許程式繼續執行,即使部分程式被阻止或正在執行較長的操作,從而提高對使用者的響應能力。這種質量在設計使用者介面時特別有用。例如,考慮一下當用戶單擊一個導致執行耗時操作的按鈕時會發生什麼。在操作完成之前,單執行緒應用程式將對使用者無響應。相反,如果耗時的操作是在單獨的執行緒中執行的,那麼應用程式將保持對使用者的響應。

- 資源共用。程序只能通過共用記憶體和訊息傳遞等技術共用資源,這些技術必須由程式設計師明確排程,但預設情況下,執行緒共用其所屬程序的記憶體和資源。共用程式碼和資料的好處是,它允許應用程式在同一地址空間內具有多個不同的活動執行緒。

- 經濟。為程序建立分配記憶體和資源成本高昂。因為執行緒共用它們所屬程序的資源,所以建立和上下文切換執行緒更經濟。從經驗上衡量開銷的差異可能很困難,但一般來說,建立和管理程序比執行緒要花費更多的時間。例如,在Solaris中,建立程序比建立執行緒慢大約三十倍,上下文切換大約慢五倍。

- 可延伸性。在多處理器體系結構中,多執行緒的好處甚至更大,其中執行緒可以在不同的處理核心上並行執行。無論有多少可用處理器,單執行緒程序只能在一個處理器上執行。

總之,執行緒的優點/優點是最小化上下文切換時間,提供了程序內的並行性,高效溝通,建立和上下文切換執行緒更經濟。利用多處理器體系結構–多執行緒的好處可以在多處理器體系架構中大大增加。

18.5.4 使用者和核心執行緒

執行緒可分為使用者級執行緒和核心級執行緒。

在使用者執行緒中,執行緒管理的所有工作都由應用程式完成,核心不知道執行緒的存在。執行緒庫包含用於建立和銷燬執行緒、線上程之間傳遞訊息和資料、排程執行緒執行以及儲存和恢復執行緒上下文的程式碼。應用程式從單個執行緒開始,並開始在該執行緒中執行,使用者級執行緒的建立和管理通常很快。

使用者級執行緒相對於核心級執行緒的優勢:執行緒切換不需要核心模式特權,使用者級執行緒可以在任何作業系統上執行,計劃可以是特定於應用程式的,使用者級執行緒的建立和管理速度很快。

使用者級執行緒的缺點:在典型的作業系統中,大多數系統呼叫都是阻塞的,多執行緒應用程式無法利用多處理。

在核心級執行緒中,由核心完成的執行緒管理。應用程式區域中沒有執行緒管理程式碼,作業系統直接支援核心執行緒。任何應用程式都可以程式設計為多執行緒,單個程序支援應用程式中的所有執行緒。

核心維護整個程序以及程序中各個執行緒的上下文資訊,核心的排程是線上程的基礎上完成的,核心在核心空間中執行執行緒建立、排程和管理,核心執行緒的建立和管理速度通常比使用者執行緒慢。

核心級執行緒的優點:核心可以在多個程序上同時排程來自同一程序的多個執行緒,如果程序中的一個執行緒被阻塞,核心可以排程同一程序的另一個執行緒。核心例程本身可以多執行緒。

核心級執行緒的缺點:核心執行緒的建立和管理速度通常比使用者執行緒慢,在同一程序中將控制權從一個執行緒轉移到另一個執行緒需要將模式切換到核心。

使用者和核心執行緒對比圖。

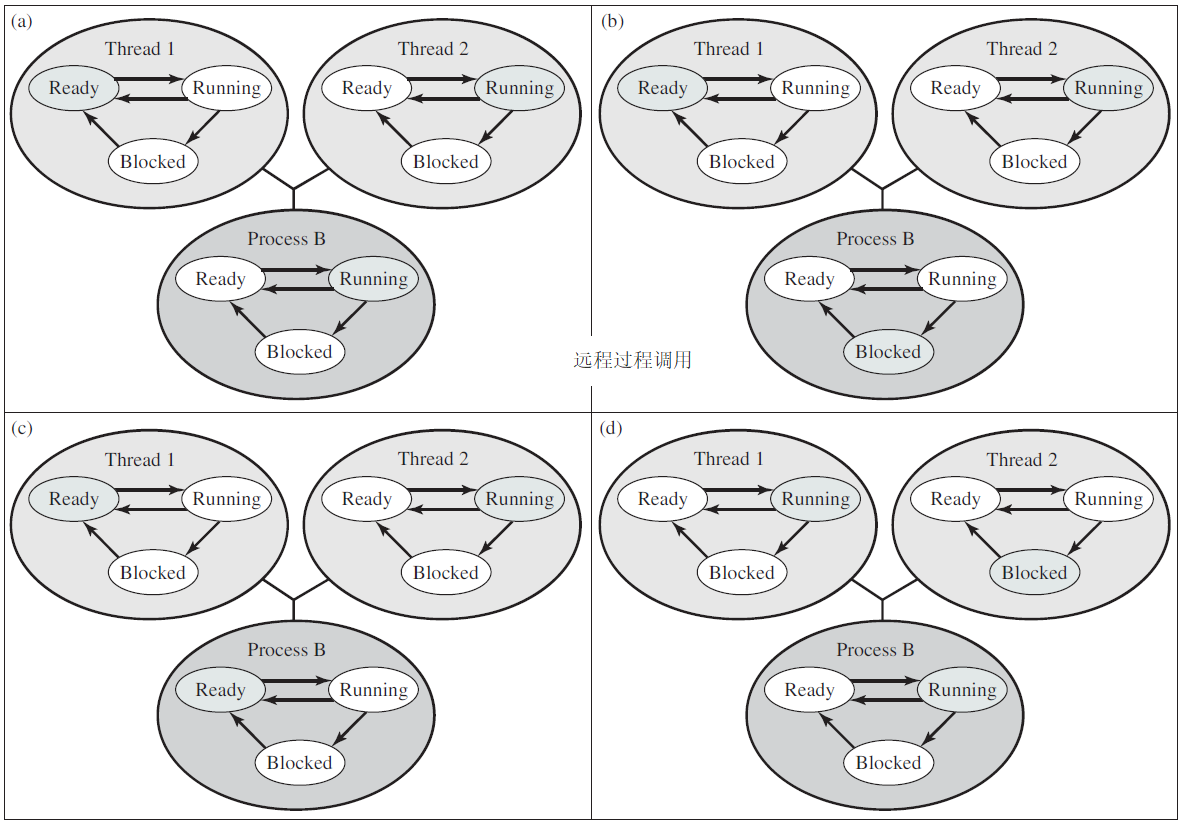

執行緒涉及了複雜的狀態轉換,以下是作業系統常見的轉換圖:

使用者級執行緒狀態和程序狀態之間的關係範例。

Windows執行緒狀態轉換圖。

Linux程序、執行緒模型。

Solaris使用者執行緒和LWP狀態。

使用者級執行緒和核心級執行緒之間的差異如下表:

| 使用者執行緒 | 核心執行緒 | |

|---|---|---|

| 建立和管理速度 | 更快 | 較慢 |

| 實現方式 | 由使用者級的執行緒庫實現 | 作業系統直接支援 |

| 作業系統依賴性 | 可在任何作業系統上執行 | 特定於作業系統 |

| 命名方式 | 在使用者級別提供的支援稱為使用者級別執行緒 | 核心可能提供的支援稱為核心級執行緒 |

| 多核利用 | 無法利用多處理的優勢 | 核心例程本身可以是多執行緒的 |

程序和執行緒的區別如下表:

| 程序 | 執行緒 | |

|---|---|---|

| 量級 | 重量級程序 | 輕量級程序(僅對類Linux) |

| 切換 | 程序切換需要與作業系統互動 | 執行緒切換不需要呼叫作業系統並導致核心中斷 |

| 共用 | 在多程序中,每個程序執行相同的程式碼,但有自己的記憶體和檔案資源 | 所有執行緒共用同一組開啟的檔案、子程序 |

| 阻塞 | 如果一個服務程序被阻塞,則在它被阻塞之前,無法執行其他服務程序 | 當一個服務執行緒被阻塞並等待時,同一任務中的第二個執行緒可以執行 |

| 冗餘 | 多冗餘程序比多執行緒程序使用更多資源 | 多執行緒程序比多冗餘程序使用更少的資源 |

| 獨立性 | 在多程序中,每個程序都獨立於其他程序執行 | 一個執行緒可以讀取、寫入甚至完全清除另一個執行緒堆疊 |

實現執行緒有兩個主要位置:使用者空間和核心空間,以及它們的混合實現。下面將描述這些方法及其優缺點。

- 使用者空間執行緒

這種方法將執行緒包完全放在使用者空間中,核心對它們一無所知。就核心而言,它管理的是普通的單執行緒程序。第一個也是最明顯的優點是,使用者級執行緒包可以在不支援執行緒的作業系統上實現。過去所有的作業系統都屬於這一類,甚至現在仍有一些。使用這種方法,執行緒由庫實現。所有這些實現都具有相同的總體結構,如下圖所示。執行緒執行在執行時系統之上,執行時系統是管理執行緒的程序的集合。

左:使用者級執行緒包。右:由核心管理的執行緒包。

當在使用者空間中管理執行緒時,每個程序都需要自己的私有執行緒表來跟蹤該程序中的執行緒。這個表類似於核心的程序表,只是它只跟蹤每個執行緒的屬性,例如每個執行緒的程式計數器、堆疊指標、暫存器、狀態等等。執行緒表由執行時系統管理,當執行緒移動到就緒狀態或阻塞狀態時,重新啟動執行緒所需的資訊儲存線上程表中,與核心在程序表中儲存程序資訊的方式完全相同。

當一個執行緒做了一些可能導致其在本地被阻塞的事情時,例如,等待其程序中的另一個執行緒完成某些工作,它將呼叫一個執行時系統過程。此過程檢查執行緒是否必須置於阻塞狀態。如果是這樣,它將執行緒的暫存器(即它自己的)儲存線上程表中,在表中查詢準備執行的執行緒,並用新執行緒儲存的值重新載入機器暫存器。一旦堆疊指標和程式計數器被切換,新執行緒就會自動重新啟動。如果機器恰巧有一條指令儲存所有暫存器,另一條指令載入所有暫存器,那麼整個執行緒切換隻需幾個指令即可完成。這樣做執行緒切換至少比捕獲到核心快一個數量級,這是支援使用者級執行緒包的有力論據。

然而,與程序有一個關鍵區別。當執行緒暫時完成執行時,例如,當它呼叫執行緒放棄時,執行緒放棄程式碼可以將執行緒的資訊儲存線上程表本身中。此外,它還可以呼叫執行緒排程程式來選擇要執行的另一個執行緒。儲存執行緒狀態和排程程式的過程只是區域性過程,因此呼叫它們比進行核心呼叫要高效得多。在其他問題中,不需要陷阱、不需要上下文切換、不需要重新整理記憶體快取等等。這些特點使得執行緒排程非常快速。

使用者級執行緒還有其他優點。它們允許每個程序都有自己的客製化排程演演算法。對於某些應用程式,例如,那些具有垃圾收集器執行緒的應用程式,不必擔心執行緒在不方便的時候被停止。它們的伸縮性也更好,因為核心執行緒總是需要核心中的一些表空間和堆疊空間,如果有大量執行緒,可能是一個問題。

儘管它們的效能更好,但使用者級執行緒包仍存在一些主要問題。首先是如何實現阻塞系統呼叫的問題,假設一個執行緒在按下任何鍵之前讀取鍵盤,讓執行緒實際執行系統呼叫是不可接受的,因為會停止所有執行緒。首先擁有執行緒的主要目標之一是允許每個執行緒使用阻塞呼叫,但要防止一個阻塞的執行緒影響其他執行緒。由於有阻塞系統呼叫,難以輕鬆實現這個目標。

系統呼叫可以全部更改為非阻塞(例如,如果沒有緩衝字元,鍵盤上的讀取只會返回0位元組),但要求更改作業系統是不可取的。此外,使用者級執行緒的一個論點是,它們可以在現有作業系統上執行。此外,更改read的語意將需要更改許多使用者程式。

如果可以提前告知呼叫是否會阻塞,則可以使用另一種方法。在UNIX的大多數版本中,存在一個系統呼叫select,它允許呼叫者告訴預期的讀取是否會阻塞。當存在此呼叫時,庫過程read可以替換為一個新的過程,該過程首先執行select呼叫,然後僅在安全時執行read呼叫(即不會阻塞)。如果讀取呼叫將阻塞,則不進行呼叫,而是執行另一個執行緒。下次執行時系統獲得控制時,它可以再次檢查讀取是否現在是安全的。這種方法需要重寫系統呼叫庫的部分內容,效率低且不雅觀,但別無選擇。放置在系統呼叫周圍進行檢查的程式碼稱為封套(jacket)或包裝器(wrapper)。

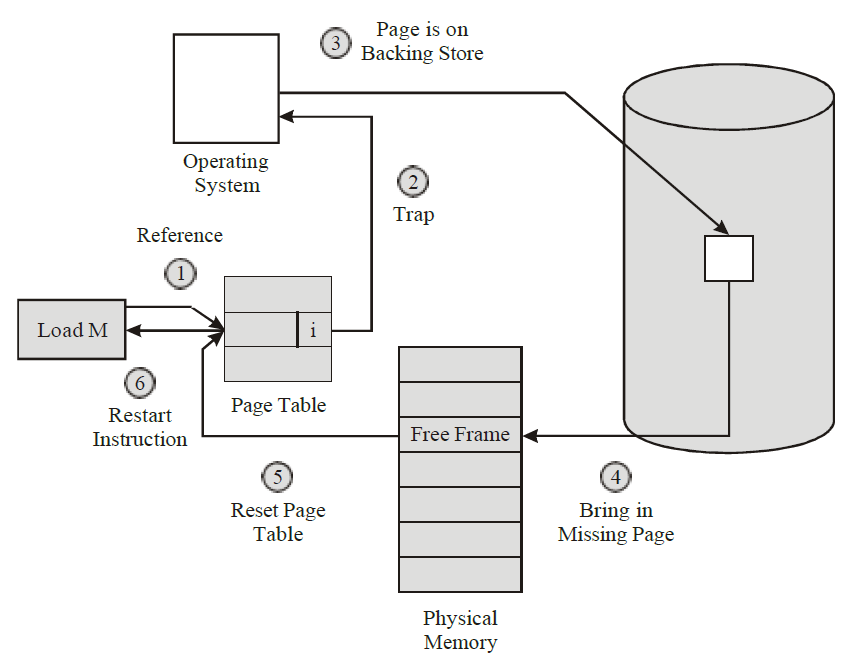

與阻塞系統呼叫的問題類似的是頁面錯誤問題。如果程式呼叫或跳轉到不在記憶體中的指令,則會發生頁錯誤,作業系統將從磁碟獲取丟失的指令(及其鄰居),稱為頁面錯誤(page fault)。當找到並讀入必要的指令時,程序被阻塞。如果執行緒導致頁面錯誤,核心甚至不知道執行緒的存在,自然會阻塞整個程序,直到磁碟I/O完成,即使其他執行緒可能可以執行。

使用者級執行緒包的另一個問題是,如果一個執行緒開始執行,那麼該程序中的其他執行緒將永遠不會執行,除非第一個執行緒自願放棄CPU。在單個程序中,沒有時鐘中斷,因此無法以迴圈方式(輪流)排程程序。除非執行緒自願進入執行時系統,否則排程程式永遠不會有機會。

執行緒永遠執行的問題的一個可能的解決方案是讓執行時系統每秒請求一次時鐘訊號(中斷)來給它控制權,但對程式來說也是粗糙和混亂的。頻率較高的週期性時鐘中斷並不總是可行,即使是這樣,總開銷也可能很大。此外,執行緒還可能需要時鐘中斷,從而干擾執行時系統對時鐘的使用。

另一個,也是最具破壞性的,反對使用者級執行緒的論點是,程式設計師通常希望執行緒恰好位於執行緒經常阻塞的應用程式中,例如,在多執行緒Web伺服器中,這些執行緒不斷地進行系統呼叫。一旦核心出現執行系統呼叫的陷阱,如果舊的執行緒被阻塞,核心就幾乎不需要再做任何工作來切換執行緒,並且讓核心這樣做可以消除不斷進行選擇系統呼叫以檢查讀取系統呼叫是否安全的需要。對於本質上完全受CPU限制且很少阻塞的應用程式,使用執行緒有什麼意義?沒有人會認真建議計算前n個質數或使用執行緒下棋,因為這樣做毫無益處。

- 核心空間執行緒

現在讓我們考慮讓核心瞭解並管理執行緒。如上圖右所示,每個系統都不需要執行時系統。此外,每個程序中都沒有執行緒表。相反,核心有一個執行緒表來跟蹤系統中的所有執行緒。當執行緒想要建立新執行緒或銷燬現有執行緒時,它會進行核心呼叫,然後通過更新核心執行緒表來建立或銷燬執行緒。

核心的執行緒表儲存每個執行緒的暫存器、狀態和其他資訊。這些資訊與使用者級執行緒的資訊相同,但現在儲存在核心中,而不是使用者空間中(在執行時系統中),這些資訊是傳統核心維護的關於其單執行緒程序的資訊的子集,即程序狀態。此外,核心還維護傳統的程序表以跟蹤程序。

所有可能阻塞執行緒的呼叫都被實現為系統呼叫,其成本遠遠高於對執行時系統過程的呼叫。當一個執行緒阻塞時,核心可以選擇執行同一程序中的另一個執行緒(如果一個執行緒已就緒)或不同程序中的一個執行緒。使用使用者級執行緒,執行時系統會從自己的程序中保持執行緒的執行,直到核心佔用CPU(或者沒有準備好的執行緒可以執行)。

由於在核心中建立和銷燬執行緒的成本相對較高,一些系統採用了一種環境正確的方法並回收其執行緒。當執行緒被銷燬時,它被標記為不可執行,但其核心資料結構不會受到其他方面的影響。稍後,當必須建立新執行緒時,將重新啟用舊執行緒,從而節省一些開銷。使用者級執行緒也可以進行執行緒回收,但由於執行緒管理開銷要小得多,因此這樣做的動機較小。

核心執行緒不需要任何新的非阻塞系統呼叫。此外,如果程序中的一個執行緒導致頁面錯誤,核心可以輕鬆檢查程序是否有其他可執行的執行緒,如果有,則在等待從磁碟引入所需頁面的同時執行其中一個執行緒。它們的主要缺點是系統呼叫的成本很高,因此如果執行緒操作(建立、終止等)很常見,則會產生更多的開銷。

雖然核心執行緒可以解決一些問題,但它們並不能解決所有問題。例如,當多執行緒程序分叉時會發生什麼?新程序是否與舊程序具有相同數量的執行緒,還是隻有一個執行緒?在許多情況下,最佳選擇取決於程序下一步計劃做什麼。如果它要呼叫exec來啟動一個新程式,可能選擇一個執行緒是正確的,但如果它繼續執行,則最好重新生成所有執行緒。

另一個問題是訊號。請記住,至少在經典模型中,訊號被傳送到程序,而不是執行緒。當訊號傳入時,哪個執行緒應該處理它?執行緒可能會註冊他們對某些訊號的興趣,因此當訊號傳入時,它會被傳送給表示想要它的執行緒。但是,如果兩個或多個執行緒註冊同一訊號,會發生什麼情況?這些只是執行緒引入的兩個問題,還有更多。

- 混合實現

為了將使用者級執行緒與核心級執行緒的優點結合起來,已經研究了多種方法。一種方法是使用核心級執行緒,然後將使用者級執行緒複用到部分或全部執行緒上,如下圖所示。當使用這種方法時,開發人員可以確定要使用多少核心執行緒,以及每個執行緒要複用多少使用者級執行緒。該模型提供了最大的靈活性。

將使用者級執行緒多路傳輸到核心級執行緒。

使用這種方法,核心只知道核心級別的執行緒並對其進行排程。其中一些執行緒可能有多個使用者級執行緒在其上進行多路複用,這些使用者級執行緒的建立、銷燬和排程就像在沒有多執行緒功能的作業系統上執行的程序中的使用者級執行緒一樣。在這個模型中,每個核心級執行緒都有一些使用者級執行緒,這些執行緒輪流使用它。

18.5.5 單執行緒程式碼多執行緒化

許多現有程式都是為單執行緒程序編寫的,將這些轉換為多執行緒比最初看起來要複雜得多。下面,我們將研究幾個陷阱。

首先,執行緒的程式碼通常由多個過程組成,就像一個程序一樣,這些變數可能有區域性變數、全域性變數和引數。區域性變數和引數不會引起任何問題,但對於執行緒是全域性的但對於整個程式不是全域性的變數是一個問題。這些變數是全域性變數,因為執行緒中的許多過程都使用它們(因為它們可能使用任何全域性變數),但其他執行緒在邏輯上應該不使用它們。

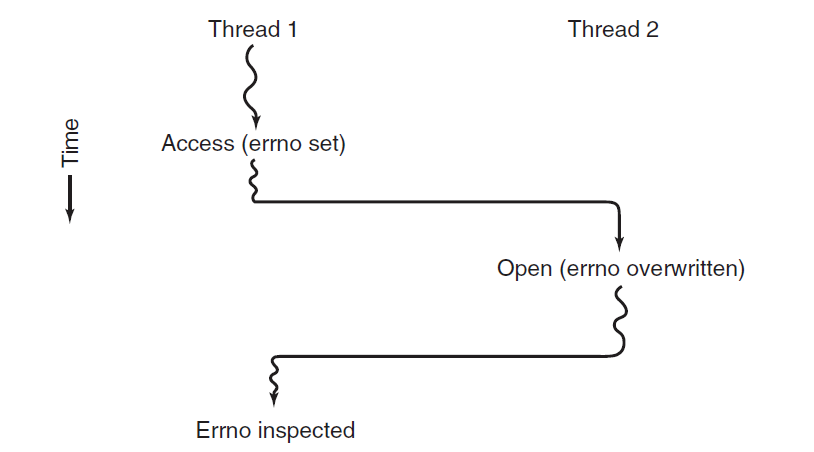

例如,考慮UNIX維護的errno變數。當程序(或執行緒)進行失敗的系統呼叫時,錯誤程式碼被放入errno。在下圖中,執行緒1執行系統呼叫存取,以確定它是否有權存取某個檔案。作業系統在全域性變數errno中返回答案,控制權返回執行緒1後,但在有機會讀取errno之前,排程程式決定執行緒1目前有足夠的CPU時間,並決定切換到執行緒2。執行緒2執行一個失敗的開啟呼叫,會導致errno被覆蓋,執行緒1的存取程式碼永遠丟失。執行緒1稍後啟動後,將讀取錯誤的值,並且行為不正確。

執行緒之間因使用全域性變數而發生衝突。

這個問題有多種解決方案。一是完全禁止全域性變數,無論這個理想多麼值得,它都與許多現有的軟體相沖突。另一種方法是為每個執行緒分配自己的私有全域性變數,如下圖所示。這樣,每個執行緒都有自己的errno和其他全域性變數的私有副本,從而避免了衝突。實際上,這個決定建立了一個新的作用域級別,變數對執行緒的所有過程都可見(但對其他執行緒不可見),此外,變數的現有作用域級別只對一個過程可見,變數在程式中到處可見。

執行緒可以擁有私有的全域性變數。

然而,存取私有全域性變數有點棘手,因為大多數程式語言都有表示區域性變數和全域性變數的方法,但沒有中間形式。可以為全域性變數分配一塊記憶體,並將其作為額外引數傳遞給執行緒中的每個過程。雖然不是一個優雅的方法,但確實有效。或者,可以引入新的庫過程來建立、設定和讀取這些執行緒範圍的全域性變數。第一個呼叫可能如下所示:

create_global("bufptr");

它在堆上或為呼叫執行緒保留的特殊儲存區域中為名為bufptr的指標分配儲存。無論儲存分配到哪裡,只有呼叫執行緒可以存取全域性變數。如果另一個執行緒建立了一個同名的全域性變數,它將獲得一個與現有儲存位置不衝突的不同儲存位置。存取全域性變數需要兩個呼叫:一個用於寫入,另一個用於讀取。寫法類似以下程式碼:

set_global("bufptr", &buf);

它將指標的值儲存在之前由建立全域性呼叫建立的儲存位置。要讀取全域性變數,呼叫可能如下所示:

bufptr = read_global("bufptr");

它返回儲存在全域性變數中的地址,因此可以存取其資料。

將單執行緒程式轉換為多執行緒程式的下一個問題是,許多庫過程都是不可重入的。也就是說,在前一個呼叫尚未完成的情況下,它們不會對任何給定過程進行第二次呼叫。例如,通過網路傳送訊息很可能被程式設計為在庫內的固定緩衝區中組裝訊息,然後陷阱到核心傳送訊息。如果一個執行緒在緩衝區中組裝了它的訊息,然後時鐘中斷強制切換到第二個執行緒,該執行緒立即用自己的訊息覆蓋緩衝區,會發生什麼情況?

類似地,記憶體分配過程(如UNIX中的malloc)維護有關記憶體使用的關鍵表,例如可用記憶體塊的連結列表。當malloc忙於更新這些列表時,它們可能暫時處於不一致的狀態,指標沒有指向任何地方。如果在表不一致時發生執行緒切換,並且來自不同執行緒的新呼叫,則可能會使用無效指標,從而導致程式崩潰。要有效地解決所有這些問題意味著要重寫整個庫,是一項非常重要的工作,很可能會引入細微的錯誤。

另一種解決方案是為每個過程提供一個封套(jacket),該封套設定一個位,將庫標記為正在使用。當上一個呼叫尚未完成時,另一個執行緒使用庫過程的任何嘗試都將被阻止。雖然這種方法可以工作,但它大大消除了潛在的並行性。

接下來,考慮訊號。有些訊號在邏輯上是特定於執行緒的,而其他訊號則不是。例如,如果一個執行緒呼叫警報,那麼產生的訊號應該傳送給進行呼叫的執行緒。然而,當執行緒完全在使用者空間中實現時,核心甚至不知道執行緒,很難將訊號指向正確的執行緒。如果一個程序一次只能有一個警報掛起,並且多個執行緒獨立呼叫警報,則會出現額外的複雜性。

其他訊號,如鍵盤中斷,不是特定於執行緒的。誰應該抓住他們?一個指定執行緒?所有執行緒?新建立的彈出執行緒?此外,如果一個執行緒在不通知其他執行緒的情況下更改訊號處理程式,會發生什麼情況?如果一個執行緒想要捕捉一個特定的訊號(例如,使用者點選CTRL-C),而另一個執行緒希望這個訊號終止程序,會發生什麼?如果一個或多個執行緒執行標準庫過程,而其他執行緒是使用者編寫的,則可能會出現這種情況。顯然,這些期望是不相容的。通常,訊號很難在單執行緒環境中管理,進入多執行緒環境並不會使它們更容易處理。

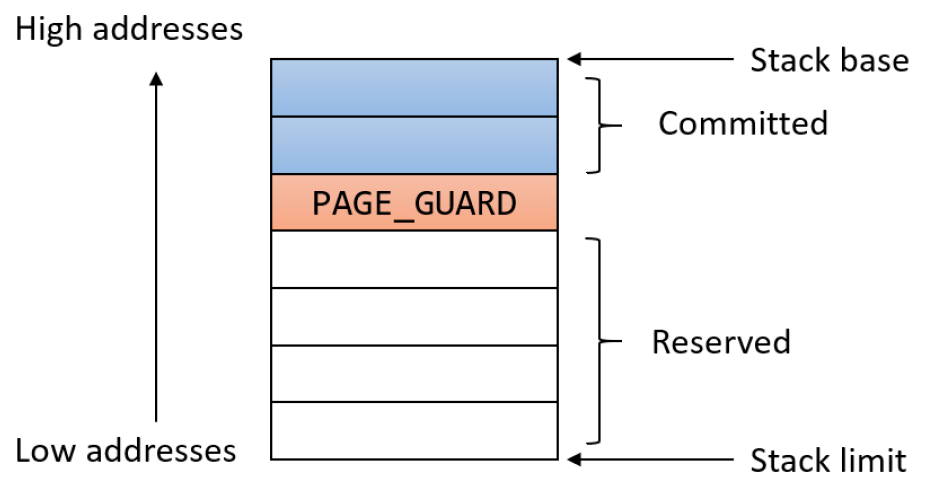

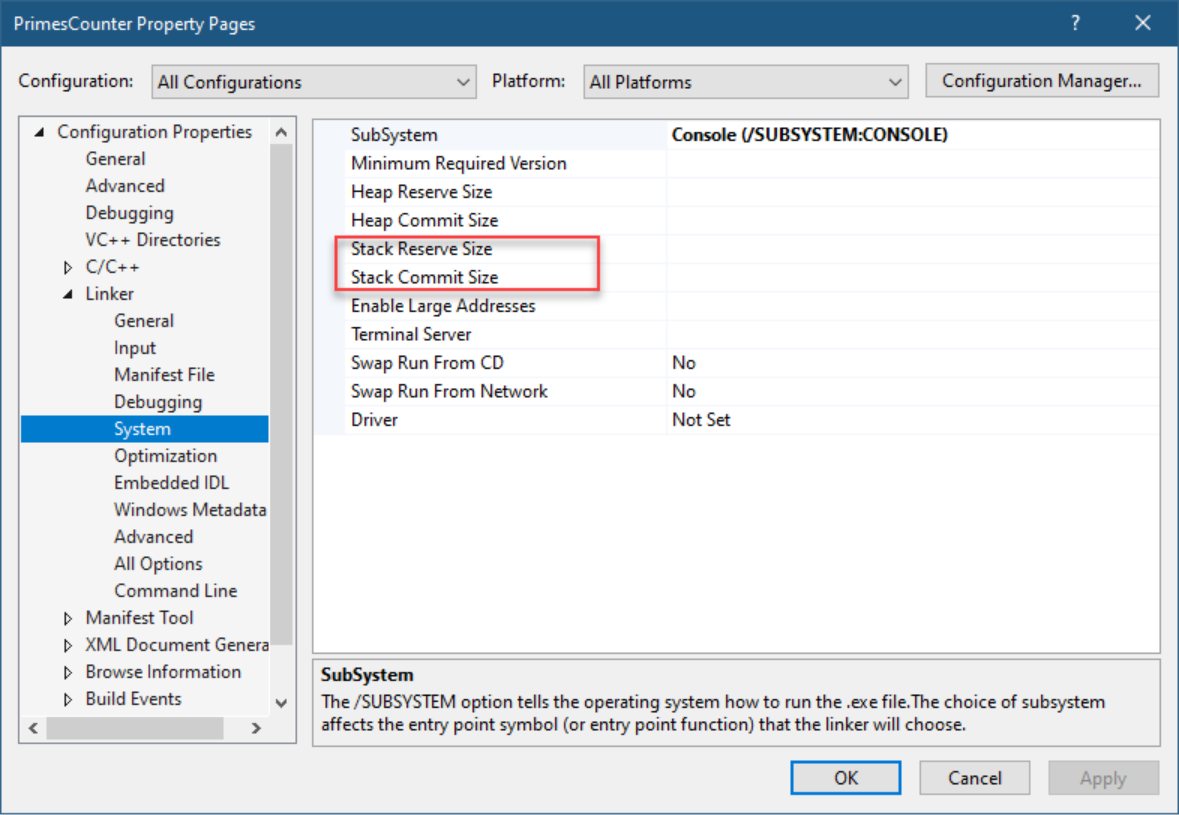

執行緒引入的最後一個問題是堆疊管理。在許多系統中,當程序的堆疊溢位時,核心只會自動為該程序提供更多堆疊。當一個程序有多個執行緒時,它也必須有多個堆疊。核心如果不知道所有這些堆疊,就無法在出現堆疊錯誤時自動增長它們,事實上,它甚至可能沒有意識到記憶體故障與某些執行緒堆疊的增長有關。

這些問題當然不是不可克服的,但它們確實表明,僅僅將執行緒引入現有系統而不進行相當實質性的系統重新設計是行不通的。至少,系統呼叫的語意可能需要重新定義,庫需要重寫。所有這些事情都必須以這樣一種方式進行,即在程序只有一個執行緒的情況下,保持與現有程式的向後相容。

18.5.6 Windows執行緒

程序是管理物件,不直接執行程式碼。要在Windows上完成任何操作,必須建立執行緒。使用者模式程序是由一個執行緒建立的,該執行緒最終執行可執行檔案的主入口點。在許多情況下,應用程式可能不需要更多執行緒。然而,一些應用程式可能會受益於使用程序內執行的多個執行緒。每個執行緒都是獨立的執行路徑,因此可以使用不同的處理器,從而實現真正的並行。

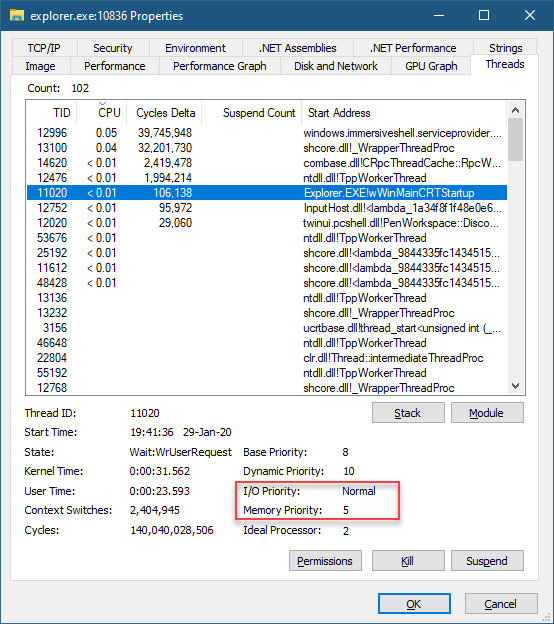

執行緒是執行程式碼的實際載體,包含在程序中,使用程序公開的資源進行工作(如虛擬記憶體和核心物件的控制程式碼)。執行緒擁有的最重要屬性如下:

- 當前存取模式,使用者或核心。

- 執行上下文,包括處理器暫存器。

- 堆疊,用於本地變數分配和呼叫管理。

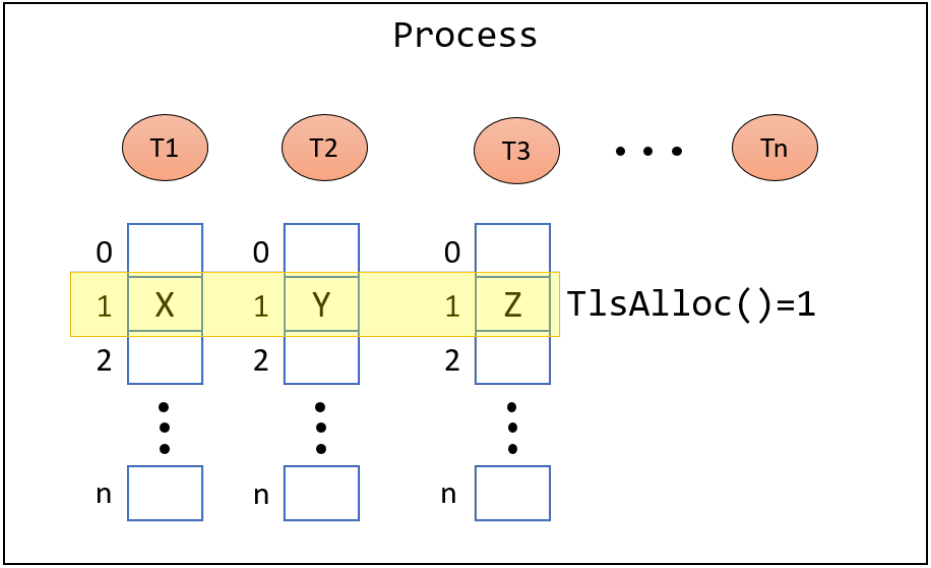

- 執行緒本地儲存(TLS)陣列,提供了一種以統一存取語意儲存執行緒私有資料的方法。

- 基本優先順序和當前(動態)優先順序。

- 處理器關聯,指示允許執行緒在哪些處理器上執行。

執行緒最常見的狀態是:

- Running(正在執行)。當前正在(邏輯)處理器上執行程式碼。

- Ready(就緒)。由於所有相關處理器忙或不可用,等待排程執行。

- Waiting(等待)。在繼續之前等待某些事件發生,事件發生後,執行緒將移動到就緒狀態。

執行緒抽象了一個獨立的執行路徑,從執行的角度來看,它與可能同時處於活動狀態的其他執行緒無關。一旦執行緒開始執行,它可以執行以下任何操作,直到退出:

- CPU密集操作——依賴CPU操作進行進度的函數計算或呼叫。

- I/O密集操作——針對I/O裝置(如磁碟或網路)執行的操作。在等待I/O操作完成時,執行緒處於等待狀態,不消耗CPU週期。

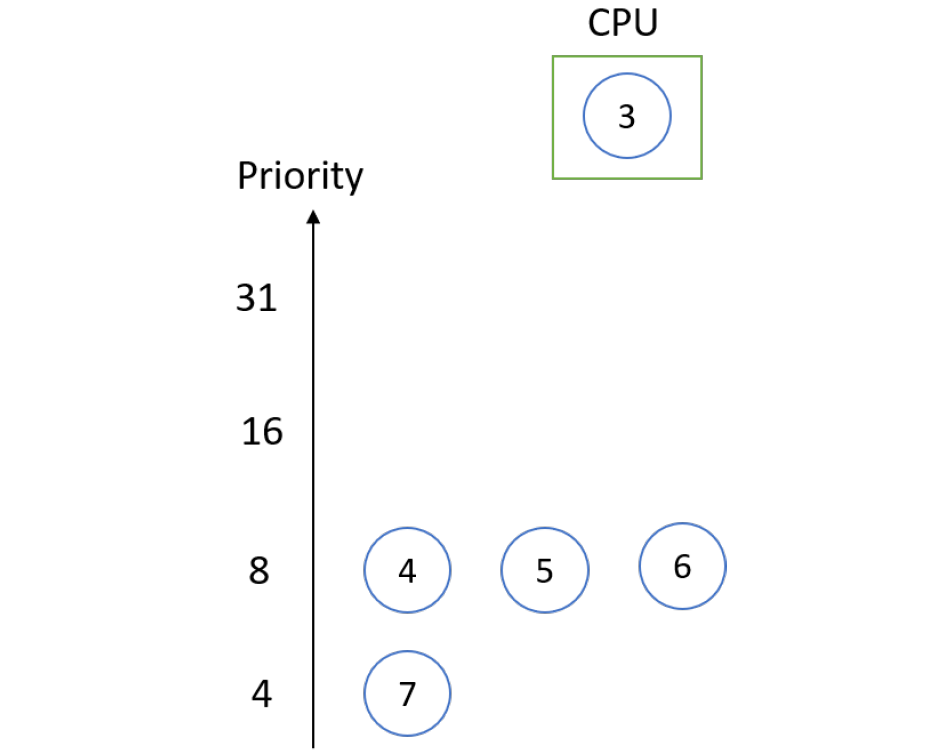

- 可能導致執行緒進入等待狀態的其他操作,如等待同步原語(互斥體等)。

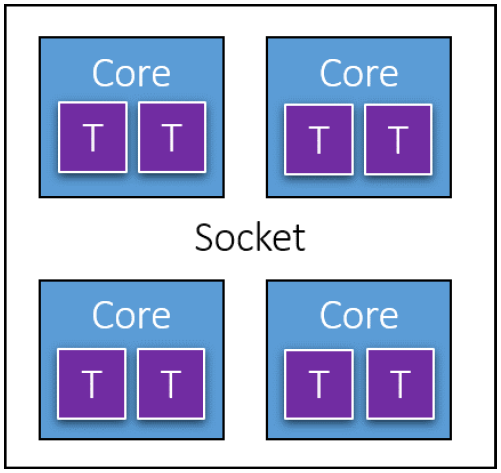

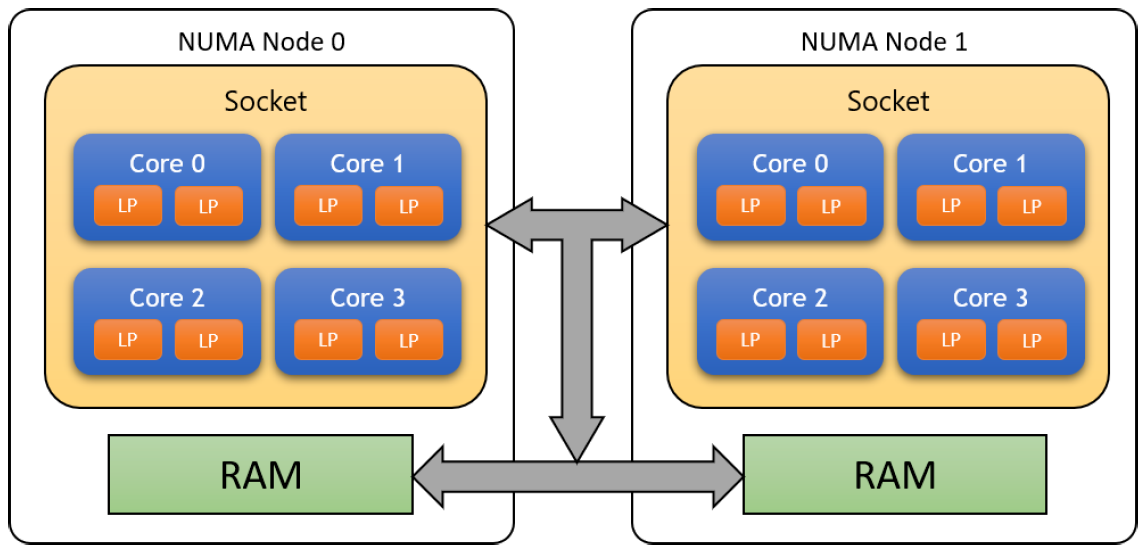

在進一步研究執行緒之前,我們必須認識到執行緒是處理器的抽象。但處理器的定義究竟是什麼?在多核構成一個典型CPU的時代,這些術語可能會變得混亂。下圖顯示了典型CPU的邏輯組成。

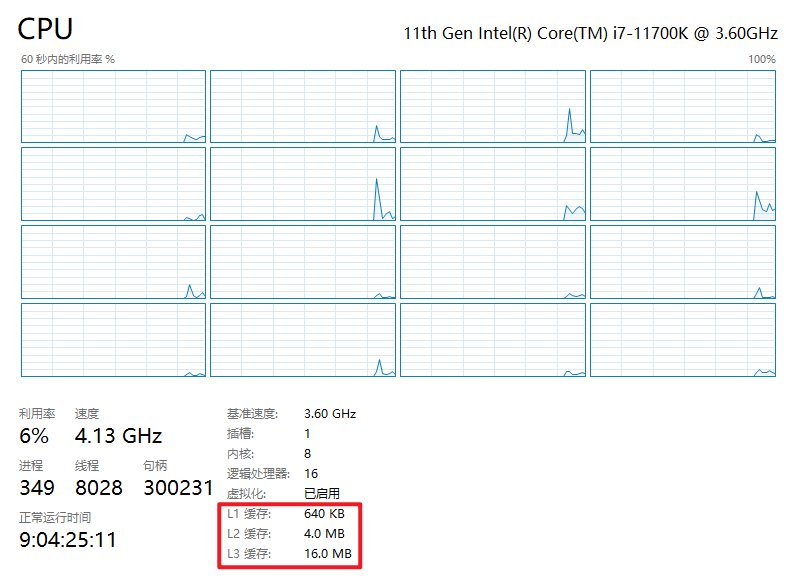

在上圖中,有一個插槽(Socket),它是卡在計算機主機板上的物理晶片。筆記型電腦和家用電腦通常只有一種,大型伺服器計算機可能包含多個插槽。每個插槽都有多個核心,它們是獨立的處理器(上圖是4個)。

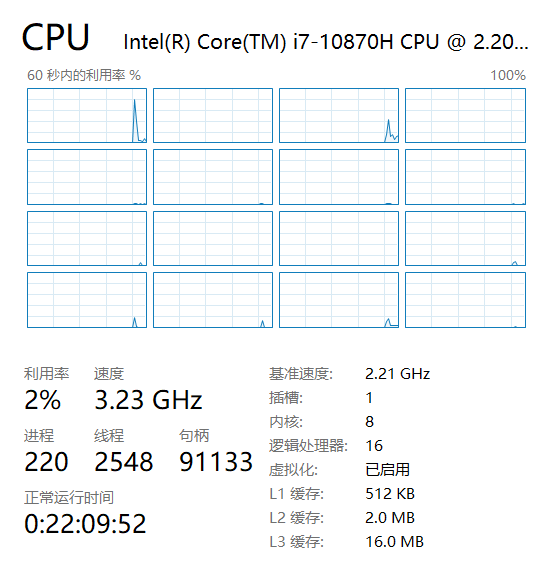

在英特爾處理器上,每個核心可能被分成兩個邏輯處理器,由於一種稱為超執行緒(Hyper Threading)的技術,也稱為硬體執行緒。從Windows的角度來看,處理器的數量是邏輯處理器的數量。下圖顯示博主的筆電有16個邏輯處理器,意味著在任何給定時刻,最多有16個執行緒正在執行。工作管理員還顯示了插槽、核心和邏輯處理器的數量。

AMD也有類似的技術,稱為並行多執行緒(Simultaneous Multi Threading,SMT)。

可以在BIOS設定中禁用超執行緒。超執行緒的潛在缺點是,共用一個核心的每兩個邏輯處理器也共用二級快取,因此可能會相互「干擾」。

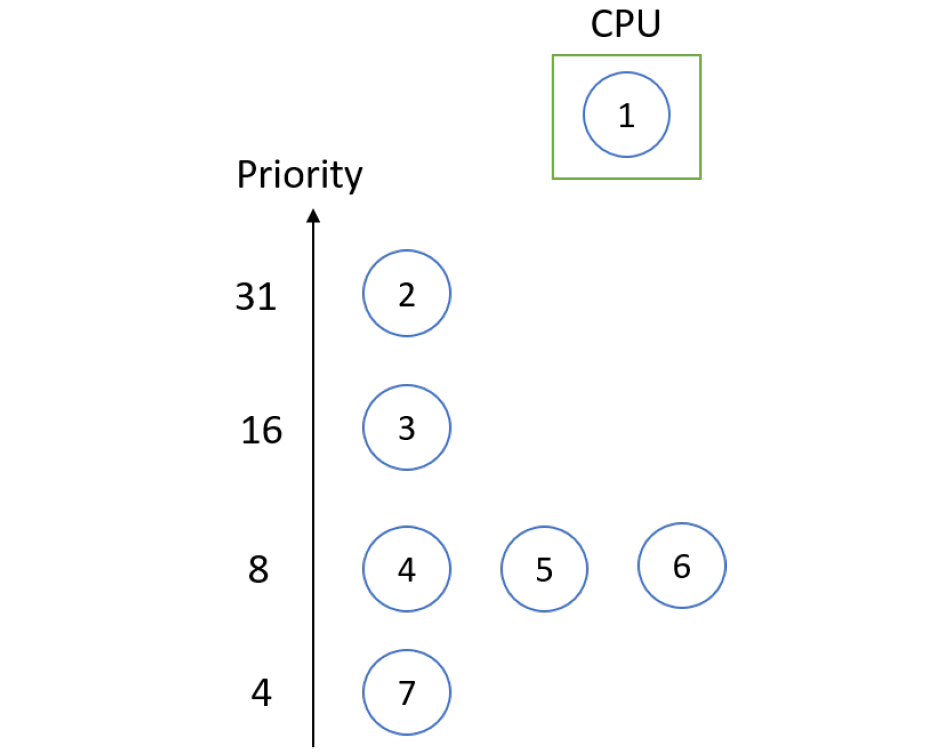

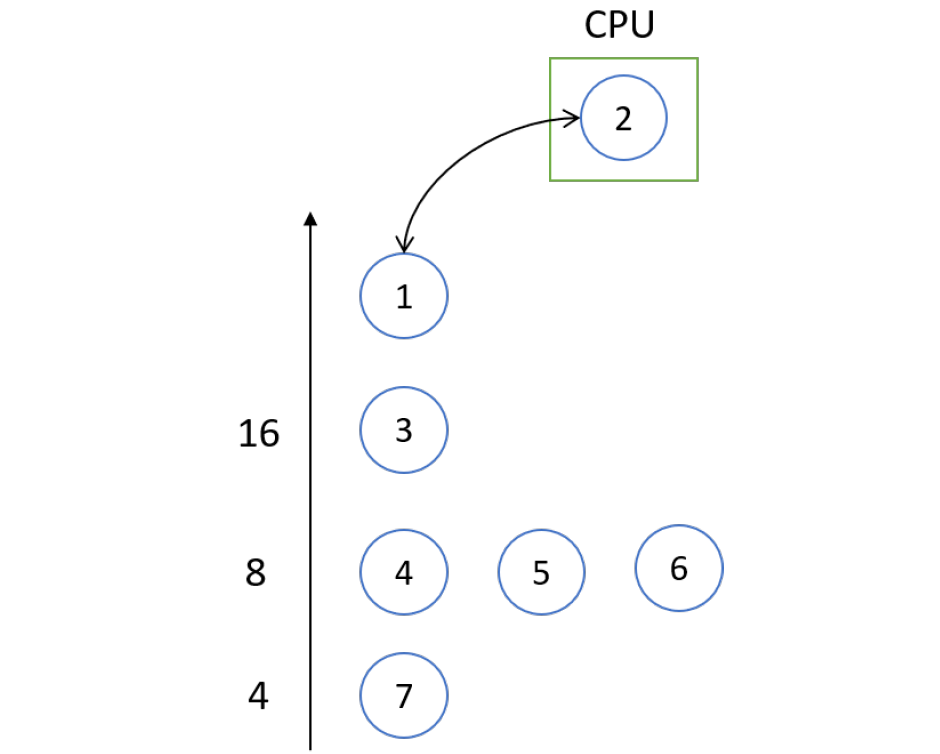

18.5.6.1 Fork-Join

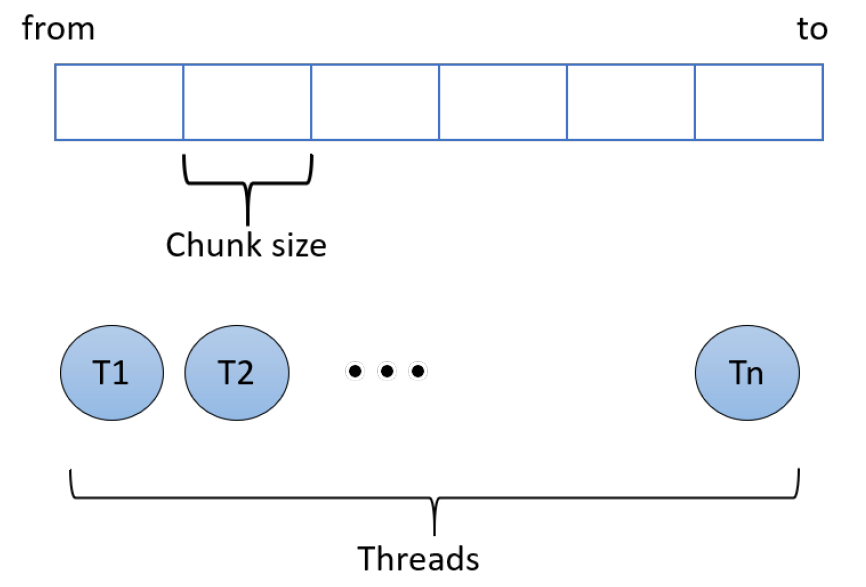

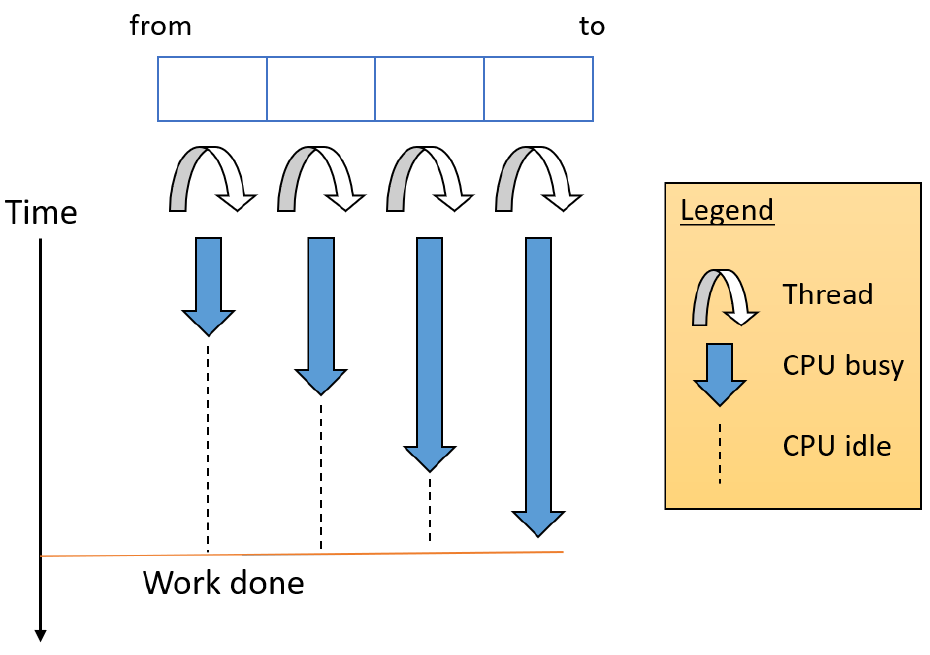

下面的範例演示了多執行緒的複雜用法。PrimeSconter應用程式使用指定數量的執行緒對一系列數位中的質數進行計數,想法是將工作分成幾個執行緒,每個執行緒都計算其數位範圍內的素數。然後,主執行緒等待所有工作執行緒退出,允許它簡單地對所有執行緒的計數求和。如下圖所示。

這種建立多個執行某些工作的執行緒,並等待它們在聚合結果之前退出的想法有時被稱為分叉-合併(Fork-Join),因為執行緒從某個初始執行緒「分叉」,然後在完成後「連線回」初始執行緒。

這種模式的另一個名稱是結構化並行(Structured Parallelism)。

此應用程式中使用的執行緒數是演演算法的引數之一——有趣的問題是,最快完成計算的最佳執行緒數是多少?

下面程式碼是上圖所示的應用程式PrimeSconter的實現程式碼:

struct PrimesData

{

int From, To;

int Count;

};

bool IsPrime(int n)

{

if (n < 2)

return false;

if(n == 2)

return true;

int limit = (int)::sqrt(n);

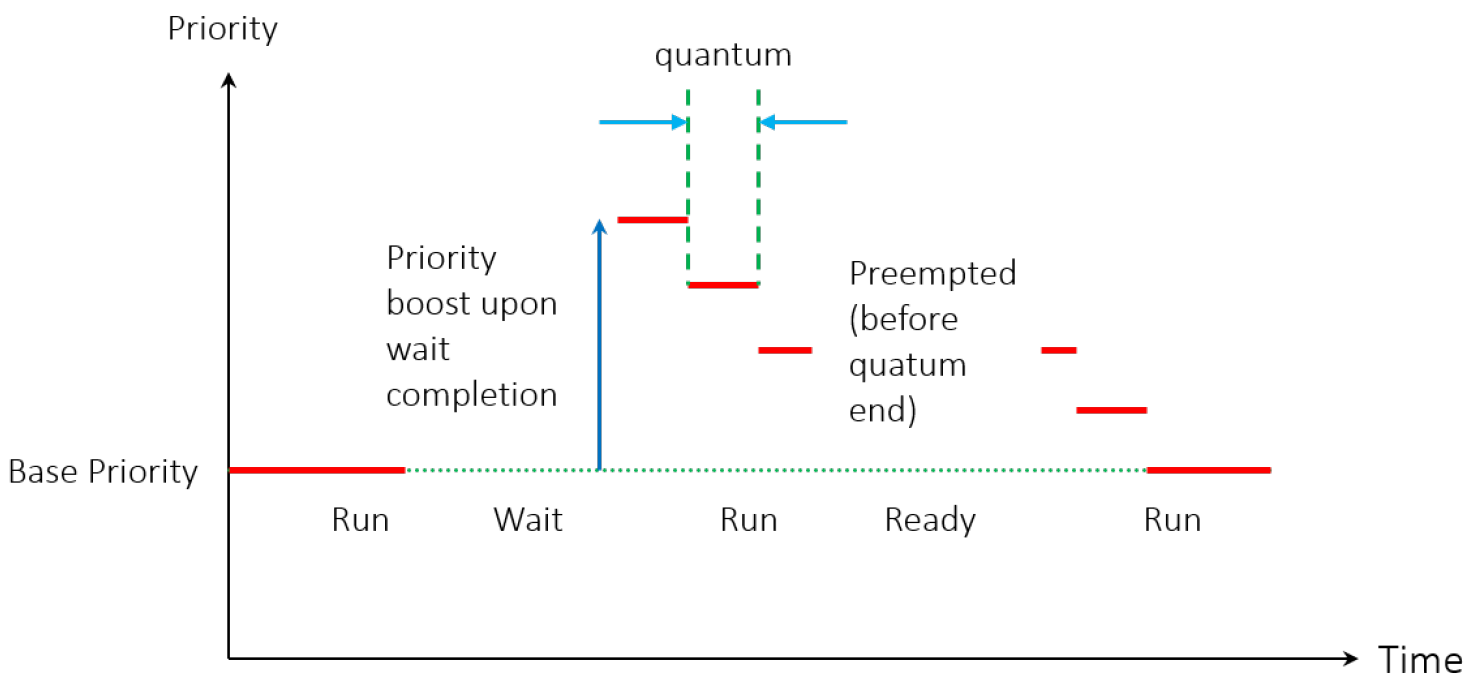

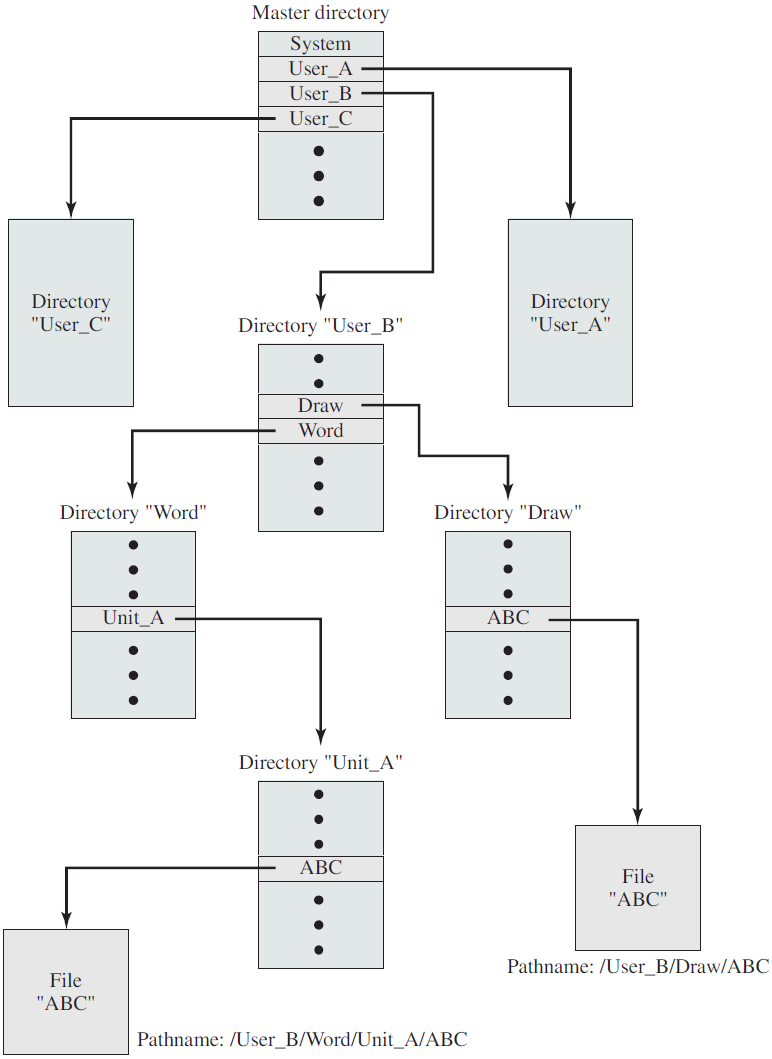

for (int i = 2; i <= limit; i++)