用Python獲取Amazon亞馬遜的商品資訊

引言

亞馬遜網站相較於國內的購物網站,可以直接使用python的最基本的requests進行請求。存取不是過於頻繁,在未觸發保護機制的情況下,可以獲取我們想要的資料。本次通過以下三部分簡單介紹下基本爬取流程:

使用requests的get請求,獲取亞馬遜列表和詳情頁的頁面內容

使用css/xpath對獲取的內容進行解析,取得關鍵資料

動態IP的作用及其使用方法

一、獲取亞馬遜列表頁的資訊

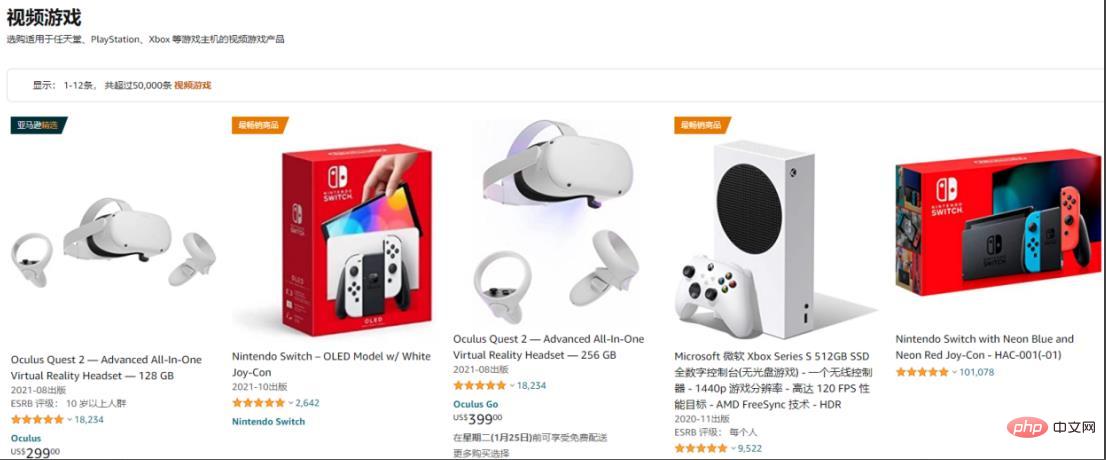

以遊戲區為例:

程式設計師必備介面測試偵錯工具:

獲取列表內能獲取到的商品資訊,如商品名,詳情連結,進一步獲取其他內容。

用requests.get()獲取網頁內容,設定好header,利用xpath選擇器選取相關標籤的內容:

import requests

from parsel import Selector

from urllib.parse import urljoin

spiderurl = 'https://www.amazon.com/s?i=videogames-intl-ship'

headers = {

"authority": "www.amazon.com",

"user-agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 10_3_3 like Mac OS X) AppleWebKit/603.3.8 (KHTML, like Gecko) Mobile/14G60 MicroMessenger/6.5.19 NetType/4G Language/zh_TW",

}

resp = requests.get(spiderurl, headers=headers)

content = resp.content.decode('utf-8')

select = Selector(text=content)

nodes = select.xpath("//a[@title='product-detail']")

for node in nodes:

itemUrl = node.xpath("./@href").extract_first()

itemName = node.xpath("./div/h2/span/text()").extract_first()

if itemUrl and itemName:

itemUrl = urljoin(spiderurl,itemUrl)#用urljoin方法湊完整連結

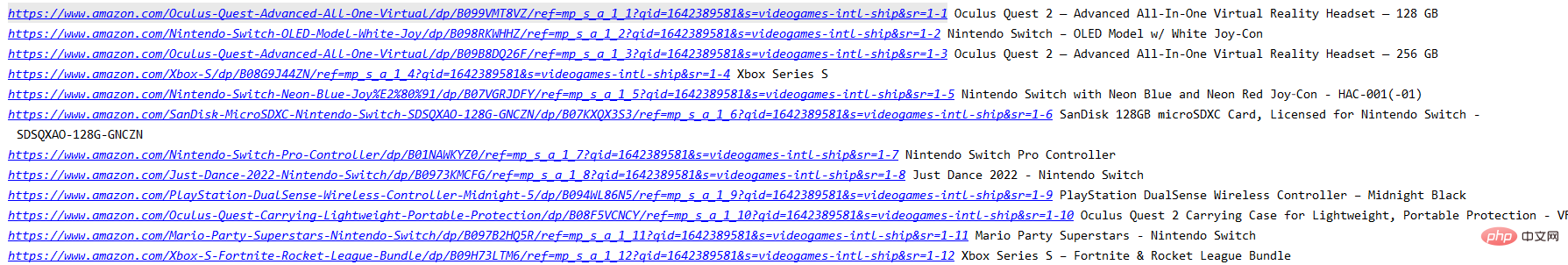

print(itemUrl,itemName)登入後複製此時已經獲取的當前列表頁目前能獲得的資訊:

二、獲取詳情頁資訊

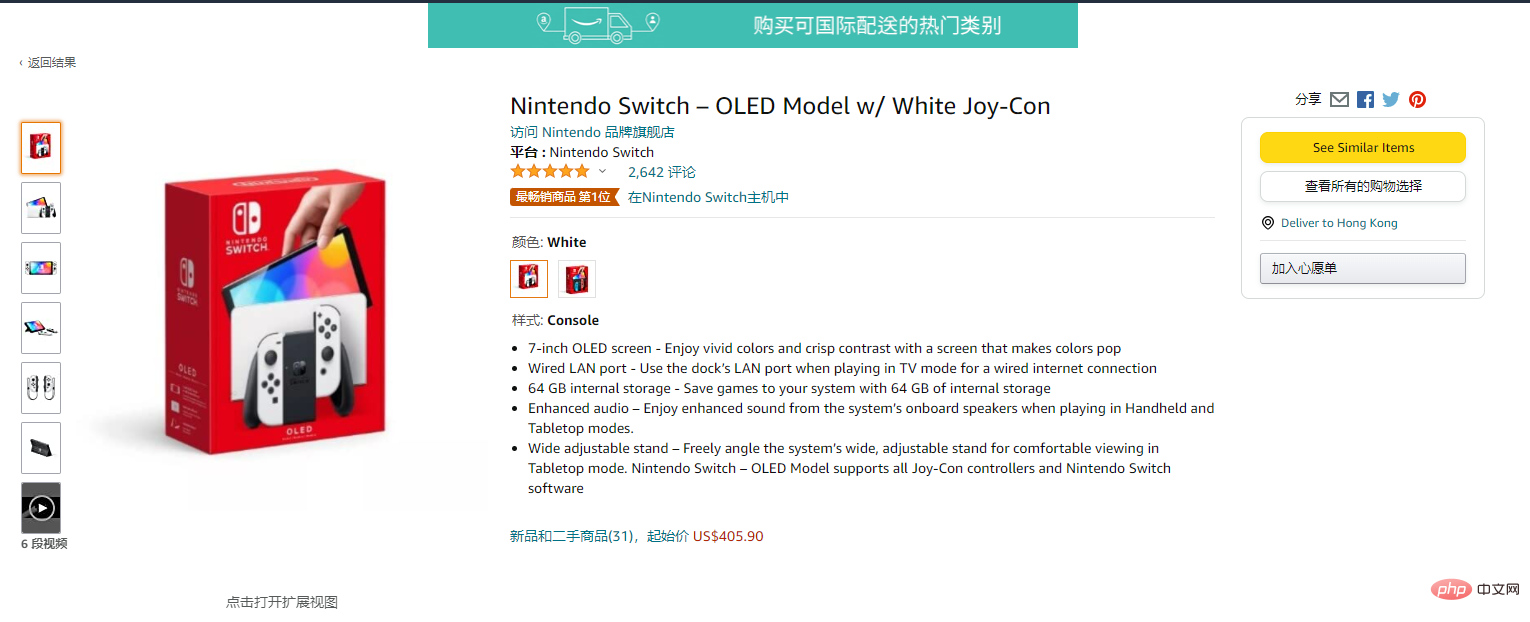

進入詳情頁:

進入詳情頁之後,能獲得更多的內容

用requests.get()獲取網頁內容,css選取相關標籤的內容:

res = requests.get(itemUrl, headers=headers)

content = res.content.decode('utf-8')

Select = Selector(text=content)

itemPic = Select.css('#main-image::attr(src)').extract_first()

itemPrice = Select.css('.a-offscreen::text').extract_first()

itemInfo = Select.css('#feature-bullets').extract_first()

data = {}

data['itemUrl'] = itemUrl

data['itemName'] = itemName

data['itemPic'] = itemPic

data['itemPrice'] = itemPrice

data['itemInfo'] = itemInfo

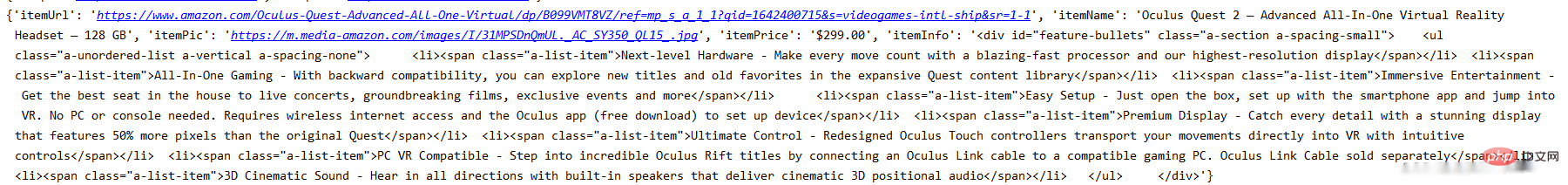

print(data)登入後複製此時已經生成詳情頁資料的資訊:

目前涉及到的就是最基本的requests請求亞馬遜並用css/xpath獲取相應的資訊。

三、代理設定

目前,國記憶體取亞馬遜會很不穩定,我這邊大概率會出現連線不上的情況。如果真的需要去爬取亞馬遜的資訊,最好使用一些穩定的代理,我這邊自己使用的是ipidea的代理,可以白嫖500M流量。如果有代理的話存取的成功率會高,速度也會快一點。

網址在這裡:www.ipidea.net

代理使用有兩種方式,一是通過api獲取IP地址,還有用賬密的方式使用,方法如下:

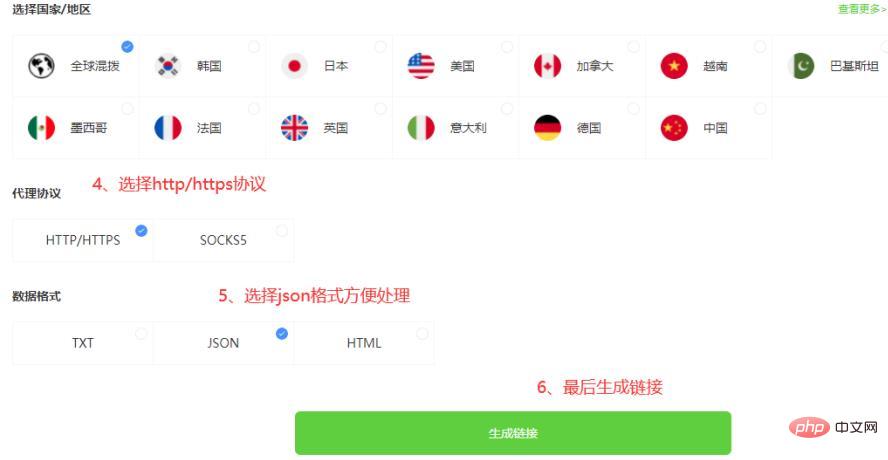

3.1.1 api獲取代理

3.1.2 api獲取ip程式碼

def getProxies():

# 獲取且僅獲取一個ip

api_url = '生成的api連結'

res = requests.get(api_url, timeout=5)

try:

if res.status_code == 200:

api_data = res.json()['data'][0]

proxies = {

'http': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

'https': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

}

print(proxies)

return proxies

else:

print('獲取失敗')

except:

print('獲取失敗')登入後複製3.2.1 賬密獲取代理

因為是賬密驗證,所以需要去到賬戶中心填寫資訊建立子賬戶:

建立好子賬戶之後,根據賬號和密碼獲取連結:

3.2.2 賬密獲取代理程式碼

# 獲取賬密ip

def getAccountIp():

# 測試完成後返回代理proxy

mainUrl = 'https://api.myip.la/en?json'

headers = {

"Accept": "text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8",

"User-Agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 10_3_3 like Mac OS X) AppleWebKit/603.3.8 (KHTML, like Gecko) Mobile/14G60 MicroMessenger/6.5.19 NetType/4G Language/zh_TW",

}

entry = 'http://{}-zone-custom{}:proxy.ipidea.io:2334'.format("帳號", "密碼")

proxy = {

'http': entry,

'https': entry,

}

try:

res = requests.get(mainUrl, headers=headers, proxies=proxy, timeout=10)

if res.status_code == 200:

return proxy

except Exception as e:

print("存取失敗", e)

pass登入後複製使用代理之後,亞馬遜商品資訊的獲取改善了不少,之前程式碼會報各種連線失敗的錯誤,在requests請求之前呼叫代理獲取的方法,方法return回代理ip並加入requests請求引數,就可以實現代理請求了。

四、全部程式碼

# coding=utf-8

import requests

from parsel import Selector

from urllib.parse import urljoin

def getProxies():

# 獲取且僅獲取一個ip

api_url = '生成的api連結'

res = requests.get(api_url, timeout=5)

try:

if res.status_code == 200:

api_data = res.json()['data'][0]

proxies = {

'http': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

'https': 'http://{}:{}'.format(api_data['ip'], api_data['port']),

}

print(proxies)

return proxies

else:

print('獲取失敗')

except:

print('獲取失敗')

spiderurl = 'https://www.amazon.com/s?i=videogames-intl-ship'

headers = {

"authority": "www.amazon.com",

"user-agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 10_3_3 like Mac OS X) AppleWebKit/603.3.8 (KHTML, like Gecko) Mobile/14G60 MicroMessenger/6.5.19 NetType/4G Language/zh_TW",

}

proxies = getProxies()

resp = requests.get(spiderurl, headers=headers, proxies=proxies)

content = resp.content.decode('utf-8')

select = Selector(text=content)

nodes = select.xpath("//a[@title='product-detail']")

for node in nodes:

itemUrl = node.xpath("./@href").extract_first()

itemName = node.xpath("./div/h2/span/text()").extract_first()

if itemUrl and itemName:

itemUrl = urljoin(spiderurl,itemUrl)

proxies = getProxies()

res = requests.get(itemUrl, headers=headers, proxies=proxies)

content = res.content.decode('utf-8')

Select = Selector(text=content)

itemPic = Select.css('#main-image::attr(src)').extract_first()

itemPrice = Select.css('.a-offscreen::text').extract_first()

itemInfo = Select.css('#feature-bullets').extract_first()

data = {}

data['itemUrl'] = itemUrl

data['itemName'] = itemName

data['itemPic'] = itemPic

data['itemPrice'] = itemPrice

data['itemInfo'] = itemInfo

print(data)登入後複製通過上面的步驟,可以實現最基礎的亞馬遜的資訊獲取。

目前只獲得最基本的資料,若想獲得更多也可以自行修改xpath/css選擇器去拿到你想要的內容。而且穩定的動態IP能是你進行請求的時候少一點等待的時間,無論是編寫中的測試還是小批次的爬取,都能提升工作的效率。以上就是全部的內容。

以上就是用Python獲取Amazon亞馬遜的商品資訊的詳細內容,更多請關注TW511.COM其它相關文章!