【一月一本技術書】-【Go語言設計與實現】- 9月

Go : 2009.11.10

代表作:Docker、k8s、etcd

模仿C語言,目標:網際網路的C語言

講的晦澀難懂。。。。硬板。。放棄了好幾次才讀完。滿分10分,打6分。

下個月:Python資料結構與演演算法分析吧。需要演演算法刷題了。

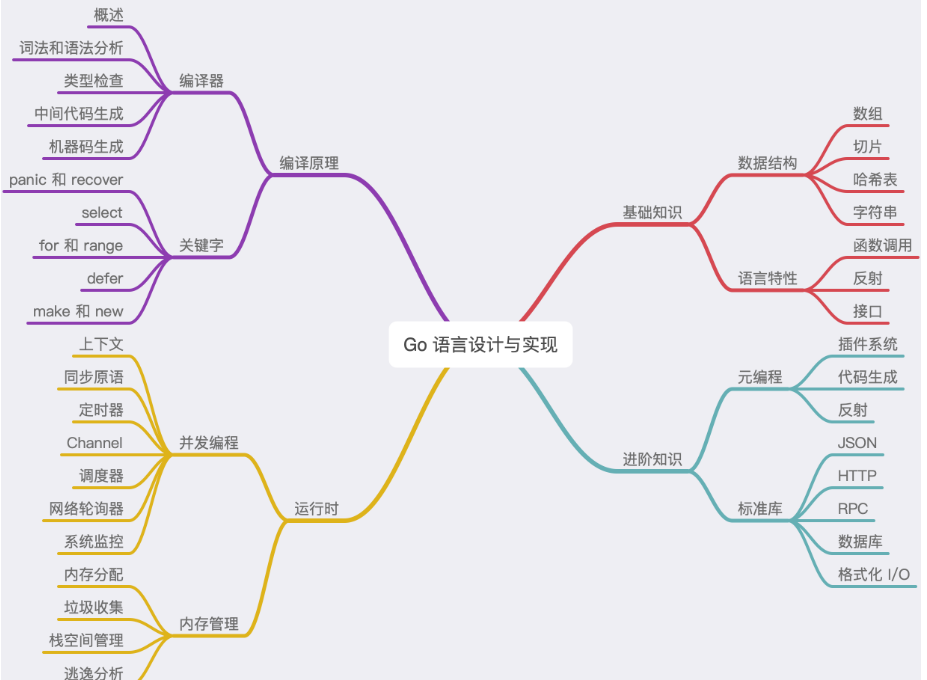

四大:編譯原理、基礎知識、執行時、進階知識

編譯原理

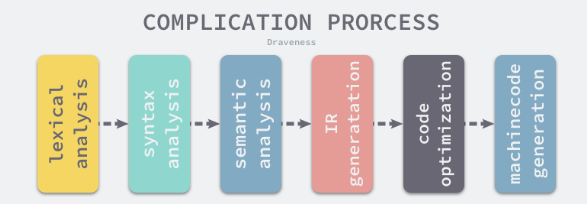

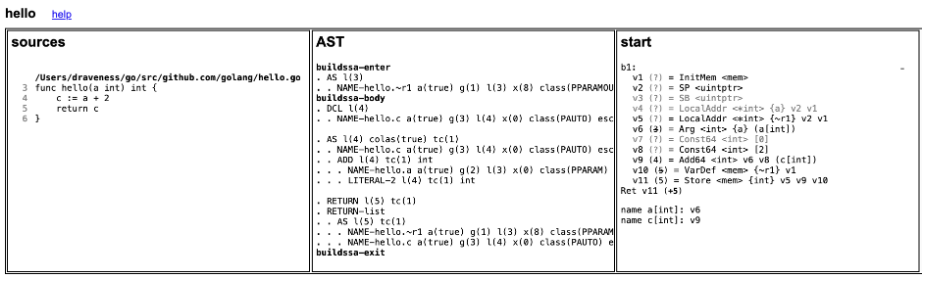

編譯過程

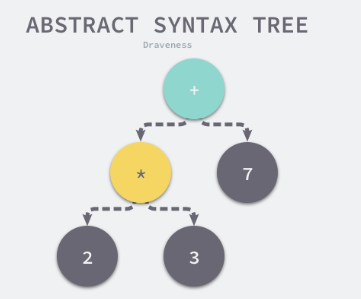

抽象語法樹 Abstract Syntax Tree\ AST\ 是原始碼語法的結構的一種抽象表示。

用樹狀的方式表示程式語言的語法結構。每一個節點表示原始碼的一個元素。每一顆子樹表示一個語法元素。

2 * 3 + 7

抽象語法樹抹去了原始碼中不重要的一些字元:空格、分號、括號等

靜態單賦值Static Single Assignment\SSA 是中間程式碼的特性。

每個變數只會被賦值一次。 優化

x := 1 # 無效

x := 2 # 有效

y := x

x_1 := 1 # 無效,編譯後,沒有這個玩意了

x_2 := 2

y_1 := x_2

指令集

- 複雜指令集 CISC: 通過增加指令的型別減少需要執行的指令數

- 精簡指令集 RISC: 使用更少的指令型別完成目標計算任務

編譯原理

編譯器程式碼:src/cmd/compile目錄中

編譯器分為 前端和後端

- 前端: 詞法分析、語法分析、型別檢查、中間程式碼生成

- 後端: 目的碼的生成、優化;將中間程式碼翻譯成目標機器能夠執行的二進位制機器碼

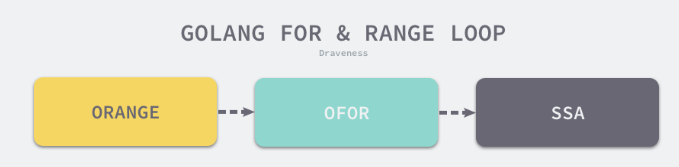

四個階段:詞法和語法分析、型別檢查和AST轉換、通用SSA生成、機器程式碼生成

- 詞法和語法分析

解析原始碼檔案開始,詞法分析的作用就是解析原始碼檔案。將字串序列轉換成Token序列。方便後面的處理和解析。

執行詞法分析的程式稱為 詞法解析器 lexer

語法分析的輸入是詞法分析器輸出的Token序列。根據程式語言定義好的文法 Grammar分析Token序列。

每一個go的原始碼檔案最終會被歸納成一個SourceFile結構。

SourceFile = PackageClause ";" { ImportDecl ";" } { TopLevelDecl ";" } .

詞法分析器會返回一個不包含空格、換行等字元的Token序列。 package,json,import,(,io,)...

語法分析器會把Token序列轉換成有意義的結構體---語法樹,AST.

"json.go": SourceFile {

PackageName: "json",

ImportDecl: []Import{

"io",

},

TopLevelDecl: ...

}

一個原始檔對應著一個AST. 包含:包名、定義的常數、結構體和函數。

GO使用的語法解析器是LALR(1)的文法。

語法解析的過程中發生的任何語法錯誤都會被語法解析器發現並列印到標準輸出上。

- 型別檢查

AST生成之後。編譯器會對語法樹中定義和使用的型別進行檢查。

- 常數、型別和函數名及型別

- 變數的賦值和初始化

- 函數和閉包的主體

- 雜湊鍵值對的型別

- 匯入函數體

- 外部的宣告

遍歷整顆抽象語法樹,保證節點不存在型別錯誤,

-

中間程式碼生成

型別檢查之後就不存在語法錯誤了,編譯器就會將AST轉換成中間程式碼

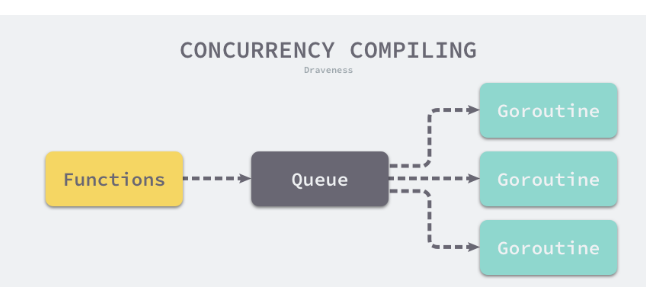

會使用gc.compileFunctions編譯整個Go語言專案中的全部函數。並行編譯

-

機器碼生成

不同型別的CPU分別使用不同的包生成機器碼,amd64、arm、arm64、mips、mips64、ppc64、s390x、x86、wasm.

Go語言的編譯器能夠生成Wasm WebAssembly 格式的指令,就可以執行在常見的主流瀏覽器中。

編譯器入口

src/cmd/complie/internal/gc/main.go。

抽象語法樹會經歷型別檢查、SSA 中間程式碼生成以及機器碼生成三個階段

檢查常數、型別和函數的型別;

處理變數的賦值;

對函數的主體進行型別檢查;

決定如何捕獲變數;

檢查行內函式的型別;

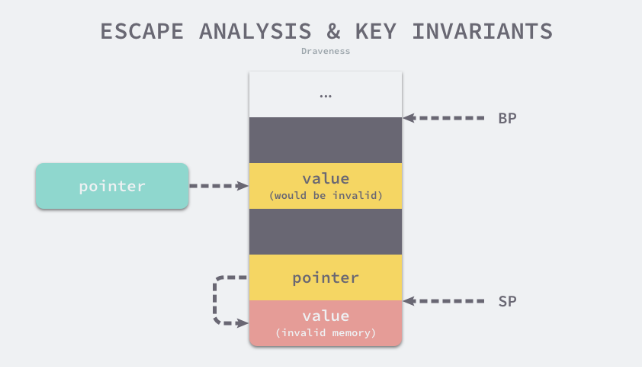

進行逃逸分析;

將閉包的主體轉換成參照的捕獲變數;

編譯頂層函數;

檢查外部依賴的宣告

詞法分析和語法分析

原始碼對於計算機來說是無法被理解的字串。

第一步:將字串分組。如下分為 make、 chan、 int 和 括號

make(chan int)

詞法分析是將字元序列轉換為標記(token)序列的過程。

- lex

lex是用於生成詞法分析器的工具。

lex生成的程式碼能夠將一個檔案中的字元分解成Token序列。

lex就是一個正則匹配的生成器。

lex檔案範例:

%{

#include <stdio.h>

%}

%%

package printf("PACKAGE "); # 解析package

import printf("IMPORT "); # 解析 import

\. printf("DOT "); # 解析點

\{ printf("LBRACE ");

\} printf("RBRACE ");

\( printf("LPAREN ");

\) printf("RPAREN ");

\" printf("QUOTE ");

\n printf("\n");

[0-9]+ printf("NUMBER ");

[a-zA-Z_]+ printf("IDENT ");

%%

這個lex檔案就可以解析下面這段程式碼

package main

import (

"fmt"

)

func main() {

fmt.Println("Hello")

}

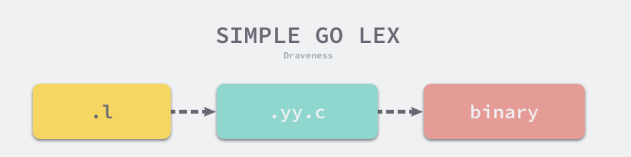

.l結尾的lex程式碼並不能直接執行,通過lex命令將上面的.l展開成C語音程式碼。

$ lex simplego.l

$ cat lex.yy.c

...

int yylex (void) {

...

while ( 1 ) {

...

yy_match:

do {

register YY_CHAR yy_c = yy_ec[YY_SC_TO_UI(*yy_cp)];

if ( yy_accept[yy_current_state] ) {

(yy_last_accepting_state) = yy_current_state;

(yy_last_accepting_cpos) = yy_cp;

}

while ( yy_chk[yy_base[yy_current_state] + yy_c] != yy_current_state ) {

yy_current_state = (int) yy_def[yy_current_state];

if ( yy_current_state >= 30 )

yy_c = yy_meta[(unsigned int) yy_c];

}

yy_current_state = yy_nxt[yy_base[yy_current_state] + (unsigned int) yy_c];

++yy_cp;

} while ( yy_base[yy_current_state] != 37 );

...

do_action:

switch ( yy_act )

case 0:

...

case 1:

YY_RULE_SETUP

printf("PACKAGE ");

YY_BREAK

...

}

lex.yy.c的前600行基本是宏和函數的宣告和定義。後面的程式碼大都是yylex這個函數服務的。

這個函數使用有限自動機 Deterministic Finite Automaton\DFA.的程式結構來分析輸入的字元流。

lex.yy.c編譯成二進位制可執行檔案,就是詞法分析器。

把GO語言程式碼作為輸入傳遞到詞法分析器中。會生成如下內容。

$ cc lex.yy.c -o simplego -ll

$ cat main.go | ./simplego

PACKAGE IDENT

IMPORT LPAREN

QUOTE IDENT QUOTE

RPAREN

IDENT IDENT LPAREN RPAREN LBRACE

IDENT DOT IDENT LPAREN QUOTE IDENT QUOTE RPAREN

RBRACE

lex生成的詞法分析器lexer通過正則匹配的方式將機器原本很難理解的字串分解成很多的Token. 有利於後面的處理。

從.l檔案到二進位制如下。

GO語言的詞法解析是通過scanner.go檔案中的syntax.scanner結構體實現的。

type scanner struct {

source

mode uint

nlsemi bool

// current token, valid after calling next()

line, col uint

blank bool // line is blank up to col

tok token

lit string // valid if tok is _Name, _Literal, or _Semi ("semicolon", "newline", or "EOF"); may be malformed if bad is true

bad bool // valid if tok is _Literal, true if a syntax error occurred, lit may be malformed

kind LitKind // valid if tok is _Literal

op Operator // valid if tok is _Operator, _AssignOp, or _IncOp

prec int // valid if tok is _Operator, _AssignOp, or _IncOp

}

tokens.go定義了go語言中支援的全部Token類。

例如操作符、括號和關鍵字等。

const (

_ token = iota

_EOF // EOF

// operators and operations

_Operator // op

...

// delimiters

_Lparen // (

_Lbrack // [

...

// keywords

_Break // break

...

_Type // type

_Var // var

tokenCount //

)

語言中的元素分成幾個不同的型別,分別是名稱和字面量、操作符、分割符、關鍵字。

語法分析

根據某種特定的形式文法Grammar.對Token序列構成的輸入文字進行分析並確定其語法結構的過程。

- 文法

上下文無關文法 是用來形式化、精確描述某種程式語言的工具。

通過文法定義一種語言的語法。包含一系列用於轉換字串的生產規則 Production Rule.

上下文無關文法中的每一個生產規則 都會將 規則左側的非終結符 轉換成 右側的字串。

終結符是文法中無法再被展開的符號。比如: ‘id’、 123

文法都由以下四個部分組成

- N 有限個非終結符的集合。

2)Σ 有限個終結符的集合

3)P 有限個生產規則12的集合;

4)S 非終結符集合中唯一的開始符號;

文法被定義成一個四元組 (N,Σ,P,S)

S→aSb

S→ab

S→ϵ

上述規則構成的文法就能夠表示 ab、aabb 以及 aaa..bbb 等字串,程式語言的文法就是由這一系列的生產規則表示的

SourceFile = PackageClause ";" { ImportDecl ";" } { TopLevelDecl ";" } .

PackageClause = "package" PackageName .

PackageName = identifier .

ImportDecl = "import" ( ImportSpec | "(" { ImportSpec ";" } ")" ) .

ImportSpec = [ "." | PackageName ] ImportPath .

ImportPath = string_lit .

TopLevelDecl = Declaration | FunctionDecl | MethodDecl .

Declaration = ConstDecl | TypeDecl | VarDecl .

每個Go語言程式碼檔案最終都會被解析成一個獨立的抽象語法樹。所以語法樹最頂層的結構或者開始符號都是SourceFile:

SourceFile = PackageClause ";" { ImportDecl ";" } { TopLevelDecl ";" } .

每一個檔案都包含一個package的定義 以及可選的 import。 和 其他的頂層宣告 TopLevelDecl。

每一個sourceFile在編譯器中都對應一個syntax.File結構體

type File struct {

Pragma Pragma

PkgName *Name

DeclList []Decl

Lines uint

node

}

頂層宣告有5大型別:分別是常數、型別、變數、函數和方法

- 分析方法

1)自定向下分析:

2)自底向上分析

型別檢查

得到抽象語法樹之後開始型別檢查。

術語:強型別、弱型別、靜態型別、動態型別、編譯、解釋

-

強型別定義:在編譯期間會有嚴格的型別限制。編譯器會在編譯期間發生變數複製、返回值和函數呼叫時的型別錯誤。

-

弱型別定義:型別錯誤可能出現在執行時 進行隱式的型別轉換,

java在編譯期間進行型別檢查的程式語言是強型別的

GO語言一樣。

型別的轉換是顯示的還是隱式的

編譯器會幫助我們推斷型別變數嗎。 -

靜態型別 檢查

對原始碼的分析來確定 執行程式 型別安全的過程。能夠減少程式在執行時的型別檢查。可以看作是程式碼優化的方式

靜態型別檢查能夠幫助我們在編譯期間發現程式中出現的型別錯誤。

一些動態型別的程式語言都會為這些程式語言加入靜態型別檢查。 javascript的Flow. -

動態型別 檢查

執行時確定型別安全的過程。

只使用動態型別檢查的程式語言叫做動態型別程式設計於洋。 js ruby php.

靜態和動態型別檢查不是完全衝突和對立的。

Java 不僅在編譯期間提前檢查型別發現型別錯誤,還為物件新增了型別資訊,在執行時使用反射根據物件的型別動態地執行方法增強靈活性並減少冗餘程式碼。

執行過程

GO編譯器 不僅使用靜態型別檢查來保證程式執行的型別安全,還會在程式設計期間引入型別資訊,能夠使用反射來判斷引數和變數的型別。

gc.Main函數

for i := 0; i < len(xtop); i++ {

n := xtop[i]

if op := n.Op; op != ODCL && op != OAS && op != OAS2 && (op != ODCLTYPE || !n.Left.Name.Param.Alias) {

xtop[i] = typecheck(n, ctxStmt)

}

}

for i := 0; i < len(xtop); i++ {

n := xtop[i]

if op := n.Op; op == ODCL || op == OAS || op == OAS2 || op == ODCLTYPE && n.Left.Name.Param.Alias {

xtop[i] = typecheck(n, ctxStmt)

}

}

...

checkMapKeys()

這段程式碼分為倆部分。

gc.typecheck()函數檢查常數、型別函數宣告以及變數賦值語句的型別。

gc.checkMapKeys()檢查雜湊中鍵的型別。

cmd/compile/internal/gc.typecheck1 根據傳入節點 Op 的型別進入不同的分支,其中包括加減乘數等操作符、函數呼叫、方法呼叫等 150 多種,因為節點的種類很多,所以這裡只節選幾個典型案例深入分析。

func typecheck1(n *Node, top int) (res *Node) {

switch n.Op {

case OTARRAY:

...

case OTMAP:

...

case OTCHAN:

...

}

...

return n

}

- 切片 OTARRATY

如果當前節點的操作型別是OTARRAY.那麼這個分支首先會對右節點,進行型別檢查。

case OTARRAY:

r := typecheck(n.Right, Etype)

if r.Type == nil {

n.Type = nil

return n

}

然後根據當前節點的左節點不容。分三種 [] int、 [...] int 、[3] int

第一種直接呼叫 types.NewSlice,直接返回了一個 TSLICE 型別的結構體.元素的型別資訊也會儲存在結構體總。

if n.Left == nil {

t = types.NewSlice(r.Type)

第二種會呼叫gc.typecheckcomplit處理。

func typecheckcomplit(n *Node) (res *Node) {

...

if n.Right.Op == OTARRAY && n.Right.Left != nil && n.Right.Left.Op == ODDD {

n.Right.Right = typecheck(n.Right.Right, ctxType)

if n.Right.Right.Type == nil {

n.Type = nil

return n

}

elemType := n.Right.Right.Type

length := typecheckarraylit(elemType, -1, n.List.Slice(), "array literal")

n.Op = OARRAYLIT

n.Type = types.NewArray(elemType, length)

n.Right = nil

return n

}

...

}

第三種。呼叫type.NewArray初始化一個儲存著陣列中元素型別和陣列大小的結構體。

} else {

n.Left = indexlit(typecheck(n.Left, ctxExpr))

l := n.Left

v := l.Val()

bound := v.U.(*Mpint).Int64()

t = types.NewArray(r.Type, bound) }

n.Op = OTYPE

n.Type = t

n.Left = nil

n.Right = nil

- 雜湊 OTMAP

如果處理的節點是雜湊,那麼編譯器會分別檢查雜湊的鍵值型別以驗證它們型別的合法性:

case OTMAP:

n.Left = typecheck(n.Left, Etype)

n.Right = typecheck(n.Right, Etype)

l := n.Left

r := n.Right

n.Op = OTYPE

n.Type = types.NewMap(l.Type, r.Type)

mapqueue = append(mapqueue, n)

n.Left = nil

n.Right = nil

中間程式碼生成

經過詞法與語法分析和型別檢查倆個部分之後,AST已經不存在語法錯誤了。

編譯器的後端工作--中間程式碼生成。

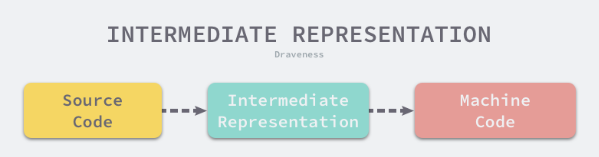

中間程式碼

中間程式碼是編譯器或虛擬機器器使用的語言。可以來幫助我們分析計算機程式。

編譯器在將原始碼轉換到機器碼的過程中,先把原始碼換成一種中間的表示形式。 即中間程式碼。

很多編譯器需要將原始碼翻譯成多種機器碼,直接翻譯高階程式語言相對比較困難。拆成中間程式碼生成和機器碼生成。

中間程式碼是更接近機器語言的表示形式。

cmd/compile/internal/gc.funccompile 編譯函數

func Main(archInit func(*Arch)) {

...

initssaconfig()

for i := 0; i < len(xtop); i++ {

n := xtop[i]

if n.Op == ODCLFUNC {

funccompile(n)

}

}

compileFunctions()

}

設定初始化和函數編譯倆部分。

設定初始化

SSA設定的初始化過程是中間程式碼生成之前的準備工作,會快取可能用到的型別指標、初始化SSA設定和一些之後會呼叫的執行時函數。

func initssaconfig() {

types_ := ssa.NewTypes()

_ = types.NewPtr(types.Types[TINTER]) // *interface{}

_ = types.NewPtr(types.NewPtr(types.Types[TSTRING])) // **string

_ = types.NewPtr(types.NewPtr(types.Idealstring)) // **string

_ = types.NewPtr(types.NewSlice(types.Types[TINTER])) // *[]interface{}

..

_ = types.NewPtr(types.Errortype) // *error

這個函數分為三部分

1)呼叫ssa.NewTypes()初始化ssa.Types結構體。並呼叫types.NewPtr函數快取型別的資訊。比如Bool Int8 String等。

types.NewPtr函數的主要作用是根據型別生成指向這些型別的指標。同時會根據編譯器的設定將 生成的指標型別快取在當前型別中。優化型別指標的獲取效率。

func NewPtr(elem *Type) *Type {

if t := elem.Cache.ptr; t != nil {

if t.Elem() != elem {

Fatalf("NewPtr: elem mismatch")

}

return t

}

t := New(TPTR)

t.Extra = Ptr{Elem: elem}

t.Width = int64(Widthptr)

t.Align = uint8(Widthptr)

if NewPtrCacheEnabled {

elem.Cache.ptr = t

}

return t

}

- 根據當前的CPU架構初始化SSA設定。

ssaConfig = ssa.NewConfig(thearch.LinkArch.Name, *types_, Ctxt, Debug['N'] == 0)

輸入引數:CPU架構、ssa.Types結構體、上下文資訊、Debug設定。

生成中間程式碼和機器碼的函數。當前編譯器使用的指標、暫存器大小、可用暫存器列表、掩碼等編譯選項

func NewConfig(arch string, types Types, ctxt *obj.Link, optimize bool) *Config {

c := &Config{arch: arch, Types: types}

c.useAvg = true

c.useHmul = true

switch arch {

case "amd64":

c.PtrSize = 8

c.RegSize = 8

c.lowerBlock = rewriteBlockAMD64

c.lowerValue = rewriteValueAMD64

c.registers = registersAMD64[:]

...

case "arm64":

...

case "wasm":

default:

ctxt.Diag("arch %s not implemented", arch)

}

c.ctxt = ctxt

c.optimize = optimize

...

return c

}

設定一旦建立,整個編譯期間都是唯讀的。並且被全部編譯階段共用。

3)最後,會初始化 一些編譯器可能用到的Go語言執行時函數

assertE2I = sysfunc("assertE2I")

assertE2I2 = sysfunc("assertE2I2")

assertI2I = sysfunc("assertI2I")

assertI2I2 = sysfunc("assertI2I2")

deferproc = sysfunc("deferproc")

Deferreturn = sysfunc("deferreturn")

...

遍歷和替換

在生成中間程式碼之前,編譯器還需要替換AST中節點的一些元素。go.walk等函數實現。

func walk(fn *Node)

func walkappend(n *Node, init *Nodes, dst *Node) *Node

...

func walkrange(n *Node) *Node

func walkselect(sel *Node)

func walkselectcases(cases *Nodes) []*Node

func walkstmt(n *Node) *Node

func walkstmtlist(s []*Node)

func walkswitch(sw *Node)

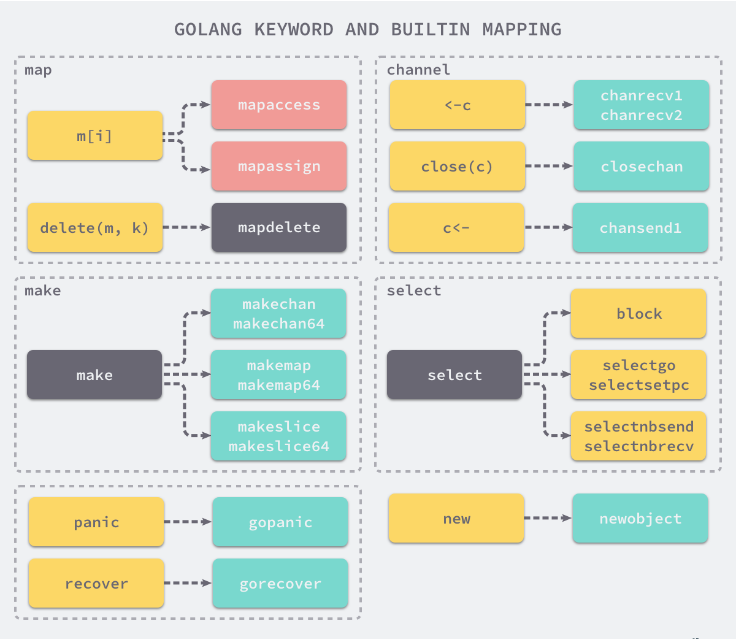

這些用於遍歷抽象語法樹的函數會將一些關鍵字和內建函數轉換成函數呼叫

例如: 上述函數會將 panic、recover 兩個內建函數轉換成 runtime.gopanic 和 runtime.gorecover 兩個真正執行時函數,而關鍵字 new 也會被轉換成呼叫 runtime.newobject 函數。

編譯器會將Go語言關鍵字轉換成執行時包中的函數,

SSA生成

經過walk函數處理之後,AST就不會再變了。會使用gc.compileSSA將抽象語法樹轉換成中間程式碼。

func compileSSA(fn *Node, worker int) {

f := buildssa(fn, worker) # 負責生成具有SSA特色的中間程式碼

pp := newProgs(fn, worker)

genssa(f, pp)

pp.Flush()

}

中間程式碼的生成過程是從 AST 抽象語法樹到 SSA 中間程式碼的轉換過程,在這期間會對語法樹中的關鍵字再進行改寫,改寫後的語法樹會經過多輪處理轉變成最後的 SSA 中間程式碼,相關程式碼中包括了大量 switch 語句、複雜的函數和呼叫棧

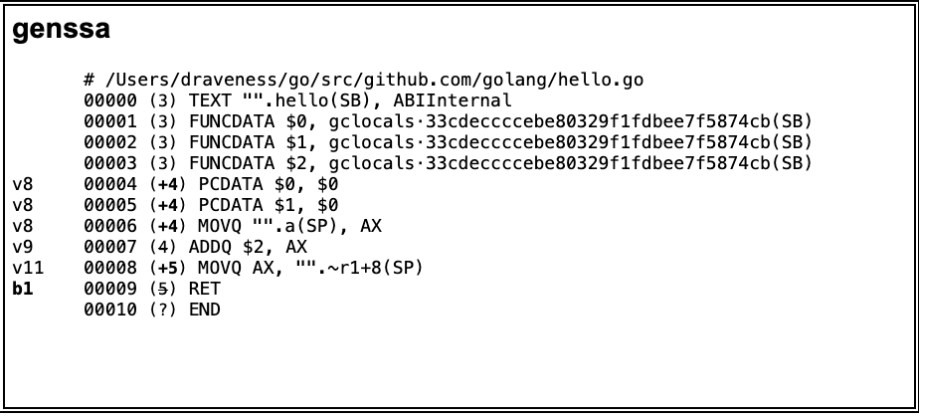

機器碼生成

編譯的最後一個階段是根據SSA中間程式碼生成機器碼,這裡的機器碼是在目標CPU架構上能夠執行的二進位制程式碼。

中間程式碼的降級Lower過程。在降級過程中,編譯器將一些值重寫成了目標CPU架構的特定值。

指令集架構

指令集架構是 計算機的抽象模型。它是計算機軟體和硬體之間的介面和橋樑。

每一個指令集架構都定義了 支援 的資料結構、暫存器、管理主記憶體的硬體支援(記憶體一致、地址模型、虛擬記憶體)、支援的指令集合IO模型。

讓同一個二進位制檔案能夠在不同版本的硬體上執行。

機器碼生成

倆部分協同工作

1)負責SSA中間程式碼降級和根據目標架構進行特定處理的ssa包

2)負責生成機器碼的obj.

- SSA 降級

SSA 降級是在中間程式碼生成的過程中完成的,其中將近 50 輪處理的過程中,lower 以及後面的階段都屬於 SSA 降級這一過程,這麼多輪的處理會將 SSA 轉換成機器特定的操作

和組合程式碼非常相似。

組合器 #

組合器是將組合語言翻譯為機器語言的程式,Go 語言的組合器是基於 Plan 9 組合器的輸入型別設計的,

資料結構

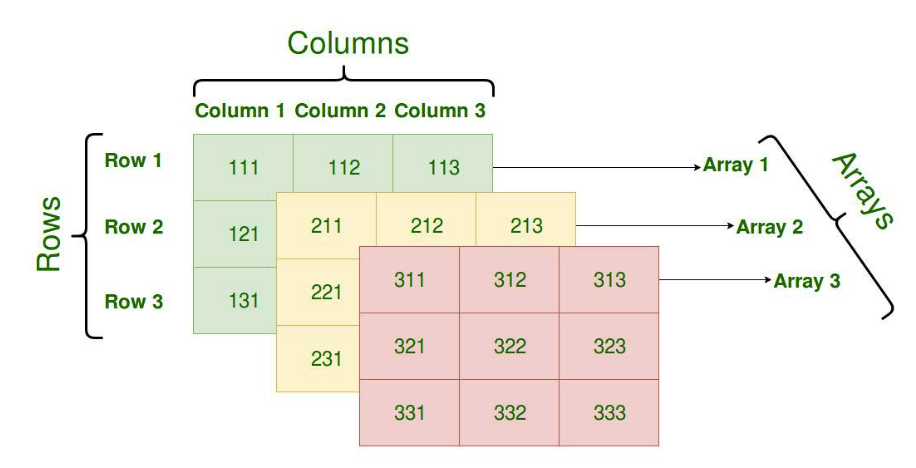

陣列

陣列和切片是Go語音中常見的資料結構

陣列是由相同型別元素的集合組成的資料結構。會為陣列分配一塊連續的記憶體來儲存其中的元素。

常見是一維的。多維的在數值和圖形領域

倆個維度來描述陣列,

1) 陣列中儲存的元素型別

2) 陣列最大能儲存的元素個數

[10] int

[200] interface{}

Go語言陣列在初始化之後,大小就無法改變。儲存元素型別相同、大小一致才是同一型別的陣列

func NewArray(elem *Type, bound int64) *Type {

if bound < 0 {

Fatalf("NewArray: invalid bound %v", bound)

}

t := New(TARRAY)

t.Extra = &Array{Elem: elem, Bound: bound}

t.SetNotInHeap(elem.NotInHeap())

return t

}

編譯期間的陣列型別是types.NewArray函數生成的。elem是元素型別,bound是陣列大小。

當前陣列是否應該在堆疊中初始化在編譯期間就確定了

初始化

倆種不同的建立方式

arr1 := [3] int{1,2,3} # 顯示指定陣列大小

arr2 = [...] int{1,2,3} # 宣告陣列,在編譯期推導陣列的大小

編譯器的推導過程

- 上限推導

倆種不同的宣告方式會做出不同的處理

[10]T 這種。變數型別在進行到型別檢查就會被提取出來。隨後使用types.NewArray建立 包含陣列大小的types.Array結構體

[...]T這種。會在gc.typecheckcomplit函數中對該陣列的大小進行推導。

func typecheckcomplit(n *Node) (res *Node) {

...

if n.Right.Op == OTARRAY && n.Right.Left != nil && n.Right.Left.Op == ODDD {

n.Right.Right = typecheck(n.Right.Right, ctxType)

if n.Right.Right.Type == nil {

n.Type = nil

return n

}

elemType := n.Right.Right.Type

length := typecheckarraylit(elemType, -1, n.List.Slice(), "array literal")

n.Op = OARRAYLIT

n.Type = types.NewArray(elemType, length)

n.Right = nil

return n

}

...

switch t.Etype {

case TARRAY:

typecheckarraylit(t.Elem(), t.NumElem(), n.List.Slice(), "array literal") # 遍歷計算

n.Op = OARRAYLIT

n.Right = nil

}

}

呼叫typecheckarryalit通過遍歷元素的方式來計算陣列中元素的數量

- 語句轉換

由一個字面量組成的陣列,根據陣列元素數量的不同。編譯器會在負責初始化字面量的gc.anylit函數中做倆種不同的優化

1)當元素數量<= 4 ,會直接將陣列中的元素放置在棧上

2)>4 ,會將陣列中的元素放置到靜態區,並在執行時 取出

存取和賦值

無論是在棧上,還是靜態儲存區。 陣列在記憶體中都是一連串的記憶體空間。

指向陣列開頭的指標、元素的數量、元素型別佔的空間大小 三個 維度來表示一個陣列。

陣列存取越界是非常嚴重的錯誤,Go 語言中可以在編譯期間的靜態型別檢查判斷陣列越界。

陣列和字串的一些簡單越界錯誤都會在編譯期間發現。

比如:直接使用整數或者常數存取陣列,但是使用變數去存取陣列或字串時,就無法提前發現錯誤。

需要go語言在執行時阻止不合法的存取

arr[4]: invalid array index 4 (out of bounds for 3-element array)

arr[i]: panic: runtime error: index out of range [4] with length 3

越界操作會由執行時的runtime.panicIndex和runtime.goPanicIndex觸發程式的執行時錯誤,並導致程式崩潰退出

TEXT runtime·panicIndex(SB),NOSPLIT,$0-8

MOVL AX, x+0(FP)

MOVL CX, y+4(FP)

JMP runtime·goPanicIndex(SB)

func goPanicIndex(x int, y int) {

panicCheck1(getcallerpc(), "index out of range")

panic(boundsError{x: int64(x), signed: true, y: y, code: boundsIndex})

}

當陣列的存取操作,OINDEX 成功通過編譯器檢查後,會被轉換成幾個SSA指令,

package check

func outOfRange() int {

arr := [3]int{1, 2, 3}

i := 4

elem := arr[i]

return elem

}

$ GOSSAFUNC=outOfRange go build array.go

dumped SSA to ./ssa.html

start階段生成的SSA程式碼就是優化之前的第一版中間程式碼。

elem := arr[i]中間程式碼如下

b1:

...

v22 (6) = LocalAddr <*[3]int> {arr} v2 v20

v23 (6) = IsInBounds <bool> v21 v11

If v23 → b2 b3 (likely) (6)

b2: ← b1-

v26 (6) = PtrIndex <*int> v22 v21

v27 (6) = Copy <mem> v20

v28 (6) = Load <int> v26 v27 (elem[int])

...

Ret v30 (+7)

b3: ← b1-

v24 (6) = Copy <mem> v20

v25 (6) = PanicBounds <mem> [0] v21 v11 v24

Exit v25 (6)

對陣列存取操作生成了判斷陣列上限的指令 IsInBounds 以及當條件不滿足時,觸發程式崩潰的PanicBounds指令。

編譯器會將PanicBounds指令轉換成runtime.panicIndex函數。當陣列下標沒有越界時,編譯器會先獲取陣列的記憶體地址和存取的下標。利用PtrIndex計算出目標元素的地址。最後使用Load操作將指標中的元素載入到記憶體中。

編譯器無法判斷下標是否越界,會將PanicBounds指令交給執行時進行判斷。

改成整數存取,中間程式碼如下

b1:

...

v21 (5) = LocalAddr <*[3]int> {arr} v2 v20

v22 (5) = PtrIndex <*int> v21 v14

v23 (5) = Load <int> v22 v20 (elem[int])

...

賦值的過程中會先確定目標陣列的地址,再通過 PtrIndex 獲取目標元素的地址,最後使用 Store 指令將資料存入地址中,從上面的這些 SSA 程式碼中我們可以看出 陣列定址和賦值都是在編譯階段完成的,沒有執行時的參與。

b1:

...

v21 (5) = LocalAddr <*[3]int> {arr} v2 v19

v22 (5) = PtrIndex <*int> v21 v13

v23 (5) = Store <mem> {int} v22 v20 v19

...

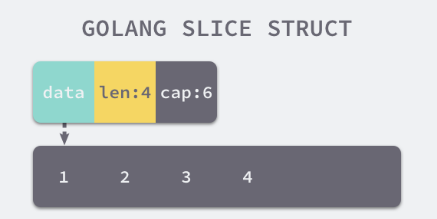

切片

陣列在go語言中沒那麼常用,更常用的資料結構是切片, 即動態陣列,長度不固定,可以向切片中追加元素。它會在容量不足時自動擴容。

宣告方式不需要指定切片中的元素個數,只需要指定元素型別

[] int

[] interface{}

編譯期生成型別只包含切片中的元素型別。

func NewSlice(elem *Type) *Type {

if t := elem.Cache.slice; t != nil {

if t.Elem() != elem {

Fatalf("elem mismatch")

}

return t

}

t := New(TSLICE)

t.Extra = Slice{Elem: elem}

elem.Cache.slice = t

return t

}

編譯期間的切片是types.Slice型別的,執行時切片有reflect.SliceHeader結構體表示

type SliceHeader struct {

Data uintptr # 指向陣列的指標

Len int # 當前切片的長度

Cap int # 當前切片的容量

}

Data是一片連續的記憶體空間。這片記憶體空間用於儲存切片中的全部元素。

切片與陣列的關係非常密切。切片引入了一個抽象層。提供了對陣列中部分連續片段的參照。而作為陣列的參照。我們可以在執行區間修改它的長度和範圍。當切片底層陣列長度不足時就會觸發擴容,切片指向的陣列可能會發生變化。但是上層感知不到。上層只與切片打交道。

切片初始化

arr[0:3] or slice[0:3] # 通過下班獲取一部分

slice := [] int {1,2,3} # 字面量初始化

slice := make([]int, 10) # make建立

- 使用下標

最接近組合語言的方式。轉換成OpSliceMack操作。

// ch03/op_slice_make.go

package opslicemake

func newSlice() []int {

arr := [3]int{1, 2, 3}

slice := arr[0:1]

return slice

}

slice := arr[0:1] 對應如下的SSA中間程式碼

v27 (+5) = SliceMake <[]int> v11 v14 v17

name &arr[*[3]int]: v11

name slice.ptr[*int]: v11

name slice.len[int]: v14

name slice.cap[int]: v17

SliceMake 操作接收四個引數: 元素型別、陣列指標、切片大小、 容量。

下標初始化不會拷貝原陣列或原切片中的資料,只會建立一個指向原陣列的切片結構體。所以修改新切片的資料也會修改原切片。

- 字面量

[]int{1,2,3}, 編譯期間會展開如下程式碼片段

var vstat [3]int

vstat[0] = 1

vstat[1] = 2

vstat[2] = 3

var vauto *[3]int = new([3]int)

*vauto = vstat

slice := vauto[:]

- 根據切片中的元素數量對底層陣列的大小進行推斷並建立一個陣列

2)將這些字面量元素儲存到初始化陣列中。

3)建立一個同樣指向【3】int型別的陣列指標

4)將靜態儲存區的陣列vstat 複製給vauto指標所在的地址

5)通過[:] 操作獲取一個底層使用vauto的切片。

- 關鍵字

slice := make([]int, 10)

使用字面量建立切片,大部分工作在編譯期間完成,使用make關鍵字建立切片時,很多工作需要執行時的參與。

呼叫方法必須向make函數傳入切片的大小以及可選的容量。gc.typecheck1函數會檢驗入參。檢查len是否傳入,還會保證cap一定大於或等於len.還會將OMAKE節點轉換為OMAKESLICE。

go.walker會依據來個條件轉換OMAKESLICE型別的節點

1.切片的大小和容量是否足夠小

2.切片是否發生了逃逸,最終在堆上初始化。

當切片發生逃逸或者非常大時,執行時需要runtime.makeslice在堆上初始化切片。

如果切片不會發生逃逸並且切片非常小的時候,make([] int, 3,4)會直接被轉換成如下程式碼

var arr [4]int n := arr[:3]

建立切片的執行時函數runtime.makeslice

func makeslice(et *_type, len, cap int) unsafe.Pointer {

mem, overflow := math.MulUintptr(et.size, uintptr(cap))

if overflow || mem > maxAlloc || len < 0 || len > cap {

mem, overflow := math.MulUintptr(et.size, uintptr(len))

if overflow || mem > maxAlloc || len < 0 {

panicmakeslicelen()

}

panicmakeslicecap()

}

return mallocgc(mem, et, true)

}

主要工作是計算切片佔用的記憶體空間並在堆上申請一片連續的記憶體。

記憶體空間 = 切片中元素的大小 * 切片容量

雖然編譯期間可以檢查出很多錯誤,但是在建立切片的過程中如果發生了以下錯誤會直接觸發執行時錯誤並崩潰。

1.記憶體空間的大小發生了溢位

2.申請的記憶體大於最大可分配的記憶體

3.傳入的長度小於0 或者大於容量。

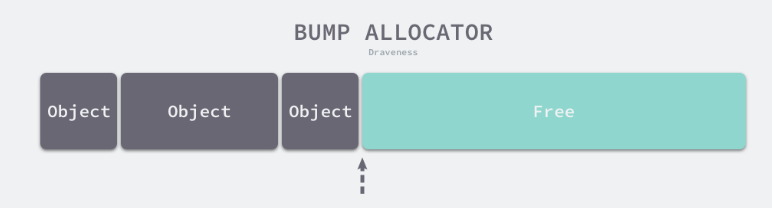

mallocgc是用於申請記憶體的函數,這個函數比較複雜,

如果遇到了較小的物件會直接初始化在Go語音排程器裡面的P結構中。而大於32KB的物件會在堆上初始化,

存取元素

使用len和cap獲取長度或者容量是切片最常見的操作。

對應倆個特殊操作 OLEN 和 OCAP.

SSA生成階段會轉換成OpSliceLen 和 OpSliceCap。可能會觸發decompose builtin階段的優化,len(slice) / cap(slice)在一些情況下會直接替換成切片的長度或者容量。不需要在執行時獲取。

(SlicePtr (SliceMake ptr _ _ )) -> ptr

(SliceLen (SliceMake _ len _)) -> len

(SliceCap (SliceMake _ _ cap)) -> cap

除了獲取切片的長度和容量之外,存取切片中元素使用的OINDEX操作也會在中間程式碼生成期間轉換成對地址的直接存取.

切片操作基本都是在編譯期間完成的。除了存取切片的長度、容量或者其中的元素之外。

編譯期間會將包含range關鍵字的遍歷轉換成形式更簡單的迴圈。

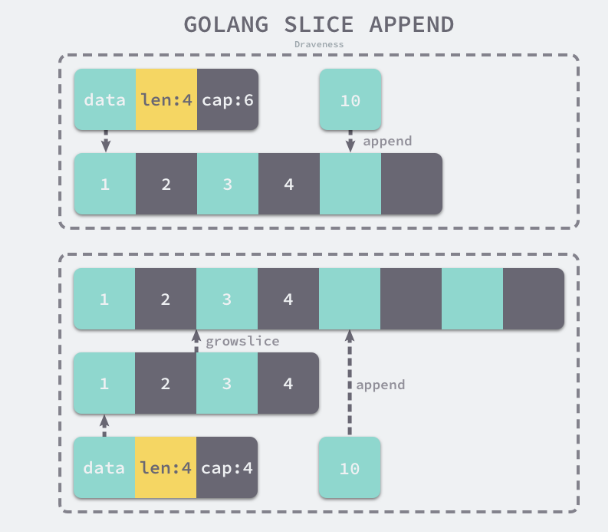

追加和擴容

使用append關鍵字向切片中追加元素。

中間程式碼生成階段的gc.state.append方法會根據返回值是否會覆蓋原變數,進入倆種流程。

如果append返回的新切片不需要賦值回原有的變數。進入如下

// append(slice, 1, 2, 3)

ptr, len, cap := slice

newlen := len + 3

if newlen > cap {

ptr, len, cap = growslice(slice, newlen)

newlen = len + 3

}

*(ptr+len) = 1

*(ptr+len+1) = 2

*(ptr+len+2) = 3

return makeslice(ptr, newlen, cap)

如果追加後切片的大小大於容量,那麼就會呼叫 growslice對切片進行擴容。然後依次將新的元素依次加入切片。

如果使用slice = append(slice,1,2,3)。那麼append後的切片會覆蓋原切片。

// slice = append(slice, 1, 2, 3)

a := &slice

ptr, len, cap := slice

newlen := len + 3

if uint(newlen) > uint(cap) {

newptr, len, newcap = growslice(slice, newlen)

vardef(a)

*a.cap = newcap

*a.ptr = newptr

}

newlen = len + 3

*a.len = newlen

*(ptr+len) = 1

*(ptr+len+1) = 2

*(ptr+len+2) = 3

是否覆蓋原變數的邏輯其實差不多。最大的區別在於得到的新切片是否會賦值回原變數。

如果我們選擇覆蓋原有的變數。就不需要擔心切片發生拷貝影響效能。

切片容量不足的處理流程。growslice.

擴容是為切片分配新的記憶體空間並拷貝原始切片中元素的過程。

func growslice(et *_type, old slice, cap int) slice {

newcap := old.cap

doublecap := newcap + newcap

if cap > doublecap {

newcap = cap

} else {

if old.len < 1024 {

newcap = doublecap

} else {

for 0 < newcap && newcap < cap {

newcap += newcap / 4

}

if newcap <= 0 {

newcap = cap

}

}

}

根據不同的容量選擇不同的策略

1.如果期望容量大於當前容量的倆倍,就會使用期望容量

2.如果當前切片的長度小於1024,就會將容量翻倍。

3.如果當前切片的長度大於1024,那麼就增加25%的容量。

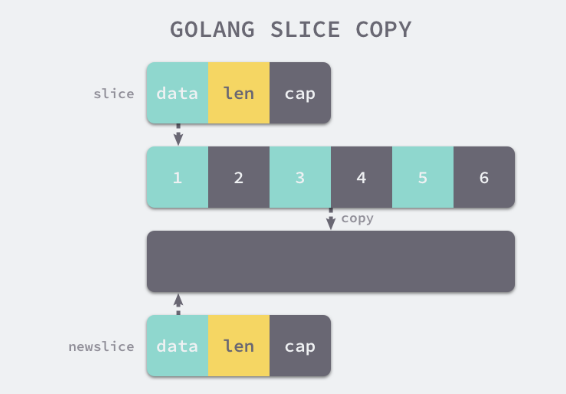

拷貝切片

copy(a,b)

gc.copyany分倆種情況進行處理。

如果當前copy不是在執行時呼叫的。直接替換成下面的程式碼

n := len(a)

if n > len(b) {

n = len(b)

}

if a.ptr != b.ptr {

memmove(a.ptr, b.ptr, n*sizeof(elem(a)))

}

執行 時發生,呼叫runtime.slicecopy

func slicecopy(to, fm slice, width uintptr) int {

if fm.len == 0 || to.len == 0 {

return 0

}

n := fm.len

if to.len < n {

n = to.len

}

if width == 0 {

return n

}

...

size := uintptr(n) * width

if size == 1 {

*(*byte)(to.array) = *(*byte)(fm.array)

} else {

memmove(to.array, fm.array, size)

}

return n

}

都通過runtime.memmove將整塊記憶體的內容拷貝到目標的記憶體區域中:

雜湊表

go語言的雜湊的實現原理。

陣列表示元素的序列。

雜湊表示的是鍵值對之間的對映關係。

設計原理

O(1)的讀寫效能。

提供了鍵值之間的對映。想要實現一個效能優異的雜湊表。需要注意倆個關鍵點---雜湊函數和衝突解決方法

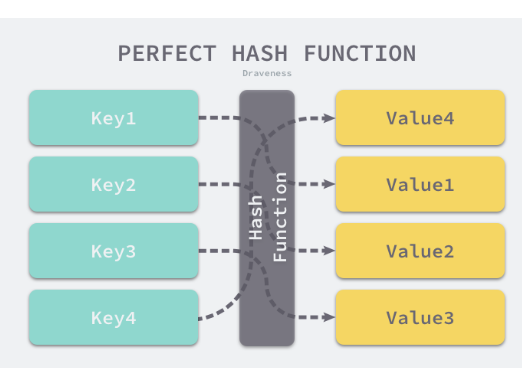

- 雜湊函數

雜湊函數的選擇在很大程度上 能夠決定雜湊表的讀寫效能。

理想的情況下,雜湊函數應該能夠將不同鍵 對映到不同的索引上。這就要求 雜湊函數的輸出範圍 > 輸入範圍

鍵的數量會遠遠大於對映的範圍。理想情況很難存在。

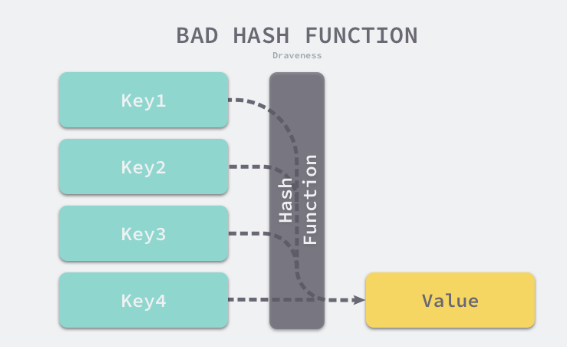

比較實際的方式是讓雜湊函數的結果 儘可能的均勻分佈。然後通過工程上的手段解決雜湊碰撞的問題。

不均勻的雜湊函數

-

衝突解決

通常情況下,雜湊函數的輸入範圍一定遠遠大於輸出範圍。

所以一定會遇到衝突。衝突不一定是雜湊完全相等。可能是部分相等。比如:前4個位元組相同。 -

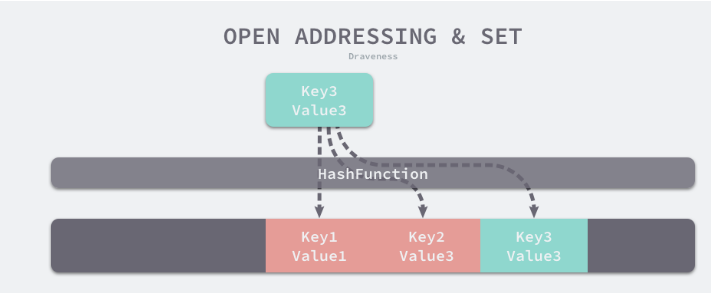

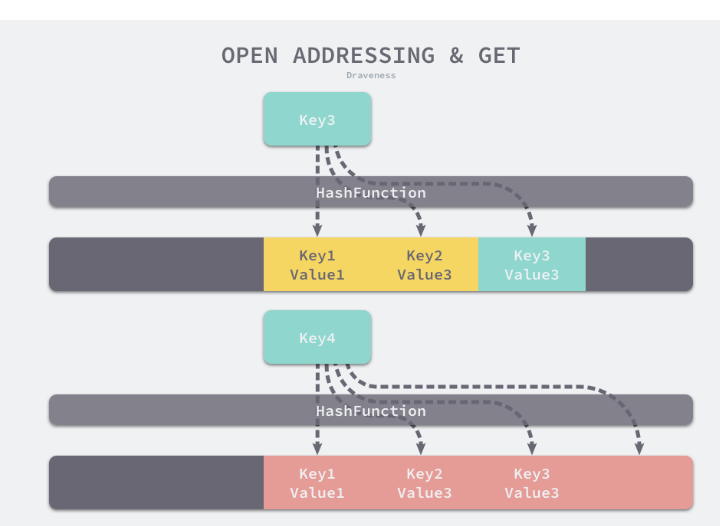

開放定址法

開放定址法 是一種在雜湊表中解決雜湊碰撞的方法。核心思想是依次探測和比較陣列中的元素以判斷目標鍵值對 是否存在於雜湊表中。

底層資料結構必須是陣列。陣列長度有限。所以向雜湊表寫入(author, draven)會從如下的索引開始遍歷

index := hash('author') % array.len

如果發生了衝突。會將鍵值對寫入到下一個索引不為空的位置。

讀取資料

開放地址法中對效能影響最大的是裝載因子。它是陣列中元素的數量與 陣列大小的比值。隨著裝載因子的增加。線性探測的平均用時就會逐漸增加。會影響雜湊表的讀寫效能。當裝載率超過70%之後。雜湊表的效能就會急劇下降。達到100%,就會完全失效。 -

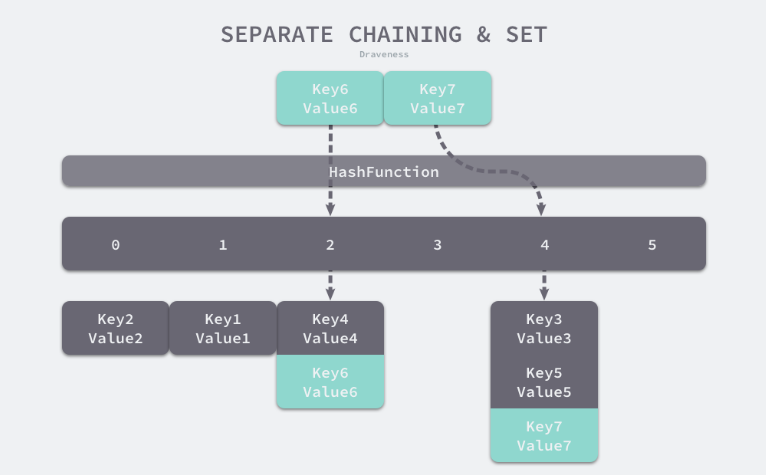

拉鍊法

拉鍊法是雜湊表最常見的實現方法。 資料結構使用陣列+連結串列。還會引入紅黑樹優化效能

雜湊函數會選擇一個桶,和開放地址法一樣,就是對雜湊返回的結果取模。

選擇了2號桶後就可以遍歷當前桶中的連結串列。在遍歷連結串列的時候會遇到以下倆種情況

1.找到鍵相同的鍵值對- 更新值

2.沒有找到-在連結串列末尾追加新的鍵值對

拉鍊法的裝載因子

裝載因子:= 元素數量 / 桶數量

當裝載因子變大是,讀寫效能也就越差。

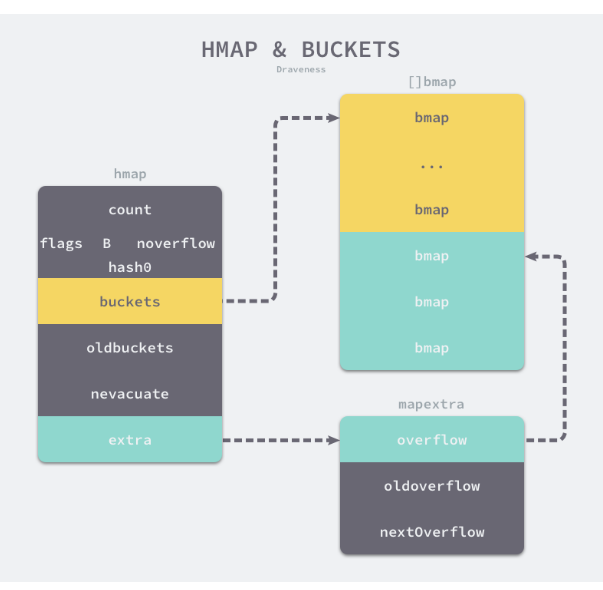

資料結構

go語言執行時同時使用了多個資料結構組合表示雜湊表。runtime.hmap是最核心的結構體。

type hmap struct {

count int # 當前雜湊表中的元素數量

flags uint8 #

B uint8 # 表示當前雜湊表持有的buckets 數量。

noverflow uint16

hash0 uint32 # 雜湊的種子。為雜湊函數的結果引入 隨機性

buckets unsafe.Pointer

oldbuckets unsafe.Pointer # 儲存之前的buckets的欄位

nevacuate uintptr

extra *mapextra

}

type mapextra struct {

overflow *[]*bmap

oldoverflow *[]*bmap

nextOverflow *bmap

}

每一個bmap都能夠儲存8個鍵值對。當雜湊表中儲存的資料過多。單個桶已經裝滿就會使用 extra.nextOverflow中桶儲存移除的資料。

上述倆種不同的桶在記憶體中是連續儲存的。分為正常桶(黃色桶)和溢位桶(綠色桶)

bmap,原始碼中 只包含一個tophash欄位。

type bmap struct {

tophash [bucketCnt]uint8

}

在執行期間不止包含tophash欄位

type bmap struct {

topbits [8]uint8

keys [8]keytype

values [8]valuetype

pad uintptr

overflow uintptr

}

雜湊表初始化

- 字面量

key:value的語法來表示鍵值對

hash := map[string]int{

"1": 2,

"3": 4,

"5": 6,

}

gc.maplit

func maplit(n *Node, m *Node, init *Nodes) {

a := nod(OMAKE, nil, nil)

a.Esc = n.Esc

a.List.Set2(typenod(n.Type), nodintconst(int64(n.List.Len())))

litas(m, a, init)

entries := n.List.Slice()

if len(entries) > 25 { # 雜湊表數量小於25個時,一次直接加入到雜湊表中

...

return

}

// Build list of var[c] = expr.

// Use temporaries so that mapassign1 can have addressable key, elem.

...

}

超過了25個,會建立倆個陣列分別儲存鍵值。會通過如下for迴圈加入雜湊

hash := make(map[string]int, 26)

vstatk := []string{"1", "2", "3", ... , "26"}

vstatv := []int{1, 2, 3, ... , 26}

for i := 0; i < len(vstak); i++ {

hash[vstatk[i]] = vstatv[i]

}

- 執行時

當建立的雜湊表被分配到棧上,並且容量小於BUCKETSIZE = 8時,GO語言在編譯階段會使用如下方式快速初始化雜湊。

var h *hmap

var hv hmap

var bv bmap

h := &hv

b := &bv

h.buckets = b

h.hash0 = fashtrand0()

讀寫操作

雜湊表的存取一般都是通過下標或者遍歷進行的。

_ = hash[key]

for k, v := range hash {

// k, v

}

- 存取

在編譯型別檢查期間,hash[key] 以及類似的 操作都會被轉換成雜湊的 OINDEXMAP操作。

中間程式碼生成階段會在gc.walkexpr 中間這些OINDEXMAP操作轉換成如下程式碼

v := hash[key] // => v := *mapaccess1(maptype, hash, &key)

v, ok := hash[key] // => v, ok := mapaccess2(maptype, hash, &key)

runtime.mapaccess1 會先通過雜湊表設定的雜湊函數、、種子獲取當前鍵對應的雜湊。再通過bucketMask和add拿到該鍵值對所在的桶序號和雜湊高位的8位元數位。

小結

Go 語言使用拉鍊法來解決雜湊碰撞的問題實現了雜湊表,它的存取、寫入和刪除等操作都在編譯期間轉換成了執行時的函數或者方法。雜湊在每一個桶中儲存鍵對應雜湊的前 8 位,當對雜湊進行操作時,這些 tophash 就成為可以幫助雜湊快速遍歷桶中元素的快取。

雜湊表的每個桶都只能儲存 8 個鍵值對,一旦當前雜湊的某個桶超出 8 個,新的鍵值對就會儲存到雜湊的溢位桶中。隨著鍵值對數量的增加,溢位桶的數量和雜湊的裝載因子也會逐漸升高,超過一定範圍就會觸發擴容,擴容會將桶的數量翻倍,元素再分配的過程也是在呼叫寫操作時增量進行的,不會造成效能的瞬時巨大抖動。

字串

如果是程式碼中存在的字串,編譯器會將其標記成唯讀資料SRODATA.

$ cat main.go

package main

func main() {

str := "hello"

println([]byte(str))

}

$ GOOS=linux GOARCH=amd64 go tool compile -S main.go

...

go.string."hello" SRODATA dupok size=5 # SRODATA標記

0x0000 68 65 6c 6c 6f hello

...

唯讀意味著字串會被分配到唯讀的記憶體空間。

可以通過在string 和 []byte 型別之間反覆轉換實現修改。

1.先講這段記憶體拷貝到堆或者棧上。

2.將變數的型別轉換成[] byte後,並修改位元組資料

3.將修改後的位元組陣列轉回string.

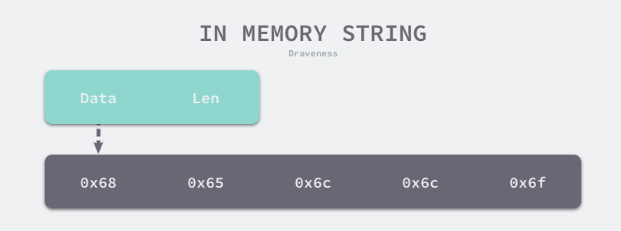

字串資料結構

type StringHeader struct {

Data uintptr # 指向位元組陣列的指標

Len int # 陣列大小

}

與切片相比,只少了一個表示容量的Cap欄位。字串就是一個唯讀的切片型別。

所有在字串上的寫入操作都是通過拷貝實現的。

字串 解析過程

解析器會在詞法分析階段解析字串。會對原始檔中的字串進行切片和分組。將原有的字元流轉換成Token序列。

倆種宣告

str1 := "this is a string"

str2 := `this is another

string`

雙引號和反引號。

雙引號:只能用於單行字串的初始化。如果內部出現雙引號需要\符合跳脫。

反引號:可以擺脫單行的限制。雙引號不再負責標記字串的開始和結束。在遇到json或者其他複雜資料格式的場景下非常方便。

字串拼接

+符號, 會將該符號對應的OADD節點轉換為OADDSTR型別的節點。然後呼叫gc.addstr函數生成用於拼接字串的程式碼

func walkexpr(n *Node, init *Nodes) *Node {

switch n.Op {

...

case OADDSTR:

n = addstr(n, init)

}

}

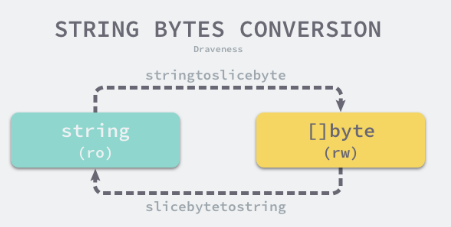

型別轉換

解析 和 序列化json等資料格式是,需要將資料在string和[]byte之間來回轉換。

從位元組陣列到字串的轉換需要使用runtime.slicebytesostring函數。例如:string(bytes),

長度為0和長度為1 的位元組陣列,處理起來比較簡單。

func slicebytetostring(buf *tmpBuf, b []byte) (str string) {

l := len(b)

if l == 0 {

return ""

}

if l == 1 {

stringStructOf(&str).str = unsafe.Pointer(&staticbytes[b[0]])

stringStructOf(&str).len = 1

return

}

var p unsafe.Pointer

if buf != nil && len(b) <= len(buf) {

p = unsafe.Pointer(buf)

} else {

p = mallocgc(uintptr(len(b)), nil, false)

}

stringStructOf(&str).str = p

stringStructOf(&str).len = len(b)

memmove(p, (*(*slice)(unsafe.Pointer(&b))).array, uintptr(len(b)))

return

}

處理過後會根據傳入的緩衝區大小決定是否需要為新字串分配一片記憶體空間。

字串轉換成[]byte型別時,需要使用runtime.stringtoslicebyte函數,

func stringtoslicebyte(buf *tmpBuf, s string) []byte {

var b []byte

if buf != nil && len(s) <= len(buf) {

*buf = tmpBuf{}

b = buf[:len(s)]

} else {

b = rawbyteslice(len(s))

}

copy(b, s)

return b

}

語言基礎

函數呼叫

函數是go語言的一等公民。

呼叫慣例

somefunction(arg0,arg1)

呼叫慣例是呼叫方和被呼叫方對於引數和返回值傳遞的約定。

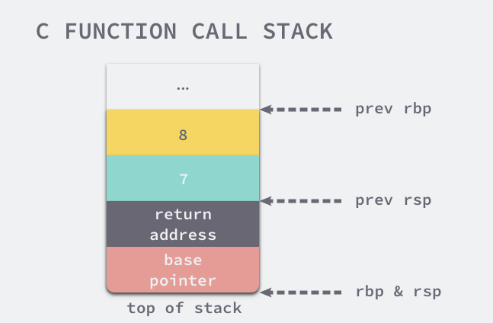

- C語言

範例

// ch04/my_function.c

int my_function(int arg1, int arg2) {

return arg1 + arg2;

}

int main() {

int i = my_function(1, 2);

}

編譯成組合

main:

pushq %rbp

movq %rsp, %rbp

subq $16, %rsp

movl $2, %esi // 設定第二個引數

movl $1, %edi // 設定第一個引數

call my_function

movl %eax, -4(%rbp)

my_function:

pushq %rbp

movq %rsp, %rbp

movl %edi, -4(%rbp) // 取出第一個引數,放到棧上

movl %esi, -8(%rbp) // 取出第二個引數,放到棧上

movl -8(%rbp), %eax // eax = esi = 1

movl -4(%rbp), %edx // edx = edi = 2

addl %edx, %eax // eax = eax + edx = 1 + 2 = 3

popq %rbp

呼叫過程:

1.呼叫方main函數將my_function的倆個引數分別存到edi和esi暫存器中。

2.在my_function呼叫時,它會將暫存器edi和esi中的資料儲存到eax和edx倆個暫存器中。隨後通過組合指令addl 計算倆個入參之和。

3.在my_fuction呼叫後,使用暫存器eax 傳奇返回值。然後儲存到棧上的i變數中。

當my_function函數的入參增加至8個時。會得到不同的組合程式碼。

main:

pushq %rbp

movq %rsp, %rbp

subq $16, %rsp // 為引數傳遞申請 16 位元組的棧空間

movl $8, 8(%rsp) // 傳遞第 8 個引數

movl $7, (%rsp) // 傳遞第 7 個引數

movl $6, %r9d

movl $5, %r8d

movl $4, %ecx

movl $3, %edx

movl $2, %esi

movl $1, %edi

call my_function

前6個引數會使用edi、esi、edx、ecx、r8d\r9d 六個暫存器傳遞。

最後的倆個引數通過棧傳遞。

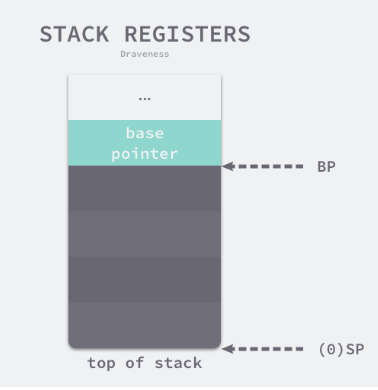

rbp暫存器會儲存函數呼叫棧的基址指標。main函數的棧空間的其實地址。而另一個暫存器rsp儲存的是main函數呼叫棧結束的位置。

這倆個暫存器共同表示了函數的棧空間。

在呼叫my_function之前。main函數通過sub1 $16,%rsp指令分配了16個位元組的站地址。隨後將第6個以上的引數按照從右到左的順序存入棧中。餘下的6個引數通過暫存器傳遞。

my_function:

pushq %rbp

movq %rsp, %rbp

movl %edi, -4(%rbp) // rbp-4 = edi = 1

movl %esi, -8(%rbp) // rbp-8 = esi = 2

...

movl -8(%rbp), %eax // eax = 2

movl -4(%rbp), %edx // edx = 1

addl %eax, %edx // edx = eax + edx = 3

...

movl 16(%rbp), %eax // eax = 7

addl %eax, %edx // edx = eax + edx = 28

movl 24(%rbp), %eax // eax = 8

addl %edx, %eax // edx = eax + edx = 36

popq %rbp

my_function會先將暫存器中的全部資料轉移到棧上。然後利用eax暫存器計算所有入參的和並返回結果。

函數的返回值是通過eax暫存器進行傳遞的。由於只使用一個暫存器儲存返回值。所以C語言的函數不能同時返回多個值。

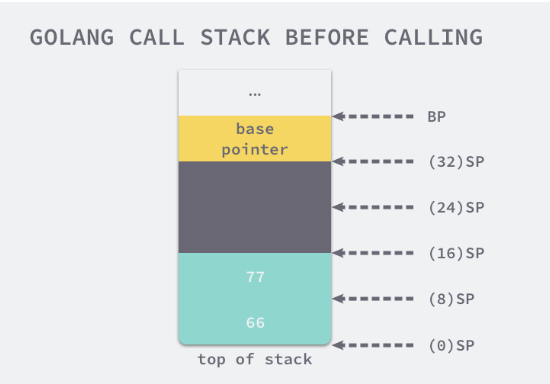

- Go語言

package main

func myFunction(a, b int) (int, int) {

return a + b, a - b

}

func main() {

myFunction(66, 77)

}

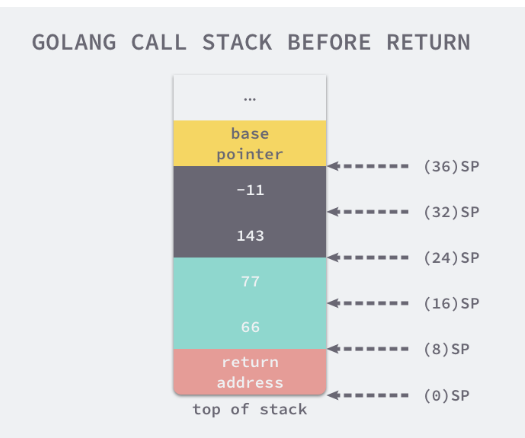

"".main STEXT size=68 args=0x0 locals=0x28

0x0000 00000 (main.go:7) MOVQ (TLS), CX

0x0009 00009 (main.go:7) CMPQ SP, 16(CX)

0x000d 00013 (main.go:7) JLS 61

0x000f 00015 (main.go:7) SUBQ $40, SP // 分配 40 位元組棧空間

0x0013 00019 (main.go:7) MOVQ BP, 32(SP) // 將基址指標儲存到棧上

0x0018 00024 (main.go:7) LEAQ 32(SP), BP

0x001d 00029 (main.go:8) MOVQ $66, (SP) // 第一個引數

0x0025 00037 (main.go:8) MOVQ $77, 8(SP) // 第二個引數

0x002e 00046 (main.go:8) CALL "".myFunction(SB)

0x0033 00051 (main.go:9) MOVQ 32(SP), BP

0x0038 00056 (main.go:9) ADDQ $40, SP

0x003c 00060 (main.go:9) RET

"".myFunction STEXT nosplit size=49 args=0x20 locals=0x0

0x0000 00000 (main.go:3) MOVQ $0, "".~r2+24(SP) // 初始化第一個返回值

0x0009 00009 (main.go:3) MOVQ $0, "".~r3+32(SP) // 初始化第二個返回值

0x0012 00018 (main.go:4) MOVQ "".a+8(SP), AX // AX = 66

0x0017 00023 (main.go:4) ADDQ "".b+16(SP), AX // AX = AX + 77 = 143

0x001c 00028 (main.go:4) MOVQ AX, "".~r2+24(SP) // (24)SP = AX = 143

0x0021 00033 (main.go:4) MOVQ "".a+8(SP), AX // AX = 66

0x0026 00038 (main.go:4) SUBQ "".b+16(SP), AX // AX = AX - 77 = -11

0x002b 00043 (main.go:4) MOVQ AX, "".~r3+32(SP) // (32)SP = AX = -11

0x0030 00048 (main.go:4) RET

Go語言使用棧傳遞引數和接收返回值。所以只需要在棧上多分配一些記憶體就可以返回多個值。

引數傳遞

值傳遞還是參照傳遞。

- 傳值: 函數呼叫會對引數進行拷貝,被呼叫方和呼叫方倆者持有不相關的倆份資料

- 傳參照:持有相同的資料

不同的語言會選擇不同的方式傳遞引數。GO語言選擇了傳值得方式。無論是基本型別、結構體、還是指標。都會對傳遞的引數進行拷貝。 - 整型和陣列

整型變數i和陣列arr.

func myFunction(i int, arr [2]int) {

fmt.Printf("in my_funciton - i=(%d, %p) arr=(%v, %p)\n", i, &i, arr, &arr)

}

func main() {

i := 30

arr := [2]int{66, 77}

fmt.Printf("before calling - i=(%d, %p) arr=(%v, %p)\n", i, &i, arr, &arr)

myFunction(i, arr)

fmt.Printf("after calling - i=(%d, %p) arr=(%v, %p)\n", i, &i, arr, &arr)

}

$ go run main.go

before calling - i=(30, 0xc00009a000) arr=([66 77], 0xc00009a010)

in my_funciton - i=(30, 0xc00009a008) arr=([66 77], 0xc00009a020)

after calling - i=(30, 0xc00009a000) arr=([66 77], 0xc00009a010)

在my_function中修改

func myFunction(i int, arr [2]int) {

i = 29

arr[1] = 88

fmt.Printf("in my_funciton - i=(%d, %p) arr=(%v, %p)\n", i, &i, arr, &arr)

}

$ go run main.go

before calling - i=(30, 0xc000072008) arr=([66 77], 0xc000072010)

in my_funciton - i=(29, 0xc000072028) arr=([66 88], 0xc000072040)

after calling - i=(30, 0xc000072008) arr=([66 77], 0xc000072010)

Go 語言的整型和陣列型別都是值傳遞的,也就是在呼叫函數時會對內容進行拷貝。需要注意的是如果當前陣列的大小非常的大,這種傳值的方式會對效能造成比較大的影響

- 結構體和指標

type MyStruct struct {

i int

}

func myFunction(a MyStruct, b *MyStruct) {

a.i = 31

b.i = 41

fmt.Printf("in my_function - a=(%d, %p) b=(%v, %p)\n", a, &a, b, &b)

}

func main() {

a := MyStruct{i: 30}

b := &MyStruct{i: 40}

fmt.Printf("before calling - a=(%d, %p) b=(%v, %p)\n", a, &a, b, &b)

myFunction(a, b)

fmt.Printf("after calling - a=(%d, %p) b=(%v, %p)\n", a, &a, b, &b)

}

$ go run main.go

before calling - a=({30}, 0xc000018178) b=(&{40}, 0xc00000c028)

in my_function - a=({31}, 0xc000018198) b=(&{41}, 0xc00000c038)

after calling - a=({30}, 0xc000018178) b=(&{41}, 0xc00000c028)

結論1:傳遞結構體時:會拷貝結構體中的全部內容

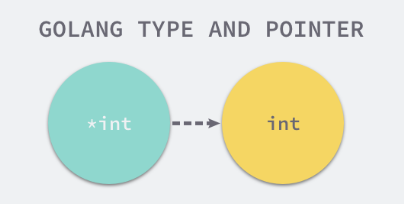

結論2:傳遞結構體指標時:會拷貝結構體指標。

修改結構體指標,是改變了指標指向的結構體。 b.i => (*b).i

儘量使用指標作為引數型別來避免發生資料拷貝進而影響效能。

介面

Go語言中的介面是一組方法的簽名。使用介面能夠讓我們寫出易於測試的程式碼。

介面概述

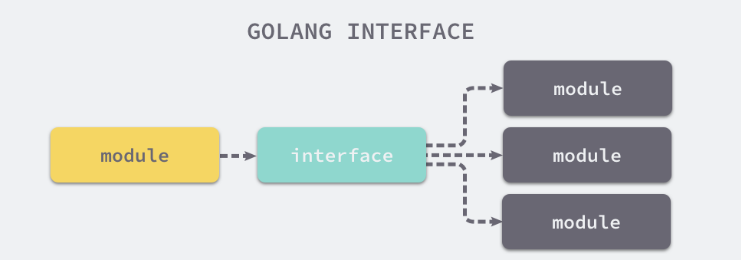

介面是計算機系統中多個元件共用的邊界。不同的元件能夠在邊界上交換資訊。

介面的本質是引入一個新的中間層。呼叫方可以通過介面與具體的實現分離。解除上下游的耦合。

上層的模組不需要依賴下層的具體模組。只需要依賴一個約定好的介面。

面向介面的程式設計方式有著非常強大的生命力。

Go語言中的介面是一種內建的型別。定義了一組方法的簽名。

- 隱式介面

java中的介面,還可以定義變數。可以在類中直接使用。

public interface MyInterface {

public String hello = "Hello";

public void sayHello();

}

public class MyInterfaceImpl implements MyInterface {

public void sayHello() {

System.out.println(MyInterface.hello);

}

}

go語言不需要使用上述方式顯示的宣告實現的介面.

一個常見的Go語言介面是這樣的:

type error interface {

Error() string

}

如果一個型別需要實現error介面。那麼只需要實現Error() string方法。

type RPCError struct {

Code int64

Message string

}

func (e *RPCError) Error() string {

return fmt.Sprintf("%s, code=%d", e.Message, e.Code)

}

Go語言中的介面實現都是隱式的。只需要實現Error() String方法就實現了error介面。

在java中:實現介面需要顯示地宣告介面 並實現所有方法

在Go中:實現介面的所有方法就隱式地實現了介面。

上述RPCError結構體並不太關心它實現了哪些介面,Go語言只會在傳遞引數、返回引數以及變數賦值時才會對某個型別是否實現介面進行檢查。

func main() {

var rpcErr error = NewRPCError(400, "unknown err") // typecheck1

err := AsErr(rpcErr) // typecheck2

println(err)

}

func NewRPCError(code int64, msg string) error {

return &RPCError{ // typecheck3

Code: code,

Message: msg,

}

}

func AsErr(err error) error {

return err

}

將 *RPCError 型別的變數賦值給 error 型別的變數 rpcErr;

將 *RPCError 型別的變數 rpcErr 傳遞給簽名中引數型別為 error 的 AsErr 函數;

將 *RPCError 型別的變數從函數簽名的返回值型別為 error 的 NewRPCError 函數中返回;

- 型別

介面也是Go語言中的一種型別,能夠出現在變數的定義、函數的入參和返回值中,並對它們進行約束。

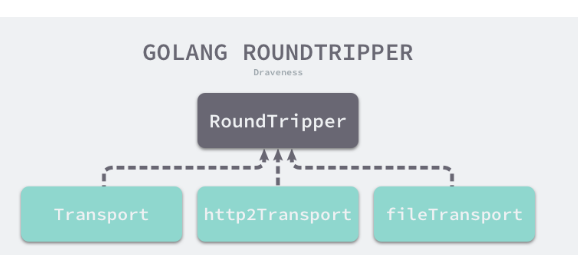

go語言有倆種不同的介面,一種是帶有一組方法的介面。

另一種是不帶任何方法的interface{}

runtime.iface表示第一種介面。

runtime.aface表示不包含任何方法介面的interface{}

interface{}型別不是任意型別。變數在執行期間的型別會發生變換。

獲取變數型別時會得到interface{}

package main

func main() {

type Test struct{}

v := Test{}

Print(v)

}

func Print(v interface{}) {

println(v)

}

上述函數不接受任意型別的引數,只接受interface{}型別的值,在呼叫Print函數時,會對引數v進行型別轉換,將原來的Test型別轉換成interface型別。

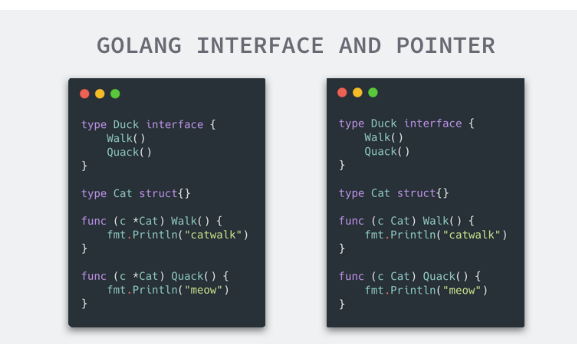

- 指標和介面

在GO語言中,同時使用指標和介面時 會發生一些讓人困惑的問題。

介面在定義一組方法時沒有對實現的接收者做限制。

所以我們會看到某個型別實現介面的倆種方式。

結構體型別和指標型別是不同的。

上圖中倆種實現不可以同時存在,如果同時存在,會報錯:「method redeclared」

對 Cat結構體來說。在實現介面時,可以選擇接受者的型別,即結構體或者結構體指標

type Cat struct {}

type Duck interface { ... }

func (c Cat) Quack {} // 使用結構體實現介面

func (c *Cat) Quack {} // 使用結構體指標實現介面

var d Duck = Cat{} // 使用結構體初始化變數

var d Duck = &Cat{} // 使用結構體指標初始化變數

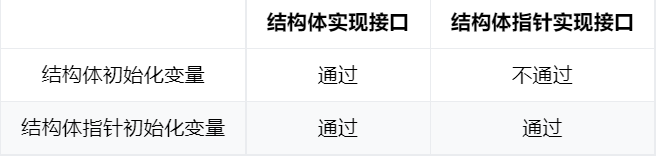

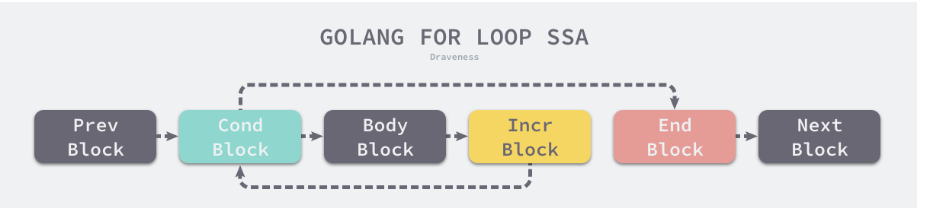

實現介面的型別和初始化返回的型別兩個維度共組成了四種情況,然而這四種情況不是都能通過編譯器的檢查:

使用結構體指標實現介面,結構體初始化變數無法通過編譯。其他三種情況都可以正常執行。

當實現介面的型別和初始化的變數返回的型別相同是,程式碼通過是理所應當的。

方法接受者和初始化型別都是結構體。

方法接受者和初始化型別都是結構體指標

而剩下的倆種方式為什麼一個可以通過編譯,一個不行呢。

可以通過的是:方法的接受者是結構體,初始化變數是結構體指標。

type Cat struct{}

func (c Cat) Quack() {

fmt.Println("meow")

}

func main() {

var c Duck = &Cat{}

c.Quack()

}

作為指標的&Cat{}變數能夠隱式地獲取到指向的結構體。通過指標找到對應的結構體,然後參照Quack()

type Duck interface {

Quack()

}

type Cat struct{}

func (c *Cat) Quack() {

fmt.Println("meow")

}

func main() {

var c Duck = Cat{}

c.Quack()

}

$ go build interface.go

./interface.go:20:6: cannot use Cat literal (type Cat) as type Duck in assignment:

Cat does not implement Duck (Quack method has pointer receiver)

Cat 型別沒有實現 Duck 介面,Quack 方法的接受者是指標。這兩個報錯對於剛剛接觸 Go 語言的開發者比較難以理解,如果我們想要搞清楚這個問題,首先要知道 Go 語言在傳遞引數時都是傳值的。

初始化的變數c是Cat{} 還是 &Cat{}。使用c.Quack()呼叫方法是都會發生值拷貝。

-

對於&Cat{}來說,這意味著拷貝一個新的&Cat{}指標,這個指標指向一個相同並且唯一的結構體。所以編譯器可以隱式的對變數解除參照 dereference。獲取結構體。

-

對於Cat{} 來說。意味著,Quack方法會接受一個全新的Cat{}.因為方法的引數是*Cat{}。編譯器不會無中生有建立一個新的指標,即使可以建立新的指標,這個指標也不會指向最初呼叫該方法的結構體。

上面的分析解釋了指標型別的現象,當我們使用指標實現介面時,只有指標型別的變數才會實現該介面;當我們使用結構體實現介面時,指標型別和結構體型別都會實現該介面。當然這並不意味著我們應該一律使用結構體實現介面,這個問題在實際工程中也沒那麼重要,在這裡我們只想解釋現象背後的原因。 -

nil 和 non-nil

資料結構

go語言根據介面型別是否包含一組方法將介面型別分成了倆類

- 使用runtime.iface結構體表示包含方法的介面。

- 使用runtime.eface結構體表示不包含任何方法的interface{}型別。

type eface struct { // 16 位元組

_type *_type # 指向底層資料型別的指標

data unsafe.Pointer # 指向底層資料的指標

}

type iface struct { // 16 位元組

tab *itab

data unsafe.Pointer # 指向底層資料的指標

}

- 型別結構體

runtime._type 是Go語言型別的執行時表示,

type _type struct {

size uintptr #該型別佔用的記憶體空間

ptrdata uintptr

hash uint32 # 快速確定型別是否相等

tflag tflag

align uint8

fieldAlign uint8

kind uint8

equal func(unsafe.Pointer, unsafe.Pointer) bool # 當前型別的多個物件是否相等。

gcdata *byte

str nameOff

ptrToThis typeOff

}

- itab結構體

type itab struct { // 32 位元組

inter *interfacetype

_type *_type

hash uint32 # 是對 _type.hash 的拷貝

_ [4]byte

fun [1]uintptr # 是一個動態大小的陣列,它是一個用於動態派發的虛擬函式表,儲存了一組函數指標

}

型別轉換

介面型別是如何初始化和傳遞的。

- 指標型別

型別斷言

具體型別轉換為介面型別

介面型別轉換為具體型別

動態派發

Dynamic dispatch.是在執行期間選擇具體多型操作(方法或函數)執行的過程。

Go語言不是嚴格意義上的物件導向的語言。但是介面的引入為它帶來了動態派發的特性。

編譯期間不能確認介面型別,go語言會在執行期間決定具體呼叫該方法的哪個實現。

func main() {

var c Duck = &Cat{Name: "draven"}

c.Quack() # Duck介面型別的身份呼叫,呼叫時需要經過執行時的動態派發

c.(*Cat).Quack() # *Cat 具體型別的身份呼叫。編譯期就會確定呼叫的函數。

}

反射

reflect 實現了執行時的反射能力。

能夠讓程式操作不同型別的物件。

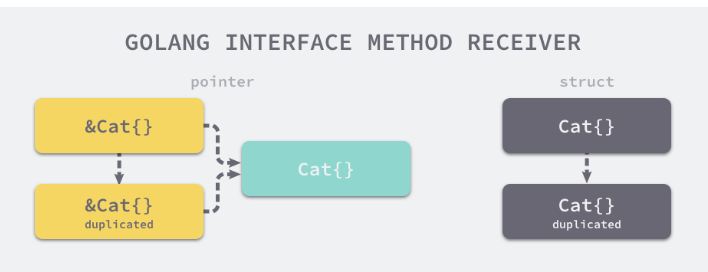

reflect.TypeOf 能獲取型別資訊;

reflect.ValueOf 能獲取資料的執行時表示;

型別 reflect.Type 是反射包定義的一個介面,我們可以使用 reflect.TypeOf 函數獲取任意變數的型別,reflect.Type 介面中定義了一些有趣的方法,MethodByName 可以獲取當前型別對應方法的參照、Implements 可以判斷當前型別是否實現了某個介面:

type Type interface {

Align() int

FieldAlign() int

Method(int) Method

MethodByName(string) (Method, bool)

NumMethod() int

...

Implements(u Type) bool

...

}

type Value struct {

// 包含過濾的或者未匯出的欄位

}

func (v Value) Addr() Value

func (v Value) Bool() bool

func (v Value) Bytes() []byte

...

三大法則

從 interface{} 變數可以反射出反射物件;

從反射物件可以獲取 interface{} 變數;

要修改反射物件,其值必須可設定;

常用關鍵字

for 和 range

for迴圈編譯成組合指令

package main

func main() {

for i := 0; i < 10; i++ {

println(i)

}

}

"".main STEXT size=98 args=0x0 locals=0x18

00000 (main.go:3) TEXT "".main(SB), $24-0

...

00029 (main.go:3) XORL AX, AX ;; i := 0

00031 (main.go:4) JMP 75

00033 (main.go:4) MOVQ AX, "".i+8(SP)

00038 (main.go:5) CALL runtime.printlock(SB)

00043 (main.go:5) MOVQ "".i+8(SP), AX

00048 (main.go:5) MOVQ AX, (SP)

00052 (main.go:5) CALL runtime.printint(SB)

00057 (main.go:5) CALL runtime.printnl(SB)

00062 (main.go:5) CALL runtime.printunlock(SB)

00067 (main.go:4) MOVQ "".i+8(SP), AX

00072 (main.go:4) INCQ AX ;; i++

00075 (main.go:4) CMPQ AX, $10 ;; 比較變數 i 和 10

00079 (main.go:4) JLT 33 ;; 跳轉到 33 行如果 i < 10

...

- 神奇的指標

當我們在遍歷一個陣列時,如果獲取 range 返回變數的地址並儲存到另一個陣列或者雜湊時,會遇到令人困惑的現象

func main() {

arr := []int{1, 2, 3}

newArr := []*int{}

for _, v := range arr {

newArr = append(newArr, &v)

}

for _, v := range newArr {

fmt.Println(*v)

}

}

$ go run main.go

3 3 3

正確的做法應該是使用 &arr[i] 替代 &v,我們會在下面分析這一現象背後的原因。

- 遍歷清空陣列

func main() {

arr := []int{1, 2, 3}

for i, _ := range arr {

arr[i] = 0

}

}

依次遍歷切片和雜湊看起來是非常耗費效能的, 因為陣列、切片和雜湊佔用的記憶體空間都是連續的,所以最快的方法是直接清空這片記憶體中的內容,當我們編譯上述程式碼時會得到以下的組合指令

- 隨機遍歷

func main() {

hash := map[string]int{

"1": 1,

"2": 2,

"3": 3,

}

for k, v := range hash {

println(k, v)

}

}

每次執行都會不同。

Go 語言在執行時為雜湊表的遍歷引入了不確定性,也是告訴所有 Go 語言的使用者,程式不要依賴於雜湊表的穩定遍歷,我們在下面的小節會介紹在遍歷的過程是如何引入不確定性的。

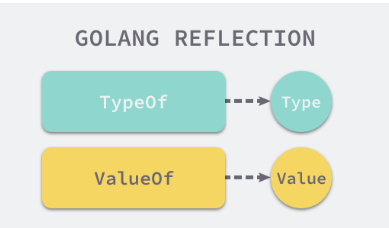

經典迴圈

Go語言中的經典迴圈在編譯器看來是一個OFOR型別的節點。由下面四個部分組成。

初始化迴圈的 Ninit;

迴圈的繼續條件 Left;

迴圈體結束時執行的 Right;

迴圈體 NBody:

for Ninit; Left; Right {

NBody

}

範圍迴圈

編譯器會將所有for-range迴圈 變成經典迴圈。

將是將ORANGE節點轉換成OFOR節點

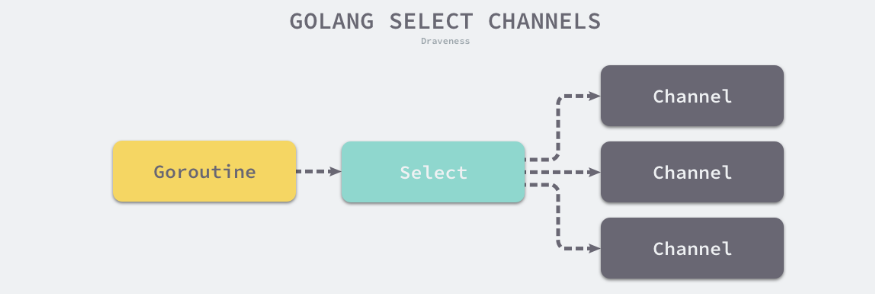

select

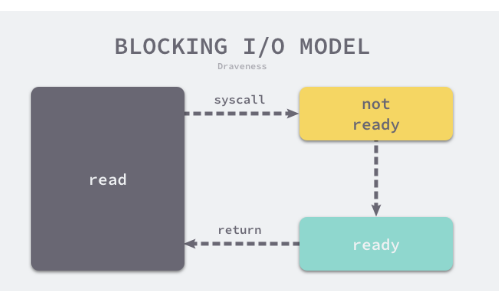

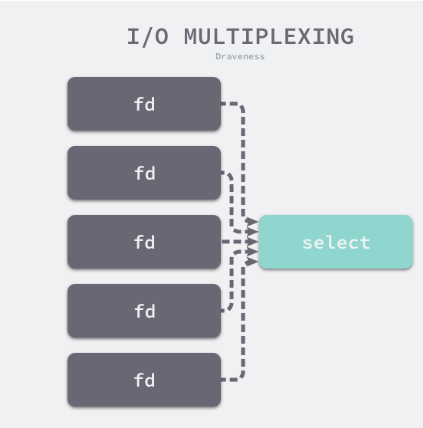

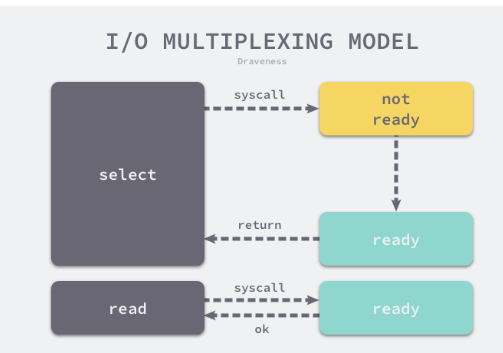

select 是作業系統中的系統呼叫。 select \ poll \ epoll 等函數構建I/O多路複用模型提升程式的效能。

Go語言的select與作業系統的select比較相似。

C語言的select系統呼叫可以同時監聽讀個檔案描述符的可讀或者可寫的狀態。

Go語言中的select也能夠讓Goroutine同時等待多個Channel可讀或者可寫。

在多個檔案或者Channel狀態改變之前,select會一直阻塞當前執行緒或者Goroutine.

select 是與switch相似的控制結構。與switch不同的是,select中雖然也有多個case.但是這些case中的表示式必須都是Channel的收發操作。

func fibonacci(c, quit chan int) {

x, y := 0, 1

for {

select {

case c <- x:

x, y = y, x+y

case <-quit:

fmt.Println("quit")

return

}

}

}

c <- x 或者 <- quit 倆個表示式中任意一個返回,無論哪一個表示式返回,都會立即執行case中的程式碼。

同時觸發,會隨機執行其中的一個。

現象

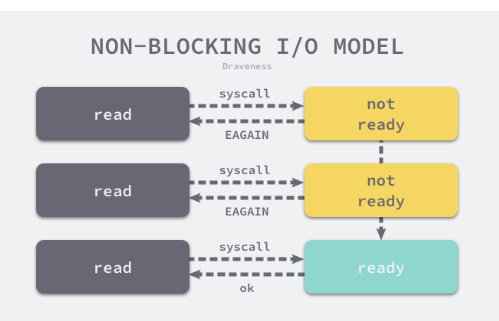

1.select能在Channel上進行非阻塞的收發操作。

2.select在遇到多個Channel同時響應時,會隨機執行一種情況。

- 非阻塞的收發

在通常情況下,select語句會阻塞當前Goroutine並等待多個Channel中的一個達到可以收發的狀態。

但是如果select語句控制結構中包含 default語句,那麼有下列倆種情況

- 當存在可以收發的Channel時,直接處理該Channel對應的case.

- 當不存在可以收發的Channel時,執行default中的語句。

- 隨機執行

避免飢餓問題的發生。

資料結構

select 在Go語言的原始碼中不存在對應的結構體。使用runtime.scase結構體表示 select在控制結構中的case.

type scase struct {

c *hchan // chan,case中使用的Channel

elem unsafe.Pointer // data element

}

實現原理

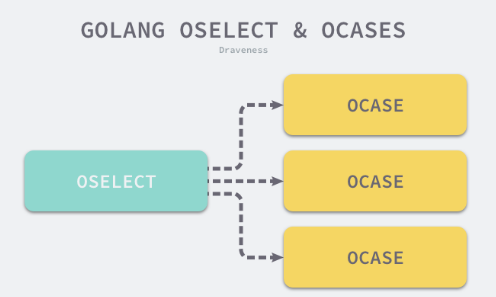

select 語句在編譯期會被轉換成OSELECT節點。

每個OSELECT節點都會持有一組OCASE節點,如果OCASE的執行條件是空,那就是一個default節點。

分析4種情況

select 不存在任何的 case;

select 只存在一個 case;

select 存在兩個 case,其中一個 case 是 default;

select 存在多個 case;

- 直接阻塞

select結構中不包含任何case.

func walkselectcases(cases *Nodes) []*Node {

n := cases.Len()

if n == 0 {

return []*Node{mkcall("block", nil, nil)}

}

...

}

select 語句轉換成呼叫runtime.block函數,

func block() {

gopark(nil, nil, waitReasonSelectNoCases, traceEvGoStop, 1)

}

block函數會呼叫gopark讓出當前Goroutine對處理器的使用權,並傳入等待原因 waitReasonSelectNoCases.

空的select語句會直接阻塞當前的Goroutine。導致Goroutine進入無法被喚醒的永久休眠狀態。

- 單一管道

select條件只包含一個case.

編譯器會改寫成if條件語句。

// 改寫前

select {

case v, ok <-ch: // case ch <- v

...

}

// 改寫後

if ch == nil {

block()

}

v, ok := <-ch // case ch <- v

...

在處理單操作select語句時,會根據Channel的收發情況生成不同的語句。當case中的Channel是空指標時,會直接掛起當前Goroutine並陷入永久休眠。

-

非阻塞操作

當select中僅包含2個case.並且其中一個是default.Go語言的編譯器會認為這是一次非阻塞的 收發操作。

gc.walkselectcases會對這種情況單獨處理,優化之前會將case中的所有Channel都轉換成指向Channel的地址。 -

傳送

當case中表示式的型別是OSEND時,編譯器會使用條件語句和 runtime.selectnbsend函數改寫程式碼。

select {

case ch <- i:

...

default:

...

}

if selectnbsend(ch, i) {

...

} else {

...

}

runtime.selectnbsend ,為我們提供了向Channel非阻塞地傳送資料的能力。

我們在Channel一節介紹了向Channel傳送資料的runtime.chansend函數包含一個block引數。該引數會決定這一次的傳送是不是阻塞的。

func selectnbsend(c *hchan, elem unsafe.Pointer) (selected bool) {

return chansend(c, elem, false, getcallerpc())

}

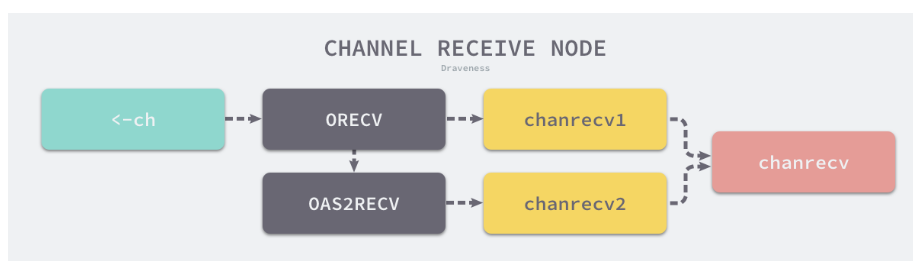

- 接收

由於從Channel中接收資料可能返回一個或者倆個值,所以接收資料的情況會比傳送稍顯複雜。

// 改寫前

select {

case v <- ch: // case v, ok <- ch:

......

default:

......

}

// 改寫後

if selectnbrecv(&v, ch) { // if selectnbrecv2(&v, &ok, ch) {

...

} else {

...

}

返回值數量不同會導致使用不同的函數。

倆個用於非阻塞接收訊息的函數。 selectnbrecv 和 selectnbrecv2(對chanrecv返回值的處理稍有不同)

func selectnbrecv(elem unsafe.Pointer, c *hchan) (selected bool) {

selected, _ = chanrecv(c, elem, false)

return

}

func selectnbrecv2(elem unsafe.Pointer, received *bool, c *hchan) (selected bool) {

selected, *received = chanrecv(c, elem, false)

return

}

- 常見流程

- 將所有的case轉換成包含Channel以及型別等資訊的runtime.scase結構體。

- 呼叫執行時函數runtime.selectgo從多個準備就緒的Channel中選擇一個可執行的runtime.scase結構體。

- 通過for迴圈生成一組if語句,在語句中判斷自己是不是被選中的case.

selv := [3]scase{}

order := [6]uint16

for i, cas := range cases {

c := scase{}

c.kind = ...

c.elem = ...

c.c = ...

}

chosen, revcOK := selectgo(selv, order, 3)

if chosen == 0 {

...

break

}

if chosen == 1 {

...

break

}

if chosen == 2 {

...

break

}

selectgo函數執行過程

- 執行一些必要的初始化操作並確定case的處理順序。

- 在迴圈中根據case的型別做出不同的處理。

- 初始化

runtime.selectgo函數首先會執行必要的儲戶和操作,並決定處理case的倆個順序- 輪詢順序 pollOrder 和 加鎖順序 lockOrder

func selectgo(cas0 *scase, order0 *uint16, ncases int) (int, bool) {

cas1 := (*[1 << 16]scase)(unsafe.Pointer(cas0))

order1 := (*[1 << 17]uint16)(unsafe.Pointer(order0))

ncases := nsends + nrecvs

scases := cas1[:ncases:ncases]

pollorder := order1[:ncases:ncases]

lockorder := order1[ncases:][:ncases:ncases]

norder := 0

for i := range scases {

cas := &scases[i]

}

for i := 1; i < ncases; i++ {

j := fastrandn(uint32(i + 1))

pollorder[norder] = pollorder[j]

pollorder[j] = uint16(i)

norder++

}

pollorder = pollorder[:norder]

lockorder = lockorder[:norder]

// 根據 Channel 的地址排序確定加鎖順序

...

sellock(scases, lockorder)

...

}

輪詢順序: 通過runtime.fastrandn 函數進入隨機性

加鎖順序: 按照Channel的地址排序後確定加鎖順序。

隨機的輪詢順序可以便祕Channel的飢餓問題。保證公平性

根據Channel的地址順序確定加鎖順序能夠避免死鎖的發生。

- 迴圈

當我們為select語句鎖定了所有Channel之後,就會進入runtime.selectgo函數的主迴圈,

分 三個階段查詢或者等待某個channel準備就緒。

- 查詢是否已經存在準備就緒的Channel。即可以執行收發操作。

- 將當前Goroutine加入Channel對應的收發佇列上,並等待其他Goroutine的喚醒。

- 當前Goroutine被喚醒之後找到滿足條件的Changnel並進行處理。

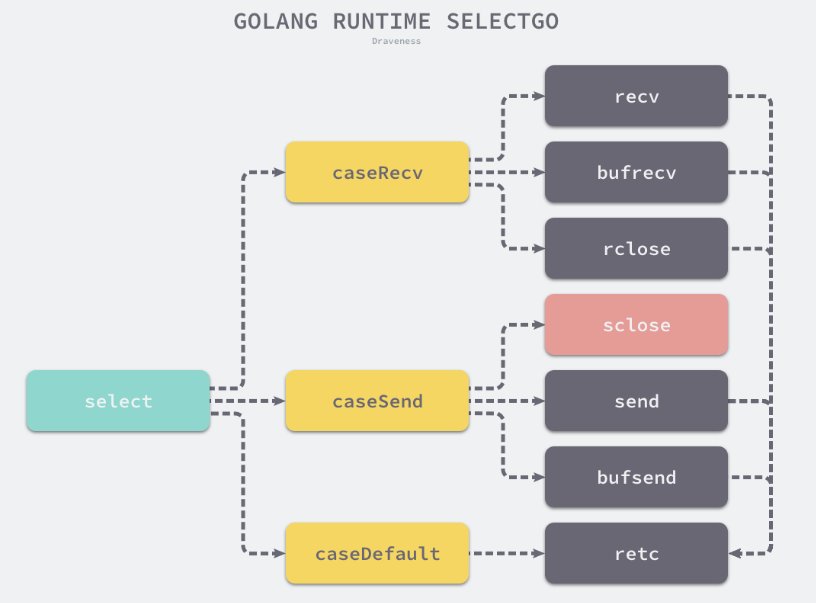

runtime.selectgo函數會根據不同情況通過goto語句跳轉到函數內部的不同標籤執行相應的邏輯,其中包括:

- bufrecv: 可以從緩衝區讀取資料

- bufsend: 可以向緩衝區寫入資料

- recv: 可以從休眠的傳送方獲取資料

- send: 可以向休眠的傳送方傳送資料

- rclose: 可以從關閉的Channel讀取EOF

- sclose: 向關閉的Channel傳送資料

- retc: 結束呼叫並返回。

分析第一個階段:查詢已經準備就緒的Channel。迴圈遍歷所有case並找到需要被喚起的runtime.sudog結構。

在這個階段,我們會根據case的四種型別分別處理

-

當case不包含channel時:會被跳過。

-

當case會從Channel 中接收資料時。

如果當前Channel的sendq上有等待的Goroutine.就會跳到recv標籤並從 緩衝區讀取資料後將等待的Goroutine中的資料放入到緩衝區中相同的位置。

如果當前Channel的緩衝區不為空,就會跳到bufrecv標籤處從緩衝區獲取資料。

如果當前Channel已經被關閉,就會跳到rclose做一些清除的收尾工作。 -

當case會向Channel傳送資料時

如果當前Channel已經被關閉,就會直接跳到sclose標籤,觸發panic嘗試中止程式。

如果當前channel的recvq上有等待的Goroutine.就會跳到send標籤向channel傳送資料。

如果當前channel的緩衝區存在空閒位置,就會將傳送的資料存入緩衝區。 -

當select語句中包含default時:

表示前面的的所有的case語句都沒有被執行。這裡會解鎖所有channel並返回,意味著當前select結構中的收發都是非阻塞的。

第一階段的主要職責是查詢所有case中是否有可以立刻被處理的Channel. 無論是在等待的Goroutine上還是緩衝區中。

只要存在資料滿足條件就會立刻處理。如果不能立刻找到活躍的channel。就會進入迴圈的下一階段。

按照需要將當前的goroutine加入到channel的sendq或者recvq佇列中。

func selectgo(cas0 *scase, order0 *uint16, ncases int) (int, bool) {

...

gp = getg()

nextp = &gp.waiting

for _, casei := range lockorder {

casi = int(casei)

cas = &scases[casi]

c = cas.c

sg := acquireSudog()

sg.g = gp

sg.c = c

if casi < nsends {

c.sendq.enqueue(sg)

} else {

c.recvq.enqueue(sg)

}

}

gopark(selparkcommit, nil, waitReasonSelect, traceEvGoBlockSelect, 1)

...

}

除了將當前的Goroutine對應的runtime.sudog結構體加入佇列之外,這些結構體都會被串成連結串列附著在Goroutine上。在入隊後會呼叫runtime.gopark掛起當前Goroutine等待排程器的喚醒。

golang select waiting

等待select中的一些Channel準備就緒後,當前Goroutine就會被排程器喚醒。這時會繼續執行runtime.selectgo函數的第三部分。從runtime.sudog中讀取資料。

func selectgo(cas0 *scase, order0 *uint16, ncases int) (int, bool) {

...

sg = (*sudog)(gp.param)

gp.param = nil

casi = -1

cas = nil

sglist = gp.waiting

for _, casei := range lockorder {

k = &scases[casei]

if sg == sglist {

casi = int(casei)

cas = k

} else {

c = k.c

if int(casei) < nsends {

c.sendq.dequeueSudoG(sglist)

} else {

c.recvq.dequeueSudoG(sglist)

}

}

sgnext = sglist.waitlink

sglist.waitlink = nil

releaseSudog(sglist)

sglist = sgnext

}

c = cas.c

goto retc

...

}

第三次遍歷全部case時,我們會獲取當前Goroutine接收到的引數 sudog結構。我們會依次對比所有case對應的sudog結構找到被喚醒的case.獲取該case對應的索引並返回。

由於當前的select結構找到了一個case執行,那麼剩下的case中沒有被用到的sudog就會被忽略並且釋放掉。為了不影響channel的正常使用。我們還是需要將這些廢棄的sudog從channel中出隊。

小結

select結構,優化,根據select中case的不同選擇不同的優化路徑。

四個優化

- 空的 select 語句會被轉換成呼叫 runtime.block 直接掛起當前 Goroutine;

- 如果 select 語句中只包含一個 case,編譯器會將其轉換成 if ch == nil { block }; n; 表示式;

首先判斷操作的 Channel 是不是空的;

然後執行 case 結構中的內容; - 如果 select 語句中只包含兩個 case 並且其中一個是 default,那麼會使用 runtime.selectnbrecv 和 runtime.selectnbsend 非阻塞地執行收發操作;

在預設情況下會通過 runtime.selectgo 獲取執行 case 的索引,並通過多個 if 語句執行對應 case 中的程式碼; - 在編譯器已經對 select 語句進行優化之後,Go 語言會在執行時執行編譯期間展開的 runtime.selectgo 函數,該函數會按照以下的流程執行:

執行時3個步驟: - 隨機生成一個遍歷的輪詢順序 pollOrder 並根據 Channel 地址生成鎖定順序 lockOrder;

- 根據 pollOrder 遍歷所有的 case 檢視是否有可以立刻處理的 Channel;

如果存在,直接獲取 case 對應的索引並返回;

如果不存在,建立 runtime.sudog 結構體,將當前 Goroutine 加入到所有相關 Channel 的收發佇列,並呼叫 runtime.gopark 掛起當前 Goroutine 等待排程器的喚醒; - 當排程器喚醒當前 Goroutine 時,會再次按照 lockOrder 遍歷所有的 case,從中查詢需要被處理的 runtime.sudog 對應的索引;

defer

defer 會在當前函數返回前 執行 傳入的函數。

經常被 用於關閉檔案描述符、關閉資料庫連線、解鎖資源

defer的實現一定是由編譯器和執行時 共同完成的。

使用defer的最常見場景是在函數呼叫結束後完成一些收尾工作。

例如:回滾資料庫事務

func createPost(db *gorm.DB) error {

tx := db.Begin()

defer tx.Rollback()

if err := tx.Create(&Post{Author: "Draveness"}).Error; err != nil {

return err

}

return tx.Commit().Error

}

defer 現象

-

defer 關鍵字的呼叫時機以及多次呼叫defer時執行順序是如何確定的。

-

defer 關鍵字使用傳值的方式 傳遞引數時會進行預計算,導致不符合預期的結果。

-

作用域

向defer關鍵字傳入的函數會在函數返回之前執行,

假如我們在 for迴圈中 多次呼叫 defer關鍵字

func main() {

for i := 0; i < 5; i++ {

defer fmt.Println(i)

}

}

$ go run main.go

4

3

2

1

0

func main() {

{

defer fmt.Println("defer runs")

fmt.Println("block ends")

}

fmt.Println("main ends")

}

$ go run main.go

block ends

main ends

defer runs

- 預計算引數

GO語言中所有的函數呼叫都是傳值的。

要計算main函數執行的時間:

func main() {

startedAt := time.Now()

defer fmt.Println(time.Since(startedAt))

time.Sleep(time.Second)

}

$ go run main.go

0s

不符合預期,defer關鍵字會立刻拷貝函數中參照的外部引數。所以time.Since(startedAt)的結果不是在main函數退出之前計算的,而是在defer關鍵字呼叫時計算的。導致輸出為0s。

解決辦法:傳入匿名函數

func main() {

startedAt := time.Now()

defer func() { fmt.Println(time.Since(startedAt)) }()

time.Sleep(time.Second)

}

$ go run main.go

1s

雖然呼叫 defer 關鍵字時也使用值傳遞,但是因為拷貝的是函數指標,所以 time.Since(startedAt) 會在 main 函數返回前呼叫並列印出符合預期的結果。

defer 資料結構

type _defer struct {

siz int32 # 引數和結果的記憶體大小

started bool

openDefer bool # 是否經過開放編碼的優化

sp uintptr # 棧指標

pc uintptr # 呼叫方的程式計數器

fn *funcval # 傳入的函數

_panic *_panic # 觸發延遲呼叫的結構體, 可能為空

link *_defer #

}

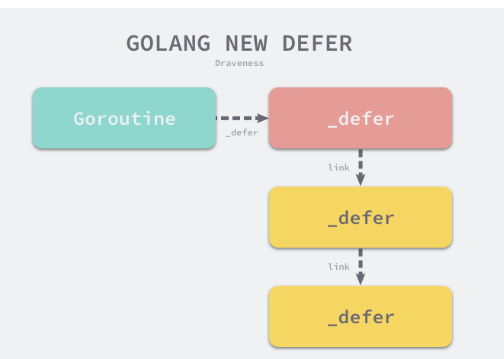

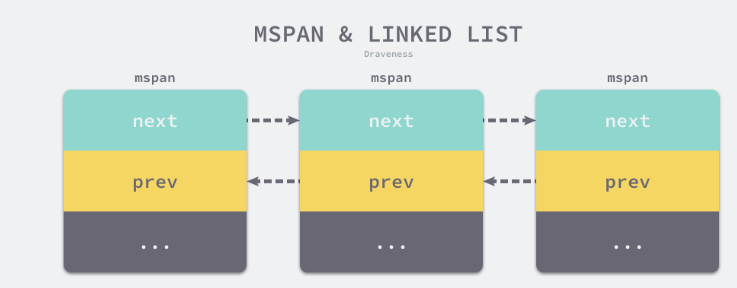

runtime._defer結構體是延遲呼叫連結串列上的一個元素。所有的結構體都會通過link欄位 串聯成 連結串列。

執行機制

gc.state.stmt會負責處理程式中的defer,該函數會根據條件的不同,使用三種不同的機制處理該關鍵字。

func (s *state) stmt(n *Node) {

...

switch n.Op {

case ODEFER:

if s.hasOpenDefers {

s.openDeferRecord(n.Left) // 開放編碼

} else {

d := callDefer // 堆分配

if n.Esc == EscNever {

d = callDeferStack // 棧分配

}

s.callResult(n.Left, d)

}

}

}

堆分配、棧分配和開放編碼是處理 defer 關鍵字的三種方法

堆上分配

堆上分配的runtime._defer 結構體是預設的兜底方案,當方案被啟用時,編譯器會呼叫 callResult和 call.這表示 defer在編譯器看來也是函數呼叫。

call 會負責為所有函數和方法呼叫生成中間程式碼,工作包括以下內容:

- 獲取需要執行的函數名、閉包指標、程式碼指標、和函數呼叫的接收方

- 獲取棧地址並將函數或者方法的引數寫入棧中

- 使用newValue1A以及相關函數生成函數呼叫的中間程式碼

- 如果當前呼叫的函數是defer. 那麼會單獨生成相關的結束程式碼塊。

- 獲取函數的返回值地址並結束當前呼叫。

func (s *state) call(n *Node, k callKind, returnResultAddr bool) *ssa.Value {

...

var call *ssa.Value

if k == callDeferStack {

// 在棧上初始化 defer 結構體

...

} else {

...

switch {

case k == callDefer:

aux := ssa.StaticAuxCall(deferproc, ACArgs, ACResults) # 呼叫 deferproc函數,此函數 接收引數的大小和閉包所在的地址倆個引數

call = s.newValue1A(ssa.OpStaticCall, types.TypeMem, aux, s.mem())

...

}

call.AuxInt = stksize

}

s.vars[&memVar] = call

...

}

編譯器還會通過三個步驟為所有呼叫defer的函數末尾插入 deferreturn 的函數呼叫。

- gc.walkstmt在遇到 ODEFER節點時會執行 sethasdefer(true) 設定當前函數的hasdefer屬性。

- buildssa會執行 s.hasdefer = fn.FUnc.HasDefer() 更新 state的hasdefer.

- gc.state.exit會根據state的hasdefer在函數返回之前插入runtime.deferreturn的函數呼叫。

func (s *state) exit() *ssa.Block {

if s.hasdefer {

...

s.rtcall(Deferreturn, true, nil)

}

...

}

當執行時將 runtime._defer 分配到堆上時,Go 語言的編譯器不僅將 defer 轉換成了 runtime.deferproc,還在所有呼叫 defer 的函數結尾插入了 runtime.deferreturn。上述兩個執行時函數是 defer 關鍵字執行時機制的入口,它們分別承擔了不同的工作:

runtime.deferproc 負責建立新的延遲呼叫;

runtime.deferreturn 負責在函數呼叫結束時執行所有的延遲呼叫;

- 建立延遲呼叫

deferproc會為defer建立一個新的runtime._defer結構體,設定它的函數指標 fn、pc、sp.並將相關的引數拷貝到相鄰的記憶體空間中。

func deferproc(siz int32, fn *funcval) {

sp := getcallersp()

argp := uintptr(unsafe.Pointer(&fn)) + unsafe.Sizeof(fn)

callerpc := getcallerpc()

d := newdefer(siz) # 想盡辦法 獲得 defer結構體。無論使用哪種方式,

# 只要獲取到 runtime._defer 結構體,它都會被追加到所在 Goroutine _defer 連結串列的最前面。

if d._panic != nil {

throw("deferproc: d.panic != nil after newdefer")

}

d.fn = fn

d.pc = callerpc

d.sp = sp

switch siz {

case 0:

case sys.PtrSize:

*(*uintptr)(deferArgs(d)) = *(*uintptr)(unsafe.Pointer(argp))

default:

memmove(deferArgs(d), unsafe.Pointer(argp), uintptr(siz))

}

return0()

}

最後呼叫的 runtime.return0 是唯一一個不會觸發延遲呼叫的函數,它可以避免遞迴 runtime.deferreturn 的遞迴呼叫

defer 關鍵字的插入順序是從後向前的,而 defer 關鍵字執行是從前向後的,這也是為什麼後呼叫的 defer 會優先執行

- 執行延遲呼叫

runtime.deferreturn 會從 Goroutine的 defer連結串列中取出最前面的defer並呼叫jmpdefer傳入需要執行的函數和引數。

func deferreturn(arg0 uintptr) {

gp := getg()

d := gp._defer

if d == nil {

return

}

sp := getcallersp()

...

switch d.siz {

case 0:

case sys.PtrSize:

*(*uintptr)(unsafe.Pointer(&arg0)) = *(*uintptr)(deferArgs(d))

default:

memmove(unsafe.Pointer(&arg0), deferArgs(d), uintptr(d.siz))

}

fn := d.fn

gp._defer = d.link

freedefer(d)

jmpdefer(fn, uintptr(unsafe.Pointer(&arg0))) # 是一個用組合語言實現的執行時函數

# 跳轉到 defer 所在的程式碼段並在執行結束之後跳轉回 runtime.deferreturn。

}

棧上分配

預設情況下,defer結構體都會在堆上分配,如果能夠將部分結構體分配到站上就可以節約記憶體分配帶來的額外開銷。

當該關鍵字 在函數 體中最多執行一次時,編譯期間的call會將結構體分配到棧上並呼叫。 deferprocStack:

func (s *state) call(n *Node, k callKind) *ssa.Value {

...

var call *ssa.Value

if k == callDeferStack {

// 在棧上建立 _defer 結構體

t := deferstruct(stksize)

...

ACArgs = append(ACArgs, ssa.Param{Type: types.Types[TUINTPTR], Offset: int32(Ctxt.FixedFrameSize())})

aux := ssa.StaticAuxCall(deferprocStack, ACArgs, ACResults) // 呼叫 deferprocStack

arg0 := s.constOffPtrSP(types.Types[TUINTPTR], Ctxt.FixedFrameSize())

s.store(types.Types[TUINTPTR], arg0, addr)

call = s.newValue1A(ssa.OpStaticCall, types.TypeMem, aux, s.mem())

call.AuxInt = stksize

} else {

...

}

s.vars[&memVar] = call

...

}

因為在編譯期間我們已經建立了 runtime._defer 結構體,所以在執行期間 runtime.deferprocStack 只需要設定一些未在編譯期間初始化的欄位,就可以將棧上的 runtime._defer 追加到函數的連結串列上:

除了分配位置的不同,棧上分配和堆上分配的 runtime._defer 並沒有本質的不同,而該方法可以適用於絕大多數的場景,與堆上分配的 runtime._defer 相比,該方法可以將 defer 關鍵字的額外開銷降低 ~30%。

開放編碼

Open Coded實現defer關鍵字。該設計使用程式碼內聯優化defer關鍵的額外開銷並引入函數資料 funcdata管理panic的呼叫。

panic 和 recover

都是go語言的內建函數,提供了互補的功能。

panic 能夠改變程式的控制流。呼叫panic後會立刻停止執行當前函數的剩餘程式碼。並在當前Goroutine中遞迴執行呼叫方的 defer.

recover 可以中止panic造成的程式崩潰,它是一個只能在defer中發揮作用的函數,在其他作用域中呼叫不會發揮作用。

paninc 現象

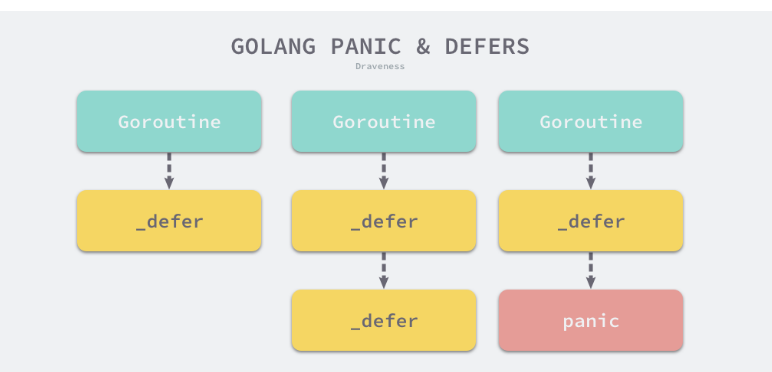

- panic 只會觸發當前Goroutine的defer

- recover只有在 defer中呼叫才會生效

- panic 允許在defer中巢狀多次呼叫

跨協程失效

func main() {

defer println("in main")

go func() {

defer println("in goroutine")

panic("")

}()

time.Sleep(1 * time.Second)

}

$ go run main.go

in goroutine

panic:

...

in main並沒有列印。 只列印了 in goroutine.

失效的崩潰恢復

func main() {

defer fmt.Println("in main")

if err := recover(); err != nil {

fmt.Println(err)

}

panic("unknown err")

}

$ go run main.go

in main

panic: unknown err

goroutine 1 [running]: # 非正常退出

main.main()

...

exit status 2

recover 只有在panic之後呼叫才生效,就是要在defer函數中。

巢狀奔潰

panic是可以多次巢狀呼叫的

func main() {

defer fmt.Println("in main")

defer func() {

defer func() {

panic("panic again and again")

}()

panic("panic again")

}()

panic("panic once")

}

$ go run main.go

in main

panic: panic once

panic: panic again

panic: panic again and again

goroutine 1 [running]:

...

exit status 2

panic 資料結構

runtime._panic 結構體表示。

type _panic struct {

argp unsafe.Pointer # 執行defer呼叫時引數的指標

arg interface{} # 呼叫panic時傳入的引數

link *_panic # 指向了更早的panic結構

recovered bool # 當前panic是否被recover恢復

aborted bool # 當前的panic是否被強行終止

pc uintptr

sp unsafe.Pointer

goexit bool

}

程式奔潰

編譯器會將panic轉換成gopanic.該函數的執行過程包3個步驟

- 建立新的panic並新增到Goroutine的panic連結串列的最前面

- 在迴圈中 不斷從當前的Goroutine的defer中連結串列獲取 defer並呼叫 reflectcall執行延遲呼叫函數。

- 呼叫runtime.fatalpanic中止整個程式。

func gopanic(e interface{}) {

gp := getg()

...

var p _panic

p.arg = e

p.link = gp._panic

gp._panic = (*_panic)(noescape(unsafe.Pointer(&p)))

for {

d := gp._defer

if d == nil {

break

}

d._panic = (*_panic)(noescape(unsafe.Pointer(&p)))

reflectcall(nil, unsafe.Pointer(d.fn), deferArgs(d), uint32(d.siz), uint32(d.siz))

d._panic = nil

d.fn = nil

gp._defer = d.link

freedefer(d)

if p.recovered {

...

}

}

fatalpanic(gp._panic) # 實現了無法被恢復的程式崩潰,它在中止程式之前會通過

*(*int)(nil) = 0

}

需要注意的是,上述函數中省略了三部分比較重要的程式碼:

- 恢復程式的 recover 分支中的程式碼;

- 通過內聯優化 defer 呼叫效能的程式碼3;

runtime: make defers low-cost through inline code and extra funcdata - 修復 runtime.Goexit 異常情況的程式碼;

runtime.printpanics 列印出全部的 panic 訊息以及呼叫時傳入的引數

列印崩潰訊息後會呼叫 runtime.exit 退出當前程式並返回錯誤碼 2,程式的正常退出也是通過 runtime.exit 實現的。

func fatalpanic(msgs *_panic) {

pc := getcallerpc()

sp := getcallersp()

gp := getg()

if startpanic_m() && msgs != nil {

atomic.Xadd(&runningPanicDefers, -1)

printpanics(msgs)

}

if dopanic_m(gp, pc, sp) {

crash()

}

exit(2)

}

崩潰恢復

recover是如何中止程式崩潰的。

編譯器會將關鍵字 recover轉換成 runtime.gorecover

func gorecover(argp uintptr) interface{} {

gp := getg()

p := gp._panic

if p != nil && !p.recovered && argp == uintptr(p.argp) {

p.recovered = true

return p.arg

}

return nil

}

該函數的實現很簡單,如果當前 Goroutine 沒有呼叫 panic,那麼該函數會直接返回 nil,這也是崩潰恢復在非 defer 中呼叫會失效的原因。在正常情況下,它會修改 runtime._panic 的 recovered 欄位,runtime.gorecover 函數中並不包含恢復程式的邏輯,程式的恢復是由 runtime.gopanic 函數負責的:

func gopanic(e interface{}) {

...

for {

// 執行延遲呼叫函數,可能會設定 p.recovered = true

...

pc := d.pc

sp := unsafe.Pointer(d.sp)

...

if p.recovered {

gp._panic = p.link

for gp._panic != nil && gp._panic.aborted {

gp._panic = gp._panic.link

}

if gp._panic == nil {

gp.sig = 0

}

gp.sigcode0 = uintptr(sp)

gp.sigcode1 = pc

mcall(recovery)

throw("recovery failed")

}

}

...

}

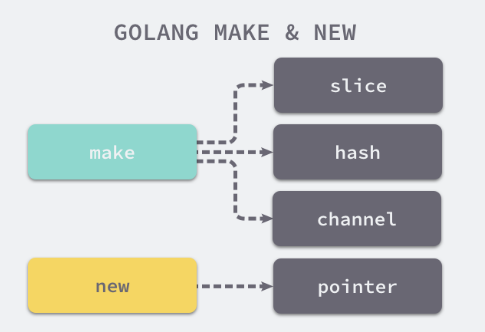

make 和 new

初始化一個結構體,會用到 make和new。

make 的作用 是初始化內建的資料結構, 切片、雜湊表 、 channel.

new 的作用 根據傳入的型別分配一片記憶體空間,並返回這片記憶體空間的指標

slice := make([]int, 0, 100)

hash := make(map[int]bool, 10)

ch := make(chan int, 5)

i := new(int)

var v int

i := &v

new 只能接收型別作為引數 然後返回一個指向該型別的指標

make

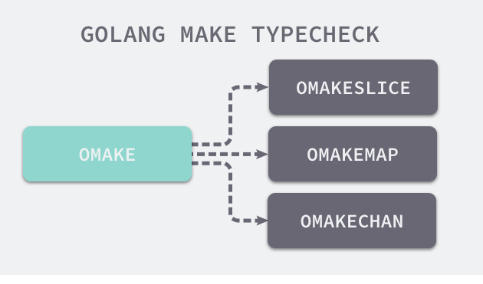

在編譯期間的型別檢查階段,Go 語言會將代表 make 關鍵字的 OMAKE 節點根據引數型別的不同轉換成了 OMAKESLICE、OMAKEMAP 和 OMAKECHAN 三種不同型別的節點,這些節點會呼叫不同的執行時函數來初始化相應的資料結構。

new

編譯器會在中間程式碼生成階段通過以下兩個函數處理該關鍵字

- gc.callnew 會將關鍵字轉換成 ONEWOBJ 型別的節點

- gc.state.exper會根據申請空間的大小分倆種情況處理

- 如果申請的空間為0,就會返回一個表示空指標的 zerobase變數。

- 在遇到其他情況時會將關鍵字轉換成 runtime.newobject函數。

func callnew(t *types.Type) *Node {

...

n := nod(ONEWOBJ, typename(t), nil)

...

return n

}

func (s *state) expr(n *Node) *ssa.Value {

switch n.Op {

case ONEWOBJ:

if n.Type.Elem().Size() == 0 {

return s.newValue1A(ssa.OpAddr, n.Type, zerobaseSym, s.sb)

}

typ := s.expr(n.Left)

vv := s.rtcall(newobject, true, []*types.Type{n.Type}, typ)

return vv[0]

}

}

需要注意的是,無論是直接使用 new,還是使用 var 初始化變數,它們在編譯器看來都是 ONEW 和 ODCL 節點。如果變數會逃逸到堆上,這些節點在這一階段都會被gc.walkstmt 轉換成通過 runtime.newobject 函數並在堆上申請記憶體.

func walkstmt(n *Node) *Node {

switch n.Op {

case ODCL:

v := n.Left

if v.Class() == PAUTOHEAP {

if prealloc[v] == nil {

prealloc[v] = callnew(v.Type)

}

nn := nod(OAS, v.Name.Param.Heapaddr, prealloc[v])

nn.SetColas(true)

nn = typecheck(nn, ctxStmt)

return walkstmt(nn)

}

case ONEW:

if n.Esc == EscNone {

r := temp(n.Type.Elem())

r = nod(OAS, r, nil)

r = typecheck(r, ctxStmt)

init.Append(r)

r = nod(OADDR, r.Left, nil)

r = typecheck(r, ctxExpr)

n = r

} else {

n = callnew(n.Type.Elem())

}

}

}

runtime.newobject 函數會獲取傳入型別佔用空間的大小,呼叫 runtime.mallocgc 在堆上申請一片記憶體空間並返回指向這片記憶體空間的指標:

func newobject(typ *_type) unsafe.Pointer {

return mallocgc(typ.size, typ, true)

}

執行時

上下文Context

Context 是Go語言中用來設定截止日期、同步訊號、傳遞請求相關值得結構體。

上下文與Goroutine有比較密切的 關係,

是Go語言在1.7版本引入標準庫的介面。定義了4個需要實現的方法

- Deadline 返回context.Context被取消的時間,也就是完成工作的截止日期

- Done 返回一個Channel.這個Channel會在當前工作完成或者上下文被取消後關閉,多次呼叫返回同一個Channel.

- Err 返回Context結束的原因。

- 如果被取消,會返回Canceled錯誤。

- 如果超時,會返回DeadlineExceeded錯誤。

- Value 從Context中獲取鍵對應的值,對於同一個上下文來說,多次呼叫Value並傳入相同的key.會返回相同的結果。該方法可以用來傳遞請求特定的資料。

type Context interface {

Deadline() (deadline time.Time, ok bool)

Done() <-chan struct{}

Err() error

Value(key interface{}) interface{}

}

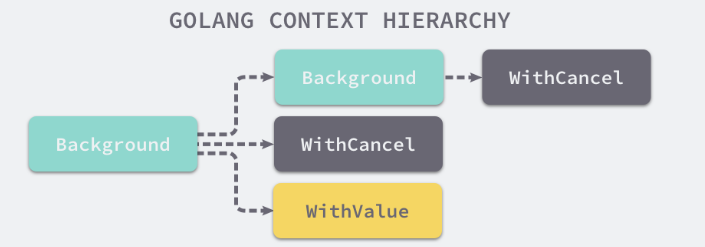

context 包中提供的BackGround、TODO、WithDeadline和WithValue函數會返回實現該介面的私有結構體。

設計原理

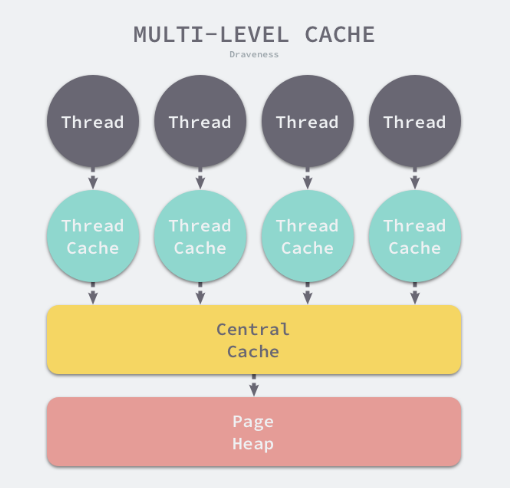

在Goroutine構成的樹形結構中對訊號進行同步以減少計算資源的浪費 是Context的最大作用。

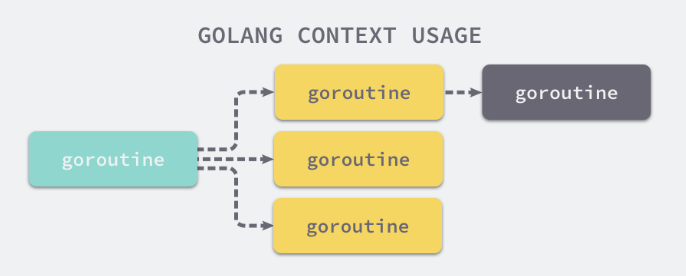

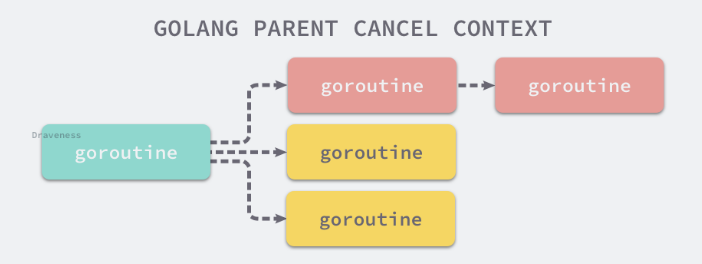

GO服務的每一個請求都是通過單獨的Goroutine處理的。http/rpc請求的處理器會啟動新的Goroutine存取資料庫和其他服務。

會建立多個Goroutine來處理一次請求,Context的作用實在不同Goroutine之間同步請求特定資料、取消訊號、處理請求的截止日期

每一個Context都會從最頂層的Goroutine一層一層傳遞到最下層。

可以在最上層Goroutine執行出現錯誤時,將訊號同步給下層。

建立一個過期時間為1s的上下文。並向上下文傳入handle函數,該方法會使用500ms的時間處理傳入的請求:

func main() {

ctx, cancel := context.WithTimeout(context.Background(), 1*time.Second)

defer cancel()

go handle(ctx, 500*time.Millisecond)

select {

case <-ctx.Done():

fmt.Println("main", ctx.Err())

}

}

func handle(ctx context.Context, duration time.Duration) {

select {

case <-ctx.Done():

fmt.Println("handle", ctx.Err())

case <-time.After(duration):

fmt.Println("process request with", duration)

}

}

因為過期時間大於處理時間,所以我們有足夠的時間處理該請求,該上述程式碼會列印出下面的內容:

$ go run context.go

process request with 500ms

main context deadline exceeded

handle 函數沒有進入超時的select分支,但是main函數的select卻會等待Context超時,並列印出 main context deadline exceeded

如果我們將處理請求時間增加是1.5s.整個程式都會因為上下文的過期而被終止。

預設上下文

context包中最常用的方法還是Background、TODO.這倆個方法都會返回預先初始化好的私有變數 background 、 todo.它們會在同一個Go程式中被複用。

func Background() Context {

return background

}

func TODO() Context {

return todo

}

這倆個私有變數都是通過new(emptyCtx)語句初始化的。它們是指向私有結構體context.emptyCtx的指標,

type emptyCtx int

func (*emptyCtx) Deadline() (deadline time.Time, ok bool) {

return

}

func (*emptyCtx) Done() <-chan struct{} {

return nil

}

func (*emptyCtx) Err() error {

return nil

}

func (*emptyCtx) Value(key interface{}) interface{} {

return nil

}

通過空方法實現了Context介面中的所有方法,沒有任何功能

取消訊號

WithCancel函數能從Context中衍生出一個新的上下文並返回用於取消該上下文的函數。

一旦我們指向返回的取消函數,當前上下文以及他的子上下文都會被取消。多有的Goroutine都會同步收到這一取消訊號。

func WithCancel(parent Context) (ctx Context, cancel CancelFunc) {

c := newCancelCtx(parent)

propagateCancel(parent, &c)

return &c, func() { c.cancel(true, Canceled) }

}

同步原語與鎖

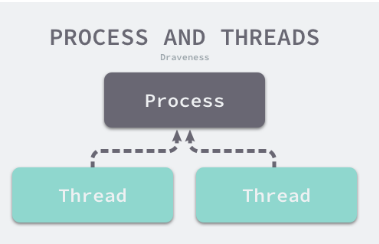

go語言作為一個原生支援使用者態程序Goroutine的語言, 當提到並行程式設計、多執行緒程式設計時。都離不開鎖這一概念。

鎖是一種並行程式設計中的同步原語 Synchronization Primitives.

它能保證多個Goroutine在存取同一片記憶體時不會出現競爭條件 Race Condition.

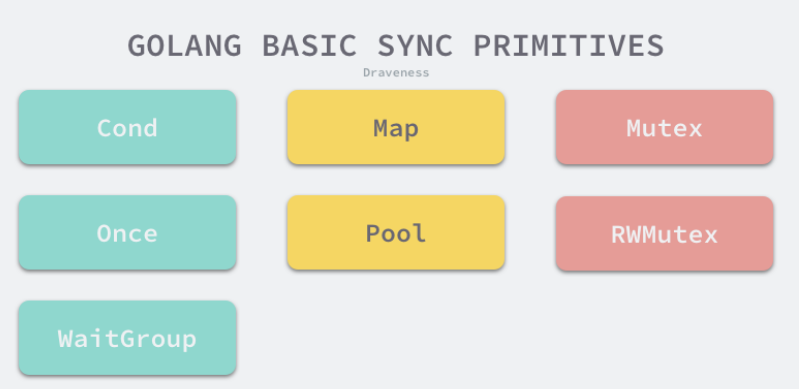

基本原語

sync.Mutex、sync.RWMutex、sync.WaitGroup、sync.Once和sync.Cond:

- Mutex

type Mutex struct {

state int32 # 當前互斥鎖的狀態。

sema uint32 # 用於控制鎖狀態的號誌

}

倆個加起來只佔8位元組的結構體,表示了go語言中的互斥鎖。

- 狀態

互斥鎖的狀態比較複雜,最低三位分別表示mutexLocked、mutexWoken、mutexStarving.

剩下的位置用來表示多少個Goroutine在等待互斥鎖的釋放

預設情況下,互斥鎖的狀態位都是0. int32中的不同位分別表示了不同的狀態。

1) mutexLocked - 表示互斥鎖的鎖定狀態

2) mutexWoken - 表示從正常模式被從喚醒

3) mutexStarving - 當前的互斥鎖進入飢餓狀態

4) waitersCount - 當前互斥鎖上等待的Goroutine個數。

- 正常模式和飢餓模式

Mutex有倆種模式, 正常模式和飢餓模式,

在正常模式下,鎖的 等待者會按照先進先出的順序獲取鎖,

但是剛被喚起的Goroutine與新建立的Goroutine競爭時,大概率或獲取不到鎖,為了減少這種情況的出現。

一旦Goroutine超過1ms沒有獲取到鎖。它就會將當前互斥鎖切換飢餓模式,防止部分Goroutine被【餓死】

飢餓模式是1.9中引入的優化,為了保證互斥鎖的公平性。

在飢餓模式中,互斥鎖會直接交給等待佇列最前面的Goroutine.新的Goroutine在該狀態下不能獲取鎖、也不會進入自旋狀態。它們只會在佇列的末尾等待。

如果一個Goroutine獲得了互斥鎖並且他在佇列的末尾或者他等待的時間少於1ms,那麼當前的互斥鎖就會切回正常模式。

與飢餓模式相比,正常模式下的互斥鎖能夠提供更好的效能,

飢餓模式能避免Goroutine由於陷入等待無法獲取鎖而造成的高尾延時。

- 加鎖和解鎖

互斥鎖的加鎖和解鎖的過程。

分別使用Mutex.lock和unlock方法。

當鎖的狀態是0時,將mutexLocked位置成1

func (m *Mutex) Lock() {

if atomic.CompareAndSwapInt32(&m.state, 0, mutexLocked) {

return

}

m.lockSlow()

}

如果互斥鎖的狀態不是0時,就會呼叫lockSlow嘗試通過自旋 Spinning等方式等待鎖的釋放。該方法的主題是一個非常大的for迴圈。

1、判斷當前Goroutine能否進入自旋

2、通過自旋等待互斥鎖的釋放

3、計算互斥鎖的最新狀態

4、更新互斥鎖的狀態並 獲取鎖。

鎖是如何判斷當前Goroutine能否進入自旋等互斥鎖的釋放。

func (m *Mutex) lockSlow() {

var waitStartTime int64

starving := false

awoke := false

iter := 0

old := m.state

for {

if old&(mutexLocked|mutexStarving) == mutexLocked && runtime_canSpin(iter) {

if !awoke && old&mutexWoken == 0 && old>>mutexWaiterShift != 0 &&

atomic.CompareAndSwapInt32(&m.state, old, old|mutexWoken) {

awoke = true

}

runtime_doSpin()

iter++

old = m.state

continue

}

自旋是多執行緒同步機制,當前的程序在進入自旋的過程中會一直保持CPU的佔用。

持續檢查某個條件是否為真。

在多核的CPU上,自旋可以避免Goroutine的切換。

使用恰當會對效能帶來很大的增益。

Goroutine進入自旋的條件非常苛刻。

1.互斥鎖只有在普通模式才能進入自旋。

2.runtime.sync_runtime_capSpin需要返回true:

- 執行在多CPU的機器上

2)當前Goroutine為了獲取該鎖進入自旋的次數小於4次

3)當前機器上至少存在一個正在執行的處理器P 並且處理的執行佇列為空

一旦當前Goroutine能夠進入自旋就會呼叫runtime.sync_runtime_doSpin和runtime.procyield並執行30次的PAUS指令。

該指令只會佔用CPU並消耗CPU時間。

func sync_runtime_doSpin() {

procyield(active_spin_cnt)

}

TEXT runtime·procyield(SB),NOSPLIT,$0-0

MOVL cycles+0(FP), AX

again:

PAUSE

SUBL $1, AX

JNZ again

RET

處理了自旋相關的特殊邏輯後,互斥鎖會根據上下文計算當前互斥鎖的最新狀態。

幾個不同的條件分別會更新state欄位中儲存的不同資訊。

new := old

if old&mutexStarving == 0 {

new |= mutexLocked

}

if old&(mutexLocked|mutexStarving) != 0 {

new += 1 << mutexWaiterShift

}

if starving && old&mutexLocked != 0 {

new |= mutexStarving

}

if awoke {

new &^= mutexWoken

}

計算了新的互斥鎖狀態之後,會使用 CAS 函數 sync/atomic.CompareAndSwapInt32 更新狀態:

if atomic.CompareAndSwapInt32(&m.state, old, new) {

if old&(mutexLocked|mutexStarving) == 0 {

break // 通過 CAS 函數獲取了鎖

}

...

#如果沒有通過 CAS 獲得鎖,會呼叫 runtime.sync_runtime_SemacquireMutex 通過號誌保證資源不會被兩個 Goroutine 獲取。

runtime_SemacquireMutex(&m.sema, queueLifo, 1)

starving = starving || runtime_nanotime()-waitStartTime > starvationThresholdNs

old = m.state

if old&mutexStarving != 0 {

delta := int32(mutexLocked - 1<<mutexWaiterShift)

if !starving || old>>mutexWaiterShift == 1 {

delta -= mutexStarving

}

atomic.AddInt32(&m.state, delta)

break

}

awoke = true

iter = 0

} else {

old = m.state

}

}

}

sync_runtime_SemacquireMutex 會在方法中不斷嘗試獲取鎖並陷入休眠等待號誌的釋放,一旦當前 Goroutine 可以獲取號誌,它就會立刻返回,sync.Mutex.Lock 的剩餘程式碼也會繼續執行。

在正常模式下,這段程式碼會設定喚醒和飢餓標記、重置迭代次數並重新執行獲取鎖的迴圈;

在飢餓模式下,當前 Goroutine 會獲得互斥鎖,如果等待佇列中只存在當前 Goroutine,互斥鎖還會從飢餓模式中退出;

互斥鎖的解鎖過程 sync.Mutex.Unlock 與加鎖過程相比就很簡單,該過程會先使用 sync/atomic.AddInt32 函數快速解鎖,這時會發生下面的兩種情況:

如果該函數返回的新狀態等於 0,當前 Goroutine 就成功解鎖了互斥鎖;

如果該函數返回的新狀態不等於 0,這段程式碼會呼叫 sync.Mutex.unlockSlow 開始慢速解鎖:

func (m *Mutex) Unlock() {

new := atomic.AddInt32(&m.state, -mutexLocked)

if new != 0 {

m.unlockSlow(new)

}

}

sync.Mutex.unlockSlow 會先校驗鎖狀態的合法性 — 如果當前互斥鎖已經被解鎖過了會直接丟擲異常 「sync: unlock of unlocked mutex」 中止當前程式。

在正常情況下會根據當前互斥鎖的狀態,分別處理正常模式和飢餓模式下的互斥鎖:

func (m *Mutex) unlockSlow(new int32) {

if (new+mutexLocked)&mutexLocked == 0 {

throw("sync: unlock of unlocked mutex")

}

if new&mutexStarving == 0 { // 正常模式

old := new

for {

if old>>mutexWaiterShift == 0 || old&(mutexLocked|mutexWoken|mutexStarving) != 0 {

return

}

new = (old - 1<<mutexWaiterShift) | mutexWoken

if atomic.CompareAndSwapInt32(&m.state, old, new) {

runtime_Semrelease(&m.sema, false, 1)

return

}

old = m.state

}

} else { // 飢餓模式

runtime_Semrelease(&m.sema, true, 1)

}

}

在正常模式下,上述程式碼會使用如下所示的處理過程:

如果互斥鎖不存在等待者或者互斥鎖的 mutexLocked、mutexStarving、mutexWoken 狀態不都為 0,那麼當前方法可以直接返回,不需要喚醒其他等待者;

如果互斥鎖存在等待者,會通過 sync.runtime_Semrelease 喚醒等待者並移交鎖的所有權;

在飢餓模式下,上述程式碼會直接呼叫 sync.runtime_Semrelease 將當前鎖交給下一個正在嘗試獲取鎖的等待者,等待者被喚醒後會得到鎖,在這時互斥鎖還不會退出飢餓狀態;

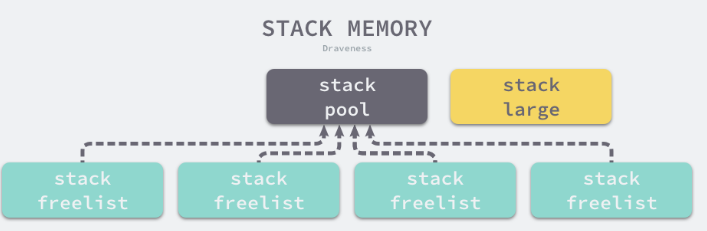

計時器

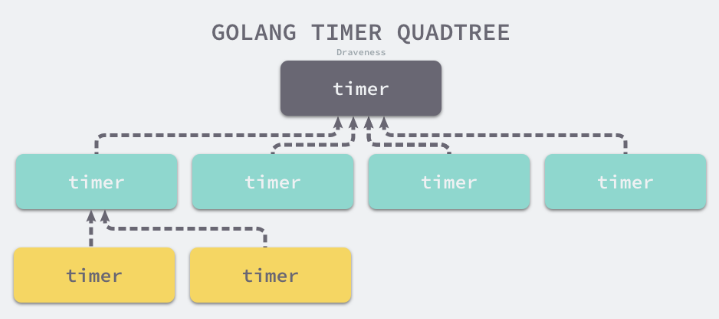

全域性四叉堆

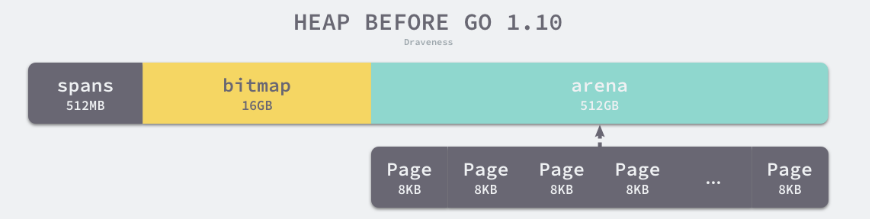

Go 1.10 之前的 計時器 都是 最小四叉堆實現

var timers struct {

lock mutex

gp *g

created bool

sleeping bool

rescheduling bool

sleepUntil int64

waitnote note

t []*timer # 最小四叉堆

}

執行時建立的所有計時器都會加入到四叉堆中

runtime.timerproc Goroutine會執行時間驅動的事件。執行時會在發生以下事件時喚醒計時器

- 四叉堆中的計數器到期

- 四叉堆中加入了觸發時間更早的新計時器

全域性四叉堆共用的互斥鎖對計時器的影響非常大。

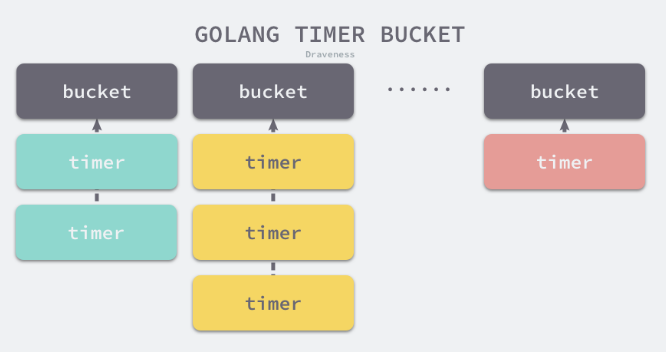

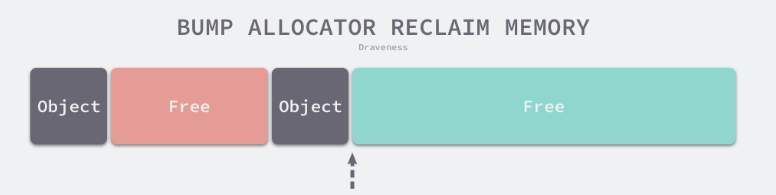

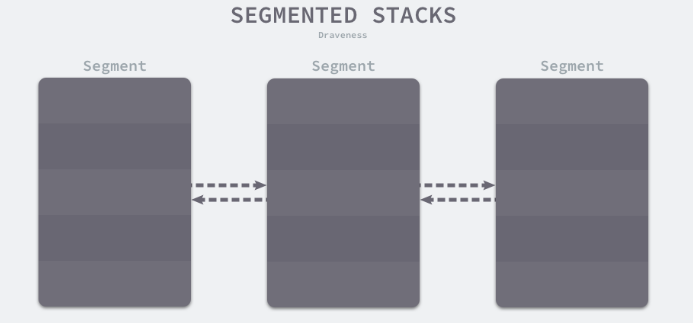

分片四叉堆

1.10 將全域性的四叉堆分割成了64個更小的四叉堆。

在理想的情況下,四叉堆的數量應該等於處理器的數量。但是需要實現動態分配的過程。

最終選擇初始化64個四叉堆。以犧牲記憶體佔用的代價換取效能的提升。

const timersLen = 64

var timers [timersLen]struct {

timersBucket

}

type timersBucket struct {

lock mutex

gp *g

created bool

sleeping bool

rescheduling bool

sleepUntil int64

waitnote note

t []*timer

}

如果當前機器上的處理器P的個數超過了64,多個處理器上的計時器就可能儲存在同一個桶中。

每一個計時器桶 都由一個執行runtime.timerproc函數的Goroutine處理。

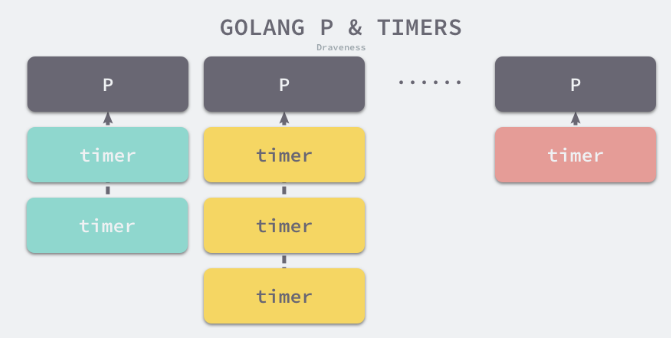

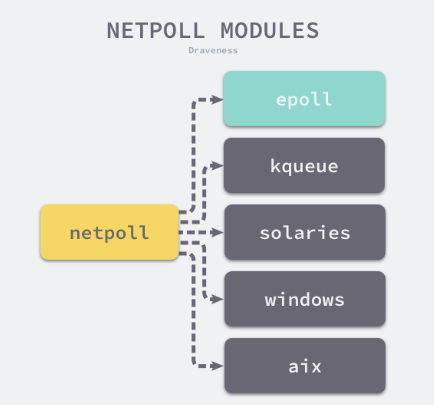

網路輪詢器

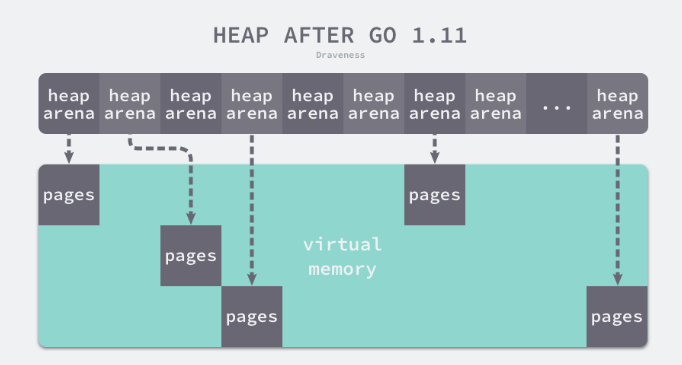

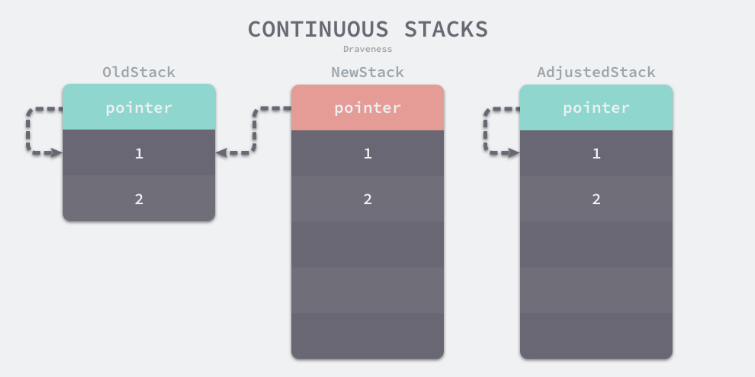

最新版本實現中,計時器桶已被移除,所有的計時器都以最小四叉堆的形式儲存在處理器 runtime.p中。

type p struct {

...

timersLock mutex # 用於保護計時器的互斥鎖

timers []*timer # 用於儲存計時器的最小四叉堆

numTimers uint32 # 計時器中的數量

adjustTimers uint32 # 處於timerModifiedEarlier狀態的計時器數量

deletedTimers uint32 # 處於timerDeleted狀態的計時器數量

...

}

timer資料結構

type timer struct {

pp puintptr

when int64 # 當前計時器被喚醒的時間

period int64 # 倆次被喚醒的時間間隔

f func(interface{}, uintptr) # 計時器被喚醒都會呼叫的函數

arg interface{} # 計時器被喚醒是呼叫f 傳入的引數

seq uintptr #

nextwhen int64 # 計時器處於timerModifiedXX狀態時,用於設定when欄位

status uint32 # 計時器的狀態

}

對外暴露的是Timer

type Timer struct {

C <-chan Time

r runtimeTimer

}

狀態機

執行時使用狀態機的方式處理全部的計時器,其中包括10種狀態和幾種操作。

由於go語言的計時器支援增刪改和重置操作。

| 狀態 | 解釋 |

|---|---|

| timerNoStatus | 還沒有設定狀態 |

| timerWaiting | 等待觸發 |

| timerRunning | 執行計時器函數 |

| timerDeleted | 被刪除 |

| timerRemoving | 正在被刪除 |

| timerRemoved | 已經被停止並從堆中刪除 |

| timerModifying | 正在被修改 |

| timerModifiedEarlier | 被修改到了更早的時間 |

| timerModifiedLater | 被修改到了更晚的時間 |

| timerMoving | 已經被修改正在被移動 |

Channel

作為Go核心的資料結構和Goroutine之間的通訊方式。

Channel是支撐Go語言高效能並行程式設計模型的重要結構。

Channel設計原理

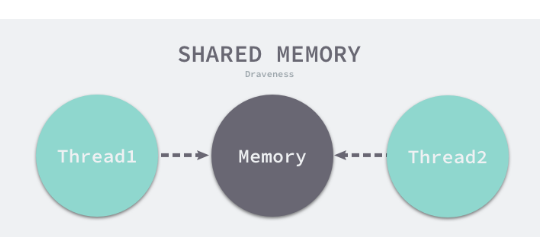

設計模式:不要通過共用記憶體的方式進行通訊,應該通過通訊的方式共用記憶體。

多執行緒使用共用記憶體傳遞資料

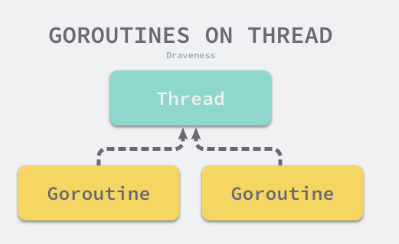

Go語言提供了一種不同的並行模型,即交談循序程式 Communicating sequential processes CSP.

Goroutine和Channel分別對應CSP中的實體和傳遞資訊的媒介。

倆個Goroutine,一個會向Channel中傳送資料,另一個會從Channel中接收資料。

它們倆者能夠獨立執行並不存在直接關聯,通過Channel間接完成通訊。

-

先入先出

1) 先從Channel讀取資料的Goroutine會先接收到資料

2) 先向Channel傳送資料的Goroutine會得到先傳送資料的權利 -

無鎖管道

鎖是一種常見的並行控制技術,我們一般會將鎖分成樂觀鎖和悲觀鎖。即樂觀並行控制和悲觀並行控制

無鎖 lock-free佇列更準確的描述是使用樂觀並行控制的佇列。

樂觀並行控制也叫樂觀鎖。

樂觀鎖只是一種並行控制的思想。

樂觀並行控制本質上是基於驗證的協定,我們使用原子指令 CAS(compare-and-swap 或者 compare-and-set)在多執行緒中同步資料,無鎖佇列的實現也依賴這一原子指令

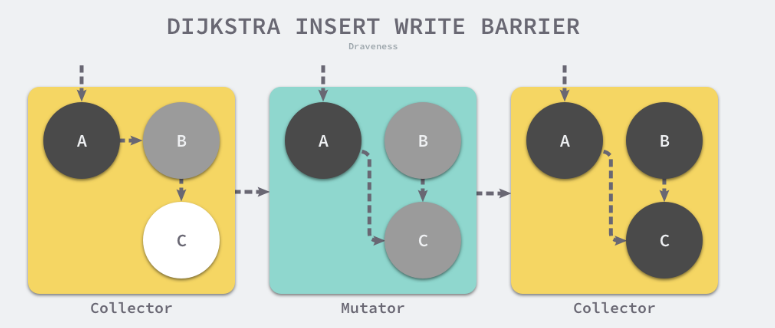

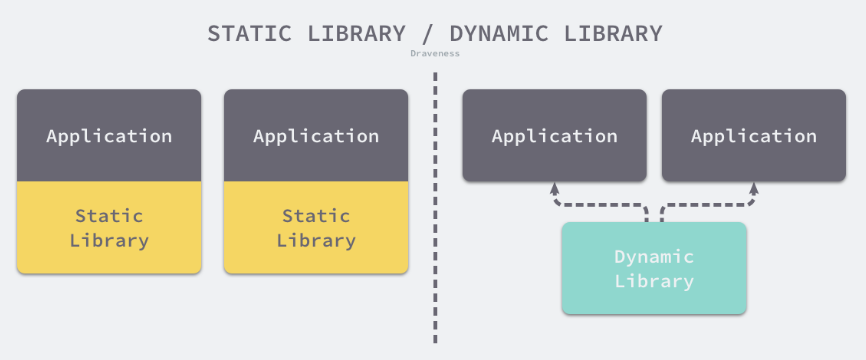

Channel 在執行時的內部表示是 runtime.hchan,該結構體中包含了用於保護成員變數的互斥鎖,

Channel 是一個用於同步和通訊的有鎖佇列,使用互斥鎖解決程式中可能存在的執行緒競爭問題是很常見的,我們能很容易地實現有鎖佇列。

然而鎖導致的休眠和喚醒會帶來額外的上下文切換,如果臨界區過大,加鎖解鎖導致的額外開銷就會成為效能瓶頸。

1994 年的論文 Implementing lock-free queues 就研究瞭如何使用無鎖的資料結構實現先進先出佇列,

而 Go 語言社群也在 2014 年提出了無鎖 Channel 的實現方案,該方案將 Channel 分成了以下三種型別:

1)同步channel - 不需要緩衝區,傳送方會直接將資料 交給 handoff 接收方

2)非同步channel - 基於環形快取的傳統生產者消費者模型

3)chan struct{} 型別 的非同步Channel - struct{}型別不佔用記憶體 空間。不需要實現緩衝區和直接傳送handoff的語意。

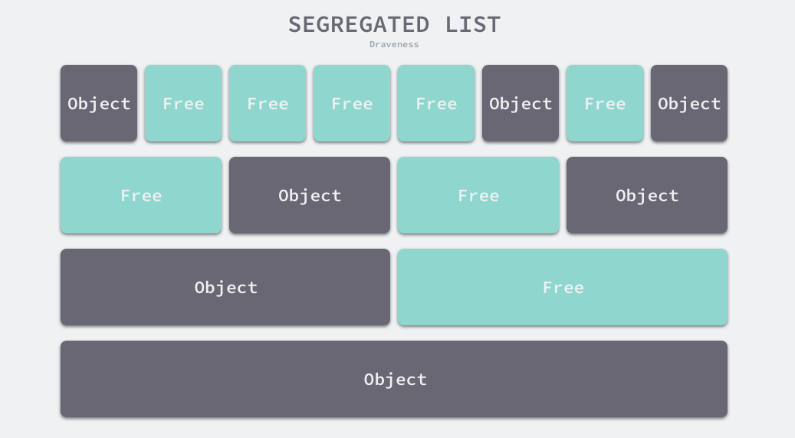

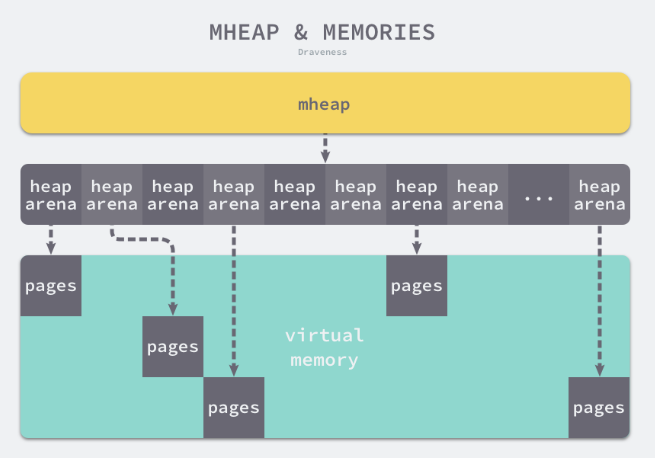

Channel資料結構

type hchan struct {

qcount uint # Channel中元素的個數

dataqsiz uint # Channel中迴圈佇列的長度

buf unsafe.Pointer # 緩衝區資料指標

elemsize uint16 # 當前Channel能夠收發的元素個數

closed uint32

elemtype *_type # 能夠收發的元素型別。

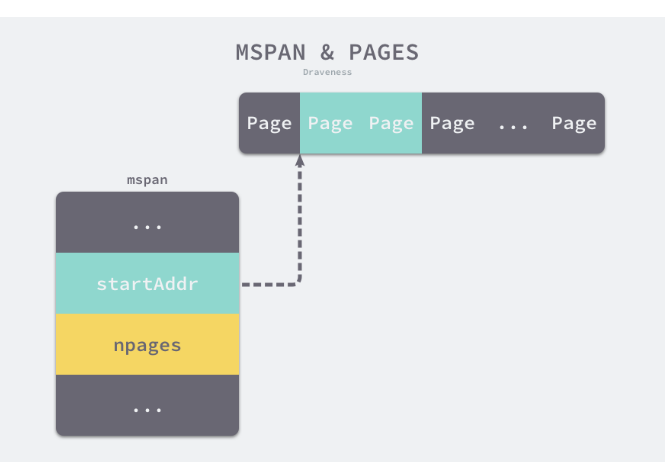

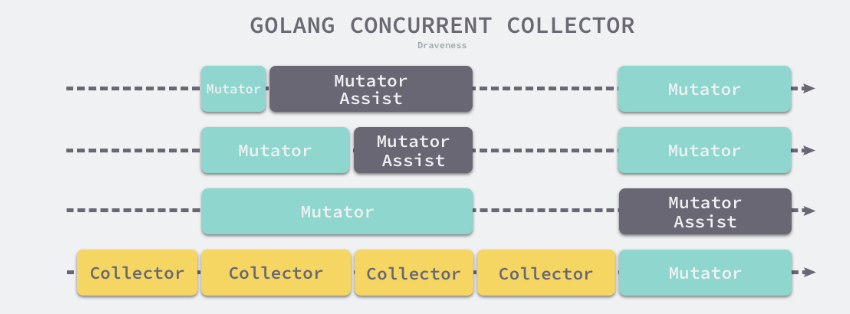

sendx uint # 傳送操作處理到的位置