手部骨骼跟蹤能力,打造控制虛擬世界的手勢密碼

AR作為一項擴增實境技術,帶來了虛擬數位世界與現實世界的深度融合,這種虛實融合,不僅能應用於虛擬汽車展示、虛擬室內設計等視覺互動場景,更可通過動作互動控制虛擬世界場景,實現無邊界的人機互動。

比如人們在拍攝短視訊時,可以不接觸螢幕,僅通過做出特定手勢來控制特效切換;也可以在拍照時通過手勢識別控制快門拍攝;還可以實現試用美甲款式、戒指試戴等。以上AR應用場景需做到精確的手部識別,這就要用到AR Engine的手部骨骼跟蹤能力。

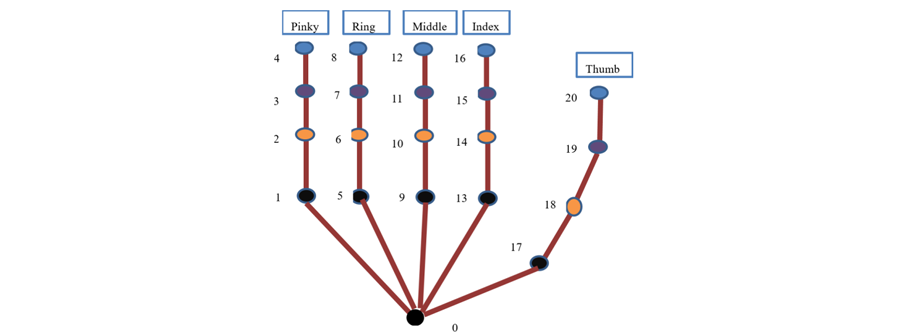

手部骨骼跟蹤能力可識別和跟蹤21個手部關節點的位置和姿態,並輸出手指端點、手掌朝向、手部骨骼等手部高階特徵,形成手部骨骼模型。當影象中出現多隻手時,只反饋最清晰置信度最高的手的識別結果和座標資訊,目前僅支援可獲取深度資訊的指定華為機型。

通過手部骨骼識別能力,可將虛擬物體疊加到更為精確的手部位置,例如手指尖、手掌心等;利用手部骨骼,可驅動虛擬手做出更為豐富和精細的操控動作,能夠為AR應用提供增強的互動功能,便於拓展更多新奇的玩法。

手部骨骼定義圖

應用場景

一、簡單的手語翻譯

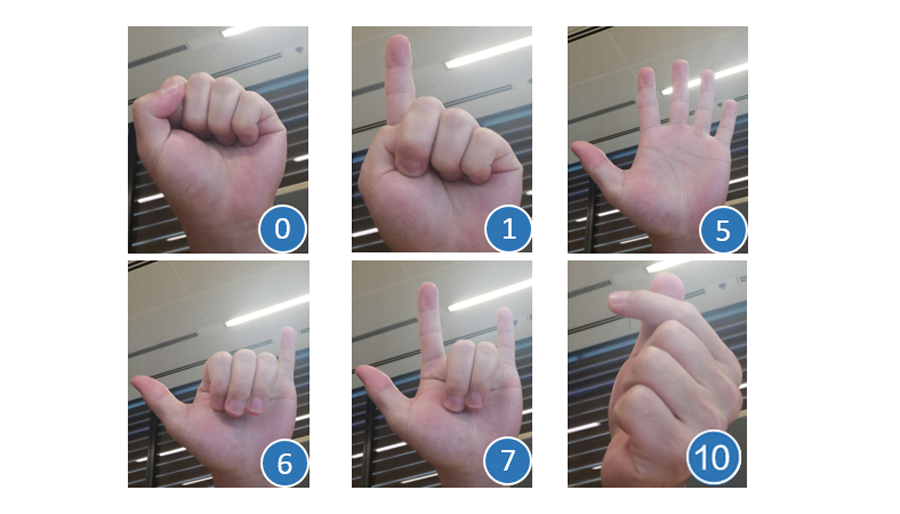

手部骨骼跟蹤能力可以形成簡單的手語理解。在對手部骨骼關鍵點進行提取的基礎上,根據關鍵點的變化預測手部姿態,可以將彎曲、豎直等手指狀態集對映到一組預定義的手勢,比如食指直直伸出就代表計數手勢「1」,通過此類演演算法推匯出的手勢動作,就是形成手語理解的基礎,可應用於手語的識別和翻譯。

二、構建非接觸式操作介面

科幻電影中常常會出現人物隔空操作電腦介面的場景,而此類功能基於手部骨骼跟蹤能力也可以實現。

通過攝像頭對手部骨骼的識別跟蹤,可精確定位指尖等關鍵節點資訊,從而實現對虛擬物件的物理互動。比如使用手指按下虛擬按鈕或其他UI元素;捏住虛擬物件並釋放選單項;拉伸較大物件上的小目標等物理控制;甚至用手重新調整物件大小或將其儲存在虛擬口袋中等等。

該功能可應用於醫療行業的機械控制、機車介面控制等。

三、短視訊直播互動

AR Engine的手部骨骼跟蹤能力也可以在短視訊傳播過程中增添一些手部特效,比如當用戶在拍攝短視訊或直播時做出比耶、點贊、比心等指定手部動作時,可識別使用者手勢併疊加相應的特效或貼紙,實現手勢觸發特效、手部特效跟蹤等效果,豐富視訊直播過程中的互動體驗。

除此之外,手部骨骼跟蹤能力還可應用於影視動畫製作、兒童教學、醫學康復、智慧家居控制等領域。

在AR技術快速發展的今天,基於手勢識別的人機互動已逐漸成為熱點,如何實現自然的、符合人類習慣的手勢識別,是人機互動介面中的一個重要組成部分,作為手勢識別的一項基礎能力,手部骨骼跟蹤也凸顯出了在該領域的重要地位。華為AR Engine希望該能力能夠幫助開發者們激發出更廣泛的研究方向和更具創新力的實際應用。

瞭解更多詳情>>

存取華為開發者聯盟官網

獲取開發指導檔案

華為移動服務開源倉庫地址:GitHub、Gitee

關注我們,第一時間瞭解 HMS Core 最新技術資訊~