Hadoop叢集搭建

Apache Hadoop 分散式叢集搭建

基礎環境準備

三臺 linux 節點,作業系統(Centos7)

- 關閉防火牆

systemctl stop firewalld

開機時禁用防火牆

systemctl disable firewalld

- 修改主機名

vi /etc/hosts

192.168.56.103 linux2

192.168.56.102 linux3

192.168.56.104 linux4

- 設定免密登入

在~目錄下執行

#生成金鑰

ssh-keygen -t rsa

cd /root/.ssh/

cp id_rsa.pub authorized_keys

//將每臺機器的金鑰拷到其他三臺上,如在第一臺上執行

ssh-copy-id -i linux3

ssh-copy-id -i linux4

- 每臺機器安裝 java 環境

安裝 Hadoop

叢集規劃

| 框架 | linux2 | linux3 | linux4 |

|---|---|---|---|

| HDFS | NameNode、DataNode | DataNode | SecondaryNameNode、DataNode |

| MapReduce | 無區分 | 無區分 | 無區分 |

| YARN | NodeManager | NodeManager | NodeManager、ResourceManager |

- 下載 hadoop

下載頁面:

https://archive.apache.org/dist/hadoop/common/hadoop-2.9.2/hadoop-2.9.2.tar.gz

下載並解壓

目錄介紹

- bin 目錄:對 Hadoop 進行操作的相關命令,如 hadoop,hdfs 等

- etc 目錄:Hadoop 的組態檔目錄,入 hdfs-site.xml,core-site.xml 等

- lib 目錄:Hadoop 本地庫(解壓縮的依賴)

- sbin 目錄:存放的是 Hadoop 叢集啟動停止相關指令碼,命令

- share 目錄:Hadoop 的一些 jar,官方案例 jar,檔案等

- 設定環境變數

新增 Hadoop 到環境變數 vim /etc/profile

export HADOOP_HOME=/opt/lagou/servers/hadoop-2.9.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

使環境變數生效

source /etc/profile

測試是否設定成功

hadoop version

叢集設定

Hadoop 叢集設定 = HDFS 叢集設定 + MapReduce 叢集設定 + Yarn 叢集設定

設定總覽:

- HDFS 叢集設定

- 將 JDK 路徑明確設定給 HDFS(修改 hadoop-env.sh)

- 指定 NameNode 節點以及資料儲存目錄(修改 core-site.xml)

- 指定 SecondaryNameNode 節點(修改 hdfs-site.xml)

- 指定 DataNode 從節點(修改 etc/hadoop/slaves 檔案,每個節點設定資訊佔一行)

- MapReduce 叢集設定

- 將 JDK 路徑明確設定給 MapReduce(修改 mapred-env.sh)

- 指定 MapReduce 計算框架執行 Yarn 資源排程框架(修改 mapred-site.xml)

- Yarn 叢集設定

- 將 JDK 路徑明確設定給 Yarn(修改 yarn-env.sh)

- 指定 ResourceManager 老大節點所在計算機節點(修改 yarn-site.xml)

- 指定 NodeManager 節點(會通過 slaves 檔案內容確定)

一、HDFS 叢集設定設定

組態檔在:/opt/lagou/servers/hadoop-2.9.2/etc/hadoop目錄下

- 設定 hadoop-env.sh

export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_151

- 指定 NameNode 節點以及資料儲存目錄(修改 core-site.xml)

<configuration>

<!-- 指定HDFS中NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://linux2:9000</value>

</property>

<!-- 指定Hadoop執行時產生檔案的儲存目錄 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/lagou/servers/hadoop-2.9.2/data/tmp</value>

</property>

</configuration>

- 指定 secondarynamenode 節點(修改 hdfs-site.xml)

<configuration>

<!-- 指定Hadoop輔助名稱節點主機設定 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>linux4:50090</value>

</property>

<!--副本數量 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

- 指定 datanode 從節點(vi slaves 檔案,每個節點設定資訊佔一行)

linux2

linux3

linux4

注意不要有多餘的換行和空格

二、MapReduce 叢集設定

- 指定 MapReduce 使用的 jdk 路徑(修改 mapred-env.sh)

export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_151

- 指定 MapReduce 計算框架執行 Yarn 資源排程框架(修改 mapred-site.xml)

<!-- 指定MR執行在Yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

三、Yarn 叢集設定

- 指定 JDK 路徑(vi yarn-env.sh)

export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_151

- 指定 ResourceMnager 的 master 節點資訊(vi yarn-site.xml)

<!-- 指定YARN的ResourceManager的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>linux4</value>

</property>

<!-- Reducer獲取資料的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

- 指定 NodeManager 節點(vi slaves 檔案,同 HDFS 設定的第四點,上面設定過,這裡就不用設定了)

linux2

linux3

linux4

注意:Hadoop 安裝目錄所屬使用者和所屬使用者組資訊,預設是 501dialout,而我們操作 Hadoop 叢集的使用者使用的是虛擬機器器的 root 使用者。

解決方法:

chown -R root:root /opt/lagou/servers/hadoop-2.9.2

備註:我們通過命令 scp 或 rsync 將一臺機器上設定好的檔案目錄複製到其他機器上去。

範例:

scp -r jdk1.8.0_151/ linux3:/opt/lagou/servers/

叢集啟動

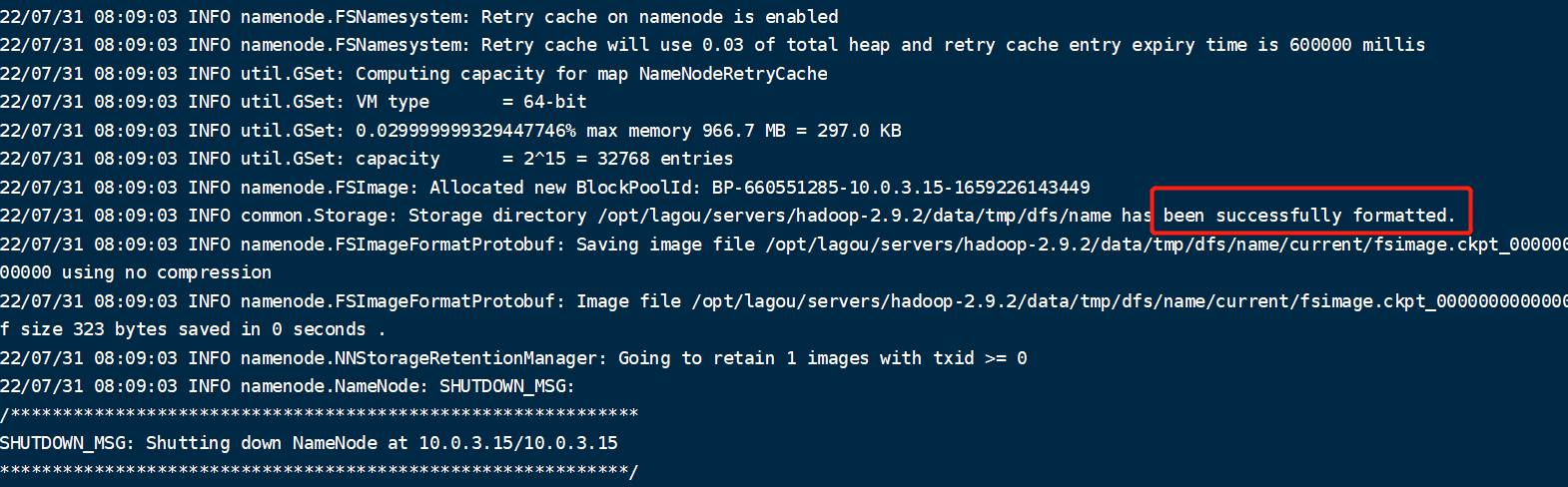

注意:如果叢集是第一次啟動,需要在Namenode 所在節點格式化 NameNode,非第一次不用執行格式化 Namenode 操作!!

hadoop namenode -format

格式化成功後有如下標識:

一、單節點啟動方式

HDFS 啟動

- 在 linux2(NameNode 節點)上啟動 NameNode

hadoop-daemon.sh start namenode

- 在 linux2、linux3、linux4 上啟動 DataNode

hadoop-daemon.sh start datanode

- 檢視啟動情況

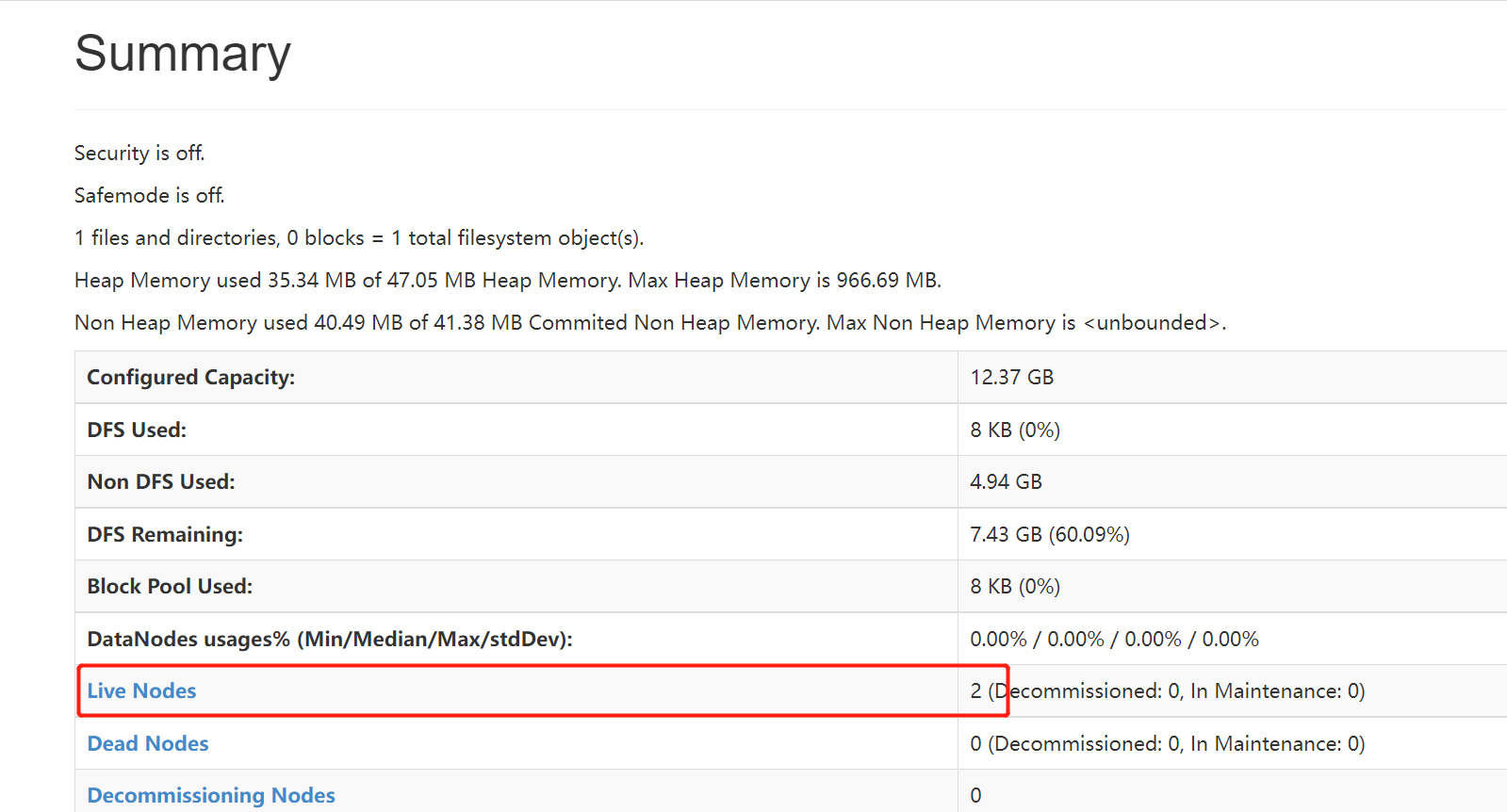

192.168.56.103:50070

從 Live Node 可以看出啟動成功的節點數量

也可以存取 HDFS 網頁:

Yarn 啟動

- 在 linux4(啟動 resourcemanager 節點)上啟動 resourcemanager

yarn-daemon.sh start resourcemanager

- 在 linux2、linux3、linux4 上啟動 nodemanager

yarn-daemon.sh start nodemanager

停止命令

就是將 start 換成 stop

hadoop-daemon.sh stop namenode/datanode/secondarynamenode

yarn-daemon.sh stop resourcemanager / nodemanager

二、叢叢集啟方式

- 在 linux2(NameNode 節點)上執行

sbin/start-dfs.sh

- 在 linux4(resourcemanager)上執行

sbin/start-yarn.sh

停止命令:

stop-dfs.sh

stop-yarn.sh

叢集測試

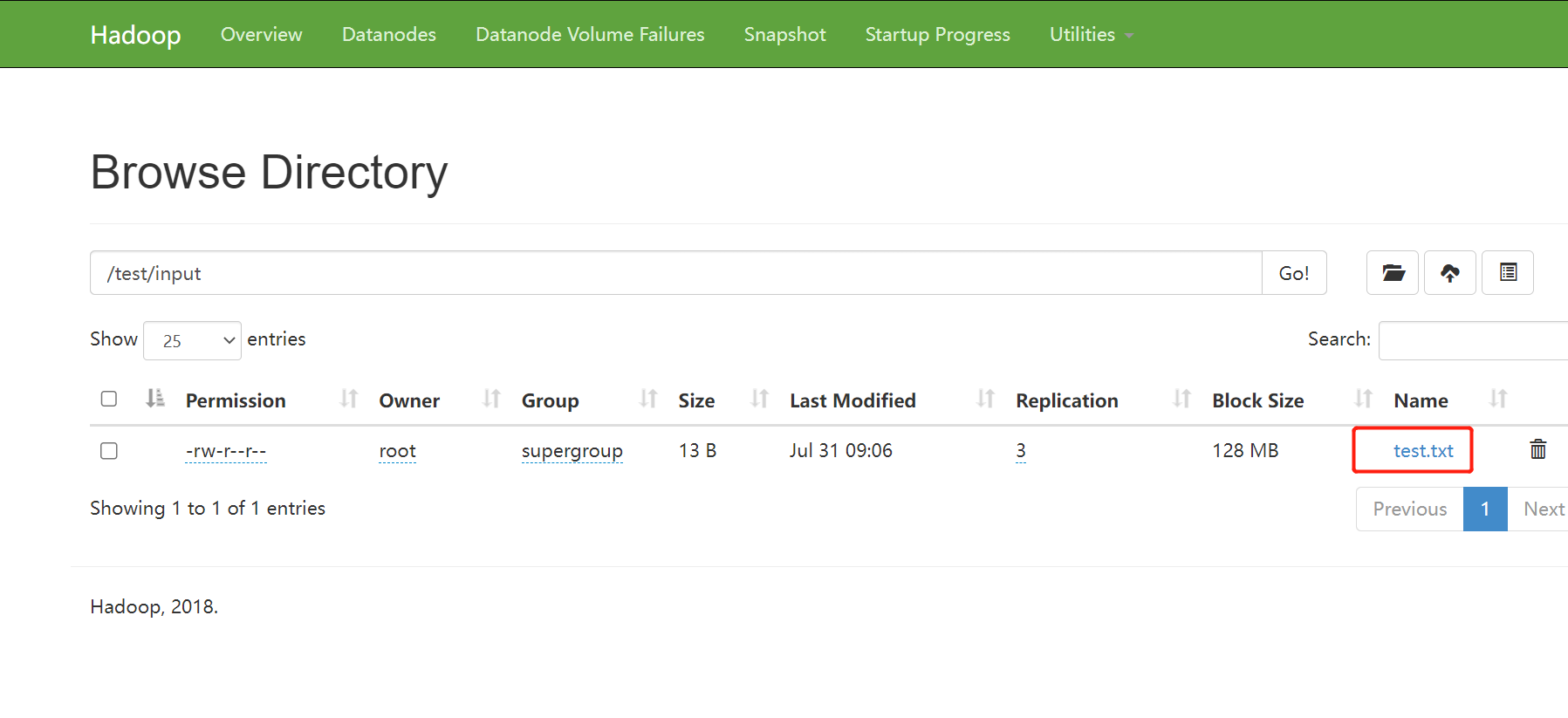

- HDFS 分散式儲存初體驗

從我們 linux 本地傳一個檔案到 hdfs 上,並從 hdfs 上下載

#在hdfs上建立資料夾

hdfs dfs -mkdir -p /test/input

#上傳linxu檔案到Hdfs

hdfs dfs -put /root/test.txt /test/input

#從Hdfs下載檔案到linux本地

hdfs dfs -get /test/input/test.txt

上傳成功後也可以從管理頁面上檢視:

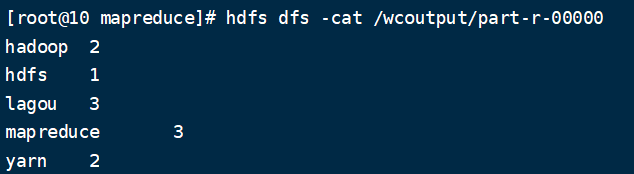

- MapReduce 分散式計算初體驗

1)在 HDFS 檔案系統根目錄下面建立一個 wcinput 資料夾

hdfs dfs -mkdir -p /wcinput

2)本地編輯一個檔案上傳到 wcinput 資料夾下

檔案內容:

hadoop mapreduce yarn

hdfs hadoop mapreduce

mapreduce yarn lagou

lagou

lagou

hdfs dfs -put word.txt /wcinput

3)執行 hadoop 提供的 mapreduce 範例程式測試

範例程式路徑: cd hadoop-2.9.2/share/hadoop/mapreduce

hadoop jar ./hadoop-mapreduce-examples-2.9.2.jar wordcount /wcinput /wcoutput

注意:wordcount 是範例程式提供的功能,wcinput 是我們放置檔案的目錄,wcoutput 由程式自動建立

4) 檢視執行結果

hdfs dfs -cat /wcoutput/part-r-00000

設定歷史伺服器

在 Yarn 中執行的任務產生的紀錄檔資料不能檢視,為了檢視程式的歷史執行情況,需要設定一下歷史紀錄檔伺服器。

- 設定 mapred-site.xml

<!-- 歷史伺服器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>linux121:10020</value>

</property>

<!-- 歷史伺服器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>linux121:19888</value>

</property>

- 設定 yarn-site.xml

<!-- 紀錄檔聚集功能使能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 紀錄檔保留時間設定7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

- 啟動歷史服務

mr-jobhistory-daemon.sh start historyserver

遇到的問題

啟動後 liveNode 只有 2 個節點。

原因:因為這兩個節點相同的 datanodeUuid 導致的。

datanodeUuid 位置:file://${hadoop.tmp.dir}/dfs/data/current/VERSION

cat /opt/lagou/servers/hadoop-2.9.2/data/tmp/dfs/data/current/VERSION

如果是一致的修改一下,然後重新啟動即可。