論文解讀(MGAE)《MGAE: Masked Autoencoders for Self-Supervised Learning on Graphs》

論文資訊

論文標題:MGAE: Masked Autoencoders for Self-Supervised Learning on Graphs

論文作者:Qiaoyu Tan, Ninghao Liu, Xiao Huang, Rui Chen, Soo-Hyun Choi, Xia Hu

論文來源:2022, ArXiv

論文地址:download

論文程式碼:download

1 Introduction

MAE 在圖上的應用。

2 Method

整體框架:

2.1 Encoder

本文的掩藏目標是隨機掩藏一部分(30%)邊,然後考慮 GCN、GraphSage 作為主幹網路提取特徵資訊,對於被掩藏的邊將通過 Decoder 訓練得到。

掩藏策略:

-

- Undirected masking:將圖看成無向圖,刪除 $(u,v)$ 之間的邊,對應於 $A$ 中的兩條邊;

- Directed masking:將圖看成有向圖,刪除 $(u,v)$ 之間的邊,對應於 $A$ 中的一條有向邊;

注意:上述兩種策略邊掩藏率是設定一樣的。

2.2 Cross-correlation decoder

由於Encoder 採用的是基於訊息傳遞機制的 Encoder,所以最終只得到被保留部分的節點潛在嵌入。

Encoder $K$ 層傳播結構共生成的保留節點嵌入矩陣 $\left\{\mathbf{H}^{(1)}, \mathbf{H}^{(2)}, \cdots, \mathbf{H}^{(K)}\right\}$,對於存在的保留節點進行 cross-correlations 操作,即

$\mathbf{h}_{e_{v, u}}=\|_{k, j=1}^{K} \mathbf{h}_{v}^{(k)} \odot \mathbf{h}_{u}^{(j)}$

其中:

-

- $\|$ 表示連線;

- $\odot$ 表示元素乘法;

- $\mathbf{h}_{e_{v, u}} \in \mathbb{R}^{d K^{2}}$ 表示節點 $v$ 和節點 $u$ 之間的交叉表示,分別考慮它們的 $k$ 階鄰域和 $j$ 階鄰域;

為避免過於複雜,通常 $K=2$。

假設剩餘的節點有 $m$ 個,那麼輸入到對應的 MLP Decoder 的將有 $m(m-1)$ (無向圖)個特徵向量,最終預測 $(u,v)$ 直接邊存在的概率通過下式生成:

$y_{v, u}=\operatorname{MLP}\left(\mathbf{h}_{v}^{(K)}, \mathbf{h}_{u}^{(K)}\right)$

2.3 Reconstruction target

MGAE解碼器,只重建掩碼的邊,目標函數如下:

$\mathcal{L}=-\sum\limits _{(v, u) \in \mathcal{E}_{\text {mask }}} \log \frac{\exp \left(\mathbf{y}_{v u}\right)}{\sum_{z \in \mathcal{V}} \exp \left(\mathbf{y}_{v z}\right)}$

為加速訓練,本文采用負取樣策略。

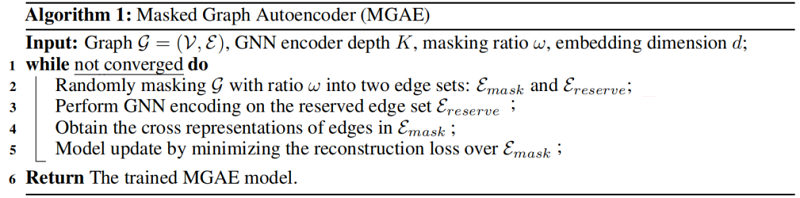

2.4 Algorithm

整體演演算法如下:

3 Experiments

資料集

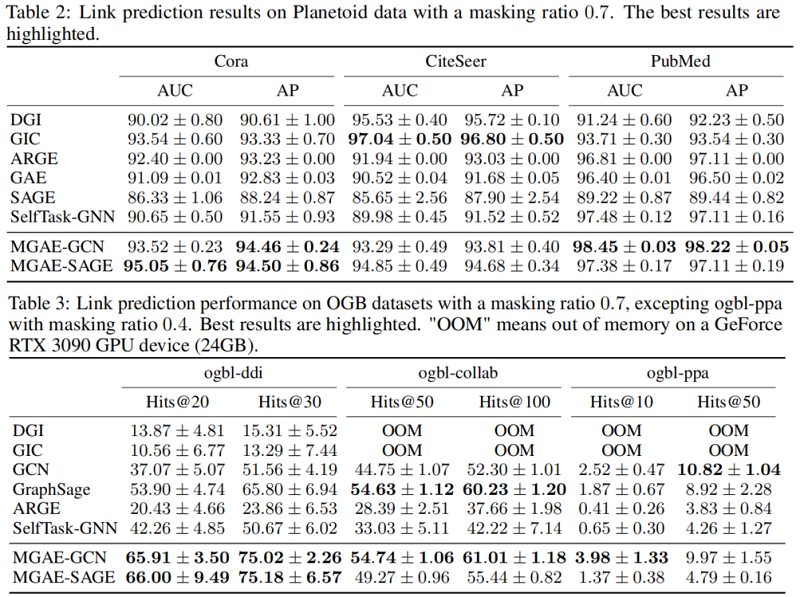

Link prediction

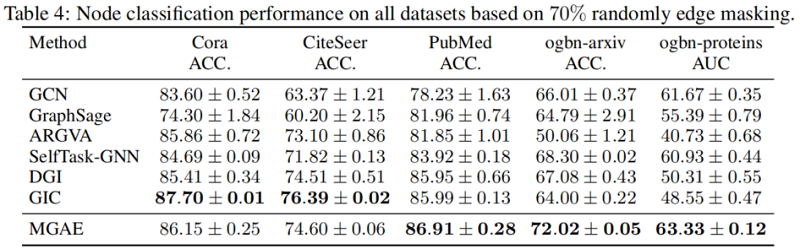

Node classifification

4 Conclusion

圖上邊掩碼AE。

修改歷史

2022-06-17 建立文章

因上求緣,果上努力~~~~ 作者:Learner-,轉載請註明原文連結:https://www.cnblogs.com/BlairGrowing/p/16386259.html