論文閱讀:Fixation Prediction for 360° Video Streaming in Head-Mounted Virtual Reality

2020-10-14 12:00:22

| 論文名字 | Fixation Prediction for 360° Video Streaming in Head-Mounted Virtual Reality |

| 來源 | 會議 Proceedings of NOSSDA V’17, Taipei, Taiwan |

| 年份 | 2017.6 |

| 作者 | Fan Ching-Ling,Lee Jean,Lo Wen-Chih, Huang Chun-Ying, Chen Kuan-Ta, Hsu Cheng-Hsin |

| 核心點 | 提出一種預測網路,可以同時利用感測器和內容相關的特性來預測未來觀眾的行為。(結合了視訊內容和人的頭部運動) |

| 閱讀日期 | 2020.10.13 |

| 內容總結 | |

| 文章主要解決的問題及解決方案: 問題:現有的解決方案要麼使用觀看者當前的方位來近似未來的市場,要麼使用歷史方位和航位推算演演算法來推斷未來的市場。 解決方案:提出一種預測網路,可以同時利用感測器和內容相關的特性來預測未來觀眾的行為。

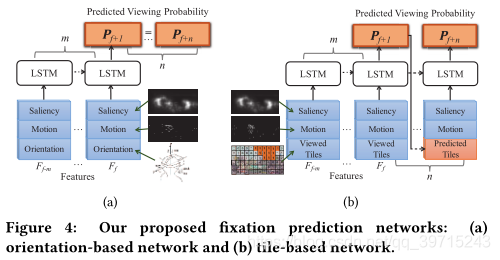

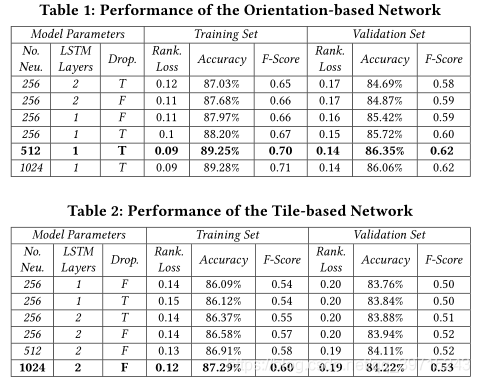

文章的主要工作: ①觀看者作為中心點,設α和β作為偏航角和俯仰角,將球面空間中的FoV描述為(α,β,θ),θ為FoV的半徑,不同裝置不同角度(Oculus Rift:100°;HTC Vive:67°;Samsung Gear:67°)。 ②使用VGG-16做影象顯著圖提取。 ③使用兩種網路模型(LSTM),網路輸入特徵為影象顯著性圖(saliency)、運動圖、觀看者方向和觀看的切片,輸出為預測觀看的概率。

④將360°視訊投影到平面圖再做處理。(可否有方法直接在扭曲的影象中做處理?)

實驗結果:

附錄: 影象顯著圖:提取色彩差異大的部分。(https://blog.csdn.net/u011630458/article/details/54693919)

提出問題:

| |