音視訊開發技術的進階路線

1. 音視訊開發包括哪些內容

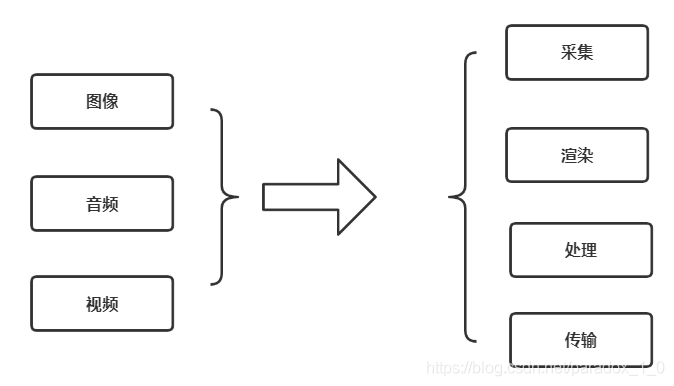

雖然一篇文章無法把音視訊開發的知識點都介紹清楚,但是大概的學習路線還是可以梳理一下的,我們先看看下面這張圖:

其實說白了,音視訊開發,就是要掌握影象、音訊、視訊的基礎知識,並且學會如何對它們進行採集、渲染、處理、傳輸等一系列的開發和應用。

- 採集:它解決的是,資料從哪裡來的問題

- 渲染:它解決的是,資料怎麼展現的問題

- 處理:它解決的是,資料怎麼加工的問題

- 傳輸:它解決的是,資料怎麼共用的問題

每一個門類,都可以深挖,衍生出一個又一個充滿技術挑戰的話題,比如:如何更高效地渲染畫面、如何提高音視訊的壓縮比,如何優化弱網下的音視訊資料傳輸等等。

其實,音視訊開發的技術積累,也沒有那麼難,帶著問題去 Google,帶著任務去實踐,一切都不是問題,我們就從上面說的 4 個方向,逐個探索一下,有哪些知識點,是要我們去了解和掌握的。

2.1 採集

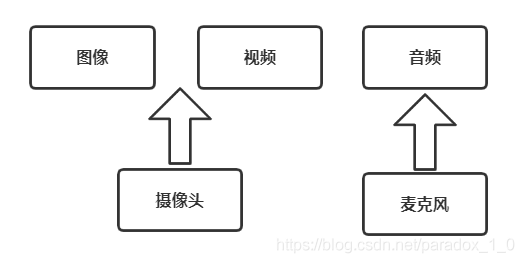

採集,它解決的是,資料從哪裡來的問題,那麼,資料究竟從哪裡來的呢 ?

其實無論在哪個平臺,影象、視訊最初都是來自攝像頭,而音訊最初都是來自麥克風,因此,做音視訊採集,就要掌握如下的技術知識:

1. 系統的攝像頭採集介面是什麼,怎麼用 ?

比如:

Windows:DirectShow

Linux:V4L2

Android:Camera

iOS:AVCaptureSession

2. 系統的攝像頭採集的引數怎麼設定,都是什麼含義 ?

比如:解析度、影格率、預覽方向、對焦、閃光燈 等

3. 系統的攝像頭輸出的影象/視訊資料,是什麼格式,不同格式有什麼區別 ?

比如:圖片:JPEG,視訊資料:NV21,NV12,I420 等

4. 系統的麥克風採集介面是什麼,怎麼用 ?

比如:

Windows:DirectShow

Linux:ALSA & OSS

Android:AudioRecord

iOS:Audio Unit

5. 系統的麥克風採集引數怎麼設定,都是什麼含義 ?

比如:取樣率,通道號,位寬 等

6. 系統的麥克風輸出的音訊資料,是什麼格式?

比如:PCM

2.2 渲染

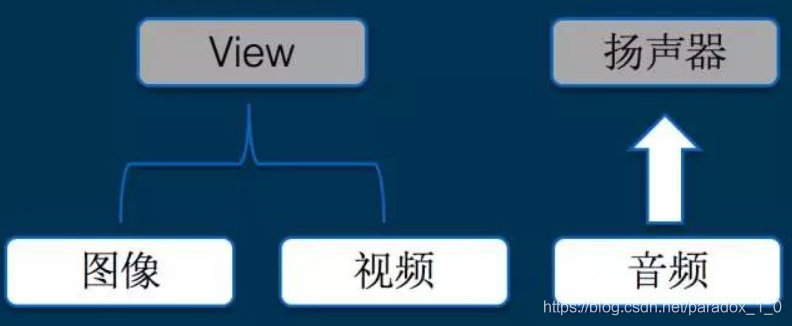

渲染,它解決的是,資料怎麼展現的問題,那麼,資料究竟怎麼展現呢 ?

其實無論在哪個平臺,影象、視訊最終都是要繪製到檢視上面,而音訊最終都是要輸出到揚聲器,因此,做音視訊渲染,就要掌握如下的技術知識:

1. 系統提供了哪些 API 可以繪製一張圖片或者一幀 YUV 影象資料的 ?

比如:

Windows:DirectDraw, Direct3D, GDI,OpenGL 等

Linux: GDI, OpenGL 等

Android:ImageView,SurfaceView,TextureView,OpenGL 等

iOS: CoreGraphics,OpenGL 等

2. 系統提供了哪些 API 可以播放一個 mp3 或者 pcm 資料 ?

比如:

Windows:DirectSound 等

Linux:ALSA & OSS 等

Android:AudioTrack 等

iOS: AudioQueue 等

2.3 處理

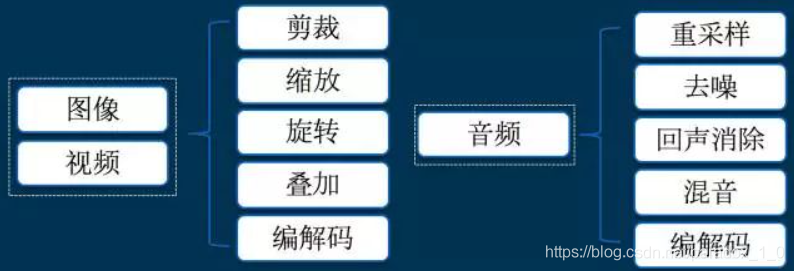

處理,它解決的是,資料怎麼加工的問題,那麼,資料究竟可以怎麼加工呢 ?

首先,我們看看影象/音視訊的資料可以做哪些加工 ?

其實無論在哪個平臺,影象和音視訊的加工,除了系統的 API,大多數都會依賴一些跨平臺的第三方庫的,通過掌握這些第三方庫的原理和使用方法,基本上就可以滿足日常音視訊處理工作了,這些庫包括但不限於:

1. 影象處理:OpenGL,OpenCV,libyuv,ffmpeg 等

2.視訊編解碼:x264,OpenH264,ffmpeg 等

3.音訊處理:speexdsp,ffmpeg 等

4.音訊編解碼:libfaac,opus,speex,ffmpeg 等

因此,學習和掌握這些第三方庫的使用,非常有必要。

2.4 傳輸

傳輸,它解決的是,資料怎麼共用的問題,那麼,資料究竟怎麼共用呢 ?

共用,最重要的一點,就是協定。

網際網路之所以能夠如此蓬勃地發展,將整個世界都緊密聯絡在一起,其實是離不開 W3C 這個委員會的巨大貢獻的,因為無論什麼資料,要想在不同的國家、不同裝置之間互聯互通,離不開 「標準」,有了 「標準」,大家就能互相讀懂對方。

因此,研究音視訊傳輸,其實就是在研究協定,具體有哪些協定呢 ?

1. 音視訊在傳輸前,怎麼打包的,如:FLV,ts,mpeg4 等

2. 直播推流,有哪些常見的協定,如:RTMP,RSTP 等

3. 直播拉流,有哪些常見的協定,如:RTMP,HLS,HDL,RTSP 等

4. 基於 UDP 的協定有哪些?如:RTP/RTCP,QUIC 等

網際網路環境下的音視訊的傳輸,是一個非常有挑戰和價值的方向,為了解決弱網下的傳輸延時、卡頓,提高使用者體驗,整個業界都在不斷地進行著深入的探索和優化。

3.小結

音視訊的路很長,更多的還是要靠自己去學習和實踐,帶著追求極致的精神去探索和優化,最終,大家都能快速成長,成為真正的行業專家!