Scrapy框架實戰(一):爬取知名技術文章網站

目錄

Scrapy 是一個非常優秀的爬蟲框架,通過

Scrapy 框架,可以非常輕鬆地實現強大的爬蟲系統,我們只需要將精力放在抓取規則以及如何處理抓取的資料上即可,本文通過實戰來介紹

Scrapy 的入門知識以及一些高階應用。

1. Scrapy 基礎知識

1.1 Scrapy 簡介

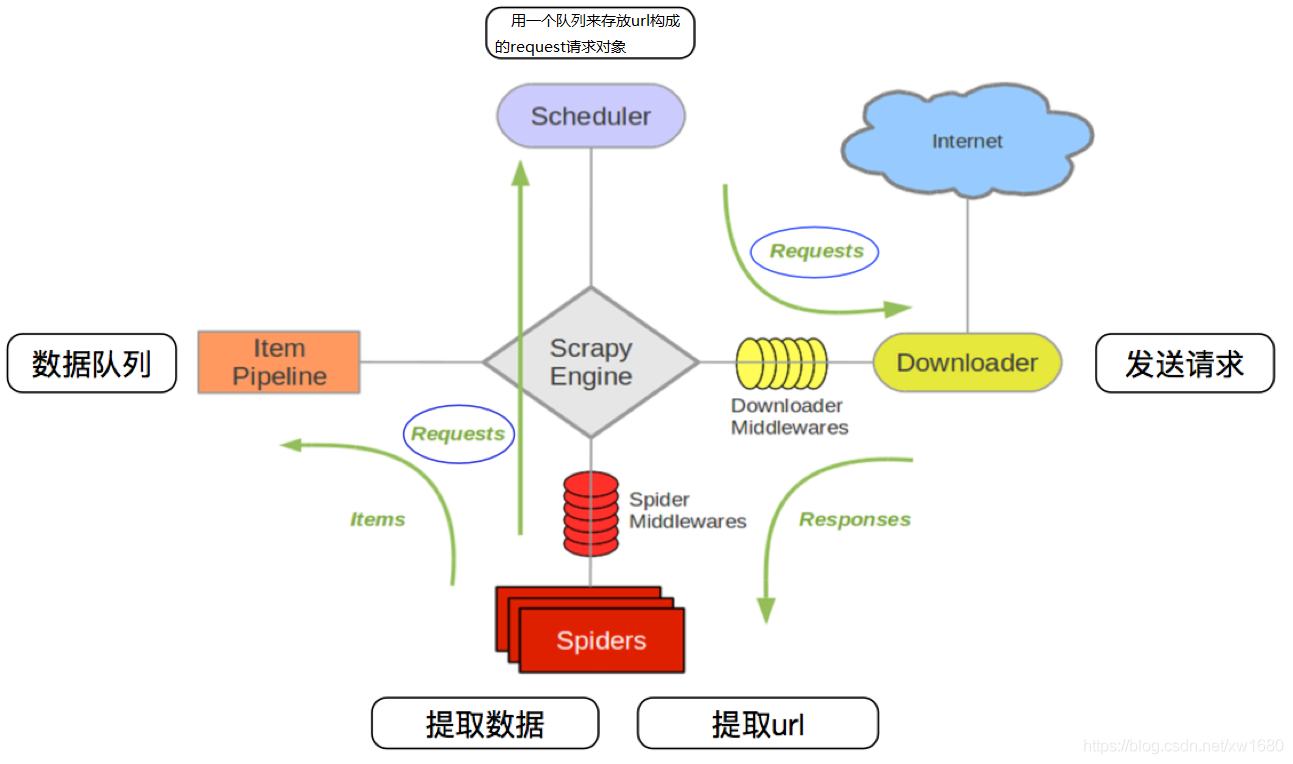

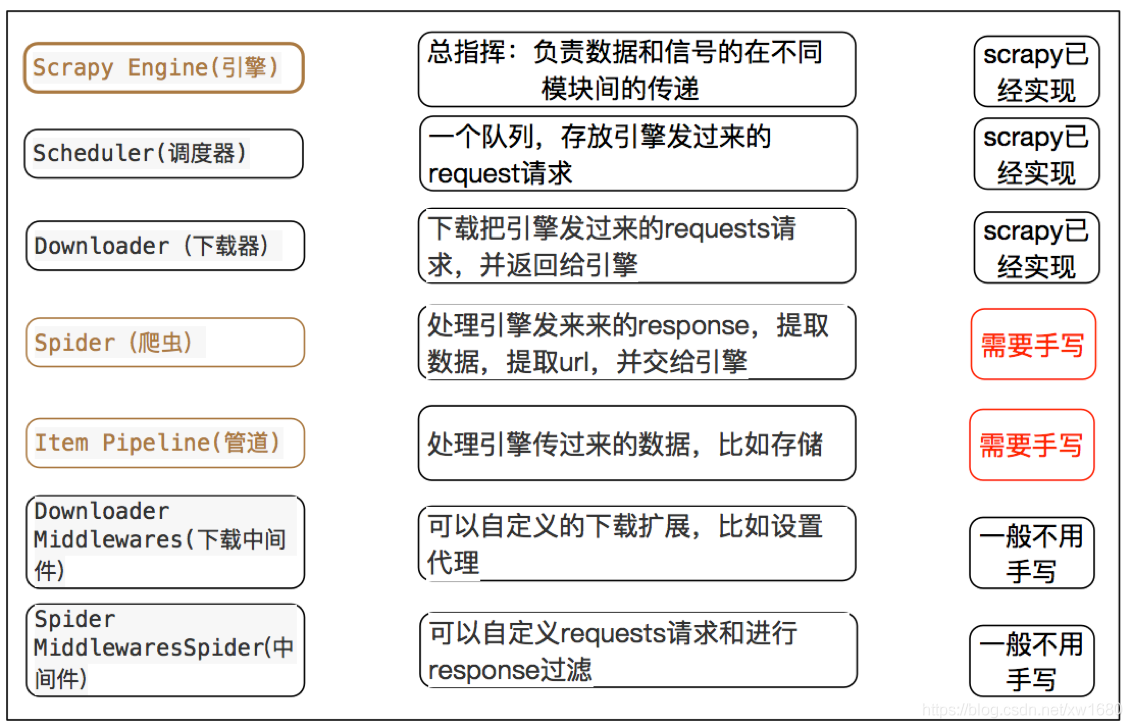

Scrapy 是適用於 Python 的一個快速、高層次的螢幕抓取和 web抓取框架,用於抓取web站點並從頁面中提取結構化的資料。Scrapy 用途廣泛,可以用於資料探勘、監測和自動化測試。Scrapy 主要是包括如下 6 個部分。

- Scrapy Engine (Scrapy引擎):用來處理整個系統的資料流,觸發各種事件。

- Scheduler (排程器):從

URL佇列中取出一個URL。 - Downloader (下載器):從 Internet 上下載 Web 資源。

- Spiders (網路爬蟲):接收下載器下載的原始資料,做進一步的處理,例如,使用

Xpath提取感興趣的資訊。 - Item Pipeline (專案管道):接收網路爬蟲傳過來的資料,以便做進一步處理。例如:存入資料庫,存入文字檔案。

- 中介軟體:整個

Scrapy框架有很多中介軟體,如下載器中介軟體、網路爬蟲中介軟體等,這些中介軟體相當於過濾器,夾在不同部分之間截獲資料流,並進行特殊的加工處理。

以上各部分的工作流程可以使用下圖所示的流程描述。

其流程可以描述如下:

- 爬蟲中起始的

URL構造成Requests物件 ⇒ 爬蟲中介軟體 ⇒ 引擎 ⇒ 排程器 - 排程器把

Requests⇒ 引擎 ⇒ 下載中介軟體 ⇒ 下載器 - 下載器傳送請求,獲取

Responses響應 ⇒ 下載中介軟體 ⇒ 引擎 ⇒ 爬蟲中介軟體 ⇒ 爬蟲 - 爬蟲提取

URL地址,組裝成Requests物件 ⇒ 爬蟲中介軟體 ⇒ 引擎 ⇒ 排程器,重複步驟2 - 爬蟲提取資料 ⇒ 引擎 ⇒ 管道處理和儲存資料

注意:

- 圖中中文是為了方便理解後加上去的

- 圖中

綠色線條的表示資料的傳遞 - 注意圖中中介軟體的位置,決定了其作用

- 注意其中引擎的位置,所有的模組之前相互獨立,只和引擎進行互動

Scrapy 中每個模組的具體作用:

1.2 Scrapy 安裝和設定

在使用 Scrapy 前需要安裝 Scrapy ,如果讀者使用的是 Anaconda Python 開發環境,可以使用下面的命令安裝 Scrapy。

conda install scrapy

如果讀者使用的是標準的 Python 開發環境,可以使用下面的命令安裝 Scrapy。

# windows 安裝命令如下 加上 --user 防止使用者許可權不夠:

pip install --user -i http://pypi.douban.com/simple --trusted-host pypi.douban.com Scrapy

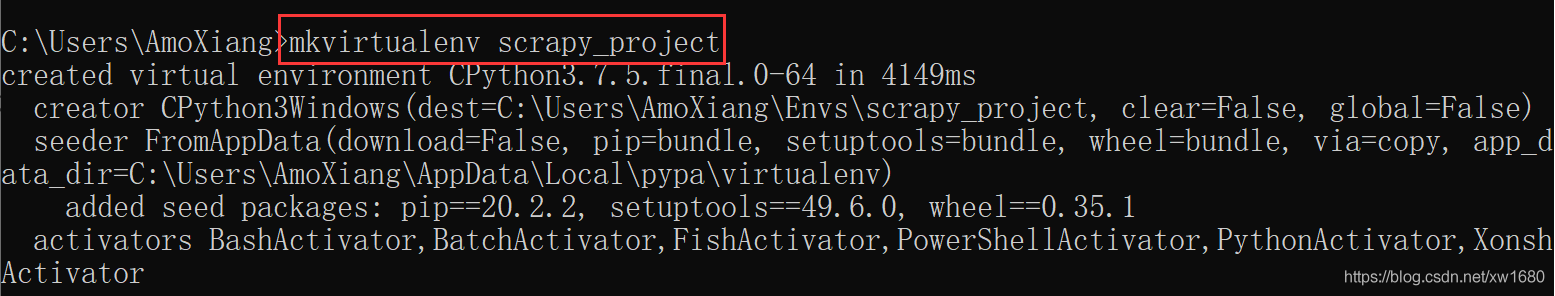

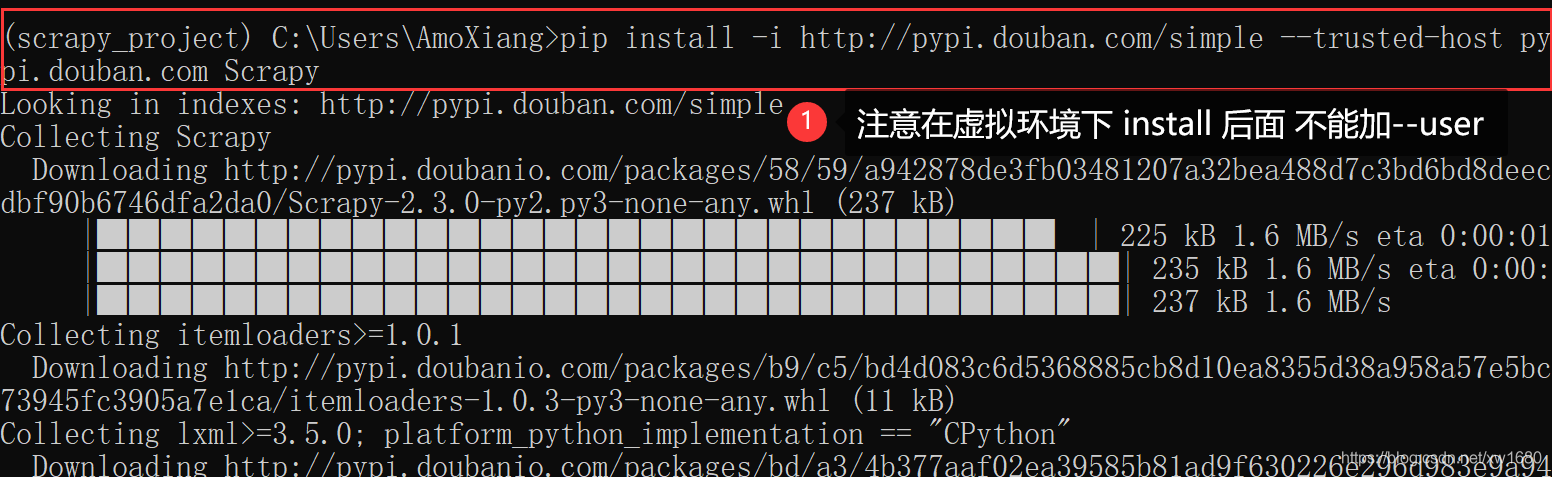

建議在所有平臺上的虛擬環境中安裝 Scrapy,筆者這裡以 Windows 為例,如下:

(1) 建立新的虛擬環境

(2) 在虛擬環境中安裝 Scrapy

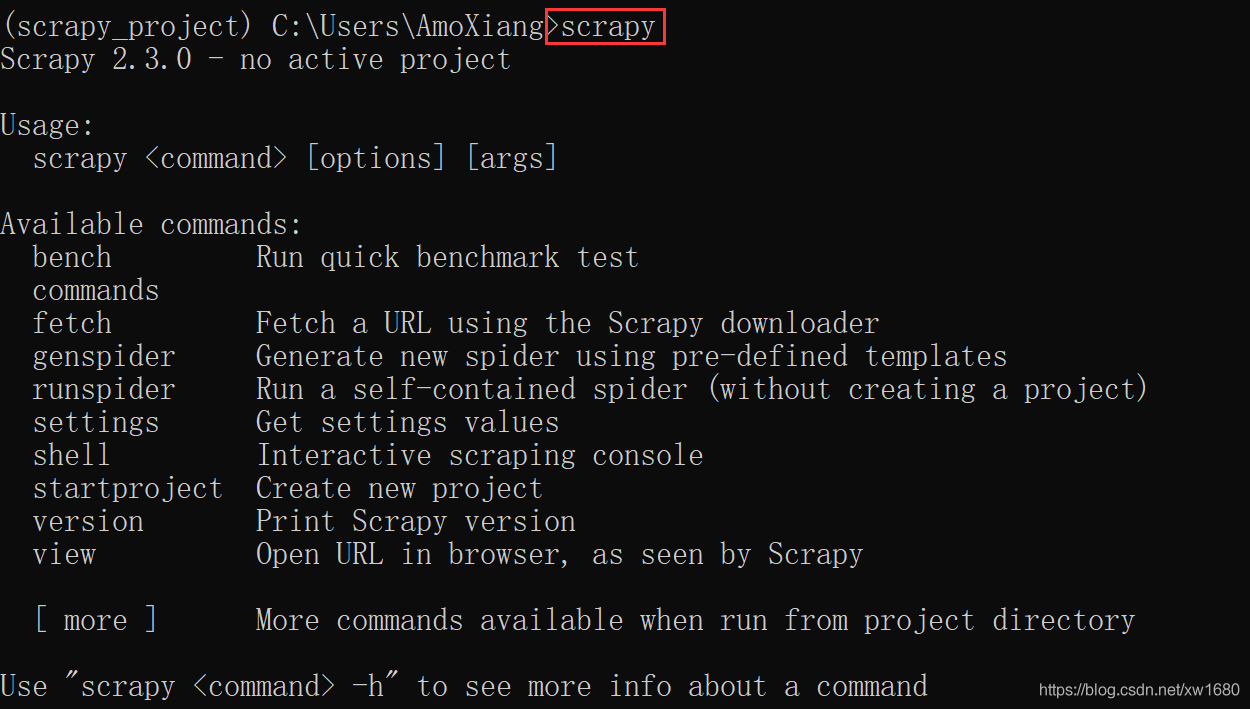

安裝完後,輸入下面的語句,如果未丟擲異常,說明 Scrapy 已經安裝成功。

1.3 Scrapy Shell 抓取 Web 資源

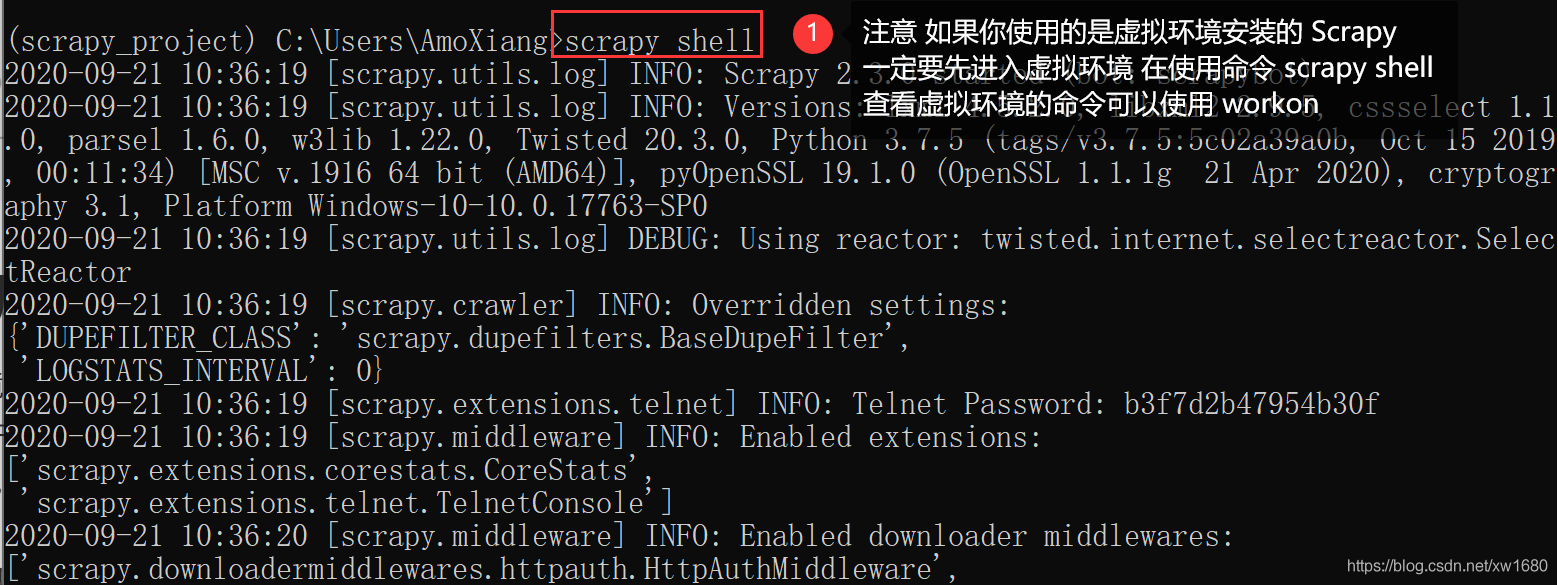

Scrapy 提供了一個 Shell 相當於 Python 的 REPL 環境,可以用這個 Scrapy Shell 測試 Scrapy 程式碼。在 Windows 中開啟黑視窗,執行 scrapy shell 命令,就會進入 Scrapy Shell。

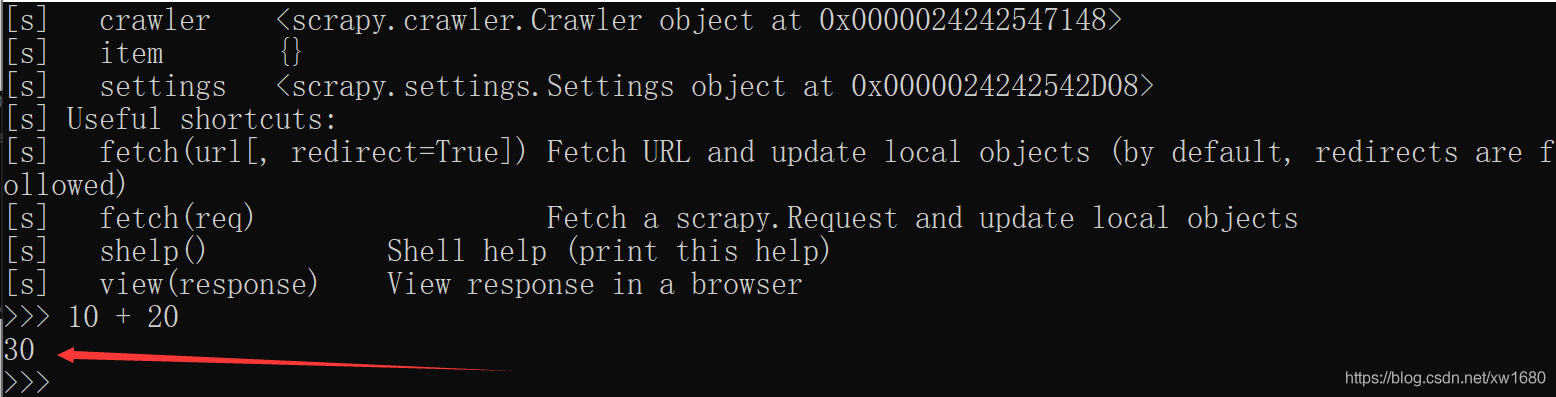

Scrapy Shell 和 Python 的 REPL 環境差不多,也可以執行任何的 Python 程式碼,只是又多了對 Scrapy 的支援,例如,在 Scrapy Shell 中輸入 10 + 20,然後回車,會輸出 30,如下圖所示:

Scrapy 主要是使用 Xpath 過濾 HTML 頁面的內容。那麼什麼是 XPath 呢? 也就是類似於路徑的過濾 HTML 程式碼的一種技術,關於 XPath 的內容後面再詳細討論。這裡不需要了解 XPath 的細節,因為 Chrome 可以根據 HTML 程式碼的某個節點自動生成 Xpath 。

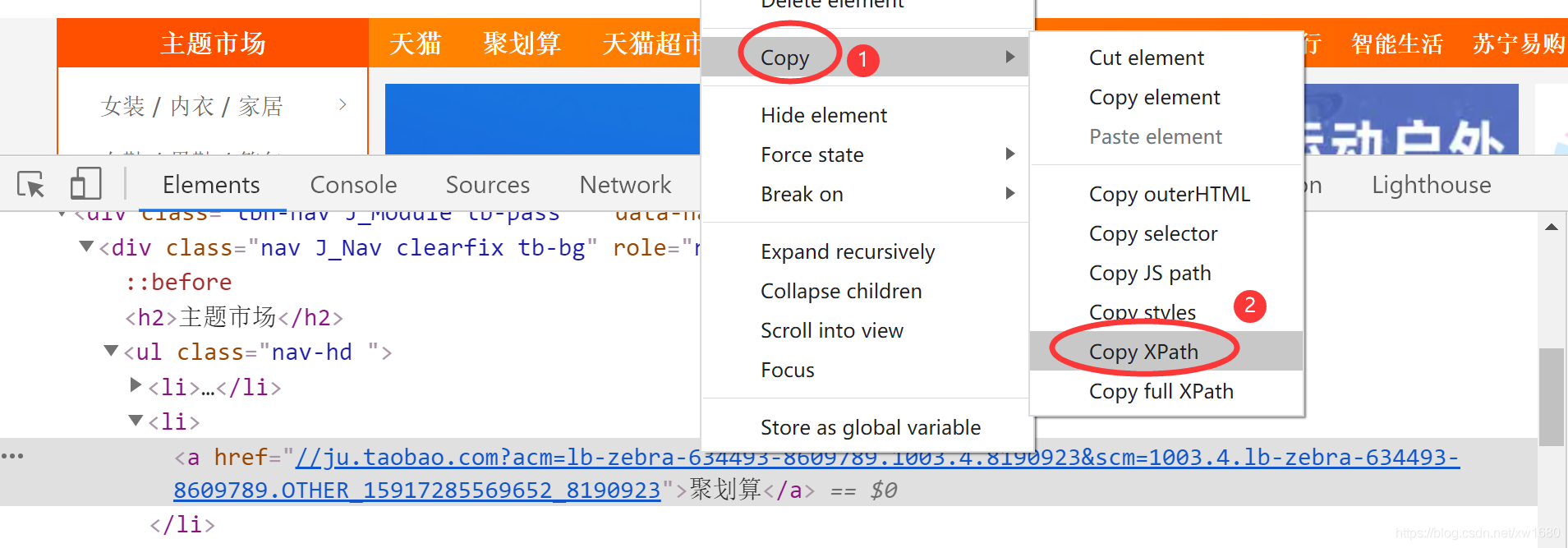

現在先體驗什麼叫XPath。啟動 Chrome 瀏覽器,進入 淘寶首頁 然後在頁面右鍵選單中單擊 檢查 命令,在彈出的偵錯視窗中選擇第一個 Elements 分頁,最後單擊 Elements 左側黑色箭頭的按鈕,將滑鼠放到淘寶首頁的導覽列 聚划算 上,如下圖所示。

這時,Elements 分頁中的 HTML 程式碼會自動定位到包含 聚划算 的標籤上,然後在右鍵選單中單擊如下圖所示的 Copy ⇒ Copy Xpath命令,就會複製當前標籤的 Xpath。

很明顯,包含 聚划算 文字的是一個 a 標籤,複製的 a 標籤的 Xpath 如下:

/html/body/div[3]/div/ul[1]/li[2]/a

根據這個 XPath 程式碼就可以基本猜出 XPath 到底是怎麼回事。XPath 通過層級的關係,最終指定了 a 標籤,其中 li[....] 這樣的標籤表示父標籤不止有一個 li 標籤,[...] 裡面是索引,從 1 開始。

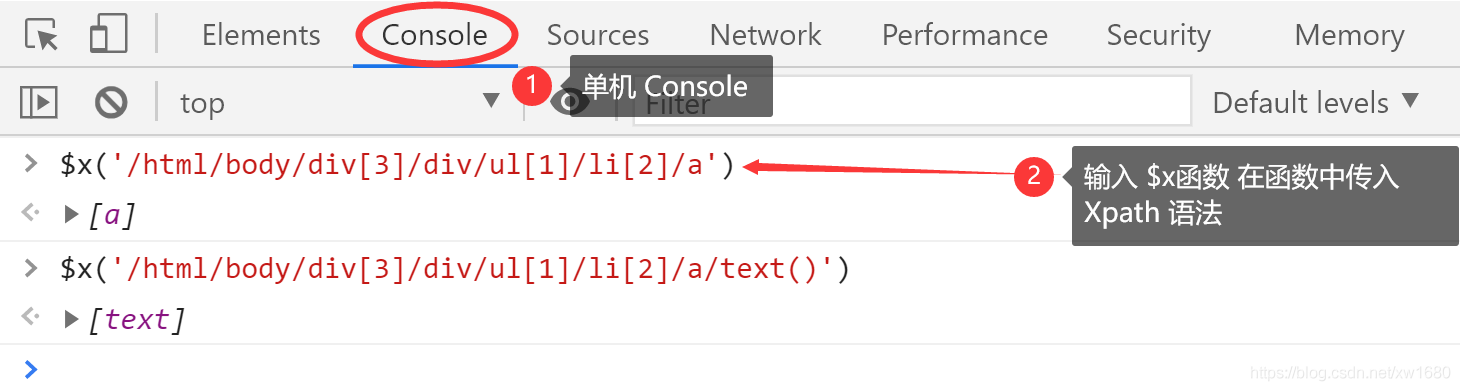

現在可以在 Chrome上測試一下這個 XPath,單擊 Console 分頁,在 Console 中輸人如下的程式碼會過濾出包含 聚划算 的 a 標籤。

$x('/html/body/div[3]/div/ul[1]/li[2]/a')

如果要過濾出 a 標籤裡包含的 聚划算 文字,需要使用 XPath 的 text 函數。

$x('/html/body/div[3]/div/ul[1]/li[2]/a/text()')

下圖是在 Console 中執行的結果,這裡就不展開了,因為Chrome 會列出很多輔助資訊,這些資訊大多用處不大。

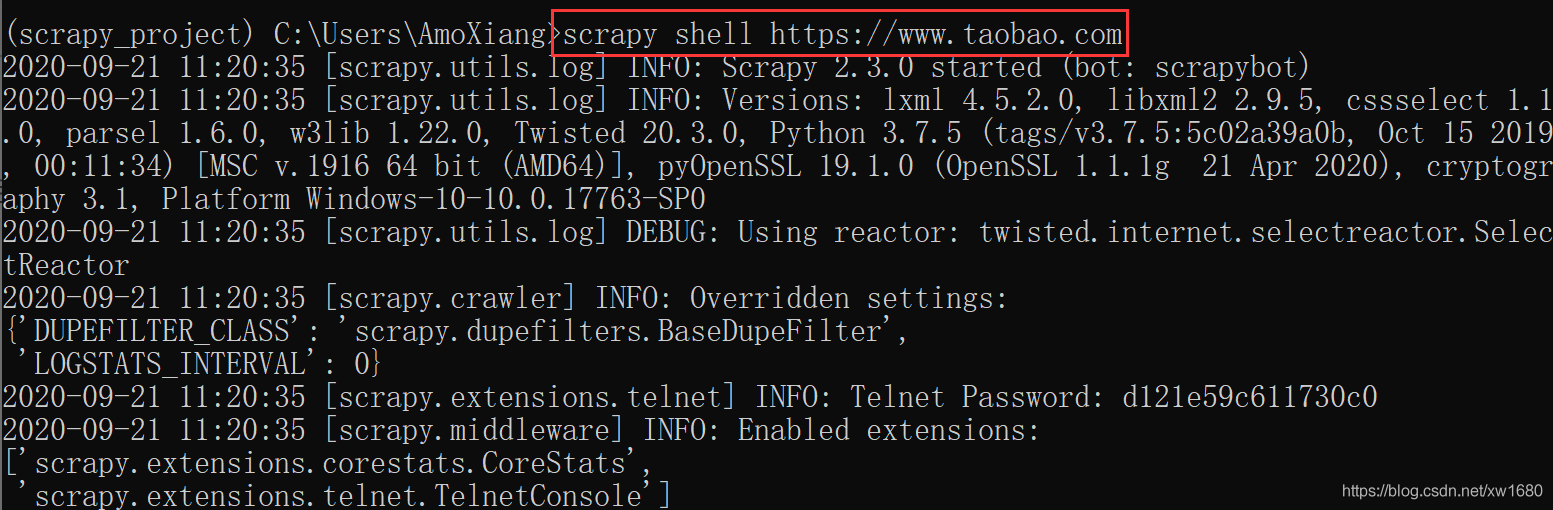

為了在 Scrapy Shell 中測試,需要使用下面的命令重新啟動 Scrapy Shell。

scrapy shell https://www.taobao.com

在 Scrapy Shell 中要使用 response.xpath 方法測試 Xpath 。

response.xpath('/html/body/div[3]/div/ul[1]/li[2]/a/text()').extract()

上面的程式碼輸出的是一個列表,如果要直接返回 聚划算 ,需要使用下面的程式碼:

response.xpath('/html/body/div[3]/div/ul[1]/li[2]/a/text()').extract()[0]

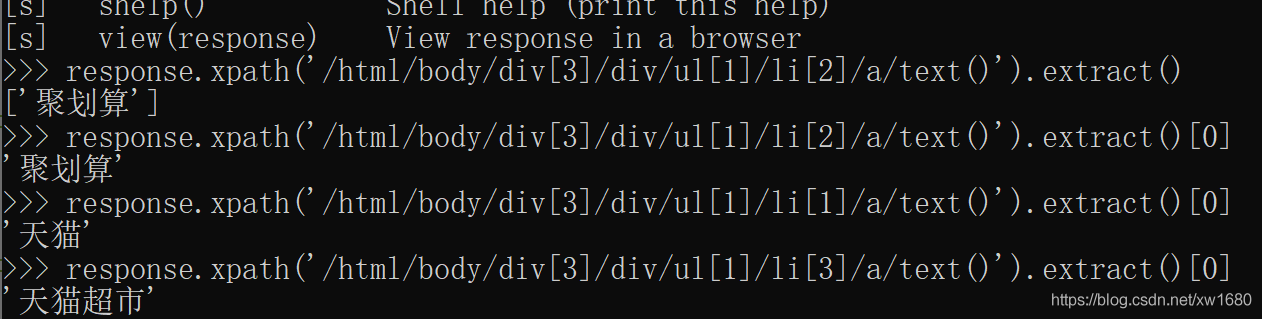

從包含 聚划算 的 a 標籤周圍的程式碼可以看出,li[1] 表示 天貓,li[3] 表示 天貓超市,所以使用下面兩行程式碼,可以分別得到 天貓 和 天貓超市。

# 輸出 "天貓"

response.xpath('/html/body/div[3]/div/ul[1]/li[1]/a/text()').extract()[0]

# 輸出 "天貓超市"

response.xpath('/html/body/div[3]/div/ul[1]/li[3]/a/text()').extract()[0]

在 Scrapy Shell 中輸入上面 4 條語句的輸出結果 如下圖所示:

2. 用 Scrapy 編寫網路爬蟲

2.1 建立和使用 Scrapy 工程

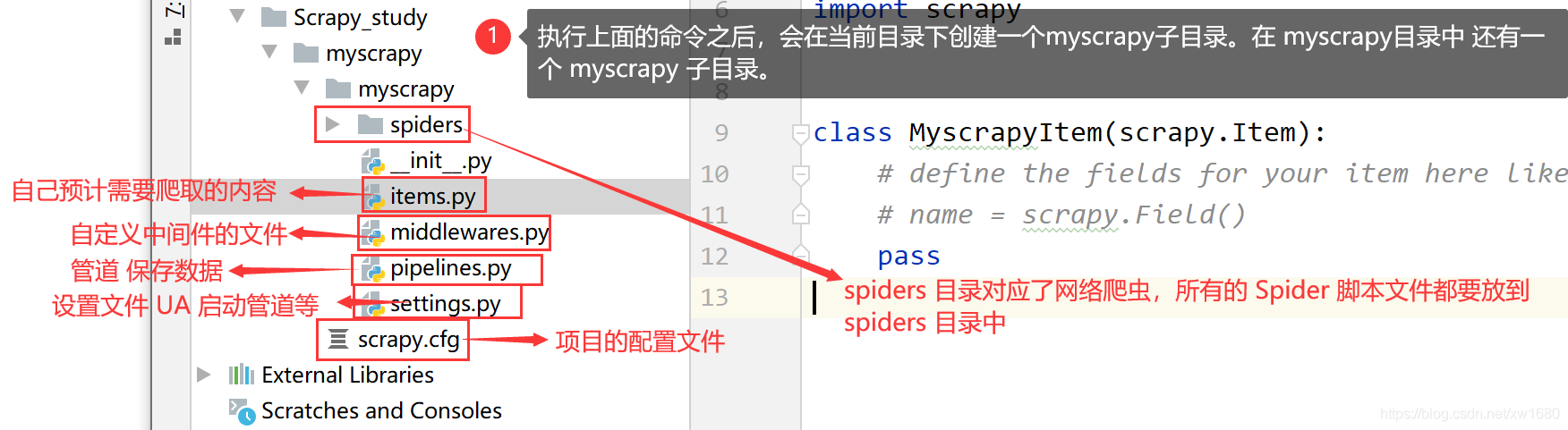

Scrapy 框架提供了一個 scrapy 命令用來建立 Scrapy 工程,可以使用下面的命令建立一個名為 myscrapy 的 Scrapy 工程。

scrapy startproject myscrapy

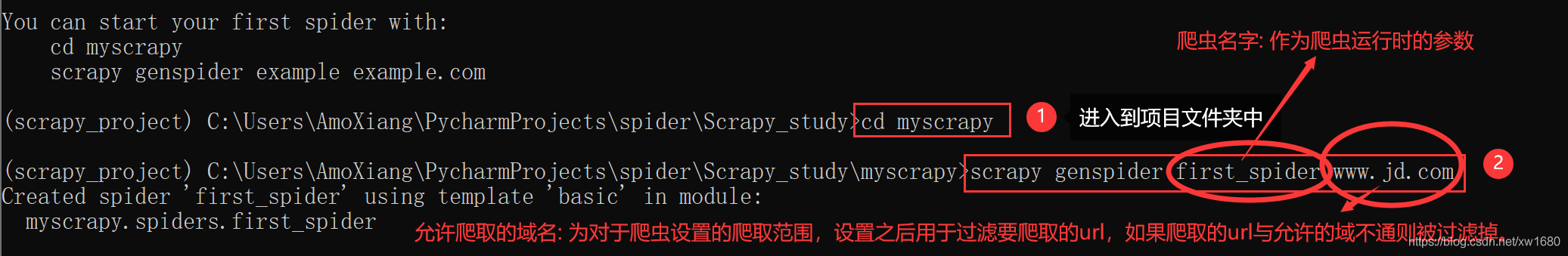

通過命令建立出爬蟲檔案,爬蟲檔案為主要的程式碼作業檔案,通常一個網站的爬取動作都會在爬蟲檔案中進行編寫。命令如下:

cd myscrapy

scrapy genspider first_spider www.jd.com

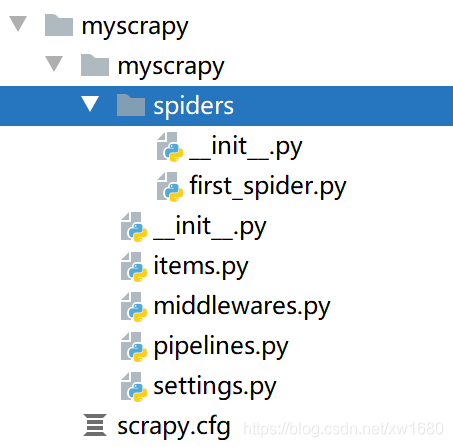

生成的目錄和檔案結果如下:

在 spiders 目錄中建立了一個 first_spider.py 指令碼檔案,這是一個 Spider 程式,在該程式中會指定要抓取的 Web 資源的 URL。範例程式碼如下:

import scrapy

class FirstSpiderSpider(scrapy.Spider):

name = 'first_spider' # Spider的名稱 需要該名稱啟動Scrapy

allowed_domains = ['www.jd.com']

start_urls = ['http://www.jd.com/'] # 指定要抓取的Web資源的 URL

# 每抓取一個URL對應的 Web資源,就會呼叫該方法,通過response引數可以執行 Xpath過濾標籤

def parse(self, response):

# 輸出紀錄檔資訊

self.log('hello world')

現在從終端進到最上層的 myscrapy 目錄,然後執行下面的命令執行 Scrapy。

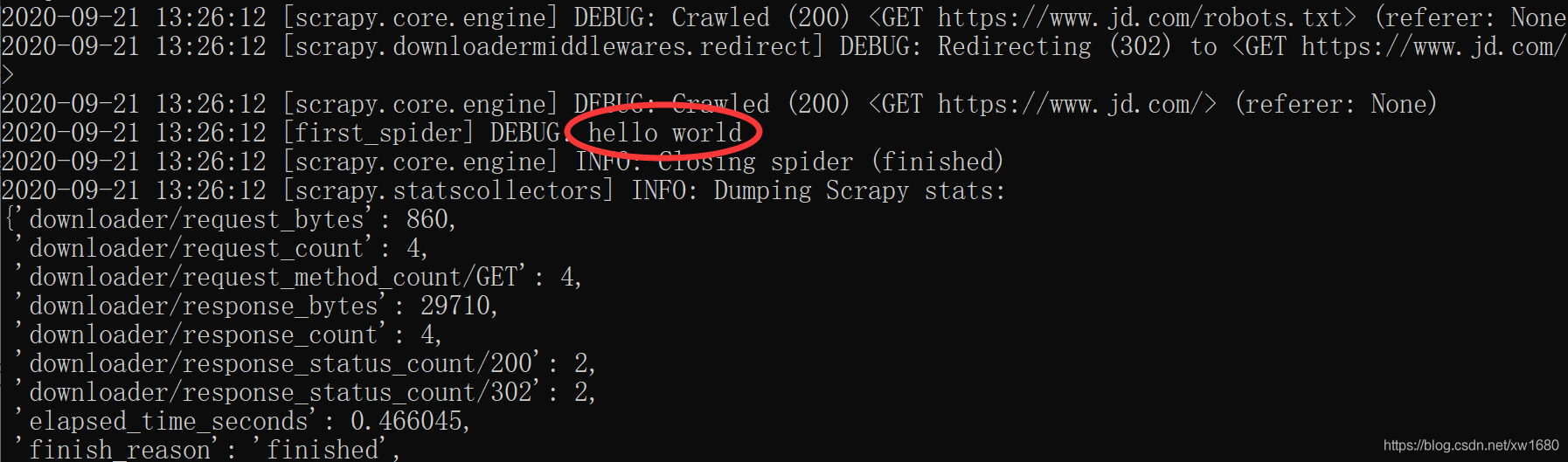

scrapy crawl first_spider

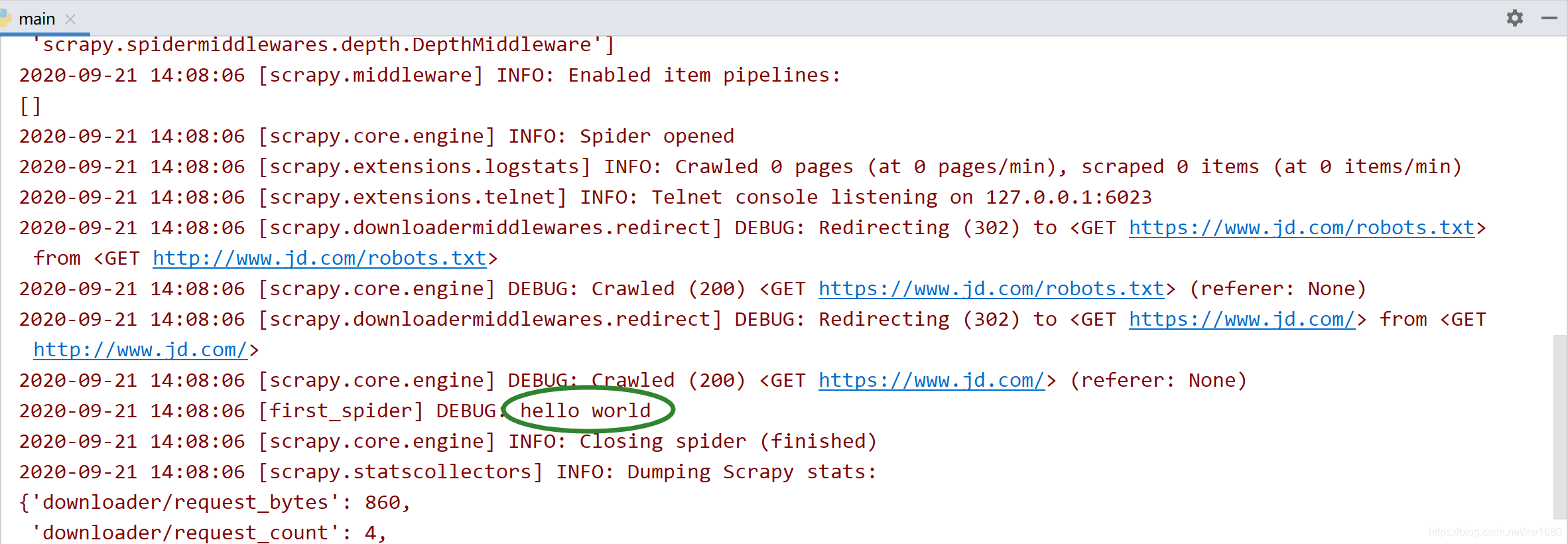

執行的結果如下圖所示:

執行 Scrapy 後的輸出結果中的 Debug 訊息輸出了 hello world,這就表明了 parse 方法執行了,從而說明 URL 指定的 Web 資源獲取成功了。

2.2 Pycharm 中偵錯 Scrapy 原始碼

為了直接能在 Python 工程中執行網路爬蟲及偵錯,需要在 myscrapy 根目錄中建立一個 main.py(檔名可以任意起) 檔案,然後輸入下面的程式碼。

from scrapy.cmdline import execute

import os

import sys

sys.path.append(os.path.dirname(os.path.abspath(__file__)))

# 如果要執行其他的網路爬蟲,只需修改上面程式碼中字串裡面的命令即可

execute(["scrapy", "crawl", "first_spider"])

現在執行 main.py 指令碼檔案,會在 PyCharm 中的 Run 輸入下圖所示的資訊,從輸出的紀錄檔資訊中同樣可以看到 hello world。

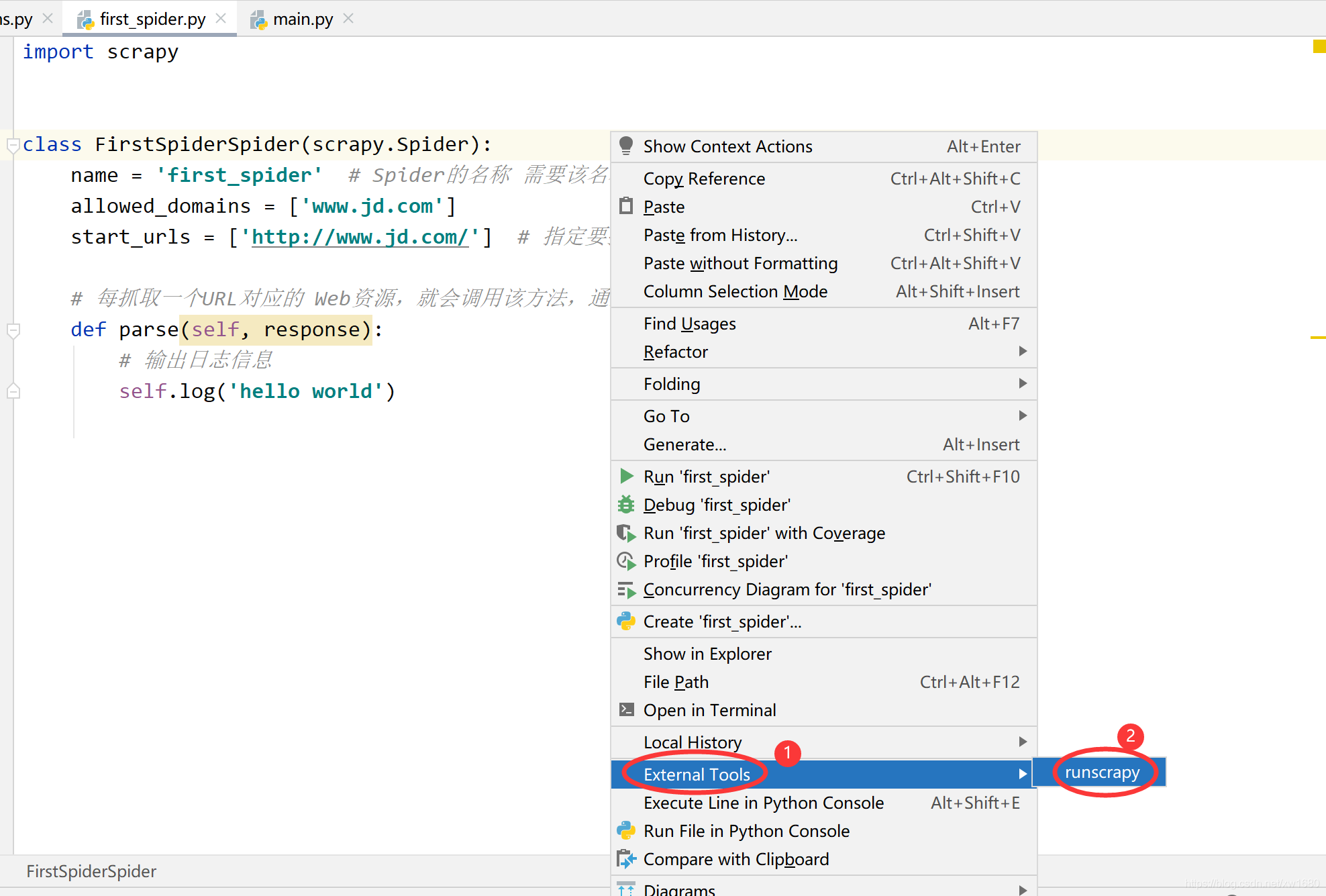

2.3 在 Pycharm 中使用擴充套件工具執行 Scrapy 工具

在 2.2 中編寫了一個 main.py 檔案用於執行 Scrapy 程式。其實本質上也是執行 scrapy 命令來執行 Scrapy 程式。不過每建立一個 Scrapy 工程,都要編寫一個 main.py 檔案放到 Pycharm 工程中用於執行 Scrapy 程式顯得很麻煩,為了在 Pycharm 中更方便地執行 Scrapy 程式,可以使用 Pycharm 擴充套件工具通過 scrapy 命令執行 Scrapy 程式。

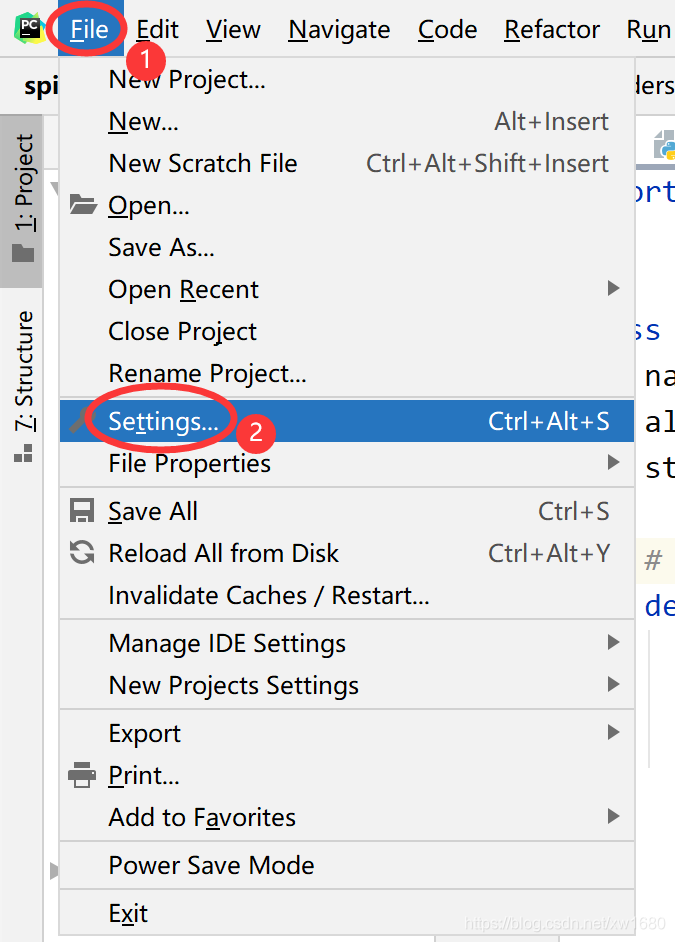

PyCharm 擴充套件工具允許在 Pycharm 中通過單擊命令執行外部命令。首先單擊 Pycharm 的 File ⇒ Settings 命令開啟 Settings 對話方塊。

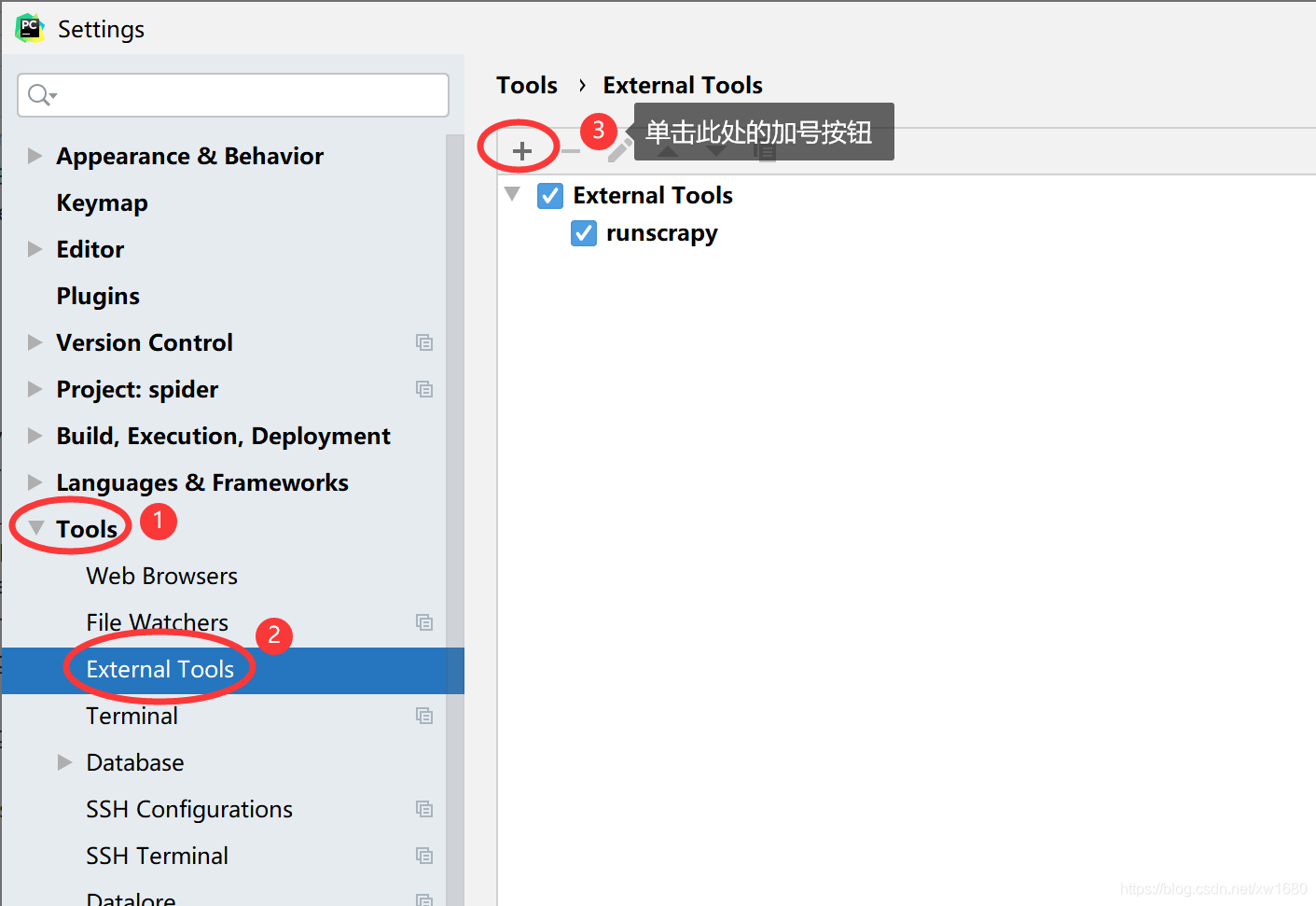

在左側單擊 Tools ⇒ External Tools 節點,會在右側顯示擴充套件工具列表,如下圖所示:

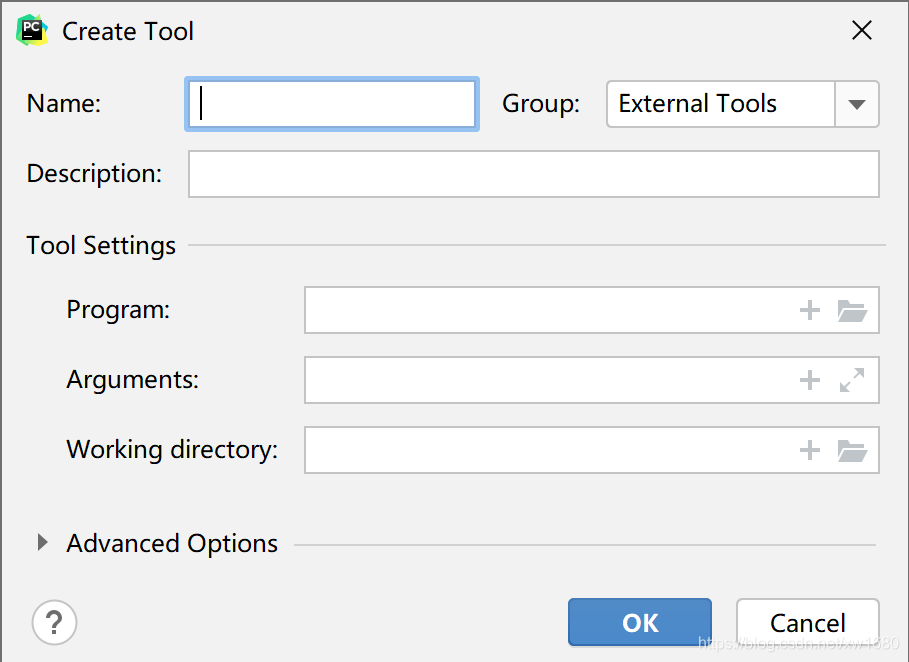

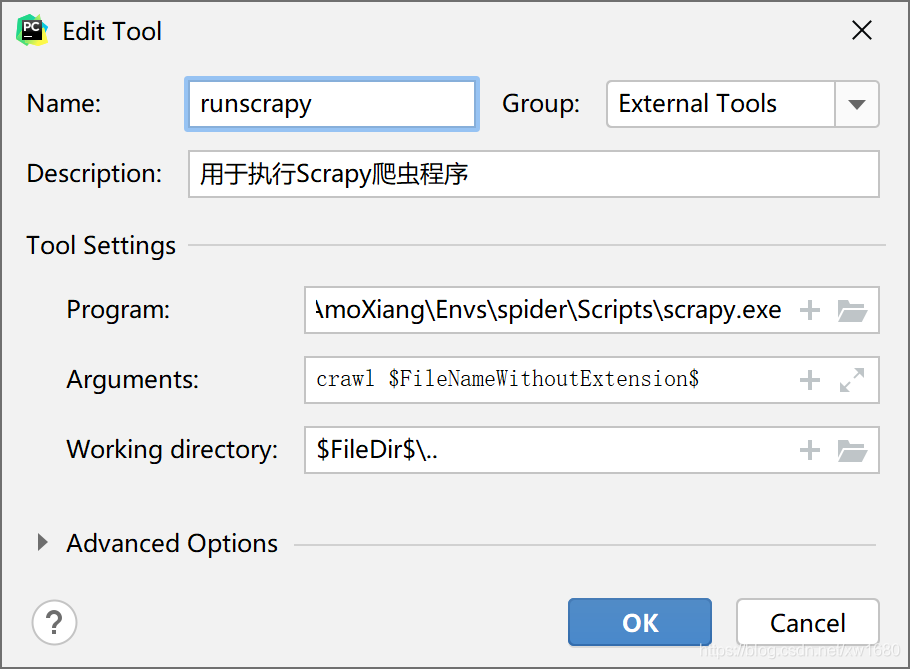

單擊之後會彈出下圖所示的 Create Tool 對話方塊。

在 Create Tool 對話方塊中通常需要填寫如下的內容:

Name:擴充套件工具的名稱,本例是runscrapy,也可以是任何其他的名字。Description:擴充套件工具的描述,可以任意填寫,相當於程式的註釋。Program:要執行的程式,本例是C:\Users\AmoXiang\Envs\spider\Scripts\scrapy.exe,指向scrapy命令的絕對路徑。讀者應該將其改成自己機器上的scrapy檔案的路徑Arguments:傳遞給要執行程式的命令列引數。本例是crawl $FileNameWithoutExtension$,其中$FileNameWithoutExtension$是PyCharm中的環境變數,表示當前選中的檔名(不包含擴充套件名),如當前檔名為first_spider.py,選中該檔案後,$FileNameWithoutExtension$的值就是first_spider。Working directory: 工作目錄,本例為$FileDir$/../..。其中$FileDir$表示當前選中檔案所在的目錄。由於Scrapy工程中所有的爬蟲程式碼都在spiders目錄中,所以需要選中spiders目錄中的爬蟲指令碼檔案(.py檔案),才能使用擴充套件工具執行爬蟲。對於用scrapy生成的Scrapy工程來說,spiders目

錄位於最內層,所以通常設定工作目錄向上反兩層。所以Working directory的值也可以是$FileDir$/..或$FileDir$。

新增完擴充套件工具後,選擇 spiders 目錄中的一個爬蟲檔案,如 first_spider.py ,然後在右鍵選單中單擊 External Tools ⇒ runscrapy 命令執行 first_spider.py,會在控制檯輸出和上面相同的資訊。